-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

A kisebb chipre épülő tervezés egy olyan döntés, ami biztosítja az AMD-nek a leggyorsabb VGA-t. Az NV azért nem így csinálja, mert nekik fontosabb a HPC-piac. Ha a játékok lennének fontosak, akkor ők is ezt a stratégiát választanák, de úgy gondolják, hogy a jövő a felhős számítási modellé, vagyis arra rendezkednek be. Az AMD a VGA-k szempontjából a játékokra rendezkedett be, mert a HPC piacra majd a Fusionnel jönnek. Ez tökéletesen látszik. A játékoknál verhetetlen a Radeon architektúrája, minden másban az, de a tervezésnél alapvetően ez volt a cél, és nem a minden más.

(#3101) Atom_Anti: A bevétel kisebb lenne, mert a GeForce adja a bevétel felét. A nyereség valószínűleg nőne, mert kiesne a GeForce balansza. Amiért még nincs eldobva a GeForce, az a bevétel. A Tegra esetében ez teljesen megváltozható. Sőt ha az NV helyében lennék, akkor a GeForce-ot nem dobnám el csak átformálnám. Nem VGA lenne, hanem külső egység, ami akár az USB 3.0 segítségével csatlakozna a táblagéphez, vagy akár a PC-hez.

-

Oliverda

félisten

"nem azt irtam hogy az ati bukott meg, hanem a kisebb chipre epulo tervezes

mar most is nagyobb chipeket gyart az ati, es a jovoben is igy lesz"

Te ezeket tényleg komolyan gondolod? A saját érdekedben remélem, hogy nem.

Néha pedig alá is támaszthatnád az irományaidat, mert ezek így csak alaptalan kitalációk. Amik ráadásul még nem is igazak.

-

Abu85

HÁZIGAZDA

Nyilván az ATI megbukott. A HD 5970 is akkora bukás volt, hogy máig az a leggyorsabb VGA.

A fogyasztási határok megmaradnak. Legalábbis a PC-ben biztos, mert a 300 watt élni fog jövőre is. Nyilván a következő generációnál is ez lesz a célkitűzés, szó sem lesz 400-500 wattos VGA-ról, maximum ilyen limitált szériás gyártói akciók erejéig. Ami kérdéses az a HPC. Mivel a Keplernél jó esély van a virtuális memória és a késleltetésre optimalizált magok alkalmazására, a rendszer gyakorlatilag inkább lesz hibrid chip, mint cGPU. Ebből a szempontból egy lapkát használva lehet HPC szervereket csinálni, ergo nincs szükség procira, mert az ARM mag megoldja ezt a feladatot. Persze itt az operációs rendszer nagy talány. Talán a teljes átállással várni kell a Maxwellig, de nyilván az NV-nek a teljes HPC platform a célja. Aminek majd a teljes kiteljesedése az Echelon projekt lesz.(#3097) BMW001: Az NV abszolút nincs bajban. A hosszútávú stratégia szempontjából ők állnak a legjobban. A Tegra és a Tesla a jövő, az egyetlen probléma ezzel a jövőképpel, hogy a GeForce-nak ebben nincs helye (már ha ez probléma), de nyilván a brand egy nagyobb cél érdekében könnycseppek nélkül eldobható. Most lehet igazán megérteni Igor Stanek szavait, amikor azt mondták a múlt évben, hogy inkább elvesztik most a csatát, ha azzal megnyerik a háborút.

-

MPowerPH

félisten

Szerintem az 5970 is elég nyereséges volt, mivel a piacon máig nincs teljesítményben ellenfele. A 6990 pedig szintén nagyon durván vetélytárs nélkül fog maradni, így úgy árazzák be, ahogy nekik tetszik, aki eddig megvette a csúcsot, az most is megfogja.

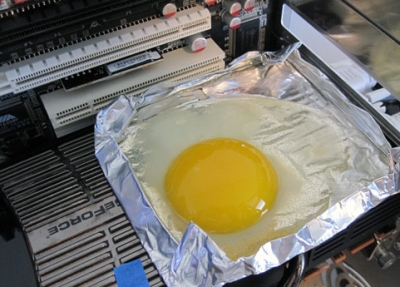

Hőtermelés, fogyasztás? Nézzed már meg a GTX480 -as fogyiját, és hőtermelését.

Vagy kell egy kis emlékeztető?![;]](//cdn.rios.hu/dl/s/v1.gif)

Én valahogy nem látom ezt a megbukást. Mutathatnál az árbevétel/eladási oldalon is ezt megmagyarázó adatot, tényleg kíváncsi lennék rá, de csakis erre a piaci szegmensre. Ha nem tudsz ilyet, akkor nem beszélj zöldségeket, mi bukott meg. Nem veszed észre, hogy közeleg az NV temetése?

-

Abu85

HÁZIGAZDA

És a PC nem egy rendszer? A programok futtatásához nem elég egy processzor. A teljes vezérlést is emulálni kell.

Az a 16 processzormag hogy jött ki?(#2515) davep: A problémás tömeggyártás is tömeggyártásnak számít. Természetesen bőven benne van a pakliban a baki lehetősége.

-

Abu85

HÁZIGAZDA

A RISC-et és a CISC-et ne keverjük ide, csak bonyolítaná a dolgot. A legnagyobb különbség, az x86-os procik és a Fermi között, hogy az előbbi termékek natívan támogatják az utasításokat. Semmiféle emulálást nem használnak, mert a teljesítmény brutálisan romlik.

Egyéb különbség, hogy a processzor fejlesztése más szempontok szerint zajlik, mint a GPU-é. Ebben az is benne van, hogy egy GPU messze nem támogat annyi utasítást, mint egy modern x86-os CPU, vagyis az utasítások állítólagos natív végrehajtása eleve elvérzik. Természetes, hogy az egyes utasítások emulálása megoldható, de az emulálás brutális igénybevételt jelent. Ezért kell például egy PS2 emulátornak többszörösen erősebb PC, és még így sem garantált a programok tökéletes működése, vagyis hihetetlenül komplex szoftveres vizsgálat kell ahhoz, hogy biztosítsd a PC-re elérhető programok futtatását emulálás mellett.

Ha valaki ezt bevállalja, akár hardveres workarounddal, az tényleg őrült, vagy nagyon kétségbeesett. -

Abu85

HÁZIGAZDA

És hogyan oldják meg a GPU-n az emulálást? Ha konkrétan x86-ra gondolsz, akkor az kivitelezhetetlen. A Transmeta számára egy speciálisan erre készített CPU-val sem sikerült ez, egy tökéletesen más dizájnt követő GPU esetében bele sem érdemes fogni. Ezek a dolgok leírva szépen hangzanak, de az a cég, aki ilyenbe belefog az őrült vagy kétségbeesett.

-

MPowerPH

félisten

Jah, hát egyenlőre még a régi 2 chippes 'vackot se veri'. Nézzél már teszteket, mit művel a Barts CF-ben. Földbe tiporja az 580-at. És a HD6990 nem Barts GPU-kból fog felépülni.

Asszem ezzel mindent elmondtam, fölösleges butaságokat írnod, mikor még magad se tudod, hányadán is vannak az erőviszonyok.

Oliverda: Tesszeláció terén ezek szerint elég nagy gyorsulás fog jelentkezni. Kicsit a memsávszélt, de inkább a ROP -ok számát bánom én is. Az persze igaz, hogy így olcsóbb lesz az előállítás.

-

Az AMD is elkövette azt a hibát a HD2000-es szériánál, hogy a jövő játékaihoz készített VGA-kat. Ha annak idején valós DX10 játékok lettek volna, akkor a HD2000-es széria sokkal jobban állta volna a sarat a GF-okkal szemben, de nem így volt, mert az emberek a jelenkor játékait akarják használni.

Ebből a hibából tanulva nem szaladnak előre a kelleténél jobban. -

cwn

tag

-

szab0729

tag

Előveszem mindjárt a troll sprayt

És mennyibe kerül? Egy GTX460 1GB/768 sli jobban megéri és olcsóbb mint az a hősugárzó..

Egy GTX460 1GB/768 sli jobban megéri és olcsóbb mint az a hősugárzó..

Másrészt: ezt eddig is tudta mindenki, mesélj vmi újat..

Harmadrészt: a topic mindig a legújabb ati sorozattal foglalkozik, nem veled..

4.: ez a középkategóriás kari, majd a 6970-nél reklamálj..Én rosszabbra számítottam, eddig bejövős, egy jó ár és vevő vagyok egy 6870-re

-

Thauglor

aktív tag

Ez már pár éve nem a " leggyorsabb" gpu harca, hanem az ATI a 4xxx óta kicsit az "ész" játékot hozta hadirendbe, ami kicsit megmozgatta az állóvizet.

SzlobiG: köszi, Tehát egy komoly KORSZAK váltás is ez egyben.

Sosem volt csúcskártyám, most is egy 4650 VGA -s lapitopival nyomom, de mindíg is a technológia rabja leszek.

Sok sikert az uúúúúj 6XXX-nek.

0:00 -

zuchy

őstag

Úgy kb senkit, annyi max a csúcskategória lehet. Én sajnálom, hogy szűkülőben van a VGA piac, de mit lehet tenni...

De szerintem valamiféle külső grafikus gyorsítók még jóideg lesznek, egy 300W-os, vagy akár egy 150W-os chipet még elég nehéz beleintegrálni egy prociba, és arról még nem is beszéltem, hogy akkor ennek a integrált VGA-chipnek milyen sávszélesség kell... A procinak is kell meg még a VGA-nak is.

De szerintem valamiféle külső grafikus gyorsítók még jóideg lesznek, egy 300W-os, vagy akár egy 150W-os chipet még elég nehéz beleintegrálni egy prociba, és arról még nem is beszéltem, hogy akkor ennek a integrált VGA-chipnek milyen sávszélesség kell... A procinak is kell meg még a VGA-nak is. -

zuchy

őstag

Fog az pörögni majd, de most csak a barts jön, annó meg a csúcslapka jött, így talán kevesebb az érdeklődő. Jönnek, mennek az emberek, de szerintem nem a kemény mag miatt fog meghalni a VGA piac, hanem az egyszeri vásárlók miatt, ...jó nem miattuk, a gyártók terelik őket más irányba. Fejlődik a technika, mindent egyre jobban integrálnak.

A kemény mag mindig is itt lesz és árgus szemekkel figyeli a VGA piacot és aki szeret találgatni, elmélkedni a VGA-kon, az itt lesz.

-

ja, aztán a 64 core-ból kijön effektív 48 core-nyi teljesítmény, mint ahogy a GTX460-nál kijön a 32-ből kb. 40. és akkor az 512 core mindjárt csak 384-nek látszik kívülről...

az 512-bites busz helyett meg "kicsivel" olcsóbb lenne megjavítani a memóriavezérlőt, hogy bírjon mit kezdeni a gyorsabb gDDR5-tel - az 512-bithez kapcsolódó +16 ROP-ra 512 ALU mellett az égvilágon semmi szüksége a chipnek, viszont akkora lenne tőle, mint egy hegyomlás. -

wednesday

őstag

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- NVIDIA GeForce RTX 5070 / 5070 Ti (GB205 / 203)

- Black Friday november 29. / Cyber Monday december 2.

- One otthoni szolgáltatások (TV, internet, telefon)

- Kertészet, mezőgazdaság topik

- Path of Exile (ARPG)

- Vezeték nélküli fejhallgatók

- Házi barkács, gányolás, tákolás, megdöbbentő gépek!

- Elden Ring

- Samsung Galaxy Z Fold7 - ezt vártuk, de…

- Xiaomi 15T Pro - a téma nincs lezárva

- További aktív témák...

- ELKELT - Sapphire PULSE AMD Radeon RX 7900 GRE 16GB - Csere is

- Gainward Phoenix 3080 10G golden sample

- Gigabyte AMD Radeon RX 9060 XT GAMING OC ICE 16GB(Bontatlan)

- MSI Radeon RX 6950 XT GAMING X 16GB DDR6 Videokártya! BeszámítOK

- PowerColor 9070 XT Hellhound Spectral White OC 16GB - Garancia 2028.05.28 - BESZÁMÍTÁS

- Samsung Galaxy S24 Ultra 8/256 GB Titanium Gray 6 hónap Garancia Beszámítás Házhozszállítás

- ÁRGARANCIA!Épített KomPhone Ryzen 5 7600X 16/32/64GB RAM RX 9060XT 16GB GAMER PC termékbeszámítással

- SanDisk Extreme Portable 8TB (SDSSDE61-8T00-G25)

- Dell Latitude 7410 karbon i7 10610U, 16GB RAM, SSD, jó akku, számla, 6 hó gar

- BESZÁMÍTÁS! 32GB (2x16) ADATA XPG Lancer RGB 7200MHz DDR5 memória garanciával hibátlan működéssel

Állásajánlatok

Cég: NetGo.hu Kft.

Város: Gödöllő

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

!

!

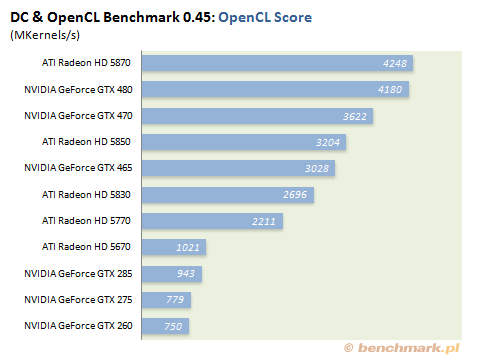

, én meg azt látom hogy az azonos fogyasztású AMD kártya 30%-al gyorsabb a leggyorsabb Nvidiától.

, én meg azt látom hogy az azonos fogyasztású AMD kártya 30%-al gyorsabb a leggyorsabb Nvidiától. .

.