-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

S_x96x_S

őstag

válasz

Busterftw

#59975

üzenetére

Busterftw

#59975

üzenetére

> Kb hasonlo marhasag amit Alogonomus irt, csak ezt a marhasagot mar 10 eve hallgatjuk.

szét kell választanod az "információt" és a "zajt" ..

valamint nem egészséges egy személyből általánosítani ...Azért az AMD-nek az APU koncepció bejött,

és ez volt az egyik ok, amivel elhozta a konzolos üzletet.> Az Nvidia teljesen kigolyozza az Intelt a CPU piacrol,

> mert a CUDA az iparagi standard es az eg kulonben is kek.erről már lekéstél.

a versenytársak és a partnerek bepánikoltak,

és bemószerolták az nVidiát,

és ugrott az ARM-es üzlet.----------------------------------

Az APU koncepció már teljesen trendi lett.

és ha az AMD tovább tudja skálázni, akkor még a CUDA-t szoftveres hátterét is ellensúlyozni tudja ...

és az MI300 csak a kezdet, a GPU chipletes játszadozás eleje.

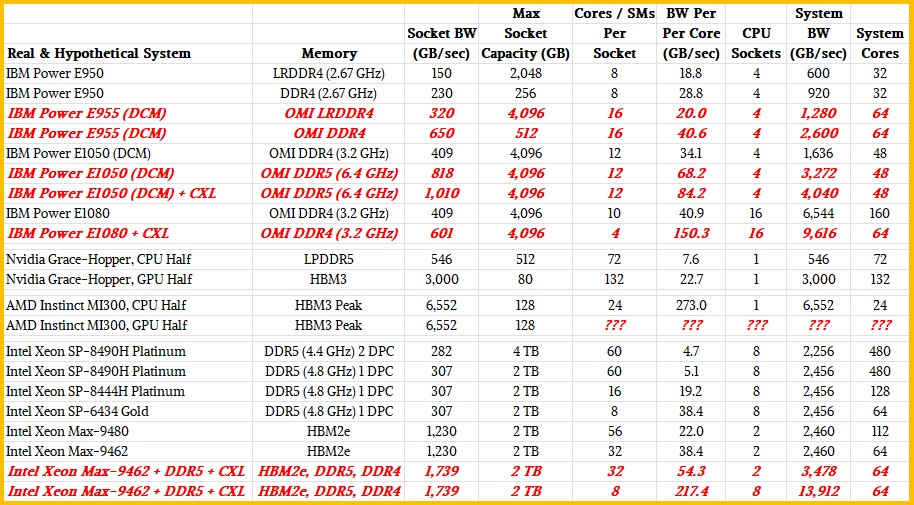

"With the AMD Instinct MI300A, we know it has 128 GB of HBM3 stacked memory across eight banks and across six GPUs and two 12-core Epyc 9004 CPU chiplets, but we don’t know the bandwidth and we do not know the number of SMs on the collection of six GPU chiplets on the MI300A package. We can make an educated guesses on the bandwidth. HBM3 is running signaling at 6.4 Gb/sec per pin and up to16 channels. Depending on the number of DRAM chips stacked up (from four to sixteen) and their capacities (from 4 GB to 64 GB per stack), you can get various capacities and bandwidths. Using 16 Gb DRAM, the initial HBM3 stacks are expected to deliver 819 GB/sec of bandwidth per stack. It looks like AMD might be using eight stacks of 16 Gb chips that are eight chips high per stack, which would give 128 GB of capacity and would yield 6,552 GB/sec of total bandwidth at the speeds expected when the HBM3 spec was announced last April. We think that the Epyc 9004 dies on the MI300A package have 16 cores, but only 12 of them are exposed to increase yields and probably clock speeds, and that would work out to an amazing 273 GB/sec per core of memory bandwidth across those Epyc cores as they reach into the HBM3 memory. It is hard to say how many SMs are on those six GPU chiplets, but it will probably be a very high bandwidth per SM compared to prior AMD and Nvidia GPU accelerators. But, again, 128 GB of total memory per compute engine is not a lot of capacity."https://www.nextplatform.com/2023/01/24/building-the-perfect-memory-bandwidth-beast/

Mottó: "A verseny jó!"

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- exHWSW - Értünk mindenhez IS

- iPhone topik

- Kormányok / autós szimulátorok topicja

- A fociról könnyedén, egy baráti társaságban

- Kerékpárosok, bringások ide!

- eMAG/edigital vélemények - tapasztalatok

- Google Pixel 6/7/8 topik

- E-roller topik

- Autós topik látogatók beszélgetős, offolós topikja

- Futás, futópályák

- További aktív témák...

- EVGA GeForce XC GAMING RTX 3060 Ti 8GB DDR6 256bit LHR

- BESZÁMÍTÁS! Gainward Phoenix RTX 3090 24GB GDDR6X videokártya garanciával hibátlan működéssel

- EVGA RTX 3070 Ti 8GB XC3 ULTRA - bontatlan - eladó!

- Palit GameRock RTX 4070 Ti BONTATLAN

- ASUS RTX 4090 24GB GDDR6X TUF Gaming OC Edition - Új, bontatlan - Eladó! 650.000.-

Állásajánlatok

Cég: Alpha Laptopszerviz Kft.

Város: Pécs

Cég: Promenade Publishing House Kft.

Város: Budapest