-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Löncsi

őstag

válasz

tombar

#10752

üzenetére

tombar

#10752

üzenetére

De ennek így semmi értelme.

Max azoknak lesz jó akik a kiszórt GTX500 sorozatból vesznek olcsón. Úgy néz ki nem kell sietnem a váltással, köszi nVidia.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

tombar

senior tag

válasz

Löncsi

#10754

üzenetére

Löncsi

#10754

üzenetére

ezek még nem hivatalos kezdőárak, illetve ez csak az enyhén túlárazott asus. szerintem a sima ref. modellek olcsóbbak lesznek. sztem nálunk cirka 300-320 euró lesz bruttóban launch pricenak. nyilván az lenne a legjobb, ha 280 környékén adnák, de ez nV, nálunk minden más.

Everybody knows, you dance like you fuck. So let me see you dance!

-

tombar

senior tag

válasz

matteo_szg

#10756

üzenetére

matteo_szg

#10756

üzenetére

hát ez kb. várható is volt. mondjuk ezek az árak leginkább a kelet európai piacokat tántorítja el a vásárlástól.

viszont remélem h nem lesz annyira hangos a ref. hűtő. palitot meg gainwardot nem igazán szeretnék venni, ha jól tudom csak 2 év a gar. szal marad msi, giga, asus. én nagyon max. nettó 80k-t adnék értük, de az már nagyon a plafon. beleéljem magam vagy ne?

Everybody knows, you dance like you fuck. So let me see you dance!

-

tombar

senior tag

válasz

Löncsi

#10758

üzenetére

Löncsi

#10758

üzenetére

de a 660ti és a 7850 nem egy kategória. am a 7850 is 50-55k között lenne ideális. nyilván ha elfogulatlanul ítélem meg a helyzetet, akkor a 660ti is max. nettó 65-68k-t érhetne. persze nem a ref. modell ultra kicsi pcbvel, meg kispórolt hűtővel.

Everybody knows, you dance like you fuck. So let me see you dance!

-

Löncsi

őstag

válasz

tombar

#10759

üzenetére

tombar

#10759

üzenetére

De, kb. egy kategória kiszivárgott tesztek szerint (eddig). Ezért mondom h ezek alapján egyelőre hajzselének használhatja Huang úr a kedves hardverét.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

KillerKollar

őstag

A tesztek alapján kb 7950 szintjén teljesít,miért van mindenki úgy meglepődve hogy hasonló az ára is?Mit vártatok hogy egy 7950 teljesítményű kártyát megkaptok majd egy 7850 áráért?

-

tombar

senior tag

-

Löncsi

őstag

válasz

KillerKollar

#10761

üzenetére

KillerKollar

#10761

üzenetére

Ezt lesd meg:

[link] Pl. Metro-ban a 7850-et hozza.Ergo nem kérhetnek 70-től sokkal többet érte el. Annak fényében, hogy van 65k körül már 7850.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Löncsi

őstag

Gondolom sokat. De mind1, nagyon kényelmesen elvagyok a húzott GTX460-al, csak gondoltam jövőre hátha lesz vmi fejlesztés jóáron, de ilyen árazással nem hiszem...

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

tombar

senior tag

válasz

Löncsi

#10763

üzenetére

Löncsi

#10763

üzenetére

metro 2033 egy eléggé elszigetelt eset és ha megnézed a többit, tisztán látszik h nagyon kódfüggő a dolog. spec ezért nem is nagyon tetszik ez a teszt, mivel elég régi játékok vannak benne, illetve jó lenne az összes elsimítást megnézni, nemcsak a maxot. az oké pölö h 680nál mindent csutkára kell rakni, mert high-end, viszont ha kisebb élelsimításnál is közel azonos vizuális élményt kapunk, de az erőviszonyok átalakulnak, az időtállóság tekintetében sokkal előrébb van. aa és af nélkül látszik is a gef. fölény.

amúgy ez az egész olyan h ,majd showdownban éppen csak 7770 teljesítményét hozza a gcn-lover kód miatt, viszont a bf3 butított ldsben meg le sincs kakálva. azt még a 448 coreos 560 ti is lenyomja, nem is kicsit. igazság szerint csomó partnerfüggetlen játékkal kéne tesztelni. ha minimum 20-25 játékot néznék, sokkal komplexebb lenne a helyzet. nyilván erre nincs kapacitás, de az lenne az igazi.Everybody knows, you dance like you fuck. So let me see you dance!

-

Löncsi

őstag

válasz

KillerKollar

#10766

üzenetére

KillerKollar

#10766

üzenetére

Ez igaz.. meg kell várni a rendes teszteket, nincs már messze, többet tudunk majd.

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Firestormhun

senior tag

+1

Néha azért nem árt levenni a technikusi szemüveget is és egy kicsit szélesebb látókört alkalmazni. Grafikus motorok irányát alapvetően az üzleti környezet/üzleti faktorok határozzák meg.Mivel a fejlesztők is meg akarnak élni, ezért soha nem fognak olyan dolgokra időt, energiát, erőforrásokat pazarolni amelyet csak a potenciális vásárlók kis százaléka élvezhet. PC esetében ezért kell a gyártóknak a zsebükbe nyúlniuk.Fizetnek x összeget a stúdiónak, küldenek 4 embert, azok leprogramozzák amit kell, aztán hajszálnyival jobb megjelenítés mellett lehet villogni benchmarkokban.

...

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10770

üzenetére

Firestormhun

#10770

üzenetére

Egyáltalán nem így van. A VGA-piac és a VGA-kat gyártó cégek üzleti érdeke másodlagos egy grafikus motor fejlesztésénél. A legfontosabb, hogy az megfeleljen az előre kitűzött igényeknek. Ha a hardverek még nem készek rá, akkor sem baj, mert a grafikában az a jó, hogy skálázható.

Az előre kitűzött célok természetesen függnek attól, hogy a grafikus processzorok általánosan milyen irányba fejlődnek. Csak pár példa. Régen minden motor forward render volt. Ez megfelelt a 2004-2006 előtti igényeknek, de felfigyeltek arra a fejlesztők, hogy a memória-sávszélesség arányaiban gyorsabban nő, mint a számítási teljesítmény. Éppen ezért a ahelyett, hogy dolgoztak volna olyan forward render eljárásokon, mely jóval több pontfényforrást kezel hatékonyan, elkezdték a deferred render felé fordítani a figyelmet. A 2000-es évek közepén ez sem volt új dolog, alapvetően régóta létező technika, csak régen a forward render jobb volt. A deferred render algoritmusok mellett megnőtt a memóriahasználat, de ez nem volt gond, mert a memória kapacitása és sávszélessége ekkor egy boomot élt meg. Marha gyorsan jött a GDDR3-GDDR4-GDDR5 egymás után, és a lapkák is relatíve olcsók voltak. Persze a deferred render algoritmusok hozták a limitációkat is, mint az MSAA normális támogatásának hiánya, illetve megnehezítette a munkát a limitált lehetőségek a felületi variációkra. Ugyanakkor a forward renderhez képest előny volt a rengeteg pontfényforrás hatékonyabb számítása és a hatékonyabb árnyalás. Mára elértünk oda, hogy szinte minden motor valamilyen deferred render eljárással dolgozik (van sok: defered shading, full és partial deferred lighting, Tile-based deferred acceleration) ... illetve elenyésző számban azért még vannak forward render motorok. Manapság megint egy változás történik. A memória-sávszélesség arányaiban lassabban növekszik, mint a számítási teljesítmény, és ezzel a mutatóval újra a forward render kerül előtérbe (ez amúgy is célszerű, mert az offline renderek forward eljárást használnak, hiszen így a művészek keze nincs annyira megkötve). Az új forward+ lighting eljárás már hatékonyabban kezel ugyanannyi pontfényforrást, mint bármely deferred render, illetve működik rajta az MSAA, nem limitálja a felületi variációkat, és az átlátszóság is egyszerűbben képezhető le. Az árnyalás fázisa ugyan lassabb forward elvvel, mint defereddel, de a lighting fázisnál bőven gyorsabb a forward, így összességében jobb.

Nyilván aki forward render motort használ opciós lehetőségként tekint a forward+ lighting eljárásra. A deferred render motorok esetében is lesz egy kis segítség itt. Ide is be lehet ágyazni a forward+ eljárás egy részét, amivel növelhető a grafika minősége. Ez persze csak egy gyors reakció a növekvő művészi igényekre, de valójában brutál compute és sávszélesség igényes, szóval amellett, hogy grafikai minőség szempontjából előny, a sebességben nagyon meg lesz az ára. Csak akkor érdemes bevetni, ha a művészek tényleg igénylik a jobb grafika kialakításához.

Ebből azért lejöhet, hogy a fejlesztések fő mozgatórugója a művészi munka szabadabbá tétele, illetve a reakció a hardverek egyes képességeinek hosszútávú változására. Pl. mi nő gyorsabban, a számítási teljesítmény, vagy a memória-sávszélesség.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Firestormhun

senior tag

Egyáltalán nem így van. A VGA-piac és a VGA-kat gyártó cégek üzleti érdeke másodlagos egy grafikus motor fejlesztésénél. A legfontosabb, hogy az megfeleljen az előre kitűzött igényeknek. Ha a hardverek még nem készek rá, akkor sem baj, mert a grafikában az a jó, hogy skálázható.

Félreértetted, játékfejlesztőkről írtam elsősorban. Ott mindig is meghatározó volt az üzleti környezet grafikus motorok tervezésénél.

2006 előtti években/évtizedben a PC-s eladások uralták a piacot, az volt a célplatform, olyan szemléletben készíthették a motorokat, hogy számíthattak a programozhatóság és a teljesítmény növekedésére. Akkoriban ha elő vettél egy 2 éves játékot már fintorogva néztél rá, amely jól jellemezte az innováció ütemét. Lehetett beszélni trendekről, trendszerűségről.Megjelentek a mostani konzolok, torrent elterjedt, pc eladások drasztikusan zuhantak, konzol eladások kilőttek. Természetesen nem állt le a grafikus motorok fejlesztése, de egy olyan irányvonalat vettek, hogy egy adott fix technikai környezettel való gazdálkodás lett a prioritás.

Jellemzővé vált az is, hogy egy-egy motor néhány tulajdonságánál egyenesen visszalépés történt a konzol specifikációk miatt. Chrome engine 3 --> 4, Cryengine 2 --> 3.

Most már ott tartunk, hogy egy PC-s GPU 16* gyorsabb a Xenosnál. Mégis mit kapnak a PC-sek? pcgameshardware.de interjúk általános válasza: kapcsolhatnak nagyobb felbontást, meg nagyobb a draw distance...

Nincsen benne pénz, hát nem csinálják az esetek 90%-ban. Maradék 10%-ban pedig maradnak a vállalkozó szelleműek, tőke gazdagabb stúdiók, illetve a gyártói szponzorációk. S ezekben is még dominálnak a konzolos assetek. Directcompute ide, tesszeláció oda, screenshotok közt a hatodik oda-vissza kapcsolgatásnál már észre is veszed a különbséget.

Nincsen benne pénz, hát nem csinálják az esetek 90%-ban. Maradék 10%-ban pedig maradnak a vállalkozó szelleműek, tőke gazdagabb stúdiók, illetve a gyártói szponzorációk. S ezekben is még dominálnak a konzolos assetek. Directcompute ide, tesszeláció oda, screenshotok közt a hatodik oda-vissza kapcsolgatásnál már észre is veszed a különbséget.

További hozadéka a konzoloknak pl. OpenGL teljes térvesztése AMD szerencséjére.

Szóval jövőbeli trendekről maximum csak annyiról beszélhetünk, hogy AMD Gaming Evolved programokban x várható, Nvidia TWIMTBP-ben y várható, DE ÁLTALÁNOSAN, hogy a játékok igen nagy részében mi várható, azzal várni kell a következő generációs konzolok specifikációinak letisztulásáig.

...

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10772

üzenetére

Firestormhun

#10772

üzenetére

Ebben félig van csak ráció. A másik fele a dolognak az, hogy a játékok fejlesztésére költött anyagi befektetés nem nőhet egyenes arányban a grafika fejlődésével. Ez fogja inkább vissza a fejlődést és nem pont a konzol. Ma már rengeteg olyan DX11-es játék jön, ami olyan eljárásokat használ, amit konzolba be sem lehet építeni. Nyilván elvben megoldható, csak nincs meg hozzá a teljesítmény. A GPU-k pedig lehetnek 30x gyorsabbak is (már bőven azok), addig ez nem ér semmit, amíg a művészi munkába fektetett anyagi- és humánerőforrás nem lesz 30x nagyobb. Erre tök jó példa a Samaritan demó. Ha lenne három év egy útcasarkot pofozgatni, akkor ma minden játék úgy nézne ki PC-n. Három év azonban egy teljes játéktérre sincs, szóval keresni kell olyan megoldásokat, amivel gyorsabban kreálható a tartalom. Carmack ezért megy a megatextúrázás és a megageometria felé, mert ez egy ilyen megoldás. Rögös az út persze, nagyon nem fekszik a dolog a CPU.nak + a lassú külső buszon bekötött GPU-nak (ezzel a textúra tile-ok folyamatos másolgatásának a rendszermemória és a VRAM között), de elméletben ott az előny, és az integráció fejlődésével a gyakorlatban is ott lesz. Aztán kiegészíthető ez a Ptexszel, ami ténylegesen pár kattintásra csökkent a mai textúraformátumok mellett sokszor órákig tartó munkát. Csak így lehet jelentősen előrelépni, mert a költségek és a befektetett humánerőforrás drasztikus növelése szerintem nem jó út, már csak anyagilag sem.

Mindig van különbség, csak az effektet ismerni kell, hogy azt hol keresd. A technika implementációja pedig jellemzően a fejlesztőktől függ. Sok olyan opció van egyébként, ami régóta létezik, de csak most kezdik alkalmazni, hogy megérkezett az ALU Power. Ilyen például az SSDO. Ez teljes felbontás mellett a Nexuizban van először. A Crysis 2 is támogatta, de negyedelt felbontással, nyilván van egy combosabb compute igénye, szóval nem árt finoman bánni vele. A különbség viszont nagyon szembeötlő:

On [link] - Off [link]Az OpenGL támogatásának csökkenése nem a konzolok hagyatéka. Egyik konzol sem használ PC-s API-t, szóval teljesen irreleváns a PC-s API kiválasztásnál a port. Amiért az OpenGL hanyatlott az a DX10-es reformok. Pont azt hozta amire a fejlesztők vágytak, ezzel viszont teljesen megölték a visszafelé kompatibilítást. Az OpenGL nem tud elszakadni a kompatibilitástól, így sajnos görgeti maga előtt azokat a problémákat, amitől az MS megszabadította a DX-et. Ettől persze nem lesz rossz API, sőt, nagyon jó, de a DX most jobb.

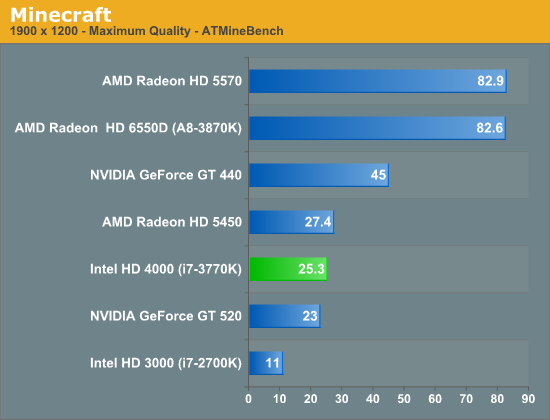

Az AMD az OpenGL visszaszorulásának egyáltalán nem örül. Az OpenGL driver náluk nagy változáson ment át az elmúlt 7 évben. Az egészet az Orca (OpenGL) driver indította el, ami a Catalyst 7.1-ben mutatkozott be. A régi driver felújításaként a sebesség marha jó volt, de a stabilitás már nem. Ezután döntött úgy az AMD (ekkor ugye már megvették őket), hogy ezt a sebességet kell hozni stabilan. Kétfelé ágazott tehát a projekt. Az Orca funkcionális fejlesztése tovább zajlott, de a nagyobb project az OpenGL driver újraírása a nulláról. Ez a projekt 2010 októberében készült el, amikor megérkezett a FirePro kártyákhoz a 8.773-as driver. Ezzel a korábbi driverhez képest 446%-os teljesítménynövekedést sikerült elérni egy v7800-on, ami az akkori csúcs volt. És ami a legfontosabb, hogy a stabilitás is elképesztően fejlődött. Ezután kezdték a FirePro termékek megkapni a programcertifikációkat, mert funkcionálisan szuper volt a működés. A konzumer termékeknél a mainline kódba 11.3-as driverben került bele ez az OpenGL driver. Ennek az eredménye, hogy a Radeonok így teljesítenek a MineCraftban:

A GeForce GT 440-nél nem gyorsabb a HD 5570 majdnem kétszer (DX-ben kb. egy szinten teljesítenek, kicsit gyorsabb a GeForce), és az A10-3870K sem gyorsabb 3,5x az i7-3770K-nál (úgy átlag 20-40%-kal gyorsabb "csak" az Intelnél). Ami ezeket az eredményeket hozza az AMD-nél az a nulláról újraírt OpenGL driver előnye.

Az AMD pechére ennek játékokban már nem nagyon lesz hozománya, mert a DX elhúzott. Persze a professzionális piacon jól jön majd a driver, szóval nem kidobott pénz és idő ... de azt mondani, hogy az AMD szerencséjére nincs sok OpenGL játék ... hát, ennek ők ennyi befektetett munka után egyáltalán nem örülnek.Az természetes, hogy a GE és a TWIMTBP programoknál más lesz a grafika fejlesztési szempontja, de mi van a Ghost Recon Future Soldierrel? Az is olyasmi eredményeket ad, mint a DiRT Showdown és semelyik partnerprogramnak sem volt része. A helyzet az, hogy a fejlesztőknek is a compute irány volt a lényeges, hiszen a Fermi erre ment. A GCN látták, hogy erre megy. Általánosan kimutatható volt, hogy az architektúrák compute hatékonysága nő. Az Intel a Gen7 architektúrát ebbe az irányba vitte. Az MS hozza a shader-trace interfészt, hogy egyre bonyolultabb compute shadereket lehessen írni, hiszen egyrészt kapják a fejlesztőktől az igénylést, és látják, hogy a GPU-k merre mennek. Ezek alapján ki gondolta volna azt, hogy az NV nem erre megy a Keplerrel ... valójában senki. Alapvetően a Kepler és a GCN különbsége nem nekünk okoz nagy fejtörést. Persze a kasszánál is gond, hiszen nehéz dönteni. De képzeld el a fejlesztőket, akik követték a napnál is világosabb trendet, és jön egy architektúra, ami hirtelen felrúgja azt. Na az ő helyzetük nem könnyű ... a Ghost Recon Future Soldier esetében azt választották, hogy hagyják a GI effektet úgy ahogy van. Ha lassú lenne, akkor majd a felhasználó kikapcsolja. Valószínű, hogy nem csak ők követik ezt az utat. Persze ott van ellenpéldának a BF3, amiből kivették a compute shaderes extra effekteket, de ez csak elővigyázatosság volt, mert maga a motor működése nagyon épít az LDS terhelésére. A Kepler kipróbálása nélkül lehetetlen volt megállapítani, hogy mennyire rázná meg a terméket, ha a Tile-based deferred acceleration mellett még mondjuk egy HDAO is ostromolná az LDS-t. Mivel a Tile-based deferred acceleration nagyon a működés része, és DX11 alatt ki sem kapcsolható, így nem ártott ügyelni erre. Gondolom az NV korábban megmondta nekik, hogy úgy csinálják a rendszert, hogy a Kepler a Fermi shared memory tempójának a harmadára képes. Ma már lehet, hogy másképp alakul a dolog, hiszen van mivel tesztelni. 2011 őszén nem volt.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Löncsi

őstag

válasz

Firestormhun

#10772

üzenetére

Firestormhun

#10772

üzenetére

Ez hülyeség, a motorok nem fejlődnek visszafele. Cryengine 3 is elég jól néz ki és hatékonyabb. [link]

Pl. HD4850-en egy Crysis 2 jobban festett mint egy Crysis 1 High-on. Csak ciki, hogy a VGA-k is fejlődnek, így egy GTX460-on a Crysis 1 már sokkal ütősebben néz ki max-on. Crysis 2-ben már nincs előnye lévén a grafika limitálva lett.

Chrome Engine amúgy nagyon jó, Unreal Engine-hez ez áll a legközelebb hatékonyságban, jó lenne ha több gém is ezen futna.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

fatallerror

addikt

-

Löncsi

őstag

válasz

fatallerror

#10775

üzenetére

fatallerror

#10775

üzenetére

Igen, persze, de ha megnézed sok olcsó megoldást tartalmaz (szaturáció, egyszerűsített víz stb..)... Crysis 1-ben ilyen nincs.

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

fatallerror

addikt

válasz

Löncsi

#10776

üzenetére

Löncsi

#10776

üzenetére

jó de nem szakmai szemmel kell nézni, lényeg h összképet nézve elég pofás (meg ugye ez asszem nem pc-s) de semmit sem fog érni ha nem lesz jó a sztori

ezt már írtam korábban h a legtöbb játék grafikailag már rendben van és onnantól a sztori meg a játékmenet az amitől tényleg jó lehet

meglesz az új gépem tuti végigtolom maxon is a crysis 1-et

ha egyéltalán a gtx 660as szint bírja, 10 nap és olvashatjuk a ph-s tesztet

don't tell me what i can't do!

-

Löncsi

őstag

válasz

fatallerror

#10777

üzenetére

fatallerror

#10777

üzenetére

De ehhez szakmai szem sem kell... 6:30-tól kezdve nézd a vidit... minden csillog, mintha kötelező lenne neki, ez egy olcsó húzás, és ezt az Unreal Engine 3 is tudta 2007 óta, magas FPS szám mellett. Persze jól néz ki, de nincs sok köze annak ami a motorbemutatóban látható, pl. víz.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Löncsi

őstag

válasz

fatallerror

#10779

üzenetére

fatallerror

#10779

üzenetére

Nem zavar, de itt van egy _2007_-es játék: [link]. Ez ugyanúgy csillog mint a Crysis 3, a GTX460 meg annyira unatkozik alatta, hogy levált néha low-3D módba, 60FPS mellett.

Crysis 1-ben ott a sűrű növényzet + komoly AO + részletes víz, ilyet nem fogsz látni Crysis 3-ban.Warhead egyik nagy pillanata, pl. amikor a sűrű, interaktív erdőből lesétálsz a szuper-realisztikus, naplementés tengerpartra és hallgatod a hullámokat. Crysis 3-ban lesz 3 fa, meg ilyen 2D-s víz (mint BF3-ban).

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

ricshard444

veterán

válasz

fatallerror

#10781

üzenetére

fatallerror

#10781

üzenetére

Nekem csak az elethu toresmodell es,hogy 2007tol a Crysis megjelenesevel megkezdodik a grafika ugrasszeru fejlodese....mindketten tevedtunk

Vannak dolgok...

-

Löncsi

őstag

válasz

fatallerror

#10781

üzenetére

fatallerror

#10781

üzenetére

Jó, de amit WH-ban látsz az meg van valósítva. Crysis 3 amolyan jó, de láttam már ilyet kategória nálam mindössze...

Fizikát én is szeretnék jobbatt, pl. Cryostasis benchmark, ott pl. a vízszimuláció elég ütős.

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

fatallerror

addikt

válasz

ricshard444

#10782

üzenetére

ricshard444

#10782

üzenetére

én a legjobban az emberek fizikájától "akadok" ki nem a környezetétől.... semmi izommozgás, valós mimika meg hajmozgás, az öltözék még mindig rávan öntve az emberre.. én azt hittem 6-7 éve h 2012re már kaphatok sárgalapot túlzott gólörömért mert levettem a mezt de nem tudja levenni mert az a teste xDD

don't tell me what i can't do!

-

Firestormhun

senior tag

válasz

Löncsi

#10774

üzenetére

Löncsi

#10774

üzenetére

Mondjuk későbbi hozzászólásokban cáfolod saját magadat, de mind1 leírom azért.

Bizony jó pár engineben előfordultak olyan dolgok amelyek egyértelmű visszalépést jelentettek, persze ez nem jelenti azt, hogy esetleg más részén ne történt volna előrelépés!

Pár példa ilyen design döntésekre:

- Lithtech Jupiter EX engine: Emlékszünk F.E.A.R. 1-re? Kedvenc benchmark játék X1000, GF7 széria idején. Önálló fényforrásként szerepló torkolattűz és robbanáseffektek és az ehhez kapcsolódó volumetrikus árnyékolási rendszer? Elsütötted a fegyvert vagy felrobbant valami, akkor a körülötte lévő objektumok is árnyékot vetettek annak megfelelően. Na ezt a rendszert FEAR 2-ból kikukázták mert Xenos rettentő gyenge stenciles árnyékok kezelésében. PC természetesen jó lett volna hozzá. Megkapták a PC-sek? NEM.

- Anvil(Scimitar Engine): Assasin's Creed 1: DX10 illetve DX 10.1 használata, sebesség javításra, illetve AA-hoz. Először NV majd, ATi környékezte meg őket. AC 2-nél már egyik se, nézzünk egy interjú részletet pcgameshardware.de-ről!

PCGH: Assuming that Assassin's Creed 2 will support DX10 too, will the DX10 visualization differ substantially from the graphics that are rendered with DX9 hardware or will DX10 just speed up the rendering process? If there are special DX10 visuals, what are the graphical features that can only be rendered with shader model 4.0 hardware?

David Champagne: Assassin's Creed II has no specific support for DX10

PCGH: Will Assassin's Creed 2 support DX11?

David Champagne: No.

PCGH: Why do you decide against supporting DX11? Would the integration of the API into the renderer have consumed too much developing time? Are there any plans to patch in DX11 support later?

David Champagne: We are using the same rendering engine as the Xbox 360 version which is based on DX9. Integrating DX11 in our renderer would have definitely been too much time-consuming given our release date.

PCGH: Your Games does still support Windows XP and the DX9-API. When do you think game development will be at a juncture where it's more viable to put all the effort into one rendering-path using only DirectX 11 (with downlevel-paths) and drop support for XP?

David Champagne: I guess when most of the gamers will have switched to DX11.

According to Steam HW Survey, 40% of the gamers are still playing under Windows XP. I think we'll have to wait a bit...

According to Steam HW Survey, 40% of the gamers are still playing under Windows XP. I think we'll have to wait a bit...No comment.

Chrome Engine: 3-mas legutolsó verziójában DX10, streamout, geometry shader support. 4-es verziónál újraírták az egészet de se híre se hamva újabb DX verzióknak, csak DX9 render path ezúttal is.

Cryengine: 3. verzióból kezdetekben hiányzó POM, hiányzó volumetrikus felhők és az igencsak sokkoló cubemap reflections (szétfeszített statikus bitkép a tükröző felületeken). Ha NV nem fizet nekik 2 millió dollárt, lehet nem lett volna semmi DX11 és highres textúra csomagból.

...

-

Löncsi

őstag

válasz

Firestormhun

#10785

üzenetére

Firestormhun

#10785

üzenetére

Az, hogy mit tud a motor és mit látsz a játékban, két külön dolog.

Cryengine 2 óta van parallax, ezt később sem vették ki, Cryengine 3-ban is van natív DX11.[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10785

üzenetére

Firestormhun

#10785

üzenetére

A F.E.A.R. példák rosszak. Az első rész után a kettőben megváltozott a render. Amit az első részben használt azt kukázták, de helyette áttértek a Valve-féle Ambient Cube rendszerére, vagyis az új játékba épített megvilágítási modell jóval modernebb volt. Tehát összességében előrelépés volt. Az első részben használt SH (spherical harmonics) modell sok memóriát evett, és nem mutatott jól specular mapok mellett. Ezt lecserélni az Ambient Cube megoldásra nem volt rossz ötlet.

Az Assasin's Creed 1 esetében valóban tartalmazott egy hibát a DX10/10.1-es kód. Ezt persze lehetett volna javítani is, de inkább a DX10/10.1 törlését választották a fejlesztők. Tervben volt a javítás utáni visszarakás, de nem történt meg. Akkor a Gaming Evolved program még nem létezett, szóval nem volt támogatás az AMD-től, hogy visszakerüljön. Az NV meg hülye lett volna támogatni a visszarakást, hiszen nagyon jó példa volt arra, hogy a DX10.1 milyen értékes.

Az Assasin's Creed 2 esetében már eleve nem döntöttek a DX10/10.1 implementálása mellett. Igazából ezzel nincs gond. A fejlesztőnek joga van ezt eldönteni.A Chrome 4 esetében a DX10 eleve nem volt tervben. A 3-ban azért volt DX10, mert sok dolgot azzal lehetett hatékonyan megoldani. A 4-es motorban már alapvető változások voltak, így elég volt a DX9 is. A legújabb Chrome 5 már támogat DX11 kódot is. Aki licenceli ezt a motort nyugodtan építhet rá, ugyanakkor ez a kódbázis csak gyorsít, de a DX9 is elég gyors, szóval a Techland nem vetette be az eddigi játékokban.

A CryEngine 3-ból sosem hiányzott semmi, amit a 2 tudott. Egyszerűen a Crysis 2-höz nem használták fel. Nem ritka, hogy egy motor sokkal többet tud annál, mint amennyit kihasznál a rá épülő játék. Ez nem a motor problémája, hanem a fejlesztő hanyagsága. A Crysis 2 iskolapéldája, hogy mit nem szabad csinálni, de ettől a CryEngine 3 nem lett rossz motor, vagy visszalépés, csak a Crysis 2-nél meghozott értelmetlen és technikailag megalapozatlan fejlesztői döntések miatt tűnik annak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Löncsi

őstag

QuakeCon 2012 Carmack. [link]

Vége fele lehet megnézni a közönséget, elképesztő milyen kevesen voltak rajta, tavalyihoz képest elég lesújtó az egész.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

huskydog17

addikt

válasz

Löncsi

#10788

üzenetére

Löncsi

#10788

üzenetére

Én csak az első órát hallgattam végig, de abból sem értettem olyan nagyon sokat, mert a szóbeli angolom nem olyan jó, de abban az egy órában megértettem pár érdekes dolgot.

Nagyon kíváncsi vagyok, hogy vajon Abu végignézte, vagyis végighallgatta-e a teljes elődadást és hogy mi a véleménye róla.

#10790: Igen, arra a részre én is felfigyeltem. Akkor lehet, hogy pont fél óra után kezdett beszélni részletesen a Tech 4-ről, elég sok technikai dolgot mondott róla.

[ Szerkesztve ]

Gameplay csatornám: https://www.youtube.com/channel/UCG_2-vD7BIJf56R14CU4iuQ

-

Löncsi

őstag

válasz

huskydog17

#10789

üzenetére

huskydog17

#10789

üzenetére

Én max felet, de csak absztakt, általános dolgokról beszélt, ami tetszett azaz, mikor megemlítette, hogy egy játékmotor ma már sok esetben fejletebb/komplexebb mint a NASA által használt algoritmusok amikkel Holdra szállnak...

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

fatallerror

addikt

válasz

Löncsi

#10788

üzenetére

Löncsi

#10788

üzenetére

jól van lehel nem kell pánikolnod, egyre gyakrabban "félted" a pc-s játékipart, nem fog megszűnni mert rohadtsok pénz van benne és bármit megtesznek azért h fentmaradjon... szóval nem kell aggódni mert kevesen voltak itt : D ilyenkor még a kockák is strandolnak meg olimpiát néznek ezért nem voltak : P

don't tell me what i can't do!

-

Löncsi

őstag

válasz

fatallerror

#10791

üzenetére

fatallerror

#10791

üzenetére

Engem nem izgat, én elég keveset játszom, BF3 inkább a húzóerő. Amiket leírtam, tény, Crysis 1 óta igyekeznek spórolni a grafikán, ezt lehet látni, ennyi. Carmack is bebukott a RAGE-el, emiatt sajnálom kissé.

De ez elég jó, Carmack is elég lelkes. [link]. Van egy hosszabb vidi is amiben működés közben is látni, de nem találom most.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

fatallerror

addikt

válasz

Löncsi

#10792

üzenetére

Löncsi

#10792

üzenetére

már 1x elmagyarázták h miért akadt meg a grafikai fejlődés, abu is ecsetelte párszor :]

de megfogják oldani mert ha megszűnnének a játékok és nem költenének több 100ezret gépre az emberek annak a hw gyártók nem örülnének szóval addig pénzelik a játékfejlesztőket míg leküzdik az api akadályaitegyre több "teszteredmény" jön a gtx 660 ti-ről és állítólag alig lassabb mint a 670 szóval elég nagy a kuszaság az nv-nél ha ez tényleg így is lesz

don't tell me what i can't do!

-

Löncsi

őstag

válasz

fatallerror

#10794

üzenetére

fatallerror

#10794

üzenetére

De az API annyira nem korlátozó tényező. Egy 8800GT hozza a konzolok szintjét könnyedén (~720p, noAA, 30fps), PS3-ban pedig van egy 7800GT variáns, ergó 1 generációt tud a konzol hozni maximum... ez nem sok.

Persze az AMD-nek valamit erre be kellett böffentenie a "nem kell DirectX..." című kirohanása ismert... ugyan, hagyjuk.

Ja és ha tudod a nevem, jelöljé be fészen.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10795

üzenetére

Löncsi

#10795

üzenetére

De az API nagyon korlátozó. Igazából csak azért van értelme, mert sok hardvert lehet vele támogatni. De ezért nagy árat kell fizetni.

A másik korlátozás a művészi munkához szükséges erőforrás. Ez is nagyon véges.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Löncsi

őstag

Jó, és mi lesz helyette ? A HSA ? Elvileg grafikus része még nincs, nomeg fog az futni egyáltalán pl. nVidia hardveren ? Kompatibilitás lesz, azaz a régebbi DirectX játékok futnak majd ? Sok a kérdés.

Szóval nekem ez kissé ilyen kocsmai nyilatkozat volt, több konkrétum is jöhetett volna. Nomeg az AMD is szerette magát fényezni a DX11-es hardvereivel, most meg akkor dobjuk ki.

Ott az Unreal 4/Samaritan demo is, lehet látni a potenciált a DirectX-ben.

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10797

üzenetére

Löncsi

#10797

üzenetére

Technikailag megoldható a HSA az már elég low-level felület, de nem a grafika az elsődleges célja, ezért sincs grafikus futószalagja, persze ilyet bármikor lehet írni, de az elsődleges cél sosem lesz ez.

A HSA az egy független felület. Bármin fut, csak írni kell rá finalizert és kernel drivert az adott hardverhez.

Miért kellene megszüntetni a legacy DX támogatást? Az OpenGL is el van mellette.

Egyébként a legjobb megoldás az a DX API hardverhez közelibbé válása. Ez már a DX11.1-gyel elkezdődött. A gyártók egyéni kiterjesztéseket írhatnak az alap specifikációk mellé.Richard Huddy csak szerette volna megtudni, hogy a fejlesztők mit gondolnak az API eldobásáról. Nyilván sok fejlesztőt megkérdezett, de az összeset nem, és ennek a legjobb formája, ha teszel a sajtóban egy kijelentést, aztán figyeled a dev. fórumokat. A leírt problémát ténymegállapítások voltak. Ettől az AMD nem akarja az API-t eldobni, csak kíváncsi volt a reakciókra. Ennek tényleg az egyik legjobb módja a sajtó kihasználása.

És ki lesz a befektető? Az rendben, hogy ha kap a csapat három évet, hogy csináljon egy olyan utcasarkot, ami a Samaritan demóban van, akkor ilyen grafikát ma is lehet csinálni, de ki ad nekik három évet, amikor egy teljes játéktérre max. 2 évet szoktak adni? Ez persze nem az API problémája, hanem a felhasznált eljárásoké, amelyek idejétmúltak lettek a művészi oldalon. Carmack ezért erőlteti megatextúrázást, mert látja, hogy lassan nem a hardver teljesítménye a grafika fejlesztésének legfőbb mozgatórugója. Nagyon sokat tudnak a hardvere, és nagyon gyorsak, de nincs pénz/idő ahhoz, hogy ezt a művészi oldalon grafikába öntsék.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Löncsi

őstag

Jó, de én arra céloztam, hogy egy "ócska" GTX680-on valahogy elvánszorog egy látványos Unreal Engine 4. Ez nem rossz és ez DirectX alatt fut, erre nehéz rámondani, hogy korlátoz (persze biztos van overhead, de épp emiatt lehet cserélni a kártyákat és ez fontos plussz).

[ Szerkesztve ]

Elvették a radírját, azt az egész élete egy nagy kompenzálás, hogy ő igenis kan és igenis 2 méteres a fallosza - by stranger28

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10799

üzenetére

Löncsi

#10799

üzenetére

A korlátozás elviekben keletkezik. Azt kell nézni, hogy 60 fps mellett mennyivel több rajzolási parancsot kezelnek a konzolok.

Az Unreal Engine 4-nek pedig van még pár problémája. Ha a konzolok nem kapnak 8-16 GB rendszermemóriát, akkor mindenképpen kell egy más megoldást találni a GI implementációra. Ezért is készült el az UE3 továbbfejlesztése, mert egyelőre az Epic sem biztos abban, hogy imáik meghallgattatnak.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Interactive Brokers társalgó

- Vodafone mobilszolgáltatások

- AMD GPU-k jövője - amit tudni vélünk

- Külpolitika

- Hardcore café

- Leáll több iCloud funkció a régebbi iOS verziókon

- Vodafone otthoni szolgáltatások (TV, internet, telefon)

- Házimozi haladó szinten

- Red Dead Redemption 2 (PC)

- Autós topik

- További aktív témák...

- AMD RX 7900 XTX 24GB EKWB EK-Quantum Vector 2 D-RGB Nickel + Plexi Vizesblokkal Garancia!

- MSi ventus RTX3060ti doboz,garancia,beszámítás is.

- Sapphire Pulse AMD Radeon RX 6600 8GB használt videókártya eladó garanciával!

- ASUS RTX 4070 Ti SUPER 16GB TUF Gaming OC videokártya (TUF-RTX4070TIS-O16G-GAMING) - 3 év Aqua gari

- ASUS AMD RADEON RX 6700 XT 12GB videókártya

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

According to Steam HW Survey, 40% of the gamers are still playing under Windows XP. I think we'll have to wait a bit...

According to Steam HW Survey, 40% of the gamers are still playing under Windows XP. I think we'll have to wait a bit...