Új hozzászólás Aktív témák

-

djculture

félisten

Nekem is az. Viszont másnak nem volt és nem örültem mikor a tizedik helyre kellett elcammognom ahol megint ugyanez a hiba volt. Sőt volt aki előtte már felhívta a Magyar Telekomot ahol egyből ezzel jöttek hogy a Microsoft szarta el, rengetegen hívták őket. De világméretű dolog volt, neten is panaszkodtak rengeteg helyen. Nem jöttem rá miért mert kb minden gépben realtek hálókártya volt az enyémben is de még se rohadt le az én gépem, másoké viszont igen.

-

djculture

félisten

Nemcsoda ha ilyeneket művelnek hogy kiadnak egy frissítést ami kilővi a hálózatot több millió számú win10-es gépen. Utána kiadnak rá egy javítást, de egy hozzá nem értő hogy a faszomba fogja letölteni a javítást net nélkül.

Pistike nem engedhet meg magának hasonló szarságokat mint amit mostanában művelt ezt Microsoft bagázs

.

Ez nem az első volt már hang driverrel is ugyanez. Menekülnek az emberek a win10-töl a hasonló hülyeségek miatt. -

FLATRONW

őstag

Köszönöm, de még várok az árcsökkenésre is, és reménykedem a Steam-es kiadásban is. Azonban ha olcsóbban belehet majd szerezni a Store-ban és a remény is elfogy a Steam-es kiadásra (10-15 euro), akkor lehet hogy szavadon foglak.

Egyébként ez hogyan működne a Store esetén? Van valami ajándékozási lehetőség, mint a Steam-en? -

FLATRONW

őstag

válasz

djculture

#169

üzenetére

djculture

#169

üzenetére

Én is reménykedem, hogy lesz belőle Steam-es kiadás, mert jónak tűnik. Felőlem maradhat csak DX12-es is.

Talán még az Áruházi verzió is érdekelne, de nem tudom beszerezni, mert nem használok bankkártyát az internetes vásárlásokhoz. Steam-en is paysafecardot használok, az Áruházban nincs rá lehetőség. -

djculture

félisten

válasz

FLATRONW

#168

üzenetére

FLATRONW

#168

üzenetére

Majd lesz belőle nyugodj meg, kutyának se kell a winstore verzió. Érdekes quantum break-nél is ez volt sose lesz más platformon, aztán lett.

Jellemző a helyzetre hogy tegnap két több ezres követővel rendelkező youtube-rnek irtam a live-ja alatt hogy ezek a játékokat nem nézik meg. Válasz: winstore verzió nem kell volt mindkettőnél, egyiknél win10 sincs mert egy csomó program amit használ rosszul működik alatta. Másiknál zozeatyánál meg win7-van ezért nem fog új windows-ot venni. -

Abu85

HÁZIGAZDA

Nem kell a nulláról nekiállni. A motorstruktúrát kell megváltoztatni. A Civ 6 esetében ez kényelmes, mert nekik már a Civ 5-nél is megfelelő volt a motorstruktúrájuk. Csupán azért, mert ott még deferred contexttet használtak. Ma már ezt nem használják, de ettől a motorstruktúra megmaradt olyannak, hogy az explicit API-khoz helyből megfelel. Másképp egyébként nem lehet az API-t beépíteni, szóval minden olyan motor, ahol van explicit API, legalább annyira fejlett, hogy az iRender a DX12-re szabott. Ellenkező esetben 5-10 fps lenne mindenen a DX12 teljesítménye.

-

Abu85

HÁZIGAZDA

válasz

FLATRONW

#150

üzenetére

FLATRONW

#150

üzenetére

Tévedés. A Microsoft az UE4-gyel több API-t támogat. Csak nem engedélyezik mindet a végső programban. De ettől a motor támogat három API-t: D3D11, D3D12 és az Xbox One D3D12 mono felületét.

(#148) b.: De ennek oka van, hogy miért hiányzik. Nem tudnak belenyúlni a zárt kódba, így nem tudják futtatni azokat DX12 alatt. Az NV pedig nem készített hozzájuk még stabil DX12 implementációt. Egy csomó DX12-es játékba úgy raktak például HBAO+-ot, hogy nem DRM-ezték le. Ezzel van gondja a GameWorks-nek DX12 alatt. Nem működik a DX11-hez szabott DRM, így nem lehet az effektet feketedobozként beépíteni. A Division fejlesztői pedig leszarták, egyszerűen nem foglalkoztak azzal, hogy DRM-mmel szívjanak, hanem egyszerűen kihajították az effekteket.

Az Ubinak nem ez az első ilyen húzása. A Far Cry Primal megjelenését azért tolták el egy héttel, mert pont akkor járt le a szerződés, és az összes tervezett GameWorks effektet kihajíthatták belőle. -

Abu85

HÁZIGAZDA

A DX12-nek különösebb jelentősége itt nincs. Ez csak egy API. A motort lehetett tervezni a Mantle-re is, nem véletlen, hogy 100+ stúdió kérte a hozzáférést, mert később egyszerű cserélni a back-endet akármelyik API-ra. DX12 vagy Vulkan itt már teljesen mindegy. Kinek melyik a kézenfekvő.

Máig sokan megtartották a Mantle back-endet, noha nem használják csak tesztelésre. Ennek az oka, hogy az AMD itt teszteli le az új konzolokba épülő funkciókat, és ezzel a fejlesztők azonnal hozzáférést kapnak ezekhez PC-n. Tehát már azelőtt felhúzhatják rá a motort, hogy a DX12/Vulkan hozzáférés megérkezne. Amint ezek megjönnek back-end csere és profit.

-

Loha

veterán

Mondjál példát mire gondolsz, mert egy vadi új motorra épülő játék fejlesztése kb. 5 évvel a megjelenés előtt kezdődik, ezért nem is gyakran csinálják.

Hol volt 5 éve a DX12?

Egy játék jut eszembe ami vadi új motorra épül, és van benne DX12 is:

Tom Clancy's The Division

Kifejezetten az új konzolokat célozták meg vele, meg persze a DX11-et, olyan 2011 tájékán.Abu85: Ne fárasszál már a Mantle-lel pls.

-

Abu85

HÁZIGAZDA

Az UE4 már beért. Régen. De a PC-s leképzője olyan szar, hogy bottal nem piszkálják meg a fejlesztők. Mindenki újat ír, aki UE4-et használ és PC-s portot is kiad. A mobilra és a konzolokra szánt leképező jó (na jó a konzolos csak elmegy), illetve most írnak egyet direkt VR-re. Egyedül a normál PC-ssel nem törődnek, mert az már nem piaci tényező. Szóval az UE4-nek semmi baja már most sem, csak nem PC-re való. De persze jó hír, hogy a 4.14-es verzió hozott PC-s újdonságokat, mint a DX12-es async compute, illetve async DMA. De a nem törődés itt is látszik, mert mindkettőt csak a GCN-ekre korlátozták. A többi architektúrára egyszerűen nem éri meg dolgozni, akkor sem, ha támogatják a funkciókat. Ezeket a funkciókat is csak konzolról portolták le.

-

Loha

veterán

"Mindent meg kell írni DX11-re is, ami plusz meló."

A gyakorlatban a legtöbb játék már meglévő játékmotorokat használ, sok éve finomított DX11-es leképezővel, amit nem írnak meg újra, csak finomítanak rajta, ahogy az egész motoron is, viszont a DX12-es leképezőt a nulláról kell megírni, ami nagyon távol lesz elsőre az optimálistól, és extra munkát jelent.

-

Azért az több volt annál. [link]

[link]Visszavettek valami oknál fogva, no offense, de lehet úgy gondolják, hogy nem lesz veszélyes a Vega rájuk 2017 ben sebesség szempontjából, vagy majd megint menni fog a kapkodás, mint most a 470 megjelenésekor

Vannak olyan pletykák is, hogy várják a konkrét infót a top Vegáról és ahhoz lövik be a 1080 Ti órajeleit. Mindegy is,csak versenyezzenek, abból mi csak nyerhetünk.

Én Nv párti vagyok, de ha arról van szó, váltok Radeonra, de eddig nem igazán voltam, vagyok rákényszerítve+

, 480-470 megjövetelekor is gondoltam, hogy lesz rá válasz. -

Már jó ideje tudni erről, szerintem a fanok hype-olták szénné ezt a 2017-es Volta eljövetelt. Ha figyelmen kívül hagyom az infókat, józan paraszti ésszel sem látom reálisnak, hogy csupán egy évvel a Pascal után máris jön a Volta. Ez az idei Volta kb olyan legenda, mint a hamargyors DX12 megváltás.

Ha folytatódik pl a Deus Ex esetén látható tendencia, akkor a Pascal is gondban lesz. A DE motorjánál már a fejlebb említett új struktúrát használják, azaz elkezdték kihasználni az új API-ban lévő lehetőségeket. Persze nem innék rá mérget (ahhoz GPU-programozónak kéne lennem), de szerintem folytatódni fog az egyre durvább különbség DX11 és DX12 között NV-n. Persze erre lehet azt mondani, hogy minek a DX12, ha ugyanígy néz ki, és nem lassul. Ez felhasználói szemszögből teljesen jogos, csak ilyen elfelejtődik az, hogy a játékokat fejlesztők készítik, s számukra az explicit API-k olyan előnyöket kínálnak, melyek miatt hamarosan kukázni fogják a DX11-et.

A Vulkannal jó kérdés, hogy mi lesz. Egyelőre AAA-ból a Doom támogatja, aztán ennyi. S ott is csalnak, mert ugye (hogy Abut idézzem) GCN csőlátással készült. Mert amúgy az NV nem lenne akkora hátrányban, mivel a Vulkan API-ban nem léteznek azok a problémák, melyek miatt az NV a DX12 alatt lassul. Ergo, lehet az NV-nek kéne nyomnia a Vulkant. Főleg, hogy nem Windows 10 only.

-

Utoljára még az volt, hogy idén nyáron már bemutatják a felsőházat a Voltából. Mégis eltolták?

ÉN örülnék a teljes Dx 12 nek, már rég WIn 10 van a gépemen, megszoktam,sőt ,szeretem is.

Úgy látom és gondolom, hogy jelenleg a Pascal sem fog még szégyent vallani dx 12 alat, egy élvezhető sebességet tud letenni még jó darabig,tehát ez miatt sem aggódok.

Sajnos a többivel( kiadók) nem igazán lehet mit kezdeni. Én 2016 ban 2 darab megvásárlásra érdemes "A "kategóriás játékot találtam magamnak, és ezen az sem segít, ha dx 12 vagy Vulkan, mert sajnos jobb nem lesz tőle egy játék sem.( Szerencsére Indie címekben más a helyzet)

Nagyon remélem, hogy Vulkan is elkezd terjedni erősen, Unreal 4 is beérik és elterjed, és akkor végre ennyi év egy helyben toporgás után történhet valami érdemi változás is. -

ceripapa

aktív tag

Én ahogy nézem csak egy pimpelt

Pascal jön, de ez így is szokott lenni :]

Pascal jön, de ez így is szokott lenni :]

1. év: Fő széria -> uj arcihtektúra

2. év: architektura updateAz ember úgy is úgy fog választani majd hogy :

1, mennyibe kerül a kártya

2. mennyit tud

3. gyártó

4 fanboy -e

fanboy -e

Majd okt-nov végignézek a piacon :] akkor érik a váltás 380-ról. előtte 660 volt 3 évig :].

-

FLATRONW

őstag

Mondjuk a Gears of War jól sikerült és csak DX12-es verziója van.

-

Mindent meg kell írni DX11-re is, ami plusz meló, hisz két alacsonyszintű leképezőt kell írni (legalábbis jobb esetben így csinálják). S ugye a DX12 minden esetben kisebb a prioritással készül, patch formájában utólag rakják bele a játékokba. Mondjuk ez is jobb, mint a semmi, de gyakorlatban rossz PR a DX12-nek, mert semmivel sem szebb (sőt), és nem hozza azt a gyorsulást, amit elvárna az ember.

Szerintem a gond nem az NV, hanem a kiadók. Nem mernek csak Win 10-re kiadni játékot, így komolyabb pénz se költenek fejlesztésre. Persze ez idén szerintem változni fog, már 50% az új windows részesedése, lehet majd akár only DX12 játékokat is hozni, ahol minden erőforrást az új API-ra fordítanak.

A Volta idén még nem lesz, inkább jövőre. Picit később, mint az első SM 6.0 játékok várható startja. Ami amúgy nem rossz időzítés, feltéve, hogy a Volta tudni fog olyat, nagyon reméljük.

-

-

-

ceripapa

aktív tag

Ez volt eddig ahogy Abu leírta hogy a nv drivereknel használtak Fast Path opciot. Az h maxwell, Pascal meg nem olyan okos h dx12 részeit kell h emulalja az nemhiszem h az AMD hibája . Évek óta erről szól a fáma hogy a dx12-Re mi kell + még igy is kedveztek az nvnek. Sztem nem hittek h olyan hamar befut a dx12.

-

Jack@l

veterán

-

djculture

félisten

Csak egyre kevesebb embernek kell diszkrét vga az marad ki az elméleti fejtegetésből. A diszkrét vga üzletág döglődik, ebben az évben is tönkrement legalább 3 gyártó. Jó vége nem lesz ennek a folyamatnak. Biztos hogy a fejlesztések lefognak lassulni az árak meg az egekbe mennek. Még akár az a csúfság is megeshet pár év múlva hogy vga cserekor ugyanazon teljesítményért két háromszor többet kell fizetni majd mint a cserélt darab újkori ára..

-

távcsőves

senior tag

Értem már, egyik esettben a 3 fps a kerersztbe húgyoza kategoria, másik esetben semmi. Köszönöm uraim. Keresetek tesztet, van bőven, elég beírni relive bench a googleba.

-

válasz

távcsőves

#129

üzenetére

távcsőves

#129

üzenetére

Elfogyott az előnye? Divisionba van 3 FPs előnye dx 12 alatt a 480 kártyának. EZ azért nem megváltás egy egy árú kártyától. Ha ez lesz a Dx 12 csoda akkor megint csak nem az NV tulajok voltak megvezetve. Erre a 7-10 % gyorsulásra megy a hajcihő évek óta, ami még az első morzsákban kb 50-60 % volt.

nem nem akarok NV AMD vitát, de ez a realizmus, igaza van a feletted szólónak.

Ettől függetlenül jó kártya a 480, de nem kell kikiáltani megváltónak. -

-

Van a piacon 50 játék,amiben meg fordított a helyzet. Mindegy is. Dx 12 játékoknak van dx 11 módja, egy játék meg nem szebb és nem jobb mint ha dx 11 alatt játszanál, ez sajnos nem ugyan az a szitu, mint volt dx 9-10 esetében. meg ahogy nézem az miatt a plusz 3 fps matt az 1060 nak nincs szégyenkezni valója, dx 12 alatt sem. Nem egy megváltás semelyik kártyának.

Mindkét kártya egyformán jó vétel lehet, 1060 is és 480 is, ki mivel játszik. -

nonsen5e

veterán

válasz

djculture

#123

üzenetére

djculture

#123

üzenetére

Több oldal több tesztjét is megnéztem, van játék (főleg 3-4 évesek) előfordul, hogy a 370 jön ki győztesen, de az összegzésben ha kicsit is, de mindig a 460 van előrébb. DX12 tesztet meg nem láttam, amiben előrébb lenne a 370, ott mindenhol jóval előrébb volt a 460. Na meg még teljesítmény egyenlőség esetén is miért vegyek 5 éves GPU-val felszerelt kártyát, ami ahogy látjuk már egyre kevesebb támogatást kap, és bizonyára jóval előbb lép át a támogatása is legacy státuszba, mint az idén (tavaly) megjelent új fejlesztés.

A +10%-nyi teljesítménytöbbletet adó (nagyjából +10%-kal többe kerülő) 1050 sem fogja megváltani a világot. Pont ott van árilag ahol lennie kell. Az ár/teljesítmény mutatókért (mindennek) pedig lehet a JMF-ot szidni.

-

jedis

senior tag

válasz

djculture

#123

üzenetére

djculture

#123

üzenetére

Ha valaki tényleg a legújabb játékokkal akar játszani normális beállításokkal , ami minimum egy FHD felbontás, Medium/High vegyes grafikai minőségben, és kitétel, hogy az fps ne nagyon essen 25 alá, az tudja, hogy a belépő erre a szintre, egy RX470, vagy GTX1060 3GB, vagy ezekkel megegyező teljesítményű régebbi VGA. Az RX460 szerintem is harmat gyenge, de a 470-es, és a 480-as best buy, ahogy az újabb játék teszteket nézzük. Ezért nem tudtam hová tenni, hogy szerinted az RX széria elbaszott. Ok, a 460 talán, de a többi pont hogy nem.

Amúgy meg mivel kellene tesztelni a legújabb kártyákat, hanem a legújabb játékokkal. Vagy mindenki azért vesz új VGA-t, hogy a Krájzisz 1-el tolja ?

Amúgy meg mivel kellene tesztelni a legújabb kártyákat, hanem a legújabb játékokkal. Vagy mindenki azért vesz új VGA-t, hogy a Krájzisz 1-el tolja ?

. A DX12, és a Vulcan a jövő ! Tehát logikus, hogy a legújabb grafikus API-kkal készült legújabb játékokkal teszteljük őket. A DX11 lassan kezd majd kikopni, és ha tetszik, ha nem a DX12, és a Vulcan veszi át a helyét. Ez a lényeg.

. A DX12, és a Vulcan a jövő ! Tehát logikus, hogy a legújabb grafikus API-kkal készült legújabb játékokkal teszteljük őket. A DX11 lassan kezd majd kikopni, és ha tetszik, ha nem a DX12, és a Vulcan veszi át a helyét. Ez a lényeg.

-

djculture

félisten

Persze sőt a doomot is felhozhatod mert abban is jó minden más játékban meg gyenge mit a franc. Volt 460-om a r7 370-nél gyengébb dx12 alatt nem sokkal dx11-ben jó 20%-al. Ezek után nem mondanám hogy huh de jó 40-ért egy r7 370-nél (ami 7850-nek egy átnevezése) gyengébb kártya 4 évvel később. Rohadt szégyen egy produktum az a helyzet.

-

djculture

félisten

válasz

távcsőves

#119

üzenetére

távcsőves

#119

üzenetére

Én amit láttam a sapphire gyártotta novemberben, szerintem még mindig van ebből a chipből elfekvő készlet. Az rx eléggé elbaszott széria lett, mikor lett volna igény rá újdonságnak akkor hiánycikk volt a 480 utána a 470 kijött az is az volt hónapokig utána ugyanaz volt a 460-nal most meg kutyának se kellenek. Eleve 460 egy gyenge szar 40 ezerért. Még úgy is hogy mit ad isten kiszivárgott a chip nem használt részeinek a feloldási módja.

-

távcsőves

senior tag

Érdekelne a véleményetek, ha már szóba jött, hogy a gcn1 nagyon sokáig benne volt a kínálatban, nem lehet, hogy azért IS öregedtek szépen, mert MUSZÁLY volt vele foglalkozni? Kérek mindenkit, ne elhamarkodottan írjon, nem háborut akarok, csak bennem felmerült ez. Vagy az amd vs nvidia vagy radeon találgatosba kérdezzek erre rá?

-

válasz

kikikirly

#115

üzenetére

kikikirly

#115

üzenetére

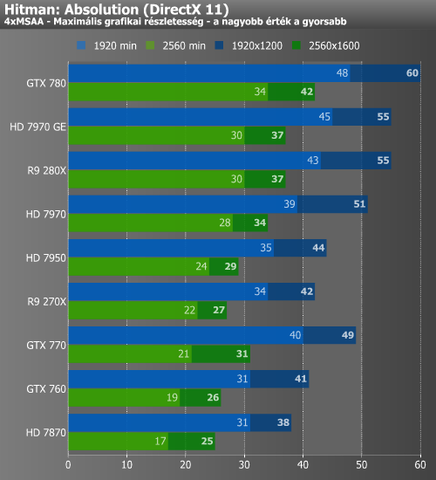

A GHZ edition egy külön kártya.azt azért adta ki az AMD mert a GTx 680 átvette a leggyorsabb egy GPU-s kártya szerepét a sima 7970 től. és itt hozzák igazából azt az órajelet, amit alapból szerettek volna a sima 7970 kártyának.PH teszt, bevezetőt olvasd el szerintem[link]

.Máshogy látjuk a dolgot, igazából parttalan vita. -

kikikirly

senior tag

-

válasz

kikikirly

#108

üzenetére

kikikirly

#108

üzenetére

A 770 GTX 2013 május a 280 X pedig 2013 október a megjelenés. tehát a 770 a 7970 ellen jött, akkor még nem volt 280x a piacon. rá fél évre mutatták be, és 8 hónapra lett valóban elérhető. A 280 x megjelenéskori tesztekben is gyorsabb volt mind a 7970 nél , mind a 770 Gtx nél.( itt a PH-n is kb 10% előnye volt.) De ez mindegy is, lehet úgy is rá tekinteni.

-

Abu85

HÁZIGAZDA

Jóval nagyobb különbség van a bekötési modell szintjei között. Ezt a Microsoft eleve azért választotta három szintre, mert eltérően működnek a GPU-architektúrák. A Tier_1 szinten a bekötést teljes egészében a CPU végzi el, igen komoly többletterhelés árán. A Tier_2 szintnél a GPU-architektúra a mintavételezőkbe tudja bekötni az erőforrást, és emiatt van többletterhelés a processzor oldalán. Végül a Tier_3 már magába a multiprocesszorba köti be az erőforrást, és ezért nem szükséges a processzor beavatkozása, mert ott van a szükséges adat, ahol lennie kell. A Tier_2 és a Tier_3 opciók az úgynevezett bindless szintek, de ezen belül is a Tier_3 pure bindless.

A mennyiségi különbség igazából csalóka, mert maga a rendszer úgy van kialakítva, hogy átfedhetők legyenek a szintek. Tehát ha mondjuk egy programhoz 100 UAV kell, akkor nem gond, hogy a Tier_2 nem támogat ennyit egy leírótáblában. A Tier_3 szinten létrehozol egy leírótáblát 100 UAV-vel, míg Tier_2 hardverekhez ugyanehhez létrehozol két vagy több leírótáblát. Effektíve a program működése ettől nem változik meg, csupán egy Tier_2 hardveren ezek a manőverek egyre nagyobb többletterheléssel járnak, azaz végeredményben egyre több processzoridőt igényelnek, ahogy a meghajtó menedzseli a létrehozott erőforrásokat tartalmazó leírótáblákat. Szóval az egész leírótáblás rendszere a DX12-nek rendkívül rugalmas, és igen sokáig lehet szimplán adagolni az extra leírótáblákat, mielőtt valami komoly, gyakorlatilag rendszerszinten jelentkező mennyiségi korlát felütné a fejét egy Tier_2-es hardveren. Számos mai játék működik így. Ha egy leírótábla nem elég a Tier_2-es hardvereken egy adott erőforráshoz, akkor létrehoz többet, nem probléma az egész, ezért tervezték ilyen rugalmasra. Arra kell csupán figyelni, hogy ezt azért nem szabad ész nélkül csinálni, mert Tier_2-es szintű működés mellett a processzornak ezek extra munkák.

-

távcsőves

senior tag

Köszi! Nem értem a rx460 vásárlók jó részét. Akinél befér a házba, rendelkezésre áll a tápegység, és játék miatt vesz dvga-t, lényegesen jobban jár vele. Hiába van lehetőség most már feloldani a teljes gpu-t, akkor is nagyon elmarad a nagyobb tesoktól és a konkurenciától (dx12-ben feljön a konkurenciára szépen). 35ezer kellene legyen az ára a 4gb-os duplaventis daraboknak.

-

Abu85

HÁZIGAZDA

Inkább egy R9 380(X). Az RX 460 lassabb. A GCN3/4 között az ISA szintjén nincs igazi különbség. Emiatt is tudja az összes új SM6 függvényt hardveresen kezelni a GCN3 is.

(#105) FLATRONW: Is-is inkább. Játékfüggő, hogy melyik, illetve milyen mértékben. Igazából a Kepler két ponton vérezhet nagyon egy játékban. Az egyik az ILP párhuzamosságra való optimalizálás hiánya, amivel elveszti a feldolgozók egy részét, ezt kibeszéltük. A másik pont az atomi műveletek, amelyben a GCN fényévekkel jobb volt az elején is, csak akkor még nem használták ki a játékok. Idén elkezdték kihasználni.

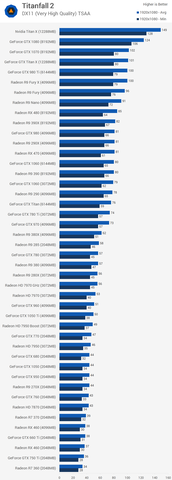

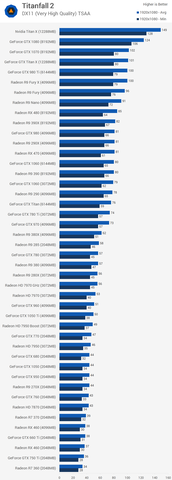

Van olyan játék is, ami épít az ILP párhuzamosságra, tehát segít a Keplernek befogni az összes feldolgozót, de a relatíve sok atomi művelet miatt mégsem teljesít jól. Ilyen például a Titanfall 2. Nyilván egyrészt dicséretes a fejlesztőktől, hogy nem hagyták teljesen magára a Keplert, de az atomi műveletek sebességével már nem tudnak mit kezdeni. Ott arra vannak utalva, hogy mennyire jó benne az architektúra.

-

kikikirly

senior tag

Javíts ki ha tévedek,de a 7970 ellenfele a 680 volt,és mint te is mondtad a 280X újra kiadott 7970GHZ edition,de ugyanigy a 770 egy újra kiadott 680 csak megemelt órajelekkel,tehát ugyanaz a felállás(GTX680: KG 104-400-A2 GTX770:GK104-425-A2 ugyanannak a GPU-nak másik változata, és Shader magok száma minden megegyezik kivéve órajelek).Az is elég feltűnő hogy a 280X és a 780 3gb között nincs ,pedig vagy 10-15 nek kéne lennie. 780TI-nak is a 290X előtt kéne ehhez képest a sima 290-től is le van maradva.Új Pascalos 1060 meg ott van ahol lennie kell...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Ez egyértelmű, hogy erősebb a 280 x, mindig is az volt, már megjelenéskor is hozott vagy 10% előnyt. A ram dolog azért említettem meg ,mert az abból bekövetkező lassulást ne írjuk az Architekturális hátránynak be.

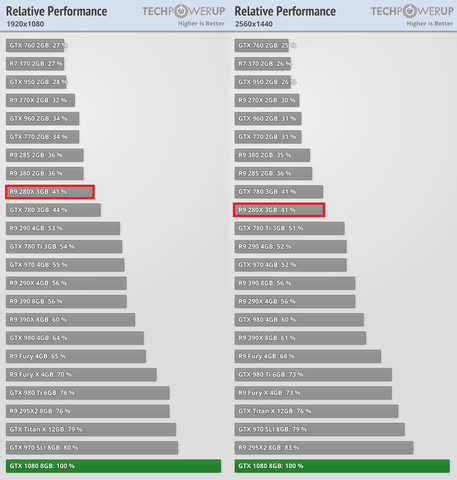

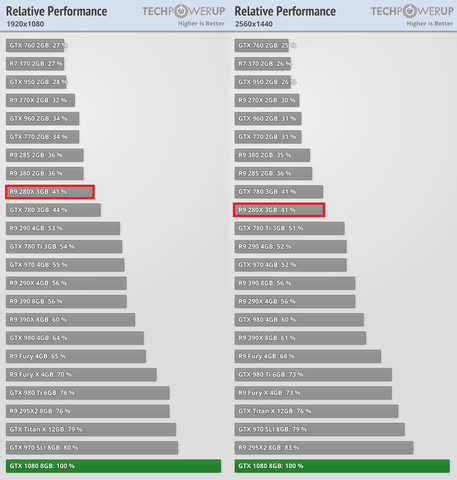

A Titanfall 2 nél értettem,a limitáló tényezőt ami 1440 P nél van,amit belinkelt.a kolléga a fent említett tesztben. Ott azért van 30 % különbség, mert a felbontás miatt (1440P) A ram akadályozó tényező volt. Közben megtaláltam ugyan azon az oldalon az 1080 P tesztet is és ott már nincs a 2 között 30 % közel sem, csak 15 %.

Félreértések elkerülések miatt mentem csak bele ebbe a vitába, mert ez a 7970 mennyire hasít és a 770 már sehol nincs szöveg erősen túlzó volt, ráadásul a kompetens írta a cikket.

Egyébként pedig a 770 ellenfele nem a 280x volt, hanem a 7970. Tudom hogy ez annak az újra kiadása, de gyorsabb volt annál. -

füles_

őstag

valamint egy 770 4 GB kártyával illene tesztelni 1440 P ben , hogy lásd az architekturális előnyt nem pedig egy 2 GB verzióval ami alapból megfekszik még FHD alatt is nem hogy 1440 ben.

Nem akarok beleszólni, de tudtommal 770-ból az "alapverzió" a 2GB-os volt és nem a 4GB-os.Akkor 280X-ból is vegyük a 6GB-osat, mert az is volt.

A 4GB-os 770 jelentősen drágább volt a 2GB-osnál, az árán lehetett venni használt GTX 780/R9 290-et.

Egyébként ezen a teszten (TPU,Sapphire R9 390 Nitro Review) tisztán látszik, hogy a Keplernél nem a VRAM a limitáló tényező.A 3GB-os GTX 780 pariban van a 3GB-os R9 280X-szel.Az R9 290 és a GTX 780/Ti viszonyát is érdemes nézni.Vagy az alsóbb kategóriában a GTX 760 és az R9 270X viszonyát, mindkét kártya 2GB-os.

-

FLATRONW

őstag

Persze, tisztában vagyok ezzel. A csúcs kártyák sem gyorsabbak annyival az alattuk lévővel szemben, mint azt a több shader egységből következtetni lehetne.

Én csak annyit mondok, hogy ez a 15-20 százalékos előny főleg ennek köszönhető, nem pedig a GCN állítólagos tudásának. -

Amit linkeltél , az dx 11 teszt., nem a vita tárgya miatt mérhető a gyorsulás.

Valamint TP tesztnél akkor illene már nézni 1440P relatív teljesítményt ahol szintén már előrébb volt a 280 x ott is.feletted linkeltem be a tesztet ott a kép PH 11 % kal gyorsabb volt a 770 nél- már megjelenéskor..

valamint egy 770 4 GB kártyával illene tesztelni 1440 P ben , hogy lásd az architekturális előnyt nem pedig egy 2 GB verzióval ami alapból megfekszik még FHD alatt is nem hogy 1440 ben.

valamint már a megjelenéskor is volt ám olyan játék, amiben a 280 x előrébb volt 30 % -kal.

-

jedis

senior tag

"A tények továbbra is azok, hogy a Kepler párjaként anno megjelent, akkor azonos teljesítményű, vagy picit lassabb GCN-ek, ma 15-30%-kal gyorsabbak a játékokban."

Ezt írtad és ez nem igaz."

De igaz !!!!!!

Asus GTX770 DC2 2013.06 : 120EFt

Furcsa mód, mikor megjelent a 280X, a 770 ára is leesett a szintjére. Ugyan miért ?

Az első tesztek alkalmával, a 280X kicsit lassabb volt a 770-nél : Techpowerup

De az újabb játékokban már elhúz 280X, a 770-től : Techspot Titanfall 2 (20-25%)

Szóval akkor most mi van ?

-

"A tények továbbra is azok, hogy a Kepler párjaként anno megjelent, akkor azonos teljesítményű, vagy picit lassabb GCN-ek, ma 15-30%-kal gyorsabbak a játékokban."

Ezt írtad és ez nem igaz.

csak úgy mint ez :

"Mert vehettél volna GTX 770-et is a 280X árán és hol lennél most? Sehol."

Ez se.

Megint megy az oltás ezerrel. -

Abu85

HÁZIGAZDA

válasz

kikikirly

#95

üzenetére

kikikirly

#95

üzenetére

A Tier_2 és a Tier_3 különbsége annyi, hogy a Tier_2 bekötési szintet támogató hardvereknél szükség van a processzor segítségére, vagyis van egy kis extra többletterhelés, ami lelassítja a munkát. A Tier_3-as bekötési szinten ez szimplán nincs meg, mert a bekötéshez nem szükséges a processzor használata, megoldja önmagától is a GPU. Ez már a mai játékokban is működik, bár igazi bindless motort még nem igazán kapott a piac. Effektíve ez annyit jelent, hogy a többletterhelés nagyobb lesz GeForce-on, de ezt kompenzálni lehet több magot tartalmazó processzorral. Ergo, ha a Pascal mellé két maggal több erőforrást tartalmazó processzort veszel, akkor nem fogod észrevenni a Tier_2 hátrányát. Igazából elég +1 mag is, de ilyen sajnos nem lesz.

-

Abu85

HÁZIGAZDA

Mondjuk ezt lehet, hogy picit félreértitek. A 33% azt azt jelenti, hogy a feldolgozóinak 33%-ához nem fér hozzá, nem azt, hogy ennyivel lassul. Tehát ha egy programban nincs betervezve az ILP párhuzamosítás, akkor egy GTX 770 1536 shader processzorából csak 1024 darab lehet egyszerre aktív. De ez nem jelenti rögtön azt, hogy azonnal 33%-kal esik az fps is.

-

Loha

veterán

El ne hidd már ezeket a hülyeségeket a Keplerről, persze -33% az új játékokban...

Pont úgy teljesítenek a Keplerek, ahogy elvárható egy 3+ éves architektúrától:Watch Dogs 2 GTX 1060 Vs AMD RX 480 Vs GTX 970 Vs GTX 780 TI Vs AMD Fury X Frame Rate Comparison

GTX 1060 Vs AMD RX 480 Vs GTX 970 Vs GTX 780 TI Vs AMD Fury X Deus Ex Mankind Divided FPS Comparison

Battlefield 1 GTX 1060 Vs AMD RX 480 Vs GTX 970 Vs GTX 780 TI Vs AMD Fury X Frame Rate Comparison

-

kikikirly

senior tag

Szerintem itt nem a DX11 alatti különbség a kérdés, ahogy a többiek is mondták 30% hű de nagynak tűnik,de FPS-re váltva 5-6 körüli értéket kapsz ami szinte semmi.Nagy különbség DX12 alatt fog kijönni, és itt nem a keplereket kell számonkérni és nem is a GCN1-2-őt, hisz még sehol nem voltak mikorra véglegesitették a DX12 specifikációkat és a Shader Modell 6.0-át(és ha jól emlékszem NV itt még nem kezdett bele a tranzisztor spórolásba) .Ami probléma hogy még a Pascalba se léptek előre semmit.Talán annyit hogy Maxvalles 980TI-t lassult 5FPS-t DX12 alatt,míg a 1070 csontra ugyanannyi FPS-t produkál.De még mindig csak Tier 2 szintet használ,Async Compute alig működik és ha működik is nem hoz teljesítményt, ez most nem probléma, DX11-es játékoknak csinálnak DX12 portot, ezek is olyanok hogy a processzor terhelést csökkentik,eltünnek a DX11 mikcrolaggok, van némi AC.De ha csinálnak olyat amit csak DX12 bir el, GPU-s fizikaszámitás Async Compute-al(Ash Of The Singularity kiegjébe terepdeformálódást AC számolja,kár hogy mint játék szar, még roncsok sincsenek a magasabb rajzolási parancslimit ellenére, de ilyen szempontból releváns).Eddig azért nem fejlődött különösebben a fizika mert CPU limit lett volna, és DX11 alatt valamiért nem működött a GPU-s fizika számitás,

de látszik hogy DX12/Vulcan alatt erőlködés nélkül működik Async.RX 480 elég jól teljesit, 1060,1070 is de én is szinte csak DX11-es játékokkal tolom itt kúrva jó a 1070, 2-3 év kérdése AAA cimek 90% DX12-es lesz(indie játékok 4/5 milyen színvonalú azt inkább hagyjuk), azért még lesznek használatba Pascalos kártyák.Tier 3 szintnél mi lesz?Pascalra illett volna valami érdemlegeset előrelépniük,megkésett mantra hogy majd Nvidia akkor reagál mikor kell...Évek kérdése és 480 DX 11 alatt is behozza a 1060-at(már nem segit Proci oldalról Fast Path,iponos teszten is látszik),12 mindenki tujda mi lesz.Így talán megéri elviselni azt a néhány FPS lemaradást megjelenés utáni 1-2 évben.A lényeg hogy jóval nagyobb a zöldek lemaradása ,DX11 alatt minimum egyenértékűek voltak, most alapjaiban hiányos a kártyáik félépítése,szóval nem 5-6 FPS különbségek lesznek. -

FLATRONW

őstag

Nem kicsinyítem a dolgot, én is eltudnák lenni továbbra is egy 770-el. Azonban lehetőségem volt váltani, így váltottam. Sajnos mások nem tehetik ezt meg vagy csak egyszerűen nem érdekli őket annyira az egész.

Akik kitartanak most egy 280x mellett, akármi legyen is az okuk rá, azoknak bőven elég lenne a 770 is és ugyanúgy ellenének vele. -

-

FLATRONW

őstag

Ez a 33 százalék egy alap dolog lenne, ezen túl is lehetne még optimalizálni a Keplerre. Ahogy azt régen meg is tették és ennek volt köszönhető az előny a fő támogatási időszakban.

(#87) Abu85 : Nem járt sokkal rosszabbul, ezek a címek már nem igazán futnak jól 280x-en sem. Akinek most nem elég a 770 teljesítménye, annak a 280x teljesítménye is kevés már.

-

Abu85

HÁZIGAZDA

2 évvel ezelőtt ugyanúgy teljesítettek. Most pedig elhúzott a GCN az új játékokban.

Nem igazán tudnak segíteni a Kepleren. A fejlesztők tehetnek érte, ha megpróbálják befogni az összes erőforrást. A Frostbite meg is teszi, ott jó is. De a többség ma leszarja.

Valójában az R9 280X nem erősebb jelentősen a GTX 770-nál. Elég picit az elvi különbség, csak a mai játékok a GCN-re vannak optimalizálva a konzol miatt, és a Kepler megkapja a maga büntetéseit. Ezek okozzák a Kepler lemaradását. És ez egyébként eléggé gáz, mert aki mondjuk anno GTX 770-et vett R9 280X helyett most sokkal rosszabbul járt. Holott igazából a hardver nem annyira rossz, mint ahogy az látszik az új játékokban, főleg DX12 alatt.

-

A tényeken nem változtat,az hogy gyorsult dx 12 alatt,mert most hozza azt a teljesítményt amit kellett volna már 1.5 évvel ezelőtt és most is az 1070 szintjén áll. Az ára pedig 190 K míg az 1070 pedig 130 K

Nincs pariban az 1080 .kártyával.

A 770 GTx párja 7970.( lehet 280 is) és nem találok tesztet, aminél hirtelen 30 % előnye lenne úgy hogy előtte nem volt.oAcido : köszi, itt 2 % hátránya van a 4 G verzióval, 280 x ellen ráadásul. 33 % ez már megint valami egy játékra alapuló legenda lesz.

-

FLATRONW

őstag

Nem mindegy. Az 1080 egy sokkal jobb választás. A FuryX már a megjelenésekor is egy elrontott termék volt, már akkor is kevés volt a 4GB memória. A FuryX még most is csak 1,5 éves, még bőven jól kellene teljesítenie, de nagyon kiegyensúlyozatlan a teljesítménye.

És igen, egy lapon említem a két dolgot. Semmire sem megyünk a lehetőségekkel, a beteljesületlen ígéretekkel.(#78) SpongyaBob: A legnagyobb baj az, hogy az AMD nem akkor teljesít jól, amikor kellene. Nem azért megy a szar AMD-zés, mert lassabb 6 fps-el, hanem azért mert a termék első 1-2 évében nagyon kiegyensúlyozatlan. Ez alól most kivétel a 480, nincs vele semmi különösebb probléma.

-

SpongyaBob

veterán

Aha, én csak azt nem értem akkor ha ugyanennyivel lassabb a Radeon akkor miért megy a rinya..? Hisz teljesen értelmetlen az a 6 fps, nem?

Érdekes hozzáállás. Annyira jó, hogy amikor lassabb egy nv kártya azt mindig ki lehet magyarázni. Fordított helyzetben meg szarazamd..

Érdekes hozzáállás. Annyira jó, hogy amikor lassabb egy nv kártya azt mindig ki lehet magyarázni. Fordított helyzetben meg szarazamd.. -

"És akkor most annak kell örülni, hogy adott esetben 30 helyett 36 fps-el játszhatjuk a játékokat az ilyen kártyákon?"

Ja, akkor a Fury X vagy 1080 közötti választás is mindegy így?

A Kepler elcseszettségét és a GCN kihasználatlan techpornóját meg ne említsük már egy lapon. A egyik nyűg, a másik lehetőség. Nagyon nem mindegy.

-

Abu. példa kellene teszt, hogy lássam, nem pedig az, hogy te mondod.7970 vs 770 gtx. De szóval az egész így kicsit vicces, lehet annak örülni, hogy 3.5 év után egy kártya gyorsabb mint az akkori konkurense, de értelmetlen,de hogy túlzás amit állítasz,a "sehol nincs " kifejezéssel, az is biztos.

-

FLATRONW

őstag

És akkor most annak kell örülni, hogy adott esetben 30 helyett 36 fps-el játszhatjuk a játékokat az ilyen kártyákon? Így a 280x/7970 pont ugyanannyira nem időtálló, mint 680/770. A Doomban van igazán jelentős különbség a Radeon javára, de ez a különbség a Project Cars esetén megvan a GeForce javára is.

Ezeknek a kártyáknak 2 évvel ezelőtt kellett jól teljesíteniük.

Jó látszik, hogy a 770 szűk keresztmetszete a 2GB memória (4GB mellett sokkal kiegyensúlyozottabb) és a Kepler 33 százalékos sebességvesztése optimalizáció nélkül. Persze az NV is segíthetne ezeken a kártyákon, de minek, hogy kapjon 5-10 százalék teljesítmény többletet, nem lennénk semmivel sem előrébb.

A fejlesztők sem hibáztathatóak, hogy nem törődnek már egy régi architektúrával.

Folyton arról megy itt a beszéd az AMD-vel kapcsolatban, hogy a fejlesztők nem használják ki a képességeit és ezért van ott ahol. Most pont ez a helyzet a Keplerrel.

Én nem vitatom azt, hogy jelenleg erősebb a 280x, de ilyen szinten már nem számít az a különbség. -

Abu. A 770 megjelenése óta eltelt 3.5 év. Már akkor ment a vadítás a GCN ről meg az új konzolokról . most azt kell olvasni 3.5 év után , hogy Én megmondtam?ne már mert ez így nagyon nem korrekt. Az elmúlt 3.5 év alatt ez a kártya jó volt, és most sem a legszarabb, még mindig hoz egy belépő szintű teljesítményt még dx 12 alatt is. Ugyan úgy nem hoz többet belépőszintű teljesítménynél egy 3.5 éves akkori középkategóriás Radeon sem., ami akkoriban egy 7950 vagy 7970 volt vele egy árban. Azok sincsenek előrébb most.Nem kell túlzásokba esni. Valamint nem látom, hogy ha egy játéknak van Dx 11 módja , akkor miben szenved hátrányt Dx 12 höz képest.

-

Abu85

HÁZIGAZDA

2015 májusi videó. Elmondom, hogy ma az R9 280 a GTX 770 és GTX 780 között van a játékokban átlagosan. Az új modern címekben pedig üti a GTX 780-at, esetenként a 780 Ti-t. A Kepler rohadtul meghalt egy év alatt. Szinte nem is lehet ráismerni olyan szinten amortizálódott a teljesítménye. Vannak fejlesztők, akik még dolgoznak Keplerhez való ILP optimalizációval, például a Frostbite Team, de a többség már nem, és enélkül a Kepler elveszti a számítási teljesítményének 33%-át. Hiába van benne a teljesítmény annak csak a 66%-át tudja megfogni az alkalmazás. Ezért esett vissza extrém módon a Kepler. Ma már nem is igazán szerepel a tesztekben sem, annyira belassult.

-

Miért milyen erős volt?talán gyengébb lett? Ez így kb értelmetlen hozzászólás volt. A 970 hozta a 780 Ti szintjét. az 1070 meg hozza a 980 Ti szintjét, nem tudom feltűnt e. Kifejthetnéd miről beszélsz. neked az NV akkor se lenne jó ja ingyen adnának egy 1080 kártyát szóval kb értelmetlen veled vitatkozni csak úgy mint arról hogy ha egyszer belátnád hogy az AMD a nagy átnevezgetéseivel a mai napig árulja a GCN 1 kártyáit ez egy jó fej dolog tényleg. ja nem , csak ha ők csinálják.

-

arn

félisten

De hat epp arrol szol a dx12, hogy a fejlesztok kaptak a nyakukba ezt a munkat... en elore megmondtam, hogy ez lesz, es ezert sem fogunk kulonosebb optimalizaciokat latni, kevesen fognak x fele hwre optimalizalni, es gond lesz a bugokkal is. Foleg, ha nem vmi kirakatkartyarol beszelunk.

-

kikikirly

senior tag

https://ipon.hu/elemzesek/radeon_r9_380x_gyorsteszt_a_hianyzo_lancszem/2707/5

Itt az Iponos 380X teszt, i5 3570K val tesztelnek ami 4,4ghz-ra van húzva.Nem i7 6-8maggal mégis ha megnézed a 390-et a 970-hez képest ott van ahol lennie kell,ráadásul nem referencia 970 hanem Asus Strix, itt a 970 teszt, ilyenkor a korábbi eredményeket használják(gyanítom referencia 970-et macerásabb beszereznie webshopnak mint egyedi kiadásút):

https://ipon.hu/elemzesek/geforce_gtx970___instant_siker/2277/3Kerestem a 390- tesztjüket is,régebben olvastam,de se a Google,se az Ipon keresője nem hajlandó kidobni, akkor is pont a processzor miatt figyeltem fel a tesztre,míg PH-n 5960X-el tesztelnek, ott mezei i5-el,mégiscsak relevánsabb.

-

jedis

senior tag

+1

Pl.: overclock3d: The Division DX12 teszt

Fury X VS 980TI

RX480 VS GTX1060

R9 380 VS GTX960Ezek a párok a régebbi DX11-es gémek alatt nagyjából pariban voltak, vagy a zöldek erősebbek voltak (nem)kicsit a pirosaktól.

-

Abu85

HÁZIGAZDA

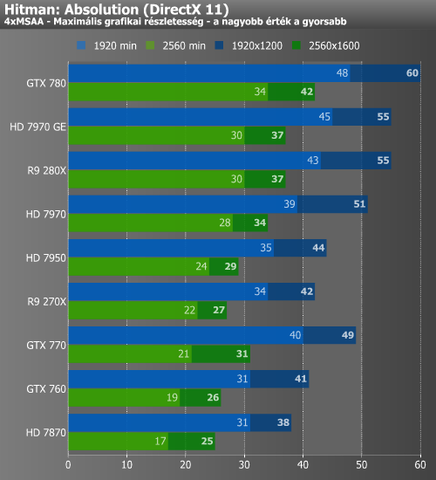

Ez nagyon függ a játék által támogatott leképezőtől. A mai DX11 és DX12 API-t egyszerre támogató játékoknál ez már nem számít annyira. Ennek persze főleg az az oka, hogy a legtöbb ilyen játék GeometryFX-es konstrukció, ami DX11 alatt is megfosztja az NV-t a parancsprocesszoron belüli fast path-októl. DX12-ben meg ugye ezek eleve elérhetetlenek, hiszen az OS adja tovább a grafikai parancsokat és a Windows 10 nem ismeri a hardverek fast path konstrukcióit.

A valóság az, hogy nagyrészt nem a meghajtón múlik ez az egész. Ami a titok az az, hogy az NV tipikus munkafolyamatokra fast pathokat épített a hardverbe a DX11-hez. Ezekre a meghajtó megfelelően be tudja tölteni a feladatokat. És vannak olyan játékok, ahol ez számít, de vannak olyanok is, ahol például használhatatlanok. Például a Hitman, vagy mondjuk a Star Wars Battlefront, és effektíve majdnem az összes modern motor, amit az elmúlt egy évben építettek. A DX12-ben ez azért látványosabb, mert az API-t a Microsoft nagyon általánosra tervezte. Nincsenek már benne fast path lehetőségek gyakorlatilag sehol, tehát mindattól a trükközéstől, amit az NV épített a hardvereibe az elmúlt három évben, és amiket bizonyos DX11-es alkalmazások alatt ki is használtak, egycsapásra megfosztották az GeForce-okat. Kihúzták a lehetőséget, hogy ezeket a funkciókat használhassák a fejlesztők, vagy akár az NV a meghajtókon keresztül. Emiatt fordul elő az, hogy DX11-ről DX12-re áttérve az NV hardverek jellemzően lassulnak egy picit. Nincs többé fast path trükközés.

Az AMD ezekben a fast pathokban sosem hitt, mert úgy gondolták, hogy ha az API oldalán történik valami paradigmaváltás, akkor csak egy nagyon apró lépés kell hozzá, hogy mindaz a tranzisztortömeg, amit fast pathokba öltek semmissé váljon. Ellenben, ha az általános pathokat erősítik, akkor az akármilyen API-val előnyt jelent. Nem lehetnek olyan gyorsak, mint a specifikus fast pathok, de nem is függ a sorsuk egy paradigmaváltástól, vagy attól, hogy a Microsoft bal lábbal kell fel és olyan specifikációt szab meg az egyik új API-jának, ahol az egységesítés miatt leszámolnak a gyártóspecifikus hardveres trükközéssel. Lásd DirectX 12.Szóval az egész kérdés nagyságrendekkel bonyolultabb itt már, mint a meghajtó helyzete. Már csak azért is, mert erős procival is gyorsulnak az AMD-k DX12 alatt, és lassulnak az NV-k a DX11-hez képest. Ez nem egy apró tényezőből áll össze, hanem egy olyan paradigmaváltás történt, ami az NV hardvereit egy rakás kedvezőtlen körülménnyel sújtja, és ezzel szemben az AMD-nek még egy csomó kedvező körülményt is kreált.

-

Raymond

titán

"Az AMD elsődlegesen az aszinkron compute-nak köszönheti a DX12-es előnyét, másodlagosan pedig annak, hogy a DX12-es meghajtójuk kevésbé terheli a procit, mint az NV meghajtója."

Aha, szoval az AC, ami szerinted is hoz talan jobbik esetben 7-9%-ot a fo oka annak hogy DX12 alatt az AMD jobban teljesit. A valosag meg mar az elso (talan az elkaszalt Fable?) eredmenyek ota valahogy igy nez ki a helyzet (szamok csak illusztracio):

DX11 NV = 100

DX11 AMD = 70

DX12 NV = 96-104*

DX12 AMD = 100-110*** nem akartam egy szamot irni mert jatekfuggo, van hogy semmi valtozas de van hogy pici kilenges pluszba vagy minuszba

** ez itt mondjuk eleg optimista/pozitiv hozzaallas hogy 100-al kezdem, nincs igy de egye feneMar anno is az volt a duma hogy "AMD a kiraly mert az AMD tud XX%-ot gyorsulni DX12 alatt az NV meg szinte semmit" es az az aprosag valahogy ignoralva volt hogy inkabb arrol van szo hogy az AMD meghajtoi DX11 alatt szarok az NV-hez kepest. Pedig ez latszik a DX11 vs. DX12-nel a tamogatott jatekokban es ez latszott az elejetol. Hozzatartozik az is hogy a PH!-n is (mint a legtobb teszt oldalon) a kartyak csak csucs procikkal vannak tesztelve, de az AMD kartyak egeszen mostanaig (pre-DX12) sokkal rosszabbul teljesitettek gyengebb procikkal (pl. a sajat 6300/8300 sorozatuk vagy eppen valami i3) mint az ugyanabban a kategoriaban veheto NV kartyak.

Szoval nem az AC segiti itt az AMD-t hogy jol mutasson DX12 alatt hanem az hogy a DX12 driver mar nem fogja vissza a teljesitmenyt mint elotte.

-

Azt még kifelejtettem, hogy én itt kettős mércét látok, az első hsz-em a topikból pont erről szólt. Nem a címkét kell nézni, hogy most van-e AC, legalábbis én telibetojom a PR-t, hogy nyomja az AMD, s hazug kocsog, mert a GCN1-en letiltja. Azt kell nézni, hogy van-e értelme. Ja hogy nincs? Konteót meg mindig egyszerűbb gyártani, mert az nagyon egyszerű, univerzális magyarázat, tetszőleges szituáción alkalmazható, na meg gondolkodni sem kell hozzá. Meg hát nagyon okosnak is érezheted tőle magad, amikor beavatod a tudatlan parasztokat, hogy mi is valójában az nagy igasság.

-

Abu85

HÁZIGAZDA

Azokat ugyanúgy ki lehet kapcsolni DX11-ben. De ami AMD-n is bekapcsolható volt az a PCSS és a HBAO+. Ezek a GCN-eken eleve gyorsabbak, mint a GeForce-okon. Az AMD elsődlegesen az aszinkron compute-nak köszönheti a DX12-es előnyét, másodlagosan pedig annak, hogy a DX12-es meghajtójuk kevésbé terheli a procit, mint az NV meghajtója. DX12-ben ez nagyon fontos, hogy GCN-en a bekötés mindig ingyenes, míg az NV-nek ehhez a processzor segítsége kell, ami némi processzoridőt emészt fel.

(#56) arn: Szerintem egyik cég sem csinálja jól a PC-t. Egyedül az tetszik, hogy az Intel nem javít tök általános játékhibákat, és rákényszeríti a stúdiókat, hogy ne a gyártók meghajtó oldali gányolására építsenek, hanem ami szar a házuk táján azt javítsák ki maguk. De a vicces dolgokat félretéve a PC az elmúlt évben nagyon jó irányba fordult, szóval a DX12/Vulkan miatt nagyon biztató lesz a 2017-es év.

-

Habugi

addikt

"Lényeg a lényeg, ugye AC a Mantle-vel indult, DX11-ben sosem volt. A Mantle pedig 2014-ben érkezett a BF4-gyel. A GCN1 pedig 2011-es."

Na végre leírta valaki..

Említik páran a mesterséges elavultatást.., he?!

Mivan-e nem van-e? Hol van most a 680/770 a 7970/280X-től? Utóbbiak úgy elmentek hogy már a távoli halványuló fényeket sem látni..

Persze gonosz mesterkedő AMD..

-

Abu85

HÁZIGAZDA

Nem teljesen. A Microsoft specifikációjának megfelel a Maxwell v2, a Pascal és a GCN1/2/3/4 is. Ezeknél van egyáltalán esély, hogy az aszinkron compute fusson. Például a 3DMark Time Spy mellett mindegyiken van async. A továbbiakban viszont már a fejlesztők döntése, hogy milyen módon implementálják a multi-engine-t, ugyanis számos módon meg lehet tenni.

Az egyes architektúrák bizonyos DXGI képességek elérésben különböznek. Például konkurens folyamatok támogatása az összes parancsmotorban, konkurens folyamatok támogatása a compute parancsmotorokban, kevert feladatfuttatás lehetősége. A Maxwellv2 egyiket sem támogatja, míg a Pascal csak a kevert feladatfuttatás lehetőségét tudja megoldani. A GCN1/2/3/4 mindet támogatja. DE. Még így sincs garantálva a megfelelő működés, tehát lehet, hogy elvi szinten egy aszinkron compute implementációnak csak a kevert feladatfuttatás az igénye, ugyanakkor elképzelhető, hogy így sem fog működni Pascalon a gyakorlatban. Ugyanez igaz a GCN1-re, ahol elvi szinten megvan minden a működéshez mégis lehetnek szélsőséges esetek, amikor nem működik a rendszer. Emiatt van beépítve a DirectX 12-be az a lehetőség, hogy a gyártó implementációja alkalmazásspecifikusan tudja visszaküldeni az OS-nek a compute parancsokat. Ha nem jók a gyártói tesztek, akkor nem jók. Semmi gond, csinálnak egy új drivert és küldik is vissza az OS-nek a parancsot. Ezek azért vannak, mert az említett képességek csak elvi lehetőségeket teremtenek a futtatásra, de a gyakorlatban a jó ég tudja, hogy miképp reagál rá a hardver. Ha rosszul, akkor inkább ne csinálja. Emiatt építette be a Microsoft ezeket a menekülőutakat.

-

Persze, mivel effektíve nincs konkurencia. Esetleg a Fury, de az eredetileg a 980 Ti ellen ment, s fail volt.

A GCN1-nél még nem ment az Async Compute nyomulás, csak az ACE egységek nevében. A GCN2-nél volt ezekben komoly újítás, csak annyira megy a megváltási mantra a fanbojok által, hogy nehéz kiválogatni, hogy mi igaz. Lényeg a lényeg, ugye AC a Mantle-vel indult, DX11-ben sosem volt. A Mantle pedig 2014-ben érkezett a BF4-gyel. A GCN1 pedig 2011-es.

A probléma inkább ott van, hogy az AMD átnevezett egy csomó kártyát, s még a 3xx szériában is található GCN1-es kártya, s jönnek a játékok, melyek GCN2-t követelnek a DX12-höz. Az AC csak egy apróság ebből a szempontból, s a cikkből meg kiderül, hogy nem szándékos elavultatás miatt kapcsolják ki, hanem azért, mert alig hoz valamit, cserébe ronthatja a felhasználói élményt.

-

arn

félisten

hu ez mennyiszer elhangzott a 2900xt ota...a baj az, hogy amig a kartyat hasznaljak, nem jon ki gyakran ez az elony, vagy minimalisan erzekelheto. kicsit kesobb meg maga az amd sem tamogatja tovabb. igy fordulhat elo, hogy az nvidia user semmit sem vesz tobbnyire eszre az egeszbol, mikozben te mar 10 eve temeted az nvidiat. akkor melyik ceg csinalja jol?

-

FLATRONW

őstag

Őszintén, a Division-el mi a helyzet?

Én úgy látom, hogy a DX12 egy szinttel alacsonyabb minőséget kapunk, a kikapcsolt GW effektek miatt.

Ezt a teljesítmény növekedést DX11 alatt is ellehet érni.

És ennek köszönhető az AMD erősödése, mert ezek az effektek jobban lassították őket. -

leviske

veterán

Volt korábban kavarodás a GCN számozás körül. Ha az GCN1.0/1.1/1.2 számozásnál maradunk, akkor a GCN4 = GCN1.3. Magyarán az AMD által végül alkalmazott számozás szerint GCN1.0 = GCN1; GCN1.1 = GCN2; GCN1.2 = GCN3 és GCN1.3 = GCN4. Az anand abbana cikkben nem a hivatalos AMD számisztikát használta.

Így a legolcsóbb AC-képes, ma is kapható videokártya az R7 360. Bár gyakorlatilag egy árban van a RX460-al, de a legolcsóbb variáns 2k-val olcsóbb.

-

Ezért volt pofátlanság a GCN1-et harmadszor is kiadniuk 2015. nyarán(!), ráadásul megtévesztő, magasabb sorszámú névvel (HD7850 -> R7 265 -> R7 370)

-

Abu85

HÁZIGAZDA

Nem kell 1.x-szelni. Az csak az Anandtech által bevezetett teljesen hülye elnevezés.

Az AMD GCN1/2/3/4 nevet használ kifelé, a hivatalos gyártói dokumentumokban pedig GFX IP6/7/8/8.1 van. De utóbbit senki sem használja, szóval megfelel a GCN1/2/3/4. Az Anand csak összekever az 1.x-es hülyeségével. -

Taranti

senior tag

Én most 1-2 bolt alapján a ma kapható kártyákat néztem. A Hardverapró persze más...

R9 285:

Anandtech szerint -

Abu85

HÁZIGAZDA

És mi történt? A GCN1 lett az időtállóbb vagy a vele együtt megjelent Kepler? Mert vehettél volna GTX 770-et is a 280X árán és hol lennél most? Sehol.

És a Pascal mellett sokan arra panaszkodnak, hogy a DX12-ben inkább hátrányt szednek össze, mintsem előnyt. A Division mérése az Ubinak azért érdekes, mert a DX11-ben a 480-at az 1060 elé rakták 2%-kal, míg DX12-ben mögé már az 1060 volt lassabb 16%-kal. Mindenki maga eldöntheti ebből, hogy a tranyókkal való spórolás jó döntés volt-e. Én csak azt írtam le, hogy a DX12-ben megfordul a helyzet. És megfordult? Sorra jönnek a játékok, amelyek azt mutatják, hogy igen, még az NVIDIA által szponzorált Divisionben is. Én csak leírtam előre, hogy mire lehet számítani. A Pascal inkább lassul a DX11-hez képest, míg a GCN inkább gyorsul. És ez történik a játékok többségében is.

-

leviske

veterán

Mondták már, hogy politikai pályát kellett volna választanod?

![;]](//cdn.rios.hu/dl/s/v1.gif) Mindenesetre specifikusabb leszek: Nem a 280X miatt sírok. Régebben ugyancsak a Te javaslatodra nem általános teljesítmény alapján, hanem az általam preferált játékokban nyújtott teljesítmény alapján vettem videokártyát és nem bántam meg. Kiszolgálta amit kellett (sőt). Hogy idővel nVidia-közeli játékok felé fordult a figyelmem, az nem a GCN1.0 hibája.

Mindenesetre specifikusabb leszek: Nem a 280X miatt sírok. Régebben ugyancsak a Te javaslatodra nem általános teljesítmény alapján, hanem az általam preferált játékokban nyújtott teljesítmény alapján vettem videokártyát és nem bántam meg. Kiszolgálta amit kellett (sőt). Hogy idővel nVidia-közeli játékok felé fordult a figyelmem, az nem a GCN1.0 hibája.A problémám azzal van, hogy még mindig megy a "bezzeg majd a GeForce-ok mennyire szívnak majd" mantra. Közben meg nem lehet nem észrevenni, hogy az nVidia a Pascal-al olyan szinten elhúzott teljesítmény/lapkaméret arányban és nyers erőben, hogy már-már vákuum maradt utána. Ezt az ilyen nüanszokkal esetleg ledolgozhatja az AMD, de emiatt gyakorlatilag óva inteni a GeForce vásárlástól minden cikkben, nem utal felelősségteljes újságíróra. Mikor cikket ír valaki, feltétlen számolnia kell azzal, hogy az olvasók többsége hiteles forrásnak tartja. Erről szólt a Prohardver! az elmúlt ~20 évben.

Tovább ezzel nem terhelem a topikot. Elnézést mindenkitől, hogy érdemi szakmai beszélgetés elől raboltam az időt és helyet.

(#46) Taranti: Helyesbítek:

GCN 1.0:

R7 250 (HD7700?)

R9 270/370 (HD7800)

R9 280 (HD7900)GCN2.0:

R7 260/360

R9 290/390GCN3.0:

R9 285/380

FuryGCN 4.0:

RX 460

RX 470

RX 480 -

Taranti

senior tag

Gyorsan átfutottam milyen kártyák és GCN verziók kaphatók manapság.

GCN 1.0:

R7 250

R7 370GCN 1.1:

R7 360

R9 290xGCN 1.2:

R9 380

R9 285GCN 4.0:

RX 460

RX 470

RX 480És hát ezek alapján bizony az RX 460 az egyetlen, ami viszonylag olcsóbb és megfelelő (lehet) specifikációkban. Ez így bizony elszomorító.

-

távcsőves

senior tag

Ja értelek, tehát a korábban megjelent fiji-t (fury x vagy radeon pro duo mert nem mindegy, de szerintem a furyra gondolhatsz) a késöbb megjelent pascal (gtx 1070/1080) veri. És ez így rendben is van. De ugye nem azt akarod mondani a fiji már a pascal ellen jelent meg?

Ez így trollkodás, írtál volna 980TI-t.

Ez így trollkodás, írtál volna 980TI-t. ![;]](//cdn.rios.hu/dl/s/v1.gif)

Erre innom kell egy Jagert, leesett az alkohol szintem.

-

Abu85

HÁZIGAZDA

[link] - Nézd meg a játéklistát, hogy melyik program melyik architektúrán hogyan támogatja az async-ot. Egyedül a GCN2/3/4-nek van előnye. Semmi másnak.

Házon belül pedig jobb a GCN1-től a GCN2/3/4. De elárulom most, hogy a GCN5-nek az NCU-ja verni fogja a GCN4 CU-ját.Ehhez még hozzávehetjük, hogy a Keplert, ami a GCN1-gyel párhuzamosan megjelent, már nem is jegyezzük. Egyszerűen nem alkalmas a DX12-re semmilyen formában.

UI.: Én többször írtam régebben itt a fórumon, hogy mindig a legújabb architektúraverziókat vegyétek. Csábító lehetett a 280X 3 GB memóriája, de akkor is a 285 okosabb volt a 2 GB ellenére is. Ez egy VGA-vásárlási aranyszabály, amit nem sokan ismernek.

Mindig az okosabb architektúraverziót, a látszatra rosszabbnak tűnő specifikációk ellenére is! Még akkor is, ha nem tűnik az akkori jelenben jobbnak! Nekem is volt lehetőségem anno a 280X és a 285 között választani. Gondolkodás nélkül a 285-öt kértem. [link] - pedig mennyivel jobbnak tűnt a 280X.

Mindig az okosabb architektúraverziót, a látszatra rosszabbnak tűnő specifikációk ellenére is! Még akkor is, ha nem tűnik az akkori jelenben jobbnak! Nekem is volt lehetőségem anno a 280X és a 285 között választani. Gondolkodás nélkül a 285-öt kértem. [link] - pedig mennyivel jobbnak tűnt a 280X.  Csak ebből a jobbnak tűnt maradt meg mára.

Csak ebből a jobbnak tűnt maradt meg mára. -

leviske

veterán

És ezzel semmi gond nincs is. Inkább haladjon előre a Khronoss és a Microsoft, minthogy megint egy helyben toporogjon az iparág. Csak zavaró, hogy a korábbi cikkekhez képest a GCN házon belül hamarabb kap pofont DX12/Vulkan alatt, minthogy a GeForce tulajok megéreznének bármit is a felépítésbeli hiányosságokból. Érdemes lehet levonni ebből a konzekvenciákat a jövőbeli hírek és elemzések megfogalmazásakor.

(#39) távcsőves: Ugye nem azt akarod mondani, hogy a GP104 ellenfelének nem lehet a Fiji-t tekinteni, miközben azonos árban futnak, csak mert fél év késéssel jön egy nagyobb Radeon is? Ennyi erővel a Vega ellenfele nem a GP104, hanem a GP204.

-

Abu85

HÁZIGAZDA

Technikai értelemben majdnem minden DX12-es játék multi-engine. Tehát effektíve majdnem mindegyik használja valamennyire az aszinkron compute-ot. De valamelyik valóban jobban, valamelyik pedig kevésbé. Az AotS az aktuális verzióval a teoretikus "közepes" csoportba tartozik. Ettől is nyer az AMD ebben a játékban úgy 3-4%-ot a GCN2/3/4-gyel, de való igaz, hogy sokat nem ezzel nyernek, hanem a többletterhelés csökkentésével. A Pascal is nyer egyébként 1-2%-ot az aszinkron compute-tól.

A Nitrous akkor lesz async heavy motor, ha elkészül az async texel shading kód, illetve a GPGPU-s terepszimuláció. Ezek már nagyon erősen igényelnék a hardvereknek ezt a képességét.A legjobban a jelenlegi felhozatalból a Hitman, a Deus Ex: MD és a Division használja erőteljesebben az aszinkron compute-ot. Ezeknél a játékoknál nyerhető vele a legtöbb teljesítmény.

(#39) távcsőves: Nagyon sokféle jelenetet lehet mérni ebben a játékban. És ezek eléggé eltérők. Például nem mindegy, hogy megy a lövöldözés vagy csak állsz a semmiben. Ez a két jelenetbeli eltérés sok különbséget okozhat a DX12-vel nyerhető gyorsulás tekintetében. A benchmark, ami van a játékban az egy eléggé ömlesztett mérést ad. Van benne minden terhelés, és ennek az átlaga adja meg leginkább a teljes játékra a sebességet. Mi is ezt fogjuk használni, de ettől függetlenül egy lövöldözés során kisebb lesz az átlag, és jobban kijön a DX12 előnye.

-

Laja333

őstag

Érdekes dolgokat mondott itt az Oxide-os emberke:

"Async compute wasn't available when we began architecting (is that a word?) the engine, so it just wasn't an option to build around even if we wanted to. I'm not sure where this myth is coming from that we architected around Async compute. Not to say you couldn't do such a thing, and it might be a really interesting design, but it's not OUR current design.""Saying that Multi-Engine (aka Async Compute) is the root of performance increases on Ashes between DX11 to DX12 on AMD is definitely not true. Most of the performance gains in AMDs case are due to CPU driver head reductions. Async is a modest perf increase relative to that. Weirdly, though there is a marketing deal on Ashes with AMD, they never did ask us to use async compute. Since it was part of D3D12, we just decided to give it a whirl."

Ezek alapján van már olyan motor ami "Async köré épül"?

Ha mág az AoS sem az.

Ha mág az AoS sem az. -

távcsőves

senior tag

Zavart érzek az erőben...

"Fogalmazzunk úgy, hogy az nVidia aktuális zászlóshajója anélkül is rommá veri az AMD-s konkurensét."

Meg sem jelent a 1080 ellenfele, vagy ellenfelének beállított vga még. A jelenlegi friss kínálat csúcsa pedig rendesen pariban van az NV megfelelőjével.

A többit inkább töröltem, mert flame war lenne belőle.

Hát Abu én 16%-ot azért nem mértem, de tény mocskos gyors ÁTLAGBAN a Division DX12-ben a DX11-hez képest, nagyon fluid a game. De DX11-ben is kaptam 58-59FPS-t RX480-al a 16,12,1 (relive) driverel.

-

Abu85

HÁZIGAZDA

7-10%-ot hoz átlagosan a GCN2/3/4-en. Valahol többet is. Főleg a Doom alatt. A feldolgozás formájától függ. De most ott a Division is, ahol az RX 480 16%-kal került a GTX 1060 elé DX12-ben, holott DX11-ben 2%-kal mögötte volt. Ezt főleg az aszinkron compute-ból szedte össze. A GCN4 sajátosságai miatt az aszinkron compute ennek az architektúrának kedvezőbb. Szóval a 7-10% egy nagy átlag.

-

Abu85

HÁZIGAZDA

Egy csomó dolgot nem kapnak meg a jövőben a régebbi hardverek.

Ezek specifikációs döntések. A Microsoftnak és a Khronosnak is megvolt a joga arra, hogy finomabb multi-engine és szinkronizációs specifikációt alakítson ki, ami nem csak a GCN2/3/4-hez illik jelenleg. Ugyanakkor ezt nem tették meg. Nyilván okkal, mert akartak egy jó és a jövőben kiegészíthető alapot. Hidd el nekik is nehéz döntés volt ez, hiszen nem csak a GCN1-nek csináltak kellemetlenségeket, hanem az NV összes meglévő architektúrájának. De többet ért, hogy a most kialakított rendszer jövőbiztos legyen. Most szidja a Microsoftot és a Khronost akinek GCN1, Maxwellv2 és Pascal architektúrája van, hiszen nekik némi kárt okoztak a döntésükkel, de majd írunk 2018-at is, amikor ezek a rendszerek lassan elkezdenek kikopni a felhasználók gépeiből, és akkor már örülni fog a világ annak, hogy a Microsoft és a Khronos a jövőbiztos alapot választotta.

Ugyanez lesz az érkező Shader Model 6.0-val is. A minimum specifikáció borzalmasan szigorú: AMD GCN2/3/4, NVIDIA Maxwellv2/Pascal és Intel Gen9 a belépő. Minden függvényre hardveres támogatása pedig csak a GCN3/4-nek van. Szóval a következő körben hoppon marad a GCN2/Maxwellv2/Pascal/Gen9. Ezeknél emulációval oldják meg a függvények egy részének kezelését. Futni fog, csak kurva lassan. De megint nem kicseszni akar a piaccal és a gyártókkal a Microsoft, csak egy jövőbiztos alapot szeretne.

-

Abu85

HÁZIGAZDA

Nem. Az async compute-ot az érintett játékokban azért kapcsolták ki, mert problémát okoz. Szóval pont, hogy az újabb meghajtókkal lesz jobb a működés.

(#21) ceripapa: Számos DX12-es játék az async compute-tal gyorsulja le a DX11-es kódot. De igazából a GCN1 a párhuzamos végrehajtásban nem annyira jó, mint a GCN2/3/4. Egyszerűen hiányzik belőle számos tudás, amit a GCN2-höz rakott hozzá az AMD, és amire eleve fejlesztette a Microsoft a multi-engine és szinkronizációt. A GCN3/4 még okosabb, de a DX12 alatt ennek nincs haszna. Szóval összességében a GCN1 az async compute-tól nem tud annyit gyorsulni, mint egy GCN2/3/4. 2-3%-ot maximum, holott az újabb GCN-en tudnak 7-10%-ot is. Ugye azért vették fél évvel később észre ezt a korlátozást, mert tulajdonképpen GCN1 mellett az async compute alig okozott teljesítménynövekedést. Szinte észrevehetetlen, hogy aktív-e vagy sem.

(#26) noPublicFG: Nem csinálnak a fejlesztők kártyaspecifikus optimalizációt. Vagy csak multi-engine kóddal szállítják a játékot, vagy mellé szállítanak egy single-engine opciót is. Mindkettő jó. Előbbi esetben a gyártói implementációnak joga van visszaküldeni a compute parancsokat, ha az a tesztjeiken nem igazán jó, míg utóbbi esetben eleve az OS kezeli az egészet, tehát a meghajtók felé nem is megy a parancs.

A felsorolt játékok közül a Rise of the Tomb Raider például olyan, hogy ha GCN1-et és Maxwellv2-t érzékel, akkor single-engine kód fut. A többi játék vagy multi-engine kódot futtat, vagy van egy ?rejtett? kapcsoló bennük, amivel a multi-engine és a single-engine között lehet váltani (például Ashes of the Singularity vagy Gears of War 4). De az ilyen kapcsolós rendszerrel még mindig joga van a gyártónak visszaküldeni a parancsokat, tehát lehet, hogy a kapcsoló az adott architektúrára nem fog érni semmit ... mindegy, hogy aktív-e.

-

leviske

veterán

Fogalmazzunk úgy, hogy az nVidia aktuális zászlóshajója anélkül is rommá veri az AMD-s konkurensét. Viszont legalább azoktól sikerült elvenni ezt is, akiknek az lett éveken keresztül propaganda szinten nyomatva, hogy DX11-ben csak azért szar az architektúra, mert majd jön a lowLV API korszak.

Senkit nem zavarna, hogy újra kiderült az AMD-ről, hogy béta tesztelőnek használja a vásárlóit, ha az elmúlt években normális híreket közölt volna az oldal. Nem nehéz belátni, hogy aki csak PH!-t olvas, az Intel és nVidia oldalról csak annyi információt hallott, hogy a kékek kénytelenek módosítani a tick-tock-on, a zöldek meg majd szívnak a HBM2 bevezetésével (óóó, az irónia).

-

Ahogy sokan leírták már előttem, ez csak arról szól hogy vegyél új vga-t. Mindkét gyártó tesz ezért eleget a saját piacán.

-

hapakj

őstag

lol. Még két ünnep közt is kimagyarázzuk az AMD-t. XD-t

-

Ha van Asynchronous Compute, akkor kamu, ha nincs, akkor meg az anyjukat.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

-

kikikirly

senior tag

Ha lassabb akkor érthető miért tiltották le,nincs szó szándékos elavultatásról.Azt pedig ne rójuk fel hogy nem működik, más is megjegyezte, sokat változott az eredeti DX12 az akkori tervekhez képest.Ha erről lenne szó akkor a Doomba is letiltották volna.És ki tudja talán tényleg keresnek rá megoldást, ez majd kiderül.Alacsony piaci részesedés miatt nincs logika abba hogy ők is eljátsszák ugyanazt mint NV.

-

nonsen5e

veterán

Mire használni valami a GCN (1) jövőbemutatását, az már nem is támogatja azt.

Itt adom írásba, hogy mire a következő Async-szintű marketingbullshit is beérik, azt már a 4-es GCN sem fogja támogatni. Semmivel sem különbbek az NV-nél.Az amúgy, hogy a 16.4.2 driver a fordulópont, az azt jelenti, hogy több esetben jobb lehet a DX12 játékaim teljesítménye ha azt használom a "jobb" és újabbak helyett?

-

Abu85

HÁZIGAZDA

válasz

djculture

#18

üzenetére

djculture

#18

üzenetére

Ilyen nincs és biztos nem is lesz. Ahogy a cikk is írja az aszinkron compute igazából nem DX12-es funkció, hanem egy implementációs dolog. A DX12-es funkciója ennek multi-engine és szinkronizáció, azt pedig kötelező minden DirectX 12-es implementációnak támogatnia.

Az aszinkron compute így aktív az egyes architektúrákon az egyes DX12/Vulkan programokban a default beállítást figyelembe véve:

GCN2/3/4:

- 3DMark Time Spy

- Rise of the Tomb Raider

- Hitman

- Tom Clancy's The Division

- Ashes of the Singularity+kiegészítő

- Quantum Break

- Total War: Warhammer

- Deus Ex: Mankind Divided

- Forza Horizon 3

- Gears of War 4

- Battlefield 1

- Civilization VI

- Doom

GCN1:

- 3DMark Time Spy

- Doom

- Battlefield 1

- Gears of War 4

Maxwellv2:

- 3DMark Time Spy

Pascal:

- 3DMark Time Spy

- Ashes of the Singularity+kiegészítő

- Rise of the Tomb RaiderAmelyik játék nincs említve az adott architektúránál ott a meghajtó visszaküldi a compute parancsot az OS-nek. De ettől még a program fut. Van pár játék, ami pedig alapból single-engine.

Az Unreal Engine 4-re fejlesztett DX12-es játékoknál (például Caffeine, Descent: Underground) használható lehet az aszinkron compute, mert a 4.14-es motorverzió a GCN-ekre ezt engedélyezte. Ha frissül az adott játék a 4.14-es motorra, akkor nyilván megkapja ezt a képességet is.

Végül a Mantle alatt a Thief használja GCN-en.

-

-

K0vasz

aktív tag

ez az aszinkron comput nem az a fícsör, ami ilyen +/- 1-2 fps-t eredményez és még csak grafikai tuningot se ad?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Robert07

aktív tag

7970 forever!

A teljesitmenye boven eleg arra, amivel en jatszok, azert meg nem fogom lecserelni egy ujabbra, mert az kevesebbet fogyaszt. Most telen amugy is kellemes az a 3-400W amit jatek kozben melegit a gep.

-

djculture

félisten

Ugyanezt csinálták a gcn előtti dx11 szériával ott meg driverileg letiltották az OpenCl támogatást a legacy driverben. Megy a vegyél új kártyát gerilla marketing.

-

NV pont nem szarja le a régebbi kártyáit, semmivel nem rosszabb ( sőt ) de inkább ezt hagyjuk. Egyébként ilyen öreg kártyáknál ez már nem igazán téma szerintem, senki nem hibáztathatja ezért AMD-t. Itt is történt bőven architekturális változás, hiába GCN, meg Dx 12 is változott azért bőven.

Korukhoz képest egész jól használható kártyák még, és NV oldalról az akkori 5xx széria is jól bírja. -

ribizly

veterán

Jöhetnének már az olyan hírek és cikkek, hogy mi az amit eddig nem írtak, de mégis működik...

-

Norbert9503

csendes tag

Az én HD 7970oc -m köszöni remekül van. Semmit nem vesz észre ebből.

-

abu megint szidja az nvidiát! ugorjunk neki!

![;]](//cdn.rios.hu/dl/s/v1.gif) bocsi, nem bírtam ki!

bocsi, nem bírtam ki!

az első generációs gcn az pl az én 7950-em? miben fog ez megnyilvánulni, ha pl a hitman-nel játszom?

-

FLATRONW

őstag

Nincs ezzel semmi baj, nem mai darabok azok a kártyák.

-

bozont

veterán

Szerintem az egyetlen dolog amit benéztek akkor, de nagyon, az a marketing. Akkor még messze nem volt egy végleges "Next-gen API" sem, de már azzal reklámoztak. Én valahogy nem lepődök meg, hogy egy 5 éves architektúrán már nem működik valami új funkció. Sőt, igazából ami meglepő hogy még manapság is egész jól használhatóak egyes GCN1 modellek.

-

lemusz

addikt

Elolvasva a cikket nekem laikusnak annyi jött le belőle, hogy valaki rátalált hogyan kezdték el szoftveresen lassítani a régebbi kártyákat, ezzel - rejtett módon? - igényt generálni, hogy újat vegyenek az emberek. Sejtettük ezt eddig is, csak nem volt így szépen levezetve meg normális, bugtalanító folyamatként prezentálva. Annak idején HD4850-emmel teszteltem a meghajtó programokat és ott is kibukott, hogy 2012-es drivereket már nem volt célszerű telepíteni neki. Az is 4-5 éves távlat volt, mint most ez is.

-

leviske

veterán

Nos gyerekek, ezért nem istenítünk butára egy architektúrát 10 évvel azelőtt, hogy használnának belőle bármilyen utasítást.

-

berVi

senior tag

"Ez azonban nem végleges állapot, mivel a cég próbál specifikus kerülőutakat találni megoldásképpen, amelyeket lassan beépíthetnek a programokhoz tartozó profilokba, és apránként vissza lehet kapcsolni a funkciót."

Aha. 5 eves hardverrol beszelunk. Forditok: elqrtuk, ugyhogy mondunk valamit, hogy ne legyen nagy balhe, amig ezek a kartyak ki nem halnak a piacrol.

Új hozzászólás Aktív témák

- BESZÁMÍTÁS! ASUS Z170 i7 6700K 16GB DDR4 512GB SSD GTX 1660Ti 6GB CooleMaster MasterboxMB 600 CM650W

- HATALMAS AKCIÓK! GARANCIA, SZÁMLA - Windows 10 11, Office 2016 2019 2021,2024, vírusírtók, VPN

- GYÖNYÖRŰ iPhone 11 64GB White-1 ÉV GARANCIA - Kártyafüggetlen, MS3123

- ÁRGARANCIA!Épített KomPhone i7 14700KF 32/64GB RAM RX 9070 16GB GAMER PC termékbeszámítással

- Azonnali készpénzes AMD Radeon RX 6000 sorozat videokártya felvásárlás személyesen/csomagküldéssel

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

a mai világba már olyan mintha a kőkorban olvastad volna :] már 1 hónap is

a mai világba már olyan mintha a kőkorban olvastad volna :] már 1 hónap is

Nem ártana frissíteni a tudást. Annyira a jelen az 1060, hogy már el is fogyott az előnye. Tanulság: Launch Day Driver nagyon fontos, mert mki a júliusi állapotokra emlékszik.

Nem ártana frissíteni a tudást. Annyira a jelen az 1060, hogy már el is fogyott az előnye. Tanulság: Launch Day Driver nagyon fontos, mert mki a júliusi állapotokra emlékszik.

Amúgy meg mivel kellene tesztelni a legújabb kártyákat, hanem a legújabb játékokkal. Vagy mindenki azért vesz új VGA-t, hogy a Krájzisz 1-el tolja ?

Amúgy meg mivel kellene tesztelni a legújabb kártyákat, hanem a legújabb játékokkal. Vagy mindenki azért vesz új VGA-t, hogy a Krájzisz 1-el tolja ?

![;]](http://cdn.rios.hu/dl/s/v1.gif)

)

)

Mindig az okosabb architektúraverziót, a látszatra rosszabbnak tűnő specifikációk ellenére is! Még akkor is, ha nem tűnik az akkori jelenben jobbnak! Nekem is volt lehetőségem anno a 280X és a 285 között választani. Gondolkodás nélkül a 285-öt kértem.

Mindig az okosabb architektúraverziót, a látszatra rosszabbnak tűnő specifikációk ellenére is! Még akkor is, ha nem tűnik az akkori jelenben jobbnak! Nekem is volt lehetőségem anno a 280X és a 285 között választani. Gondolkodás nélkül a 285-öt kértem.