Új hozzászólás Aktív témák

-

eight

senior tag

válasz

sayinpety

#114

üzenetére

sayinpety

#114

üzenetére

Bocs hogy nekrózom ezt a topicok, de volt egy kis szabadidőm és olvasgattam a Keplerről, aztán eszembe jutott ez a pár hónappal ezelőtti beszélgetés.

a Kepler leírása szerint minden egyes warp két független utasítást is tud végrehajtani.

"Quad Warp Scheduler

The SMX schedules threads in groups of 32 parallel threads called warps. Each SMX features four warp schedulers and eight instruction dispatch units, allowing four warps to be issued and executed concurrently. Kepler’s quad warp scheduler selects four warps, and two independent instructions per warp can be dispatched each cycle. "

Nem úgy kéne inkább ezt felfogni, hogy minden egyes SMX-re jut egy "block-nyi" szál (tehát nem 1 szál fut magonként)?

-

válasz

sayinpety

#109

üzenetére

sayinpety

#109

üzenetére

Köszönöm, én pont erre voltam kíváncsi. Miután a 290X-ben a legtöbb erőforrásból több van (talán csak a ROP a kivétel), az eredmények nem lepnek meg - viszont azt jó látni, hogy ezeket az erőforrásokat DX12 alatt már tudjátok mozgósítani. Egyszersmind az eredmények megerősíteni látszanak azt a régi teóriámat, hogy gfx workload alatt a GeForce-oknak jobb az ALU-kihasználtsága - és ez az előny még a GCN megjelenésével sem tűnt el (pontosabban a Keplerrel nagyjából eltűnt, a Maxwellel visszajött).

-

sayinpety

tag

Engine test scene. Jellemzo eredmeny. GCN sokkal jobb µarch, tobb vGPR, tobb active thread. Sok compute pipeline es fine-grain async task scheduling mellett hatekony. A threading a kulcs. A GCN CU negy SIMD, 4x64 thread=256 thread. Minimum ennyi active thread kell. Mai compute pipeline-okban nincs ennyi, ezert nem hatekony ma.

-

sayinpety

tag

Korrabbi szazalekok targytalanok. Az AMD hozott register pressure optimalizalast. R9-290Xen mar a gyorsulas 55%. GTX 980nal elertuk a 20%ot.

GCN 8 ACEvel ALU-limitalt, GCN1 frontend limitalt. Maxwell2 frontend limitaltnak tunik. Ha az tudok javitani. Nagyjabol elegedett vagyok. -

janos666

nagyúr

válasz

sayinpety

#91

üzenetére

sayinpety

#91

üzenetére

Én ebben a kérdéskörben régóta nem értem (valószínűleg, mert nem vagyok programozó, csak lelkes amatőr), hogy a CPU-n miért ekkora probléma pusztán a thread-ek száma. Miért nem lehet azokat a fránya display driver thread-eket (amiket mondjuk talán tényleg nem ártana legfeljebb az elérhető CPU szálak, de inkább fizikailag is jelen lévő CPU magok számra korlátozni) egyszerűen alacsonyabb prioritásra kényszeríteni, mint magát a játékmotort?

A CPU tudtommal nem kezd el bicegni attól, hogy váltogatja a feladatait, viszont ha a driver és a játék is ad egy fix limitet a CPU szálak számában, akkor ha mindkettő óvatos, a végén legfeljebb is két-két, de ha nagyon óvatos, csak egy-egy CPU szálat használnak (ha kétmagos CPU a játék minimum gépigénye).

Ha alacsony prioritáson menne minden driver szál, akkor lehetne belőle 4-8 is, miközben a játéknál szintén 4-8, és akkor legalább meglenne az esély, hogy a high-end consumer desktop CPU (FX- és -E) is ki lenne használva valamiképp (elvben "szükség szerint", de alapvetően a játékmenetet előnyben részesítve). -

Xmister

senior tag

válasz

#06658560

#84

üzenetére

#06658560

#84

üzenetére

Nem értem ezzel mi a bajod.

DX11 alatt az AMD hajlandó lenne a Thin driverre. Az NV nem. AMD pedig, ha nem akar lemaradni, kénytelen ő is driverben optimalizálni. Ennyi.A Mantle-t pedig pont azért voltak képesek kihozni, hogy többek között az ilyen dolgokat is elkerüljék.

-

sayinpety

tag

Lehet, am szuksegem lenne leirasra.

Foleg strategia, TPS. A CPU eleg. A driver veszi el a magokat.

Mas nem akar veluk foglalkozni. Tudjak mennyire fafejuek. Mar atkerult az Nvidia optimalizalas kulsos ceghez. En hetvegen szabadnapon optimalizalok Nvidiara. Engem erdekel mit adok ki. A nevem lesz rajta. Probalok javitani, ahogy tudok es idegesit, ha ugy erzik nem vagyok nyitott. Nem fogok elfogadni egy lassabb kodot. Nem lassitani akarok, gyorsitani. -

válasz

sayinpety

#91

üzenetére

sayinpety

#91

üzenetére

Vagy ezt úgy kell értelmezni, hogy dx12 alatt a grafikára fordított szálak mennyisége változatható lesz a rendelkezésre álló erőforrások függvényében? Mert akkor viszont tényleg beköszönthet a jó világ, ha az ai-ra fordított fix 2 szál mellé skálázhatóan 2-14 szálat kaphat a grafika cpu-tól függően (i3 - i7/5960x)

-

bunfi

őstag

(#92) schawo

Nem, nem a megkérdőjelezhetőségről van szó. Sőt a félisten szót sem szándékoltan használtam, csak benntmaradt a vizuális memóriámban. Csupán kicsit úgy éreztem a kommented vége felé, mintha csak egy témában járatlan fanboyt akartál volna pellengére állítani. Kissé túl nyers volt a megfogalmazásom, elnézést. Nem az én tisztem lett volna ezt megjegyezni.(#93) Kopi31415

De, senki nem tévedhetetlen. Ellenben, ha vitáról beszélünk, akkor neked kellene megvilágítani, hogy hol van a logikájában a hiba, nem fordítva. -

válasz

sayinpety

#91

üzenetére

sayinpety

#91

üzenetére

Ezzel a erőforráselosztással szerintem kaptok még sok átkot a nyakatokba, ha DX12-n rosszabbul fog futni a játék egy i7-en, mint DX11-en. Pont ettől a fejlesztői gondolkodásmódtól féltem, amikor kifejtettem aggodalmam attól, hogy teljesen szabad kezet adnak a fejlesztőknek dx12 alatt. De rendben, ha te azt mondod, hogy meg tudjátok oldani, hogy jó legyen ám lássuk. Most majd itt lesz a lehetőség.

-

sayinpety

tag

2 szalat a drivernek. Nem egeszseges, am elfogadhato. Sok driver szal elveszi a program elol a CPU idot.

Core i3 jo pelda. Intel driverrel kepes vagyok a CPU ido 40%at hasznalni. NVidia driverrel csak a 15%at.

Gameplay sajnos nem skalazhato. Mindig minimum CPUhoz, worst case driverhez kell tervezni. -

bunfi

őstag

Ez egyre jobb, szétszedik a fejlesztőt a ph! félistenei...

-

eight

senior tag

válasz

sayinpety

#86

üzenetére

sayinpety

#86

üzenetére

Nem lehet profile-olni a kódot? Miféle játékot csináltok amihez nem elég egy i5 4 magja? Azt mondod nagyon nehéz velük dolgozni, de veled sem lehet egyszerû, ha simán kiírsz ilyeneket róluk egy publikus oldalra. Talán másnak kéne a csapatból megpróbálni velük komunikálni, néha elôfordul, hogy két ember nehezebben érti meg egymást, aztán másik kettô meg gördülékenyebben össze tud dolgozni

(bocs a nyelvtanért, angol teló)

-

válasz

sayinpety

#83

üzenetére

sayinpety

#83

üzenetére

Maximum 2 elfogadhato.

2 szálat a grafikának? Akkor a többmagos processzorral rendelkezők nyaljanak sót? Mindent i3-ra optimalizálnátok? Vagy a szimuláció/ai kapna több erőforrást erősebb cpu-n? Ha nehezebb játékmenetet akarok, vegyek erős cpu-t, ha könnyűt, akkor Celeront? Vagy ezt hogyan máshogy lehet értelmezni?

-

sayinpety

tag

Sejtjuk. Keves az LDS es a register. A kulsos teamben sok Intel programozo segit. Egyikuk optimalizalta az LDS elerest, ebbol a 10%. Az AMDtol varunk register pressure optimalizalast, remeljuk javit a Maxwellen.

NVidia segithetne. Nem kerek lehetetlent. Annyit kertem mondjak meg mitol lassu a kod. Hetekkel kesobb kaptam egy tessellation middleware-t, ami lassabb es rondabb a sajatunknal. Majdnem sirtam amikor meglattam. Ez nem optimalizalas. A Gameworks szerzodest el sem olvastam. Most hisztiznek. Szerintuk nem fogadjuk el a javaslataikat. Nagyon nehez veluk dolgozni. -

sayinpety

tag

válasz

#06658560

#84

üzenetére

#06658560

#84

üzenetére

Mantle mint Explicit API megszuntet minden driver threadet. Programe az egesz CPU. En dontom el mire koltom az eroforrast. Am D3D11 nem explicit. El kell fogadni hogy rossz. Multithread driver 7-8 kernel driver thread csak ront rajta. Grafikat mindig lehet butitani, gameplay szimulaciot nem biztos.

-

sayinpety

tag

Az overhead D3D11ben ketelu. Evek ota gyozkodunk minden IHVt ne probaljanak javitani a driveren. Csak ront a helyzetunkon. Sajnos csak Intel tervez thin drivert. Pontosan ertik mirol beszelunk. A kernel driver threadek kiszamithatatlanok. Elveszi az eroforrast, serial feldolgozasra kenyszerit, sokkal kevesebb processor time jut a szimulaciora. Mindig keves driver threadet kerunk. Maximum 2 elfogadhato. A driver elvesz egy magot, a maradek megmarad szimulaciora. Az AMD es nVidia rosszul dolgozik. Tepem a hajam, amikor latom az nVidia driver 6-7 aktiv threadjet. Nem kerhetek minimum 8 magos CPUt! Le kell butitanom a jatek fizikat, AIt csak az nVidia driver miatt. Az AMD meggyozheto lenne. Ugy latjak, ahogy az Intel, csak menniuk kell az nVidia utan.

Az nVidia szerint a grafika sokkal fontosabb a jatekelmenynel, jo AInal.Sok console jatek a robust drivertol nem jon PCre. A Dragon's Dogma AI es fizika butitast igenyelt volna. A Capcom targyalt minden IHVval thin driverrol. Az nVidia nem engedett, toroltek a portot. Nagyon fafeju itt mindenki.

Elhagytam Magyarorszagot, am ismerem mi politika van ott. Olyan a PCs Triple-A jatekfejlesztes. Nem viccelek.

-

ukornel

aktív tag

"az nvidia nem, hülye dx váltáskor mindig le voltak maradva egy lépéssel, és sajnálkoztak, hogy hát ez van de a következő szériát gond nélkül megoldották. Az nvidia fan meg mit csinált??? Megvette a dx váltás előtti szériát, majd mivel ő is akarta az új dolgokat, megvette a következő generációt is... Na ki járt jól? Az AMD meg a -mi szeretjük a gémereket- hozzáállásával már úgy adta ki a kártyáit, hogy dx váltáskor nem kellet a user-nek váltani, de mire mentek vele elestek az eladásoktól"

Ezek a képzeletbeli fanok elég gazdagok, ha következetesen minden generációváltásnál kétszer fizetnek. A kevésbé gazdagokban inkább az a kérdés merülhet fel, hogy legyek tovább nV-fan, vagy inkább Ati-fan?

-

macman507

aktív tag

Na!

"A Microsoft valószínűleg azért döntött az apróbb szigorítás mellett, hogy a gyártókat az AMD GCN architektúrájához hasonló hardverek kifejlesztésére sarkallja, annak érdekében, hogy a fejlesztők egyre több grafikai és compute futószalagot futtathassanak párhuzamosan. Nem elhanyagolható módon a PC-s grafikus vezérlőknek is fontos lenne az Xbox One vagy a PlayStation 4 konzolhoz igazodni, mert a kutatások ezekre a gépekre zajlanak, és jó lenne, ha ezek eredményei jelentős módosítás nélkül átmenthetők lennének PC-re."

-

pkornel

aktív tag

Ez aztán "szenzáció" ilyen dolgok miatt sírnak itt az emberek?

Ez meg lehet csinálni pl physx-el is szerintem.

Ez meg lehet csinálni pl physx-el is szerintem. -

stratova

veterán

Hmm úgy rémlik a részecskerendszere profitál belőle.

-

bunfi

őstag

Jelenleg a játékokhoz kénytelenek drivert írni és attól, hogy ebben az nVidia a jobb nem hiszem, hogy ez lenne a jövő útja. Attól pedig, hogy jelenleg nincs konkrét negatív következménye a 970 mérnöki szemmel szánalmasan szakbarbár megcsonkításának, az nem változtat a tényen, hogy szánalmasan szakbarbár munka.

-

válasz

#32839680

#69

üzenetére

#32839680

#69

üzenetére

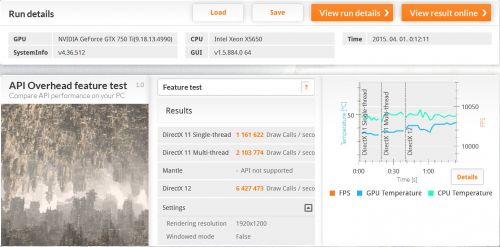

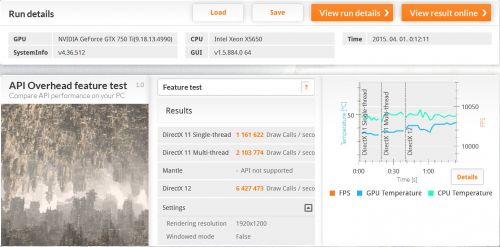

Egyébként pont a napokban kijött új 3dmark világított rá, hogy mi a baja az amd vga-kártyáknak, miért nem muzsikálnak úgy, ahogy kéne. Elképesztő overheadje van az amd drivereknek az nvidiához viszonyítva (dx11 alatt). Most majd meglátjuk, hogy mi történik, ha a játékgyártók kezébe adják a gyeplőt, és nekik kell kvázi drivert írni a hardverhez. Remélem nem fogunk együtt sírni. Aztán ha ebből a dx12/vulkán izéből végre profitál az amd, akkor együtt örülünk, vincent, és én is újra amd-t veszek. De addig még sok víz lefolyik a Dunán.

-

válasz

#32839680

#65

üzenetére

#32839680

#65

üzenetére

És ez most megint hogy jön ide? Ha tuningos maxell notebookokod van, amiből most ku..ára hiányzik a tuning, annak megvan a topikja, ha pedig túl lassú 970-ed, akkor futhatsz a boltba visszakérni az árát. Nem tudom, miért érzem úgy, hogy neked egyik sincs. De amúgy igen, nekik szörnyű világ van. Az a laptop tuning nélkül használhatatlan lett, a 970 pedig végtelenül lassú. Oh wait.

(#66) morgyi

Miért ne lehetne támogatni alapabb funkciókkal. Ha a játékgyártó akarja, most is mehet egyből tier3-ra, és akkor egyetlen nvdiás sem veszi meg a játékát, ugyanúgy, mintha a dx12 csak a mostani tier3-mal lenne elérhető, és minden mai nv dx11 only lenne. Mondom, a dx12 opció, nem kötelező a játékgyártónak. Szóval hidd el, mindenkinek jobb, hogy vannak alacsonyabb dx12 szintek. -

Akkor csak neked, itt, titokban kifejtem, hogy miért baromság, amit a kolléga írt.

Kifutott termékek támogatásáról van szó. Nincs semmiféle dx12 címke, hiszen ezek annó, régen, amikor eladták őket dx11 címkével kerültek boltba. Semmiféle dx12 marketing nem volt körülöttük. Ha most se kapnának dx12-t, akkor dx11 mellett ugyanúgy kellene boltba futni maxwellért, ahogy most, alap dx12 támogatással.

(#62) morgyi

Te szélmalomharcolsz. A dx12 játékok általi támogatása önmagában opciós. Ha lesz rengeteg vga, ami nem dx12 kompatibilis semmilyen szinten, akkor aztán lesheted, mikor jönnek a dx12 címek. -

eight

senior tag

"Amúgy meg ez csak a kis hazánkban, vagy hasonló helyen élőknek probláma, tőlunk nyugatra nem hiszem, hogy gond lenne kiperkálni évente kb. 400 jóféle jurót, vagy dolcsit, vagy mit egy új vasért.."

Nah, pont az van hogy nyugatabbra sokkal kedvezőbbek a lehetőségek vásárlói szempontból, mert szinte minden 1-2 héten akad egy jó üzlet amivel simán fillérekért bevásárolsz procit, lapot vagy éppen GPU-t. Olyan "akciók" amilyenek nálunk szinte sohasem történnek (vagyis legalább is én sosem látok itthon ilyeneket, csak esetleg használtban aprón évente párszor)

Én pl anno átszámolva 25 ropiért vettem a 250GB-os 840proimat, de itt van egy mostani példa:

-

Prof

addikt

Teljesen reszletkerdes. Par napi meloval megveszik a 980-at ha kijon Titan X lecserelik arra. Ha kijon ujabb megint lecserelik. Nem magyar fizura van az egesz tervezve.

Egy a kerdes az atlagusernek melyik a legjobb? XY , ok akkor kerek 2-ot. -

Duck663

őstag

Azért várjuk majd meg a játékokat is.

Egyébként mintha Abu olyat írt volna korábban, hogy jelenleg még valamennyire lekorlátozott a DX12 alatt használt magok száma, de erre nem esküdnék meg. Majd jön aztán mondja, hogy rosszul emlékszem!

Szerintem a bullnál édes mindegy, hogy mit csinálsz azokkal a magokkal/modulokkal, sokkal jobb nem lesz.

Nem tudtam, hogy van 6-8 magot is használó DX11-es játék, de elhiszem.

-

Az Intelnél a SMT-t is érdemesebb kikapcsolni, mert a legtöbb esetben játékok alatt az sem hoz teljesítményjavulást, de DX12 alatt fog.

Úgy gondolod? Leteszteltem.A teszt első felét pár órával ezelőtt megcsináltam. HT off eredmények: [link]

Bekapcsolt HT-val erre jutottam.

HT on, VGA alapon (1162/2700):

A CPU egyébként egy 4.0 GHz-en járó 6 magos, 12 szálas Xeon.

Amit ebből le tudok olvasni, hogy semmi változás. Az API OH nem lesz kisebb az SMT aktiválásával, sőt a mérési hibahatáron belüli mértékkel még gyengébb is lett az eredmény.

Az AMD CPU-k egyik nagy problémája pont ez a modulos felépítés a megosztott erőforrásokkal. Ha legalább le lehetne tiltani a csonka magokat (tehát a modulon belül egy maghoz rendelni az FPU-t, és az árván maradt félmagot letiltani), hasonlóan a HT kikapcsolásához, az lehet, hogy jót tenne az AMD játékok alatt mutatott teljesítményének.

Egyébként de, léteznek játékok, amik ki tudnak használni a 6-8 magot DX11 alatt is.

-

Duck663

őstag

Pontosan tudom, hogy mi az amit látok.

A lényeg, hogy mind a GPU-nál mind a CPU-nál keletkeznek limitációk, nem jelenthetjük ki egyértelműen, hogy ez vagy az limites! Csak akkor ha az órajel emelés már nem hoz több mérhető sebességnövekedést.

"Csakhogy ha a rajzolási parancsok száma a GPU egyéb terhelése miatt amúgy sem éri el a limitet" Most nézz meg egy AC játékot! AC3, AC4, Unity

Mi az hogy az FX nem ér? Már miért nem érne? DX 12 alatt azért nem is így fog muzsikálni majd. Itt jön elő az, amire a DX12 részben van, nem csak az egy szálas teljesítmény lesz a döntő, hanem az összteljesítmény is számítani fog és a 8 mag is kihasználásra kerül. Tudtommal nincs olyan DX11-es játék amely 8 magot használna. Az Intelnél a SMT-t is érdemesebb kikapcsolni, mert a legtöbb esetben játékok alatt az sem hoz teljesítményjavulást, de DX12 alatt fog.

(#37) RECSKA: Örülök, hogy eljutottál az i7-4770K-ig, de azért lejjebb is görgethettél volna.

-

rocket

nagyúr

Nem az a kerdes, hogy tobbet tett vagy nem, hanem, hogy mit profitalt ebbol?

A Vulcan vilagmegvaltasa se egyertelmu, mert az NV alelnoke a Khronos Group elnoke.Ertem en ido kell az AMD-nek, de fogynak a lehetosegek, nem a jovot kene ilyen melyen fejlesztgetni, hanem profitot szerezni, 28nm-es tobb eves gyartastechnologian keszulo refresh GPU-kkal vannak jelenleg ~6.5 honap hatranyban az NV-hez kepest.

Nagy vilagmegvaltasok mindig elszoktak maradni, mert vannak cegek akik uzleti befolyasolassal eltudjak erni, hogy AAA cimet 2016-ban DX11-re fejlesszenek.

Ezen kivul van a jozan paraszti esz, amikor majd kiderul a Win10-rol, hogy nem terjed ugy ahogy kene, akkor visszafognak nyulni a jatekfejlesztok akik esetleg nem akartak es nem fizettek meg oket ezert a DX11-hez, mert profitot szeretnenek termelni a PC verzioval.

Kulfoldi hardver forumokon ahol van nehany nem kispalyas emberke kozelbe nincs ez a hype az uj API-k irant, mint ami itt megy, tenyleg mar csak mosolyogni lehet ezeken a cikkeken

"Nem mellesleg semmi különbség az nvidia és a radeonok között játék alatt... Nekem senki ne mondja hogy a pár fps különbségtől bármelyik gamer falnak rohan, bár melyik gyrtó oldalán legyen is az."

Errol kerdezzel meg par AMD usert mit gondol, de az is eleg ha ranezel a piaci reszsedesre, ami ugye 2014Q4-ben 76-24 volt.

Jo esetben 3 havonta szulnek egy drivert, sok jateknal hetekig sehol sincsenek teljesitmenyben.

A kozelmultbol sajat peldambol a Dying Light-ot tudom kiemelni, 3 hetbe telt amig a fejlesztok csinaltak nemi optimalizaciot (ami ugye az AMD dolga lett volna, hogy megjelenesre megadja a megfelelo supportot a jatekhoz) es azota se lett olyan, mint a konkurens kartyakon a megjelenes napjatol. -

Reggie0

félisten

Miert szerinted AMD-nek mi a lenyeg? Ugyan ugy a profit. Csak annyi a kulonbseg, hogy ok "technologiailag" akartak elhuzni az nvidia mellett, csak eppen a jatekok es a piac nem mentek utanuk a nagy Nvidia tabor miatt, igy az utobbi tudasanak a korlatai lettek meghatarozoak a szoftverek fejlesztesekor es az AMD kartyak kepessegeinek folenyebol nem ervenyesult semmi. Erre fel az Nvidia a piacon levo szoftverek igenyeihez finomhangolta a kartyait, ugy hogy az AMD egy pazarlo kazannak minosult mellette. Nyilvan az optimalizaciot sok ember eszre sem veszi es nem tekinti komoly munkanak, pedig nagyon is az.

Az Nvidia pont annyit tett le technologiailag, mint az AMD, csak a celok voltak a masok. Uzletileg pedig talan most sikerul az AMD-nek bekuzdeni magat a ringbe. -

kila25

csendes tag

Hát pedig bizony többet tett az AMD mint bárki. Az nvidia-nak az a lényeg meg legyen a profitja oszt csá, csak ülnek a megszerzett hírnév tetején... A microsoft-ot nem árdekli a pc-s játék neki ott a box... az intel meg nincs mivel beleszóljon.

Nem mellesleg semmi különbség az nvidia és a radeonok között játék alatt... Nekem senki ne mondja hogy a pár fps különbségtől bármelyik gamer falnak rohan, bár melyik gyrtó oldalán legyen is az.

-

sayinpety

tag

Teljesen mindegy van-e fine-grain async task scheduling 2nd gen Kepler es 1st gen Maxwell IPn. 2nd gen Maxwell IPn csak 10%ot nyerek. Ugyanaz a kod R9-290Xen 40%ot gyorsul. Pascal IPt tervezik fine-grain async task schedulingre.

-

rocket

nagyúr

"Emellett a cikkben leírtakkal pont az nVidia nem jár rosszul - a 2-3 éves kártyák lecserélésére tudnak mondani egy újabb érvet."

Pontosan, ezzel megint az NV jar jol.

A felhasznalok nagy resze nem Radeonra fog valtani, mert a brand erteke a markanak a beka hatsoja alatt van.Nagyon unalmasak mar ezek az API hirek, lassan minden heten 5 ilyen nesze semmi fogd meg jol cikk van, amiben kiderul a GCN mekkora ultragigacsaszar lesz DX12 alatt, meg az AMD a megvaltoja a PC-s jatektarsadalomnak.

Elmeleti sikon folynak ezek a hirek allandoan, jo lenne mar egyszer latni, hogy az AMD profital valamit a szines grafikonon megalmodtakbol.

Fogadnom kene akkor nagy valoszinuseggel a tortenelem ismetli onmagat, es a konkurencia leaartja a baberokat, sot az se biztos, hogy lesz meg addigra AMD mar formajaban, mert nem gigantikus termekeket fejlesztenek, mint ahogy az egyik PHBlikk cikk cime sugalta nehany napja, gigantikus szot az AMD eseteben a negyedeves uzleti jelenteseknel kell kereni, a veszteseg kategorianal. -

Szerintem egy kicsit gondold át a tények szintjén is, amit leírtál, ne csak retorikában. Már a sokadik ember vagy, aki ezt a zöldséget szajkózza, hogy az nVidia fogja vissza a fejlődést - alá is tudjátok ezt valamivel támasztani? Az meg, hogy az nVidia architektúrája nem korszerű... inkább nem is mondok semmit.

Emellett a cikkben leírtakkal pont az nVidia nem jár rosszul - a 2-3 éves kártyák lecserélésére tudnak mondani egy újabb érvet. Bennem már az is felmerült, hogy az ő ötletük volt

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Én tökéletesen értem, miről szól, még ha nem is ilyen egyszerű, és főleg nem ilyen hatékony. Ugyanis amit te felvázoltál, az nem más mint egy buta szintetikus teszt működése, mint pl. a 3dmark overhead tesztje. Csakhogy a GPU ezer másik műveletet is végez, a kirajzoláson kívül, ami leköti a kezeit. Ha nincs kikevert festék, akkor mindegy, hogy hány kézzel nem rajzol éppen.

-

kila25

csendes tag

Nem vagyok szaki úgyhogy ne kövezzetek meg ha nem így van...

Szerintem a vitátok pusztán csak elméleti, mert mire ebből a gyakorlatban is lesz (kész játékra gondolok) valami, addigra, aki rendesen játszik pc-n már rendelezni fog olyan vassal ami támogatja ezeket a funkciókat, csak a koca játékosok szívják meg esetleg a dolgot, akik úgy vannak vele, hogy nem baj ha kissebb a felbontás, meg közepes a grafika, de fut... Vagy mégsem, mert a cpu limit pont ott jön elő...

Amúgy meg ez csak a kis hazánkban, vagy hasonló helyen élőknek probláma, tőlunk nyugatra nem hiszem, hogy gond lenne kiperkálni évente kb. 400 jóféle jurót, vagy dolcsit, vagy mit egy új vasért..

A másik meg, hogy gondolom (ez pusztán feltevés) az nvidia nem, hülye dx váltáskor mindig le voltak maradva egy lépéssel, és sajnálkoztak, hogy hát ez van de a következő szériát gond nélkül megoldották. Az nvidia fan meg mit csinált??? Megvette a dx váltás előtti szériát, majd mivel ő is akarta az új dolgokat, megvette a következő generációt is... Na ki járt jól? Az AMD meg a -mi szeretjük a gémereket- hozzáállásával már úgy adta ki a kártyáit, hogy dx váltáskor nem kellet a user-nek váltani, de mire mentek vele elestek az eladásoktól + a piaci részesedésük sem nyomta le az nvidiát. Szerintem a zöldek végig röhögtek a markukba

Ha az AMD viszont elkezdi megszüntetni a gpu limitet is, akkor kivágja maga alatt a GCN-el és konzolokkal maga alá ültetett fát rendesen, mert a procijai el fognak vérezni az intelekkel szemben. Legalább is szerintem mert játékok alatt csak a gpu limit miatt tartották eddig is a lépést.

lásd [link]

-

Tyrel

őstag

A lényeg pont az a DX12 esetén hogy a linkelt teszten látott TitanX eredményei csak egy bizonyos értelemben GPU limitesek. A DX11 renderelő futószalagjával nem tud ennél több feldogozást végezni azon a GPU-n, de ettől még egy csomó erőforrása marad kihasználatlan, mert nem tud nekik munkát adni - többnyire azért, mert az egyes képkockákon elvégzendő feladatok egymás függőségei így lehetetlenné válik a párhuzamos feldolgozás.

Kicsit úgy képzeld el mint ha lenne egy festőd aki először ceruzával megrajzolja a körvonalat, aztán szépen körbefesti, aztán kiszíneszi a végleges képet, meg egy másik a Marsról akinek 3 keze van meg 6 szeme és full egyszerre csinálja meg ugyan ezt a 3 műveletet, így harmad annyi idő alatt végez.

Ez a fajta, feladat-párhuzamosítás lehetetlenségéből eredő GPU limit egy TitanX-nél gyengébb videokártyán nyilván sokkal korábban előjön, így fontosabb is a feloldása. Dióhélyban erre való a DirectX 12.

-

Ugye megvan, hogy egy Titan X tesztjét látod. Majd ha Titan X méretű problémám lesz, akkor nem fogok a GPU limiten aggódni. De a tesztben a Titan X-szel sikerült GPU limiten táncolni még sima fullhádén is, hiszen a 4 magos Haswell 2,5GHz és 4,5GHz között (80%-kal emelt órajelen) nyert 6 kemény százalékot.

Az FX nem ér, az nem CPU, az egy vicc. Az persze, hogy limites, de azért 4GHz-től már képes kihajtani a Titan X-et is.

A Titan X sem árban, sem sem teljesítményben nem egy kategória az FX-szel. Nem normál párosítás, ilyet senki emberfia nem hoz össze éles rendszeren, csak a vicces tesztek kedvéért.

-

eight

senior tag

schawo fórumtárs már elmondta mit értettél félre (amit köszönök szépen), szóval nem fogom én is leírni még egyszer.

Az ultra vs medium vitára meg csak annyit mondanék, hogy én sem ma kezdtem és emlékszem még azokra az időkre, amikor a 640x480-as felbontástól meg a 16k színtől eldobtunk a hajunkat, szóval megy az a különbség észrevétel " a felhasználok nagy százalékának" is, csak esetleg egy kicsit később mint a lelkes (enthusiast) közönségnek

szerk.: de a linkelt tesztben az i3 108fps az i7 meg 115

-

Duck663

őstag

Igen ám, de épp az aszinkron compute miatt nehezebb lesz elérni a GPU limitet is.

Ismét egy teszt, BF Hardline: [link] ahogy folyamatosan növelik a CPU órajelét úgy nő folyamatosan a GPU teljesítménye, tehát korántsem beszélhetünk csak GPU limitről.

Ez az egész arról szól, hogy a lehető legtöbb limitáló tényezőt próbálják kiiktatni. A több magos processzorok mindegyik magját játékok alatt munkára fogni, a GPU-kban rejlő tartalékokat kiaknázni.

Nem várom én, hogy sokszoros legyen a teljesítményt, inkább kiegyensúlyozottságot várok...

-

Tyrel

őstag

válasz

v_peter2012

#29

üzenetére

v_peter2012

#29

üzenetére

Ha valami egyértelműen korszerűbb és gyorsabb, és ezt Abu le meri írni akkor miért ő a fizetett reklám ember? Nem egy rossz dolgot próbál jóként eladni.

Hosszú-hosszú évek óta folyamatosan, minden DirectX generációváltásnál ez ment: az nVidia nem volt hajlandó kellően korszerű GPU architektúrákkal előállni, aminek köszönhetően az új DirectX feature-ök csak évekkel később kezdtek megjelenni a játékokban, ha egyáltalán valaha is megjelentek...

Hosszú-hosszú évek óta folyamatosan, minden DirectX generációváltásnál ez ment: az nVidia nem volt hajlandó kellően korszerű GPU architektúrákkal előállni, aminek köszönhetően az új DirectX feature-ök csak évekkel később kezdtek megjelenni a játékokban, ha egyáltalán valaha is megjelentek...nVidia most is ennek a stratégiájának köszönheti a helyzetét és ha végre egyszer ők fogják megszívni miatta, nem mi játékosok, azt bizony megérdemlik... ha már mindenképp akasztunk valakit, az ne a hírhozó legyen.

-

Nem. Azt látod, hogy az API overheadje egy jobb CPU-nak kisebb. Csakhogy ha a rajzolási parancsok száma a GPU egyéb terhelése miatt amúgy sem éri el a limitet, akkor nem kevés az adott CPU. Márpedig az óriási overheades DX11-ben eddig is általában GPU limit volt, tehát belefért a kért rajzolások száma a limitbe. Most, hogy a limit az égbe emelkedett, nem történik semmi csak még kevesebb CPU fog limiten futni. Ennyi. Nem kell ebbe túl sokat belelátni. Nem fognak a DX12 játékok hirtelen 4-8-16x nagyobb fps-t produkálni egy csapásra. Aki ilyenekkel álmodik, annak kellemetlen lesz az ébredés.

-

Duck663

őstag

Igen ez egy API Overhead teszt, de nem ez a lényeg, hanem a tesztben 6 CPU-t használnak, igen eltérőeket, és láthatod, hogy igenis számít és számítani fog a CPU teljesítménye. Jó ok, ez egy szintetikus teszt, de ott lehet legjobban kimutatni ezt.

A felhasználok nagy százaléka még a felbontást sem állítja be.

Az hogy felmész ultrára manapság csak annyit jelent, hogy kifekszik a GPU-d, de általában már egy közepes beállítás mellett is elérhető közel az a vizuális élmény, egyszerűen azért, mert mesterségesen vannak feltornázva a gépigények. Ráadásul a felhasználók vagy 2/3-a nem lát különbséget a PS4-es és a PC-s ultra között... nem csoda hogy a felhasználók elfordulnak a PC-től.

-

stratova

veterán

Itt tényleg "legfeljebb" a felhasználók faraghatnak rá, mivel mindhárom gyártó készül aszinkron compute képességű GPU-val (ha nem is feltétlenül a teljes termékpalettát lefedve):

AMD - GCN

Intel - Gen9 - Skylake-U / Skylake-S (15-65 W) elvileg 2015 Q3

Nvidia - Maxwell v2 GM206, GM204, GM200v_peter2012: megértem, ha zavar Abu látásmódja, de ebben a cikkben egészen pontosan, hol került előtérbe, hogy csúnya Nvidia? Mindhárom gyártónál vannak GPU-k amik kiesnek ebből a körből:

AMD: Llano/Trinity/Richland APU-k

Nvidia: Pre-Maxwell v2 GPU-k

Intel: Gen9 előtti GPU-k (Hasswell, Broadwell, Braswell és régebbiek)Ez a cikk nem az Nvidiát állítja, be "szemétnek", hanem a Microsoftot, ha a te megközelítésedet nézzük.

-

Abu85

HÁZIGAZDA

válasz

v_peter2012

#27

üzenetére

v_peter2012

#27

üzenetére

Az AMD-nek az NDA-s anyagához ennek semmi köze. Az egy külön cikket kapott. [link]

Ez a módosítás a development logból származik, ahogy például ezt a módosítást is onnan vettem. [link]Ha szerzel developer hozzáférést a Microsoftnál, akkor eléred a development logot. Ott megtalálod az early specifikációkat, annak a későbbi provisional specifikációkhoz meghirdetett részeit, illetve a módosításokat.

(#29) v_peter2012: Minden DX12-ről szóló cikkben benne volt, hogy ezek nem végleges specifikációk, és a Microsoft fenntartja a jogot, hogy módosítással éljen, ezekről a módosításokról írtam a legutóbb két hírt.

-

eight

senior tag

Egyrészt az egy api overhead(!) teszt, másrészt meg szintetikus (ráadásul szvsz buggos is, legalább is minimum kérdéses mikor mekkora framebufferrel dolgozik) (elnézést hogy nem tudom mindennek a magyar megfelelőjét, kicsit szégyellem mert nagyon szeretem a nyelvünket, de nem szoktam lefordítgatni ezeket, és talán nem is szükséges egy szakmai oldalon).

Ha tippelnem kéne, akkor a dx12 kb. olyasmi lesz játékokban mint a bf4+mantle volt (persze azért jobb/erősebb hatású mivel a fejlesztői technikák is fejlődnek meg már eleve úgy fogják felépíteni), azaz APUknál meg Xbone szintű PC-knél segíteni fog sokat, de amint felmész "high"-ba vagy "ultra"-ba (és ugyebár a PC-t szerető embereknek nem kell elmagyaráznom miért is szeretjük mi aztatot olyan nagyon

) ott már kb. csak az fog számítani hogy mit bír a GPU.

) ott már kb. csak az fog számítani hogy mit bír a GPU. -

Duck663

őstag

Csökken a CPU-k terhelése valóban, de meg nem szűnik,

Itt egy teszt a 3DMark új tesztjéről. [link] Több CPU és több GPU-val, és elég jól látható, hogy kell bizony a CPU is. Az előny csak az lesz, hogy 8-10-12 vagy akár sokkal több mag és/vagy szál is kihasználható lesz. Ebben meg nem azért, de megint mintha az Intel lenne kicsit előbbre.

Az nv-nek meg talán idejében el kellett volna kezdenie fejleszteni!

-

No, ez egy jó nagy marhaság. Amúgy sem lesz könnyű szülés a DX12, és a rohadt sok draw callon túl amúgy sem egyértelműek az előnyök felhasználói szemmel - most egy csomó kártyától elveszik a kevés maradék valódi előny egyikét. Zseniális.

Persze, az MS leszarja, hogy a Kepler / GM107 tulajok váltanak-e Win10-re![;]](//cdn.rios.hu/dl/s/v1.gif)

-

eight

senior tag

Pár hete még és is össze-vissza klikkelgettem a DirectX Caps Viewerben, de aztán kezdett ez a egész dx12 mizéria fárasztóvá válni a számomra. Az MS-nek az az érdeke hogy az xbox, PC-n meg a win10 és a dx12 legyen sikeres, az AMD-nek meg az hogy a GCN meg az APUi, szóval összefogtak és ezt az egészet meg megint mi PC-sek fogjuk megszívni, mert a procik IPC-je még annyira sem fog számítani mint eddig. Egyrészt mert majdnem minden játékot konzolokra is fejleszteni fognak, és már a Jaguár magok is elegek lesznek hozzájuk bőven, másrészt meg az új API is csökkenteni fogja a CPU terhelését. Szóval szvsz értelmetlen azon izgulni mi lesz majd támogatva és mi nem, mert ha valamit esetleg nem tud hardverből a (pl.) a Kepler vagy a Maxwell-1(stb.) - mert az MS úgy döntött, - akkor azt majd az Nvidia megcsinálja szépen driverből vagy shaderből. A procinak úgyis lesz elég "szabad" ideje, és ezek a "feature level" driver dolgok igazán nem kívánnak sokat, pláne akkor nem, ha majd minden még inkább GPU limitáltabb lesz mint eddig, azaz totálisan.

Hát ez lett volna az én két centem a témához

-

Cifu

félisten

Nekem olybá tűnik, hogy a DX12 is olyan lesz, mint anno pl. a PS2.0 megjelenése. Tök jó dolog, de mivel a hardverek egy jelentős részét kizárja a használata, így a programozóknak vagy kell külön támogatnia a régi és az új eljárásokat (így extra munkát jelentve), vagy inkább lemondanak az új technológia használatáról, cserébe a régi hardverek támogatásáért...

-

Tigerclaw

nagyúr

Az Intel-t tekintve ez szerintem nem oszt nem szoroz, mert nincs senki aki azt várná el, hogy majd DX12-es címekkel játszik majd Intel APU-n.

-

CybonTom

tag

Igen, nem könnyű ilyet csinálni az biztos, viszont ennek egy szabványos api-nál nem feltétlenül kell meghatározó érvnek lennie, főleg úgy, ha te magad is azt mondod, hogy a stateless felé tolja a piac a fejlesztőket amúgy is... szóval én ebben nem érzem a nagy gondot, inkább azt, hogy a kivételesen az MS megpróbált a piacra hangolódva csinálni egy limitációt és nem annyira óvatosan hátsóba billenteni a fejlesztőket abba az irányba amerre elvárják tőle. Egyébként, ha még az is benne van a pakliban amit írtál, hogy az NV és az Intel amúgysem támogatta volna ezt a részt azokkal a hw-kkel, akkor meg még csak gond sincs belőle a részükről.

-

lenox

veterán

amik gyakran a múltban ragadnak a technológiát tekintve.

Nem a multban, hanem a valosagban. A valosagban sok regi hardware van a usereknel, azon kell futnia a szoftvereknek. Jo lesz biztos a DX12, de minel tobb dologgal szurik a user baset, annal lassabban fog terjedni. Persze az uj hw vasarlasat meg gyorsitja.

-

Riddick77

tag

Olyan hardvert is nehéz gyártani,mint az INTEL új CPU-i,mégsem érdekelt senkit,hogy a konkurencia nem ér fel hozzá. Mindig a jobb terméket érdemes venni,márka függetlenül. Igen,meglehet,hogy a mostani generációs GPU-k közül pár nem fogja normálisan támogatni az új DX 12 minden újítását,de akkor majd tervezzenek olyat,ami fogja! Mint a konzolokon,mikor nem tudja normálisan futtatni az előző generáció játékait. Ha,ez az ára,hogy hosszú távon jobb legyen a végeredmény,akkor simán megéri.

-

Abu85

HÁZIGAZDA

Ez meg a másik. A stateless tempóban előny, tehát ha valaki komolyan gondolja, akkor úgyis elmegy ebbe az irányba. És ez az eredeti koncepcióval is pont úgy jó, mint a mostanival.

Amúgy tudni kellene, hogy mi volt a háttérben, hogy az NV és az Intel mennyire tervezte az aszinkron compute támogatását. Az Intel a GDC-n azt mondta, hogy semennyire, mert bár technikailag működik, de a többi architektúrával ellentétben a Gen8 lassul tőle. Az NV gondolom a Maxwell V2-re tervezte. Elképzelhető, hogy a többire már nem, tehát effektíve az sem kizárt, hogy egy olyan ajtót csukott be az MS, amin eleve nem léptek volna be az említett architektúrák.

-

Hiftu

senior tag

A vásárlóknak részéről rossz irány -> új hardvert kell venni.

Az nVidia régi és az Intel összes termékének rossz -> még gyengébb hatásfokkal sem supportálhatnak egy funkciót. Ha szeretnék akkor sem.A szoftverfejlesztőknek jó, mert várhatóan kicsit homogenizálja a piacon lévő hardverek tudását.

-

Abu85

HÁZIGAZDA

Mert igazából a módosítással csak annyi történt, hogy pár eddig jó hardvert kizártak. Előnye viszont igazából nincs. A GCN a korábbi modellben is stateless volt. Ugyanazt meg lehetett csinálni vele, mint amit most meg lehet. Effektíve csak becsukták az ajtót pár architektúra előtt. Persze lehet, hogy ezekre eleve nem jött volna támogatás, de az ajtó nyitva volt.

A másik gond, hogy könnyen lehet azt mondani, hogy másolják le a GCN-t a konkurensek. Csak a konkurensek nem azért élnek együtt a limitációkkal, mert az olyan jó dolog, hanem azért, mert olyan hardvert csinálni, mint a GCN piszok nehéz. Ebbe a szoftveres emberek nem gondolnak bele. -

Petyyyyy

addikt

Innen kicsit úgy tűnik, hogy valahányszor DX12-vel kapcsolatos hír lát napvilágot, annyiszor csapnak az nVidia fájának törzsébe egyet a fejszével és tesznek fel egy díszt az AMD fájára.

Nem fáj a dolog, sőt kifejezetten megnyugtató, hogy hw csere nélkül megkapunk szinte minden fícsört, csak már kezd kényelmetlenné válni a kiegyenlítetlenség. -

Tigerclaw

nagyúr

Szerintem mire jön a DX12, meg az azt támogató játékok, ez már nem lesz akkora probléma, mert cserélik a játékosok a vasat pár évente. Én mondjuk nem de amivel játszok talán még mindig csak a DX9-et támogatja. Hiába jött/jön a DX10-11-12, ha sok fejlesztő nem tud vagy nem akar arra átállni. Ráadásul a sok playert vonzó MMO-k esetén nagyon ritkán cserélnek motort...amik gyakran a múltban ragadnak a technológiát tekintve.

-

Riddick77

tag

Rossz a cím. A Microsoft csak szigorítson az új AMD APU-k javára,mert így akkor az XONE is jobban tud gyorsulni. Ha,meg valamit fejleszteni akarunk,akkor csak a jobb felé haladjunk,ne a butább felé.

-

-Solt-

veterán

A Microsoft valószínűleg azért döntött az apróbb szigorítás mellett, hogy a gyártókat az AMD GCN architektúrája hasonló hardverek kifejlesztésére sarkallja, annak érdekében, hogy a fejlesztők egyre több grafikai és compute futószalagot futtathassanak párhuzamosan.

Nem értek egyet a cikk címével... szerintem ez jó irány!

Új hozzászólás Aktív témák

- Kínai és egyéb olcsó órák topikja

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Kodi és kiegészítői magyar nyelvű online tartalmakhoz (Linux, Windows)

- Luck Dragon: Asszociációs játék. :)

- Melyik tápegységet vegyem?

- Az időjárás borongósabbra váltott, de a hardverek még vígadnak

- Redmi Note 10 Pro - majdnem minden stimmel

- EA Sports WRC '23

- Háztartási gépek

- Autós topik

- További aktív témák...

- GYÖNYÖRŰ iPhone 12 Pro Max 256GB Blue -1 ÉV GARANCIA - Kártyafüggetlen, MS2116, 100% Akkumulátor

- Xiaomi Redmi Note 13 Pro BONTATLAN // Számla+Garancia //

- ÁRGARANCIA!Épített KomPhone i5 13400F 16/32/64GB RAM RTX 5060 Ti 16GB GAMER PC termékbeszámítással

- Panasonic CF-XZ6 AIO all-in-one laptop tablet 2k touch i5-7300u speciális ütésálló rugged

- Bomba ár! Lenovo ThinkPad T460s - i5-6GEN I 8GB I 128GB SSD I 14" FHD I Cam I W10 I Garancia!

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Ez meg lehet csinálni pl physx-el is szerintem.

Ez meg lehet csinálni pl physx-el is szerintem.

![;]](http://cdn.rios.hu/dl/s/v1.gif)