Új hozzászólás Aktív témák

-

dezz

nagyúr

Ez így tényleg butaság... A diploma önmagában tényleg nem jelent semmit. (Én pl. nem is szereztem meg, mert már 15 éves koromban játékokat írtam ASM-ben, nem volt ilyesmire időm.

Mostanában mondjuk, így 40 felé közeledve, álláskereséskor néha jól jönne. Bár oda nem is megyek, ahol ez számít.

Mostanában mondjuk, így 40 felé közeledve, álláskereséskor néha jól jönne. Bár oda nem is megyek, ahol ez számít.  ) Viszont nem az időtől függ, ki mire lesz képes, hanem a képességektől. Valakinek 15 év sem elég arra, mint másnak 2-3.

) Viszont nem az időtől függ, ki mire lesz képes, hanem a képességektől. Valakinek 15 év sem elég arra, mint másnak 2-3. -

orbano

félisten

megint másról beszélsz. sem az nem minősít egy programozót, hogy teljesíti-e egy játékfejlesztő cég felvételi követelményeit, sem az, hogy mennyi pénzt keres. eddig talán ez a legnagyobb hülyeség. ezek szerint egy magyar programozó szükségszerűen rosszabb programozó, mint egy jól kereső amerikai mondjuk?

-

cwn

tag

hat pedig igy van, altalaban engine programozonal megkovetelik a 2 kiadott jatekot , ami ugy alapbol 6 ev tapasztalat 2*3ev, plusz az egyetem 4-5 ev akkor mar 10-11 evnel jarunk

es akkor ez a legjobb scenariooo

persze az is fontos kerdes hogy ki a jo programozo, pl akinek a havi fizetese 2 mill netto?, vagy 10? -

orbano

félisten

en nem mondtam, hogy vezeto programozot kell csinalni egy kezdobol, de attol meg boven kerulnek ki jo szakemberek egyetemrol, akik nem szoptak a cumisuvegbol az ada95-ot

es igen, sok az egyetemrol kikerulo hulye. ezzel is egyetertek. de ettol meg nem igaz az az allitas, hogy 13 ev kell ahhoz hogy valaki jo programozo legyen. -

orbano

félisten

na ezeket úgy fél tucat ismerősöm tudta negyedikben

leszámítva persze a platform specifikus dolgokat. de ahhoz meg nem kell 13 év.

leszámítva persze a platform specifikus dolgokat. de ahhoz meg nem kell 13 év.

de most komolyan ezekben mi a kunszt?

-next gen platform? grafika sáv és egy kis utánaolvasás, több szakdoga született már az ismerőseim között ebben a témában.

-strong 3d math skills? szerintem n dimenziós politópok után egy kis euler-tér nem igazán kunszt egy progmatosnak sem. pláne mert lineáris algebra első éves tárgy. de grafika sávon fél év alatt letudod az összes 3ds grafikai algoritmust a paramterikus felületektől kezdve a bernstein polinomokon át mindent. én másodikosként megértettem belőle mindent, pedig hiányzott az algebrai háttértudás fele.

-assembly language skills és egyéb PS3 specifikus cucc: na ez az amit az ember a szabadidejében megtanul egyetem alatt, ha éppen ez érdekli.

-fluent C++: nálunk ezt Haladó C++ programozásnak hívták, a template programozás bugyraiba is bele-belenéztünk. aki ezek után nem értette kívülről-belülről a C++ fordítókat, az mehet amőgy is takarítónak.

-Multi threaded blabla: párhuzamos programozás a tananyag neve, a többit meg megtanultad otthon magadban, mert érdekelt a ps3.a többi rizsa meg olyan, hogy ha nem akarod is megtanulod egyetemen. még egy nehe tutorial is elég hozzá. de ha nem, felveszel egy real time 3d grafika specit és írsz saját motort fél év alatt. ha azalatt nem ragad meg semmi és nem fejleszted tovább hobbiból, akkor szintén javallott a wcpucolás sávosodáskor.

-

cwn

tag

hat nekem mindegy, de keptelensegnek tartom ennel kevesebb ido alatt megszerzel ennyi tudast, amit minden engine programmer munka igenyel

Skills

• A good BSc degree or equivalent in a relevant subject such as maths, computer science or engineering.

• A proven level of in-depth experience developing on next generation platforms.

• Strong 3D maths skills and an in-depth understanding of next-gen rendering techniques.

• Fluent C++

• Strong assembly language skills coupled with a detailed knowledge of 360 and PS3 architecture.

• Multi threaded / multi core techniques on both 360 and PS3 platforms.

• The ability to communicate ideas clearly.• Post processing techniques.

• Real time lighting.

• Character rendering techniques.

• Streaming technology.

• Particles and special effects. -

cwn

tag

dehogynem, persze a tudasnak tobb lepcsofoka van

5 ev programozas tanulas utan copy -paste kontar az ember

10 ev utan mar ra lehet bizni kisebb munkakat, pl tool programozo

15 ev utan szakember, pl engine programozoahhoz hogy egy nvidia doksit le merjen szarozni valaki kell 15 ev

-

cwn

tag

tulzas azt varni hogy par ev alatt barkibol programozo valik, 15 ev kell ahhoz hogy az ember atlassa az egeszet es sajat algoritmusokat alkothasson

tehat ha mondjuk 13 evesen nekiall valaki programozni akkor ugy 28-30 eves korara lesz szakember , ez alatt kb megvan 1000 konyv, meg 100 ezer pdf olvasas, egy elte, meg par architectura, stb

persze ezzel meg nincs keszen az ember, mert folyamatos tanulast igenyel a szakma, mivel a technologia allandoan es gyorsan fejlodik -

orbano

félisten

pont ezt mondtam én is: olyan embernek kellene kijönnie az egyetemről (nem BSC, mert azok menjenek el kertet ásni), akinek ha azt mondom, holnaptól párhuzamos programokat fog írni, akkor tudja, hogy másnap már kezdheti is a temporális logika szakkönyveket olvasgatnia, nem pedig imádkoznia, hogy egy backroundworker, egy okos foreach, meg három lock majd segít a gondjain.

-

Ribi

nagyúr

Szerintem hanyagoljátok ezt az orvos témát...

Amúgy majd akkor dolgoznak sejt szinten az orvosok amikor egy procit is atomokból raknak össze. Ez pedig igen messze van. A másik, ha képesek is rá, annyira drága, hogy nem a halandók pénztárcájához lesz mérve soha. Igen sokaknak még midnig a kalapács az alap eszközük, pedig annál "barbárabb" eszköz nincs. Mégis ezt használják, mert az az ócsó. -

Abu85

HÁZIGAZDA

válasz

Bj Brooklyn

#69

üzenetére

Bj Brooklyn

#69

üzenetére

A második generáció lett volna a 2010-es verzió. Az tipli lett. A harmadik generáció van fejlesztve, de az Intel bejelentette, hogy belátható időn belül nem lesz a projektből diszkrét GPU.

Igazából nem az a lényeg, hogy jó irányba mennek-e. Az a probléma, hogy a VGA-k piaca annyira leszűkül, hogy értelmetlen lesz ott a trónért versenyezni.

A Larrabee koncepciója beépülhet még a CPU-ba integrált GPU-val. Ez lesz s zsíros piac, amire érdemes hajtani. -

Bj Brooklyn

aktív tag

Nem, Housra gondoltam, hanem Larabee-re, csak már nem volt kedvem keresni ABU-s kommentárt, amire feltehetem a kérdésem. Én meg úgy emlékeztem, hogy a 3. vagy 4. generációs jött volna ki, szóval azért nem is értettem, ezt a projekt befejezősdit. Amit idáig láttam az meggyőzött arról hogy jó irányba mennek, csak még kell pár gen., mire kiforrja magát.

-

dezz

nagyúr

Hát ja, a legtöbben nem a kihívás miatt lesznek orvosok...

(A lelkiismeretet és az empátiát meg eleve meg kell tanulniuk elnyomni valamennyire.)

(A lelkiismeretet és az empátiát meg eleve meg kell tanulniuk elnyomni valamennyire.)cwn: Csak az a baj, hogy a DNS nem ír le mindent. Pl. az egypetéjű ikrek szervezete sem egyforma, sem fizikailag, sem kémiailag, stb. stb. Intelligens önszerveződés van. Ezt eleve rettentő nehéz számítógéppel szimulálni (és nem csak kapacitáshiány miatt), és ha mégis sikerül, minden futtatás alkalmával más lesz az eredmény.

Bj Brooklyn: A köv. gen. Dr. House, vagy ez most miért volt off?

De egyébként én úgy emlékszem, a legelső Larrabee példány volt a kísérleti, és a következő már ker. forgalomba került volna. Mostanában. -

cwn

tag

mer az tud?,

az orvosok elvannak tevedve, a jovo orvosai nem a mai ertelemben vett orvosok lesznek, szal nem vagnak ,darabolnak, hanem programoznak

a dns siman programozhato , minden megvaltoztathato , csak eleg bonyolult , meg eltelik par ev mire leszoknak a szikerol

pl ott vannak a gyogyszerek, amit nem is szabadna hasznalni, mert mindenkinel mashogy hathat, lehet hogy meggyogyit valamit, de mashol elindithat egy folyamatot amibe 10 ev mulva belehalsz

az egesz orvos,gyogyszer ipar sarlatanokbol all jelenlegmondjuk azt meg nem tudom hogy egy ember kepes lesz e megtanulni a szervezet mukodesenek minden reszletet , mivel tanultam molekularis sejtbiologiat, igy elsore nem tunik megtanulhatonak mert minden mindennel osszefugg es igen bonyi, muszaj a computerek segitseget hivni, es szimulalni a szervezetet, a mai gepekkel ez nem is igen megvalosithato, nade majd a cloud rendszerek segitenek

-

"én egy egyetemről kikerült diáktól azt várnám el, hogy friss aggyal mindenhez értsen."

Nem talalom a smiley-t, hova dugtad?

Ma, Magyarorszagon kb. az orvosok az egyetlenek, akikkel szemben tenyleges kovetelmeny az, hogy a kepzes vegen ertsenek (nem mindenhez, hanem) a konkret szakteruletukhoz, az o kepzesuk ugy nez ki, hogy hat ev egyetem + ket ev rezidensi kepzes + par ev szakorvosi kepzes (vagyis osszesen tobb, mint tiz ev, rengeteg gyakorlattal (meg persze rengeteg elmelettel)) - valahogy nem ugyanaz, mint egy harom eves BsC kepzes (raadasul az orvosknal nagyjabol egyedulallo modon hivatalosan definialt szakteruletek vannak, amik nem valtoznak csak ugy es a munkaltatok is ehhez igazodnak).Egy frissen vegzett diplomassal kapcsolatban kb az az optimistan realis elvaras, hogy ugy altalaban kepben legyen a szakteruletet illetoen es kepes legyen viszonylag gyorsan betanulni az allasaba.

-

orbano

félisten

válasz

killerjohn

#52

üzenetére

killerjohn

#52

üzenetére

én egy egyetemről kikerült diáktól azt várnám el, hogy friss aggyal mindenhez értsen. ha nem, visszakérném tőle azt a pént, amit az állam fizetett ki a taníttatására.

-

-

dezz

nagyúr

válasz

Geri Bátyó

#59

üzenetére

Geri Bátyó

#59

üzenetére

Ja, látom. [link] Hmm, ezek újfent IA32, azaz x86 magok. (Viszont az alap-arch. hasonló, mint a korábbi.)

-

Valóban a Tera Scale inkább csak kiindulási alap, de a jövőbeni fejlesztések erre fognak épülni. Viszont már készítettek 48 magos működőképes példányt, amin Windows futott (emlékeimben erősen él egy kép a feladatkezelőről 48 maggal), tehát ha más nem, emulálja az x86-ot.

A Larrabee ennek egy elég korai "vadhajtása". Valóban más fejlesztési irány, de a kiindulási alap közös.Szóval nem javítlak ki, mert nagyobb részt neked van igazad. Én nem fogalmaztam eléggé pontosan.

-

dezz

nagyúr

válasz

Geri Bátyó

#56

üzenetére

Geri Bátyó

#56

üzenetére

A Tera-scale architektúra egy kicsit más alaprendszerű (crossbar router, nem ringbus) és a magok sem x86 alapúak, nem is kimondottan CPU magok: [link] (Az itt látható példány nagyon is koncepció projekt volt, hiszen eleve nem volt tervben a ker. forg., hanem a kutatási program része.)

Szerintem a Larrabee nem ide tartozik, hanem egy párhuzamos fejlesztés volt. Csak az a közös, hogy itt is jópár mag van. De javíts ki, ha tévedek.

-

-

dezz

nagyúr

Nem tudom, hogy az egyetemről kikerültek mit csinálnak, de az igaz, hogy a Fermi mindent lenyom izomból -- többszáz wattos fogyasztással...

Cell alapon ez töredék energiából kihozható, csak éppen tudni kell hozzá programozni is. (Bár a Roadrunnerhez csinált egy cég valami környezetet, amit "egyszerű" matematikusok is használhatnak, viszonylag hatékonyan, mivel előre elkészített librarykat használ. Közelebbit nem tudok.) Ezért foglalja el a fogyasztás/teljesítmény arányt alapul vevő Green500-as lista első helyeit csupa Cell (PowerXCell) alapú gép.

(#50) Geri Bátyó: Igen, az Intelnek (is) vannak ilyen koncepció projektjei, de nem reklámozza őket ennyire (csak pl. előadást tartanak róla egy évben egyszer az IDF-en). Szerintem nagyon is kereskedelmi terveik voltak a Larrabee-vel, csak elszámították magukat. Pl. nagyon mutogatták azokat a ray-tracingre moddolt játékokat, amik első ránézésre látványosak voltak, de valóban használható megjelenítés, értelmes felbontáson még sokkal nagyobb teljesítményt igényelt volna...

hcl: Hát, néha valóban úgy érzem, az Intel közép(?)vezetői nem kimondottan szakemberek. Föntről, pusztán üzleti szempontból nézik a dolgokat. (Pl. szokott lenni egy ilyen Intel által szponzorált és szervezett találmányi verseny, ahol ezek az emberek néha olyan dolgokat díjaznak és csodálnak, amikben valójában semmi újdonság nincs, csak ők még nem hallottak róla.)

(#53) cwn: Ők valami olyasmit akartak, mint a Cell, de sokkal egyszerűbben programozhatót. Az egyszerűség itt a szokványos main memória elérés. Így egy hétköznapi egyszerű kód is elfut. (És persze az x86 alap sem hátrány sok szempontból.) Nyomták is a sódert, hogy ez mennyivel jobb, mint a Cell nehézkes, blockos main ram elérése. Csak éppen, ha minden magon ilyen kódot kezdenek futtatni, beáll az egész. (De úgy tűnik, pár kör optimalizálás után is.) A Cell sem véletlenül olyan, amilyen, mivel az IBM-nél sem hülyék dolgoznak...

-

cwn

tag

válasz

killerjohn

#52

üzenetére

killerjohn

#52

üzenetére

meg szerencse hogy rekurziv algoritmus nem nagyon van gpu-n, meg ugy altalaban a mai processzorok se szeretik

amugy szerintem a larrabee a cell hatasara jott letre, es mivel biztos hogy az intelnel sem hulyek dolgoznak, szerintem a tesztelesi idoszakot fogtak rovidre, gondoltak hogy ha az ibm-nek a cell ilyen jol bejott akkor majd ok is csinalnak egyet

csak az kesobb derult ki hogy az architecturahoz profi programozok kellenek, hogy valami teljesitmeny ki is csorogjon a csovon, olyan mint a forma1-es auto , atlagember el se tud indulni vele, profi kezekben meg a leggyorsabb -

killerjohn

addikt

na ezzel meg én nem értek egyet

az egyetemről kikerültek gyakorlatilag "sima" környezetben is totál értetlenek, nem hogy "fermivel elprogramozgatnak". Egy valós munkahelyen nem lehet elprogramozGATNI

az egyetemről kikerültek gyakorlatilag "sima" környezetben is totál értetlenek, nem hogy "fermivel elprogramozgatnak". Egy valós munkahelyen nem lehet elprogramozGATNI  Amíg a programozók többségének gondot okoz a REKURZIÓ (ami a BME 4. évében kb mítosz szinten van...) addig mit akarunk mi a mai programozó generációtól párhuzamosság szintjén? Bontsák szét a számukra 'kínai' módon működő, átláthatatlan rekurzív algoritmust több szálra?

Amíg a programozók többségének gondot okoz a REKURZIÓ (ami a BME 4. évében kb mítosz szinten van...) addig mit akarunk mi a mai programozó generációtól párhuzamosság szintjén? Bontsák szét a számukra 'kínai' módon működő, átláthatatlan rekurzív algoritmust több szálra?

-

-

Nekem mindig is az volt az érzésem a Larrabee-vel kapcsolatban, hogy csak egyfajta tesztnek szánja az Intel és hosszabb távon azt akarta (vagy akarta volna)elérni, hogy egy jövőbeli sokmagos x86 proci - akár terheléstől függően - elossza a magok között a GPU és a CPU feladatokat.

-

-

dezz

nagyúr

"Hogy most mi van a tarsolyukban, azt tudjuk.

Ha elkezdenek fejleszteni, az lesz az érdekes."Elkezdenek?

Már mióta próbálnak ők GPU-t tervezni (meg hozzá normális drivert), de nem nagyon sikerül. Éppen ezért kezdték el ezt a Larrabee-s vonalat, de ez is bukás, jelen formájában. (Más hasonló formában sem GPU lesz belőle, ugye.) Pedig anyagi erőforrásokban nincs ott hiány. A megfelelő tudásnak viszont nincsenek birtokában. Ha 5-10 év alatt nem sikerült ezen változtatni, mitől változna a jövőhéten? Van egy sanda gyanúm, hogy ez nem úgy megy, hogy az egyik manager kiadja, hogy na jó, akkor csináljunk egy Fermi/Evergreen verő GPU-t, és akkor a mérnök urak leülnek, és terveznek egyet.

Már mióta próbálnak ők GPU-t tervezni (meg hozzá normális drivert), de nem nagyon sikerül. Éppen ezért kezdték el ezt a Larrabee-s vonalat, de ez is bukás, jelen formájában. (Más hasonló formában sem GPU lesz belőle, ugye.) Pedig anyagi erőforrásokban nincs ott hiány. A megfelelő tudásnak viszont nincsenek birtokában. Ha 5-10 év alatt nem sikerült ezen változtatni, mitől változna a jövőhéten? Van egy sanda gyanúm, hogy ez nem úgy megy, hogy az egyik manager kiadja, hogy na jó, akkor csináljunk egy Fermi/Evergreen verő GPU-t, és akkor a mérnök urak leülnek, és terveznek egyet. -

orbano

félisten

válasz

killerjohn

#46

üzenetére

killerjohn

#46

üzenetére

én nem mondtam, hogy könnyű. én arra a kijelentésre replikáztam, hogy nincsenek a programozók kezében PP eszközök. tisztában vagyok vele hogy egy párhuzamos program komplexitása kb. egy normálishoz képest exponenciálisan nő. nem is csoda hogy a sok önjelölt párhuzamos program író meghal egy 50 soros programtól is, mert fingjuk sincs a pp. módszertanról.

-

killerjohn

addikt

egyetértek... ha olyan könnyű lenne, akkor már rég minden párhuzamosítva lenne. Ne vessük már össze a dedós Xkirálynő algoritmust egy valós életbeli algoritmussal, ahol lehet hogy tucatszámra állnak a változók, melyeket csak lockolással lehet párhuzamosan kezelni, az meg a mai processzorokkal borzalmasan lassú...

példának itt van a .NET 4.0, ahol bevezették például a "parallel for utasítást", ami egy ciklus belsejét több magon futtatja. Na kösz: a külső változókat továbbra is zárolva kell kezeleni, továbbá tapasztalatból mondom, hogy teljesen agyament az ütemezője, mert van hogy ugyanazon gépen ugyanazon ciklust (MINDEN ugyanaz...) 4 magnak osztja ki miközben totál le van fogva a gép mással, és olyan is van, hogy nem csinál a gép semmit, és mégis max 2 magra osztja szét (a másik kettő meg malmozik...). És ez a Microsoft, nem a dunaújváros alsó programozó egylet...

-

-

orbano

félisten

"a parhuzamos programozasnal az egyetemi elavult algoritmusok nem hasznalhatok

ezert is bukott meg a larrabee meg a cell, mert olyan megoldas a nyero ami a hulyeknek is megy"egyetemi elavult algoritmusok? muhaha

milyen egyetemre jártál Te egyöcsém? én amondó vagyok, hogy aki nemt ud megtervezni és helyességbizonyítani egy párhuzamos programot, az ne is írjon ilyet, inkább menjen virágkötőnek.

milyen egyetemre jártál Te egyöcsém? én amondó vagyok, hogy aki nemt ud megtervezni és helyességbizonyítani egy párhuzamos programot, az ne is írjon ilyet, inkább menjen virágkötőnek. -

cwn

tag

speciel 17 kirtanynovel teszteltek, legalabb az anandot olvasd el ha mar kotozkodni akarsz

megy az parhuzamosan is,gondolom az osszes variaciot egyszerre futtatjak aztan kiszorjak ami nem jo

a parhuzamos programozasnal az egyetemi elavult algoritmusok nem hasznalhatok

ezert is bukott meg a larrabee meg a cell, mert olyan megoldas a nyero ami a hulyeknek is megy

-

cwn

tag

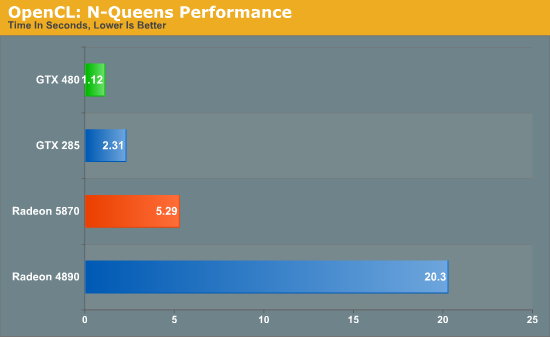

"This benchmark offers a distinct advantage to NVIDIA GPUs, with the GTX cards not only beating their AMD counterparts, but the GTX 285 also beating the Radeon 5870"

altalanos algoritmusnal mint az n kiralyno teszt, lazan 4-szer gyorsabb a gtx480 az atinal

szal ezt hivjak alazasnak azt hiszem, de a gtx285 is uti a 5870 radeontaz egyik jatekra valo a masik meg nem ennyi a trukkje

-

cwn

tag

valami oka csak van hogy az ibm szerverekben fermi van, es nem ati gpu, pedig olcsobb lenne

ibm-nel biztos hulyek dolgoznak...na meg az anandtech is tesztelte, az nvidia architectura 2-szer gyorsabb raytracingben is..

ez van, bele kell torodni -

eXodus

őstag

gyk: a lényeg a kép jobb oldalán.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

cwn

tag

nem fake, hanem opencl teszt, az utolso csikot en rajzoltam bele, mert meg nincs 2 chipes nvidia vga, de a tobbi real

elismerem hogy a fermi nem teljesit olyan jol jatekok alatt mint az ati megoldasai, de GPGPU alatt hulye az aki megkerdojelezi az nvidia felsobbrenduseget, Abu szavaival elve"ez nem jatek gpu"

-

Duree

veterán

Lássuk be,hogy az Intel próbálkozásai nem hoznak sikert ebben a szegmensben.

Már vagy 10 éve próbálkoztak egy önálló grafikus chippel ez volt a 740 de nemigazán tudták felvenni a versenyt a konkurenciával.

Ami nem megy nem eröltetjök -

eXodus

őstag

Viszont 5870 dx11 alatt akár 1000x is gyorsabb lehet mint az i7...

Fermi rt alatt egy kocsit bír csak mozdítani alacsony fpssel és ennyi.dezz

Nem hibáztatom én.

A p4 ahhoz képest h már régen felismerték nem csak az órajel számít, elég sokáig fennmaradt. (Sőt még 2magost is csináltak belőle...)

Itanium is elég sokáig szenvedett. AMD nélkül szerintem simán lenyomták volna az ember torkán... Szerencsére ezt már nem tudjuk meg. -

leviske

veterán

Nah, Abu ! Várnék egy kis előrejelzést/esélylatolgatást, most, hogy így az egyik gyártó felett beborult az ég.

A Larrabee letérdelése mennyire fogja befolyásolni az NVIDIA HPC és mobil front felé irányuló fejlesztéseit? Még jobban ráfekszenek, vagy elkezdenek újra a desktop GPU piacra is koncentrálni? (Jó, tudom, hogy az APU-k miatt sok értelme nem volna, de az Intelnek köszönhetően nyertek nem kevés időt.) Mennyivel jönne ki olcsóbban a játékból az Intel, ha nem a Larrabee-vel próbálna beszállni, hanem benyelné az NVIDIA-t a tapasztalataival együtt? (Csak mert gondolom a Larrabee fejlesztési buktái sem ingyenesek és az NV legalább termel is vissza valamennyi pénzt.)

És az AMD -míg a két ellenfél szenved- mennyi eséllyel tudja a saját szájízére formálni a játékpiacot? Egyáltalán van-e erre esélye, vagy már véglegesen eldőlt, hogy egy Larrabeeféle megoldással kell előállni a jövőben? Vagy nem is annyira a Larrabee, mint inkább az APU-ké a jövő?

De aztán nekem válaszoljál, mert más esetben többet akkor nem szólok hozzád!

(Tudom, ritkán szoktam ilyen kegyetlen és embertelen dolgokkal fenyegetőzni.

(Tudom, ritkán szoktam ilyen kegyetlen és embertelen dolgokkal fenyegetőzni.  )

) -

cwn

tag

az nvidia fermi 10 darab intel i7 processzor sebesseget hozza ugy altalaban, pl raytracing alatt

erre az intel egyszeruen nem kepes valaszt adni jelenleg2 fajta architectura versenyez egymassal, a larrabbee ,meg az ibm cell azt a vonalat kepviseli amiben altalanos processzormagok kapnak helyet, mindegyik sajat thread kezelovel

a fermi pedig a egyseges, kozpontositott thread kezelo és a kulon elhelyezkedo vegrehajtoegysegekben latja a jovotes ez utobbi bar nem annyira hatekony altalanos dolgokra, de jobban skalazhato , mivel a csikszelesseg csokkentesekor, a thread kezelot kisebb mertekben kell novelni , es igy a vegrehajto block / thread block arany egyre jobban novexik

es emiatt a sok kis komplett processzormagos felepitesnek eselye sincs , se most , se a jovoben

az egyetlen ut amivel uberelni lehetne a fermit a szendvics processzor lenne, ami 3 retegbol allna , ugymint 1.vegrehajto reteg, 2.thread reteg,3 beegyazott cache

es koztuk a kommunikacio feny ,vagy indukcios alapon tortenne, mert igy az egyseges felepites miatt a waferek kihozatali aranya messze jobb lenne

nade az intel nem all sajna ilyen szinten meg, majd egyszer talan -

Angel1981

veterán

Követtem a projectet, de a 700mm^2-es GPU új info volt.

Nem csoda, hogy törölték - még a kisebb csíkszélesség sem orvosolta volna igazán. -

zoltanz

nagyúr

Lehet még Atom telefonokban, de állítólag a gyártók kivárnak. 1-2 év múlva jöhetnek olyan procik amik ürásjárási fogyasztása tényleg versenyképes az ARM megoldásokkal.

-

-

dezz

nagyúr

Nem a szerencsén múlott... Maga a koncepció volt a rossz. Hogy ezt lehetett-e előre látni, vagy nem, arról lehetne vitatkozni. De a lényeg, hogy "legközelebb" mivel állnának elő? Mi van a tarsolyukban, ami versenyképes a GF-ekkel és Radeonokkal? Szerintem semmi. Szerinted?

Amúgy szerintem nem igazán az Intel lenne oda kívánatos, mivel ők inkább a többiek erőből lenyomására játszanának, mint igazán versenyképes termékek piacra dobására. (Végülis a Larrabee-vel is ilyesmi volt a szándékuk, csak még ehhez is gyenge volt.) Lásd pl. az Intel részededése a belépő szinten. Egy negyedik, nem túl nagy anyagi háttérrel, de nagy tudással rendelkező, új vagy eddig marginális piaci szereplő belésése vagy feltörése lenne inkább kívánatos. Mint pl. az Imagination Technologies. [link]

-

Hm, hát ha most nem jött össze, majd összejön máskor.

A GPU-k közé kifejezetten kívánatos lenne az Intel, hogy felrázza a piacot. Minél több a szereplő, annál jobb a műsor, és olcsóbbak a hardverek. -

dezz

nagyúr

válasz

Jim Tonic

#17

üzenetére

Jim Tonic

#17

üzenetére

Annó a PS2-t is szídták a vektormagjai miatt (állítólag nehezebb is volt programozni, mint a Cellt), aztán belejöttek... A PS3-mal is hasonló a helyzet.

Az Xbox360-ban sem egy egyszerű Power(PC) proci van, hanem egy némileg butított (in-order végrehajtás), ugyanakkor kétszálas végrehajtásra optimalizált magokból 3, amik akkor teljesítenek megfelelően, ha 6 párhuzamos szálat hajthatnak végre, és még abból is tömény SIMD kódot. (Egyébként ezek a magok nagyon hasonlítanak a Cell PPE-jére (főprocimag).)

Ehhez képest az átlag game-kód, főleg ami a multiplatformokat illeti, mint PC-n is tapasztalhatjuk, többnyire egy, jobb esetben kétszálasak... Így ezek általában még az Xbox360 képességeit sem használják ki teljesen. Bár ez lassan változóban van.

Így a multiplatformok szereplése, illetve kinézete a GPU-kon dől el, amiből az Xbox360-ban összességében egy kicsivel jobb van. Ugyanakkor, egyes dolgokban az RSX a jobb (pl. fillrate-ek), és Celles segítséggel a másik fölé kerededhet, mint ahogy egyes exklúzív játékokban láthatjuk.

Ja, voltak hírek, hogy a PS4-ben már nem Cell lesz (hanem pl. Larrabee

), de szerintem ezek csak találgatások. Egy ütősebb Cell a legesélyesebb (elég akár egy újabb, 32nm-est 2x órajelen járatni, ezt már akár a 45nm-essel is megtehetnék), így a fejlesztőrendszerek továbbra is használhatók lennének, csak kapásból nagyobb prociteljesítmény állna rendelkezésre. És a visszafelé kompatibilitás is adott lenne.

), de szerintem ezek csak találgatások. Egy ütősebb Cell a legesélyesebb (elég akár egy újabb, 32nm-est 2x órajelen járatni, ezt már akár a 45nm-essel is megtehetnék), így a fejlesztőrendszerek továbbra is használhatók lennének, csak kapásból nagyobb prociteljesítmény állna rendelkezésre. És a visszafelé kompatibilitás is adott lenne. -

Én jól írtam. Nem a Cell-lel volt baj. A Sony nyúlt bele ebbe, amikor ezt választotta a PS3-hoz. Volt Kraft, csak az XBOX360 egy egyszerű power procival és egy Ati Xenos (R500) GPU-val gyakorlatilag ugyanazt hozza ebben a szegmensben, csak egyszerűbben, olcsóbban. Jó, tudom, hogy abban is van még egy Nvidia GPU mégiscsak arról van szó, hogy a hihetetlen számítási képességgel akartak lenyomni mindent, a gyakorlatban ez teljesen kiaknázatlan maradt. A PS4 már nem is tartalmaz majd Cellt, ha jól tudom.

-

dezz

nagyúr

"Egyébként a Sony a Cellel ugyanebbe a bilibe nyúlt bele."

Nem igazán a Sony (ők főképpen a pénzt adták), hanem inkább az IBM (a fejlesztés nagy részét ők csinálták). És egyébként nem... Nem tudom, tudsz-e róla, hogy több szuperszámítógép Cell alapú (illetve annak fullos DP FP támogatású PowerXCell 8i nevezetű változatát tartalmazza). A legismertebb köztük a Roadrunner, amit több év után tudtak csak letaszítani az 1. helyről...

Igen, a Cellt nehezebb programozni, mint egy átlag procit, azonban adott fogyasztás és méret mellett többszörös teljesítmény nyújt.

A nehezebb programozás mellesleg inkább csak a laikusok szemében probléma, mivel az SPE-k (vektormagok) belső RAM-ja (ami sokkal kisebb helyet foglal, mint ha cache memória lenne, azaz cache-ből nem 256KB lehetett volna SPE-nként, csak 64, vagy épp 32) és a sokat szídott blockos main RAM elérés éppen a hatalmas sávszél igényt hivatott kiküszöbölni, ami akkor jelentkezik, ha fogjuk magunkat, és egyszerű, a main ramban dolgozó kódokat kezdünk futtatni egy sokmagos procin...

...mint pl. a Larrabee, amikor is egy jó kis dugó alakul ki, a teljesítmény meg a béka feneke alá süllyed, mert a magok csak várnak és várnak. Így aztán itt is neki lehet állni az optimalizálásnak, pl. annak érdekében, hogy minnél ritkábban nyúljanak a main ramhoz a magok, stb. Csakhogy, a Larrabee és más többmagos procik koncepciójából eleve hiányzik az erre való felkészülés.

Pl. a Cell SPE-i azt a bizonyos blockos RAM-elérést DMA-val csinálják, amikor is az adatmozgatás automatikus, miközben a mag számolhat tovább, double-bufferes technikával. Van még pár egyéb trükkje is a Cellnek, most nem fogom mindet felsorolni. Lényeg, hogy rákényszeríti a programozót az optimális kódokásra, viszont azt hw-esen támogatja.

Szóval, a Larrabee amatőr programozóknak való -- a nagy semmire...

Igen, a 32nm-es, 32 SPE-t tartalmazó Cell változat fejlesztése is leállt. Csakhogy nem azért, mert rossz lenne az egész koncepció, viszont időközben rájöttek, hogy egy PPE kevés 32 SPE-re, és több PPE sem lenne optimális, így most egy olyat kezdtek el fejleszteni (valószínű a 22nm-t megcélozva), amiben a butácska PPE-t egy fullos POWER mag váltja fel. (És az SPE-k RAM-ja is nagyobb lesz.)

eXodus: Az Itanium önmagában is bukás lett volna, mint ahogy a P4 is zsákutcának bizonyult... Az AMD-t nem hibáztatni kell mindezért, hanem dícsérni, hogy időben elő tudtak állni más megoldásokkal, nem akadt meg a fejlődés...

-

Jester01

veterán

memória olvasására (scatter) és írására (gather)

Ez nem fordítva vagyon

-

eXodus

őstag

Neked és másoknak:

Larrabee igen is életképes koncepciónak tűnt régen. (és lehet h a jövőben még az is lesz)

Csak egy kis hiba csúszott az elképzelésbe. Az a mocsok AMD![;]](//cdn.rios.hu/dl/s/v1.gif)

![;]](//cdn.rios.hu/dl/s/v1.gif)

Párszor már előfordult ilyen a történelemben (itanium, p4, fermi), és még biztosan lesz is is ilyen a jövőben.Gyakorlatilag most is ugyan azt játssza el az AMD mint 64bit "váltásnál". Van egy teljes értékű, kompromisszummentes x86 processzora, kiegészítve opcionálisan egy rendkívül gyors, de speciális egységgel. SW környezet is szépen fejlődik, ami kihasználja.

-

Mr.Csizmás

titán

ez egy jó cikk, holnap átolvasom mégegyszer

végre tudom, hogy mi is akart lenne az intel GPU-ja

végre tudom, hogy mi is akart lenne az intel GPU-ja

-

Móci

addikt

Hát, ez nem jött be,. Mindenhova azért nem lehet benyomni az x86-t, kedves intel...

-

acsa77

tag

Az Intel ugye megengedheti magának, hogy pár évente becsődöljön egy hatalmas üzlete. Azt hittem, hogy a P4-ből tanultak kicsit. De nem eléggé. Ha valaki elolvasta az anandtechen az interjút a mostani ATI GPU családról, akkor láthatja, hogy jó pár évvel ezelőtt elég pontosan kitalálták azt, hogy mi lesz ma. Az Nvidia pedig ráadásul igen látványosan csinálta a CUDA-val. Tehát mivel biztos nem volt vak és tudatlan az Intel, durván a széllel szemben pisiltek egy lebutított P3 architektúra ilyen furcsa felélesztésével. Úgy, hogy még csak meg sem kérdezik rendesen a leendő felhasználókat.

Naivan még az Atomot is be akarták nyomni az iPadbe...

-

hugo chávez

aktív tag

Kösz Abu, hogy leírtad az Andrew Richards féle elemzés lényegét, így azért számomra sokkal érthetőbb, mint az angol nyelvű.

Azért az 1 GHz körüli órajelű, közel 700 mm²-es chip TDP-je is érdekes lehet.Amúgy arról lehet tudni valamit, hogy ray-tracing-ben a 32 magos Larrabee, vagy a Fermi lenne az erősebb?

-

Lenry

félisten

bár nem vagyok szakértő, de nekem nagyon az jött le, hogy az x86 baromira nem alkalmas GPU-nak, mert sok fontos "GPU-s" dolgot nem, vagy csak nagyon bonyolultan lehet benne megvalósítani, ennek fényében pedig az egész Larrabee-s ötlet úgy hamubasült fasság, ahogy van...

-

tzsolesz

nagyúr

Hát nem értek minden részletet, de azért laikusként is kapisgálom a bukás okát.

Egyébként az Intel, és az NV úgy látom még a jövőben számol a szoftveres megvalósítással, de mi újság az AMD-vel? Ő kiesik a versenyből 2012 környékén? Vagy a Microsofttal karöltve el vacillálnak még a DX16-ig?

(#5) Jim Tonic: Így van, süllyed lesz az. Egyébként nekem mindig aláhúzza a Firefox a helytelenül írt szavakat.

-

Tök f@sza, hogy az van benne leírva, amit 2 évvel ezelőtt beborítékoltam, és akkor teljesen hülyének nézett mindenki. Még Abu is azt mondta, hogy a sw renderelés a jövő, mert a DX11 a vége a régi útvonalnak. Lehet, de biztosan nem az Intel megoldása a nyerő.

Mindig nyilvánvaló volt, hogy egy általános eszközzel sosem lehet felvenni a versenyt a célhardverekkel, akkor sem, ha megkönnyí(he)ti a programozók dolgát. Kicsit olyan, mint a kombinált fogó. Sok mindenre jó, és tuti, hogy csak egy szerszám a sok helyett, de mégiscsak nehéz vele vízvezetéket szerelni.

Egyébként a Sony a Cellel ugyanebbe a bilibe nyúlt bele.Amúgy jó látni, hogy az Intel végre nem tudott valamit pénzből átvinni. Mondjuk a telefonokban sem lesznek Atomok, bármennyire is akarta.

4: süjesztett? Azt a leborult szivarvégit... Te meg hol voltál iskola helyett? Ha már magyar vagy, nem turista, megtanulhatnád a nyelved...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

gfefe

őstag

Szerintem az intel "Gpu" már befuccsolt...

Miért is írom ezt... Még ha elő is szedik a süjesztett terveket 1x és csinálnak vele valamit...

Az ati és az Nvidia addig sem ül a babérjain... ők is fejlesztenek és a lemaradás az lemaradás.... -

proci985

MODERÁTOR

ez így már érthetőbb.

"GPU mérete nagyon közel áll a 700 mm²"

uhh. az nagy. innentől érthető, hogy csak HPCben gondolkodnak (consumer szinten ezt profittal 500-600 usd alatt nem igazán lehetn adni tippre, ott meg nem az 5770OC lenne az ellenfél, hanem az 5970), bár az meg a terméktámogatáson bukhat.elnézve a felépítését nekem inkább egy egy chipen elhelyezkedő többprocesszoros rendszer jut eszembe (ringbus bár azt GPUnál is használják, a memóriák szinkronizációjának komoly problémája és főleg az overhead), mint GPU (de az is lehet, hogy tévedek).

mind1, kutatóknak és fontosabb fejlesztőpartnereknek kiküldeni jó lesz, meg a drivercsapatnak addig is gyakorolni függöny mögött.

azért remélem, hogy a második verziója már jobban sikerül.

-

Giot

addikt

Hm akkor ez így első neki futásra nem jött össze. Végül is érthető idegen terepen poroszkáltak, hiába a nagy tapasztalat CPU tervezés, gyártás terén ez más világ. Azért az ATi-nak nV-nek sem egy két évnyi tapasztalat van hátuk mögött. Remélem nem fogják ennyiben hagyni Intel-ék, és folytatják a fejlesztéseket.

Új hozzászólás Aktív témák

- exHWSW - Értünk mindenhez IS

- Milyen okostelefont vegyek?

- Multimédiás / PC-s hangfalszettek (2.0, 2.1, 5.1)

- MWC 2026: Újból érik a szeder az Unihertz kertjében

- Elegánsan vizezné be a munkaállomásokat az Artic

- sziku69: Fűzzük össze a szavakat :)

- Luck Dragon: Asszociációs játék. :)

- Vicces képek

- Nem lesz Redmi Note 16, évet ugrik a sorozat

- Motorola Edge 50 Ultra - szépen kifaragták

- További aktív témák...

- GYÖNYÖRŰ iPhone 12 mini 64GB Purple -1 ÉV GARANCIA - Kártyafüggetlen, MS3851

- Akciós! Lenovo ThinkPad P15 Gen 1 Intel i7-10875H 32GB 512GB Nvidia Quadro RTX 3000 1 év garancia

- Apple iPhone 13 /128GB /Kártyafüggetlen / 12 Hó Garancia / akku: 85%

- Keresek Galaxy S21/S21+/S21 Ultra/S21 FE

- Beszámítás! MSI Thin 15 B13UC FHD GAMER notebook - i5 13420H 16GB DDR4 512GB SSD RTX 3050 4GB WIN11

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Mostanában mondjuk, így 40 felé közeledve, álláskereséskor néha jól jönne. Bár oda nem is megyek, ahol ez számít.

Mostanában mondjuk, így 40 felé közeledve, álláskereséskor néha jól jönne. Bár oda nem is megyek, ahol ez számít.  ) Viszont nem az időtől függ, ki mire lesz képes, hanem a képességektől. Valakinek 15 év sem elég arra, mint másnak 2-3.

) Viszont nem az időtől függ, ki mire lesz képes, hanem a képességektől. Valakinek 15 év sem elég arra, mint másnak 2-3.

leszámítva persze a platform specifikus dolgokat. de ahhoz meg nem kell 13 év.

leszámítva persze a platform specifikus dolgokat. de ahhoz meg nem kell 13 év.

(A lelkiismeretet és az empátiát meg eleve meg kell tanulniuk elnyomni valamennyire.)

(A lelkiismeretet és az empátiát meg eleve meg kell tanulniuk elnyomni valamennyire.)

Már mióta próbálnak ők GPU-t tervezni (meg hozzá normális drivert), de nem nagyon sikerül. Éppen ezért kezdték el ezt a Larrabee-s vonalat, de ez is bukás, jelen formájában. (Más hasonló formában sem GPU lesz belőle, ugye.) Pedig anyagi erőforrásokban nincs ott hiány. A megfelelő tudásnak viszont nincsenek birtokában. Ha 5-10 év alatt nem sikerült ezen változtatni, mitől változna a jövőhéten? Van egy sanda gyanúm, hogy ez nem úgy megy, hogy az egyik manager kiadja, hogy na jó, akkor csináljunk egy Fermi/Evergreen verő GPU-t, és akkor a mérnök urak leülnek, és terveznek egyet.

Már mióta próbálnak ők GPU-t tervezni (meg hozzá normális drivert), de nem nagyon sikerül. Éppen ezért kezdték el ezt a Larrabee-s vonalat, de ez is bukás, jelen formájában. (Más hasonló formában sem GPU lesz belőle, ugye.) Pedig anyagi erőforrásokban nincs ott hiány. A megfelelő tudásnak viszont nincsenek birtokában. Ha 5-10 év alatt nem sikerült ezen változtatni, mitől változna a jövőhéten? Van egy sanda gyanúm, hogy ez nem úgy megy, hogy az egyik manager kiadja, hogy na jó, akkor csináljunk egy Fermi/Evergreen verő GPU-t, és akkor a mérnök urak leülnek, és terveznek egyet.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

), de szerintem ezek csak találgatások. Egy ütősebb Cell a legesélyesebb (elég akár egy újabb, 32nm-est 2x órajelen járatni, ezt már akár a 45nm-essel is megtehetnék), így a fejlesztőrendszerek továbbra is használhatók lennének, csak kapásból nagyobb prociteljesítmény állna rendelkezésre. És a visszafelé kompatibilitás is adott lenne.

), de szerintem ezek csak találgatások. Egy ütősebb Cell a legesélyesebb (elég akár egy újabb, 32nm-est 2x órajelen járatni, ezt már akár a 45nm-essel is megtehetnék), így a fejlesztőrendszerek továbbra is használhatók lennének, csak kapásból nagyobb prociteljesítmény állna rendelkezésre. És a visszafelé kompatibilitás is adott lenne.

Hoppá Off

Hoppá Off