Új hozzászólás Aktív témák

-

proci985

MODERÁTOR

válasz

Yodamest

#246

üzenetére

Yodamest

#246

üzenetére

5760 ala en szeptemberig egy elsogeneracios i5ot hasznaltam, kb eleg volt. nem ezen mulik. 4kra jellemzoen ket kartya kell, ez 970bolt talan meg mindig a legolcsobb tapot es szellozest figyelembe veve.

a 300ezres hatmagos gondolom nem szemelyes tapasztalat, mert akkor nem mondanal ilyeneket

-

Yodamest

veterán

Jó kártya ez, aki meg 4K ban játszik, 6 magos (12 szál) intel procival az nem is értem minek vesz ilyen kártyát? 300K-s proci mellett a VGA-n spórol? Az is gratula....

-

pzske

aktív tag

-

pzske

aktív tag

Szerintetek arra van esély, hogy Nvidia módosítja a GM204-es architektúrát emiatt vagy az nagyon nagy erőforrás igényelne gyártás részről ?

-

stratova

veterán

Vagy ha gond is lenne valószínűleg érdemesebb pár opciót alacsonyabbra venni (ha az ember nem szeretne plusz kiadást és ragaszkodik az Nvidia kártyához), néhány játéknál már közepes s max. beállítás mellett is vadászni kell a különbségét. A fenti GTX980 vételes példát csak pár a csere/visszatérités kapcsán OEM-ekehez intézett hozzászólásra alapoztam.

-

DNReNTi

őstag

válasz

stratova

#225

üzenetére

stratova

#225

üzenetére

Szerintem e miatt hülyeség lenne visszaküldeni a kártyát, az semmivel sem rosszabb mint amikor megvettük. Én még akár az elállási jog alapon is megválhattam volna tőle (a balhé előtt vettem vagy 2-3 nappal), de eszemben sincs. Maximum az zavar, hogy ez a kavarás ront az értékállóságán így később valszeg olcsóbban lehet majd eladni, mint amennyit valójában ér(ne). Másrészt, kipróbáltam, gyakorlatilag semmivel sem lesz lassabb a FC4, amikor beleszalad az utolsó 500Mb VRAM-ba.

-

stratova

veterán

Mivel az etikai rész már oda vissza ki lett tárgyalva, töprengtem kicsit, milyen egyéb oka lehetett a profitmaximalizálás mellett a 256 bites busz választásának. Az alábbi természetesen csak feltételezés.

1. Technikailag a GM204 elődje a GK104 szintén 256 bites:

GK104: 1536 SP, 128 TMU, 32 ROP 256 bit 28 nm 294 mm^2

GM204: 2048 SP, 128 TMU, 64 ROP 256 bit 28 nm 398 mm^2Tahiti: 2048 SP, 128 TMU, 32 ROP 384 bit 28 nm 365 mm^2

Ami nem teljesen világos, érintettek-e pl a GM204-es mobil vgak. GTX970M 192 bitesként aligha, GTX980 érdekesebb a 1536:96:64 256 bit 4 GB-os konfigurációval.

2. Kepler esetében is a zászlóshajó igen méretes lapkája kapta a 384 bites buszt:

GK110: 2880 SP, 240 TMU, 48 ROP 384 bit 28 nm 551 mm^2

GM200: 3072 SP, 256 TMU, 96 ROP 384 bit 28 nm 632? mm^2Hawaii XT: 2816 SP, 178 TMU, 64 ROP 512 bit 28 nm 438 mm^2

Fiji XT: ? 4096 SP, 256 TMU, 128 ROP 124 bit HBM 20 nm ?3. Már GK110 is tekintélyes darab ill. a feldolgozók számát tovább növelik a várományos utód GM200-nál is. Mindeközben TSMC-nél a legnagyobb 28 nm-es chipméret 650 nm^2. AMD esetében R9 280-as sorozat busza 384 bites ugyan, de a paletta felvégén ez már 512 bitesre dúzzadt. Bár nem tudom pontosan mekkora részét tehetné ki Nvidia esetében a lapka egészének egy ekkora memória interfész; nem kizárt hogy nem lehetne gazdaságosan legyártani, ha GM200-at már így is ~632 nm^2-esnek vélik egyes oldalak.

4. A 28 nm-es gyártósornál maradva Nvidia a konkurenciát megelőzve dobhatja piacra csúcsmodelljét és olcsóbb is lehet a 20 nm-es. Elképzelhető, hogy Fiji XT éppen a gyártói kapacitás/kihozatal miatt várat magára.

Nvidia egyébként akár még jól is kijöhet ebből a helyzetből:

- Aki visszakéri a GTX 970 árát nem feltétlenül R9 290X-re vált - noha az AMD most árat csökkentett, hanem ráfizetéssel 980-ra vált.

- Ezzel megágyaztak a 6, 8 GB-os kártyáknak.

Mindkét esetben felfelé terelik a vásárlóközönséget. -

Loha

veterán

Ha az NV nem vallja be bűnét, senki nem jött volna rá, hogy mi a helyzet, mert senki nem tudja megszámolni, hogy hány ROP egység van a GPU-ban ténylegesen. Az egész csak a 3,5 GB memória miatt lett gyanús, amit minimum még fél évig kenhetett volna az NV akár driver problémára is, megvárva amíg leül a hiszti...

A tejnek tehénből kell kijönnie (államilag szabályozott), ha a reggeli italt kapsz tej néven, az büntetik.

há' úgyse' veszi észre a júzer mer' hülye

Pedig pont pár power usernek lett gyanús a dolog, nem a neves tesztoldalak vették észre.

A tanulság SZVSZ ebből az esetből, hogy a GPU-k belső felépítéséről nincsenek hiteles specifikációk, a gyártó mond vmit, aztán azt vagy elhiszed, vagy nem. -

haxiboy

veterán

válasz

oraihunter

#222

üzenetére

oraihunter

#222

üzenetére

Az oké hogy lebutított kártya, de nem a valóságnak megfelelő paraméterekkel árulták, és tudott róla az Nvidia.

Kérek egy liter tejet az olcsóbbikból, hazaviszem és azt látom hogy színezett aromás víz valójában. Tej ize van, tej van a dobozra írva, de mégsem az.

És ezek után még költsek többet ugyanennek a gyártónak a VGA-jára +30-40 ezer forintot 10% teljesítményért csakmert ők nem voltak képes hiteles specifikációkat írni. Ráadásul a gyártók is ezzekkel a referencia adatokkal árulták a kártyát, amikor kiküldték mindenkinek csak volt ott egy mérnök aki azt mondta hogy ez nem stimmel. De gondolom el volt intézve annyival hogy ...há' úgyse' veszi észre a júzer mer' hülye

-

oraihunter

aktív tag

Akinek ez probléma az vegye meg a 980 -ast és el van intézve. Nem tudom minek kell rágni ezt a csontot tovább. Ez végtére is egy lebutított kártya, és még így is nagyon szép teljesítményre képes!

-

FLATRONW

őstag

válasz

stratova

#220

üzenetére

stratova

#220

üzenetére

Nem tudom, hogy melyik a jobb megoldás, de szerintem az nv kimérte hogy hogyan viselkedik a kártya teljes memória használat mellett és úgy döntöttek, hogy a jelenlegi megoldással nincs semmi baj. A játék tesztek is ezt látszanak igazolni.

Gondolom a tisztán 192 bites megoldáshoz 3 memóriavezérlő mellett 3 GBC-t kellene használniuk, amibe csak 12 SMM fér bele, így a számítási teljesítmény is tovább lenne rontva.

Nem hiszem, hogy a vásárlóknak ez a felállás jobban tetszene. -

stratova

veterán

-

FLATRONW

őstag

válasz

vinibali

#218

üzenetére

vinibali

#218

üzenetére

Emlékezzünk csak a GTX 660 esetére. A 2 GB memóriából csak 1,5 GB-ot tudott 192 bites sávszélesség mellett használni, a maradék fél gigának csak 64 bites volt az elérése.

3,5 GB 256 bit mellett csak úgy valósítható meg, hogy 3 darab 64 bites memóriavezérlőhöz egyenként hozzárendelünk 1 GB memóriát, a negyedik vezérlőhöz pedig fél gigát.

Ez a felállás pedig azt eredményezné, hogy csak 2 GB memóriát lehetne teljes 256 bites sávszélesség mellett használni, a maradék másfél gigát pedig csak 192 bit mellett használhatnánk. -

-

Scholes9

nagyúr

válasz

Outsiderman

#194

üzenetére

Outsiderman

#194

üzenetére

Szerintem meg maradjunk a Földön, de leírom még 1x: odébb van még ennek az elterjedése 😉

-

RPZ

tag

Hát ez igen csúnyán dealbreaker.

Az a szomorú, hogy sokkal jobb lenne egy 3,5GB-os kártya. Sok játék elfoglal minden ramot amit csak tud (amint írák az Anandteches cikkben is. pl. a Frostbite enginesek!). 3,5GB felett bejön a stuttering, punktum. Viszont ha csak 3,5GB gyors VRAMmal rendelkezne, akkor nem stutterelne (mert akkor úgy zabálná csak a memóriát, hogy ne kelljen a RAM-ot is használni). Ahogy írta az egyik user is: 2 db gtx670-el semmi baja nem volt, 2 db gtx970-el meg stutterel.

Ennyi, kár rágódni rajta, ez így kutyaszar.Már most is van 5-8 játék amivel a user IDEGESÍTŐ mikrolagokba fut (1080p-n is!). Mi lesz a következő 2 évben (gondolom a legtöbb játék szépen el fog terpeszkedni a teljes vramon)? 3,5-4GB gyors VRAM még elég lehetne erre az időszakra, de ebben a felállásban a 970 megbukott. Nem lehet valahogy letiltani benne azt a részt?

Az Anandtech írása (miszerint a felső, lassú 500MB vrammal így még mindig jobb kártyát kapunk, mint anélkül) paraszti logika szerint jól hangzik, de az előbb említettek miatt azonnal megbukik.

Persze a valóságban kellene látni, így a kusza írások alapján megállapíthatatlan a jelenség fontossága. Így nem mernék 100k-t rádobni, alternatívája meg nincs most sajnos. Majd talán az R9 380X a Q2-ben (vagy egy 8GB-os 970 .

. -

namaste

tag

A cikk hibás információkat tartalmaz és nincsenek összhangban az NV által kiadott ábrával.

"GPC-hez rendelt ROP blokk"

A ROP-ok az L2 cache szegmensek mellett vannak, azzal együtt tiltják le."GPC-n belül a megmaradt aktív adatbuszok túl lennének terhelve"

Ha egy SMM-et letiltanak a GPC-ben, akkor a megmaradóknak több erőforrás marad."nem igényel rengeteg tranzisztort felemésztő univerzális belső adatbuszt az egyes részegységek között"

A crossbar az micsoda?"Világosan látszik, hogy a letiltott SMM-ek hiányzó adatbuszai miatt a GeForce GTX 970 képtelen használni az összes ROP blokkot."

Dehogy látszik. Azért nem tudja használni az összes ROP blokkot, mert párat letiltottak. -

shiftac

aktív tag

Nem szeretem azt, hogy letiltogatnak ezt-azt az "olcsóbb" kártyákon. Azt hiszem pont itt PH!-n olvastam valamikor, hogy 2008 vagy mióta nem dokumentálja az nVidia az architektúrákat, ebből is akadnak gondok.

-

válasz

proci985

#196

üzenetére

proci985

#196

üzenetére

Lövésem nincs azokról a dolgokról, amely a cikkben van részletezve, csak az érdekel, hogy jól menjen a rendszer, normál használat mellett (Photoshop, Corel, böngészés, stb.) ne legyenek laggok, akadások és élvezhetően fusson a BF3 multi.

Próbaképpen rákötöttem a GTX460-ra és egy új i3-as integrált VGA-s gépre is a kijelzőmet. Mindkét esetben szaggatott még a Windows is. Csak ezért kérdem...

-

Duck663

őstag

Azért kíváncsi lennék, ha a hardverről valahogy kiszivárogna egy dokumentáció, még hány ehhez hasonló sumákságot találnának benne... Lehet a végén az is kiderülne, hogy csak papíron támogatja a DX11-et...

-

Abu85

HÁZIGAZDA

De a programok felé lehet profilozni a rendszert, tehát az, hogy a termék általánosan 4 GB-ot mutat egy új alkalmazásprofillal lekorlátozható 3,5 GB-ra. Az ilyen burn teszteknél az a baj, hogy erre annyira figyelnek a fejlesztők, hogy szinte minden verzióban szívatják a grafikus drivert, így az gyártók már nem foglalkoznak azzal, hogy ezekhez a tesztekhez specifikus profilt készítsenek. Menjen nyugodtan az általánossal.

Szóval ez játékoknál nem lesz gond.

Ahol gond lehet az a DX12, mivel ott a GeForce GTX 970 ennyire specifikus működésére magának a fejlesztőnek kell reagálnia egy specifikus optimalizálással. Erre majd az NV-nek fel kell hívnia a fejlesztők figyelmét, hogy nem elég egy Maxwell path a játékba, hanem kell több is, mert low-level API-val nem tudnak belenyúlni a működésbe. -

proci985

MODERÁTOR

válasz

TigerCat

#192

üzenetére

TigerCat

#192

üzenetére

akkor boven jo lesz szvsz.

290/290x/970/980 kozul innentol egy szimpatikusat valasztanek. msi/asus/giga 970 ar/teljesitmeny/fogyasztas/futes szempontbol szvsz a legjobb osszessegeben.

ha meg par napot varsz valszeg tobb kiderul a 970ek nyugjeirol, nekem meg mindig nem teljesen tiszta, hogy mennyire problemas a kartyak mukodese. mert egyebkent a 970 erre a celra bestbuy.

-

keIdor

titán

válasz

Outsiderman

#194

üzenetére

Outsiderman

#194

üzenetére

Ez az összes olcsó modellre igaz. Ami 60Hz és én meg is vennék az még bőven 300k felett tanyázik.

-

jó kérdés, hogy ez a félreriportálás okozhat-e real-life problémákat. ha sikerül pár ilyet beazonosítani a tesztoldalaknak, akkor akár még változhat is ez a driverben. lássuk meg.

(#187) sb: igen, pont ezt írtam az utolsó mondatban. kicsit sokat hazudik az nVidia az utóbbi időben

-

Andrejka

csendes tag

Én azért láttam már rosszul optimalizált játékokat (Titanfall, Watch Dogs, Assassin's Creed IV: Black Flag), amelyek már fullHD-ben (1920x1200) is megették a GTX 770-en mind a 4GB VRAM-ját is! Nem kellett hozzá UDH. Én MSI Afterburner-el szoktam monitorozni és érdekességképpen meg szoktam nézni, hogy egyes játékok mennyire használják ki a CPU/GPU/VRAM/RAM erőforrásokat az aktuális FPS értékek mellett és bizony-bizony a legtöbbször elszomorító értékeket kapok. Gondolok itt a 30-50 fps-re 50%-os GPU/CPU terhelés és 500MB-1GB VRAM kihasználtság mellett.

-

proci985

MODERÁTOR

válasz

TigerCat

#182

üzenetére

TigerCat

#182

üzenetére

minimalis kompromisszum: lejjebb veszed / kilovod az AAt (ha eleg kicsi a pixelmeret ez nem latvanyos), megelegedsz 40fpssel vagy legrosszabb esetben leveszed a grafikat highra.

szerintem ez meg teljesen vallalhato. ha kell a fix 60fps, akkor szvsz cf/sli fog kelleni. en is ugy voltam vele amikor vettem a 970et, hogy ha kell be tudjak rakni melle meg egy kartyat, de egyelore nem volt ra szukseg.

-

keIdor

titán

válasz

Outsiderman

#184

üzenetére

Outsiderman

#184

üzenetére

Amiből sok 30Hz, PC-re, játékra nem jó.

-

sb

veterán

"Rendkívül erős és aligha fog hiányozni."

Maximálisan igazad van mégis sokkal, de sokkal korrektebb úgy eladni, hogy eleve ezt írják rá.

Ez ugyanaz az eset amikor pl. veszel itt az aprón egy "rendes bolti garis" HDD-t használtan majd az átvételnél kiderül, hogy "Há' garlevél az nincs, de nem is kell. meg amúgy se lesz semmi baja... ki látott már olyat, hogy HDD elromlik?!?!"

Az inkorrektség magyarázkodása.

De sorolhatnék még példákat. Az összese marketing ill. gyártói félreinformálás ugyanez a kategória.

Egy autónál, hogy hány lovas, vagy a fogyasztása... egy TV-ben a panel típus, stb, stb... -

dergander

addikt

Azért kicsit gáz hogy az nvidia eddig hamis adatokkal érvelt,most teljesen mindegy az hogy senkit nem érdekelt,de én nem így ismertem meg a céget

-

Egon

nagyúr

válasz

proci985

#171

üzenetére

proci985

#171

üzenetére

A kolléga a 4K-s felbontás elterjedését említette. Azért, mert te 3 éve használod az adott felbontást, máris elterjedtnek számít?

Statisztikailag reprezentatív vagy önmagadban?

Statisztikailag reprezentatív vagy önmagadban?  LOL...

LOL...

Tavalyi felmérést néztem, az elterjed felbontásokról. A leggyakoribb használt felbontások, még mindig a közvetlenül fullhd alattiak (1680*1050 és társai), de igen sokan használnak pl. 1280*1024-es kijelzőket. Fullhd feletti felbontás elenyésző volt (>10%), és annak is egy része értelemszerűen 4K alatti (pl. 2560x1440). -

#16729600

törölt tag

Nah már kezd elterjedni a botrány elnevezése is "ROPGATE", bár szerintem a " storm in a teacup" jelző találóbb.

-

válasz

FollowTheORI

#173

üzenetére

FollowTheORI

#173

üzenetére

Tehát nem csak ott van butítas, mint ahol újfent állította a zöld cég. Ejjnye, mit hittek, miután kiderült a turpisság, megetetnek a felhasználókkal egy újabb maszlagot? Miért titkolnak olyat, amire ilyen hamar fény derül? Persze költői a kérdés, jobban mutatott az eddigi specifikáció

-

-

Újabb fejlemények az ügyben.

-

proci985

MODERÁTOR

válasz

Scholes9

#169

üzenetére

Scholes9

#169

üzenetére

harom eve hasznalok 5760x1080as felbontast lassan. szoval nem, valos problema, jelen pillanatban is, mielott leirod harmadszor is.

ha meg megnezed az osszes fontosabb nemzetkozi review oldalt, a 970/980 sli honapok ota az ajanlott konfig 5760/4K ala (pont amiatt, mert ket 290(x) legen kicsit meleg).

-

proci985

MODERÁTOR

válasz

MPowerPH

#130

üzenetére

MPowerPH

#130

üzenetére

ja, mondjuk en meg nagyon nem szoktam AAt hasznalni (21.5"os kijelzoim vannak, motortol fuggoen nem nagyon kell).

---

en SLIbol csak 5760/4K tesztet neztem vasarlas elott, 290xnel igazabol a fogyasztas volt amivel nem tudtam volna mit kezdeni (maxwell se TDP szerint fogyaszt, kozel sem, de a 290 rosszabb), tobb radi meg mar nem fer el nagyon hazon belul.

szamoltam vele, hogy az AMD ringbus cimzese sokkal jobb ha kifogyoban a memoria, de azert ez picit durva volt.

en varok mindenesetre az eredmenyekre, a G1em relative halk, huvos, eleg jol is birja, max nem veszek meg egyet belole.

-

Loha

veterán

válasz

westlake

#163

üzenetére

westlake

#163

üzenetére

Gondolom nem az integrált VGA-ról hajtották közben a monitort, Aero-t sem kapcsolták ki, és a böngészőt is nyitva hagyták közben, így ezek pár száz MB-ot lefoglaltak maguknak a VRAM-ból, ami esetén ugyan úgy belassul a benchmark, mert már lefoglalt területre próbál írni.

-

Asbee

veterán

Én szerintem aki nem 4K-ban játszik, ahova a 980 SLI sem árt annak nincs félni valója. De néztem 3,5 giga feletti használattal játék videót, játszható fps-el és nem igazán látszott bármi probléma.

Ha az nv így tervezte tudatosan, akkor kicsit tényleg gáz, hogy ezt nem jelezték, de kicsit túl van lihegve. Nem érzem azt hogy ezért rossz vétel lett volna a G1-em és ennek tudatában is megvenném. -

gainwardgs

veterán

Kell valamin csámcsogni amíg az AMD vajúdik az új radeonokkal

-

jozsef8

aktív tag

Egyébként a hír után direkt megnéztem mennyit bír a ramja. Far Cry 4-ben 4k felbontásban 3945MB VRAMOT megeszi. (970 strix)

-

-

Speed®

titán

Igazából nV részéről ez nem meglepő, mert szeretnek trükközni, de a végeredmény szempontjából meg túllihegett..ettől még marad best-buy a kari, mert emberes tempót diktál jó fogyasztással. Nincs miért sírni szvsz.

-

Loha

veterán

Egyet értünk. Ami probléma lehet ezzel a 3,5 GB-al az az, hogy 4 GB -ot mutat a programok felé a 970, azok meg ha jóhiszeműen kitöltik a 4GB-ot, ahelyett hogy megállnának 3,5 GB -nál, több probléma adódhat, mintha csak 3,5 GB memóriát látnának a kártyán, és szükség esetén a Windows intézné a többletet, mint ahogy ez a videó is mutatja.

-

haxiboy

veterán

válasz

#85552128

#138

üzenetére

#85552128

#138

üzenetére

De ezzel a vram

átkurogatósdologgal nem nagyon tudok mit kezdeni. Most reklamáljak? Ne reklamáljak? Van-e egyáltalán esély visszakapnom/levásárolnom a pénzem vagy éljek vele boldogan? azért nem jó tudat hogy 4GB-s kártyát vettem de csak 3.5GB-t használhatok teljeskörűen mert "vegyes" ramot/vezérlőt pakoltak a kártyára hogy spóroljanak. 110K azért nem kis tétel... -

MPowerPH

félisten

válasz

Outsiderman

#139

üzenetére

Outsiderman

#139

üzenetére

Igen. A problema ott van, hogy Abu elmondasa szerint a DX12 -ben nincs definialva sem a CF, sem az SLI.

Szoszo94: Eddig sem tette. Ramondjak a GM204-re, hogy herelt chip... Elotte ott volt a GK110, az is pont ugyan ezt produkalta.

-

Outsiderman

tag

válasz

MPowerPH

#135

üzenetére

MPowerPH

#135

üzenetére

Azért várj még az eladással. Jön a DX12, még bármi megtörténhet.

A Win10 TP-n már van DX12 API igaz nem végleges, és a 3D Mark API Overhead Future Test is hamarosan megjelenik. Lehet a frissebb fejlesztés miatt DX12-n a GM204 jobban teljesít. De lehet hogy nem. Majd a tesztek eldöntik. -

haxiboy

veterán

Nagyon inkorrektnek érzem, először a coil whine ami az utóbbi időben nálam mintha halkabb lenne/megszűnt volna, most meg ez ráadásul csesztek elmondani. Gondolom arról ne is álmodjak hogy az ipon levásárolhatóvá tenné számomra a kártya összegét, a coilwhine problémával is elhajtottak. (970 g1 gaming tulaj)

-

MPowerPH

félisten

Egyik kartya sem egy best, mindegyik elfogy extrem felbontason. Annyi a kulonbseg, hogy a 970 megtobbet veszit mar multi monitoron, 4K-t nem is emlitem. SLi-t meg csak ilyen felbontasokra erdemes osszerakni, mert FHD-n lazan visz mindent az 1 kartya is.(meg ugy igazabol ott tudnak erosek lenni az R200-al szemben) Mar sajnalkozok, mert en elhamarkodtam, es vettem meg egy 980-ast.

Megprobalom elpasszolni mindkettot, es veszek helyettuk 2db 290X-et, de a 8Gb-st. Ha nem sikerul, akkor sem sirankozok persze, csak nagyobb lesz a penzugyi bukta.

Ha nem sikerul, akkor sem sirankozok persze, csak nagyobb lesz a penzugyi bukta.De ugye en sem nagyon tudtam ezt, az oldalak inkabb csak FHD-n, esetleg 1440P-n tesztelnek. Ott meg nagy az elonye a 980-nak a 290X-el szemben. Ez multi monitornal ellenben majdnem teljesen leolvad. Inkabb ez a szegyen.... Es a 290X mar majd fele annyiba kerul a hasznalt piacon, es meg a 8Gb-s modellek is olcsobban mennek boltbol, mintha hasznaltan akarnal venni 980-ast. Pfejjj...

Megyunk a 4K fele, az NV meg meg mindig az FHD-n tengodik.

-

válasz

westlake

#119

üzenetére

westlake

#119

üzenetére

Ez a kijelentésed nagyon erős volt....az elmúlt pár év legnagyobb újítása egy API volt, aminek hatására jön is a DX12. Szerinted ha a Mantle-t nem fejleszti ki az AMD, jönne a Win10-el együtt a Microsoft oldaláról a válasz?

Ebből a hozzászólásodból sem látszik más, mint egy elvakult Nvidia fan támadása védekezés gyanánt. Rám rámsütheted az AMD fan kijelentést, de előre szólok, egy 6600GT-t használtam a megjelenése napjától 5 éven keresztül nagy megelégedéssel, jelenleg is az ár/érték miatt vettem csak pirosat - 50k egy 280X-ért fél éve kihagyhatatlan ajánlat volt. Örülök, hogy tetszik a zöld oldal, de felesleges a szomszéd kertjébe sz@rni

-

tomas51

senior tag

Különben szerintem arra is rájöttek, hogy egy kicsit túl van árazva az a 980 és most "bemocskolják" a 970-et.

Azért érdemes volna egy tesztet megnézni a 980-ról is ott nincs-e esetleg valami turpisság.

Én pl terveztem a 980sli-t de végül 970sli-lett néztem összehasonlításokat az sli-k között jó esetben 20-25-százalék, értelmetlen vétel lett volna szerintem.

Mert nem éppen 20-százalékkal került volna többe ugye.

Lehet azt hitték majd mindenki 980-at vesz mert húha, aztán mindenki 970-et vett, meghúzták és tessék egy 980......

-

aswmaster

tag

na, még jó, hogy 980-at vettem

-

ViZion

félisten

Engem a cicergés jobban aggaszt... még nem döntöttem, h merjek-e ilyet venni.

-

MPowerPH

félisten

válasz

proci985

#108

üzenetére

proci985

#108

üzenetére

De melyik problema? Mert magaban a tesztprogiban nyujtott szerepleset leszamitva eddig eszre sem lehetett venni. Ok eddig is gond nelkul hasznaltak a VGA-kat, es szerintem ez igy lesz ez utan is. Egyebkent SLi-ben is teljesen rendben vannak, az MSAA-t ugysem tudod feltolni ilyen extrem felbontasban, mert oda meg a 4GB sem lenne eleg. Ellenben pl. az emlitett 5760-as felbontasban a minimalis 2xMSAA-val boven 4Gb alatt maradsz, FPS viszont siman 40, es az ala szorul meg igy is, tehat kell a 2. kartya, es akkor tuti nem megy be 60 ala, ami szerintem alap elvaras. Extrem magas MSAA-t el kell felejteni ezeken a felbontasokon. A tobbi meg mehet maxon, mert azt elbirja a kartya, es a memoria merete is.

-

Dtomka

veterán

válasz

westlake

#119

üzenetére

westlake

#119

üzenetére

Majd meglátjuk...

De a DX12 sem a Microsoft miatt kényszerült megszületni, voltak akiknek elegük volt abból, hogy hiába csúcs vga ha a játékok, programok nem használják ki...Azért sok múlhat 0.5 gb ramon...pl BF4 be ha elfogy a vram akkor az "akadozás" megkezdődik. (fps drop)

-

LGLuke

őstag

Csak szerintem akkor az lenne a korrket, ha le lehetne tiltani a 0,5 GB ramot és akkor SLI-ben később használható a kártya 4K felbontás mellett. Mert ez így nem 3,5 GB, hanem ha véletlenül valaminek több memória kell, akkor belassulhat az egész. Szerencsére ma még nincs sok hatása, de ki tudja, hogy 1 év múlva mi lesz.

A másik lényeges szmpont, hogy 5-10 évvel ezelőtt a következő VGA generáció szinte minden tagja újat mutatott.

Ma már sok esetben csak a csúcs kártya kapja meg a legújabb chipet, a következők, pedig az előző széria átcimkézése. Tehát egyrészt nem kell olyan vadul cserélni a kártyákat, így aki ma 100+ K HUF-ot kifizetett, az lehet 2-3 évre tervezett legalább.

Illetőleg nem kizárt, hogy a következő generációban ugyanez megtalálható lesz a középkategóriában, amikor már bizony SLI-ben biztosan visszafogja majd a 4K-t. -

imi123

őstag

1 napig amíg el nem füstöld tulajdonosa voltam egy G1 gaming 970-nek.

Le a kalappal az Nvidia előtt.Egy 290X-ról akartam váltani.Nem számít hogy érték el hogy ilyen baromi gyors lett a kártya. Egyszerű de nagyszerű megoldások.Nem hiszem hogy egy ideig gond lesz ezekkel a karikkal.Minden specifikációt nem írhatnak rá a kártyára.A vásárlót az érdekli hogy menjen mint a meszes!Na ez megvan.Egyébként korrekt cikk lett.Vártam már.Sejtettem hogy az Nvidiások támadásnak veszik.Pedig nem az! -

hát ez egy érdekes fordulat (én Anandék cikkét olvastam először, az valamivel alaposabb). a legszomorúbb az egészben az, hogy az nVidia még a 2 nappal ezelőtti kommunikációban is heveny marhaságokat írt, ugyanis a kevesebb SM-nek semmi köze a problémához

végeredményben érdemes úgy nézni a 970-et, hogy 1664 ALU, 104 TEX, 56 ROP, 224-bit, 3.5GB. a 329 USD-s nyitóáron ezekkel a specifikációkkal is rendkívül erős, és a low-speed 0.5GB aligha fog hiányozni 1-2 extrém eseten kívül. viszont nem ártott volna a vásárlókra bízni ennek az eldöntését...

-

Egon

nagyúr

Úgy gondolom, Abu korrektül leírta a lényeget.

Szerencsétlen GTX 970: nem elég a cicergés, most még ez a sztori is...

Nem tudom, mi lett volna a legszerencsésebb megoldás. Ha eleve 4-0.5 GB-osnak jelölték volna ezeket a kártyákat, az szvsz visszavetette volna az eladásokat (annak ellenére, hogy jó eséllyel csak extrém körülmények között jelentkezik a limitáció).

Talán az lett volna a legjobb választás, ha mondjuk 3 GB-osként lettek volna hirdetve: a leleményes tesztelők/vásárlók így találhattak volna rajta "ingyen" fél gigát, és mindenki boldog lenne, még azok a tulajok is, akik most háborognak, pedig végeredményben ugyanazon vas birtoklói így is-úgy is...![;]](//cdn.rios.hu/dl/s/v1.gif)

-

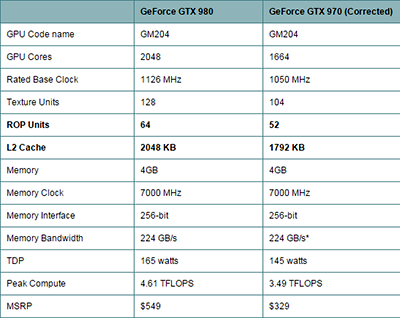

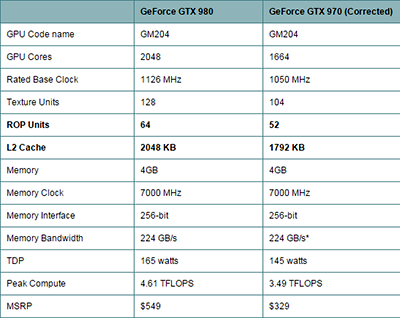

Loha

veterán

Itt a megfejtés:

NVIDIA Discloses Full Memory Structure and Limitations of GTX 970

GTX 980-hoz képest a ROPok, és a cache mérete is meg lett nyirbálva a GTX 970-ben:

-

dergander

addikt

Érdekes hogy az Nvnél az egyes elemek letiltásával mondjuk a többi részegység teljesítménye is romlik. Gondolom tervezésnél csak 980-ra összpontosítottak,ígyhát arra fejlesztették ki minden porcikáját. A csúnya pirosaknál érdekes mód nincs ilyen probléma,ez szerintem a GPU felépítésében van,tehát az nvidia nem a selejtesebb GPUkra számol,valamint nem tesztel utána hogy most mi is.

A legnagyobb baj pedig az hogy bármilyen Bestbuy kártya is,mindig akad sok emberke aki keres problémát minden hülyeségre. -

Hmmm...hibának nem hiba tehát, ugyanis ilyennek tervezték. DE! Szerintem ezt fel kellett volna már tünteniük a piacra kerülés előtt, hogy az utolsó ~0.5GB csak teljesítményvesztéssel használható. Ha valaki kihasználna mind a 4GB-ot és emiatt vette ezt a kártyát, akkor vele szemben csúnyán elbánt az Nvidia, lehet jobban járt volna egy nyers erőben gyengébb, de valós sebességgel elérhető 4GB-os verzióval. Csak hát ugye erről nem tudott (és nem is sejtette) senki eddig.

-

Scholes9

nagyúr

Amúgy meg mire a mostani 970 tulajok egyáltalán oda jutnak, hogy 4k-s monitorra váltanak már rég nem a 970 fog a gépükben dolgozni 😊

-

CARNIVAL

csendes tag

szerintem nem kell nagy felbontás meg AA kell hogy elő jöjjön majd a probléma

ha bekapcsolsz 8MSAA kevesebb fps-t fogsz kapni, mert nem bírja a gpu, de

egy kártya soha nem lassul be attól hogy elfogy a vram...én még ilyet nem tapasztaltam

ami történik az az hogy a textúra streamelésben lesz késés vagy hiba, főleg olyan engine-ban mint a idtech 5 ahol a vram nagyobb szerepet kap mint bárhol.én legalábbis így tudom

-

sb

veterán

Pl. nem vesznek kártyát. Vagy máshogy néznek rá.

Egy biztos, az érvelésed nagyon véleményes. Miszerint nincs leírva, hogy az egész memót azonos sebességgel éri el, tehát ha nem így van az nem hazugság és nem gond.Hazugságnak valóban nem az, de gond, mert félrevezető. Vannak nem csak jogi és logikai síkok, hanem ilyen izé... hogyishívják... "erkölcsi", talán ismerős a szó... nézőpont is.

Ha egy vga mellé odaírják, hogy X GB ram, ill. sávszélesség = Y ez 20 éve ugyanazt jelenti.

Akkor is ha nem írták soha mellé 20 év alatt, hogy a ram összes blokkjára igaz.Ettől eltérőt gyártani és nem leírni sehol: ez félrevezetés, elhallgatás.

Aminek lehet, hogy nincs semmi jelentősége, hiszen, nem azon a 0.5GB-on múlik a kártya teljesítménye.

Az elhallgatásnak már annál nagyobb a jelentősége... mert tudod, hogy létezik és azon gondolkodsz mi az ami máshogy működik még mint ahogy le van írva (vagy nincs leírva).Szóval vicc, de nem is maga a megoldás ami negatív, hanem a kommunikációja.

Tök egyszerű logikai ok-okozati összefüggés ez is a maga nemében.

-

proci985

MODERÁTOR

...

nezzuk a jo oldalat, hogy hala egnek megse vettem a karacsony utani raktarsopresben meg egy G1et.

de ha ezt tudom lehet 290x lett volna.

Outsiderman: slivel jellemzoen mar most is megvan a 60fps, nem kell dx12re varni.

Keldor papa: nyugatabbra ezeket a kartyakat SLIbe veszik 5760/4Kra. egy reszrol keves ember erintett, masreszrol viszont pont, hogy a celcsoport egy reszet kapja telibe a problema.

-

Hellwhatever

aktív tag

válasz

Hellwhatever

#102

üzenetére

Hellwhatever

#102

üzenetére

Akarom mondani: kardélre

Bocs, lejárt a szerk. idő.

-

helkis

veterán

mindig ugyanaz a 0.5Gb lassul be? (hiába utolsónak mondják, a memóriaterület lehet más szvsz) ezt kéne kideríteni/bizonyítani..

ha dinamikusan változik a letiltott memória helye, akkor mind a 4Gb és a 224Gb/s paraméter is hibátlan mindenhol gyakorlatilag, +pontosan az van, amit nV-jék mondanak, hogy ezt a csonkítás miatti túlterhelés eshetőség elleni softveres harc miatt kellett bevetni egyfajta védelem, ami előnyös mindenkinek..

tegyük fel, hogy kijön a 980, majd a 970. be van marketingelve, stb.. ahogy szokott lenni, tesztek faják..

viszik mint a cukrot, majd jönnek a kistesóval a problémák, fagy, kilép, bsod, stb.. akkor ezek a kártyák garanciális cserék lennének.. nv-jék ekkor táv-orvosolhatnák a dolgot, pl. kiadnak egy friss drivert, ami azt tartalmazza, mint amit most is, ekkor mindenki elégedett lenne, hogy milyen jól orvosolta a gondot az nV..

-

Hellwhatever

aktív tag

Abból milyen sírás lesz amikor a csili-vili Drive CX-es Merci az Autobahn közepén 250km/h-nál dob egy OUT_OF_MEMORY_EXCEPTION -t..

Mielőtt valaki kardnyélre hányna: 970 tulaj vagyok

-

Decske

senior tag

Nem jó, hogy ilyenek derülnek ki, de ez az én szememben nem von le a kártya értékéből. Eddig nagyon meg vagyok elégedve vele.

Új hozzászólás Aktív témák

- Vezetékes FÜLhallgatók

- Apple MacBook

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Xiaomi Pad 6 - kiapadhatatlan jóság

- Apple Watch Sport - ez is csak egy okosóra

- Filmvilág

- Samsung Galaxy A56 - megbízható középszerűség

- Audi, Cupra, Seat, Skoda, Volkswagen topik

- Nintendo Switch 2

- Autós topik

- További aktív témák...

- Epson Workforce DS-530II dokumentumszkenner

- Gamer PC-Számítógép! Csere-Beszámítás! I7 6700 / Rog RX580 8GB / 32GB DDR4 / 500GB SSD

- Macbook Pro 2019 15"// i7 // 512GB // Számla+Garancia //

- Bomba ár! Dell Latitude 5490 - i5-8GEN I 8GB I 256GB SSD I 14" HD I HDMI I Cam I W10 I Gari!

- Magic Trackpad legújabb fajta, lightning csatlakozóval

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Statisztikailag reprezentatív vagy önmagadban?

Statisztikailag reprezentatív vagy önmagadban?

![;]](http://cdn.rios.hu/dl/s/v1.gif)