Új hozzászólás Aktív témák

-

nexplo

őstag

válasz

Sontir Fel

#298

üzenetére

Sontir Fel

#298

üzenetére

Van aki LIDL-be jár Ferrari-val. Nem vagyunk egyformák. Az biztos hogy láttam már nem egy gépet amit "profik" szereltek és a csatik nem voltak teljesen koppanásig tolva. Simán benne van hogy bár a helyén volt a csati, nem "kontaktolt" rendesen és itt azért van hő és fogyasztás rendesen. Majd írd le hogy mi lett a sztori vége, remélem jó lesz a vége garancia szempontjából

-

Sontir Fel

őstag

Az ő esetében az a vicc, hogy máshogy ül a lovon. Nem játszik fő

fpst például. Leginkább Civilizációval játszunk![;]](//cdn.rios.hu/dl/s/v1.gif) Úgy tekint erre, hogy megveszi és 5+ évig jó lesz. Azért is bosszantó az olvadás, mert elmondása szerint egésznap youtube videókat nézett, amikor bekövetkezett a katasztrófa

Úgy tekint erre, hogy megveszi és 5+ évig jó lesz. Azért is bosszantó az olvadás, mert elmondása szerint egésznap youtube videókat nézett, amikor bekövetkezett a katasztrófa

-

nexplo

őstag

válasz

Sontir Fel

#296

üzenetére

Sontir Fel

#296

üzenetére

Gondolom ő nem ezt a vonalat képviseli

De igazad van amúgy

De igazad van amúgy

-

nexplo

őstag

válasz

Sontir Fel

#292

üzenetére

Sontir Fel

#292

üzenetére

Az ekkora fanatizmus érthetetlen számomra, de az tény hogy kártya fronton nem nagyon van más alternatívája

-

BusinessGuy

őstag

válasz

Sontir Fel

#292

üzenetére

Sontir Fel

#292

üzenetére

Aha ok...

-

Sontir Fel

őstag

válasz

BusinessGuy

#290

üzenetére

BusinessGuy

#290

üzenetére

Annyira fanatikus nvidiás, hogy szerintem ha elhajtja a gyártó, hogy az ő hibája, szó nélkül vesz másik 4090est. És addig ismétli a storyt amíg nem megy tönkre

-

Dr. Akula

félisten

válasz

BusinessGuy

#288

üzenetére

BusinessGuy

#288

üzenetére

A kibicnek ugyebár semmi se drága...

-

BusinessGuy

őstag

válasz

Sontir Fel

#289

üzenetére

Sontir Fel

#289

üzenetére

Aha ok...

-

Sontir Fel

őstag

válasz

BusinessGuy

#284

üzenetére

BusinessGuy

#284

üzenetére

Ismerősömnek most volt volt olvadás, szóval nem egy ritka jelenség

Ami igen szomorú hír, hogy már corsair gyári kábellel is van eset

-

BusinessGuy

őstag

válasz

Dr. Akula

#286

üzenetére

Dr. Akula

#286

üzenetére

1 eset....

Az meg hogy jól volt rádugva nem jelenti azt hogy véletlenül nem mozdította el.

Ha nem túlfújt lufi lenne hemzsegne tőle a net...Ehhez képest redditen meg pár helyen pár user akik meg képet is raktak es ennyi....Ráadásul messziről jött ember azt ír amit akar pláne ha fanatikusokról van szó akik képesek az utált márkát bármikor rossz színben feltüntetni 5 perc hírnévért és csak hogy legyen min csámcsogni függetlenül attól hogy amd nvidia intel vagy bármi más.Miért nem tömeges az eset miközben jócskán fogyott a kártya?

-

Dragon3000

nagyúr

válasz

Dr. Akula

#286

üzenetére

Dr. Akula

#286

üzenetére

Lehet, hogy 1 éve használatban volt, de arról nem ír, hogy ez idő alatt bármikor is szerelt e valamit a gépben, és közben meg mozgatta e a kábelt vagy sem.

Mással kapcsolatban nagyon sokszor derültek ki utólagos dolgok, amikor az illető azt állította, hogy hozzá sem nyúlt, aztán a fél berendezést átszerelte..... -

Dr. Akula

félisten

-

BusinessGuy

őstag

válasz

Dr. Akula

#281

üzenetére

Dr. Akula

#281

üzenetére

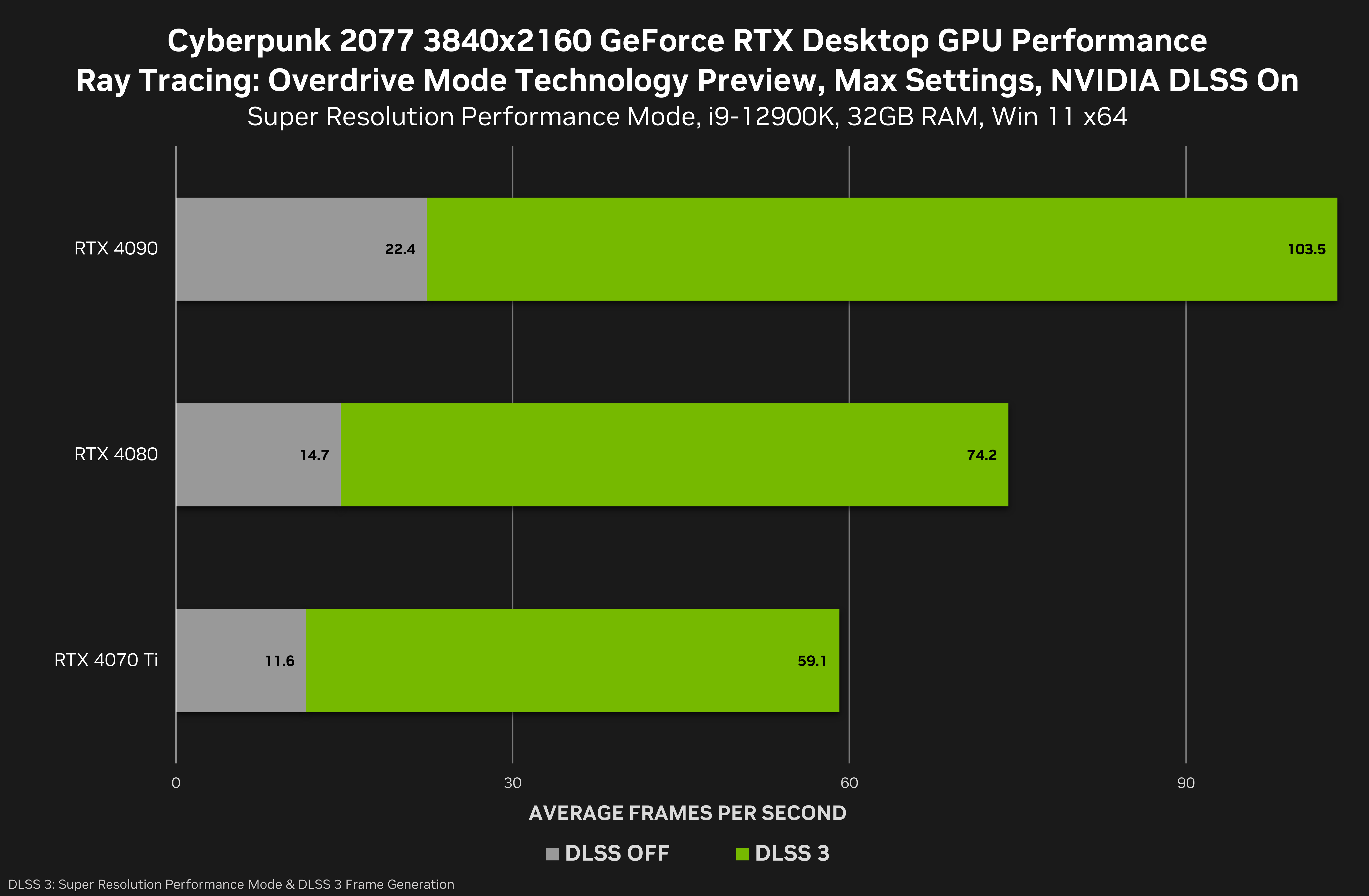

Ez a leolvadás egy borzalmasan túlfújt lufi ami egy maréknyi usert érintett ott is javarészt user error miatt valamint a fene tudja hogy hány olyan fanatikus pénzes idióta van aki direktbe okozza a problémát. 4090-nál végképp csak egy lufi... Hibás kábelrendezés/feldugás illetve egyes állatoknak nem elég a 4090 alapon vagy oc profillal (amik egyébként játékok alatt 400-500w között vannak kb a 4090-eken), még felfeszelik és 600w-ra lövik amúgy teljesen értelmetlenül a teljesitményt pár százalékért miközben alulfeszelve pár százalék vesztéssel konkrétan brutálisan csökkenthető a fogyasztás és a vele járó hő - és esetleges problémák...

Ismerettségi körben van 4090 máig semmi baja - a fogyasztásról annyit hogy 420w-nál nemigen látott még többet a kártya, Alan Wake 2 az első ami megizzasztja 460w körül - koxon sync és fps limit nélkül. Alapbeállitásokon.... Ennyit benyel gyári OC profillal az EVGA 3080-am (410w-ig fel felszalad AW alatt)...

Powerlimitelve és Undervolttal 1-2% teljesitményvesztés mellett gyakorlatilag kevesebbet zabál mint a 3080-am, pláne ha még sync-et és maxfps-t is kap a tv-hez mert akkor ahol a 3080 60 fps-hez nyeli a 350 wattokat nálam 70 fokon ott a 4090 cirka 100 watt körül ketyerészik 48 fokon...

-

Dr. Akula

félisten

Valahol olvastam, és szerintem ez lesz az igazság, hogy ott olvad ahol sok áram megy át rajta. Egy akár 600W-os 4090-ben ez nyilván esélyesebb, mint egy 450-es 4080-ban. Ez viszont azt jelenti, hogy gyári selejt a csatlakozó, tökéletes kontakttal talán most még elbírja, de a vga-k áramfogyasztása mindig megy feljebb, ha nem most, majd a nextgennél fog elolvadni mind. Ide inkább Molex csatikat kellett volna rakni, meg vastagabb kábeleket, erre pont az ellenkezőjét csinálták. Meg is lett az eredménye.

-

nexplo

őstag

válasz

Sontir Fel

#279

üzenetére

Sontir Fel

#279

üzenetére

4080-ról én sem váltanék. Sajnos itthon az 1400euró igencsak esélyes ahogy állunk mostanság

-

Alogonomus

őstag

Szerintem sem fogja megváltani a világot a 4080 Super. Arra próbáltam utalnia válaszomban, hogy a 4080 Super bár egyértelműen a vanilla 4080-nál erősebb kártyaként érkezik, mégis némileg, vagy akár jelentősebben is alacsonyabb áron lesz kénytelen piacra küldeni az Nvidia, mert azon az áron lehet nagy mennyiségben eladni. A Super kártyákkal lényegében egy jelentősebb árcsökkentést lép meg az Nvidia, de jobban néz az ki úgy, ha új kártyát ad ki alacsonyabb áron, és nem a már piacon levők hivatalos árát csökkenti jelentősen. Végeredményként ugyanúgy egy jobb ár-érték arányú terméket ér el.

-

válasz

Sontir Fel

#270

üzenetére

Sontir Fel

#270

üzenetére

Elolvadós csati a 4090-ek egyes darabjait érintette, 4080-as olvadásról egy hírt se olvastam.

-

válasz

Alogonomus

#271

üzenetére

Alogonomus

#271

üzenetére

Az se fogja megváltani a világot +5% körüli sebességnövekedéssel.

-

nexplo

őstag

válasz

Sontir Fel

#274

üzenetére

Sontir Fel

#274

üzenetére

Ez a jövő zenéje

-

nexplo

őstag

válasz

Alogonomus

#271

üzenetére

Alogonomus

#271

üzenetére

A 4080 S talán lefele billent mindent árban. A reális az lenne ha a 400K-s 4080 S után a 360K-s sima 4080 majd 320K körül a 7900xtx. De ez csak az én véleményem

-

nexplo

őstag

válasz

Sontir Fel

#270

üzenetére

Sontir Fel

#270

üzenetére

Igen a csati az sz@r lett mondjuk ki

Az a baj hogy a nyers erő a mai világban nagyon keveset ér. Szoftveresen bármit bármikor le lehet kukázni hiába gyors alap esetben. Minden esetre mindkettő jó kártya. Reméljük még olcsóbbak is lesznek.

Az a baj hogy a nyers erő a mai világban nagyon keveset ér. Szoftveresen bármit bármikor le lehet kukázni hiába gyors alap esetben. Minden esetre mindkettő jó kártya. Reméljük még olcsóbbak is lesznek.

-

Alogonomus

őstag

A 300e vs. 420e alapján kialakuló 40% felárat garantáltan nem éri meg a 4080 az 7900 XTX ellenében.

Nem véletlen, hogy még a 4080 Super ára kapcsán is legfeljebb olyan tippek keringenek, hogy a 4080 jelenlegi áráért érkezhet januárban, ami 20%-kal van a 7900 XTX jelenlegi ára fölött. Egyes tippek pedig egyenesen inkább csak 10%-os felárat tippelnek, amivel éppen $1000 alatt maradna a 4080 Super a $999-os árával. A 4080 eredeti $1200-os árával senki sem számol a 4080 Super kapcsán. -

Sontir Fel

őstag

Viszont a negatív oldalon ott van a szutyok elolvadós csati és a 16gb memória szemben az amd 24essel. + Ha valakit tényleg hidegen hagy a dlsst és az RT (engem PL az utóbbi annyira nem mozgat meg) akkor nyers erőben a 7900 van játék ahol megbarackolja a 4090est is

![;]](//cdn.rios.hu/dl/s/v1.gif) ha COD mániás lennék, valószínűleg abba az irányba indulnék el

ha COD mániás lennék, valószínűleg abba az irányba indulnék el

-

nexplo

őstag

válasz

Sontir Fel

#268

üzenetére

Sontir Fel

#268

üzenetére

Tudom kicsit vulgáris (sorry) de így van. Itt a 79XTX vs 4080 a nehezebb ügy mert ott 350e Ft vs 420e Ft a kezdő ár kb most amik fenn vannak. Szerintem a 300 szint környékén érné meg a 79xtx az nv-vel szemben. Így hogy nagyon közel vannak egymáshoz, így az nv talán a jobb választás.

-

nexplo

őstag

válasz

Sontir Fel

#263

üzenetére

Sontir Fel

#263

üzenetére

Itt PH-n 7900xtx 350e Ft-tól, 4090 600e Ft-tól indul. Nem egy árkategória a kettő bezony. Én majd 2e euroért (4090) biztosan nem venném meg... jó kártya de azért a lóf@sznak is van vége na

-

Sontir Fel

őstag

válasz

Busterftw

#264

üzenetére

Busterftw

#264

üzenetére

Az nagyon barátságos ár volt. Sokáig nézegettem, hogy akkor mit is vegyek (májusban vásároltan végül) és emlékezetem szerint a legolcsóbb egy bontott PNY 4090 volt 1600 euró magasságában - további hátránya a kevesebb garancia mellett, hogy nem járt hozzá Diablo 4. Mondjuk most pont van egy bontott 1.678ért, 3 éf garanciával

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Busterftw

nagyúr

válasz

Sontir Fel

#263

üzenetére

Sontir Fel

#263

üzenetére

Tegyuk hozza, hogy az utobbi 1 honapban sokat dragult a 4090 a szankciok miatt.

Olcsobb modellek anno voltak 1500eur-ert is. -

hahakocka

őstag

válasz

Dr. Akula

#254

üzenetére

Dr. Akula

#254

üzenetére

Pont te trollkodsz hisz tèged idèztelek hogy 20-30 fős is elèg a látvány a lènyeg ezt írtad! Lènyegèben. Önmagadat trollkodtad egy 1 db Rt dlss3.5 game el. Nèzd meg az Alan Wake eredmènyeit pl natívon vagy hogy raszterben a totàl sponsor Nv S Cyberpunkban jobb az Amd, ami fura.

Dlss-Fsr T màr próbàltam Dlsst egy ismerősnèl, FSR-t Starfieldnèl nàlam. S max 4K ba èri meg esetleg ha nincs meg a 60-80fps. Amúgy ghostingol artifaktok szellemes hatása van. Az Fsr3-Dlss3 meg akkor jobb csak ha pl megvan a 60 fős feletti natív erő mert input lag lesz kb.. Ez a framrgen àtka. Nem hiàba sokan akkor is Dlss2-Fsr2 T hasznâlnak inkàbb. Nem lesz mosottas S laggos. -

nexplo

őstag

válasz

BusinessGuy

#234

üzenetére

BusinessGuy

#234

üzenetére

NV lesz a befutó ahogy látom. Kivárom hátha vágnak az árakon az új jövevények miatt

-

Create.

addikt

válasz

Dr. Akula

#254

üzenetére

Dr. Akula

#254

üzenetére

Milyen jó is azzal az input laggal játszani. Mintha filccel felírnám a monitorra, hogy 100fps, kb annyit ér. Egyébként is a framegent akkor ajánlják, ha megvan az átlag 60fps framegen nélkül is.

Azt nem vitatom, hogy jobb az nvidia, mint az amd, illetve a dlss, mint az fsr, sajnos afelé megyünk, hogy kötelező lesz a használatuk, de a framegen értelme ilyen formában kb nullával egyenlő.

-

BusinessGuy

őstag

válasz

Dragon3000

#253

üzenetére

Dragon3000

#253

üzenetére

Dlss-el nemigen van ilyen.

De lényegtelen, gyosabb? Gyorsabb. Továbbra is egyetlen feltétel mellett jobb a 7900xtx a 4080-al szemben. Ha full nyers erőt nézünk es így az árat ignorálva minden mást. Amint beugrik a dlss ez már nem igaz. Márpedig 10-ből 9 alkalommal ma már beugrik a dlss. Ez van. Sajnos ez a tendencia a fejlesztők az fsr/dlss kombinációba kapaszkodnak. Ez a trend ez a jövő. Az FSR-t pedig változatlanul max a dlss2 mellé lehet odatenni oda is jóindulattal.... -

Dragon3000

nagyúr

válasz

BusinessGuy

#251

üzenetére

BusinessGuy

#251

üzenetére

Mégegyszer ott nem két kártya teljesítmény összehasonlításáról volt szó, hanem, hogy mi értelme kikapcsolni az rt-t. Arra írtam, hogy van olyan játék, ahol a 4080 rt-vel 4k-ban 30 FPS alatt teljesít, így ott azért, hogy legyen FPS is. Abban a játékban hiába lenne 1080 a gépben, ha rt nélkül a 4080 is csak 60 fps-t tud kipréselni magából 4k-ban. Na meg ha 4k-ról van szó, akkor nem low grafika mellett, és az rt on/off közt jelenleg a legtöbb játékban alig van észre vehető grafikai különbség.

-

Busterftw

nagyúr

válasz

hahakocka

#250

üzenetére

hahakocka

#250

üzenetére

Teljesen irrelevans egy-egy kiragadott pelda, nagy atlagban raszter/price-ban mindig is jo volt az AMD.

A raszter ero mindig is fontos volt, ez most sem valtozott, csak emelle bejott az RT teljesitmeny is. Semmi nem valtozott, az AMD ugyanugy atlag lassabb mint az Nvidia, olcsobban, csak ekozben az RT jobban lehuzza oket, ez van.

Ezekre a vitakra pontosan emlekszem az RTX 2080 es Radeon VII eseteben. Ment a blama, hogy az RT miatt dragabb az RTX 2080, mikozben a valosag az volt, hogy mire megjelent a RadeonVII, 2080-et kb egyarban arultak vagy volt 50 dollar differencia, az RT mellett raszterben is gyorsabb volt atlagban a 2080.

Vegyel egy normalis telefont.

-

BusinessGuy

őstag

válasz

Dragon3000

#240

üzenetére

Dragon3000

#240

üzenetére

Az ugyenem gond hogy még mindig arról van szó hogy melyik kártya képes azonos beállításokkal a kornak megfelelő megoldásokkal magasabb fps-re?

A te felfogásod szerint akkor egy gtx 1080 is jobb hisz inkabb leveszem a grafikat a 60 fps-ért mintsem rt-vel jatszak a 4080-on...

Továbbra is: 2023-ban dlss és rt kihagyással szigorúan nyers erőt nézni nettó parasztvakítás és ez maradni is fog.

-

hahakocka

őstag

válasz

Busterftw

#246

üzenetére

Busterftw

#246

üzenetére

Raszterben nem volt mindig jobb. Árban max S nèha fogyasztásban - difi volt most plusz van. Èn a Dlss-Fsr T említettem n gatívan S marketing rèsznek mely elfedi a règebben mèg oly fontos fórumokon hangoztatott raszter VGA szimpla erőt. S nem kell annyit optimalizàlni se.. Rt ből jó dolgok nőhetnek ki a jövőben, de most mèg nem, hisz jó sokan tudjàk 60 fps- el natív tolni se Rt vel a gameket. Alan Wake 2 nagyon szèp amúgy!

-

huskydog17

addikt

válasz

Alogonomus

#228

üzenetére

Alogonomus

#228

üzenetére

"Attól, hogy a 2016-os állapotot kiegészítették plusz funkciókkal, még nem vált modern motorrá a Northtlight."

Hol szerepel a 2016-os állapot, hol állítottak a készítők ilyet?

Tehát szerinted az egyik legmodernebb leképzési technikával, forradalmian új technológiákkal, soha nem látott geometriai részletességgel a modern nem motor. Aha, érdekes meglátás. Szerinted akkor mi a modern? Szerintem gondold át újra.

Tehát szerinted attól, hogy motor moduláris, nem lehet modern? Ezt komolyan gondolod?

Mit értesz az alatt ,hogy moduláris és miért gondolod, hogy az új Nortlight is ilyen és ettől nem lehet modern? Ha elolvastad volna a linkelt blogot, akkor talán látnád, hogy mekkora butaságokat hordasz össze, szerintem olvasd át és próbáld megértelmezni, mert a tények neked ellent mondanak. -

Alogonomus

őstag

válasz

Dragon3000

#247

üzenetére

Dragon3000

#247

üzenetére

Csak rosszul olvastuk eddig a nevét. Az "a" után oda kell képzelni egy szóközt

.

. -

Busterftw

nagyúr

válasz

hahakocka

#245

üzenetére

hahakocka

#245

üzenetére

Nem tudom te hol eltel eddig, de az AMD eddig is jobb volt ilyen szempontbol.

Az mar inkabb erdekes, hogy miert lepodsz meg azon, hogy ha valami lassabb/nem olyan gyors az olcsobb, illetve miert nem tudod felfogni, hogy egy termek arat nem csak a raszter/vram mennyisege hatarozza meg.

Van vagy tucat masik faktor, ami az ido haladtaval valtozik es vagy bovul, lasd RT es felskalazas.

Mar a Navi megjelenesekor is tobb oldal negativkent hozta le az RT hianyat peldaul.

Ha tetszik ha nem, a RT/felskalazas itt van es maradni fog."tàmogassuk hát az artifaktos,a ghostingos ködös zizis

Dlss-Fsr-t kis felbontàson új karikkal!."

Tessek, kijavitottam. Illetve nem kotelezo tamogatni, valaszthatsz masik hobbit. -

hahakocka

őstag

5-10 ève S koràbban is mindig a nyers erő a natív S raszter erő volt a lènyeg. Mit tud a kàrtya S mennyi Vram van stb. Ma amikor Amd hosszú idő utàn jobb ezen a tèren is 6-7000 és szèriâval S árban is. Már nem èrdekes. Sokan benyaltâk a DLSS-Fsr marketing dumàt 720pbe kis vgakon meg 1440p Ben toljàk csúcs vgakon Dlss-Fsr el 300-700e közti àrú új kártyàval S kevesebb vramon mint Intel S Amd. S erre tapsolnak is. Ezt viccesnek tartom. Persze így a fejlesztőknek nem kell optimalizàlni, tàmogassuk hát az artifaktos,a ghostingos ködös zizis Dlss-Fsr-t kis felbontàson új karikkal! Ez a jelen S jövő! Szemlèlettel van a baj a koncepció alapból. Azzal meg inkâbb más trollkodik, hogy jó a 20 FPS egy csúcskarival... Hogy nagy èlmèny mert maxon megy legalàbb nonszensz!

-

Dr. Akula

félisten

válasz

Dragon3000

#243

üzenetére

Dragon3000

#243

üzenetére

Szerintem már épp eleget trollkodtál ebben a topikban (is), ideje lenne befejezned.

-

Sontir Fel

őstag

Azért vannak meglepő dolgok. Ha jól emlékszem az új (és tán a korábbinál is) COD esetében jobbak az FPS számok 7900xtx alatt a 4090essel szemben.

Ha csak gsync kompatibilis a monitor és tuti nem megy a freesync akkor szerintem ez a kérdés el is dőlt, nem?

![;]](//cdn.rios.hu/dl/s/v1.gif) én csak olyan monitort veszek, aminél mind a kettő opció él, gyakran cserélek kártyát és nem akarok emiatt gondot. 6800-6900-4080, a következő lehet 8900xtx lesz 🙂 sem az RT, sem a DLSS nem hat meg komolyabban, ár/értékben számomra a 7900xtx szimpatikusabb... A hülye 12vhpwr csatlakozóról nem is beszélve

én csak olyan monitort veszek, aminél mind a kettő opció él, gyakran cserélek kártyát és nem akarok emiatt gondot. 6800-6900-4080, a következő lehet 8900xtx lesz 🙂 sem az RT, sem a DLSS nem hat meg komolyabban, ár/értékben számomra a 7900xtx szimpatikusabb... A hülye 12vhpwr csatlakozóról nem is beszélve ![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Dr. Akula

félisten

válasz

Dragon3000

#238

üzenetére

Dragon3000

#238

üzenetére

"Szándékosan érvelsz ilyen hülyeségekkel?"

Én is ezt kérdezem tőled! De látom azóta már másba is belekötöttél. A lényeg hogy mindenki szembejön az autópályán, ugye?

"a 4090 alatt ilyen esetben minden szar?"

Te mondtad hogy az alatt már csak kikapcsolt RT-vel van élet... Persze lehet azt is, csak attól még nem lesz egyenértékű a 2 kártya továbbra se.

"A 30 és 60 fps közt eléggé észre lehet venni a különbséget"

DLSS bekapcsol, és már mehet 4070Ti-vel is az RT:

-

Dragon3000

nagyúr

válasz

BusinessGuy

#239

üzenetére

BusinessGuy

#239

üzenetére

Az ügye nem gond, hogy itt nem az amd vs nvidia részről volt szó, hanem a miért kapcsolná ki bárki is az rt-t kérdésre a reagálás, hogy nvidia esetében is előfordul még 4080 esetében is, hogy rt mellett nagyon kevés lesz az fps és sokan inkább választják a 60 fps-t rt nélkül, mint rt mellett a 30 és alacsonyabb fps-t. A dlss is olyan, hogy kérdés van e a játékban, illetve adott játékban melyik verzió került.

-

BusinessGuy

őstag

válasz

Dragon3000

#238

üzenetére

Dragon3000

#238

üzenetére

Aha, nemigen látok olyan játékot ami a 4080-at RT-vel fektetné maximum ha nincs DLSS ami meg ma már szinte mindig van kivétel a pár darab AMD cimet ahova külön bemodolják vagy késöbb jön. Namármost DLSS3 (vagy 3.5)-el kapsz RT mellett a 4080-al egy jelentősen magasabb framerate-et egy jelentősen jobb képpel mint amit a 7900XTX FSR-el RT-vel kiprésel, ráadásul mindezt alacsonyabb fogyasztás mellett. RT nélkül szintén DLSS-el kapsz jóval magasabb framerate-et jóval jobb képpel szintén alacsonyabb fogy mellett.

Vagyis nem, rohadtul nem egyenlő a két kártya maximum továbbra is egyedül akkor amikor nincs a képletben sem RT sem DLSS. Ami napjainkban kb elenyésző és egyre ritkább és ritkább lesz. Ergo nettó parasztvakitás manapság RT és DLSS meg FSR nélkül összevetni a kártyák erejét és igy kimondani a framerate/ár arányt hisz jócskán kimarad a kártyák tudásának java a képletből csak azért hogy az AMD kártyáit fel lehessen fényezni.

Ez majd leginkább akkor fog kijönni amikor 1-2 év múlva a 4k 60 fps is erősen kompromisszumossá válik a 4080 és 7900xtx alatt, viszont azonos framerate-ért a 4080-on DLSS vagy RT mellett jóval kisebb kompromisszumokat kell majd kötni.....Ahogyan akár már most is kijön pont az Alan Wake 2 esetében ahol a 4080 DLSS mellett jóval kevésbé kompromisszumos grafbeállitásokat illetően mint a 7900xtx ha azonos framerate-ot akarunk látni.

Szép és jó a nyers erő, ezzel el lehet még adni a vga-kat azoknak akik nem látják merre halad az ipar és kizárólag a nyers erőt nézik, csak sajnos ma már az optimalizációt ráterhelik az FSR és DLSS szintü megoldásokra mondván az majd megoldja a szar sebességet, és ez tendencia is marad sőt csak fokozódni fog. -

Dragon3000

nagyúr

válasz

Dr. Akula

#237

üzenetére

Dr. Akula

#237

üzenetére

Szándékosan érvelsz ilyen hülyeségekkel? Azért, mert egy dolgot kikapcsol az ember ami van, hogy 4090 alatt használhatatlanná degradálja a kártyákat, akkor az egyenértékű az S3 trióval, akkor szerinted a 4090 alatt ilyen esetben minden szar? A 30 és 60 fps közt eléggé észre lehet venni a különbséget és mégegyszer az a 30 fps még mindig átlag volt, a minimum 30 alatti.

-

Dr. Akula

félisten

válasz

Dragon3000

#236

üzenetére

Dragon3000

#236

üzenetére

Akkor lefordítom neked magyarra: "tesztek alapján akkor lenne egyenlő a 2 kártya, ha kikapcsolod az RT-t - de mivel az is van benne, nem egyenlő". Mondom, még pár dolgot kikapcsolsz, és az S3 Trioval is egyenlő lesz...

"10 játékból 8-ban szinte észre se lehet venni a különbséget."

Mint a 30 és 60 fps köztit se. Ismerek olyat aki a 20 fps-re is azt mondta hol van itt szaggatás. Elhiszem hogy neked megfelel lebutított grafikával, de ez semmivel nem relevánsabb, mint másnak a kevesebb fps.

-

Dragon3000

nagyúr

válasz

Dr. Akula

#235

üzenetére

Dr. Akula

#235

üzenetére

Ezzel indítottam: Tesztek alapján kb egyenlő a két kártya, a 4080 rt esetében húz el.

Utána írtam, hogy akinek nem számít az rt, az olcsóban megkapja ugyanazt a teljesítményt. Sőt vannak olyan játékok, ahol 4080 esetében is a játszhatatlan kategóriába került a teljesítmény rt mellett, így ott is kikapcsolja az ilyen játékok esetében, ha nem a szaggatást akarja nézni.

Ezzel, hol állítok olyant, hogy az amd utolérte az nvidiát? Eleve amd oldalról a csúcs kártyáról volt szó, miközben nvidia oldalról a második legerősebbről. Az, hogy te miket vélsz belemagyarázni az már a te dolgod.Megint ez a túlzó hülyeség, mert aztán, ha az rt ki van kapcsolva, akkor 10 évvel ezelőtti grafika lesz, miközben 10 játékból 8-ban szinte észre se lehet venni a különbséget. Ennél már csak az a viccesebb, amikor némelyik rt nélküli játék szebben néz ki, mint amibe belekerült az rt, de csak azért, hogy elmondhassák, hogy támogatja.

-

Dr. Akula

félisten

válasz

Dragon3000

#231

üzenetére

Dragon3000

#231

üzenetére

Ebbe a vitába szálltál be az AMD oldalon, tehát kár "hol írtam ilyet"-tel takaróznod.

"Biztos azért vesznek az emberek 5-600e-ért vga-t, hogy 30 vagy kevesebb fps legyen."

Hát nem is azért hogy ugyanazt a grafikát bámulja amit már 10 éve...

-

Dragon3000

nagyúr

Meg kell nézni mikkel játszol, azok melyik oldalt szeretik jobban. Ez mellett melyik megoldások tetszenek jobban, akár felskálázás, akár rt, akár sync...... Igen az mindig gond, ha a csúcs ellen nincs versenyző, régebben is volt ilyen, hogy ááá a csúcsot elfelejtjük, aztán már a lejjebb lévőt is aztán ha már felső kategóriában keresett valamit a vásárló, akkor már csak nvidia volt. Az 5700xt anno csak a 2070 superig volt versenytárs, felette a 2080/super/ti meg elvolt magában. Remélhetőleg nem ez lesz újra, hogy a felsőházat megint elengedi az amd és az nvidia megint annyit kér majd, amennyit csak akar.

-

nexplo

őstag

válasz

Dragon3000

#231

üzenetére

Dragon3000

#231

üzenetére

Hát igen a 4090-re amd oldalon elmaradt a tökéletes válasz. Ez nekünk fogyasztóknak rossz minden téren. Én pont azon agyalok hogy 7900XTX AMD vagy 4080 NV legyen a gépemben. Főleg hogy jönnek az újoncok. Használtan sok esetben a piros kártyákat kicsit olcsóbban meg lehet venni ami sok esetben feléjük borítja a mérleg nyelvét. a másik oldal a G-sync amit a monitorom tud. Nehéz ügy pro-kontra.

-

Dragon3000

nagyúr

válasz

Dr. Akula

#229

üzenetére

Dr. Akula

#229

üzenetére

Akinek elég a 30 az vegyen konzolt, de még mindig a 30 fps átlag volt a 4080 esetében, a minimum alacsonyabb. Biztos azért vesznek az emberek 5-600e-ért vga-t, hogy 30 vagy kevesebb fps legyen. Hol írtam, hogy az amd utolérte az nvidiát? Annyit írtam, akinek nem számít az rt, annak a 7900xtx ugyanazt hozza, mint a 4080 alacsonyabb áron. Te jöttél, olyan hülyeségekkel, ha már az rt-t ki kell kapcsolni, akkor ennyi erővel elég az igp meg a többi hülyeség, erre írtam, hogy van olyan játék, ahol 4090 alatt rt-vel élvezhetetlen teljesítményt nyújtanak a vga-k, még a második legerősebb nvidia is. Na meg arra is, hogy minek kikapcsolni az rt-t, erre is az a válasz, hogy nem mindenki vesz 4090-et és vannak játékok, ahol nvidia esetében is durván leesik a teljesítmény rt mellett.

-

Busterftw

nagyúr

válasz

Alogonomus

#228

üzenetére

Alogonomus

#228

üzenetére

Ja mert a 2018-ban kezdett Unreal 5 mar modern, ugye? Ne viccelj mar.

Ott biztos nem az UE 4-et vettek alapul es egeszitettek ki uj modulokkal. -

Dr. Akula

félisten

válasz

Dragon3000

#227

üzenetére

Dragon3000

#227

üzenetére

Neked meg az fps minden? Konzolon elvannak 30-al is...

Amúgy még mindig nem arról volt szó hogy neked hogy tetszik egy játék, hanem hogy utolérte-e ez AMD az Nvidiát vagy nem. Ha bármit is ki kell kapcsolni ahhoz hogy egyáltalán rajtvonalhoz állhasson, akkor értelemszertűen nem.

-

Alogonomus

őstag

válasz

huskydog17

#226

üzenetére

huskydog17

#226

üzenetére

Attól, hogy a 2016-os állapotot kiegészítették plusz funkciókkal, még nem vált modern motorrá a Northtlight.

Modulos rendszerűek a motorok, hogy a később megjelenő technikákkal ki lehessen azokat egészíteni, de attól még nem válnak modern motorrá, csak modern képességekkel is felruházott motorrá. Végül ahogy egyre inkább "frankenstein" kezd válni a foltozgatott motorból, idővel döntést kell hoznia a fejlesztőnek, hogy rááldoz sok erőforrást egy új motor elkészítésére, amiben az elmúlt években csak "hozzácsapott" funkciók modulszintből az alapmotor kódjába átemelésre kerülnek, vagy jobban megéri egy külsős motorra átváltaniuk, amit rajtuk kívül sok másik fejlesztő is használ, ezért a motor fejlesztésének a költsége is sok fejlesztő még több játékának a büdzséje között oszlik meg. -

huskydog17

addikt

válasz

Alogonomus

#206

üzenetére

Alogonomus

#206

üzenetére

Csak hogy tisztában legyél a helyzettel, ismét hatalmas butaságokat hordasz össze.

"Alan Wake II alatti engine a Northlight, ami 2016-os. Szóval már bőven nem modern."

Nem tudom honnan szedted ezt, de mielőtt ilyen hülyeséget leírsz, nem ártana utánajárni. Ebben a blogban a fejlesztők részletesen leírják, hogy az új motor miket tud. Ez egy új Northlight Engine, sok olyan képességgel amiket a korábbi verziók nem tudnak. Az meg, hogy szerinted nem modern, nos a GPU-DRIVEN RENDERING PIPELINE a legmodernebb leképzési technikák egyike.

"Egyébként a másik zöld oldalról általában példaként felhozott "korszerű játékmotort" éppen maga a CDPR dobja a valóban korszerű UE5-re váltva."

A RedEngine 4 továbbra is fejlettebb, mint egy UE5, utóbbi alatt nem tudsz olyan jó CPU skálázódást elérni, mint RedEngine 4 alatt, továbbá feature set-ben is messze felülmúlja a saját motorjuk az UE5-öt.

Nem azért dobják ki a sajátot, mert az UE5 fejlettebb, hanem "költséghatékonyság miatt", az UE5-ben valszeg gyorsabban lehet pályákat szerkeszteni, azaz gyorsabban készülhet el egy játék. Nem ez az első eset, amikor egy neves csapat a saját fejlesztés motorját kidobja az UE-ért cserébe, beáldozva ezzel a minőséget. Ezen felül egy ilyen mértékű változás mindig nagy hátránnyal is jár, hiszen minden fejlesztőknek meg kell tanulnia az új motort, ami nem kevés időbe telik és nem kevés feszültséget is képes generálni.

Nehogy azt hidd, hogy az ilyen nagy stúdiók azért dobják ki a fejlettebb saját motorjukat egy UE-ért, mert utóbbi fejlettebb, mert pont az ellenkezője az igaz, hanem mert hosszú távon ettől alacsonyabb kiadást remélnek, amire nincs semmi garancia. Rövid távon mindenképp káros, mintsem hasznos lépés, de hosszú távon is kockázatos. -

Dr. Akula

félisten

válasz

Dragon3000

#223

üzenetére

Dragon3000

#223

üzenetére

Tré grafikával is szar játszani. Mind a kettő számít. De itt nem erről volt szó. Hanem az AMD "utolérte" az Nvidiát urban legendről. Nem érte utol, mert ki kell kapcsolni fontos dolgokat hogy ez egyáltalán elmondható legyen. De ha mégtöbb dolgot kikapcsolunk, 2D-ben az S3 Trio is utoléri, akkor az is van olyan jó, nem?

-

MZsoltee

veterán

válasz

Dr. Akula

#221

üzenetére

Dr. Akula

#221

üzenetére

Szeritnem parttalan a vita, elbeszélünk egymás mellett. Az emberek, felhasználóknak hozzáállása nem az, hogy bármi áron kell a legjobb legnagyobb teljesítményű vga. Ha ez lenne a hozzáállás, akkor igen mindenki vegyen 4090-et. De a valóság az, hogy a felhasználók többsége könnyen köt kompromisszumot, mond le egyes grafikai beállításokról, akár az RT-ről mert nem érdekli, nem hajlandó kifizetni a felárat, vagy az általá játszott játékokban nincs is. Ebben az esetben. ami szerintem a felhasználók túlnyomó többségét jelenti igenis versenyképes az AMD. Minek fizessen olyanért amit nem használ, nem ér neki annyit?

Tehát a röviden a legerősebb vga az Nvidia, de nem az Nvida az, ami minden esetben ár/érték arányban a jó választás. Az s3 trio és a 4090-es között sok lehetőség van.

-

Dr. Akula

félisten

válasz

MZsoltee

#218

üzenetére

MZsoltee

#218

üzenetére

Attól hogy te milyen játékkal játszol, a kártyák közt még van különbség.

#220gulupeti: Miért akarnám lebutítani a grafikát, ha van jobb is? Nem azért veszek új kártyát hogy ugyanazt bámuljam mint 10 éve. Arra ott a régi is.

#219Dragon3000: Ha a szebb grafika nem számít, akkor az fps sem.

-

válasz

Dr. Akula

#217

üzenetére

Dr. Akula

#217

üzenetére

Nekem úgy tűnik, hogy te a játékot csak és kizárólag a saját megélt dolgaidon keresztül tudod értelmezni, minden más ami ettől eltérő, az csak helytelen lehet. Ha az RT ennyire kötelező érvényű lenne, akkor ki sem lehetne kapcsolni, de ugye ki lehet és ahogy olvasom sokan az Nvidia felhasználók közül is ezt teszik. Nincs miről beszélni...

Másik topikban írtad, hogy "a max. grafikába a 4k is beletartozik." Egy játék részletessége szerintem nem egyenlő a felbontással. Mivel van már ugye 8k monitor is, akkor nem érzed úgy, hogy ez ügyben meg lemaradásban vagy, ha minden feature maxra járatása ennyire nélkülözhetetlenül fontos?

-

Dragon3000

nagyúr

válasz

Dr. Akula

#217

üzenetére

Dr. Akula

#217

üzenetére

Mert pl nagyon fogja a kártyát, akár amd akár nvidia, nem mindenki rohangál 4090-nel, még 4080 esetében is van olyan játék, hogy 4k + rt 30 FPS körül teljesít, míg rt nélkül meg 60 FPS körül megy, ugyanazzal a játékkal a 4070 hasonlóan teljesít 1440p-ben. Ez mellett van olyan játék is, ahol észre se venni, ott is csak viszi az fps-t.

-

BusinessGuy

őstag

válasz

gulupeti

#204

üzenetére

gulupeti

#204

üzenetére

Részben igen, de főleg pont azt mutatja hogy elöbb lesz gpu limited mintsem vram.

Kb a 3090-től nevezhető elfogadhatónak ahogy fut a cucc, ott is 31 fps. A tesztben szerepel az is hogy mennyi igy a vram fogyasztás, 4k max RT-vel 15 giga. A legtöbb kártya csúnyán elvérzik a gpu limit miatt persze nyilván jobban vérzik amelyiken a ram is kevesebb csakhogy egyiken sem fut elfogadhatóan a cucc, az RT-t kikapcsolva éred el a gyengébb kártyákon a jó sebességet és rögtön más a leányzó fekvése, 4k MAX RT nélkül 9.5gb a vram használat és lám:

Vagyis pont az van amiről pofázunk sokan, rengeteg kártyán parasztvakitás a sok vram mert elöbb fogy el a kártya ereje mintsem a vram. A 10gb 3080 4k-ban pláne 2k-ban még mindig elég ha a grafikát oda teszed ahol a játék jól fut - ahol a 16gb konkurens kártyákon is jól fut. RT-vel akkor se futna jól ha lenne rajta 16gb ram vagy több, a 3090 is alig éri RT-vel a 24gb ram mellett a 31 fps-t. Van az elmúl 5 évben nagyjából 2 olyan játék aminél előjön az elfogyó vram egy 3080 esetében, mindkettő az AMD-nek köszönhető parasztvakitással lásd pl Resident Evil ahol a szuper AMD ficsörért az ultra textúrák iszonyat vram igénytől szenvednek - cserébe semmivel sem néznek ki jobban mint N+1 játék textúrái negyedakkora Vram igény mellett, ráadásul a high és ultra között is leheletnyi difit adott.....Hálistennek kevesen használják pedig Abu ódákat zengett itt annó arról az erősen megkérdőjelezhető techről is...

Ez a jelen konzolgen végéig nemigen fog változni mert változatlanul a konzolok határozzák meg nagyban a CPU és ram/Vram igényét az adott játékoknak. -

Alogonomus

őstag

A probléma nem az, hogy ma arányaiban gyengébbek a videokártyák, hanem az, hogy sokkal többet várunk el tőlük.

Az elvárások erősen függnek a kifizetett ártól. A példádban felhozott 8800 GT 2007-ben $350-volt, ami inflációval korrigálva is csak $500 lenne jelenleg. Egy most $500-os kártyától (4060 Ti 16 GB/7800 XT/4070) nem is várja el senki, hogy 4K maximális beállítással vigye 60 fps fölött a legújabb játékokat. 2007-ben az az 1280x1024 pedig ugyanúgy felső kategóriás felbontásnak számított az 1024x768-as átlaghoz képest, ahogy most a 4K a 1080p és 1440p közötti átmenet idején.

A jelenlegi magasabb elvárások abból erednek, hogy még a 8800-as kártyák csúcsát jelentő 8800 Ultra is "csak" $830 volt, ami átszámítva is a 2080 Ti ára alatt marad, nem beszélve a 4090, vagy a 3090 Ti áráról. Egy jelenleg $1000-os kártyától érthető okokból sokkal többet vár el a tulajdonosa, mint amit anno egy 8800 GT kártyától. A legdrágább $1600-os kártyától pedig még annál is többet. -

aginor

veterán

válasz

Alogonomus

#209

üzenetére

Alogonomus

#209

üzenetére

Ezt kitesztelted, vagy csak gondolod?

Amúgy a videóban ráadásul még csak a "sima" RT van, de igazából amiatt hoztam példának, hogy az RT hiába eszik kicsit többet, de a végeredménye is jobb (egyébként, így egymás között, a Lumen minősége sem rossz ).

).

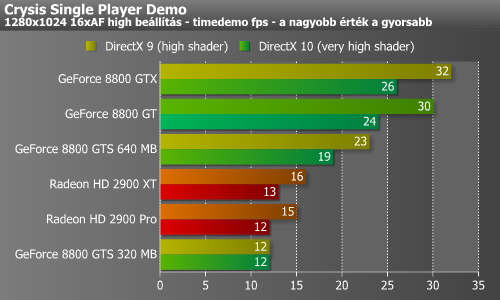

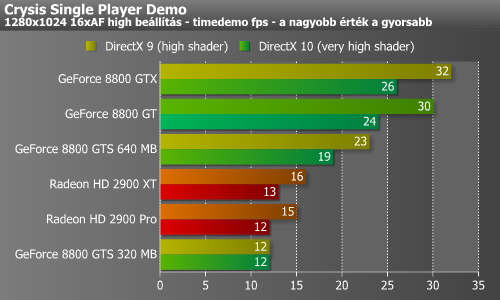

Nem tudom, hogy mit hoz a jövő, ahogy azt sem, hogy mikor lesz egyértelműen kevés a 12GB memória, de vélhetően itt már a jelenlegi generáció számítási kapacitása sem lesz elegendő az örömködéshez, emiatt a vélt AMD előny lehet, hogy soha nem fog mutatkozni (de biztos, hogy nem lesz akkora, mint amekkora jelentőséget ennek egysek betudnak).Amúgy mellékesen jegyzem csak meg, hogy anno amikor a Crysis kijött, akkor a frissen megjelent 8800GT-vel több tesztet is futtattam, és 20-24 képkockát tudott kirajzolni másodpercenként. Ma viszont amiatt sírunk, hogy egy azonos kategóriájú kártya alig tudja tartani a 60fps-t és hű desz szak, és cse**e meg mindenki és ha ennél több kell, akkor fel kell skálázni. Brühaha...

A probléma nem az, hogy ma arányaiban gyengébbek a videokártyák, hanem az, hogy sokkal többet várunk el tőlük.

Idézet a PH-s tesztből:

"Egyelőre lényegtelen, hogy van-e DX10 a Crysisben vagy nincs, mert jelenleg nincs olyan szóló grafikus kártya a piacon, mely magas (high) beállításokkal akár csak DX9-ben is tisztességes sebességet produkálna, és akkor még nem is beszéltünk a legmagasabb (very high) szintről."

-

s.bala31

őstag

válasz

Alogonomus

#209

üzenetére

Alogonomus

#209

üzenetére

A linkelt videoban nem említenek PT-t, a címében is csak RT-t írnak.

-

Alogonomus

őstag

Az elképzelhető, hogy a teljesen kiaknázott path tracing szebb képi világot biztosíthat, mint ami a Lumen segítségével elérhető, de cserébe "megfojtja" a kártyát, végül pedig csak upscaling segítségével lehet az adott kártya árához méltó szintig visszatornázni a képkockasebességet. Amit látványban hoz(na) a path tracing, annál többet egyből el is bukik a felhasználó az Ultra Performance felskálázás 9-ed akkora felbontása miatt.

-

MZsoltee

veterán

válasz

Dr. Akula

#198

üzenetére

Dr. Akula

#198

üzenetére

Azt ki lehet jelenteni, hogy a 4090eshez hasonló gyorsaságú kártyája nincs az AMD-nek. De az árazás határozza meg, hogy melyik kártya melyikkel versenyez. Egyik cég sem jótékonysági szervezet profitálni akarnak. De a végén a felhasználó jó esetben a penztarcajaval szavaz ár/teljesítmény alapján és nem szimpátia, érzelmek alapján.

-

aginor

veterán

válasz

Alogonomus

#206

üzenetére

Alogonomus

#206

üzenetére

Tisztában vagyok vele, ugyanakkor ezek a jelenlegi címek, amik támogatják a Path RT-t. Unreal oldalról ilyen nincs, és ismerve a Lument, nem is lehet rá számítani.

Itt egy összehasonlító videó. -

Alogonomus

őstag

Csak hogy tisztában legyél a helyzettel, az Alan Wake II alatti engine a Northlight, ami 2016-os. Szóval már bőven nem modern. Ez meg is látszik mind a gépigényén, mind a főleg amiatt elért siralmas aktív játékosszámán.

Egyébként a másik zöld oldalról általában példaként felhozott "korszerű játékmotort" éppen maga a CDPR dobja a valóban korszerű UE5-re váltva. -

aginor

veterán

válasz

gulupeti

#204

üzenetére

gulupeti

#204

üzenetére

Azért ez nem ennyire egyszerű, különben a 11GB-os 2080 nem versenyezne a 16GB-os 6800-al..

Igazából mindkét oldal igyekszik úgy forgatni a tényeket, hogy az a saját igazát bizonyítsa. Ha több vram van, mint amire szükség van, az nem baj, ellenben ha kevesebb az igen. Az viszont az érem másik oldala, hogy egy 6800-ra a GPU teljesítménye alapján majdnem fölösleges a sok ram, csak növeli az árat.

Igazából azért alakult így a piac, mert az AMD nem tudott nagyon mással versenyezni a 6-os szériában, mint az árral, és a vrammal. Ugyanakkor nincs ezzel baj, csak legyünk tisztában a dolgokkal. Már egy éve hajtogatja minden AMD fan (Abu alapján), hogy nemsokára jönnek az olyan játékok, amik 16gb ram alatt el sem indulnak, nemhogy jól fussanak. Nos, én máig várom ezt -az egyszer majd vitathatalanul bekövetkező- állapotot. -

aginor

veterán

válasz

Alogonomus

#73

üzenetére

Alogonomus

#73

üzenetére

Itt egy korszerű játékmotor, és tényleg milyen jó benne az AMD..

-

aginor

veterán

Bocs, hogy ezt mondom, pláne látatlanul, de ez így ebben a formában biztosan nem igaz. Ha igaz lenne, akkor állna a bál a neten, és elárasztanának minket az ilyen esetek, ahogy az volt pl. a 12tüs tápcsatlakozóval NV oldalon. Itt vagy user hiba lesz, vagy azok a gépek szarok/szarul vannak összerakva/szoftveresen valami nagyon nem kerek.

Ha gondolod, add ide azt a hibás 7900-et, megnézem, hogyha NV után bakarom a gépbe, akkor mit produkál.. -

Dr. Akula

félisten

válasz

Dragon3000

#199

üzenetére

Dragon3000

#199

üzenetére

Az AMD, ahogy írtam, azt tartja az ellenfélnek, amit végül sikerült valamennyire utolérni. Ha az Intel Xe lenne az, akkor azt tartaná. Ők is csak utólag magyarázkodnak, hogy á, nem is akartunk mi jobbat... Dehogynem, csak nem sikerült.

Új hozzászólás Aktív témák

- Azonnali készpénzes Microsoft XBOX Series S és Series X felvásárlás személyesen/csomagküldéssel

- Apple Magic Mouse (USB-C) - Fehér

- Lenovo ThinkPad L460,HD+, 14",i5-6200U,8GB RAM,256GB SSD,WIN11

- Apple iPad Air 5 13' 128GB (2029.02.09-ig Garancia) Csak kibontva volt, Aktiválatlan!

- HP Pavilion 15 - 15,6" Full HD - Intel Pentium N3710 - 4GB - 500GB HDD - Win10 PRO - MAGYAR - DWD R

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) Úgy tekint erre, hogy megveszi és 5+ évig jó lesz. Azért is bosszantó az olvadás, mert elmondása szerint egésznap youtube videókat nézett, amikor bekövetkezett a katasztrófa

Úgy tekint erre, hogy megveszi és 5+ évig jó lesz. Azért is bosszantó az olvadás, mert elmondása szerint egésznap youtube videókat nézett, amikor bekövetkezett a katasztrófa