Új hozzászólás Aktív témák

-

Puma K

nagyúr

válasz

Kolbi_30

#39797

üzenetére

Kolbi_30

#39797

üzenetére

Vajon mire gondolt a költő...?

Tehát az RTX 2080 Super vajon az RTX 2080 Ti helyett van?

A válasz, nem.Csak a különbség csökkent vélhetően (még nem jelent meg, majd 23-án) a két kártya között. Ha minden igaz, akkor később jöhet egy RTX 2080 Ti Super.

Ha jön.Amúgy most adták ki azokat a kártyákat amiket alapból kellett volna az RTX 2000 széria megjelenésekor.

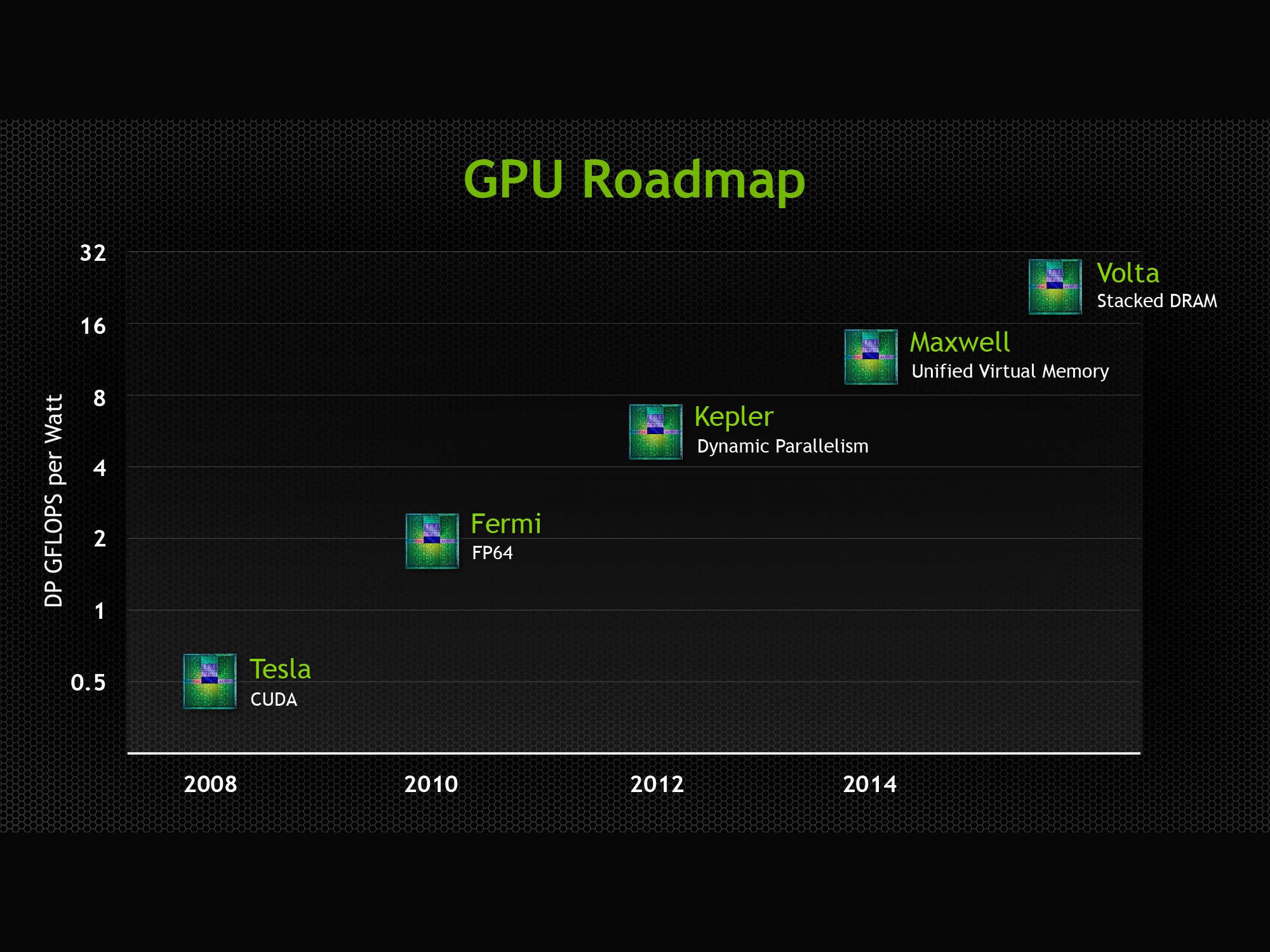

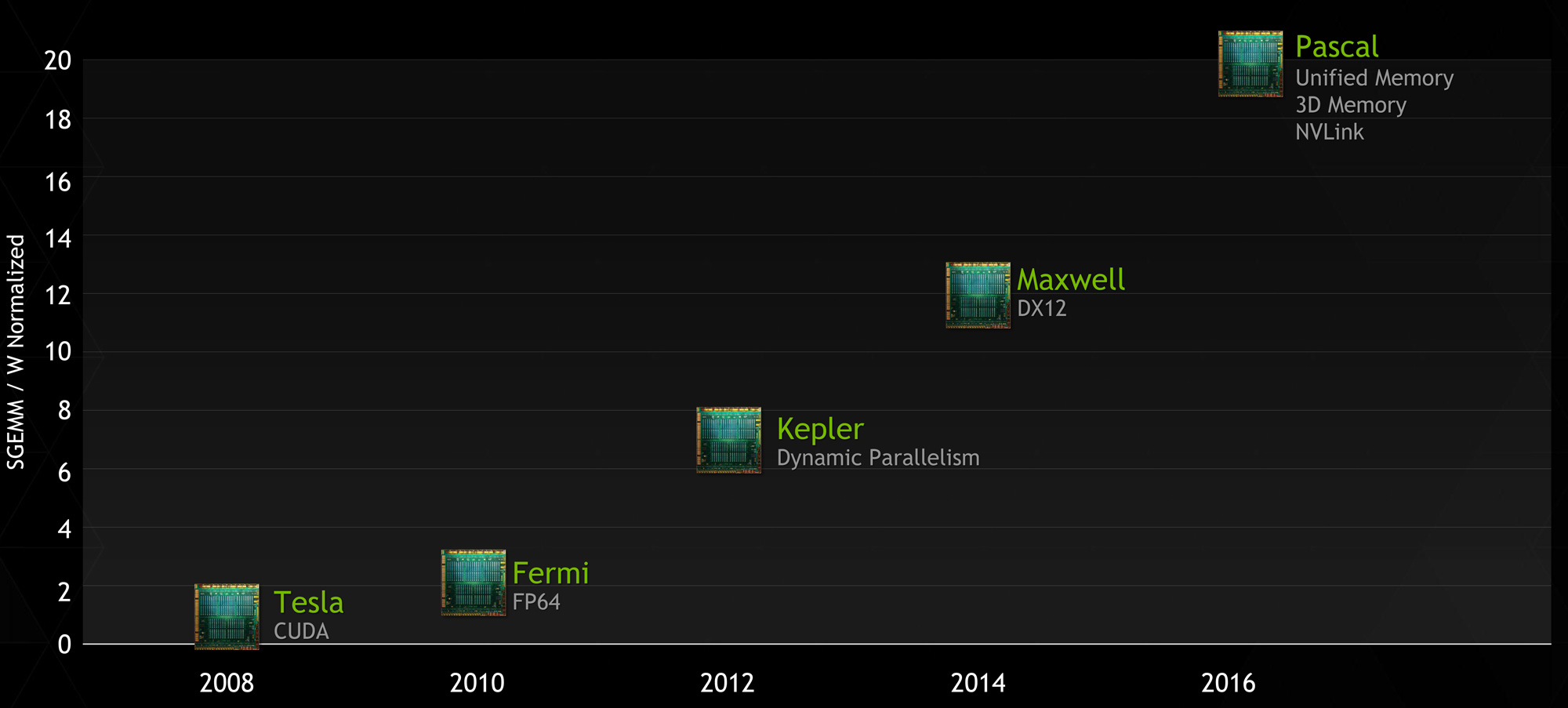

Ebből is látványosan látszik, hogy az Nvidia legalább a Maxwell széria óta azt csinál amit akar... hopp itt egy töltelék generáció, hopp ott egy olyan széria kiadása amit alapból megtehettek volna...

Várom a Ryzen 3000 széria tesztjeit... és remélem hamarost eljut a VGA részleg is arra az útra amire az AMD a Ryzen 1000 szériával tévedt így tetszhalott 10-12 év után...

-

Puma K

nagyúr

Nem tudom hogy hol harangozták be és kik, de ameddig a gyártó nem jelenti be a konkrét termékét-termékeit addig minden neten terjengő pletykát és valósnak vélhető információkat feltételesen kell kezelni.

Majd ha kint a kész termék, amit a boltok polcairól is le lehet majd emelni és megvásárolni, akkor lehet vitázni.

-

Puma K

nagyúr

válasz

Raymond

#39755

üzenetére

Raymond

#39755

üzenetére

"En se irok mar, de van hogy annyi osszegyulik a hetek alatt hogy azert felszisszen az ember itt-ott. Azt hiszem az lesz a legjobb ha hagyom a francba es csak a tapsikolo rajongok maradnak akikkel "diskuralhatsz"."

Azokból is egyre kevesebb van, mert megsértődnek és törlik magukat.

Számomra Abu 2008-tól kezdve bizonyítja, hogy nem a gyakorlat az erőssége.

Az óvodás szintű megnyilvánulás: [link] meg igencsak elgondolkodtató, akinek ott van a neve alatt, hogy HÁZIGAZDA. -

Puma K

nagyúr

Look what we found in NVIDIA's Top Secret Gaming Monitor Lab

1:03-tól erős a gyanúm a talpa miatt az Nvidia G-Sync logóval a szélén, hogy az egy LG monitor az Acer Predator mögött

Az AMD féle FreeSync

1... 2-nél hogy megy a minősítés? -

Puma K

nagyúr

válasz

CsonkaImo

#39312

üzenetére

CsonkaImo

#39312

üzenetére

Ryzen 1700@3,9GHz + RTX 2080 Ti

De a 2080 Ti még fut 600 valamennyi MHz-en is a tesztben ha emlékezetem nem csal a 60 FPS miatt, hogy meg van-e úgy is...?

Tegnap néztem meg a videót. Most meg én is munkában vagyok (bár a feliratot be lehet kapcsolni azért

![;]](//cdn.rios.hu/dl/s/v1.gif) ) így nincs hangom.

) így nincs hangom. -

Puma K

nagyúr

válasz

Valdez

#39227

üzenetére

Valdez

#39227

üzenetére

Ebben a

DLC-ben... jah öö... folytatásban! sem érdemes még a DX12-őt választani a beállításoknál.

A 4c/8t avagy a régi i7-ek megállják a helyüket ahogy a GTX 1080 Ti is mint ahogy tapasztalom azalapjátékban... öö előző részben.Ahhoz képest, hogy egy AMD cím, a Vegeta Wii-t a 16 GB VRAM jával minimum az RTX 2080 köré és fölé saccoltam volna...

-

Puma K

nagyúr

Ezt csak úgy itt hagyom: Flashgitz: Console Wars Full Movie!

Nyugi. A PC master race is benne van

-

Puma K

nagyúr

válasz

Devid_81

#38709

üzenetére

Devid_81

#38709

üzenetére

A tesztből világosan kiderül, hogy azok akik tavaly innen hardver apróról 147.000 Ft-ért hozzájutottak bolti garanciás, dobozos és patika állapotú Asus Strix OC, MSI Gaming X és EVGA SC2 GTX 1080 Ti-khez (összesen 21 db volt vegyesen) azok nagyon jól jártak

Akik meg 190.000 Ft alatt jutottak hozzá valamelyik jobb hűtéssel szerelt 1080 Ti-hez azoknak sincs okuk búslakodni

-

Puma K

nagyúr

válasz

#85552128

#38627

üzenetére

#85552128

#38627

üzenetére

Nekem az ilyen méreteknél hatalmasnak számító keret-ventilátor lapátok széle közötti távolság az ami igazán gagyivá teszi ezt a referenciahűtést... emiatt is meg zajos a hűtés.

A rajta lévő ventilátorról nem is beszélve.

De legalább a majdnem 2 éve jelen lévő GTX 1080 Ti-vel versenyben van (ha nem is fogyasztásban).

-

Puma K

nagyúr

-

Puma K

nagyúr

válasz

Raggie

#38237

üzenetére

Raggie

#38237

üzenetére

Nem az árazással kapcsolatban írtam és nem is az általad fantáziált-vélt "jövőbelátási" képességemet firtattam, hanem erre reagáltam első sorban:

"... a 2060 hamarabb fog kukába kerülni, és már ma is kompromisszumos itt ott..." - [link]

Ezért volt az összehasonlítás, hogy hiába az RTX 2060 6 GB VRAM-os, mert sebesség szempontjából nincs vele baj.

Mert ugyanúgy fog "kukázódni" mint egy régebbi-mostani 8 GB VRAM-os kártya (Vega 56/64, GTX 1070 Ti/1080), mivel a GPU ereje kapásból limitáló tényező lesz így előbb lesz a grafika visszavéve mint sem a VRAM lenne a probléma forrása.

Persze lehetnek VRAM igényesebb játékok, de nagy átlagnál megállja a helyét.

Egy alsó-közép / közép kategóriás kártyán ennyi azaz 6 GB VRAM elég... több nem is kellhet rá jelenleg.

Egy 1080 Ti-re is elég lett volna 8 GB VRAM (lásd RTX 2080 8GB), de ez nem lett volna kivitelezhető, mivel az egy Titan X kevesebb részegységekkel és magasabb órajelekkel:

GTX 1080 Ti vs TITAN X

2.75 MiB / 2,816 KiB L2 Cache 3 MiB / 3,072KiB

3584 Shader Units 3584

88 ROPs 96

1480 MHz Core Clock 1417 MHz

1582 MHz Boost Clock 1531 MHz

11000 MHz Memory Clock 10000 MHz

352 Bit Bus width 384 Bit

11264 MB VRAM 12288 MB

12000M Transistors 12000M

250W TDP 250WNem lehet hogy volt 3 GB-os 1060 hanem még most is van.

Hiába vágott, jó választás volt anno és most is, annak akinek arra volt-van pénze.[ Módosította: Intruder2k5 ]

-

Puma K

nagyúr

Mi az hogy "elterjedtebb 8GB-os méret."?

Ezt hogyan kell értelmezni?

Miben hol elterjedtebb?Már a GTX 1060 3 GB-os verziónál (megjelenési idő 2016. augusztus 18.) is kongatták a leginkább csak a diákat nézegető fórumtagok a harangokat, hogy az kevés lesz.

Ehhez képest a gyakorlatban semmi probléma nem volt vele ahogy az elmúlt idők folyamán olvastam az itten fórumot. De 7 hónappal ezelőtt sem volt gond a 3 GB VRAM-os verzió léte ahogy olvastam redditen. Annyit emeltek ki hogy ha van több pénzforrás akkor a 6 GB-os egy fokkal jobb választás de ha nincs jó a kisebb VRAM-os kártya is.

Ha valakinek arra volt pénze akkor kapott egy 1080p@60Hz-re bőven megfelelően erős kártyát.

Sőt az 1050 Ti 4 GB-hoz képest jobb vétel volt teljesítmény-ár szempontjából egy 3 GB-os 1060.

Durván két és fél év elteltével az 1060 megjelenése után most itt van ez az RTX 2060 6 GB VRAM-al amiből jelenleg nincs is más.

Mint látható megállja a helyét egy 295W-os TDP-vel rendelkező Vega 64-el szemben amin a csillámporos HBM2 van gigabrutál sávszéllel meg a többi meseszerű képességével.

RTX 2060 vs RX Vega 64

1920 Shader Units 4096

48 ROPs 64

1365 MHz Core Clock 1274 MHz

1680 MHz Boost Clock 1274 MHz+

1750 MHz Memory Clock 953 MHz

192 Bit Bus width 2048 Bit

6 GB VRAM 8 GB

10800M Transistors 12500M

160W TDP 295WIlyen paraméterekkel, nem kellene hogy egy lapon legyen említve a 2 kártya...

3-4 évente elég az átlagos játékosnak cserélnie a VGA-t és akkor ott még mindig nem a VRAM lesz az ami miatt cserélni fog hanem a kártya teljesítménye-ereje fogy el.

Idővel én is azért fogom lecserélni az 1080 Ti-t mert elfogy a GPU ereje ott és úgy ahogy én játszom. Nem pedig a VRAM mennyisége fog limitálni.

-

Puma K

nagyúr

-

Puma K

nagyúr

válasz

Raggie

#38079

üzenetére

Raggie

#38079

üzenetére

Olvass te is, mert maga AMD-ék nyilatkozták azt a kínaiaknak, hogy szerintük lesz annyi kártya ami az igényeket ki fogja tudni szolgálni.

Tehát aki majd ki tud adni érte minimum 700 USD / 200k Ft-ot és hajlandóak a váltásra a meglévő VGA kártyájukról, azoknak lesz kártyájuk. Avagy azt a pár ezer embert ki fogják tudni szolgálni referencia kártyával.

Más szóval maga az AMD sem számít nagy rohamra ennél a kártyánál.

A személyeskedést nem lehet elhagyni amúgy?

-

Puma K

nagyúr

válasz

Raggie

#38077

üzenetére

Raggie

#38077

üzenetére

Írás megjelenése: 2019.01.17. 11:00

"A kínai média szerint mindössze 5000 kártya lesz kész a februári indításra, de az AMD ezt tagadja."

"... az információik szerint csak a CES-en bemutatott referenciakártya lesz kapható átmatricázva mindegyik partner kínálatában, és a helyzet hosszútávon sem változhat ... kevés GPU készül, hiszen a TSMC 7 nm-es gyártókapacitása is véges ... az AMD az új Ryzeneket is azon gyártatja."

"Az AMD a MyDriversnek azt nyilatkozta, hogy konkrét számokat nem fog mondani, de szerintük lesz annyi kártya az induláskor, ami lefedi az igényeket."

Mindez majd úgy is kiderül a gyakorlatban.

-

Puma K

nagyúr

Igen csak egy régebbi laptop i7 CPU más mint egy asztali, mert nem ketyeg minimum 4400MHz-en 4 magon 8 szállal, nincs megtámogatva 2133Mhz-en járó DDR3-al

amiből 16 GB van benneés nem is a picit erősebb HD 4600-al van ellátva.Na de sok a rizsa, aki meg nem tud játszani 15 FPS-en se az egyen nudlit magában!

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Puma K

nagyúr

Ha olvasol a sorok között akkor láthatod, hogy az Intel HD 4600-as időkkel kapcsolatban írtam mindazt.

És hogy az még mindig nem diavetítés. Szerintem.De mindez ellen tettem a mostani konfiggal amivé kiteljesedett jelen állapotában.

Tovább nem ragozom értsd ahogy akarod adtam elég tápanyagot amiből táplálkozhatsz

-

Puma K

nagyúr

Szépítek: az még nem képregény csak érzed hogy baj van.

A 10 FPS na _az_ már képregény. És itt nem a 30 vs 60 FPS témáról van szó avagy a látod vagy nem látodról hanem a ténylegesen látodról.

De igaz egyénenként eltér (mint a 30vs60 FPS

![;]](//cdn.rios.hu/dl/s/v1.gif) ) ki mit érzékel-lát.

) ki mit érzékel-lát."... nem azért szemezek egy 144Hz-es monitorral, hogy utána 40Hz (vagy FPS) alatt hajtsam, nagyon nem..."

Én sem azért költöttem tavaly a gépre 700-800k közötti összeget (mínusz 2x 8GB/1866MHz DDR3, GTX 1050 Ti ára plusz visszafizetett mert elhalálozott H75 és AF240 értéke), hogy diavetítést vagy széteső képet nézzek

-

Puma K

nagyúr

"...40Hz-től fog képtörésmentesen működni"

Ez az ami G-Sync-nél 1 FPS-től már megvan.

Szóval nincs FPS-ed, de legalább nem törik a kép és máshogy érződik a kevés FPS.Tehát még mindig játszható pl egy offline-single játék és csak annyit veszel észre, hogy valami nem kerek.

Kapcsolsz egy FPS mutatót és látod, hogy húha 17 FPS-el poroszkálsz...Megjegyzem, hogy ~15 FPS-ig én tudtam játszani adott játékokkal, de éreztem még FPS mutató nélkül is, hogy valami nagyon nem kerek... és inkább a játékra és a játék élményre koncentráltam

Ha meg ugráló az FPS-ed, ami során akár 40 alá is benéz akkor még mindig nem törik a kép. Viszont a széteső kép elég látványos tud lenni és zavaró. Engem legalábbis zavar, de mindezek miatt lett olyan konfigom, hogy ezeket ne tapasztaljam még véletlenül sem.

Szabályozni a 40 alá való bezuhanást meg úgy tudod, hogy visszább veszel a grafikából, de mint tapasztaltam hiába vettem vissza adott címeknél a grafikából (low és off beállításokon nem fogok játszani.. elég volt az intel HD 4600-as élményekből

) GTX 1050 Ti esetén oda már az a kártya kevés volt, de ami sokat számított, hogy még mindig folyamatos volt a kép.

) GTX 1050 Ti esetén oda már az a kártya kevés volt, de ami sokat számított, hogy még mindig folyamatos volt a kép.Most viszont eléggé más élmény még egy régebbi játék is (már aminek nem örül meg a grafikus motorja a 30-60-tól magasabb képkockáktól másodpercenként...) 60 feletti átlag FPS-el (esetemben 166-ra van lekorlátozva az FPS) azaz magasabb képkockaszámmal mint korábban a 60Hz képes tévén amit gépre kötve használtam megjelenítőnek a mostani monitor előtt.

-

Puma K

nagyúr

Ezt az emberek többsége egy erős géppel abszolválja hogy még a közelébe se menjen az FPS mutató

Én meg még úgy inkább igyekszem elkerülni az FPS bezuhanást avagy az alacsony minimum FPS-t:

CPU: BIOS-ból fixált órajellel és feszültség

VGA: 3D terhelés közben a GPU órajelét driver-ből állandó, MSI AB-ben előre beállított 2000MHz@1,025v-on tartatom, amibe csak a hőmérséklet tudna beleszólniNézd... kb 1.2 évig Intel HD 4600-al (4790K) játszottam 768p-ben. Ezalatt a GTA Online-ban az Xbox 360-as élmény meg volt! 15-70 FPS (min-max?) átlag 30

Szóval nem olyan rossz azaz élet 30 FPS alatt...

G-Sync/Free-Sync nélkül IS

G-Sync/Free-Sync nélkül IS

Eredetileg a 9900X-re kacsingattam (10 mag 20 szál ésss ami még fontos, hogy maximum 128 GB RAM-ot kezel), de a HT mostanság nem túl nyerő Windows 10 alatt (jelenleg 1803-on vagyok)... a videómachináláshoz viszont jó lenne a sok szál és a sok ram, de a 351k Ft-os jelenlegi ára nekem nem jó. Meg platformváltás se tetszik annyiért meg megint Windows 10 reinstall... most tértem át alig 1 hónapja Win7-ről... most megint letilt a józan ész.

-

Puma K

nagyúr

válasz

#34576640

#37924

üzenetére

#34576640

#37924

üzenetére

Az igényeidnek a függvényében alakulnak az árak még ha hobbi gamer is vagy az említett G-Sync/Free-Sync 2 varázsszavak miatt.

Nvidia + G-Sync: ezzel a kombóval nem fogod lábon lőni magad, mert a G-Sync egymagában egy garancia a kép folyamatosságára és képtörésmentességére 1-240Hz között bármilyen Nvidia VGA-t teszel mellé.

(majd várom ezt a részt meg úgy az egész hozzászólásomat ki hogyan fogja kiforgatni és csűrni-csavarni)Veszel egy G-Sync képes monitort azt rákötöd a mostani GTX 980-ra és használod addig ameddig nem normalizálódnak az Nvidia árai és váltasz később egy RTX 2060-ra vagy felette valamire.

AMD...?

Minimum 10 éve elengedtem a kezüket VGA fronton (előtte csak Nvidia kártyám volt... GeForce 6800 GT FTW! a mai napig) az akkori Gigabyte HD 4850 512MB + Arctic Twin Turbo hűtővel szerelt kártyámmal:

nem saját kép

CPU-nál meg utoljára AMD Athlon64 3200+ Venice Socket939 volt tőlük, majd csak Intel...

Ezzel az ATI/AMD HD 4850-el nem voltam teljesen elégedett teljesítmény szempontjából így 6 hónap után cseréltem egy Gigabyte GTX 275 896MB-re. Anno i5 750@3,2Ghz+GTX275 OC-vel szerelt akkori gépemet használtam egy ideig majd eladtam és elköszöntem pár évre az asztali gépektől és laptopra váltottam.

De aztán 2014 július-augusztus idején építettem a bejelentett GTA V PC verziója miatt (megjelenés 2015. április 14.) a 0-ról egy asztali gépet (i5 4460+8GB RAM+Asus DirectCU II GTX 760 OC+SSD+HDD) amihez vettem egy tévét is amit a megjelenítőnek szántam.

Ezzel a géppel elvoltam egy ideig majd fokozatosan fejlesztettem-cseréltem minden részét, ahogy előjöttek a gyengeségek az adott komponenssel kapcsolatban.

Nagy vonalakban: 4460-->4790K, 8GB-->16GB, GTX760-->Intel HD4600... eladtam a GTX 760-at a Pascal széria megjelenése körül, amíg adtak érte valamit. Ettől függetlenül egy nagyon jó kártya volt. Majd jött a várakozás.2017 januárjában a CES-ig vártam a bejelentést AMD-éktől, hogy lesz valami épkézláb válaszuk az Nvidia Pascal szériára, hogy esetleges alternatívát jelentsenek a VGA fronton, de semmi nem jött tőlük...

Tovább nem vártam rájuk ezért vettem egy Asus ROG Strix GTX 1070-et, amit használtam fél évig. Nem voltam elégedett a teljesítményével 100%-ban (még IGP után sem), ezért eladtam (megint Intel HD 4600 768p@30FPS ), majd később váltottam egy Asus ROG Strix GTX 1050 Ti OC-ra. Ennek a teljesítménye 1080p-ben és fogyasztása-hőtermelése tetszetős volt számomra. Meg is lepett, hogy mit tud ez a kártya, mert megmondom őszintén rosszabbra számítottam.

Viszont...

Közben az akkori LG 32"-os tévém késleltetése (50-60ms...?) által tapasztalt hátrány online-multi játékokban akkor csúcsosodott ki nálam így lecseréltem az akkori tévét a mostani szintén LG gyártmányú 32"-os 1440p, 165Hz-es, G-Sync-et támogató monitorra.

Igen ám, de az 1440p egymagában mint felbontás erős gyomrosokat vitt be a a GTX 1050 Ti-nek így cseréltem egy MSI Gaming X 1080 Ti-re. Most teljes az összhang 1080 Ti + 1440p, 165Hz és G-Sync, de a 2015-ben vásárolt i7 4790K-t kell lassacskán cserélnem.

Viszont egy rendes monitorral és erős géppel kinyílt egy új világ, mivel jó a kép minden értelemben és erős a vas hogy meg is hajtsa azt.

Most megint az AMD-re várok a CPU fronton, de ez a legutóbb 2019-es CES megint egy gyenge valami volt a részükről... A Vega VII-en röhögtem egy jót a live stream nézése közben, a CPU """"bemutatón"""" meg majdnem sírtam szomorúságomban... Most egy 9700K-ra kacsingatok...

de kiszolgál a mostani gép bőven játék szempontjából.

de kiszolgál a mostani gép bőven játék szempontjából. -

Puma K

nagyúr

-

Puma K

nagyúr

válasz

Kolbi_30

#37330

üzenetére

Kolbi_30

#37330

üzenetére

Azért egy minimum 120Hz-re képes megjelenítőn az adott játékot ennek megfelelő FPS-el futtatni eléggé más élményt ad mint a 30 vagy 60 még ha offline-single is.

Az inputlag-ról nem is beszélve amit az FPS mennyisége mellett nem kevés ember érzékel.Az a folytonos (G-Sync, Free-Sync, Fast-Sync) folyamatosság egy plusz avagy új élményt nyújt.

De ehhez persze kell az is, hogy az adott játék grafikusmotorja ne örüljön meg a 30 vagy 60 FPS-nél több képkockától...

-

Puma K

nagyúr

-

Puma K

nagyúr

válasz

rumkola

#36573

üzenetére

rumkola

#36573

üzenetére

Az gyönyörű

Csili-vili játék okádék kinézettel.Élsimítást már a downsampling felfedezése óta (2013) nem használok, ha az adott birtokomban lévő hardver bírja a felskálázott felbontást. AA-ból esetleg az FXAA-t lövöm be, de azt sem szívesen. De most az 1080 Ti hozza azt amit elvárok tőle.

-

Puma K

nagyúr

válasz

rumkola

#36571

üzenetére

rumkola

#36571

üzenetére

Felezi és pluszban mosott okádék lesz a képminőség...

Sokkal inkább downsampling/DSR mint sem élsimítás... jobban szeretnem az éles képet.

Sőt a DSR-rel még az élességet is lehet állítani driver-ből Nvidia esetén.Most hogy natív 1440p felbontású megjelenítőm van fel tudom skálázni a felbontást maximum 5K-ra, 2880p-re avagy 5120 × 2880 felbontásra 16:9 képarány esetén.

-

-

Puma K

nagyúr

válasz

#45997568

#36178

üzenetére

#45997568

#36178

üzenetére

Ami a linken van az nem az RTX újonnan előjött hibája.

Én is azt hittem.

-

Puma K

nagyúr

-

Puma K

nagyúr

válasz

Raggie

#34422

üzenetére

Raggie

#34422

üzenetére

Arról volt szó, hogy melyik CPU-nál nincs IGP

Ezekben pedig nincs 2012-től kezdve napjainkig megjelenő és ebbe a családba tartozó CPU-knál.Ha valaki inkább CPU intenzívebb munkát végez, akkor mindegy a megjelenítő milyensége.

Még egy GT 1030 DDR4 VRAM-mal is elegendő ilyen esetben![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Puma K

nagyúr

Plusz Intel® Core™ X-series Processors 2012-től.

-

Puma K

nagyúr

válasz

DudeHUN

#34405

üzenetére

DudeHUN

#34405

üzenetére

A VGA-nál a gyártót, hűtést és esetleg a VRAM mennyiségét tudja az ember megválasztani. Mást nem.

Míg egy kőművest igénylő munkánál sokkalta részletekbe menőbben lehet meghatározni a kész munka minőségét-küllemét-összetettségét-variáltságát.

Eddig nem írtam le, de szerintem a kőműves példa jelen esetben rossznak mondanám...

Továbbá,

kéthárom webshop-ot megnézve (még FLATRONW hsz-e előtt én is megnéztem, csak közben dolgoztam) olvasható a specifikációknál, hogy DDR4 vagy GDDR5 van-e az adott GTX 1030-cas kártyán. -

Puma K

nagyúr

Magamból kiindulva azért kutatok a neten adott termékek után, hogy a pénzemért a lehető legjobbak kapjam.

Vagy ha nem értek az adott szakterülethez mert semmilyen rálátásom és tapasztalatom nincs, akkor mástól kérek segítséget. Leginkább olyantól akiben megbízok és tudom, hogy jártas az adott területen.

Így minimalizálom az átb@szás esélyét. Ha meg valami nem kerek azzal amit vettem, akkor visszaviszem.

A gyártó a specifikációknál részletezi az adott terméket.

Aki tud olvasni annak ez nem lehet akadály.Amit most írtál azzal kapcsolatban az jut eszembe, mikor egyik ismerősöm ismerőse nem értette mi a különbség a szimpátia és az empátia között... amit te is említesz, az két különböző téma.

Az egyiknél egy kész terméket vásárolok.

A másiknál pedig egy szakembert bízok meg egy adott munka elvégzésével aminek a milyensége az ő tudása alapján lesz olyan amilyen, és nem csak és kizárólag az általa használt anyagoktól függ a végeredmény.

Így van

-

Puma K

nagyúr

Tények-tapasztalatok vs Arab mesék

1:0 -

Puma K

nagyúr

válasz

huskydog17

#33802

üzenetére

huskydog17

#33802

üzenetére

Az jó hogy hozza Linux alatt is csak kérdés a játék hogy néz ki?

Korábban néztem Windows vs Linux összehasonlítást és Linux alatt ugyan az a játék (már meg nem mondom, hogy miket néztek...) rondábban nézett ki avagy helyesebben egyszerűbb volt más szóval hiányosabb, mert adott effektek hiányoztak.

-

Puma K

nagyúr

Nem jó az utolsó link.

De ez már jó: PC had more “good” exclusive & multi-platform games than any console in 2017

-

Puma K

nagyúr

válasz

solfilo

#33546

üzenetére

solfilo

#33546

üzenetére

Valóban: List of AMD FX microprocessors

Bezavart az erőbe valamelyik megnyitott lap amit ezzel a témával kapcsolatban nyitogattam sorra

-

Puma K

nagyúr

válasz

cyberkind

#33541

üzenetére

cyberkind

#33541

üzenetére

Mikor először próbáltam a GTA V-öt FPS-nézetben PC-n, akkor elmentem az erdőbe nézelődni, hogy azta qrva de rohadt jól néz már ki az egész világa a játéknak ráadásul egy új szemszögből.

Az erdő szélén nézelődve egy pihenőnél leparkolva az autómmal vizsgáltam a környezetet. Nem mentem nagyon az erdő mélyére. Ugyan látni nem láttam, de már hallottam a puma jellegzetes hangját amitől már frászt kaptam mert hirtelen hangosan felüvöltött... majd rám vetette magát és megölt. A váratlan eseményt riadtsággal és kifakadó röhögéssel tudtam nyugtázni

Az AMD CPU-ra reagálva meg ha megnézed, hogy egy jaguar magos FX 8xxx a maga 8 szálával és csilliónyi Ghz-cével játékokban egy Intel i5-ös 4 magos és 4 szálas CPU-val versenyez aminek elég minimum 3-3.2Ghz-cen járnia... akkor ebből nem nehéz azt a következtetés levonni, hogy harmat gyenge a konzolokban lévő 2x 4 magos 1.6 GHz-cen járó 2MB cache-el rendelkező CPU-k bizony gyengék a multiplayer-hez csillámporos low level API ide vagy konzolokra szabott OS oda.

Ezen a szálon tovább haladva, pedig a tapasztalatom azaz volt, hogy egy i5 4460 (4 mag, 3.2 Ghz és 6 MB SmartCache) gyenge volt a GTA Online-hoz, mert meg-meg akadt a játék hát még mikor egymást elkezdték darálni az emberek és elővették a vadászrepülőket, tankokat, RPG-ket meg ami rendelkezésre állt. Ugyan azzal a géppel offline-single a játék gyönyörűen futott, de a CPU-t az Online megette, és ezért voltam kénytelen i5-ről i7-re váltani és ugyan azon grafikai beállítások mellett 1 komponens azaz a CPU cseréjével kisimult a játék.

-

Puma K

nagyúr

válasz

Remus389

#33373

üzenetére

Remus389

#33373

üzenetére

A felépítését (és fogyasztását...) figyelembe véve alapból GTX 1080 Ti-vel kellett volna kezdenie a versenyt amikor megjelent. Ebből kiindulva toronymagasan kellene vezetnie amúgy és ebben a címben meg végképp.

Az hogy egy friss játéknál amin még faragnak majd a készítői és a kártyák driver-e is csiszolódnak meglátjuk később mire jutottak.

-

Puma K

nagyúr

válasz

#45997568

#33328

üzenetére

#45997568

#33328

üzenetére

Valóban az a lényeg amit írsz egy játéknál, de azért egyszer az ember tekintete mászkálás közben rátéved a fűre ami valóban úgy viselkedik ahogy Crytek is írja akkor azért megint szippantani kell a csillámporból hogy visszakerüljön a játékos a játék hatása alá miután kizökkent egy pillanatra.

-

Puma K

nagyúr

válasz

TTomax

#33289

üzenetére

TTomax

#33289

üzenetére

"ehhez a grafikához nem nagyon kell vas..."

Mi ez a cím...?

...

......

.........

Mi ez a grafika...?

Odamész egy barlanghoz és loading screen... ilyet a WoW is tudott már 2004-ben jóval nagyobb bejárható pályával, több NPC-vel és játékossal.

De amúgy vicc ehhez a játékhoz egy belépőszintűnél erősebb CPU-VGA (ennek a játéknak egyáltalán minek külön VGA-CPU teszt??

). Ez ilyen IGP-s szörtyögős játék (ha már PC) amúgy meg konzolra való ez elsősorban a kontrollereseknek

). Ez ilyen IGP-s szörtyögős játék (ha már PC) amúgy meg konzolra való ez elsősorban a kontrollereseknek

![;]](//cdn.rios.hu/dl/s/v1.gif)

Kicsit keveslem a minimum 132 meg maximum 148 FPS-t

A nagyon sok verzióban lévő meg reskin-elt Dynasty Warriors jutott az eszembe ahogy néztem a videót.

-

Puma K

nagyúr

Amiket felsoroltál nyugodtan tudd be annak, hogy ezek az apróságok amik be lettek áldozva a grafikai optimalizálás oltárán 2013 előtt mikor a játékot készítették.

Itt egy 6 részes videósorozat mi minden másra figyeltek oda ennél a korlátolt DX11-gyes játéknál: GTA V - Attention to Detail [Part 1]

Szerencsére adott a lehetőség szét moddolni úgy ahogy az ember gépe bírja: [link]

Vagy tessék ezzel már te is elégedett leszel: [link]

Mert hogy kiadáskor számolni kellett a konzolok és az átlag emberek birtokában lévő PC-k erejével és akkor erre futotta alapból.

Elhiheted, hogy ha jobb hardvereik lennének az embereknek és erősebb konzolok lennének a piacon (cöh

) akkor már a játékok is látványosabbak lennének DX verziószámtól függetlenül.

) akkor már a játékok is látványosabbak lennének DX verziószámtól függetlenül.Még egy kis adalék mit lehet kihozni a korlátolt DX11-ből egy open world játéknál:

GTA 5 Photorealistic | ULTRA REALISTIC Graphics MOD (REDUX)

Annál a Devilnél lehet kezdeni egy HBM pasztázással:

-

Puma K

nagyúr

Dehogynem láttam.

Viszont akkor ha már így kiemelted akkor megkérdem, hogy hogyan kell érteni a "nem is túl szép" kifejezést ez esetben ha grafikáról van szó?Jelenleg az Overwatch valamint a GTA az ami naponta elindul nálam és több óráig pörgetem őket és DX11-gyes címek.

"...számomra már elképesztően illúziórombolóak az üvöltő DX11 korlátok."

Ezeken a képeken te látod az üvöltő DX11 korlátait pl a GTA V esetén?

mod nélkül ez az alap grafika

Én azt látom, hogy egy 2013-ban megjelent játék 2015-ben teljesedett ki PC-n ami DX11-gyet használ és baromi jól néz ki. A jó offline tartalom mellett az aktívan frissített online tartalmon felül ami azóta +9GB-tal hizlalta fel az alap játékot 65GB-ról 74GB-ra ami majdnem egy másik open world játék a Mafia 2 mérete (10GB) szép a csomagolása a játéknak.

Az Overwatch-ot is berakhatnám mert az is baromi szépen néz ki, de az egy jóval kisebb pályán játszódó játék. Vagy akár ott a Witcher 3 is ami szintén DX11-gyet támogat és szintén open world játék. Egyiknél sem látom a DX11 korlátját. Azt látom egyedül az általam felsorolt címeken kívül szinte mindegyik játéknál, hogy hanyagolják a készítők a rombolható környezetet...

A DX10 és 10.1 is egymagukban bukás volt attól függetlenül hogy milyen alapot jelentettek.

Az akkor kiadott tudásuk alapján semmivel sem tudtak többet a gyakorlatban. Ki sem kellett volna adni csak akkor mikor már elérte a DX11 szintjét tudásban. Ezt is alátámasztja a Vista rövid pályafutása és a Windows 7 gyors megjelenése ahhoz képest mennyi idő volt az XP és a Vista között.Ugyan az van most a Win7+DX11 párossal mint a WinXP+DX9.c duóval volt anno.

A játékkészítők-kiadók nagyobb rálátással rendelkeznek erre az egész témára mint te vagy én.

Arra az OS és DX-re adnak ki játékot ami elterjedtebb és tudják, hogy zökkenőmentes az áttérés. De számomra egyáltalán nem meglepő módon az eddigi tapasztalatok és információk alapján a DX12-re való tömeges áttérés és új játékok megjelenése elmaradt.

-

Puma K

nagyúr

"Ami az Ashes of the Singularity-t illeti, azért ott elég komoly dolgokat megvalósítottak, még ha első ránézésre "nem is túl szép"."

Tehát akkor inkább legyen egy játék DX12-es ami csúnyább és kevesebb FPS produkál?

Akkor minek szeretnél bármilyen szintű fejlődést ha szerinted a csúnyább-alacsonyabb FPS jobb?

Neked miért fontos mint játékos a technológiai háttér ha a játék jól néz ki és jól fut szemben egy olyan eljárással ahol a végeredmény minden szempontból rosszabb?

"Ami a DX12 címeket illeti, ott még mindig a probléma, amennyire én látom, hogy senki nem meri bevállalni, hogy nesze, egy DX12 only cím... Nem elég nagy a piaca."

Mert kb ez a DX12 is akkora bukás mint a DX10 és DX10.1 volt.

Ott is az volt, hogy pár címbe bele rakták a DX10/10.1-gyet és kész.

Gyakorlati előnye-haszna nem volt.Be lett harangozva mind a kettő-három DX a maga idejében az új OS-ekkel együtt -név szerint Vista majd Win10- megjelenés előtt, hogy fú most aztán nagyon jön és olyan grafika meg ilyen-olyan újítás lesz hogy úha. Ehhez képest lóf@sz sem történt még mindig. Akkor sem a Vista idejében és most ~2.5 év után sem a Win10-nél.

A DX11-nél nem emlékszek arra, hogy ennyire előszopták volna a terepet bármilyen szinten bármelyik gyártó-cég mint most a DX12-nél az AMD&Májkrémszaft duó. Ja de már volt egyszer ilyen... szintén az AMD részvételével a külön DX10.1 támogatás ami ha a számozást nézzük akkor több mint a DX10, de a gyakorlati haszna nulla volt.

A Win7 és a DX11 jött, látott és a mai napig nem akar kihalni egyik sem.

Hasonlóan mint anno a Windows XP és a DX9.c, azok is elég jól tartották magukat, majd leváltották őket mikor időszerű volt.A DX9.c-re is ment a fújás, hogy hát de miért nem felejtik már el a játék készítők, mikor kint van a DX10/10.1 és azt kellene már használni...

Azt sem szabad elfelejteni, hogy vannak a konzolok amiket csak adott évenként fejlesztik hardveresen... ameddig azok nem fejlődnek addig a játékok sem fognak. Lehet rájuk várni.

-

Puma K

nagyúr

Az nem az Nvidia sara, hogy nincs mit kiszolgálni a jelenlegi szinttől jobban.

A felbontás növekedésre is reagáltak plusz teljesítménnyel.Látható részükről ha vannak adott területek ahol helyt kell állni és tudnak rá megoldást (önvezető autók, gépi tanulás, szerverek, játékra szánt grafikuskártyák asztali és hordozható gépekbe, kézi konzol, stb) akkor rakják alá a hardver+driver-t.

A csillámporos meselistát meg minek adjanak ki?

-

Puma K

nagyúr

válasz

Kolbi_30

#31994

üzenetére

Kolbi_30

#31994

üzenetére

A kis pénztárcájú emberek nem fogják megérteni sosem, hogy adott teljesítményszinten az ár nem számít csak a teljesítmény.

Ezen a nem számít szinten anno az AMD is jelen volt mint opció tehát választhattál, hogy vagy AMD vagy Nvidia az a kártya-kártyák amik dolgozik-dolgoznak a gépedben.

Erről a játszótérről tűnt el gyakorlatilag szőrén-szálán az AMD.

Ezért (is) ekézik sokan őket, hogy ezt hogyan sikerült összehozniuk.Most pedig azt lehet látni, hogy az Nvidia úgy játszik az árakkal ahogy csak jól esik nekik és még a számozást is elcsúsztatták. Mindezt megint csak az veszi észre akik a felső kategóriából válogatják meg az aktuális kártyájuk leváltóját és figyelemmel követik ezt a teljesítményszintet, a specifikációkkal és számozással együtt.

Mert megtehetik.Sőt ha sejtik-tudják, hogy nem lesz acélos a konkurencia adott új szériája akkor áremelgetések mellett még töltelék generációt is kihoznak amik ugyan megint megállják a helyüket a gyakorlatban, de látható, hogy nem kapkodnak-sietnek semmivel:

Akik meg azt szajkózzák, hogy az Nvidia nem fejleszt, azok megint olyan alsóbb teljesítményszinten válogatják a kártyáikat ahol a valós elért fejlesztés nem olyan látványos, de azért a teljesítmény/fogyasztás mutatón meglátszik a lentebbi szinteken is a fejlődés.

Mindig a felsőbb kategóriát kell nézni az előzőhöz képest. Ha azt megnézed akkor látszik mit fejlesztettek és mennyivel gyorsultak.Az AMD-t meg nem kell sajnálni.

Ők is a pénzedbőlélnekélnének. Csak rosszul csinálják, egy ideje, hogy még többet szerezzenek az emberektől...Ezek ketten régóta gyűrik egymást a piacon, de az egyik úgy látszik elpuhult...

-

Puma K

nagyúr

válasz

#45997568

#31772

üzenetére

#45997568

#31772

üzenetére

Több hónapja olvasgatok róluk véleményeket és eddig nem futottam bele negatív tapasztalatokba a tiéden kívül az Amazonnal kapcsolatban.

Ha valami pontatlanság van akkor rendelés előtt rá kell kérdezni. Lehet elírás volt.

Ilyen itthoni üzlettel is megesett, hogy adott kártyára 2 évet adtak holott 3 év járt, a fórumtárs (igaz vásárlás után) jelezte a cég felé és küldték az új javított garanciaidővel rendelkező garanciapapírt.Kártya megjelenés után (2017. augusztus) max 1 hónappal mint ahogy az Nv kártyáknál sikerült a gyártóknak.

Az Asus Strix RX Vega 64 már korábban is megjelent, de ott valami nem volt kerek.

AMD-vel kapcsolatban a sokszor leírt-olvasott majd, ha, egyszer, talán és a jövőben szavacskák amit már jó pár éve olvasni lehet az = soha

-

Puma K

nagyúr

A nVidia-nál tudnak harapni a gyártók az új szériákra és a referenciák után pár nappal-héttel már jönnek is az egyedi megoldások.

Késett a Vega: Release date August 14, 2017

(Pascal: Release date May 2016)16 hónap.

Egyedi megoldások meg: 2017-11-29 - Szállingóznak az egyedi Radeon RX Vega VGA-k

Már december van és még mindig nem lehet kapni egyedi vegát: 16 hónap + 4 hónap = 20 hónapja nincs egyedi kivitelű vega a késéssel együtt számolva

-

Puma K

nagyúr

Elfogultak vagytok... nem hisztek a jövő technológiájában ami a majd, egyszer, ha és talán a jövőben kiaknázottá válik és csak úgy hasít majd egyszer, talán és ha úgy akarja az AMD is

-

Puma K

nagyúr

válasz

FollowTheORI

#31640

üzenetére

FollowTheORI

#31640

üzenetére

Pascal kártyával meg kellene nézni, hogy viselkedik a játék ha az Nv driver-ben a kártyára vonatkozóan a Power management mode résznél a Prefer maximum preformance lehetőséget választja az ember és úgy méricskél az AC: Origins-ben egy előtte és utána állapotot.

Lehet a GPU boost 2.0 és 3.0 közötti működésbéli különbség adja az eltérést ez esetben.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Nem indul és mi a baja a gépemnek topik

- sziku69: Szólánc.

- Luck Dragon: Asszociációs játék. :)

- sziku69: Fűzzük össze a szavakat :)

- Milyen asztali (teljes vagy fél-) gépet vegyek?

- Kodi és kiegészítői magyar nyelvű online tartalmakhoz (Linux, Windows)

- Genshin Impact (PC, PS4, Android, iOS)

- Milyen okostelefont vegyek?

- E-roller topik

- Xiaomi 17 Ultra - jó az optikája

- További aktív témák...

- Lenovo IdeaPad 3 - 15,6" Full HD - AMD Athlon Silver 3050U - 4GB - 512GB SSD - Win10 PRO - MAGYAR

- Oppo A14 4/64GB Kék / 12 hó jótállás

- Macbook Pro M3 Max 14" - 36 GB/1TB/ 27% ÁFÁS! - 0360AB

- Honor 200 Lite 256GB, Kártyafüggetlen, 1 Év Garanciával

- Tablet felvásárlás! Samsung Galaxy Tab S10+, Samsung Galaxy Tab S10 Ultra, Samsung Galaxy Tab S10 FE

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) ) így nincs hangom.

) így nincs hangom.