Új hozzászólás Aktív témák

-

hobizoli

nagyúr

válasz

Dragon3000

#299

üzenetére

Dragon3000

#299

üzenetére

akkor lehetne a CPU felol hatuljan is egy vonalban a 4xPCIE, ahogy feljon a kabelrejtobol

de ha csak 2-t dugnak ra 12VHPWR mellett, akkor is mar lefelezodik a terheles azon is -

Dragon3000

nagyúr

válasz

GoldhandRent

#296

üzenetére

GoldhandRent

#296

üzenetére

A 12vhpwr legnagyobb gondja, hogy van egy kicsi méretű csatlakozó, amihez sokan az adaptert használják, amire 3 vagy 4 8pines kábel megy rá és ez a nagy súly simán tudja feszíteni a csatlakozót még akkor is, ha jól rá van dugva, innen kezdve azzal is foglalkozni kellene, hogy milyen elhelyezkedése van a csatlakozónak a vga-n, hogy ez a feszítés minél kisebb legyen. Ebből a szempontból az olyan megoldások, ahol el van rejtve a csatlakozó általában maga a kábel felfekszik a hűtőbordára vagy egy lemezre ami erre szolgál, így sokkal jobb a helyzet ezeknél, mint a vga tetején lévő csatlakozóknál, ez mellett még a kártya hűtése is keveri a csatlakozónál a levegőt.

-

GoldhandRent

őstag

válasz

Dragon3000

#295

üzenetére

Dragon3000

#295

üzenetére

van a szarul rádugás, mikor a fele csatlakozó le van törve, lóg a levegőben, el van görbülve a pin,,,,

és van a 12VHPWR szarul rádugás, ami úgy néz ki mint egy ETALON összecsatlakoztatás, közben meg szar xd -

Dragon3000

nagyúr

válasz

GoldhandRent

#292

üzenetére

GoldhandRent

#292

üzenetére

Minden lehet szar, ha szarul dugod rá, nem véletlen vannak esetek 6 és 8 pines olvadásokról is a neten, ez mellett ha még szar a csatlakozó utáni rész, akkor meg megette a fene az egészet.

-

X2N

őstag

válasz

GoldhandRent

#292

üzenetére

GoldhandRent

#292

üzenetére

Le kell tenni az ilyen olcsójános megoldásokról ha 1db kábellel akarják megoldani a táplálást, vagy feltenni rá a 3-4db 8pines normális csatlakozót.

Lehet venni nagyon jó tápcsatlakozókat, amikkel akár 1000+W-os videokártyákat is lehetne használni. A Battlebots robotoknál is ezeket használják vagy a nagyobb Anderson SB350-at. 2 ilyen vastagságú vezeték még kevesebb helyet is foglalna a pcb-n mint a mostani csatlakozó. A quadroknál is kivezetik vezetékkel a pcb-ről a tápot. -

Dragon3000

nagyúr

A nitro plus esetében szépen el van rejtve a ventilátor még hűti is és még meg is van támasztva a kábel, így a súlya sem tudja elhúzni.

Amúgy ha jól tudom a régi csatlakozók esetében is megvolt ez a 35mm a hajlítás esetében, de sokkal kisebb teljesítmény ment egy csatlakozón és maga a csatlakozó robusztusabb volt, így kevésbé okozott gondot a be nem tartása. -

GoldhandRent

őstag

válasz

Dragon3000

#289

üzenetére

Dragon3000

#289

üzenetére

és #288 és #287

tehát a csatlakozó a SZAR

független attól, hogy melyik gyártó rakja rá a kártyájára, szar a csatlakozóa baj(a sok embernek itt most) az, hogy éppen úgy hozta a sors, hogy szinte csak NV kártyákon látni ezt a rémet..meg most ezen az seggkövön

nem is tudtam, hogy van 9070xt ilyen csatival.. én pl többek között a csatlakozó miatt vettem inkább AMD kártyát ezúttal

és így már van összehasonlítási alap -> a többi 9070xt amin "hagyományos" 8pines van, leolvad ? ugyan akkora teljesítmény mellett -

X2N

őstag

válasz

Dragon3000

#289

üzenetére

Dragon3000

#289

üzenetére

Ha ezekre az ábrákra gondolsz akkor kb. lehetetlen a kábelt normálisan csatlakoztatni. A saját súlyától meghajlik a kábel a csatlakozó tövénél.

Egy nem mai cikkből. -

Pocoyo.hun

kezdő

válasz

Dragon3000

#289

üzenetére

Dragon3000

#289

üzenetére

negativ

-

Dragon3000

nagyúr

válasz

Pocoyo.hun

#288

üzenetére

Pocoyo.hun

#288

üzenetére

Ha rám gondolsz, akkor nv kártyánál is egyből azt írtam, hogy jól rá volt e dugva, nem volt megtörve a kábel, ha figyelembe vesszük, hogy az alap 5080 ugyanakkora tdp-vel rendelkező kártya, mint az említett oc-s 9070xt és az 5080-ról elég ritkán lehet olvasni, hogy olvadt, akkor egyértelműen először a user errort kellene kizárni, illetve miért nem készült kép az összedugott rendszerről, miért csak a kábelről utólag? Illetve a kártyán lévő csatlakozóról miért nem készült kép?

-

Pocoyo.hun

kezdő

válasz

Busterftw

#287

üzenetére

Busterftw

#287

üzenetére

Azt reagálják, amit itt már egy el is kezdett. Látod egyből előkerültek a rendesen összedugott kábelek, a user error, amit természetesen nv kártyánál azonnal és feltétel nélkül ki kellett zárni, mint hibaforrást. Sőt még a táp is, ami ugye OPP vagyis túlterhelés védelemmel van ellátva, és nem is a táp oldalon volt olvadás. Vagyis kizárható.

Persze lesz egy két intelligensebb fanboyka aki csöndbe marad, de a vérfanboyok és haterek úgyse bírnak magukkal.... egyébként nagy mosolygással olvasom a külföldi fórumokon a nyüszítést....

-

Busterftw

nagyúr

Most kíváncsi leszek mi lesz a "média" reakció, meg itt a fórumon nagy kuss lesz vagy nem.

Ugye eddig házak égtek le, meg perelni kell az Nvidiat."amiről inkább tehet a User"

Juj juj ezzel vigyázz. Egyértelmű az Nvidia ment el hozzá és gyújtotta fel.Kíváncsi leszek most mit reagálnak ezek az userek.

-

Dragon3000

nagyúr

Nekem seasonic prime titanium 650W mellett gond nélkül el volt a 9070xt nitro plus az adapterkábellel, 1 hónappal később cseréltem egy seasonic 2x8pin to 16 pin kábelre (így sokkal szellősebb lett a nagy kábel köteg hiánya miatt a táp rész), az adapterkábelnek semmi baja nem volt (itt még színezték is kékre, így eléggé feltűnő lett volna, ha bármi baja lenne), a táp a 3080 oc-met is kiszolgálta, ami sokkal többet kért gyárilag, mint a 9070xt.

-

-

X2N

őstag

Értem amit mondasz, de ilyeneknek akkor sem kellene megtörténnie. Ahogy a repülőgép szerencsétlenségeknek se. Nem tudod nem rendesen összedugni a kábelt, azért van rajta a locking pin ezt megakadályozza, a régi 8 pinesen is van. Már kiadtak belőle egy újabb 12V-2x6-verziót hosszabb pinekkel, jobb locking mechanizmussal de így se jó.

-

-

X2N

őstag

First Case of Melted 16-Pin Connector Reported On AMD Radeon RX 9070 XT GPU

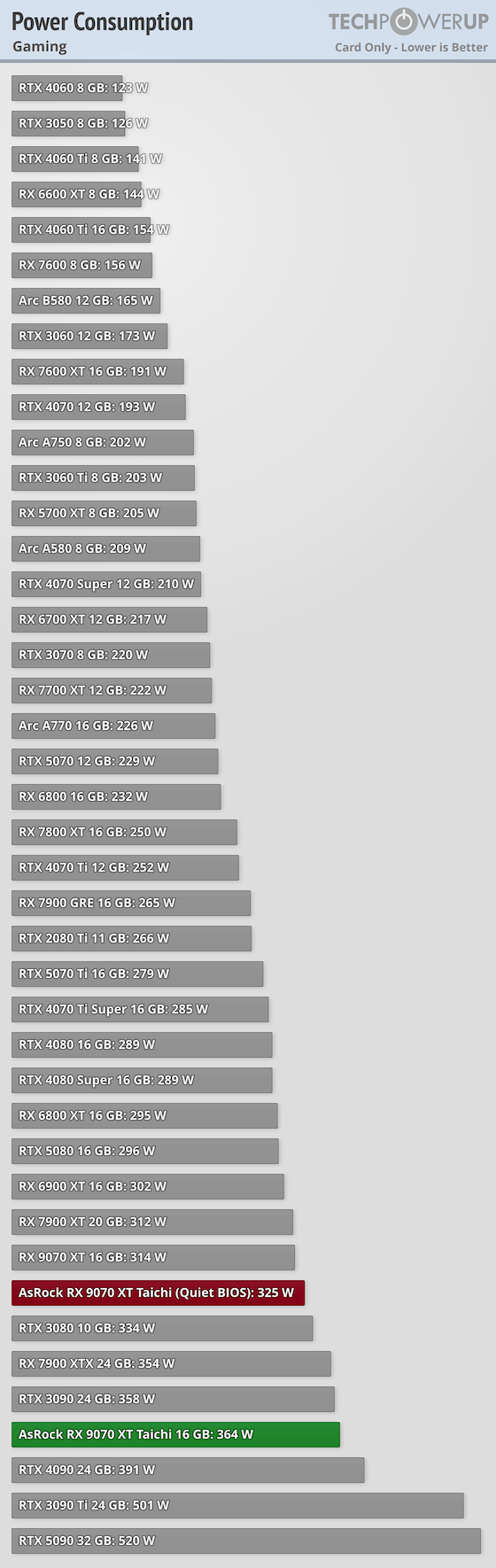

ASRock Radeon RX 9070 XT Taichi OC-kártya az érintett. Játék alatt 364W-ot fogyasztó kártya.

-

Dragon3000

nagyúr

-

Busterftw

nagyúr

Teljesen mindegy, irreleváns, hogy melyik kártya, mert cáfolja azt, hogy egy bizonyos limitet nem léphet át.

A Techpowerup tesztben FE van, az már két példa."Van ~30W fogyasztás különbség 4K és 1440p átlag fps-be a proci limit miatt."

Nincs CPU limit. A többi, már linkelt tesztben is kijön a különbség.

A te YouTube teszteden 10900K van, ami papíron és játék tesztben gyorsabb mint az 5950x, ott is van különbség."Átlag fogyasztás továbbra is ~450W csúcsban 500W, nem 537W ahogy a techpwowerup tesztbe behaluzták az átlag fogyasztást."

Te tartós fogyasztásról írtál, ami játék alatt megvan ,ott pedig ennyit mértek. Aztán hogy te milyen tényeket és méréseket ignorálsz, mert csak az a te egyéni problémád.

A tényeket az öngóljaid és a logikai bukfenceid nem befolyásolják. -

X2N

őstag

válasz

Busterftw

#275

üzenetére

Busterftw

#275

üzenetére

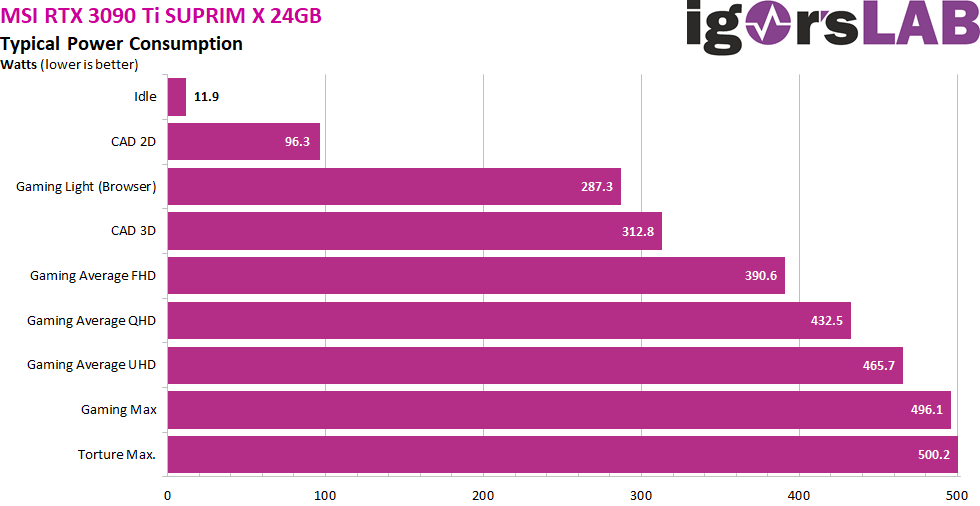

Az a teszt egyébként se FE teszt hanem egy MSI GeForce RTX 3090 Ti SUPRIM X.

Ezen lovagolsz megint:

Van ~30W fogyasztás különbség 4K és 1440p átlag fps-be a proci limit miatt. Igen, még úgy is hogy tuningolta a processzort. FHD-ba még még több, proci limit van, ki gondolta volna.

Átlag fogyasztás továbbra is ~450W csúcsban 500W, nem 537W ahogy a techpwowerup tesztbe behaluzták az átlag fogyasztást.

-

-

X2N

őstag

válasz

Busterftw

#273

üzenetére

Busterftw

#273

üzenetére

Már leírtam mi a baj az Igor-os tesztel, proci limit miatt volt 30W különbség 1440p és 4K felbontás között, de ott se fogyasztott a FE 3090Ti 530W-ot. Lehet hogy akkor az volt a legerősebb processzor, de akkor is limitált 1440p-n abban a mérésben azzal a szoftverrel/játékkal.

A techpowerupos tesztben meg van +70W különbség az összes többi teszthez képest. -

X2N

őstag

válasz

Busterftw

#269

üzenetére

Busterftw

#269

üzenetére

Melyik kettő? Techpowerupról volt csak szó.

Ribi-Ezek a dolgok ilyenek, Linus-ék is úgy rakták össze a "mérőlabort" amivel majd remélhetőleg jobb teszteket tudnak készíteni, meg automatizálva lesz a hibák minimalizálása miatt.

De azért egy olyan biztosítékos toldót szerintem sokan eltudnának itthon is készíteni ami megszakítaná 9.5A felett áramfogyasztásnál a kártya tápját.

Kevesen tudnak már egy tápegységet is normálisan letesztelni mert nincs hozzá műszerezettségük, meg nem is értenek hozzá mint anno JonnyGuru.A gyártóknak meg nem érdekük semmi. Letelt a gari vegyél újat, ennyit kell tudnia a kártyának.

Nem népkártya az 5090-keveseket érint ez a probléma szerencsére.

-

Ribi

nagyúr

Nem, csak 50A-el amivel hegeszteni szoktak. Plusz ugye nem úgy van hogy bemész megveszel mindent és kész. Ezeket utána nem árt valamennyire hitelesíteni, nem árt pár normális labor cucc.

Hogy usereknek ez a jövő az meg nagyon durva csúsztatás. Pár youtuber akik ebből élnek ezt csinálják az semmit nem vetít előre. Főleg nem pistikék millióinak akik egybegépet vesznek. Viccnek is rossz lenne. -

Busterftw

nagyúr

Az a baj, hogy ezt két elismert tesztelő is megcáfolta, mérésekkel, tesztekkel és ezt te ignorálod.

Ez a baj, hogy te száraz tényeket tagadsz."Valami nyilvánvalóan rossz a techpowerup mérésénél"

Szerinted, amit cáfolni nem tudsz, csak rugod az öngólokat."Ha továbbra is bizonytalan vagy"

Az egyedül itt te vagy, már sokszor saját magad megcáfoltad, a te érvelésed konkrétan eddig ennyiből állt: mert csak.

Nulla infó, nulla bizonyítás, nulla objektivitás. -

X2N

őstag

Senki nem mondta hogy ez egy délutános projekt. De nem nagyfeszültséggel kell dolgozni ahol elég 1x rossz helyre nyúlni, így semmi komolyabb baj nem történhet, azon kívül hogy fordítva kötöd be a polaritást és tönkrevágod vele a videokártyát meg az alaplapot is.

Lesznek megvehető megoldások is.Ez lesz a jövő, majd a usernek kell a gyártók helyett okosnak lennie, ha hosszútávon akarja használni a megvett hardvereket.

-

X2N

őstag

Egy hasonló mérőt bárki összerakhat 5mOhm-os ellenállásokkal meg egy arduinoval. Még programozni se kell tudni különösebben hozzá. Az nvidia PCAT is ugyanígy működik. A fentebb linkelt házi barkács védelemből az első is így működik.

A második példa a biztosítékokkal elég paraszt megoldás de működik

-

X2N

őstag

Árammérő ellenállással mérném, az a legpontosabb(<0,1%).

Lakatfogó(1–3%)

Szoftveres mérés(±5–10%) -

X2N

őstag

Amelyik FTW3-at anno a Techpowerup is letesztelte és csontra ugyanazok az eredmények jöttek ki mint TechJesus-nál:

Gaming: Cyberpunk 2077 is running at 2560x1440 with Ultra settings and ray tracing disabled. We ensure the card is heated up properly, which ensures a steady-state result instead of short-term numbers that won't hold up in long-term usage.Maximum: We use Furmark's Stability Test at 1920x1080, which results in very high no-game power consumption that can typically only be reached with stress-testing applications. All modern graphics cards have power limits, which are tested in this scenario. Our high-speed test equipment is able to capture power spikes that occur very quickly, before the power limiter on the graphics card can react.Lényegében nem változtatott a fogyasztáson az hogy TechJesus 4K-felbontáson Futtatta a Furmarkot, a Techpowerup meg 1080p-n.

-

X2N

őstag

válasz

Busterftw

#259

üzenetére

Busterftw

#259

üzenetére

Az a baj hogy a hivatalos specifikáció-t nem lépheti túl a kártya, ha 450W van megadva az FE-nél annyi lesz a maximális fogyasztás, ettől nem lehet eltérés fölfele, akármilyen felbontáson is teszteled(játékkal).

Még az agyon tuningolt FTW3 is maximum 533W-ot fogyaszt Furmark alatt 4K felbontáson, ami sokkal nagyobb terhelés mint a játék alatti.

Valami nyilvánvalóan rossz a techpowerup mérésénél ahol játék alatt fogyaszt ennyit egy FE.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Ha továbbra is bizonytalan vagy ott van a 30xx topik majd segítenek. -

Busterftw

nagyúr

Te nem érted. Ott 1440p-ben tesztelnek, míg a 5090-nél az újrateszt már 4K-ban történt, ahol nagyobb terhelés éri a kártyát, többet fogyaszt.

Ezt már 4 esetben (ebből az egyik a tiéd) alátámasztottam, és nekem kell segítség?

"Ami nem FELBONTÁS függő, ha 100%-os terhelésen megy a kártya ennyit vehet fel maximum."

Ez nem így van, látod Igor tesztjében is többet fogyaszt, mint a BIOS limit, ezt is leírta, csak szokásos módon terelsz.

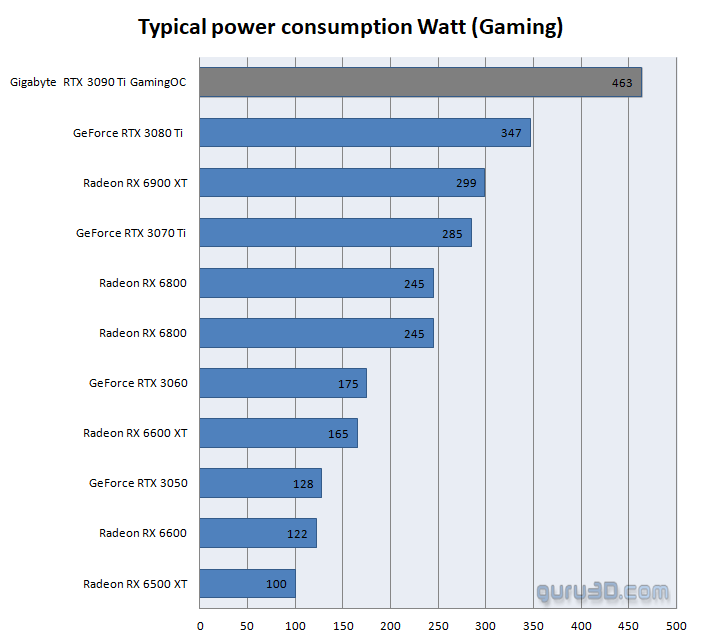

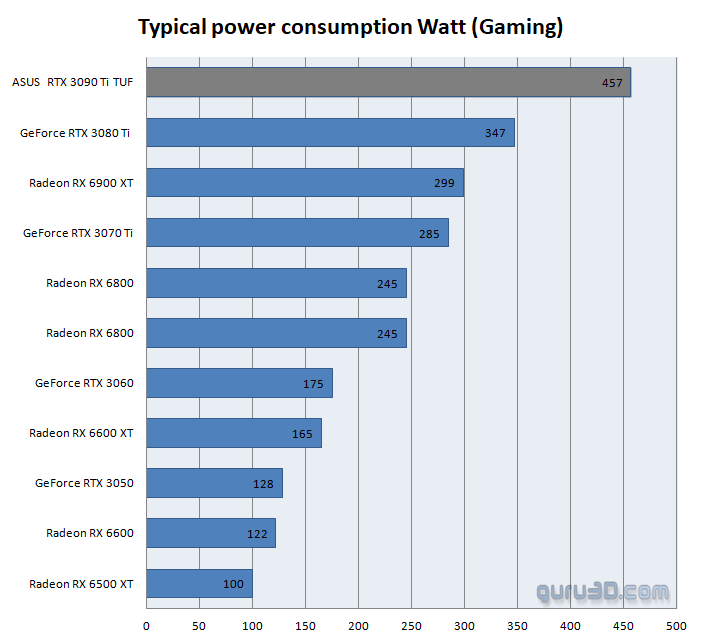

A Guru3D-nél nincs leirva mivel és hogy teszteltek! Ezt is mondtam már, persze hogy más lesz az eredmény, más a teszt! -

X2N

őstag

válasz

Busterftw

#254

üzenetére

Busterftw

#254

üzenetére

Segítek mert nem érted:

Ez a kártya(3090Ti), a büdös életbe nem fogyaszt folyamatosan 530W-t játék alatt, a csúcs teljesítmény felvétele lehet maximum ennyi:

Ami nem FELBONTÁS függő, ha 100%-os terhelésen megy a kártya ennyit vehet fel maximum."Ryzen 9 5950X OC"

Ez a proci egyik felbontásban sem bottleneckeli a 3090Ti-t.

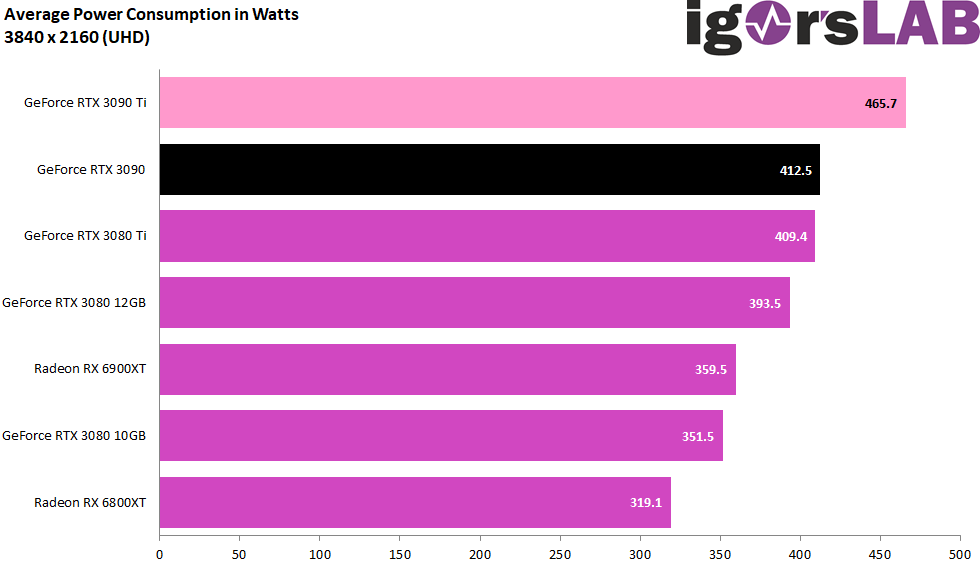

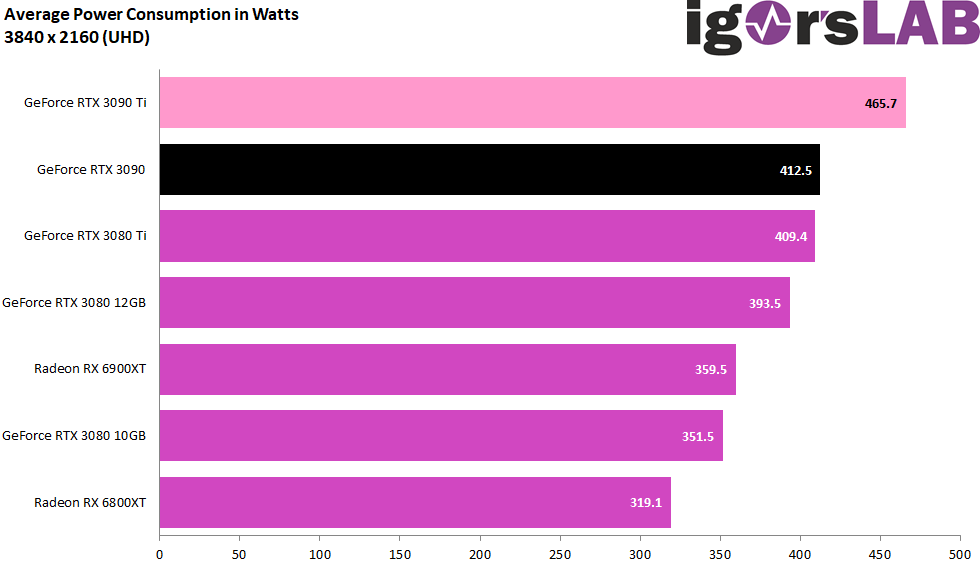

Ja látszik a 30W-os különbség teljesítményfelvételnél. 4K/1440p

-

Busterftw

nagyúr

"We conduct a physical measurement using professional lab equipment, the values are not software sensor readings, which are much less accurate" - Techpowerup.

Égesd tovább magad. Tudjuk hogy a random Joci Gaming csatorna az náluk jobban mér otthon a panelban.

Mellesleg 1440p-ben kevesebbet fogyaszt itt is, mint 4K-ban. -

Busterftw

nagyúr

"Azt írtad hogy 4K-ban többet fogyaszt mint 1440p-ben ahol 540W-ot fogyaszt a Techpowerup szerint"

Pontosan, tehát nem írtam azt 4K-ban 600W-ot fogyaszt a 3090Ti amit te itt próbáltál ferditeni, a sok öngól után.És igen, már 3 forrásal lett alátámasztva, hogy 4K-ban a nagyobb terhelés miatt többet fogyaszt a kártya vs 1440p-ben.

Te hoztál nulla cáfolatot és sok terelést."Közbe meg Igornál 440-465W van feltüntetve 4K alatt, ahogy a Guru3D-nél és a Hardware Unboxednél is."

Persze, mert mással tesztelték a kártyát, mit nem tudsz ezen megérteni? A Guru3D nem is írta mivel tesztelték."De amikor a Techpowerupnál 130W-al fogyaszt többet a 3090Ti mint az összes többi oldalon"

Igornál is eléri az 500W körüli wattott, miközben teljesen mással és máshogy mértek. Szép ferdítés megint.

Persze úgy könnyű terelni, hogy téged az adatok és a tények nem érdekelnek."Ryzen 9 5950X OC"

Ez a proci egyik felbontásban sem bottleneckeli a 3090Ti-t."Kit érdekel? Nem az én problémám."

Nagyon is a tiéd, mert itt bukik ki a marhaságod.

Mert amikor az öngól logikádat alá kellene támasztani, akkor terelsz és hát amúgy is kit érdekel, meg le se szarod.

-

X2N

őstag

válasz

Busterftw

#252

üzenetére

Busterftw

#252

üzenetére

3090Ti 4K natív CP2077 max grafika RT-vel. ~420W fogyasztás.

Nem 540W mint a hibás techpowerup tesztben.

Meddig tagadod még a nyilvánvalót?

Meg lehet nézni az 1440p-t is ugyanitt, semmivel se fogyaszt kevesebbet a kártya.

-

Busterftw

nagyúr

válasz

Dragon3000

#246

üzenetére

Dragon3000

#246

üzenetére

Nem hibás. Itt is ugyanaz a különbség, 4090 tesztnél a Gaming teszt még 1440p volt, 4080-nál már 4K.

Játék és beállítás ugyanaz.A Maximum teszt meg Furmark 1080p. Ezért más.

-

Dragon3000

nagyúr

Igazából a 3090ti fogyasztásával kapcsolatban ment a vita köztük és akkor már ránéztem, hogy mégis mi változott, hogy ekkora a különbség, de semmi, ugyanaz a tesztrendszer, ugyanaz a driver és windows verzió, mégis csak úgy változott egy kártya fogyasztása ~100W-ot, míg a többi esetben minimális változások voltak, de a legviccesebb, hogy a maximum fogyasztás alacsonyabb, mint amit játék közben mértek, illetve az újabb tesztben más kártyák esetében is vannak érdekességek a fogyasztásnál ugyanúgy, hogy a maximum kisebb, mint amit játék közben mértek.

-

válasz

Dragon3000

#247

üzenetére

Dragon3000

#247

üzenetére

Megmondom őszintén én elvesztettem a fonalat már régebben miről is megy a vita, csak azért tettem be igort, mert ő ebben a nagymester, ha VGA fogyasztásról van szó.

Az egyik kommentben láttam hogy felmerült hogy magasabb felbontáson többet eszik a VGA ezért írtam ezt, nem közvetlenül a te kommentedhez kapcsolódóan.X2N: a 3090Ti idejében az csúcs CPU volt.

-

X2N

őstag

válasz

Busterftw

#245

üzenetére

Busterftw

#245

üzenetére

De ha már Igor tesztje, ő is alátámasztotta a 1440p-4K fogyasztást:

"The higher the resolution, the higher the thirst."BOTTLENECKES PROCESSZORRAL:

The benchmark system is new and is no longer in the lab, but in the editorial room again. I now also rely on PCIe 4.0, the matching X570 motherboard in the form of an MSI MEG X570 Godlike, and a select Ryzen 9 5950 X

Igor "tesztje" is kb. ennyit ér.Bezzeg ha X3D lett volna. Akkor ugyanaz a fogyasztást méri 1044p,4K felbontáson.

Így is csak 30W eltérés volt a 2 felbontásnál mert tuningolta a procit is meg a ramot is. Az kevesebb mint 10% eltérés. De már ez se jó. Csúcs VGA-t nem gyenge processzorral tesztelünk. -

X2N

őstag

válasz

Busterftw

#245

üzenetére

Busterftw

#245

üzenetére

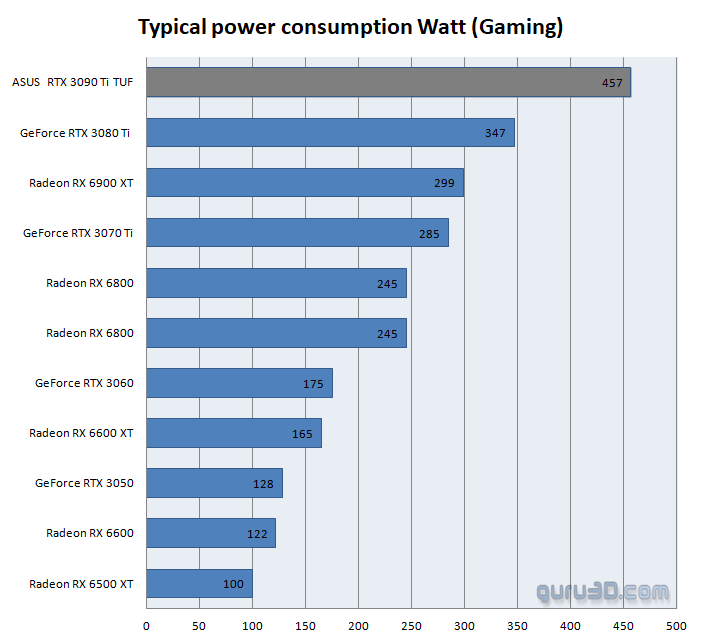

Azt írtad hogy 4K-ban többet fogyaszt mint 1440p-ben ahol 540W-ot fogyaszt a Techpowerup szerint, egész délután ezt magyaráztam neked hogy ezt marhaság.

Közbe meg Igornál 440-465W van feltüntetve 4K alatt, ahogy a Guru3D-nél és a Hardware Unboxednél is.Képzeld nem egy nagy kaland megmérni egy videokártya fogyasztását, nem érdekel hogy mérték. Le se sz@rom. Ha érdekel megmérem magamnak, nem kell hozzá tesztoldal. De amikor a Techpowerupnál 130W-al fogyaszt többet a 3090Ti mint az összes többi oldalon, és az nvidia oldalán is TGP 450W van feltüntetve, akkor ott valami csúnyán benéztek.

Én meg emlékszek rá hogy 3 évvel ezelőtt mit mértek képzeld, nem kellett megnéztem a mostani fals eredményt.

"Na mennyi 4080/4090 és mennyi 5090 olvadt? "

Kit érdekel? Nem az én problémám. -

Dragon3000

nagyúr

Mi techpowerupról beszéltünk és nem az, hogy fullhd vagy 4k, hanem, hogy a 4090 tesztig 445W volt a 3090ti fogyasztása, majd 1 hónappal később a 4080 tesztnél már 537W (leírás szerint semmi változás nem történt a mérések esetében a két teszt közben), és mindezek mellett a maximum fogyasztásnál kisebb érték jött ki náluk, illetve minden kártya fogyasztása változott a két teszt közben, még a 4090-é is, miközben mindenben ugyanazt az eredményt használták.

-

Dragon3000

nagyúr

-

Busterftw

nagyúr

"Na HOL FOGYASZT 4K-ban 600W-ot a 3090Ti? "

Nem írtam sehol, hogy 600W-ot fogyaszt, szerintem fejezd be ezt a fajta termelést, mert csak magadat égeted még jobban.A Techpowerup egy másik teszt, más körülmények között, más metodika alapján, mit akarsz megmagyarázni?

Igor teljesen mással mért fogyasztást és külön tért ki a gamingre.

Persze ha egyszer végre elolvasnad a tesztet amit linkelsz, akkor nem írnál ekkora marhaságokat.De ha már Igor tesztje, ő is alátámasztotta a 1440p-4K fogyasztást:

"The higher the resolution, the higher the thirst.""A 4080/4090 is olvadt, csak NEM ANNYI mint 5090."

Na mennyi 4080/4090 és mennyi 5090 olvadt? -

X2N

őstag

válasz

Busterftw

#243

üzenetére

Busterftw

#243

üzenetére

Na HOL FOGYASZT 4K-ban 600W-ot a 3090Ti?

De benézte a Techpowerup meg te is.

Persze most már teljesen felesleges ezen rugózni amikor 3 oldal be lett neked linkelve a délután folyamán hogy mi a helyes fogyasztás érték.

A 4080/4090 is olvadt, csak NEM ANNYI mint 5090.

-

Busterftw

nagyúr

válasz

Dragon3000

#234

üzenetére

Dragon3000

#234

üzenetére

Linked légyszíves a két tesztet, mert a másik két tesztben (3090ti és 5090 amit én linkeltem) a különbség az, hogy 1440p helyett 4K-n futott a Gaming tesz, játék maradt ugyanaz.

De teljesen felesleges ezen rugózni, mert a 4080/4090 is olvadt, szóval nem azért kezdtek leégni mert "most először közelítünk a 600W-hoz", ahogy itt hősünk behaluzta.

-

válasz

Dragon3000

#234

üzenetére

Dragon3000

#234

üzenetére

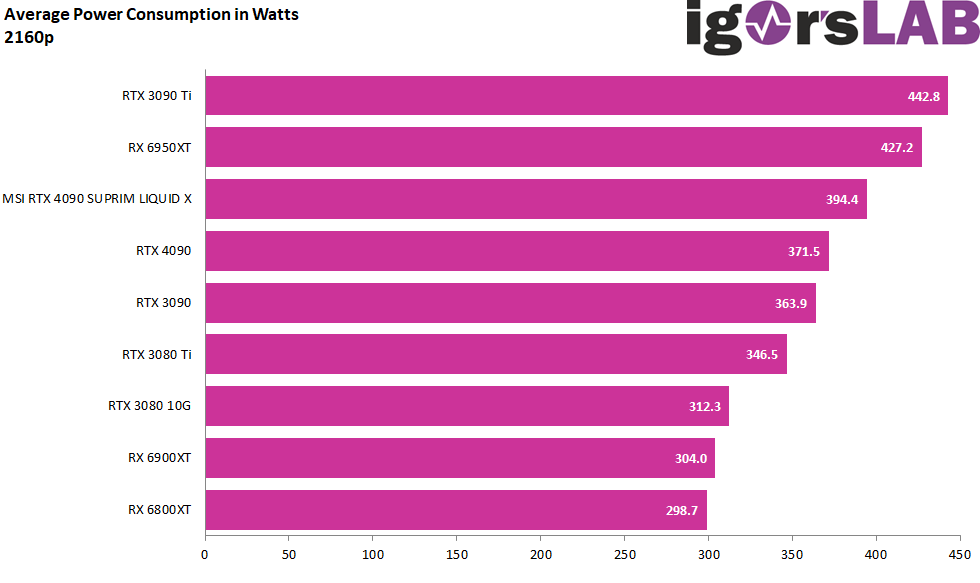

Ezekben a vitákban Igor bácsit szoktam alapul venni, ehhez nagyon ért:

Mindegyik MSI Suprim,de a 4090 folyadék.

[3090 Ti]

[4090]

[5090]Amúgy igen valószínűleg CPU limit miatt de közel 20 % eltérés van FHD és 4K között átlagos fogyasztásban3090 Ti nél és az 5090 esetében az 1 ms tüske közel 900W a 20 ms tűske pedig 640W

-

Busterftw

nagyúr

Én alátámasztottam mindent, te pedig semmit nem hoztál, csak hasraütéseket.

Lássuk a következő marhaságokat:"De szerinte ugyanannyit fogyaszt a kettő mert azt mondták a tesztbe"

Ilyet sehol nem írtam, visszaolvasható, csupán írtam, hogy nem csak az 5090 az egyedüli "600W-hoz közeli kártya", ezt teszttel alátámasztottam, te meg elkezdtél terelni.De egy egyszerű utánanézés is engem támaszt alá, ahogy a két forrás is, miszerint 4K-n a több terhelés miatt többet fogyaszt egy kártya.

Te semmit nem hoztál, csak terelést."Elég lenne csak megnéznie a HardverUnboxed/Guru3D ide vonatkozó tesztjét"

Linkelted fentebb a Guru3D tesztet, megkerestem a kép alapján, a teszt semmit nem mond el a metodikáról, se azt hogy milyen játékkal és milyen beállításokkal teszteltek. -

X2N

őstag

válasz

Dragon3000

#238

üzenetére

Dragon3000

#238

üzenetére

Az fedi is a valóságot.

3090Ti-Ki gondolta volna.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Azért az nvidia honlapján még a jó érték van feltüntetve. -

Dragon3000

nagyúr

Ha már ennyire belekötsz, akkor az nvidia tgp-t ad meg, amiben az egész vga fogyasztása benne van, minden hatásfoka, a vrm-é is, így az egész kártya fogyasztása 575W az fe megoldás esetében.

A techpowerup 3090ti fogyasztás esetében még egy furcsaság szerepel a táblázatokban, a maximum fogyasztása kisebb a kártyának, mint játékok esetében. -

X2N

őstag

válasz

Dragon3000

#236

üzenetére

Dragon3000

#236

üzenetére

Mert butítottak máson is, a monitorozó részen a 4090-nél a 3090Ti-hoz képest. Az 5090 meg még ennél is rosszabb, Buildzoid csinált róla videót már hónapok óta. A fogyasztás nőtt, nem csak a TDP, ne keverjük...

A TDP (Thermal Design Power) egy számítógépes hardvereknél (főleg CPU és GPU esetén) használt érték.

👉 Jelentése: az a maximális hőmennyiség (wattban megadva), amit az adott alkatrész tipikus maximális terhelésnél termel, és amit a hűtőrendszernek el kell tudnia vezetni.

🔹 Nem feltétlenül az aktuális fogyasztásAz amit fogyaszt a kártya több mint 600W, a VRM se 100% hatásfokú, ha 600W-ot fogyaszt a kártya, akkor ahhoz neked még hozzá kell adnod a többi elektronika meg a VRM plusz fogyasztását is. Nem elég csak a tápkábelen mérni, mert a PCIE slotból is kivesz 75W-ot.

3,3 V ágon: max. 3 A → ≈ 10 W

12 V ágon: max. 5,5 A → ≈ 66 W

➡️ Összesen: 75 W -

X2N

őstag

válasz

Dragon3000

#234

üzenetére

Dragon3000

#234

üzenetére

Érdekes módon a Guru3D-nél meg a Hardware Unboxed-nél sikerült lemérni hogy 450W a kártya fogyasztása játék alatt...

-

Dragon3000

nagyúr

válasz

Busterftw

#230

üzenetére

Busterftw

#230

üzenetére

Techpowerup esetében azaz érdekes, hogy a 4090 tesztnél még 445W volt a 3090ti fogyasztása (az oc-s megoldások tesztjében is a legtöbb 487W volt), ami kb 1 hónappal később a 4080 tesztnél már 537W lett, a konfig nem változott és a régebbi kártyák estében a driver sem, így elég érdekes, hogy ilyen drasztikusan megváltoztak a fogyasztási adatok a két teszt között. Ami még nagyon furcsa, hogy a 4090 mindkét tesztben ugyanazokkal az fps számokkal szerepel, de a fogyasztás mégis mindenhol különbözik, mindkét tesztben ugyanaz a driver is van feltüntetve.

-

X2N

őstag

Össze-vissza hazudozik.

A 3090Ti-on van 18 vrm fázis.

AZ 5090-en meg 23 fázis.

De szerinte ugyanannyit fogyaszt a kettő mert azt mondták a tesztbe, ahol hibásan vannak feltüntetve a 3090Ti fogyasztása, aztán kitalálta hogy 1440p-be kevesebbet fogyaszt a kártya mint 4K-n.Elég lenne csak megnéznie a HardverUnboxed/Guru3D ide vonatkozó tesztjét ahol fent vannak a helyes fogyasztási adatok. Több féle AIB kártyával, nem csak a FE változattal.

-

DudeHUN

senior tag

válasz

Busterftw

#230

üzenetére

Busterftw

#230

üzenetére

Amúgy ezt Nvidiával megbeszélhetnéd ha ugyan annyit fogyasztanak, akkor az egyik kártyához (3090Ti) miért 850W-os tápot javasol legalább és a másikhoz (5090) miért 1000W-os egységet. Már, ha jól dekódolom a vita elejét.

OC-n változik ofc a gyárihoz képest. Plusz az Nvidia 3000-res kártyákon évő táp megoldása más volt, mint a későbbi szériákon. -

Busterftw

nagyúr

-

xtremist

őstag

válasz

Pocoyo.hun

#214

üzenetére

Pocoyo.hun

#214

üzenetére

Röviden összefoglalva igen, ha akár csak felmerül a gyártó felelőssége egy ilyen esetben, azt kötelessége a gyártónak a biztosító közreműködésével kivizsgálni, adott esetben a keletkezett kárt megtéríteni, megtenni a szükséges lépeseket azért hogy ne ismétlődjön meg az esemény, és nem kibújni a felelősseg alól. Ha az osram gyártana egy olyan izzót amit be lehet rosszul csavarni és leég tőle a ház, szarrá perelnék 5 perc alatt, mert egy fogyasztói termékről van szó, és kutya kötelességük úgy megtervezni és legyártani hogy ilyen ne fordulhasson elő.

-

hobizoli

nagyúr

válasz

Pocoyo.hun

#214

üzenetére

Pocoyo.hun

#214

üzenetére

igen, kezdjek

ugy kell megcsinalni azert a penzert amit elkernek erte, hogy ne egjen leBMW-k is leegtek a EGR huto miatt, mert muanyagbol volt egy resze es a levalo izzo korom szemcse felgyujtotta vele az autot

ha alubol lett volna, akkor sosem gyullad ki

atom sokat sporolhattak ezen egy eleve 35-40k EUR-s autonal, nem?volt olyan nap horvatorszagban a tenger meno autopalyan, hogy egymastol par szaz meterre egett ki ketto ilyen is

ez mindig aaddig neme rdekes vkiknek, amig nem erintett ebben

ismerosnek is igy egett le az autoja, olyan hirtelen gyulladt ki, hogy eppencsak ki tudtak szedni a gyerekeket az gyerekulesbol meg kipakolni a csomagtartot a leallosavba, mar a szelvedonel egett a muszerfal

na?

fun fact: egy tgk-s sem allt meg hogy a kotelezo felszereles portoltojaval nekialljon oltani, amig tuzoltok nem ernek oda

ezek az autok reg nem garancialisak

Suzukinal, amikor utolag kiderult, hogy a kedves magyar beszallito elspurkodta vedogazt a lengescsillapito hegesztesenel es azert rohad el egy szeria tokugyanott, amitol kifordul a kerek es balesetveszelyes az auto, ingyen kicsereltek a 10-12 eves autokon is az elso ket telot boven gari ido utan is

pedig ezek nem tizen+ millios autok voltak ujonnan sem -

xtremist

őstag

A samsung galaxy note7-nél 35 dokumentált tűzeset miatt szántották be a tipust, 2,5millió eladott példány után.

-

xtremist

őstag

válasz

Pocoyo.hun

#214

üzenetére

Pocoyo.hun

#214

üzenetére

A mezőgazdasági gépek üzemeltetése a veszélyes üzem kategóriába tartozik, biztosítási jogi szempontból gyökeresen eltérő elbirálás alá esik mint egy háztartasi elektronikai eszköz által okozott kár. Ha az ebből adódó jogi problémákat el akarja kerülni a gyártó, akkor nem gyárt tűzveszélyes termékeket.

Emellett a közúti közlekedés IS veszélyes üzem, mégis kiemelt figyelemmel kísérik azokat az eseteket ahol felmerülhet a gyártói felelősség. -

Ribi

nagyúr

válasz

Pocoyo.hun

#214

üzenetére

Pocoyo.hun

#214

üzenetére

Szerinted autó visszahívások és miegymás miért van? Mert szarul terveztek meg valamit.

Ha 1 kombájn kigyullad még okés, de ha több, az már szériahiba és a gyártó problémája. -

Abu85

HÁZIGAZDA

Valószínűleg előfordulhat, hiszen számos példát láttunk a leégésre, ahol egy-két vezeték volt olvadt. De ez nem feltétlenül a konnektor miatt van, lehet, hogy jobban meg lett hajtogatva a kábel a konnektor mögött.

A kábellevágás arra hivatott magyarázatot adni, hogy maga a leégés miért következik be. A hardveren nincs semmi, ami ezeket a nem kívánt szituációkat megfogná, így engedi elégni a konnektort.

-

Busterftw

nagyúr

-

Busterftw

nagyúr

"Elég megnézni a szétégett csatlakozókat. Mi más bizonyíték kell?"

Ez nem bizonyít semmit, mert nem ismered a többi faktort.

Főleg nem azt az állításod, hogy közel 600W fogyasztás miatt olvadt meg."Gondolom ki tudod számolni hogy 6 vezetéken keresztül"

Igen ki tudom, nem kellene szarul bedugni. Meg nem kellene ilyen olyan 3rd party kábeleket és átalakítókat használni, ugye ezt sem tudod kinél melyik volt. Ezekből (Corsair) volt is visszahívás.Tehát nem azért égnek a csatlakozók mert 600W közeli a fogyasztás, ahogy te azt behaluztad fentebb, mert akkor a 4080-4090 sem olvadt volna.

"Hol vannak a te méréseid az 5080-al?"

Irrelvans, ahhoz nem kell neked kocsit venni, hogy tudd mennyit fogyaszt 100-on, mert már bizonyított dolog.

4K monitorom csak 4k60Hz tv van, nem lenne ugyanaz, magasabb Hz-es lenne fair."Teszteket én is tudok linkelni."

Én hoztam két különböző forrást, te semmit. Egy guru3d tesztet hoztál, ahol 1 felbontásban és nem tudni melyik játékkal tesztelnek."A sok memória(32GB) nem azért van egy 5090-esen hogy mozgassuk feleslegesen az adatokat. "

Teljesen mindegy mert nem erről van szó, 4K-n több terhelést kap és többet fogyaszt.

Ha az lenne amiről te beszélsz, akkor fix hőmérsékleten futna mindig, fix feszültségen, de terheléstől függően ez változik, ami 4K-n több." Csak viszonyításképpen, 3db 8 pines csatlakozóval"

Újabb logikai öngól, a 8pinesről is vanak példák ahol megolvadtak. Tehát akkor te nem fogsz semmit venni a jövőben. -

Ribi

nagyúr

Hát a régi kártyáknál pont ez volt a baj, hogy nem a bemeneten mérték az áramot és még a kártya is kisebb fogyasztást reportál vissza mint a valós. Szerintem ott nem mérnek, csak szűrnek. Igor is csinált erről videót, hogy amd kártyák 10-20%al többet esznek mint amit visszajeleznek. AMD karik nem TBP-t mértek, csak TGP-t.

-

hobizoli

nagyúr

válasz

Pocoyo.hun

#198

üzenetére

Pocoyo.hun

#198

üzenetére

BEV-bol is pont eleg ha csak 1-2 eg le barmiert

csak szar ugy amikor a te garazsodban gyullad ki toltes kozben es fabol van az epulet... -

X2N

őstag

Sajnos nincs, de engem is érdekelne én is kerestem neten, mivel nincsenek söntellenálások, így vagy a vrm-ből nyerik ki a fogyasztás adatokat, ami nem a teljes kártyára vonatkozik, az meg kevés, szerintem valahogy a tekercsen átfolyó áramot is mérik. Kapcsolási rajz kellene, akkor látnánk melyik ic mit monitoroz pontosan. Vagy csak kitalálnak valamit.

![;]](//cdn.rios.hu/dl/s/v1.gif) AMD-nek ez a része mindig is gyengébb volt mint a régi nvidia kártyáké, az új nvidia kártyák(50xx)-meg már ennél is rosszabbak.

AMD-nek ez a része mindig is gyengébb volt mint a régi nvidia kártyáké, az új nvidia kártyák(50xx)-meg már ennél is rosszabbak. -

hobizoli

nagyúr

az keletkezo hőt a hutobordazat vezeti el, nem a NYAK panel

ha vedelem fika, az gyartora nezve ciki

siman lehetne ott egy thermisztor, pont erre valo

mondom, Pentium-4 CPU 25 eve lazan leszabalyzott, ha leesett rola a huto es csutkan boven 100W felett zabalt az is...es nem kerult tobb ezer USD-be

azota mit nem lehetne annal sokkal jobban IS megcsinalni?

kajakra, mintha visszafejlodnenk csak az idovel

a regi PCIE megoldas 4x ezt lazan elbirna

vagy ha abbol is ramenne ketto, az lefelezne a 12VHPWR csatin atfolyo teljeitmenyt meg az aramot

na?

a NYAK-n meg odavezetik a VRM-hez azt is, par vastagabb rez sinnel, ami be van forrasztva

----------

CPU is, amikor 1.2V Vcore es 200+ W-t harap, akkor ott mennyi Amper is folyik?

na pont ezert is van a CPU-nak 1700 laba is akar, mert annak egy joresze csak tapfesz meg a test

pont azert, hogy legyen eleg vezeto keresztmetszet

Új hozzászólás Aktív témák

- Samsung Galaxy S25 - végre van kicsi!

- Kerékpárosok, bringások ide!

- The Crew sorozat

- Milyen okostelefont vegyek?

- Xiaomi 13T és 13T Pro - nincs tétlenkedés

- Megérkeztek a Xiaomi 15T sorozatának telefonjai Magyarországra

- Motorola Edge 50 Neo - az egyensúly gyengesége

- Telekom otthoni szolgáltatások (TV, internet, telefon)

- Windows 11

- Logitech szerviz

- További aktív témák...

- Xiaomi Mi 11T Pro 5G // 256GB // Számla + Garancia //

- Azonnali készpénzes Intel i3 i5 i7 i9 12/13/14 gen processzor felvásárlás személyesen / csomagküldés

- GYÖNYÖRŰ iPhone 13 mini 128GB Midnight -1 ÉV GARANCIA - Kártyafüggetlen, MS3447, 94% Akkumulátor

- Kezdő Gamer PC-Számítógép! Csere-Beszámítás! I5 7500 / GTX 1050Ti / 16GB DDR4 / 128SSD+1TB HDD

- LG 27CN650N-6A - Felhő Monitor - 1920x1080 FHD - 75Hz 5ms - USB Type-C - Quad Core - BT + WiFi

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) :

: