Új hozzászólás Aktív témák

-

janos666

nagyúr

Feature-ök vehetőek át (mint ahogy már meg is történt, pl. Turing VGA-kkal és XBox One konzolokkal van VRR, ALLM, stb, utóbbit pár TV gyártó is átvette 2.0 sávszélű portokra), de 48G sávszél nagyon valószínűtlen (nincs is rá példa). Szerintem célszerűbb lett volna HDMI 3.0-nak nevezni a 2.1-et, mert most először nem csak a TMDS órajel nő (akkor talán lehet most játszani, "overclock" jelleggel kicsit többet kisajtolni a 2.0-ás forráseszközökből), hanem változik az átviteli séma DP 1.x szerűre (a DP pedig most vált majd át ThunderBolt szerűre a 2.0-ás verzióval

).

). -

MeszesKPT

őstag

válasz

janos666

#113

üzenetére

janos666

#113

üzenetére

Értem, köszi.

Nagyon remélem, hogy az Ampere-re már végre 2.1-es HDMI kerül, hogy mehessen a 2160p 60+ Hz gond nélkül. Akik régebbi játékokkal játszanak, azoknak nagyon jól jönne. Én például elsősorban szimulátorozok és eddig is meg volt a teljesítmény, de mégsem tudtam kihasználni. Na majd 2020-ban talán végre minden adott lesz.

-

janos666

nagyúr

válasz

Alogonomus

#116

üzenetére

Alogonomus

#116

üzenetére

Mindkét oldalon vannak különböző TDP-re konfigurált kártyák és olyanok is, amiken tág keretek közt állítgatható a gyári alapértéktől fel és le is. Viszont...

-

Alogonomus

őstag

Azért a zöld szemüveget levéve nézzél kicsit szét az RX 580 fogyasztását illetően, és máris nem csak a 180+ wattos modelleket fogod észrevenni. Nekem például 150 wattos Aorus kártyám van, de a 140 wattot is csak szökőévenként éri el, miközben csendesen hozza a FullHD játékélményt. 1435 MHz-re felengedve kezd csak hangosabb lenni.

-

ÁdiBá

veterán

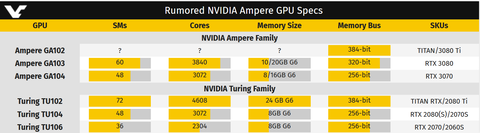

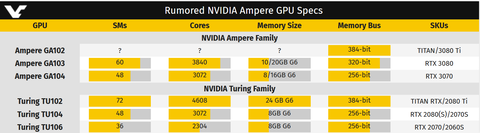

Nem hiszem, szerintem egyiksem lesz HBM2 es, kizárolag a GA100-as.

GA100 8GPC*8TPC*2SM 6144bit ?GB?

GA102 7GPC*6TPC*2SM 384bit ?GB? valósznű - 12GB / 24GB

GA103 6GPC*5TPC*2SM 320bit 10GB/20GB

GA104 6GPC*4TPC*2SM 256bit ?GB?

GA106 3GPC*5TPC*2SM 192bit ?GB?

GA107 2GPC*5TPC*2SM 128bit ?GB? -

janos666

nagyúr

válasz

MeszesKPT

#112

üzenetére

MeszesKPT

#112

üzenetére

Igen, bár nem sok értelmét látom.

Az 1440p ránézésre jobban hasonlít a 2160p képre, mint az 1080p-re. Nyilván nem olyan éles hatású, és persze több aliasing marad a képen (szerintem ez ma a 4k igazi előnye, hogy nem kell rá SSAA, miután az MSAA már 10 éve kihalt, még sincs helyette normális új megoldás), de szerintem abszolút élvezhető. Cserébe elbírja egy megfizethetőbb VGA kártya is akár 100+ fps-el, és -6ms lag is, ha 60 helyett 120Hz-el van hajtva a TV, na meg a mozgóképfelbontás is sokkal jobb magasabb fps és Hz mellett. (Kár, hogy nem lehet tesztelni az 1080p240-et úgy, mint a 2017-es TV-ken az 1080p120-at, ahol kikapcsolt a színkezelés, hogy elbírja a SoC, bár nem érné meg úgy használni). -

janos666

nagyúr

válasz

janos666

#110

üzenetére

janos666

#110

üzenetére

Na, egy "pixel clock patcher", és megy a passzív adapteren át a 2160p60 és 1440p120 is. Bezs@r@s, kiderül, hogy teljesen feleslegesen cseréltem le a GTX1070-et RTX2060, pár hetet hetet kellett volna csak várnom erre a driver-re, hogy működjön HDMI helyett DP portról a HDMI VRR az 1$-os adapterrel.

-

janos666

nagyúr

válasz

janos666

#109

üzenetére

janos666

#109

üzenetére

Erről most eszembe jutott, és puszta érdekességből kipróbáltam újra, hogy vajon működik-e már a legújabb beta driver-el (450.12) a G-Sync, ha egy passzív DisplayPort -> HDMI adaptert használok a VGA és a TV közt (~1$ kínai kacat). Régebben ilyenkor teljesen eltűnt a G-Sync tab az NVCP-ből, de most elérhető maradt és tényleg működik is!

Most már csak egy olyan passzív adapter kéne, ami elbírja a DP port maximális sávszélességét, és akkor elvileg akár mehetne is a 2160p120 RGB.![;]](//cdn.rios.hu/dl/s/v1.gif)

(Kár, hogy tudtomal nem létezik ilyen, ami adapterként is árulnak, még HDMI 2.0 sávszélhez sem, nem hogy a fölé, 2.0-hoz is csak alaplapra integráltról tudok...)Nem tudom, hogy ez vajon annak az előszele-e, hogy az Ampere-n nem lesz natív HDMI 2.1, hanem kap egy PCB-re integrált passzív DP->HDMI konvertert, hogy legyen DP 1.4 sávszél a HDMI 2.0 porton "tuning" jelleggel.

De ami most jobban érdekelne ezzel kapcsolatban, hogy a Pascal kártyákon mi történik ilyenkor (mert azzal érvelt az nVidia, hogy a Pascal HDMI része nem elég jó a HDMI 2.1 VRR-hoz, nem csak anyagi/marketing okokból korlátozza ez Turing-ra, de ez az érv teljesen elvész, ha DisplayPort-ot használunk).

-

janos666

nagyúr

Szabvány HDMI 2.1 VVR implementáció, ami bármely, a DP 1.xa VESA A-Sync implementációhoz hasonlóan a nem hitelesített készülékhez is bekapcsolható kézileg, de azon túl a konkrét TV (jelen esetben LG 55 C9) kapott G-Sync Compatible hitelesítést is, benne van az nVidia listájában.

Ez a gyakorlatban is úgy nézett ki, hogy majdnem egyszerre jelent meg a kérdéses nVidia driver és a hozzá tartozó firmware US modellekre. Ekkor kézileg be tudtam kapcsolni NVCP-ben a G-Sync-et a még nem frissített EU TV-hez is (ugyan úgy, mint egy nem hitelesített DisplayPort-os monitor esetén is teheti a felhasználó), majd némi késéssel az EU-s TV modellek is megkapták az új firmware-t, és azóta automatikusan is bekapcsol már a G-Sync (nem emiatt, de kipróbáltam már, hogy "clean install" után bőszen felugrott az értesítés róla, hogy a driver "gratulál" a G-Sync kijelzőhöz, automatikusan bekapcsolta nekem), de a villódzás maradt.

Egyébként nem katasztrófa, egy átlag felhasználónak talán fel sem tűnik, mert ritkán és nem erősen villan.

-

janos666

nagyúr

válasz

MeszesKPT

#106

üzenetére

MeszesKPT

#106

üzenetére

A tartomány minden felbontásban 40-120, de még csak 1440p120-ban lehet használni, a 2160p120-at (ami 8bit YCC 4:2:0-al beférne a 2.0 sávszélbe) nem kajálja a TV. Viszont a frametime tüskéknél felvillan kicsit a kép (kicsit fényesebb a képkocka, mint kéne), nem tudom, hogy ez nVidia vagy LG hiba. Gondolom utóbbi, de passz, hogy javítják-e firmware-el, és nem egészen értem hogy kapott így "G-Sync Compatible" matricát (tudom, hogy ennek a hitelesítési szintnek sokkal lazább a követelményrendszere, de azt hittem ebbe is beletartozik valami alapvető képminőség teszt).

-

janos666

nagyúr

Decemberben nézegettem teszteket, mikor a HDMI 2.1 VRR miatt "valami Turing"-ra kellett cserélnem a 1070-et, és akkor azt láttam, hogy kb. a 1660Ti lenne vele egálban, picivel alatta a 1660S, vagy kicsit felette a 2060. De játéktól is függ: úgy tűnt, hogy az újabbak jobban fekszenek a Turing-nak, így hozza be átlagban a 1660Ti a 1070-et (régi játékban elmarad, újabban viszont mellé, némelyikben pedig fölé is lép), a 1660S pedig csak új játékokban van közel egálban (régiekben egyértelműen lemarad).

-

-

válasz

egyedülülő

#94

üzenetére

egyedülülő

#94

üzenetére

pedig azt hoznia kellene 350 dollárért( ha annyi lesz mint ahogy mondják, hogy nem változik az ár az alsó szegmensben a felsőben pedig csökken valamelyest) ha versenyképes akar lenni a 400 dolláros 5700 XT vel.

Pascalnál már volt erre példa. -

egyedülülő

őstag

Ezt a 3060 hozza a 2080 szintet enyhe túlzásnak érzem.

-

szerintem nem szabad nagyon sokat várni,ha valóban nem lesz áramemelés ahogy pletykálnak róla. egészséges 30-35 % -t érdemes várni RT ben pedig ennél jóval több gyorsulást remélek.

Bizakodásra ad okot, hogy a Turinggal ellentétben újra xx4 GPu-t kap a 3070, mint a Pascal esetében, azaz azt amit most a 2080 kapott így a 3060 képes lehet egy 2080 sebességére.Már persze ha a pletykák igazak.

Videocardz. -

BeZol

őstag

Én is ebben reménykedek, pont pár napja számolgattam haverommal, hogy nyers feldolgozóegységek alapján +20%-ot mindenképp tud a 3070-es egy 2070 Super-hez képest (nem a sima 2070-hez képest!). Ehhez jön még, hogy jobb órajelek várhatóak.

Anno 980Ti és 1070 viszonylatban (28nm vs 16nm) a memória GDDR5 maradt (GDDR5X-et 1080 és felette kaptak, 1070Ti GDDR5 maradt), csak 1750MHz helyett 2000MHz (+14%), a CUDA magok száma 2816-ról 1920-ra csökkent (+46% gtx 980Ti-nek), és az alap gpu clock 1000MHz-ről 1500 fölé ment (+50%), közben a turbó is pöttyet jobb lett persze, fogyasztás is csökkent, ÉS egyforma erősek lettek! Tehát hiába csökkent a feldolgozóegységek száma, ezt órajellel ellensúlyozni tudták.Most jönnek a kérdések, hogy vajon GDDR6-ban mennyi tartalék lehet órajelnövelésre (talán semennyi

), de ha szimplán azt nézzük, 28nm-ről 16nm-re ugrásnál (57,14%-osra kicsinyítés) tudtak kb. +50% órajeltöbbletet adni a gpu-nak, akkor 12nm-ről 7nm-re ugrásnál (58,33%-osra kicsinyítés, tehát majdnem ugyanakkora előrelépés!) is képesek lehetnek erre, hiszen minden egyes nm-beli ugrásnál magasabb órajeleket kaptunk kisebb fogyasztással párosítva (980Ti 250W, 1070 160W, ami egyben kb. a kicsinyítés mértéke úgy, hogy h a kevesebb nyers erőt +50% órajellel megpakolták és kb. egyforma a két kártya).

), de ha szimplán azt nézzük, 28nm-ről 16nm-re ugrásnál (57,14%-osra kicsinyítés) tudtak kb. +50% órajeltöbbletet adni a gpu-nak, akkor 12nm-ről 7nm-re ugrásnál (58,33%-osra kicsinyítés, tehát majdnem ugyanakkora előrelépés!) is képesek lehetnek erre, hiszen minden egyes nm-beli ugrásnál magasabb órajeleket kaptunk kisebb fogyasztással párosítva (980Ti 250W, 1070 160W, ami egyben kb. a kicsinyítés mértéke úgy, hogy h a kevesebb nyers erőt +50% órajellel megpakolták és kb. egyforma a két kártya).Tehát a kicsinyítés mértéke közel azonos lesz a gyártástechnológiának köszönhetően, csak 28nm -> 16nm helyett 12nm -> 7nm.

Azt már tudjuk, hogy 2070 Super-hez képest +20% nyers erő biztosan lesz a 3070-esben (legalábbis pletykák alapján).

Ha 980Ti kontra 1070 horderejű váltás lenne, akkor az RTX 2070 Super 2560 CUDA magja = 1742 CUDA magú 3xxx szériájú kártyáéval +50%-os órajel mellett (210W helyett 140W-tal), ergo az RTX 2070 Super utódja 1742 CUDA magos 3xxx lehet +50% gpu clock-cal (1605MHz-es Base Clock-ról 2400MHz-es Base Clock, és ezekre jön a turbó érték), ami így leírva a "hihetetlen" kategória, de gtx 9xx széria 1000-1100MHz-es base clockjai után az 1070-es 1500 feletti értéke is annak tűnhetett!

Az RTX 3070 pletykált 3072 CUDA magja az RTX 2070 Super erejének megfelelőjű 3xxx szériás 1742-höz képest +76%.A nagy kérdés, hogy az órajeleket mennyire tudják feltornászni. Nyers erő alapján +20% a minimum előrelépés 2070 super -> 3070 viszonylatban, a fentebbi kalkuláció alapján pedig +76% is lehetséges. A végeredmény valahol a kettő közé várható.

Techpowerup-os összesítések alapján a founders edition-ös 2080 Ti a founders edition-ös 2070 Super-re 1080p-ben 24%-ot, 1440p-ben 31%-ot, 4k-ban 37%-ot ver.

HA csak 20%-kal lenne erősebb a 3070-es, akkor 2080 Super környékén tanyázna a teljesítménye, HA viszont 76%-kal lesz erősebb, akkor 2080Ti-t is kenterbe veri.

HA abból indulunk ki, hogy anno a 980Ti teljesítményét hozta az 1070-es, akkor legalább 24-37%-kal kéne erősebbnek lennie a 3070-esnek a 2070 Super-nél.A kérdés az, hogy mennyire tudják és akarják kiaknázni a gyártástechnológia nyújtotta lehetőségeket, mert piacra dobhatnak "csupán" RTX 2080 Ti erejű kártyát is 270W körüli fogyasztás helyett 180W-tal, 2/3 annyi feldolgozóegységgel és 50%-kal gyorsabb base clockkal.

Az RTX 3080-as specifikációi alapján, hogy 3840 CUDA magja lesz, ott pedig a 2070 Super-hez képest akár 2,2-szeres teljesítménybeli ugrás is lehetséges.

Ez 1440p értékek alapján

RTX 2070 Super: 100fps

RTX 2080 Ti: 131fps

RTX 3070: 176fps

RTX 3080: 220fpsA pletykák alapján "According to Taipei Times, the new GPU based on the Ampere architecture would use 7-nanometer chips, which would boost performance by 50% and halve power consumption" nem fognak 76%-ot gyorsulni, hanem csak 50%-ot, DE a 3070-esben +20% CUDA mag lehet, ergo már majdnem meg is van a 76%

Lesz itt gyorsulás kérem szépen , csak ne legyen az, hogy megint drágul minden és 600ezer Ft lesz egy 3080 Ti...

, csak ne legyen az, hogy megint drágul minden és 600ezer Ft lesz egy 3080 Ti... -

nuke7

veterán

hát, a 0.1% nem érzed semmennyire, én legalábbis biztos nem...

az 1%-ok meg elég közel vannak egymáshoz a linkelt videóban... szóval lehet magyarázni bizonyítványt, de nem véletlenül van most az intel lépés kényszerben

Én witcher 3-al sokat játszom, direkt visszatekertem a videót, nem látom egyszerűen azt a 0.1% "mikro-lag"-ot..

Szerintem az AMD + nvidia a nyerő páros

-

BeZol

őstag

Tetszenek az 1% és 0.1% Low értékek... Néhol 1/3 annyi, mint Intelnél. Ez pont az, hogy be-beakad a játék érzésre, mert olyan kevés fps-re ugrik le. EZ PONT AZ, AMIT MINDENKI UTÁL! Vesz egy drága gépet, és be-beakad neki a játék, szánalmas. Aláírom, sok játékban rendben van a dolog, DE ha TE épp azzal játszol rendszeresen, aminél ezt produkálja?! Vagy kijön egy új játék amivel tolni akarod és épp nincs normálisan optimalizálva AMD-re és hasonló mikrolaggokat érzel, akkor kb. felgyújtanád a gépedet... EZ ÍGY LUTRI!

Tudom, hogy nincsenek egy árban a procik (bár cserébe alaplapoknál amd drágább), de INKÁBB költenék egy olyan gépre többet, aminél nincsen mikrolagg/stuttering ÉS minden játékban hozza ezeket a jó értékeket, minthogy majd xy játéknál ami épp érdekel szívjam a fogamat... És ez nem csak AMD processzorokra igaz, hanem AMD videókártyákra is. Elég olvasni a navi-s topikot, mennyi driver probléma van a kártyákkal MÉG MINDIG! (szeptember óta!!!) Szóval ha valaki a nyers benchmarkokat nézegeti és mellé az árakat, akkor AMD-t vesz, viszont kicsit a dolgok mélyére ásva már problémás az egész.Nekem volt AMD videókártyám még anno 4870+4890 hibrid crossfire-ben. CS:Source alatt nuke-on fényproblémák voltak (sose javították ki), Battlefield Bad Company 2 béta még tökéletesen ment, mikor kijött a végleges játék, már nem ment a crossfire. 1,5!!!! évvel később jött egy driver, amivel működött, de a rákövetkező driverrel már nem ment! Jött ki később másik játék ami miatt kellett az újabb driver, és nem tudtál egyszerre a két játékkal játszani, mert más vga driverrel mentek rendesen a kártyák... Az új 5xxx széria topikjába beleolvasgatva pontosan ugyanezek a problémák vannak most is, csak már crossfire nélkül 1 kártyával... A legjobban azon röhögtem, mikor vki nem tudott LoL-ozni, mert a launcher crashelt a vga driver miatt

, érdemes végigolvasni a problémákat, kinek épp mi jön elő, BOTRÁNY!

, érdemes végigolvasni a problémákat, kinek épp mi jön elő, BOTRÁNY!Volt Ryzen 7 1700X-em is, ami mint már tudjuk nem egy fényes széria (de akkoriban a benchmarkok kb. nem ezt mutatták, az tegyük hozzá!), az is botrányos volt több játékban, mert az átlag fps is pocsék volt sok helyütt. Konkrét példa nekem a World of Warcraft (amit csak több millióan tolnak napi szinten, régi játék, és nem egy új AAA cím ami jobb esetben 3 hétig van nyüstölve és megy a levesbe). Gondoltam 8mag16szál, tökéletes lesz x264 alapú streamelésre a proci, a probléma csak az volt, hogy míg questelgetéskor és 5fős instákban tulajdonképpen rendben volt az fps (talán 75 alá nem ment és 100-120 körül voltam), addig raideken 20fővel (mythic raid) ÁTLAG 38fps-em volt!!! Ki kellett kapcsolnom az SMT-t, hogy 8/8 legyen, fel kellett pöckölnöm 3.85GHz-re (3.9ghz-en már eldobta magát), és így 55 körüli fps-re tudtam feltornászni, akkora CPU limitem volt (mert inkább 1-2szálat használt csak a játék), mindezt 1080Ti-vel! Aztán így már gondoltam mehet a streamelés, igazából 3.7ghz-en is eldobta magát a gép x264 kódolással olyan 2 óra játék után, és az fps is botrányos volt már így is, úgyhogy hagytam a fenébe. Az új 3xxx széria már aláírom egész jó lett, de az igazi konkurencia (játékok szempontjából) a 4xxx széria érkezésével érkezhet meg az Intellel szemben, mert akkor az IPC + órajelnövekedés + javított memóriakezelés következtében pariban kellene lenniük, már csak a minimum fps-ek lehetnek problémásak. Ha még ott is pocsék lesz, akkor játékra továbbra is felejtős, mert visszatérve, mi van ha épp abban a játékban szerencsétlenkedik a proci, amivel rendszeresen játszanék?

BF V-nél bejön a single player benchmark... Gondolom te sem nyomod neten 64 fővel. Ezeket a beépített benchmarkokat lehet nézegetni meg postolgatni az eredményeit, de hogy a játékban töltött idő 99%-ában nem single playerben fognak az emberek ilyen és ehhez haosnló játékokat nyomni, az is biztos. Itt egy régebbi BF V ryzenes teszt 1080p-ben, ahol pl. látni érdemes, h ez a 2xxx-es ryzen képtelen volt 130as átlagfps-nél többre, ergo már egy RTX 2070-essel "kimaxoltad" a játékot (minimum fps alapján látni, h 5% körül még abban is hagyott!), kár volt RTX 2080 v. 2080Ti-t vásárolni, mert képtelen volt kihajtani. De ez csak egy BF V, ami köztudottan jól optimalizált játék, és már van 3xxx ryzen és fél éven belül itt a 4xxx, viszont minden egyes játéknál utána kell nézni, hogy mit alakít az adott processzor xy videókártyával "VALÓS" játékkörülmények között!

Nekem pl. a WoW fontos, és ott nem minden virít úgy, ahogy kéne, még az olcsó 8700K sem (4.2ghz-es proci, 40% körül kihajtott RTX 2060 és 40 fps körüli érték... és ez még nem a raid része a dolgoknak, AHOL KRITIKUS h akad-e a játék vagy sem)!

PUBG sem fenékig tejfel: Ryzen 1080p-ben 2080Ti-vel (tudom túlzás, nem átlagos kártya) csak 60-70%-on hajtja ki a videókártyát, az Intel pedig 85%+, és 120 helyett 180 fps-ek vannak...A lényeg, h vásárlás előtt tájékozódni kell, h xy játékkal van-e probléma vagy sem. Aki nem akar tájékozódni, az vegyen Intelt és Nvidiát, mert ott minden úgy megy, ahogy mennie kell. Azóta nincs driver problémám, random beakadozgatás, semmi idegeskedés, minden úgy működik ahogy működnie kell, és ennek így kéne lennie AMD-nél is, de "még" nem sikerült nekik.

Mindenkinek tájokozódnia kell, hogy a saját felhasználásához mi a jó vétel, és nem szabad minden benchmarknak hinni!!! És igen, lesz amihez AMD-t érdemesebb vásárolni, és lesz amihez Intelt, DE be kell látni, hogy annak ellenére, hogy papíron azonos v. jobb teljesítményt olcsóbban kínál az AMD, annak bizony van árnyoldala is, ahogy fentebb is leírtam pár példát, de aki meg munkára használja, ott megint programonként változhat, hogy most melyik gyártó a nyerő választás.

-

egyedülülő

őstag

Izgalmas dolgok ezek. A 2070-emet szeretném váltani akár Superre vagy sima 2080-ra. Nem tudom milyen árban lesznek ezek az új kártyák, megéri e várni.

-

MeszesKPT

őstag

A cloud gaming már 10 éve hype szinten van és még vagy addig az is marad, semmi több. Google-nek sem sikerült megugrani a lécet, érdemes olvasni a felhasználói számokról.

Amperet illetően szerintem aki eleve nem a mostani középkategóriában nézelődik, annak érdemes most már kivárni.

-

Prof

addikt

válasz

Televan74

#70

üzenetére

Televan74

#70

üzenetére

Megneznek vmi frame per frame osszehasonlitast AMD-n es NV-n adott grafikai beallitasok mellett szerintem valami susmus van, nem azonos dolgok futnak le egyik ill. masik kartyan.

Nagyon sok fpst lehet nyerni szinte lathatatlan grafikai reszletesseg butitasokkal, amit mondjuk a Geforce driver szinten megcsinal ha detektalj a jatekot.

Amikor jonnek az Intel igp ilyen megy olyan gyros mar az AMD APUval szemben ott altalaban rosszabb a grafika az intelen nem csoda, hogy gyorsult... -

Prof

addikt

válasz

#00137984

#80

üzenetére

#00137984

#80

üzenetére

Azert vard ki az uj 7nm-es Nvidiat/ illetve Nagy Navit. Valoszinu atrendezi az ar/ertek feature kategoriakat.

Amig jelenlegi konzolgenre tervezik jatekokat, sokat ne varj olyan 2-3 ev mig kovetkezo konzolgenre, illetve Stadia/egyeb cloud streamszerverre (5g elterjedesere idozitik) tervezett jatekok jonnek. Hiaba csinalt MS "szuper eros" Xbox One X konzolt ott malmoznak es alig van ra jatek ami kihasznalja, mert nem az az elterjedt etalon mainstream konzol.

Szerintem az Intel is akar 2-3 ev mulva ertekelheto cloud szerverbe rakhato gpukat gyartani, akar multigpu tamogatassal.

2020 a hype eve, igazi valtozasokat kb. 2022-23 fog hozni, ha minden terv szerint megy. -

Prof

addikt

Sajnos a jelenelgi 2060 learazas nekem azt sejteti nem akarnak ezek egyhamar 3060at kiadni, csak a 3070,3080 fog jonni. Valoszinu sokkal jobb raytracing miatt nem akarnak a 2070/2080-nak konkurrenciat egy dragabban 7nm-en gyartott kartyaval ha AMD nem kenyszeriti oket.

En ugy latom az NVidia ul a piros gomb elott amin az van gyartas indit 7nm-en, azonnal megnyomjak ha kijon megbizhato info a Nagy Navirol (felteve ha versenytars a highend szinten nekik). Addig is gyujtik a zsetont az olcson 12nmen gyartott kartyakkal es soprik a keszletet. -

#00137984

törölt tag

Csak halványan megjegyezném, hogy minden más CPU-t mellőző témát elemző cikkben (Nvidia videókártya) a Ryzen procikról olvasni nekem már nagyon unalmas és alkalmasint átugrom ezeken... Nem igazán érdekel.

-

#00137984

törölt tag

Megint Nvidia videókártyára leszek kénytelen váltani, de remélem a GTX 1070 Ti még évekig állja majd a sarat. Amig a játékok fejlődése nem olyan látványos, miközben a játékélmény alig változott, és még ez a Ray Tracing sem érdekel...

-

"Pont valamelyik nap néztem a GTX 1660 jelenleg olyan gyors mint egy GTX 980TI. Szerintem az elég jónak számit"

Ez kb. mindig is így volt. Az aktuális széria tagja mindig olyan teljesítményű, mint előző generációban az egyel nagyobb számozású.GTX 980 = 1070 = 1660Ti

GTX 780 = 970 = 1060

GTX 770 = 960 = 1050Ti, stb. -

carl18

addikt

Ha a RTX 3060 tudja a RTX 2080 szintjét már nagyon jó kártya lesz. 8 gig a ramot tuti megkapja...+ Főként az árazás lesz a lényeg.

Pont valamelyik nap néztem a GTX 1660 jelenleg olyan gyors mint egy GTX 980TI. Szerintem az elég jónak számit

-

X Factor

addikt

Ha a 8/16 helyett tényleg 10/20-as felállásban is lesznek elérhető kártyák, akkor a renderfarmok nem csekély mennyiségű 1080-at és 1080ti-t boritanak a használt piacra

-

Prof

addikt

válasz

antikomcsi

#21

üzenetére

antikomcsi

#21

üzenetére

Jatekok latvanyvilagat mindig a mainstream olcso gepek teljesitmenye szabja meg, es az utobbi evekben mar nagyon regen a konzoloke. Ha jonnek erosebb konzolok akkor par eve mulva lesz pozitiv valtozas es nem csak az fps/felbontas hajhaszas megy majd.

Kb. 80% Pc jatek konzolport, sot lassan mar rengeteg mobilport.

Ennek ellenere veszik a hulladek Rdr2-t, igy is sok evvel a konzol megjelenes utan. Ami amd hardverre tervezett jatek ellenere pcn rosszabbul megy amd-n, mint nvidian vmi csoda folytan.. -

Puma K

nagyúr

válasz

Black-core

#64

üzenetére

Black-core

#64

üzenetére

Milyen VGA kártyád van?

-

sb

veterán

Igen, kicsit el van tévedve a kolléga.

CB single-ben R20-ban konkrétan gyorsabb a 3900X 4.6-os max boosttal mint a 9900K 5GHz-en. CB15-ben meg 1-2% a lemaradása.Szóval nem előny az 5GHz, jobb az IPC a másik oldalon és így kisebb órajelen lassan fele annyi fogyasztásból hozza a csúcsot is. Az optimumot 3-4GHz között (rohadt sok magnál) meg még nagyobb perf/W aránnyal hozza.

Ezen kívül érdemes még megnézni a multitasking teszteket is, Compterbase-en mérték, ott is gyorsabb volt az AMD két feladattal, azonos magszámmal, mint az Intel. Nem nagyon van már olyan terület ahol nemhogy kikapnának, de egál helyett ne húznának el.

A játék optimalizáltság még igaz. 200fps felett meg 3-5%-nyi előnyre ott még lehet "verni".

-

Ragnar_

addikt

"De leszarom.

Hasznalj amd-t.

Csak ne terits.

Nekem volt anno 6 egymas utan.

Azert olcso mert szar..."Melyik piacvezető Intel is felezte a teljes HEDT termékpalettája árát , mert az AMD asztali teteje 3900x verte a teljes Intel HEDT felhozatalt ? Ott ahol nem a 4-6 magig skálázódó konzolport játékok vannak, hanem olyan szoftverek amik kihasználják a korszerűbb gyártástechnológiát ?

"Tele a youtube 9900kf vs ryzen 3800x osszehasonlitokkal.

A battlefiled 1-ben 50+ fpst vert a ryzenre. Pedig jo sok szalat kepes hasznalni a frostbyte.

A cinebench amit mutogatni lehet csak."Első video Youtubeon 9900k oc vs 3800x BF1 188vs184 FPS.. RTX 2080OC-val Ultrán. Oke én értem, hogy ott a 2080Ti is, de már a 2080OC is 250k egy Ti pedig már 400.

És nagyságrendileg ugyanez a helyzet a többi játékban is. Mindez biztonsági rések nélkül olcsóbban. De nem akarlak semmire rábeszélni, ha Intel fan lennék lehet, hogy én is inkább sima 6 magos i5-öt vennék HT-s 6/12-s R5 helyett 65k-ért. (Ami meg ugye olyan, mint a 8700k)![;]](//cdn.rios.hu/dl/s/v1.gif)

[link] -

Puma K

nagyúr

A 2560x1440 a monitorom natív felbontása.

De az Nvidia driver-ből lehet szorzókat állítani a DSR részen adott játékra-program vonatkozóan ami adott mértékben az adott monitor natív felbontását felskálázza.

Így tudok 2560x1440 felbontás helyett 5120x2880-as felbontásban játszani a GTA IV-gyel.

De ha az adott játék grafikai beállításainál ott a lehetőség a felskálázásra, akkor azt használom.

A GTA V-öt így futtatom 2560x1440 helyett 1,750 szeres felskálázással 4480x2520-as felbontáson.

-

janos666

nagyúr

-25% fogyasztás lesz idle-ben, másfélszeres teljesítmény úgy, hogy megint elcsúsztatják egymáshoz képest az árérzékeny kategóriákat (mint ahogy pl. sokkal inkább az RTX2060 volt a GTX170 utódja, mintsem az RTX2070), és olcsóbb lesz annyival, hogy most talán nem emelik meg az egyes kategóriák nyitóárait, és a félgenerációs frissítéskor sem, így egy év múlva egész megfizethetőnek néznek majd ki az eredeti modellek ... használtan.

-

GreatL

őstag

Fele fogyasztás lesz (a kocsmában), dupla teljesítmény (a munkahelyen) és harmadannyiba fog kerülni (használtan)!

-

Puma K

nagyúr

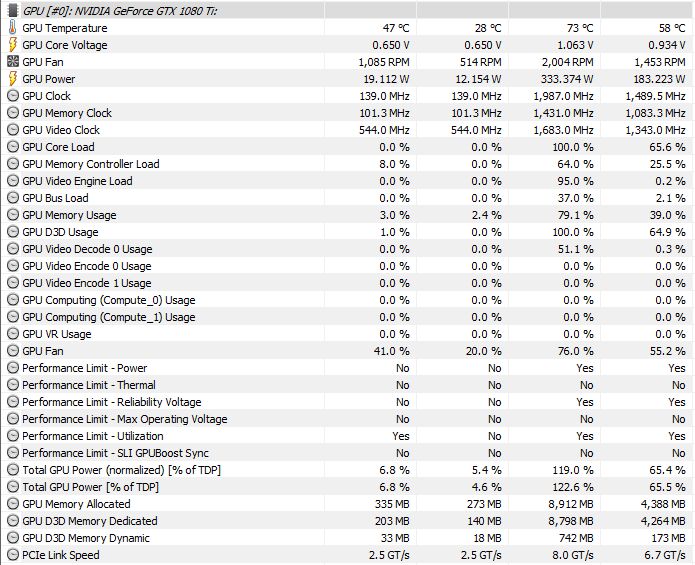

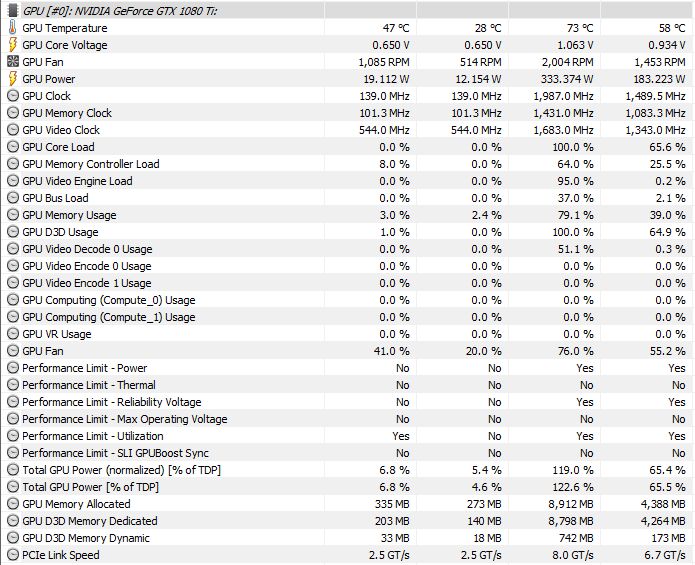

Múltkor arra lettem figyelmes, hogy a Division 2 képes majdnem 9GB-nyi VRAM-ot használni:

15 órás nyúzás során más-más játékkal játszva jöttek ki ezek a maximum értékek a VGA-nál.

Overwatch inkább a GPU hőmérsékletet tornássza fel 70°C környékére, viszont a VRAM-ot tuti a Div2 hozta össze.

-

tibaimp

nagyúr

Ha ez így igaz, akkor nem lesz semmi. Az én 2070-ben van 2304 cuda mag, a 3070-ben meg 3072. Jelenleg a 2080 Super-ben van ennyi, ehhez még hozzá jön egy kis optimalizáció plusz órajelek, és simán +40-50% gyorsulás az előző generációs 2070-hez képest. De lehet keveset írtam...

-

Tanisz

senior tag

Pletykák mindig vannak, kíváncsi leszek mit fog tudni a valóságban.

Ez az Ampere lesz az első HBM-es Nvidia kártya vagy még ezt nem lépi meg az Nvidiar?

-

milkabrams

őstag

Ha jó emlékszem a 960-as 60-70k körül nyitott, az 1060-as ~90k, a 3060-as biztosan nem jön ki 120 ezer ft alatt.

A tévedés jogát fenntartom. -

Ja értem. Volt régen FX-ed (vagy még régebbi), tehát szar az AMD.

Akkó vedd a lassan 5 (mit 5? Inkább 8-10) éve fingreszelt Intelt.

Az új Ryzen-ek meg TR-ek ellen nem is küldenek semmit, mert sajnos 18 magnál kifulladt az i9 is.

Ha többet raknának bele, akkor lenne kb. 2Ghz az alap órajel, mert felette már az 1000W-os táp is izzadna.Az FPS különbség (ami messze nincs 50) meg hol jön ki? High End VGA mellett. Gondolom sokakat érint, hogy kevés az FPS 2080Ti kártyával. Veszi kb. a piac 1%-a.

-

ProNoob

tag

-

MeszesKPT

őstag

Várom, de inkább csak azért, mert a Turing teljesen hidegen hagyott. Mondjuk az áraktól már előre csuklom.

-

ted_tris

tag

Aha.

Nezd meg a 4700u vs 1xxx7g osszehasonlitast.

2,8%al gyorsabb az amd 7nm-en, dupla annyi maggal, magasabb orajel mellett.Tele a youtube 9900kf vs ryzen 3800x osszehasonlitokkal.

A battlefiled 1-ben 50+ fpst vert a ryzenre. Pedig jo sok szalat kepes hasznalni a frostbyte.

A cinebench amit mutogatni lehet csak.

Meg az unzip.

V-ray-ben meg megint csak az intel jobb.

Azt talan tobben hasznaljak munkara mint ez elobbit.

Bullshit.

De leszarom.

Hasznalj amd-t.

Csak ne terits.

Nekem volt anno 6 egymas utan.

Azert olcso mert szar... -

egyedülülő

őstag

A játékipar is ott szaródott el ahol a legtöbb mai cég. Kimentek a részvénypiacra és onnantól már csak a részvényesek zsebe számított, hogy rövidtávon meglegyen a profit. Már rég nem a játékokról szól ez mint még a régi megadrive-snes időkben.

-

válasz

antikomcsi

#36

üzenetére

antikomcsi

#36

üzenetére

Mivel az optimalizálás plusz munka, így gondolom úgy vannak vele, hogy itt vannak az erősebb kártyák, azok majd elviszik így is.

Bár az a vicc, hogy messze nem akkora meló, mint amekkorának be akarják állítani.

Itt a saját példám is.

Elkezdtem berendezni egy nagyobb pályarészt Unreal Engine alatt. Egy kisebb erdős rész azt eredményezte, hogy csak a növényzet + a fák voltak meg, és RX580 alatt stabilan tartotta FHD-ban a 15FPS-t.

Nagyjából fél délutános meló volt feltolni 100+FPS-re úgy, hogy sokkal több lett a fa, lett egy csomó szikla is, stb.

Pedig én mondhatni kezdő vagyok és nincs mögöttem egy komplett stúdió sem.

Csak épp szarnak az optimalizálásra, mert így minél előbb ki lehet adni és dől a lé.

A kártyák meg majd izomból megoldják. -

janos666

nagyúr

válasz

antikomcsi

#36

üzenetére

antikomcsi

#36

üzenetére

Főleg, hogy az utóbbi időben néha többet ért a kickstarter-es játékokkal játszani 'a tartalom nyomában', mint az úgymond 'sokAs' triplanemx címekkel, ami vagy full retró hangulat grafikában (konkrét 2000-es évek, pixelháború a 4k-s kijelzőn), vagy átlagos kissé koros grafika borzasztó gépigénnyel.

(#12) F e Z o - Nyiss meg 10-20 fülöt FireFox-ban, kapásból 2-3 Gb, nyiss mellé egy játékot is, és elfogyott 6Gb. Mióta 8Gb-os 1070-ről 6Gb-os 2060-ra váltottam, jobbnak érzem bezárni a böngészőt, mielőtt elindítok egy játékot.

-

arn

félisten

válasz

antikomcsi

#36

üzenetére

antikomcsi

#36

üzenetére

altalanos grafikai ugras majd az uj generacioval lesz, het eves konzolok ala mar nehez olyan dolgot tolni, ami versenykepes lenne a pck kepessegeivel. pcre meg kitalaltak kulonbozo teljesitmenytemeto iranyzatokat, mint a felbontas es fps egekbe tolasa, es a raytrace.

-

antikomcsi

veterán

Jó, nem felejtem. De nem látom, hogy ez hol van összefüggésben azzal, hogy szerintem sokkal jobban emelkedett a játékok erőforrás igénye, mint maga a látvány. Laikusként nem látok akkora grafikai fejlődést mondjuk a 2007-es Crysis óta, mint amekkorát azóta a VGA kártyák ereje ugrott. Az, hogy drágák a kártyák, ilyen, vagy olyan okból az egy sajnálatos dolog, a hozzászólásomban bár megemlítem, de nem erről szólt. Igen, az a játékos vagyok akit sokan csak köpködnek, mert nekem a látvány is fontos, jelentősen hozzátesz az élményhez. Erre olyan grafikákat kapunk, olyan animációval, hogy így az évtized vége felé az már viccnek is rossz. Örülök, ha más így is élvezi, és nem is sajnálom tőle, de engem ez nem vígasztal. Szóval sokkal több olyan játékot várnék, hogy azt lehessen mondani, ez igen, odatették magukat a készítők.

-

arn

félisten

az nv pletykak ritkan jottek be... ennyi rammal rohadt draga lesz

az rtx2070 inkabb volt kozepkategoria, mint csucs a megjeleneskor.

az rtx2070 inkabb volt kozepkategoria, mint csucs a megjeleneskor. -

Ragnar_

addikt

Az azért látszik, hogy az Intelnek se megy ám 5GHz-en a 10nm-es procija egyelőre, mert ha menne már tudnánk róla. És fogyasztásban már nagyon elszállnak a magasabb teljesítménykategóriában. Szerintem a Zen3 +15% IPC-jével nagyjából lőttek az órajel miatti + 10%-nak is, és a HEDT-ben, ahol a korszerűbb technológia magasabb magszám jól skálázódik, már így is elég jelentősen le van maradva az Intel főleg teljesítmény/fogyasztásban vagy ár/teljesítményben.

-

-

Na, erről lemaradtam.

"a probléma ott jön, hogy a ryzen 4-4.5ghz környékét tudja terhelés alatt, míg az Intel 5 felé tud menni, máris ott a 10%. Plusz ott van még az is, hogy elég sok minden Intelre van optimalizalva, az is hoz pár %-ot sok helyen."

Az a sok hely egyedül némelyik játékra igaz. Minden másban kb. tönkre veri az Intelt a Ryzen.

Adobe Premiere is hiába szereti jobban a kék procit, a 9900K-t már csak az erőviszonyok miatt is állva hagyja egy közel azonos árú 3900X.

Feljebb meg hagyjuk is.

i9-ből tudsz venni max. 18 magosat (olyan TDP mellett, hogy leég a falról a villanyóra), TR-ből meg jön már a 64 magos...

Szóval aki mást nem csinál, csak játszik, és nagyon számít neki 10FPS, az megveszi az Intelt. Minden másra ott a Ryzen. -

Sinesol

veterán

Ezt már nagyon rég javitották, szal kár a gőzért. Amúgyis Cinebenchben régen is mérhető volt az egyszálas treljesitmény, tökmindegy mit varázsolt a Windows. Jelenleg kb azonos szinten vannak azonos órajelen egy szálon, a probléma ott jön, hogy a ryzen 4-4.5ghz környékét tudja terhelés alatt, míg az Intel 5 felé tud menni, máris ott a 10%. Plusz ott van még az is, hogy elég sok minden Intelre van optimalizalva, az is hoz pár %-ot sok helyen.

-

K0vasz

aktív tag

az AMD megint nagyon el lesz picsázva... oké, hogy most kb egy szinten vannak a kártyáik, de ha az nvidia semmi mást nem tenne, csak átrakná a Turingokat 7 nm-re, már akkor is sokkal jobb fogyasztást vagy teljesítményt nyújtanának, mint a jelenlegi navik. de hát ugye minden bizonnyal fejlesztik az architektúrát is, és még az is hozzá fog tenni a nyers erőhöz

a "big navi" meg ki tudja, mikor fog megjelenni - de ha be is jelentik végre a launchot, az tuti, hogy az nvidia már másnap megkezdi a 3000-es sorozat forgalmazását xD

amire viszont nagyon kíváncsi vagyok, az a ray-tracing képessége az új naviknak, bár azért túl nagy csodára nem számítok

-

Az új Ryzen-ek már egyszálas teljesítményben is erősebbek, mint az Intel.

Az FPS lemaradás okát a Windows és az Infinity Fabric viszonyában kell keresni.Pl. Ryzen 2600-nál a 6 mag 2x3-ra van osztva.

A Windows pedig nem nézi az utasítások küldésénél, hogy melyiket kellene használni.

Ha mondjuk csak 2 mag kell, akkor is simán megcsinálja azt, hogy az egyik magot az egyik klaszterből használja, a másikat meg a másikból.

Ilyenkor viszont Infinity Fabric-on keresztül kommunikálnak a magot, ami miatt van egy kis késés.

Ezért kevesebb egy kicsit az AMD procik FPS-e. -

F e Z o

veterán

válasz

antikomcsi

#21

üzenetére

antikomcsi

#21

üzenetére

Azt ne felejtsük már el, hogy a bányászláz miatt nagymértékben emelkedtek a vga-k árai.

-

antikomcsi

veterán

A játékok hardver igénye egyre brutálisabb. A megjelenő új hardverek is egyre "durvábbak" és ezzel együtt egyre drágábbak is. És mégis azt mondom, hogy a legtöbb játék látványvilága nem tükrözi azt, amiért jelenleg ennyi pénzt kell leszurkolnunk a kasszánál!

-

Picco

addikt

válasz

szabi80sz

#19

üzenetére

szabi80sz

#19

üzenetére

Az meg, hogy sokan egyből elvárnák, hogy a Ray tracing brutál látványos és gyors legyen már az első kártyákon, elég szánalmas. Minden fejlődés evolúciók sorozata. Az újításoknak örülni kellene. Lesz még ez jobb is, ha a sok elégedetlenkedő miatt nem veszik ki.. Akkor meg ne várjon senki sem fejlődést a köv.évszázadban. Mert egyik napról a másikra nem lehet nagyot produkálni. Aki szerint meg ez nem így van, az mutassa meg és fejlesszen valami látványosat!

-ha nem ugy adtak volna elo hogy ok talaltak fel a spanyol viaszt, valamint lenne tobb mint 5 jatek(nem tech demo) ami hasznalni is tudja, talan az altalanos velemny sem lenne ilyen negativ.

-DLSS, parasztvakito feature ami rosszabb vegeredmenyt hoz (ha nincs rendesen adaptalva es altalaban nincs) mintha sima upscaling-et hasznalnal, ami vicc.

-Nvidia elegge pofatlan tud lenni marketing teren es mar a termekukkel elegedett vasarlok egy reszenek is unszimpatikus. -

szabi80sz

tag

Kíváncsi lennék, hogy a pcie 5 vagy a 4 lesz támogatva. Remélem, hogy az 5. Bár itt minden vérpistike odaírja a 4-hez is, hogy felesleges, de nem csak játékra és bányászásra használnak videokártyát, hanem általános számításokra is, és itt sok algoritmust azért nem volt értelme gpu-n futtatni, mert ha csak 1 irányba ment át az adat a 16x pcie 3.0 buszon, máris akkor olyan lassú lett az egész, hogy már a 2012-es cpu-kon gyorsabban lefutott az adott algoritmus, pedig a gpu-n a futási idő sokkal kedvezőbb lett volna. A 4.0 kb.mint halottnak a csók. Az 5.0 felett már lehet kezdeni valamit,de már a 7.0 felett kellene tartani. Az Apu-k elvileg jók lettek volna, mert ott nincs késleltetés, de x86-os licensze csak az AMD-nek van és ezekben az apu-kban meg brutál lassú gpu-k vannak, így vakvágány. Videokártyákat sok önvezető autó cég használ. Természetesen cuda-val, mert az opencl egy vicc, az AMD videokártyák általános számításoka meg szintén. Bár tudom, hogy az Abu által bemutatott szintetikus opencl tesztekben esetleg nem ez látszódik, de a valóságban ezeket senki sem veszi komolyan a GPGPUs szakemberek körében.

Ide még a sok memória is jól jönne.

Az meg, hogy sokan egyből elvárnák, hogy a Ray tracing brutál látványos és gyors legyen már az első kártyákon, elég szánalmas. Minden fejlődés evolúciók sorozata. Az újításoknak örülni kellene. Lesz még ez jobb is, ha a sok elégedetlenkedő miatt nem veszik ki.. Akkor meg ne várjon senki sem fejlődést a köv.évszázadban. Mert egyik napról a másikra nem lehet nagyot produkálni. Aki szerint meg ez nem így van, az mutassa meg és fejlesszen valami látványosat! -

Cassi

őstag

Annyit tudunk, hogy a 3080 árát kicsit lejjebb veszik, tehát árban talán 3070: 499 USD, 3080: 599 USD. A TDP jóval alacsonyabb lesz, talán 120W ill. 150W. A teljesítménynek nincs fix értéke, de mindenesetre az előbbi a 2080S felett, az utóbbi a 2080 Ti felett lesz valamivel.

Satz18: csak a konkurencia hiányában

Az 5700 XT nagyon is versenyképesre sikerült, vége a lazsálásnak, továbbá az új konzolok indulása miatt is villantani kell. -

Prof

addikt

semmit nem ernek a pletykak.

Milyen aron milyen fogyasztas mellett milyen teljesitmenyt tud a lenyeg.kamu raytracing nelkul termeszetesen.

-

satz18

őstag

Ezek nagyon szép fejlődések lennének, csak a konkurencia hiányában a 3700 sztem nem 500 hanem inkább 6-700 dollár körül fog nyitni sztem. A 3800, 3800 Ti ról meg jobb nem is beszélni. A nagy nyertes az talán a noti piac lehet ha tényleg javul a fogyasztás. A turing eseténe alig volt előrelépés a pascalokhoz képest laptopokban, mert a teljesítménnyel nőtt a fogyasztás. Jó lenne ha lenne egy jó mobil 3700, ami valódi előrelépés a 1070hez képest.

-

M107

addikt

1, Milyen áron ? - mennyibe kerül ?

2, Ezek lesznek a csúcs kártyák ?

3, Nem esik át a ló túl oldalára mint anno 4 GB 64 bites kártyák esetén. (16-20 GB GGDR 6 ram esetén).

2060 6 GB Full HD High felbontás talán.

Szerintem ezek a nagy memóriával szerelt kártyák pont nem a játékosoknak lesznek, ha nem video és picture editing miatt.

UI:

De várjuk meg a hivatalos kiadásokat. De nézve hogy az RTX TITAN és a 2080 TI közt pár Fps olyan 10-12 a különbség pedig az egyik 11 GB ram a másik 24 GB ram-mal van ellátva és majdnem dupla annyiba kerül. -

#82819712

törölt tag

Több a memória ami drágább, jóval több a 7 nm ára, miből gondoljátok hogy a 3070 olcsóbb lesz mint a 2080 ? akár azonos teljesítmény mellett ?

-

Picco

addikt

nem tunik riziko nelkulinek a dontes, csak nehogy ugy jarjanak mint az Intel.

eleg szarban van mar a GPU piac amugy is, nem hianyozna meg ez is.

-

Televan74

nagyúr

Lehet 3060 -t venni majd!

A cikkhez: Kit érdekel a 20 éves hagyomány ha olcsóbban tudják gyártani.Több pénz marad a részvényesek zsebében.

Az Nvidia piacvezető helyzetét senni sem veszélyezteti. De neki örömteli az helyzet,mert van egy kis piaci rész uraló Radeon, és egy éppen csak a szárnyait próbálgató Intel. -

GodGamer5

addikt

Nagyon kemények lesznek ezek a kártyák és a pletykált 16-20 giga ram mellett nem tudom mire lesz elég a 2060 6 gigája a jövőre nézve.

Új hozzászólás Aktív témák

- Bomba ár! HP EliteBook 820 G2 - i5-5GEN I 8GB I 256GB SSD I 12,5" FHD I Cam I W10 I Garancia!

- PlayStation Network (PSN) ajándékkártyák, feltöltőkártyák áron alul!

- Azonnali készpénzes AMD Radeon RX 7000 sorozat videokártya felvásárlás személyesen/csomagküldéssel

- Vadiúj számlás AM4 lapok! Akár kamatmentes rèszletre is! Kèszleten lèvő termèkek

- HIBÁTLAN iPhone 14 Pro 256GB Deep Purple -1 ÉV GARANCIA - Kártyafüggetlen, MS3516, 94% Akkumulátor

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

).

).

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Hiába na, vörös szemüvegesen szép az élet...

Hiába na, vörös szemüvegesen szép az élet...

max alulról közelíti, 8-10%-al van mögötte

max alulról közelíti, 8-10%-al van mögötte

), de ha szimplán azt nézzük, 28nm-ről 16nm-re ugrásnál (57,14%-osra kicsinyítés) tudtak kb. +50% órajeltöbbletet adni a gpu-nak, akkor 12nm-ről 7nm-re ugrásnál (58,33%-osra kicsinyítés, tehát majdnem ugyanakkora előrelépés!) is képesek lehetnek erre, hiszen minden egyes nm-beli ugrásnál magasabb órajeleket kaptunk kisebb fogyasztással párosítva (980Ti 250W, 1070 160W, ami egyben kb. a kicsinyítés mértéke úgy, hogy h a kevesebb nyers erőt +50% órajellel megpakolták és kb. egyforma a két kártya).

), de ha szimplán azt nézzük, 28nm-ről 16nm-re ugrásnál (57,14%-osra kicsinyítés) tudtak kb. +50% órajeltöbbletet adni a gpu-nak, akkor 12nm-ről 7nm-re ugrásnál (58,33%-osra kicsinyítés, tehát majdnem ugyanakkora előrelépés!) is képesek lehetnek erre, hiszen minden egyes nm-beli ugrásnál magasabb órajeleket kaptunk kisebb fogyasztással párosítva (980Ti 250W, 1070 160W, ami egyben kb. a kicsinyítés mértéke úgy, hogy h a kevesebb nyers erőt +50% órajellel megpakolták és kb. egyforma a két kártya). , csak ne legyen az, hogy megint drágul minden és 600ezer Ft lesz egy 3080 Ti...

, csak ne legyen az, hogy megint drágul minden és 600ezer Ft lesz egy 3080 Ti...

az rtx2070 inkabb volt kozepkategoria, mint csucs a megjeleneskor.

az rtx2070 inkabb volt kozepkategoria, mint csucs a megjeleneskor.