Új hozzászólás Aktív témák

-

válasz

Aprósólyom

#109

üzenetére

Aprósólyom

#109

üzenetére

Cserélném, cserélem, most fog jönni egy EX240 Benq. Így ha esetleg AMD-re váltok, akkor lesz sync ugyan úgy.

-

A 6950XT szintje azt jelentené, hogy a 7800XT-nél csak 15%-kal gyorsabb a 7900XT - 40%-kal több CU, 25-30%-kal erősebb memória és duplaannyi (!) ROP mellett. Ez még akkor is necces, ha a tényleges órajel 20%-kal magasabb, ami már 3GHz feletti értéket jelent. Az árak kérdéséről meg nem is beszélve.

-

GeryFlash

veterán

MCD van 6nm-en gyartva, az semmit nem befolyasol, a 4N meg egy marketing bullshit, ugyanugy 5nm. Nem, itt az architektura es az Nvidia knowhow plusszbol jon, ahogy az elmult 10 evben lassan mindig (elozo gennel volt egyenlo perf/watt, ugy hogy az Nvidia sokkal rosszabb nodeon gyartott).

-

anulu

félisten

fej-fej mellett van többnyire a 6950XT-vel a 7800XT, de hajlamos nagyon kikapni tőle.

-

Aprósólyom

addikt

A frametime analízist nem a bénaság mentegetésére szoktuk nézegetni, hanem amire készült.

Szemlátomást semmi kapcsolatod, se tapasztalatod a fast-paced online multikhoz, ennek ellenére mégis olyanokról teszel feltételezéseket, amiben se tapasztalatod, se képességed, se információd a játékok felületesebb technikai részleteiről sem és a köré épített infrastruktúráról se, legyen az szerver vagy kliens oldal.

Mi a fenének szólsz bele erős kritikával és teszel prekoncepcionális állításokat, ha nyilvánvalóan inkompetens vagy a témában? Oktalan okoskodás.

Több ezer szót kellene gépelni egy felületes magyarázathoz, de az is kevés lenne, hiszen meg is kellene tapasztalni a leírtakat és még az is kevés lenne, hiszen képesség, motiváció és sok gyakorlás is kell hozzá.#106 laskr99: Én úgy tudom Freesync/adaptive sync nem tud olyat, mint a dedikált G-sync modul: variable overshoot. Illetve a dedikált G-sync modulosak már már 1Hz-től szinkronizálnak. Kvázi ~24fps mozi mód nem gond.

A variable overshoot meg single player címeknél jön jól, ahol el lehet lenni 60fps/60Hz-en. Ami azért fontos, mert egy high-refresh rate monitor hiába jó képet ad 180hz/180fps-en, 60fps-en csúnya utánhúzásokat/szellemképet produkálhat, ha nem állítja a monitor magán az overshoot értékét. Márpedig a dedikált g-sync modult ezt tudja, úghogy valószínű soha semmilyen szellemképet nem láttál még, miközben a VRR aktív.

Gamingre az egy nagyon jó monitor, úgyhogy ha nem cseréled, akkor a radeon neked nem lenne ideális. -

-

ughhh

senior tag

Kiscsikó, most fogják szállítani az új gamer gépemet:: Precision 7865 Tower Workstation : Dell Workstations | Dell USA

-

A nagyobb érdekes is lehet, csak kérdés támogatná e a monitorom, mert Gsync és ugye nem tudom, hogy meg lehet e oldani

-

válasz

Aprósólyom

#101

üzenetére

Aprósólyom

#101

üzenetére

de ha nem uszik el rajta a serleg, azaz jelentősége semmi, akkor minek mérni?

nem azzal vitázok, hogy az ELVBEN igazad van-e - igazad van: a nyolc millisec kétszer annyi, mint a négy! viszont nem hiszem, hogy a GYAKORLATBAN ennek lenne jelentősége és pláne nem gondolom, hogy elveket finghámozó kisebbségnek kellene a teszteknek szólnia. az is eredmény, hogy négykában mindegyforma...

még lötyögni SEM szoktam kompetitív játékokban, szóval nem jártál messze

talán pont ezért sem vágyok a bénaságomat ELVBEN mentegető frametime gráfokra

talán pont ezért sem vágyok a bénaságomat ELVBEN mentegető frametime gráfokra

-

Aprósólyom

addikt

Senki nem beszélt arról, hogy ezen fog elcsúszni a serleg. Neked súlyos értelmezési problémáid vannak.

Nem mellékesen meg nem teória, mert ahol van x számú fps ott simán előfordulnak x/2 frametime-ok.

Inkább hagyd abba a fságaidat, mert a hsz.-eid alapján képzelem mennyit játszol competive címekkel lötyögésen kívül. -

"ehez jön az amd "szánalmas" r&d büdzséje az nv-hez képest."

Azt azért ne felejtsd el hogy AMD bevétele már nem olyan aprócska.22 ben 23 milliárd volt Nvidiának 26 milliárd. a két cég egy ligában játszik. NV most ebben a negyedévben rekordot döntött az AI / datacenterek miatt de amúgy a két cég bevétele közel azonos már. AMD valószínűleg a CPU ra koncentrál elsősorban és bevétele is onnan származik. és a Xilinx üzlet is most érik be .

-

válasz

Aprósólyom

#98

üzenetére

Aprósólyom

#98

üzenetére

tippre pont annyi embert érdekel, mint a teóriád, miszerint pont a 0.1% pillanatokban ugranak eléd és pont azon a 0.2 ms "lagon" fog elúszni a serleg, tehát annak a 7 embernek a kedvéért kell ilyen teszteket nyomni, akiknél már ez IS számítHAT, szigoruan elméletben!

-

Aprósólyom

addikt

Kit érdekel, hogy te mit vennél? Feltűnt, hogy én sem a saját vásárlási szokásomról beszéltem? De annak ellenére, hogy avg. 720p fps táblázatot illesztettem be, a kompetetív online gaming 0.1%/1% fps teljesítményéről beszéltem. TP nem mér ilyet, ezért olyan táblázatot illesztettem be, ami a legrelevánsabb.

Nem a 700fps számít, hanem hogy ha már van 165/240/280/360Hz monitora a kompetetive gamernek, akkor legyen "tűzön-vízen" keresztül ennyi fps, lehetőleg a 0.1% szintuációkban is.

Megsúgom nem lesz, de pont ezért vesz a kompetetive player a lehetőségeihez mérten a lehető legerősebb CPU-t a játékához, mert normál esetben CPU limite lesz, nem GPU a low video setting miatt.

És ismétlem, az, hogy ki mit vesz a sokszor a játékon is múlik.

Az más kérdés, ha valaki fanból vesz valamit. Az nem az én dolgom, nem is érdekel. A piaci verseny engem olyan szinten érdekel, hogy a lehető legkisebb befektetett pénzből a lehető legtöbb stabilabb frametime-t kapjam. -

de ezt nem tudják "ledolgozni", itt az nv a brutális piaci súlyával és befolyásával sok éve diktálja a tempót és az irányt

(20XX széria óta mindenképpen, ráadásul 1-1 "elvárásra" évek alatt tudnak a versenytársak max reagálni...)

(20XX széria óta mindenképpen, ráadásul 1-1 "elvárásra" évek alatt tudnak a versenytársak max reagálni...)ehez jön az amd "szánalmas" r&d büdzséje az nv-hez képest... ördögi kör...

pl nv tolja h legyen pathtraced cybepunk, lesz, majd ehez kártyát is szállít 6-700ezerért... de ha az sem elég (márpedig nem az), akkor kapsz dlss3-at is, frémgenerátorral, de ha ez is kevés volna, akkor dlss3.5-el... jahogy nyers hw-erővel a közelében nem vagyunk, hogy ilyen graf lehessen? kitérdekel, látszólag van bőven elég fizetőképes kereslet a 4090-ekre, szóval nincs itt semmi látnivaló.

#95 Aprósólyom

jah, 745fps ellen csében 692-vel teljesen esélytelen vagy

ilyen marginális, változó elsőség szerintem nem kell h mérvadó legyen vásárláskor - ellenben az ár és a fogyasztás már inkább jó támpont. én intelt biztosan nem vennék, eleve azért sem, hogy az AMD feljöhessen egy 50-50%-os, IGAZI VERSENYpiacra. -

D55

senior tag

"a dlss és társai, RT, stb bekavarnak"

Ezt kéne már ledolgozniuk, vagy amíg ez nem megy, addig sokkal agresszívabban kellene árazniuk. Mert lehet itt makacskodni, de ha még egy ideig kitartanak a jelenlegi kereslet-kínálati viszonyok, akkor egy idő után nehéz lesz az alacsony bevételekkel együtt élniük (amin ugye mostanság az amúgy is szintén túlárazott 7000X3D CPU szériájukat érintő leégéses botrány sem valószínű, hogy segít). Sőt, az nVidia számára is csak látszólag kényelmes ez a helyzet (mert ott ugye állítólag nagyon mennek az AI lufi termékeik most), hiszen ok, hogy abból van elég bevétel nekik és talán ha nem pukkan el a dolog és/vagy nem fojtja meg az egészet a bürokrácia / jogterrorista szervezetek akkor még lesz is egy ideig, viszont azért a versenyhivatalok türelme sem végtelen, vagy ha esetleg az is, azért akkora arcvesztést már csak a mögöttük álló államok jogállamisági megítélése miatt sem kockáztathatnak meg, hogy összemossák a kínálathiányos piaci időket a mostani túlárazás miatti büntetőkeresletes időkkel![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Aprósólyom

addikt

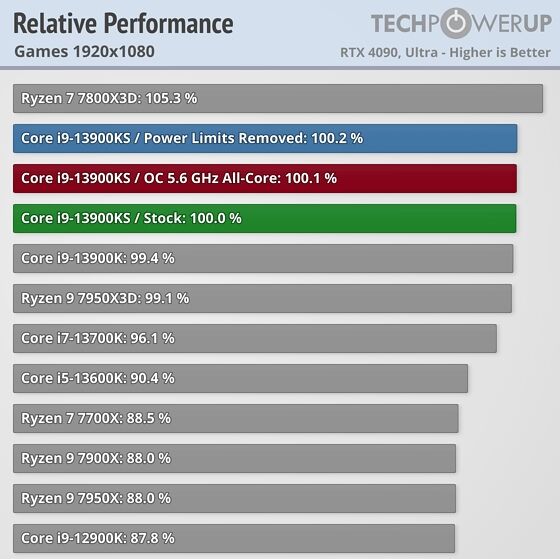

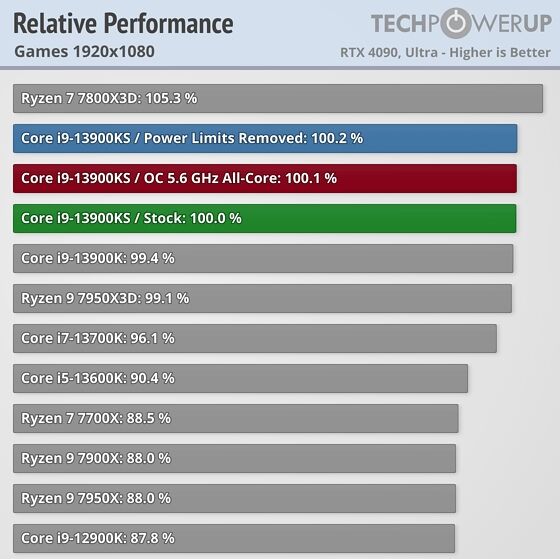

Az én elméletem szerint gaming teljesítményben az erősebb procikat inkább competetive high refresh rate címekben van értelme összevetni, mert ott számít a CPU erő/limit.

Véleményem szerint egy AAA single player címben, ízléstől függően 60fps/75fps felett, esetleg 90fps felett már tök mindegy, hogy +/- 20%. Miért? Akinek van egy jó monitora + VRR és nem lesz képtörés, azoknak kiváló élményt nyújt 60fps/75fps (néhányuk igényli a ~90fps-t, bár azoknak szerintem nem feltétlen a legjobb monitoruk van. hiszen a tiszta mozgókép nem csak az fps-től függ, hanem nagy részt a monitor paneljának a valós pixel response idejétől).

Competetive online multi címeknél meg van egy kis packet késés, akkor tök mindegy hogy amúgy van avg. 240fps+, a pillanatnyi késés render queue idejét csak a CPU erő irreális növelésével lehet rövidíteni és javítani a 0.1%/1% low fps-en, sajna . Ott minden "dadogás" a farametime-ban számít. Egy kvázi "tötyi-lötyi" lassú tempójú single player címnél meg mindegy, 60fps/75fps-től már kiválóan játszhatóak és élvezhetőek.

. Ott minden "dadogás" a farametime-ban számít. Egy kvázi "tötyi-lötyi" lassú tempójú single player címnél meg mindegy, 60fps/75fps-től már kiválóan játszhatóak és élvezhetőek.Competetive címekben pedig játéka válogatja, hogy melyik jobb. Az én szemembe ez olyan, hogy egyértelműen nem lehet rámondani, hogy egyik-másik jobb. Egyéni preferencia, hogy ki-mit és miért választ.

-

FragMaster

addikt

válasz

Piszmaty76

#85

üzenetére

Piszmaty76

#85

üzenetére

Úgy gondolom ez teljes tévút volt. Söpört végig anno az interneten, hullámzik parttól-partig oda-vissza azóta is, de teljesen alaptalan, semmi forrás nincs hozzá. Ilyen, oszt' csók.

-

200 ezerért 7700xt jön a 170 ezres 4060ti mellé? ejha, előrébb lettünk

(nem)

(nem)kíváncsi leszek, mit tud a 6700xt-m után, tippre: nem eleget

valszeg kell 3-4 generáció, amíg azonos szérián belül érdemes váltani... (várom a 9700xt-t, addigra talán a 200 ezer forint sem ér majd semmit )

)#86 ughhh

és amugy javultak is... pontosabban az nv aktuális arhitekturája nem öregedett olyan szerencsésen (de ez régen volt, mamár valszeg nem igaz, sőt... pláne a dlss és társai, RT, stb bekavarnak) -

válasz

Piszmaty76

#85

üzenetére

Piszmaty76

#85

üzenetére

Jól emlékszel, volt ilyen, csak az állítólagos probléma mibenléte változott az idő folyásával, úgyhogy nem zárható ki, hogy szerecsenmosdatás a dolog. Igazából mindegy is, ez a széria most így sikerült, most már az AMD-s stratégiának megfelelően várjuk a 8000-eseket, hátha majd akkor (TM)

-

ughhh

senior tag

válasz

Piszmaty76

#85

üzenetére

Piszmaty76

#85

üzenetére

Régebben a amd cuccokhoz (nem emlékszem mi volt) is várta a közönség a csodadrivert, hogy sokkal több van benne mint amit ki tud tolni magából. Értem én, de mégse hozza az elvárt teljesítményt, tehát ennyit tud.

-

Piszmaty76

aktív tag

Ha jól rémlik, az RDNA3 valamilyen pittyputtyba futott, valami nem úgy működik, ahogy azt Lisa-ék tervezték. Arról is volt szó, hogy később érkező kisebb kártyákban már valószínűleg javítják (de mégsem) a hibát. Többen is írták anno, hogy bőven van tartalék a kártyákban, sokkal jobban is tudnának menni. Vagy csak álmodtam az egészet...

-

ughhh

senior tag

válasz

Piszmaty76

#75

üzenetére

Piszmaty76

#75

üzenetére

"a széria valójában mire is lehetne képes"

Pont erre képes amit látsz, lóf@sz esti fény.

Az aktuális amd kártyáknak az mspr árát osztani kellene kettővel.

Keveset gyártanak, tájékozatlanok megveszik, horror profit erről szól az rdna az utóbbi években. -

tasiadam

veterán

válasz

paprobert

#65

üzenetére

paprobert

#65

üzenetére

Ugyr az AMD-nek a stabil bevetelt a konzolok hozzak, a szerver CPU-k es a gyorsitok. Amig a konzolokbol eladnak sokat, addig kb alig tudnak ra nagy haszont pakolni. De legalabb fix a bevetel. Mig nem adnak el annyi VGA-t amin nagyobb a ROI, addig nem is lesz trillion della

-

Piszmaty76

aktív tag

válasz

Dr. Akula

#22

üzenetére

Dr. Akula

#22

üzenetére

Én inkább úgy fogalmaznék, hogy a 7900 XTX felé is kiadhatott volna még valamit (7950 XTX?). De azért sem lettem volna morcos, ha év végén jött volna egy "RDNA 3.5 vagy RDNA 3 v.2", egy csiszolt/javított verzió, ahol végre megmutathatná a széria valójában mire is lehetne képes.

-

Egy komolyabb változó van a kérdésben, az órajel. A becsléseket a 7900XT eredményeiből "deriváltam", és a target órajel a 7800XT esetében 1.5%-kal, a 7700XT esetében 6.3%-kal magasabb, azaz szinte semmivel. Ha a gyakorlati órajeleken tudtak tekerni (a gyászos fogyasztási specifikáció alapján könnyen lehet, hogy erről lesz szó), akkor annyival előrébb jönnek a kártyák mind raszerben, mind RT-ben.

-

El sem hiszem, hogy az AMD végre kegyeskedik valami terméket hozni a videokártya piacra

Gyors becslés a számok alapján:

- A 7800XT a 4070 alatt lehet 5-10%-kal raszterben, RT mellett meg 25-30%-kal. 100 dollárral olcsóbb, több RAM van rajta, cserébe szolgáltatásban kevesebb.

- A 7800XT annyiba kerül, mint a 4060Ti 16GB, raszterben 20-25%-kal lehet gyorsabb, RT-vel kb. egál. Azonos RAM, szolgáltatásban kevesebb.

- A 7700XT cca. 10%-kal lehet a 4060Ti felett, RT-vel meg 10%-kal alatta. 50 dollárral drágább a 8GB-os variánsnál, ezért több RAM-ot ad, szolgáltatásban meg kevesebb. A 16GB-os variánsnál meg 50 dollárral olcsóbb, kevesebb RAM, kevesebb szolgáltatás.Ha ez így megáll, akkor a 7800XT egy kicsivel jobb ajánlat, mint az NVIDIA kártyák, a 7700XT pedig legalább olyan szar, ha nem még szarabb (főleg attól függ, hogy valakinek görcsöt kap-e az ujja, ha a textúra-felbontást át kell kapcsolnia Ultráról High-ra). Köszönjük Jensennek és Lisának, hogy ilyen áldozatosan dolgoznak érettünk

-

DudeHUN

senior tag

válasz

Dr. Akula

#51

üzenetére

Dr. Akula

#51

üzenetére

AMD prociknál sajnos azt csinálja, mint Nvida a kártyáknál. Feljebb tolt mindent és kinyomja őket ameddig lehet. Borzasztóan olcsón gyárthatóak ezek a Ryzen processzorok. Egy R9 7950 100 dollár alatt megáll... Intel sajnos(?) nincsen ilyen jó helyzetben.

De látszik is, mert AMD konkrétan a desktop chipeket is tudja laptopokba, mini gépekbe eladni annyira nem az asztali X széria széthúzott mivolta a sweet spot ezeknek.Az Ada-val nem lehet hatékonyságban versenyezni. Az RDNA 3 kevés ehhez. Ez tisztán látszik. 4060Ti 16GB árán az RX 7800XT jobb lesz. A 7700XT lehetne 50 dolcsival kevesebb. Így sok értelne nincsen. De gondolom még jön legalább egy sima RX 7700.

-

Dr. Akula

félisten

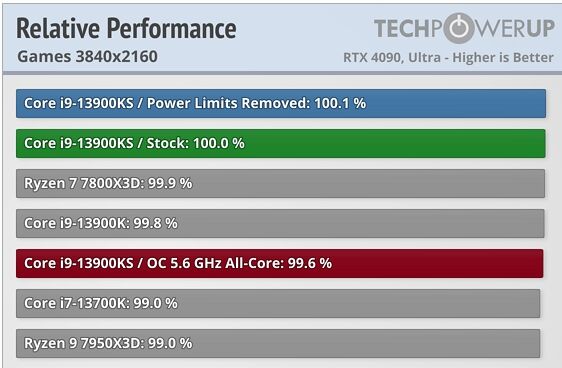

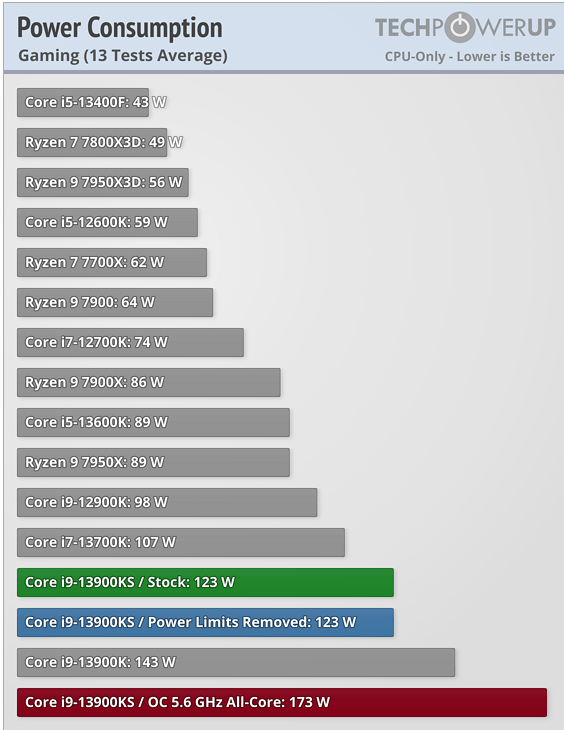

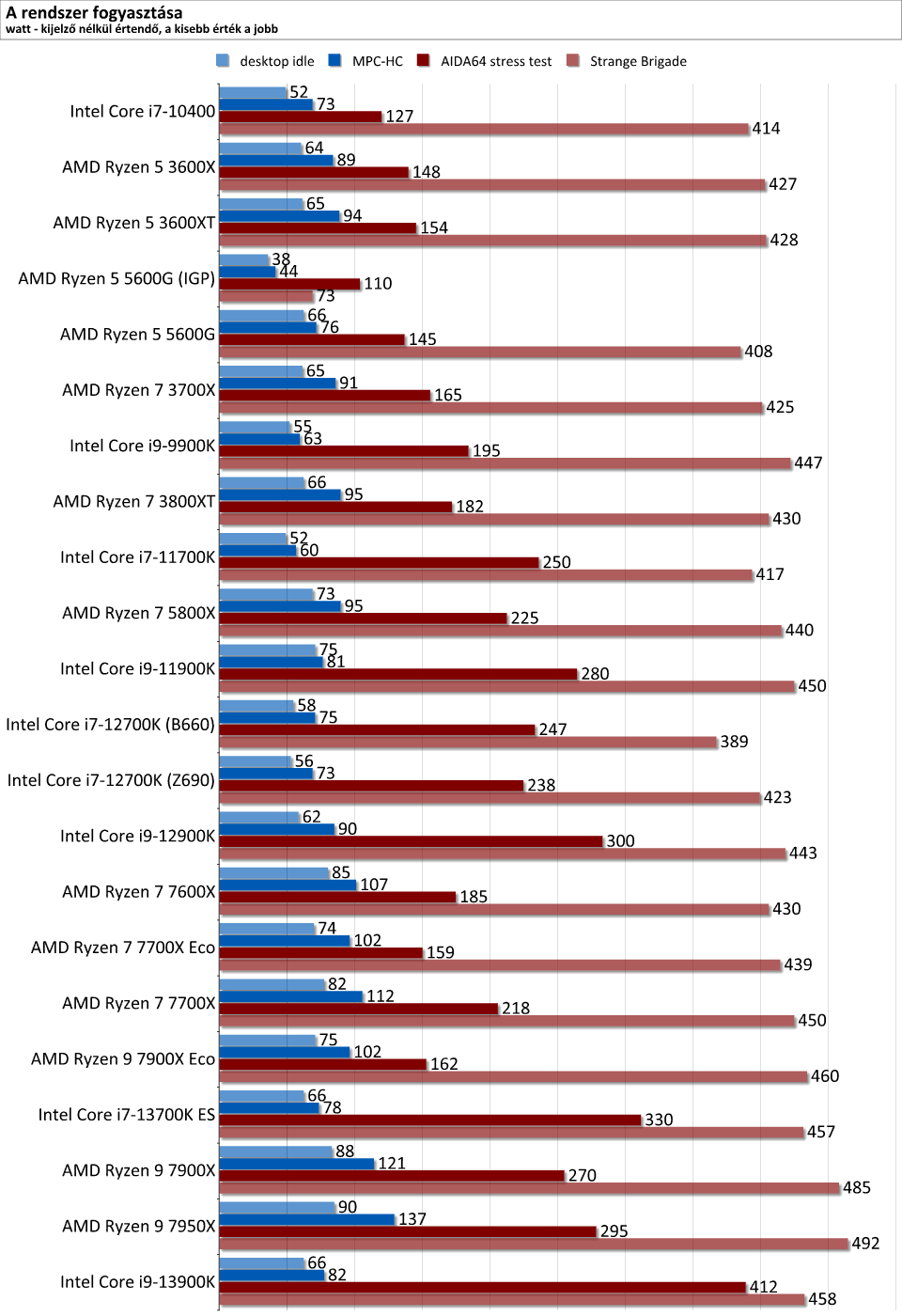

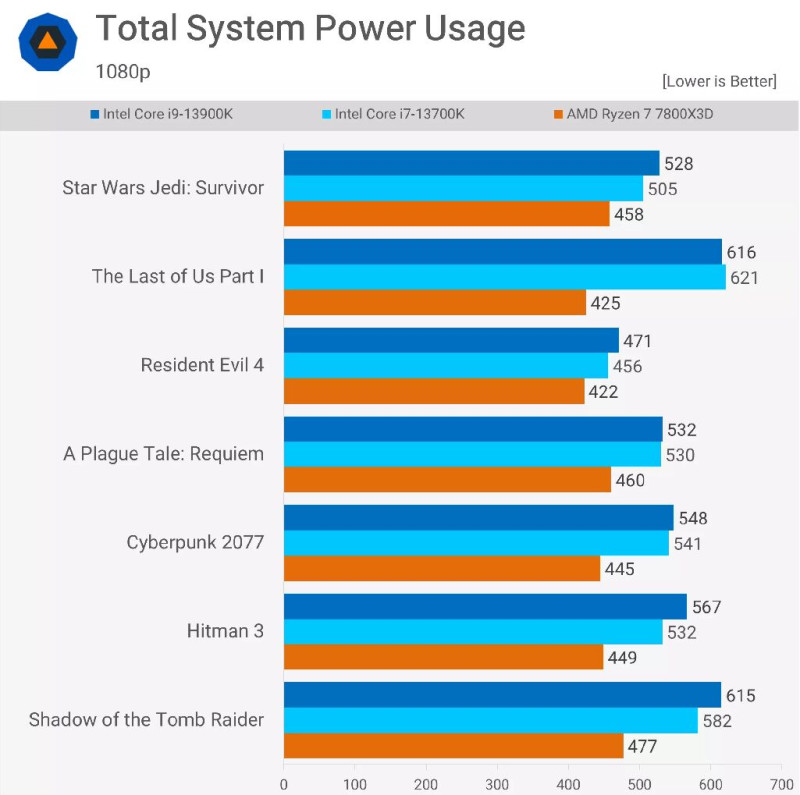

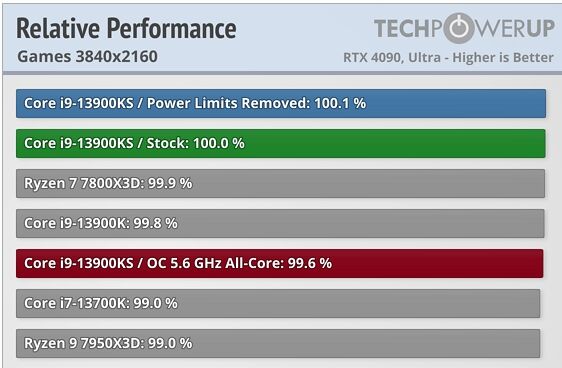

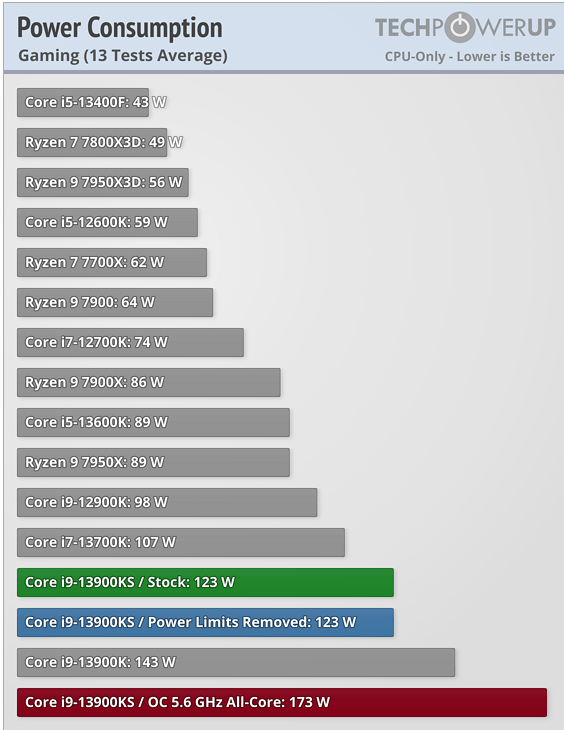

10-25% a proci leterheltsége, mindez ráadásul 4K-ban, nem 1080p-ben, ahol még annyi se lenne, biztos nem ebből adódik a különbözet. Hanem az ész nélkül nyomatott turbóból, ami fpst-t ugyan nem rak hozzá (ez érthető is, ha már addig se volt leterhelve a cpu), viszont fogyasztást annál inkább.

-

KISDUCK

addikt

válasz

Dr. Akula

#68

üzenetére

Dr. Akula

#68

üzenetére

Én maradnék a korábbi véleményemnél hogy a ph!-s tesztnél a vga szűk keresztmetszet volt. Megnézve több ph!-s tesztet a shadow of the tomb raider ott volt a ph!-s tesztekben is és azon az oldalon is amit először linkeltem, szóval ph-n ryzen 7600x-től felfelé benne az 13700k és 13900k is meg az eco módos ryzenek is ugyan azt az fps-t hozták avg-ben minimális szórással és annyi hogy a felsőkategória felé picit nőtt a minimum fps. Értem én hogy a játékok motorjának is van korlátja, de az i9- nek azért magas a turbója és maximális tdp-n több magra tovább kéne tartania a magasabb órajelet ami több fps-t eredményezne, de ehelyett ugyan annyit hozott mint az eco-s rizsa, rámernék tenni egy csili csíz békönkinget hogy vga limit volt a ph!-s tesztben játékok alatt a 2080ti miatt. Persze ezen sokat tudna segíteni ha a tesztekbe nem csak itt, de máshol is be lenne szúrva akár egy hwinfo log vagy akármi hogy lehessen látni, hogy mi meddig nyújtózott, de helyette kapunk pár színes grafikont ami gyakran nincs is sorba rendezve.

-

Dr. Akula

félisten

Találtam egy tesztet, ahol szintén teljes konfigot mérnek mint itt a PH-n. Sajnos a VGA típusa nem derült ki, viszont ami érdekes belőle, viszont a lényeg a Blender és a gaming ábrán van. Az Intelnél külön mérik a PL1/2 (gyári TDP limit, alap 125W / turbó 253W), valamint az UNL(ocked) PL1/2 (= ereszd el a hajam turbó, nincs limit) fogyasztást. Itt az unlimited a turbó idejére vonatkozik, ugyanis a classic Intel turbó az 56 másodperc volt korábban is, a 12. generációnál a K-s prociknál alapból kikapcsolták ezt a Tau időt, addig marad turbóban, amíg bírod hűtéssel. Így jön össze az akár 300W fogyasztás, mivel nem vesz vissza 125W-ra 56 másodpercenként. Ahogy látjuk, amikor a TDP keret be van kapcsolva, akkor hasonlóképp fogyaszt az AMD is mint az Intel. Az 500W meg unlocked turbónál jön. Valószínűleg a te tesztedben unlocked turbóval teszteltek, itt a PH-n meg lockeddel. Itt egy teszt arról, hogy mennyit számít az unlocked: hát kb. semmit. Cinebench és hasonlóknál van némi hatása, játékban 0. Szóval unlocked módban tesztelni arra volt jó, hogy a semmi fejében megpörgessük a fogyasztást indokolatlanul. Olyan mint ráülni a mérlegre: kicsit csalás szaga van. Persze lehetőséget ad rá az Intel, de leginkább csak a teszteredmények befolyásolására jó, hogy "látjátok milyen sokat fogyaszt az Intel". Hát tud annyit is, meg tud kevesebbet is, és mégis ugyanaz az fps.

-

#25237004

törölt tag

"Nvidia első negyedéve üzleti évre nézve február."

Gondolom februárral kezdődőt szerettél volna írni, mert ugye egy negyedév az 3 hónap, február-április. Az adott üzleti év első negyedéve az a megelőző naptári év február-április hónapja. Pl. a Q4 FY21 az 2020. november - 2021. január időszakot jelenti.Itt van még 3 negyedév (Q2 FY22, Q1 FY22, Q4 FY21), tehát összesen 6, ahol magasabb volt a bevétel. Linkeltél már 4 táblázatot, de pont ezeket valahogy véletlenül nem sikerült.

Nvidia negyedévek Q2 FY21 - Q1 FY23

Rá lehet fogni, hogy "de ez is bányaláz", bár a Q4 FY21 az még nagyon az eleje volt.Összességében amúgy nincs értelme nézni sem, hogy volt vagy nem volt bányászláz, mert ahogy írtam, valamilyen mértékben az utolsó 6-7 évben mindig hatott a bevételre (az ilyen időszakok után negatív irányban, mert a korábbi túlkereslet később odavert használt kártyák, túlkínálat, árcsökkenés stb. formájában), nem csak 3 negyedévben a BTC double top időszakában 2021-ben (nyilván ott a leginkább).

De ha igazán precízek szeretnénk lenni ráadásul, akkor azt is számításba kellene vennünk, hogy az abszolút agyhalott szinteket verdeső pénznyomtatás (és ebből eredő infláció) sem volt ilyen a megelőző években, ami mind hozzájárult bármelyik hasonló cég árbevételeinek az irdatlan növekedéséhez.

Akkor vesd össze így is a korábbi bevételeket, hogy mennyi volt és mennyi most az M2 money supply és ebből eredően az infláció és hogy az Nvidia bevétele hogyan alakult ezekkel arányosan, ne csak önmagában a nominális értékeket nézve. (természetesen ezt nem fogod tudni pontosan meghatározni)

De ne fárasszuk a topicot, úgyis mindegy, bemutatták az összes kártyájukat, a recesszió is a sarkon kukucskál, innentől megy újra lefelé a gaming szegmens (is).

-

paprobert

őstag

Az AMD hozzáárazott az NV 4000-res generációhoz, azoknak is a rosszul teljesítő darabjaihoz.

Ha 150-200 dollárral csökkenne mindkét kártya, még akkor is korrekt haszon lenne rajtuk, de az elég az sosem elég.Biztos ők is a "next trillion-dollar chip company" címre gyűjtenek, amihez én nem kívánok asszisztálni a pénzemmel.

Ezekkel a közel kétszeres árakkal most nem(sem) sikerült vevőt konvertálniuk belőlem, ebből használt piac lesz.

Az FSR3, FMF biztatónak tűnik a marketing alapján, de a tesztekre mindenképp szükség lesz, hogy tiszta képet kapjunk.

-

Pip3.9

csendes tag

Ez a fórum megint kicsit félrement.

Szerintem a jelenlegi helyzetben 500 usd msrp a 7800xt-nek (nyilván áfa nélkül) versenyképes, 4070 ellen. Persze nem rendkívüli, de hát megint ez a helyzet, csak most épp az AI miatt nincs gpu, nem a bánya miatt.

Szóval mintha az AMD kicsit próbálna versenyezni. De igazán kíváncsi vagyok a független tesztekre, azok általában reálisabb képet adnak és sajnos az eredmények általában kevésbé kedvezőek ott, mint a marketing anyagban. Ott dől el hogy mennyire jó is ez a kártya.

Ajánlom az MLID egyik mostani videóját az FSR3-ról, hogy ez miért lehet nagy húzás, ha sikerül jól megcsinálni (driverből) . -

KISDUCK

addikt

válasz

Dr. Akula

#59

üzenetére

Dr. Akula

#59

üzenetére

Hát jó 100 wattal magasabb a fogyasztási kerete az i9-nek és más a két proci felépítése, a mérés alapján úgy látszik hogy nyélgázon ami játékok alatti teljesítményt érinti az i9-nek több energia kell ugyan ahhoz az eredményhez és ugye azt tudjuk hogy a számítási teljesítmény és fogyasztás növekedése nem egyenesen arányos. A 7800x3d-nél 120 vagy 162 watt a plafon, elvileg az utóbbi érték a cpu foglalat maximuma, míg intelnél 253 watt. Nem tudom hogy pontosan hogy működik a 2 cpu, de az látszik a teszt alapján, hogy az inteles rendszer elég szépen felszökik, hol 50 wattal fogyaszt többet, hol majdnem 200 wattal. Plusz az i9-nél magasabb a turbó órajel is ami indokolhat nagyobb étvágyat. Anno az 5GHz-es bulldozer is nagy étvágyú volt. Úgy néz ki hogy ekkora fogyasztási különbséget okozhat az eltérő felépítés, a plusz gyorsítótár és a más gyártástechnológia.

-

-

CptAdamica

veterán

Kíváncsi leszek a tesztekre, a 3070-el manapság állandóan a vram limittel kínlódok, ha jobb lesz a 4070-nél és ráadásul olcsóbb is, akkor az a +60W még nem egy visszatartó erő a vásárlástól.

-

#25237004

törölt tag

És? Volt bányászláz 2017-2018 környékén is, tehát az elmúlt 6-7 év nagyobb részére hatott, mint amire nem.

Ezekben a táblázatokban (amelyek egyébként nem profitot, hanem bevételt mutatnak), összesen csak 8 negyedévet látsz, amiből instant 3 magasabb, mint a mostani - és valószínűleg az ezt megelőző 1-2 is, ami a táblázatban nem látszódik -, tehát ahogy írtam, rekorddöntögetésnek a közelében sincsenek, teljesen mindegy, hogy ki, mikor és miért veszi a kártyáikat.

Ezekben a táblázatokban (amelyek egyébként nem profitot, hanem bevételt mutatnak), összesen csak 8 negyedévet látsz, amiből instant 3 magasabb, mint a mostani - és valószínűleg az ezt megelőző 1-2 is, ami a táblázatban nem látszódik -, tehát ahogy írtam, rekorddöntögetésnek a közelében sincsenek, teljesen mindegy, hogy ki, mikor és miért veszi a kártyáikat. -

Dr. Akula

félisten

A 2080Ti >> 4090 megmagyarázná hogy miért magasabb minden eredmény, de azt nem hogy miért csak az Intelnél nőtt meg. AMD procival is többet eszik a 4090 a 2080Ti-nél. A 7800X3D 50W-tal kevesebbet eszik a 79(0/5)0X-nél, ennyi (+- valamennyi) különbség még érthető lenne, de további +-150W azért már nem hibahatár.

Komolyabb VGA-val az AMD procinak is több képkockát kell kiszámolnia, nem csak az Intelnek, ott is nőnie kell a fogyasztásnak. 4K-ban ráadásul majdnem ugyanott vannak fps-ben, az ehhez tartozó áramfelvétel se lehet 0 az AMD-nél, +200W meg az Intelnél.

Komolyabb VGA-val az AMD procinak is több képkockát kell kiszámolnia, nem csak az Intelnek, ott is nőnie kell a fogyasztásnak. 4K-ban ráadásul majdnem ugyanott vannak fps-ben, az ehhez tartozó áramfelvétel se lehet 0 az AMD-nél, +200W meg az Intelnél. -

#25237004

törölt tag

"(döntögeti sorban a saját rekordjait az nVidia Gaming részlege is, nem csak a Data Center...)"

Itt pontosan melyik univerzumról van szó? A miénkben ugyanis a gaming részleg mostanában kezd egyáltalán újra életjeleket mutatni (mielőtt jön a masszív recesszió, ami majd újra legyalulja), a crypto boom vége utáni, kifejezetten gyenge negyedévek után. Rekorddöntögetésnek még csak a közelében sincs.

A miénkben ugyanis a gaming részleg mostanában kezd egyáltalán újra életjeleket mutatni (mielőtt jön a masszív recesszió, ami majd újra legyalulja), a crypto boom vége utáni, kifejezetten gyenge negyedévek után. Rekorddöntögetésnek még csak a közelében sincs. -

KISDUCK

addikt

válasz

Dr. Akula

#53

üzenetére

Dr. Akula

#53

üzenetére

Hát tippre azt mondanám hogy a 2080ti miatt van ami csak 250w tdp-s szemben a teszttel amit linkeltem, mert ott 4090 oc van ami elvileg 450w tdp-s. Ha jól tudom akkor utóbbi 80%-al erősebb az előbbinél, ezért arra tippelnék, hogy a ph!-s tesztben nem volt az utolsó csepp is kifacsarva a tesztelt cpu-kból játékok alatt és 4090 mellett tovább tudtak nyújtózni a procik aminek a hatására az intel 13900k jobban be tudott zabálni.

Shadow of the tomb raider mindkét tesztben van és látszik hogy 4090 mellett magasabbak az fps-ek mint ph!-s tesztben, szóval ph!-s tesztben vga limit volt megérzésem szerint. (igaz hogy ph-nál nem 7800x3d van a tesztben hanem 7950x) de i9 esetében a ph!-nál 171 min fps és 221 avg fps volt, míg 4090 mellett ezek 248 és 299-re ugranak. -

K0vasz

aktív tag

válasz

#57018880

#47

üzenetére

#57018880

#47

üzenetére

"Ez is tovább erősíti a gyanúmat, miszerint a két cég ismét össze dolgozik ezekkel az árszabásokkal és időzítésekkel, hiszen mindketten előrébb vannak vele."

persze, az véletlenül se lehet, hogy mivel az emberek megveszik ennyiért is a 4060ti-t, ezért az AMD úgy van vele, hogy akkor a hasonló teljesítményű kártyájukat miért ne adhatnák ők is hasonló áron? mondjuk a részesedésüket így nem nagyon fogják növelni, de könnyen lehet, hogy az APU-k meg a konzolok mellett eleve nem is tudnának sokkal több chipet gyártani a dGPU-kba (azért a chipgyártás se végtelen kapacitással üzemel), szóval ilyen szempontból lehet, nekik mindegy is

-

Dr. Akula

félisten

Ez frankó, csak akkor itt a PH-n hogy jött ki mégis az ellenkezője? Igaz, ott 170W-os 7900X és 7950X a tesztalany, a 7800X3D meg csak 120W (persze mindez TDP, jól leterhelve ki tudja mennyi az eltérés ettől), viszont mindhárom(!) eredményben (üresjárat, filmnézés, játék) konzisztensen hozta ugyanazokat az arányokat, egyedül az AIDA tesztprogramnál fordult. A PH tesztben az Intel konfig 460W volt (a 12900K 443W, ami arányosnak tekinthető), ezen a grafikonon meg repkednek a 600W-ok... Ez nem kerekítési hiba, valami itt nem stimmel.

-

KISDUCK

addikt

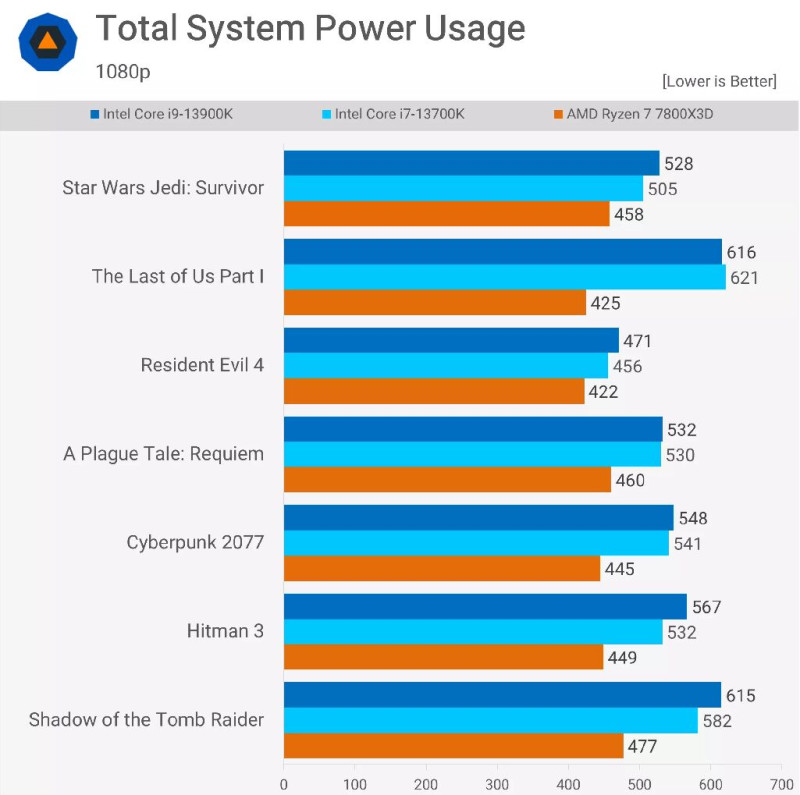

A 7800x3d fogyasztásban jobb mint a 13900k teljes rendszer szintjén és fps-ben beéri simán, van ahol picivel alatta van van ahol picivel felette. Forrás

-

Dr. Akula

félisten

"Mutatsz nekem olyan tesztet, ahol játék közben egy AMD chipset cirka 100W-ot fogyaszt, amekkora eltérés van a 7800X3D vs. 13900K(S) között?"

Mutattam. A PH-s teszt, mint már írtam korábban is, a TELJES fogyasztást mérte, a tied meg csak a prociét. A kettő közt milyen különbség lehet még? Marad még az hogy a gyíkemberek viszik el a maradékot...

Tehát?

Tehát?"Mindezt olcsóbban és kisebb fogyasztás mellett."

Ebből a kisebb fogyasztás mítosza megcáfolva.

"Ennyit állítottam."

Volt ott még azért más is: az AMD CPU-k jobbak. Hát szóval ez se igaz. 1080p-ben hasonlóan teljesítenek, 4K-ban viszont már MINDENBEN jobb volt az Intel (linkeltem a tesztvideót). Hogy lenne akkor jobb az AMD? Eléggé az Intel nyomában van, de jobbnak nevezni erős túlzás.

"Rendben, átfogalmazom:

"...és a hozzá legközelebb álló 13900KS proci árának felébe kerül."Elégedett?"

Ha valóban közelebb állna hozzá, akkor még lehetne azt is mondani. De mint láttuk, a 13900K mégközelebb áll hozzá, tehát felesleges a KS luxusfelárát felszámolni, miközben még a sima K-t se tudja megverni.

-

Cifu

félisten

válasz

Dr. Akula

#38

üzenetére

Dr. Akula

#38

üzenetére

"'A fogyasztással amit linkeltél, az a baj, hogy az csak és kizárólag a procikat hasonlítja össze, a hozzá tartozó chipsetet nem. Nekem viszont a teljes villanyszámlát kiszámlázza az ELMÜ, nem csak a CPU-ét, tehát jobban érdekel az hogy a végén mennyit kell fizetnem. Ez a magyarázat a különbségre, a PH a TELJES fogyasztást mérte! És abban az AMD nagyon nem áll jól. Sovány vigasz hogy de legalább a proci kevesebbet fogyaszt... Jó, de ez nekem pontosan mire is jó? Semmire."

Őőő.... Mutatsz nekem olyan tesztet, ahol játék közben egy AMD chipset cirka 100W-ot fogyaszt, amekkora eltérés van a 7800X3D vs. 13900K(S) között?

Tényleg komolytalan már ez a vagdalkozás...

"AMD procik közül ez a jobbik játékra, ennyi állítható."

Mindezt olcsóbban és kisebb fogyasztás mellett. Ennyit állítottam."A fele ár erősen sántít."

Rendben, átfogalmazom:

"...és a hozzá legközelebb álló 13900KS proci árának felébe kerül."

Elégedett? -

Cifu

félisten

"Persze a fogyasztástól nem tudok eltekinteni, de azért kicsit kétlem, hogy a "lelépte" kategória lenne az alacsony felbontáson mért kemény 5 azaz öt százalékos különbség, ami nem sokkal több mint a mérési hibahatár."

Az AMD oldalon egy adott csúcs teljesítmény szintet jóval olcsóbban tudsz megvalósítani, mint Intel szinten. Mindezt kisebb fogyasztás mellett. Akkor most miről is beszélünk?"Persze azt sem érdemes elfelejteni, hogy ebből mennyi köszönhető az Intel bénázásának, mint olyannak, és mennyi valóban innovatív fejlesztés."

Tök mindegy abból a szempontból, hogy most az AMD ül a nyeregben, vagy az Intel. -

GodGamer5

addikt

Ha lett volna esze az AMD-nek, akkor a Starfieldbe Day1 belerakja az FSR3-at....

-

#57018880

törölt tag

Radeon 7700/XT -re vártam én is leginkább idén, de én ott elvesztettem a lendületet amikor láttam, hogy az RTX 4060 Ti 16GB-hoz mérnek és áraznak, ami konkrétan az egyik legrosszabb ár-érték arányú kártya perpill. Ez is tovább erősíti a gyanúmat, miszerint a két cég ismét össze dolgozik ezekkel az árszabásokkal és időzítésekkel, hiszen mindketten előrébb vannak vele.

Gyakorlatilag az egész jelenlegi kínálat mehetne 100 EUR-al lejjebb és még úgy is túlárazott lenne, legalábbis ahhoz képest, hogy azonos Hz mellett még a +78%-ot sem sikerült megugrani árszintben valamilyen felskálázás nélkül. (igen,tudom a játékok sokkal komplexebbek és sokkal kevésbé optimalizáltak, de ez trend szinten gond volt régen is amikor még volt érdemi előrelépés. )

Mondjuk a nyitóárak amiket anno sokan védtek mindenféle jó kis házi matekkal, azóta érdekesen erősen mérséklődtek. Érdekes ha csappan a kereslet akkor valahogyan kijön a matek a még mindig orbitálisan profitálóra, csak éppen nem rekord szintűre.

-

-

bajusz15

senior tag

€500-ért a 7700XT inkább egy "rakj hozzá egy kicsit és vegyél drágábbat" stratégia, az €550-s 7800XT meg lesz vagy 300k nálunk?

És ezekre vártam hónapokat.. nagyon remélem, hogy a 6700XT-k ára megy még lentebb, odakint $330-$350, itthon $430 minimum. Vagy veszek egy gagyi 6650XT-t és kivárok mit hoz 2024. -

GhanBuri Ghan

őstag

Nem értek hozzá, azért kérdezem, de az Infinity fabric nem tenné lehetővé több GCD összekapcsolását is? Mert akkor sokkal egyszerűbben lehetne skálázni az architektúrát.egyből kijöhetnének az összes variánssal, és a kisebb lapkák miatt a selejtarány és a wafer szélén a veszteség is kisebb lenne.

-

válasz

Dr. Akula

#23

üzenetére

Dr. Akula

#23

üzenetére

Volt egy időszak amikor a Steam-en az Intel vezette a GPU listát, mert tőlünk keletre laptopokon nyomták a "CSét" a srácok.

Amúgy ha a konzolokat is bele számolnánk vajon mekkora lenne a piaci részesedése az AMD-nek?

#39 Egon

Egy mára multira növekedett cégnél dolgoztam és az egyik vezetői meetingen előadta az egyik termékmanager, hogy 200% növekedést értek el csupán egy év alatt. Tudni kell, hogy teljesen új termékkategória volt és a semmihez képest sikerült 200%-ot abszolválni. Én olyan jót nevettem akkor is. -

Annyit hozzátennék, vagy javítanék, hogy a 4080 12 GB a 4070 Ti lett volna, ami 3090 és a Ti körüli teljesítményt hoz.

A CPU ra:

Én is bementem hozzátoka topikba hogy gépet rakok össze ,de elhalasztottam , mert borzalmas szerintem mindkét oldal, mert vannak problémák és mert ne igazán / sokkal olcsóbb az AM5 platform mint az 1700, ha az ember DDR5, PCIE5 támogatást szeretne, és normális ram támogatást valamint azonos kategóriás CPU-t hogy egy darabig ne kelljen fejleszteni.

Főleg az alaplap árak elrettentőek. -

Nyilván a gamer videokártya piacon releváns, mennyi az MI-chipek eladásából befolyt zsé...

Egyébként meg megint a kettős mérce: ha az Intel lemarad, akkor bénázik, ha éppen az AMD, akkor szar.

Elárulom: ahhoz, hogy valaki lemaradjon a versenytársától, bénázni kell, legyen szó 3dfx-ről, nV-ről, Intelről, AMD-ről, Sun Microsystems-ről, Microsoftról, IBM-ről, akárkiről. -

Egon

nagyúr

Az megvan ugye, hogy a mainstream hozza a nagy lóvét?

A mainstream hozná? Mondd meg ezt a nV-nek és a piacnak is...

![;]](//cdn.rios.hu/dl/s/v1.gif)

MI-üzemanyaggal töltött rakétaként lőtt ki az Nvidia profitja - HWSW

Hogy a fókusz rendkívül rövid idő alatt mennyire átterelődött az adatközponti termékekre a cégnél, azt jól érzékelteti, hogy a 13,51 milliárd dolláros árbevételhez 10,32 milliárd dollárral járult hozzá az a részleg, melyhez az MI-termékek, így az egyenként több tízezer dollárba kerülő Grace Hopper sorozatú chipek és az azokat tartalmazó DGX szuperszámítógépek tartoznak.

Ebben a környezetben az egykor fő bevételforrást jelentő gaming szegmens rövid megtorpanása meg sem kottyant a cégnek, ráadásul láthatóan ez a terület is növekedési pályára állt mostanra, a zömében PC-s grafikus gyorsítóprocesszorokat gyártó üzletág árbevétele ugyanis 2,48 milliárd dollár lett, ami nagyjából 22 százalékkal teljesíti túl az egy évvel korábbi értéket. -

Dr. Akula

félisten

A fogyasztással amit linkeltél, az a baj, hogy az csak és kizárólag a procikat hasonlítja össze, a hozzá tartozó chipsetet nem. Nekem viszont a teljes villanyszámlát kiszámlázza az ELMÜ, nem csak a CPU-ét, tehát jobban érdekel az hogy a végén mennyit kell fizetnem. Ez a magyarázat a különbségre, a PH a TELJES fogyasztást mérte! És abban az AMD nagyon nem áll jól. Sovány vigasz hogy de legalább a proci kevesebbet fogyaszt... Jó, de ez nekem pontosan mire is jó? Semmire.

Játékban is elég vegyes az X3D előnye, van ahol van, van ahol lemarad az Intel mögött. Cyberpunkban (ami minden gépet letérdeltet) pl. ha minimálisan is, de az Intel a jobb. Tudott győzni Horizon Zero Dawnban (265 vs 236 fps), MS Flight Simulatorban (113 vs 103 fps), cserébe Hitman 3-ban (245 vs 262 fps) és Plague Taleben (198 vs 203 fps) meg lemarad. A többiben alig 4-5 fps az eltérés ide-oda. És ez még csak az 1080p, 4K-ban mindenhol megveri az Intel, bár ilyen felbontásban már nagyon minimálisak a különbségek, sokszor 1-2 fps, de annyit bizonyít hogy jobbnak egyáltalán nem tekinthető a 7800X3D. AMD procik közül ez a jobbik játékra, ennyi állítható.

"és a hozzá legközelebb álló 13900K és KS procik árának felébe kerül"

7800X3D 161k, 13900K 221k HUF. A fele ár erősen sántít. Olcsóbbnak olcsóbb valamivel, de azért ne túlozzunk... Alaplap árakban is hasonló különbség van.

Olcsóbbnak olcsóbb valamivel, de azért ne túlozzunk... Alaplap árakban is hasonló különbség van. -

Egon

nagyúr

Persze a fogyasztástól nem tudok eltekinteni, de azért kicsit kétlem, hogy a "lelépte" kategória lenne az alacsony felbontáson mért kemény 5 azaz öt százalékos különbség, ami nem sokkal több mint a mérési hibahatár.

Szerver vonalon valóban nagyobb a különbség.

Persze azt sem érdemes elfelejteni, hogy ebből mennyi köszönhető az Intel bénázásának, mint olyannak, és mennyi valóban innovatív fejlesztés. -

-

Cifu

félisten

válasz

Dr. Akula

#34

üzenetére

Dr. Akula

#34

üzenetére

Szerintem nézz valami naprakészebb listát, mondjuk a TPU-ét, amin rajta van a 7800X3D is. Most maradjunk a játékoknál.

A 7800X3D játékokban jobban teljesít bármelyik Intel procinál (4K-ban kb. ott van, ahol a 13900KS), cserébe töredékét fogyaszt azokhoz képest, és a hozzá legközelebb álló 13900K és KS procik árának felébe kerül, de komplett rendszert nézve is jóval olcsóbban nyújtja az adott teljesítményt.

-

Dr. Akula

félisten

Én nem látom hogy jobbak lennének, legjobb esetben is tartják vele a lépést. Nem mondom hogy nagyon le vannak maradva, de azért mindig csak a 2. helyre elég csak a teljesítményük. Állítólag kevesebbet fogyasztanak, de hogy miben az jó kérdés, ebből semmi nem látszik, sőt...

Mindezt úgy, hogy az Intel rendesen le van maradva gyártástechnológiában. Mi lenne ha nem lenne? Szóval minderre azt mondani hogy lelépték volna az Intelt, az elég meredek. Egyedül a szerverprocis rész ami valós, az Intel tré gyártástechnológiával nem tudja tartani a magszám versenyt, de ez a piac nagyon kis szelete.

-

-

Cifu

félisten

válasz

KEKWKapitány

#26

üzenetére

KEKWKapitány

#26

üzenetére

A gond az, hogy ha végignézed a kártya specifikációkat és teszteket, az nVidia a gigászi előnyét arra használja ki, hogy a csúsztatott egyett a sorozaton.

Az RTX 4060 valójában RTX 4050-ként kellett volna kijöjjön (RTX 3060 szintű teljesítmény, 128 bites memóriavezérlő, stb.), a TDP 115W, tehát valójában simán megoldható lenne egy 75W-os, külső csati nélküli, akár passzív hűtésű változat.

Az RTX 4070 valójában RTX 4060-ként kellett volna kijjöjön (csak túl jól sikerült (RTX 3080 körüli teljesítmény), ezért akarták először RTX 4080 12GB-ként eladni, de aztán viszakoztak)

Az RTX 4080 inkább illett volna RTX 4070 Ti szintre (de megint túl jól sikerült, kicsivel kisebb frekin és teljesítményen RTX 3090 (Ti) szintet hozott volna).

Az RTX 4090 pedig lehetett volna az RTX 4080 kisebb fogyasztással, a kijött verzió meg RTX 4080 Ti vagy RTX 4090 magasabb fogyasztással és teljesítménnyel. Ezért lett ár/érték szinten az Ada Lovelace család messze legjobb kártyája...Csak az AMD annyira padlón van teljesítményben, plusz még késett is, hogy az nVidia kényelmesen megléphette ezeket a lépéseket, és gigászi felárat húzhat be (döntögeti sorban a saját rekordjait az nVidia Gaming részlege is, nem csak a Data Center...), és az AMD képtelen rá választ adni, lásd RX 7700XT és 7800XT fél év késés és teljesítény szint.

Utóbbira leglátványosabb a saját diájuk, ahol a két generációval korábbi RTX 2070 Super meg az RX 5700 a viszonyítási alap, nem az előző generáció, mert akkor esélyesen azt látnánk, hogy a most érkező kártyák nem versenyképesek (az RX 6800 kb. ott van árban, mint az RX 7700, az RX 6800XT meg a 7800XT árában van, tehát bőven össze lehetne mérni).Érdemes azt is megnézni, hogy csak az nVidia kártyákkal mérik össze magukat, mert ha oda raknák az Intel Arc sorozatot, akkor még a végén kiderülne, hogy Ray-Tracing terén igazából még az Intel dGPU újra-nyitánya is tök jól teljesít az AMD 7000-es szériához képest (raszterben nyilván nem).

Szóval jah, a helyzet az, hogy az nVidia akkora előnyben van minden téren (nem csak hardware, de szoftver (DLSS, RT) terén is), hogy hülyére keresi magát, az AMD és az Intel pedig csak fut utána, és nem egy, de bizonyos téren (szoftver) két generációs késéssel.

Mi pedig ezt úgy kapjuk a nyakunkba, hogy azonos árért nem kapunk teljesítmény plusz értékelhetően... -

-

Dr. Akula

félisten

válasz

KEKWKapitány

#26

üzenetére

KEKWKapitány

#26

üzenetére

Ezeknek a kártyáknak már az előző generáció egyel nagyobb tagjai is konkurrenciái, ott már megtalálható ugyanez a teljesítmény, csak most más néven is meglesz mégegyszer ugyanaz. Ez azért nem olyan hiánypótló, mint valami még nemlétezőt alkotni.

Népkártya már van elég, ami az AMD-nek hiányzik, az a csúcskártya. Az RT teljesítménye viszont mindenhol lemaradásban van a konkurrenciához képest, így ha népkártyát akar az ember, azt is inkább a konkurrencia népkártyái közt keresi leginkább. Most épp fogyasztásban se jobbak, az se jó indok mellette. Igazából semmi se, csak arra jók hogy az Nvidia ne szálljon el annyira az áraival, egyfajta kontroll szerepet tud csak betölteni. Szóval igen, teljesítményre lenne szükségük, nem mégegy ugyanolyanra amijük már van 2-3 másik néven is.

-

KEKWKapitány

csendes újonc

válasz

Dr. Akula

#25

üzenetére

Dr. Akula

#25

üzenetére

Kérlek avas be ebbe a low-end kilengésbe... No offenz de nagyon el lehet tàjolva valamid ha ezek (7700/7800/4070) low-end szerinted... consumer lowend az x500 és a xx50-es kártyá... szvsz technikailag meg ha az új architektúràval csinàlnak olyan konstrukciót amit lehet passzívan is hűteni...

De oké szubjektív véleménynek elfogadom, egyéb mondjuk objektív érv szól amellett hogy az AMD epénisz méregetésbe kezdjen az nvidia 4090-esével ahelyett hogy kiszolgàlja a piacot egy jó nép kàrtyàval ?

-

Dr. Akula

félisten

válasz

KEKWKapitány

#24

üzenetére

KEKWKapitány

#24

üzenetére

Mert a lowend szegmensben már így is túltengés van, oda tök felesleges mégegy, highendbe meg nincs semmijük.

-

KEKWKapitány

csendes újonc

válasz

Dr. Akula

#23

üzenetére

Dr. Akula

#23

üzenetére

Miért ? 7800xt ezzel az árral és specifikációval hajthat a nép kártya címre... és ez az ami hozza a piaci részesedést... 4090 és egy esetleges AMD ekvivalens max niche csunyàbb szóval élve pózerkedésre jó... Föleg ha maga a gyàrtó gàncsolja az előző generációs csúcs kàrtyàit featurok hiànyàval, 3090 ott az erő benne de tudomásom szerint se av1 se dlss3.5(?) De voltak olyanok akik arra is kiadtak milla közeli összeget...

-

Dr. Akula

félisten

Inkább a 7900 XTX fölé kellett volna valami, amivel az Nvidia nyomába tud érni.

-

válasz

Hellwhatever

#20

üzenetére

Hellwhatever

#20

üzenetére

A Steam az összes GPU-t nézi, nem csak a diszkrét vezérlőket.

Magam részéről hajlamosabb vagyok olyannak hinni akinek a főoldala nincs kitapétázva az nVidia CEO-jával (se másével). 17 cikk, ebből 7 nV témájú, 2 AMD a maradék pedig Intel és egyéb. Suspicious...

-

válasz

Hellwhatever

#18

üzenetére

Hellwhatever

#18

üzenetére

A kedves kolléga egy 2022-es grafikonnal riogatja a nagyérdeműt. Lehet az is az eltérés oka.

-

KISDUCK

addikt

Táblázatban szereplő értékek jók? Az amd oldalán kicsit mást látni, a 2 jobban eltérő érték első ránézésre:

7700XT - Peak Pixel Fill-RateUp to 244 GP/s

7800XT - Peak Pixel Fill-RateUp to 233 GP/s -

djbb534

tag

Nocsak! Az alsópolcra is megérkezett a fake frame generator

-

Ez a HYPR-RX, és az Anti-Lag+ csak a 7000-es kártya tudja majd?

-

-

hahakocka

őstag

válasz

GlitterJohan

#4

üzenetére

GlitterJohan

#4

üzenetére

Korábban volt sokszor fordítva is +30-40W nem tápcsere függő a dolog engem nem zavar mindegy melyik gyártónál lenne ez. Ha hozza az ár értéket és az erőt. Ha igazak a grafikonok ez hozza a 4060ti-4070 ellenében. S több a vram is. S most már van FSR3 Hyperx nem tudom mi engem ezek a képrétegeztető dolgok továbbra se érdekelnek. Nehogy már egy új közép és felső kateg alsó szintjén lévő kártyán csak csalással és 720p-1080p ről felfele legyen meg az 50-60fps 1440-4K n akár.

-

FLATRONW

őstag

Az MCD-ket leszámítva, semmi különbség nincs a gyártástechnológiák között.

Az N4 is 5nm-es.

Az MCD-k 6 nm-en gyártása pedig nem eredményez ekkora különbséget.

Itt csak az látható, hogy azonos gyártás mellett az NV hatékonyabb architektúrát képes készíteni.

Jó példa erre, hogy a 12 nm-en készült Turing hatékonyabb volt, mint a 2. generációs 7 nm-en készült RDNA 1.Az NV az előző generációnál pedig nagyot hibázott, hogy az Amperhez a Samsung 8 nm-ét választotta.

Ez azt eredményezte, hogy az RDNA 2, 3. generációs 7 nm-e hatékonyabb lett. -

szmörlock007

aktív tag

"Itt alapvetően a GCD az újdonság, amely 346 mm²-es kiterjedésű, így kedvezőbb gyártani, mint a nagyobb testvérét, de nincs is benne annyi feldolgozó."

Itt valami nem stimmel, a GCD-nek 200 mm² környékén kéne lennie, szerintem a 4 MCD-vel együtt lesz az 346 mm².

-

typo: "...az RNDA 3 dizájnnál..."

-

Duck663

őstag

válasz

GlitterJohan

#4

üzenetére

GlitterJohan

#4

üzenetére

12%

A trendet érdemes figyelni! Így fognak kiszorulni a piacról, illetve fogja átvenni a helyüket az Intel.

-

vicze

félisten

válasz

GlitterJohan

#4

üzenetére

GlitterJohan

#4

üzenetére

AMD N5/6-on gyártat, nV meg 4N-en, pont ennyi a node-ok közti különbség.

-

tasiadam

veterán

2*8 pinnel remelem mar azert erejuk is lesz, nem csak fogyasztasuk

-

Duck663

őstag

válasz

GhanBuri Ghan

#1

üzenetére

GhanBuri Ghan

#1

üzenetére

Igen, de nem készült több GPU. Csak a Navi 31, a 33 és most a 32-es van. A 7900-at kellett volna 7800 ként kiadni, a tempója alapján is oda illik, ez meg lehetne a 7700. Ez is inkább oda illene, ahogy nézem a 7800XT alig gyorsabb, mint a 6800XT.

#2 ledgeri: Amíg veszik őket! Na de itt a bibi, hogy nem veszik, nézted, hogy áll az AMD piaci részesedése Radeon fronton? -

válasz

GhanBuri Ghan

#1

üzenetére

GhanBuri Ghan

#1

üzenetére

De akkor ha az nvidia beékel valamit, akkor az AMD is még tud ékelni....

A végén kevesebb a fa, mint az ék, de amíg veszik így is, kit érdekel a fűtőérték?! -

GhanBuri Ghan

őstag

Alig van különbség a két kártya között, indokoltabb lenne 7700 és 7700 XT vagy 7800 és 7800 XT néven árulni őket.

Új hozzászólás Aktív témák

- Xiaomi Redmi 15C 128GB, Kártyafüggetlen, 1 Év Garanciával

- Telefon felvásárlás!! iPhone 13 Mini/iPhone 13/iPhone 13 Pro/iPhone 13 Pro Max

- Akció! Hordozható GAMER Monitor! MSI MAG162V ! 15.6 1920x1080 FULLHD! Bolti ár fele!

- BESZÁMÍTÁS! MSI B450 R5 5500 16GB DDR4 512GB SSD RX 6600 8GB COUGAR GAMING MX330-G 500W

- Lenovo T14 Thinkpad Gen3 WUXGA IPS i5-1245U vPro 10mag 16GB 512GB Intel Iris XE Win11 Pro Garancia

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Ez nagyon jó monitor, nem tudom hogy van e hasonló olcsóbban ami freesyncet tud.

Ez nagyon jó monitor, nem tudom hogy van e hasonló olcsóbban ami freesyncet tud.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

. Ott minden "dadogás" a farametime-ban számít. Egy kvázi "tötyi-lötyi" lassú tempójú single player címnél meg mindegy, 60fps/75fps-től már kiválóan játszhatóak és élvezhetőek.

. Ott minden "dadogás" a farametime-ban számít. Egy kvázi "tötyi-lötyi" lassú tempójú single player címnél meg mindegy, 60fps/75fps-től már kiválóan játszhatóak és élvezhetőek.

Tehát?

Tehát?