Új hozzászólás Aktív témák

-

Pingüino

senior tag

válasz

Armagedown

#10

üzenetére

Armagedown

#10

üzenetére

Ha anélkül is jó az energiahatékonyság, akkor minek? Sokkal hatékonyabb steppinget használnak. Nem olyan egyértelmű az, hogy ez lenne a jövő.

-

arn

félisten

válasz

fatpingvin

#63

üzenetére

fatpingvin

#63

üzenetére

Itt az lenne a lenyeg, hogy egy kezben van az os es a hw, kiszamithato, es olyanokat is meg tudnak csinalni, ami a szettoredezett pcs piacon ki tudja mennyi ido lesz (unified felepites, swes optimalizaciok, etc).

-

-

-

arn

félisten

válasz

#32839680

#55

üzenetére

#32839680

#55

üzenetére

Ez egy olyan piaci res, amit siman meglephetnenek… erolkodnek mindenfele tucathwel, ennek a pcpiacon alternativaja se lenne. A pc gamingpiac 90%at vinnek, olcso munkaallomasnak is megtenne, es mivel egykezben a hw es sw, hasonlo dolgokat megtehetnenek, mint az apple, magaval huzva az egesz pcs piacot.

Jelenleg az apple elhuz az egesz pcs gabazs mellett, amig szamolgatjak a banyaszok penzet.

-

sb

veterán

válasz

#32839680

#48

üzenetére

#32839680

#48

üzenetére

Desktopra ott vannak (vagy inkább voltak) az APU-k. Elég erősek voltak de ha kellene sokkal erősebbet is tudnának gyártani.

HBM-et "bármikor" lehetett volna rá tenni RAM-nak is akár, de ugye működött cache módban is a Vegákon.

Most jön a 3D cache is...

Plusz ha jól rémlik akkor szerverbe jönnek vmi IF-re drótozott gpu-k.Így a PCIe szerintem simán kikerülhető. APU-n egységes címtér létezett is már, nem?

Az más kérdés, hogy nyilván egyedi megoldás lenne továbbra is... -

XZoli

aktív tag

Kérek szépen zen 4 CPU Battlefiled 2042 magokkal

-

sb

veterán

Ezt a hw sose fogja jól tudni. Írok egy szar progit ami ugyanúgy 1 szálon 10GHz-es magon érzi jól magát és ütemezhet bárhova meg varázsolhat alatta hw erőforrásból bármit.

Vagy ha a hw gyakorlatilag újraírja a kódom akkor az is sw-s megoldás. Akkor is egyszerűbb beültetni helyettem őt az irodába és nem a hw-be integrálni. Aztán indulhat a skynet.

-

Duck663

őstag

Érdekes gondolat, de szerintem ehhez meg kellene emelni az órajelet, annak az egységnek az órajelét mindenképpen, ami elvégzi a virtuális magokhoz való feladatszétosztást. Ez nem biztos, hogy energiahatékonyság szempontjából jó lenne.

Összességében jó lehet ez az elgondolás, de sok buktatója van. Abban viszont mindenképpen egyetértünk, hogy hardveres megoldás kell.

-

sb

veterán

Fantázia van, azt írtam, hogy nehezebb kihasználni. De ha sikerül akkor hatékonyabb a funkcionális specializáltság. A tök általános és a fixfunkciós felépítés között lenne.

Viszont a cikk egyértelműen ilyen funkcionális különbségekről szólt nem arról amit írsz, hogy pl. órajelben lesz különbség. Az AVX már ilyen, ott kell is kódot és ütemezőt igazítani hozzá ha így lesz.

@hokuszpk

szóval hardveres megoldas kell.

Mivan, ha a prociban nincsenek klasszikus magok, csak 120 vegrehajtoegyseg, amirol a biosban eldontheted, hogy ez hany virtualismagnak tunjon. ( 1,2,3,4,5,6,8,10,12,15, 20, 30, 40, 60 ? )

ennek megfeleloen virtualis magonkent allokal 1-1 vegrehajtot, a tobbit pedig a terheles fuggvenyeben rendeli az egyes virtualis magokhoz.

Ez szerintem nem működőképes. Legalábbis ugyanúgy sw oldali megoldás kíván.A compilerek adott architektúrára optimalizálnak. Az sem világos a "feldolgozó" az mi, de ahhoz még tartoznak más erőforrások magok/feldolgozók között elosztva, még a regiszterek használata is optimalizált kell legyen egy jó kódhoz. Szóval ha ezt az egész alól kihúzod akkor vagy szarul fog futni a kód vagy erre szintén sw kell ami megoldja... ráadásul csak egy bizonyos szintig, mert ha mondjuk dolgozol X regiszterrel és azt fizikailag lefelezed alatta akkor tök mindegy mit-hova optimalizálna a fordító, szar lesz a kód.

Ez akkor jó, ha hw szinten az új architektúra "fedné" ilyen szempontból a régit. De akkor meg a jó hatékonysághoz kellene nagyon flexibilis erőforrás kiosztás. Az sem jó önmagában ha mindenből sok van mert ha pazarlóan osztod akkor elfogy szar hatékonysággal.

Ebbe az irányba mutathatna a k*va sok cache amúgy, meg egy unified, gyors ramos architektúra. Nyilván az még mindig lassú a belső feldolgozáshoz képest, de így erőből, ha sok a cache és a gyors ram, akkor elég sok mindent el lehetne fedni.

Ettől függetlenül az sw-s célirányos kihasználás még mindig sokkal többet nyújt ahogy az Apple-nél látható. Nem véletlenül ment erre az egész Fusion-APU szemlélet is. Szerintem ezt kéne erőltetni:

- Talán változott annyit a hozzáállás sw oldalról egyébként is, meg most itt az M1 példa ami miatt azért vakarhatják a fejüket AMD/Intel oldalon.

- Közben megdrágultak a hw-k plusz beszűkültek a fejlesztési lehetőségek. Tudsz venni csillió TFlops 400W gpu(ka)t és 32-64 magos cpu szörnyeket. Big/little-el sem arra mennek, hogy ebben felfelé tornázzák magukat. Inkább lefelé vagy hatékonyságban fel ugyanabból a keretből.

- És a gyártás is rohadt drága. Ott sem várható, hogy ami nem fejlődik az majd kijön 2 év múlva jobb gyártással 1.5x gyorsabb kivitelben. -

fatpingvin

addikt

öö azért az nem egészen ez volt. a TMC prociknak volt egy "meta-utasításkészletük", és azt hogy ez konkrétan hogyan fordítja a proci lényegében egy hardveres ISA emulátoron keresztül, azt határozta meg a mikrokód. pl lehetett rajtuk Java bytecode-ot is futtatni kvázi natívan, amennyiben olyan mikrokódot töltöttél be ami lényegében egy JVM-et valósított meg.

-

ricsip

addikt

válasz

fatpingvin

#1

üzenetére

fatpingvin

#1

üzenetére

Transmeta Crusoe néven 2000-ben már kijött egy ilyen, és csúfosan meg is bukott.

-

Graphics

Jómunkásember

válasz

Armagedown

#10

üzenetére

Armagedown

#10

üzenetére

Hiába a jövő a mobilokban, ha ott is csesznek az optimalizálásra...

-

-

#90088192

törölt tag

És mi van akkor, ha az FPGA-t arra használják fel hogy szoftver defined hardware alapon adják meg a magok tulajdonságait?

-

siva

aktív tag

válasz

#25954560

#35

üzenetére

#25954560

#35

üzenetére

Én inkább pont fordított irányba mennék el. Chiplettes megoldásban könnyebb egy procra több magott rakni, de így ha teljesítmény kell, elég sok pazarolodik el. Vannak feladatok ahol a többszálosítás nem lehetséges. Ezért inkább valamiféle sinrendszerrel a magokat összekötve kifele kevesebbet mutatva, rá lehesen tolni egy-egy programszálat. Lassan a CPU-knál oda jutunk mint a GPU-knál több ezer feldolgozóval.

-

Sanya

nagyúr

SZerintem meg olyan procik kellenének, amik:

lennének olyanok, amiben csak 2db gyors mag van, 2 lassú, és ezeket elkombinálhatnánk egy darabig.

2+2, 2+4, 2+6, 2+8, 4+2, 4+4, 4+6, 4+8, 6+2,6+4, 6+6, 6+8, 8+2, 8+4, 8+6, 8+8 16db)De, hogy ne legyen ilyen egyszerű a helyzet, és legyen kisfogyasztású játszani, meg nagyfogyasztású facebookozni, minden proci 800-2000Mhz-es sebességről indulva lehetne erősebbeket kapni, de csak 100mhz-es lépcsőkkel:

2000-től mondjuk 4000-ig skálázódnának a konzum procik ( sebességhuszároknak, akiknek a megaherc számít, más semmi, nekik lenne egy special edition 6ghz-el, de az nem tudna mást, csak azt) ez lenne vagy 20 különböző konfig.Na akkor utasításkészletek, extrák:

FPGA benne-nincs benne

HT benne-nincs benne

avx512 benne-nincs benne

cache növekedés 2 megabyteonként 32-ig,

virtualizáció támogatása igen-nem

ez összesen 24 különböző változatösszesen lenne akkor 20*24*16 különböző AMD proci. De jó lenne. 7680 különböző CPU csak 1 évben!

-

S_x96x_S

addikt

-

#25954560

törölt tag

válasz

fatpingvin

#1

üzenetére

fatpingvin

#1

üzenetére

az intel par eve felvetette, legyartottak par minta procit, vegul arra jutottak h abban a formaban nem kell senkinek, szoval nem lett belole vegleges termek.

pl anandtech leiras

lehet az AMD ugyesebben all neki, nem lesz ennyire lekorlatozva vagy hasznosabb funkciokat enged az fpga-ra tolteni, esetleg nem egy rettenet korulmenyes es limitalt keszlet lesz, amibol valogatni lehet... -

hokuszpk

nagyúr

"hogy hogy ismeri fel? "

siman. megfordítod a ht-t. ( ami ebben a koncepicoban nincs. )

ugye most az van, hogy ha a fő szálnak nincs meg a vegrehajtashoz valamilye (adata // de nem a cég // ), akkor mehet a ht szál.

ha megforditjuk, akkor amelyik virtualis maghoz minden rendelkezesre all, es van szabad vegrehajto, akkor kezdhet dolgozni a vegrehajtoegyseg.

mondjuk mar tovabb is fejlesztettem az otletet, es mondjuk csak maximum 40 virtualis magra lehetne osztani a procit, es nem 1, hanem 2 vegrehajto/virtualcpu az alap, a maradekot meg dinamikusan allokalja.

*** bakker, maris leptem egy generaciot

-

Duck663

őstag

Abban igazad van, hogy hardveres megoldás kell! De ez a virtuális magosztás, hát valahogy nem.

Én inkább valami olyasmit tudnék elképzelni, hogy maga a processzor ismeri fel a folyamatot és annak megfelelően osztja valamerre, és hogy hogy ismeri fel? Mondjuk profilokból. Igaz hogy ehhez az kell, hogy lényegében a GPU-khoz hasonlóan a processzorokhoz is készüljenek majd meghajtók, illetve alkalmazásonként erőforrás kezelő profilok. Kicsit bonyolultnak hangzik, de ezzel 100%-ban a saját kezükben tartják az irányítást.

-

Petykemano

veterán

2-3 éve Coreteks csinált a témában egy videót

Ott mutogat valami ML szoftvert, ami párhuzamosítja az egyébként szekvenciális kódot. Persze kell hozzá néhány futtatás, hogy kiismerje.

És ott van az Intel által 2016-ba. Felvásárolt soft machines VISC.

5 év telt el, lassan kiderül, hogy lufi volt-e. -

hokuszpk

nagyúr

válasz

Petykemano

#21

üzenetére

Petykemano

#21

üzenetére

vizionalok egy megfejtest.

azt mar megtapasztalta az AMD, hogy a szoftveres tamogatas...

na addig aljal vivóállásban, amig az megjön.szóval hardveres megoldas kell.

Mivan, ha a prociban nincsenek klasszikus magok, csak 120 vegrehajtoegyseg, amirol a biosban eldontheted, hogy ez hany virtualismagnak tunjon. ( 1,2,3,4,5,6,8,10,12,15, 20, 30, 40, 60 ? )

ennek megfeleloen virtualis magonkent allokal 1-1 vegrehajtot, a tobbit pedig a terheles fuggvenyeben rendeli az egyes virtualis magokhoz. -

Chaser

legenda

no és akkor all core setup innentől hogy lesz? ( :

külön kicsik, külön nagyok?

vagy ez csak engem érdekel? :dA gyorsítótár növelése és a specializációra tervezi új magjait az AMD

növelésére -

Petykemano

veterán

válasz

Petykemano

#21

üzenetére

Petykemano

#21

üzenetére

-

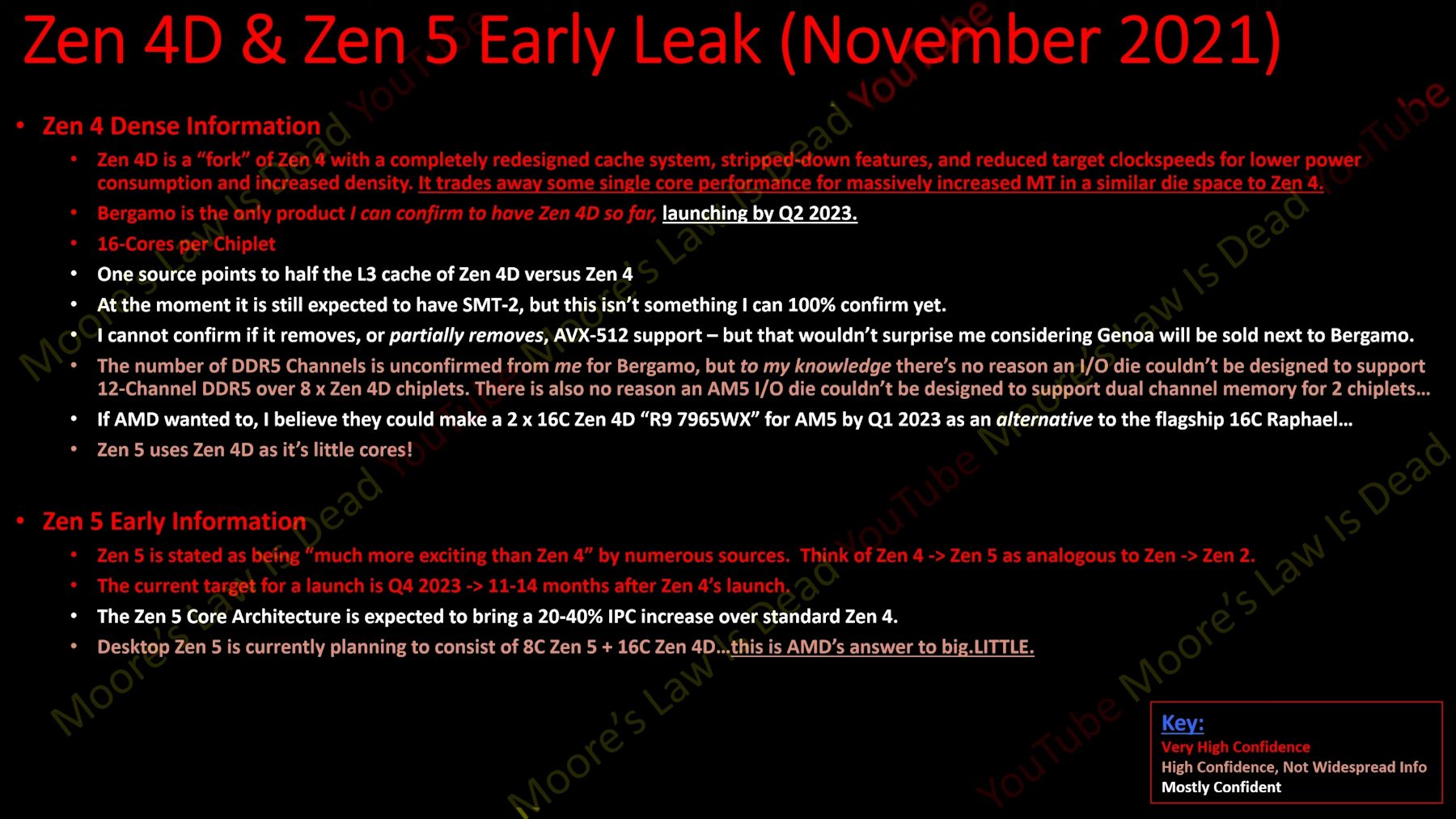

carl18

addikt

Minden esetre nagyon kíváncsi vagyok mit tud majd a Zen 4 élesben, ha igaz a pletyka 30% IPC emelkedést hozhat.

És kíváncsi vagyok az AMD-nél hogy lesz megoldva a több szálas teljesítmény. Az biztos az intel a 13. generácionál is add 8 nagy magot is 16 kis magot.

Az AMD még megoldhatja hogy 24 nagy mag legyen a platform teteje. Szerintem minden vásárlónak szimpatikusabb, mint a 8 kis és 16 gyenge mag felosztás.

És újra eloszthatnák az elnevezések között a magszámot, ami már kiélesíthetné a versenyt.

R3 6/12 R5 8/16 R7 12/24 R7/16/32 R9 20/40 R9 24/48

Én valahogy így képzelem el az AM5 jövőjét, bár tény és való még nincsenek kényszerhelyzetbe hogy kategórián belül magszámít emeljenek. Ameddig kitart a Chiphiány nem is szabad túl sokat várni. -

Petykemano

veterán

Ez a cikk sajnos nekem eléggé neszesemmifogdmegjól.

Bár lehet, hogy ez azért van, mert pár nappal ezelőtt Charlie@S|A is írt cikket erről, hogy az AMD nem a big.LITTLE elgondolás alapján fog hybrid/heterogén magokat készíteni. Részleteket persze onnan sem tudok, mert azt nem tudtam elolvasni.Az korábbi patentből ismeretes lehetett már eddig is, hogy az AMD abba az irányba nézelődik, hogy egy CPU-n belül megvalósítani a "kismag" és "nagymag" funkciókat. Ezt high features-nek és low featuresnek nevezte asszem.

Ez azt a benyomást keltette, hogy végső soron minden mag egyforma lesz, csak a különböző képességek nagyon finomszemcsés módon lesznek lekapcsolhatók és csak indokolt esetben kapcsolnak be, hogy így is csökkentsék a fogyaszást (a fogyasztást, viszont a tranzisztorköltséget nem)

Ez a cikk viszont közös őssel rendelkező, de eltérő mag-designokról szól.Önmagában ezen kívül a cikkben megjelent részletek azt tartalmazták, hogy az AMD eltérő képességekkel rendelkező magokban gondolkodik (pl: integrált FPGA) és sugalmazta, hogy lehetnek eltérő cache mérettel rendelkező magok.

Namost eltérő cache méretekkel az AMD eddig is játszott, csak épp nem egy designon belül. Ugye tudjuk, hogy az APU-k felezett méretű L3$-sel jönnek. És azt is tudjuk, hogy a Zen3D az originalhoz képest 3x annyi L3$-sel fog rendelkezni. Ebből aztán lehet sejteni, hogy a zen magok képesek lehetnek kisebb-nagyobb L2 vagy L3 mérettel is működni. De azért ez sem olyan hatalmas innováció, hiszen a gyári ARM magok esetén is meg van adva, hogy milyen L2$ méretekkel lehet tervezni. Ugyanazt az X1 magot pl a Samsung 512Kb L2$-sel, míg a Google 1MB L2$-sel tervezte.

Itt halkan meg is jegyezném, hogy az ARM big.LITTLE is kétrétű. A klasszikus kis és nagy (ma már közepes) magok valóban nagymértékben eltérő architektúrával rendelkeznek. Viszont az X1 és az X2 inkább csak valamiféle kiterjesztése, bővítménye az ismert A7_ magoknak. Valószínűleg egy kicsit összetettebb kiterjesztés, mint az L2$ méretének tetszés szerinti megválasztása, de azért azt szerintem nyugodtan mondhatjuk, hogy az X_ mag a A7_ kiterjesztése, vagy hogy az X_ mag az A7_ mag spinoffja.

Az lett volna izgalmas / igazán hír, hogy ezt a heterogenitást miképp tervezi az AMD megvalósítani? Merthogy eddig ugye alap koncepció volt, hogy a szerver és a desktop ugyanazt a lapkát használta és az L3$ méretétől eltekintve az APU is gyakorlatilag ugyanazt a core blokkot kapta.

Tehát például különböző célokra különböző lapkákat fog készíteni az AMD, de lapkán (CCX-en) belül ugyanolyan magok lesznek? és akkor mondjuk lesz olyan 8 magos lapka,

- ami erős AVX-512-ben és AMX-ben? (lásd ARM N1, V1, N2)

- A másik típusú lapka erős v-cache-ben?

- A harmadik típusban integrált FPGA van?

- A negyedik típusban kifejezetten kicsik, cache-ek, de ez egyben pici lapkát és alacsony frekvencián működő magokat eredményez?És akkor ebből hogy fognak összeállni a termékek? Jó, persze, a nagyon nagy megrendelők majd maguk válogatnak, hogy milyen összetételt szeretnének, de azért csak kell legyen egy menü. És ebből hogy állhat össze a desktop kínálat? Persze ott nem lesznek speciális igények, de a desktoppal való közösködés lényege az, hogy oda lehet kiszórni a szart.

Vagy: lapkán (CCD) belül valósulna meg a heterogenitás? 8 magból lesz 4, amiben erős az AVX512, lesz 4 normál (kicsi)? vagy lesz 2 mag, ami erős cache-ben, és 6 normál.

Vagy: lapkán belül valósul meg, de különböző CCX-ek formájában? 4 brutál nagy mag, 8 normál?Utóbbi két lehetőséget csak felvetettem. Számomra legtisztábbnak az tűnik, hogy több eltérő feature-settel rendelkező, de lapkán belül homogén magokkal rendelkező CCD-t gyártanak és a heterogenitás akkor valósulhat meg, amikor ezeket összerakod.

A cikk mondanivalójának egyébként szerintem épphogy ellentmond a Zen5 és a kissé módosított Zen4 (zen4D) felemlegetése a Strix pointban. Mike Clark épp most mondta el AT interjúban , hogy az Zen5-től el fogunk ájulni és hogy szélesíteni fogják a Zen magokat.

Ez arról árulkodik, hogy a Zen4D és a Zen5 legalább olyan távolságban lesznek egymástól, mint egy alacsony L2$-sel tervezett A78 és az X1.És itt egy pillanatra visszatérnék a low-feature - high feature résznél tett megállapításomra. Ilyen homogén magok esetén ugye nem kérdés az, hogy az OS hogyan találja mag a szálaknak a megfelelő magot. Mert minden mag egyforma, bármelyik kismagból lehet hirtelen nagymag, ha a folyamat úgy kívánja.

Viszont a cikk eltérő mag designokról szól. Mindenki azért szidja most az Intelt, hogy milyen szar lesz, hogy hogy találja mag az OS a folyamatoknak a megfelelő magot. Ugyanakkor most itt az AMD (pontosabban a cikkíró) sem mondta meg, hogy miképp lesz az megoldva, hogy a heterogén felépítésű CPU magok - jelentsen az kisebb-nagyobb cache méretet, vagy több feldolgozót, stb - közül az OS miképp fogja megtalálni az adott folyamat számára megfelelőt.Kivéve persze, ha arról van szó, hogy az AMD eltérő képességű magokkal gyárt CCD-ket, de egy SKU-ban mindig azonos felépítésű magok lesznek. Erről viszont épp a Strix point (zen5 + Zen4D) miatt nem lehet szó. Tehát ha a zen5 és a zen4D között nincs is 2x-es különbség, azért mondjuk az talán elvárható lenne, hogy egy hely és energiatakarékos Zen4D változathoz -hez képest 50, vagy akár 60%-kal tudjon gyorsabb lenni a Mike Clark szerint ámulatba ejtő zen5. Az meg már megint nem olyan kicsi különbség, hogy ne lehetne morogni azon, hogy az OS miképp választja meg megfelelően a szálakhoz a magokat.

-

arn

félisten

Nem biztos… en olyasmire tippelnek, hogy chipletenkent lesznek felosztva a funkciok, es az egyik blokk tud mittomen avxet, a masik meg nem. Vagy az sem lenne elvetelt otlet, hogy kiforditjak a littlebig koncepciot, es pl van egy orajelre kihegyezett blokk par szalhoz, meg egy normal. Szvsz van ebben fantazia, ha okosan sakkoznak.

-

Picco

addikt

Pl win alatt mi a töknek megy perpill nekem 8 fullos mag összesen 25w fogyasztással (SoC undervolt), ha ezt az erőt egy kis pöcsköszörű alulfeszelt i3 is tudná?

AMDnek nincs akkora piaci reszesedese/gyartokapacitasa hogy rakenyszeruljon az osszes fejleszto az optimalizalasra ha eloall egy big.little koncepcioval. ha csak a 100 leggyakrabban hasznalt program + winfost nezzuk mar ahhoz iszonyat munkaora kellene...hacsak meg nem oldjak egy hardveres utemezovel

en elobbire semmi eselyt nem latok, utobbira meg nincs ralatasom hogy lehetseges e -

tasiadam

veterán

Hát emlékszem amikor képbe gyüttek, még csak S4-em volt, az erősebbik 2.3ghz-s. Na ott mind a 4et elvitte a kamera. Most note 9em van, asszem ebben 6 kicsi 2 nagy, és a 2 nagy csak akkor aktivizálja magát ha valami tényleg komoly dolog megy, mint pl játék, ami nincs. Szóval 2 mag üresen áll kb, akkor meg persze besegít, ha kérem az AI-t meg HDR-t a kamerának. Nem rossz ez, ha rendesen meg van csinálva. Pl win alatt mi a töknek megy perpill nekem 8 fullos mag összesen 25w fogyasztással (SoC undervolt), ha ezt az erőt egy kis pöcsköszörű alulfeszelt i3 is tudná?

Ha játszom, menjen a nagy, ha win10 megy, menjen a kicsi. Ha háttérfolyamat kell, menjen a kicsi.

Itt a munkás laptopot, 4 "erős" maggal (i7 10610u). Ha kapnék 2 erős magot és mellé 4 gyengét, az üzemidő duplázódna, mert nagyon ritkán van kihasználva az ejere, akkor boldogan halnék meg. -

sb

veterán

Desktopon is van, bár kisebb. Ott beszéltünk róla, hogy azért ha nagy a különbség perf/W-ra több gyenge mag javára akkor hatékonyságban lehet előnye inkább mint takarékosságban.

(Consumerben eléggé elértük a tetejét a használható fogyasztási szintnek. 150W-ból 16 mag még elég jó de már rég itt vannak a 32-64 magos procik. Ebbe az irányba viszont már nehéz lesz lépni és átlagusernek eladni, hogy erre van szüksége.)Ettől erősebb érv, hogy az utóbbi 10-15 év a mobil és ultramobil felé mozdulásról szólt szinte teljesen. Most a legjobb példa az M1 Pro/Max. Ha belefér notiba a power desktop akkor sokaknak elég lesz. Ahogy a telefon is elég lett sok noti helyett.

@HSM

A Renoir(Lucienne)/Cezanne esetén tulajdonképpen sikerült nekik megoldani. Max 15-20W-ból igen fürge 8 magot kapsz. A többi igazából a szoftveren és a használaton kívüli részegységek lekapcsolgatásán múlik. Pl. egy 5800U-nak szvsz nincs különösebb szégyenkezni valója az M1-ek mellett sem.

Nagyon hatékonyak "lent" is a magok és itt nincs meg az a 10-20W-os overhead a monolitikus felépítés miatt. De azért a big-littleben van még tér lefelé is és hatékonyságban, lásd feljebb. -

dokanin

aktív tag

válasz

Armagedown

#10

üzenetére

Armagedown

#10

üzenetére

Mert a mobiloknál van értelme.

-

hokuszpk

nagyúr

válasz

Armagedown

#10

üzenetére

Armagedown

#10

üzenetére

kiveve, ha az AMD eltero megoldasa (s|n)em bizonyul zsakutcanak.

szvsz a big/little a zsákutca, marad a "fejleszto draga, a megfelelo prociteljesitmenyt majd az user kifizeti" cimu nóta, amivel az AMD mar megjarta egyszer. Lehet az Intel piaci ereje eleg lesz atnyomni, hogy valami uj monkeyboy a "developers developers" mantra helyett "optimization optimization" szlogennel ugraljon a szinpadon, de valahogy ezt nemlátom magam előtt, pedig igen széles spektrumban látok

-

CPT.Pirk

Jómunkásember

válasz

Armagedown

#10

üzenetére

Armagedown

#10

üzenetére

Kétlem. Az Intel megoldása a szoftveres támogatás szükségessége miatt elég problémás, de majd a tesztekben meglátjuk mennyire.

Én jelenleg nem látom az értelmét PC oldalon a little magoknak, ellenben a nagy L2 és L3 cache annál inkább tetszik. Mind játék, mind munka szempontjából nézve.

-

HSM

félisten

"Kivéve, ha megoldják azt, amit eddig senki sem tudott: ugyanaz a mag tud keveset is fogyasztani és gyors is lenni. _marhára kételkedő szmájli_"

A Renoir(Lucienne)/Cezanne esetén tulajdonképpen sikerült nekik megoldani. Max 15-20W-ból igen fürge 8 magot kapsz. A többi igazából a szoftveren és a használaton kívüli részegységek lekapcsolgatásán múlik. Pl. egy 5800U-nak szvsz nincs különösebb szégyenkezni valója az M1-ek mellett sem. -

Armagedown

őstag

Ha kihagyja az AMD a BigLittle designt, akkor nagyon le fog maradni.

Ez lehet a jövő, a mobiloknál már bevált. -

Picco

addikt

ugy tunik amugy mostanaban okosabban taktikaznak, remelem nem tevedek, jo lenne ha az elmult par ev fejlesztesei utan nem jonne megint 5-10 ev alloviz.

regebben sokszor ok jottek ki radikalisabbnak mondhato fejlesztesekkel amit az intel tovabb fejlesztett es/vagy a piaci egyeduralkodasa kvazi "rakenyszeritette" a szoftver fejlesztoket az optimalizalasra.

-

Ez egyelőre nem sok infó.

Gondolom, marha sokféleképpen lehet ezt majd csinálni.

Nem tudjuk, hogy mit lehet majd letiltani, meg engedélyezni az okos/buta magoknál.Szóval majd ráérünk dícsérni vagy szidni akkor, amikor tudjuk, hogy miről is van szó pontosan.

Feltételezem, hogy az AMD is lő majd valahogy az energiahatékonyságra, ha nem akarja elbukni a laptop téren nagy nehezen megszerzett pici kis részesedését is.

Kivéve, ha megoldják azt, amit eddig senki sem tudott: ugyanaz a mag tud keveset is fogyasztani és gyors is lenni. _marhára kételkedő szmájli_Én nagyon drukkolok, de méginkább annak, hogy az Apple M1* utódait utolérjék energiahatékonyságban. _kételkedő de azért nagyon reménykedő szmájli_

-

tasiadam

veterán

AMD be like: az intel csinalt HT, mi akkor fizikai tobbszallasitast fogunk

AMD kicsit kesobb; joszar lett, lesz nekunk is HTCsak nehogy ez legyen itt is

-

jerry311

nagyúr

Volt már ilyen merész terve az AMD-nek.

El is bukott.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

dokanin

aktív tag

Hát ez az irány nekem jobban tetszik, mint az alder.

-

hokuszpk

nagyúr

igazabol az AMD "kismagnak" odaragaszthana masodiknak ( harmadiknak ) egy rosszabbul sikerult chipletet, smt letiltva, 3.5 - 3.7 Ghz korul maximalt frekivel, abban a magassgban meg eleg takarekos a Zen core.

-

sb

veterán

Ez elég merész, nehéz lesz kihasználni. Gyanítom inkább szerverre céloznak első (és második

) körben, nem desktopra.

) körben, nem desktopra. -

Cythyel

senior tag

nekem valahogy jobban tetszik ez a fajta specializálódás mint amit az intel és az arm csinál, persze azoknak is megvan a logikájuk és arm esetén működnek amióta nem big.little hanem dynamic.iq lett, intel esetén meg elválik...

-

fatpingvin

addikt

FPGA a prociban, ez nagyon érdekes. akár azt is elképzelhetőnek tartom hogy a proci on the fly átkonfigurálja magát, persze csak egy későbbi fejlesztési pontként

Új hozzászólás Aktív témák

- 5.1, 7.1 és gamer fejhallgatók

- Bluetooth hangszórók

- OLED TV topic

- Google Pixel 10 Pro XL – tíz kicsi Pixel

- Kerékpárosok, bringások ide!

- Google Pixel topik

- AMD Ryzen 9 / 7 / 5 7***(X) "Zen 4" (AM5)

- Nintendo Switch 2

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Dell asztali gépek

- További aktív témák...

- Intel Core i9-12900K 16-Core 3.2GHz LGA1700 (30M Cache, up to 5.20 GHz) Processzor!

- Intel Core I9 14900F - 24mag/32szál - Új, Gari 2030.08.27. -ig - Eladó!

- Intel Core Ultra 7 265K - Új, Gari 2028.09.27. -ig - Eladó!

- AMD Ryzen 7 9700X - Új, 3 év garancia - Eladó!

- AMD Ryzen 5 7600X BOX - Új, 3 év garancia - Eladó!

- HIBÁTLAN iPhone 13 mini 128GB Starlight -1 ÉV GARANCIA - Kártyafüggetlen, MS3334, 94% Akkumulátor

- DDR5 8/ 16/ 32GB 4800-5600MHz SODIMM laptop RAM, több db- számla, garancia

- BESZÁMÍTÁS! Gigabyte H610M i5 12400F 16GB DDR4 512GB SSD RX 6600 XT 8GB AEROCOOL Aero One Frost 700W

- BESZÁMÍTÁS! Gigabyte B650M R5 7600X 32GB DDR4 1TB SSD RTX 4080 16GB Zalman Z1 Plus Seasonic 750W

- HUAWEI MateBook 13 2020 - Kijelző nélkül - I7-10510U - 16GB - 512GB SSD - Win11 - MAGYAR

Állásajánlatok

Cég: CAMERA-PRO Hungary Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Akkor nem lenne értelme.

Akkor nem lenne értelme.

via :

via :

![;]](http://cdn.rios.hu/dl/s/v1.gif)