-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Alogonomus

őstag

válasz

tisztelturam

#56654

üzenetére

tisztelturam

#56654

üzenetére

és mvkly

Pont ezt írtam én is: "Ráadásul a táblázatot úgy kell olvasni, hogy az RTX 2080 Ti nem egy 4K90fps kártya, az RTX 3090 pedig nem 4K120fps kártya, hanem ahogy a CP:20770 eredmények is mutatják, medium beállítás mellett is a csúcs Turing egy 1440p80fps és 4K40fps kártya, míg a csúcs Ampere egy 1440p120fps és 4K70fps kártya. Vagyis 2022 végén az RTX 3090 egy akkor megjelenő játékokhoz 1440p100fps vagy 4K60fps kártya lehet majd."Az fps számok játékról játékra eltérnek. A kártyák egymáshoz viszonyított várható erőviszonyait jelzi csak a táblázat.

-

Alogonomus

őstag

Megint írni kezdtél az első pillanatban, pedig végig kellene olvasnod a hozzászólásokat. Írtam, hogy "Amennyiben az Nvidia szintén előránt valahonnan legalább 60-80% sebességnövekedést, akkor továbbra is versenyben maradhat...".

Szóval én is úgy vagyok vele, hogy ha igazak az RTX 3090x2 Lovelace pletykák, akkor nem lesz bálványdöntés, de MLiD Tom nem szokott tévedni, és szerinte a Lovelace nagyjából 60-80%-ot tudhat gyorsulni, amit esetleg 100%-ig elhúzhatnak "insane power usage" esetén. Vagyis a "legalább 60-80%" az nagyjából a maximumot is jelölheti a Lovelace esetén, ha nem egy mondjuk 600-800 wattos szörnyet nézünk, amit te is jósolsz a "Ráadásul szerintem Nvidia ezt majd fokozni fogja, csak hogy övék legyen a trón egy MCM Hopper alapú Titan kártyával ami hozza az RDNA 3 csúcsot vagy felette lesz tippre 5000+$ körüli áron.ez sem érdekli a piacot úgy általában" mondatoddal. -

Alogonomus

őstag

válasz

Yutani

#56638

üzenetére

Yutani

#56638

üzenetére

Nekem pedig sokszor az az érzésem, hogy sokakban nem tudatosul, hogy az AMD elég sok területen van jelen egyszerre, és folyamatosan próbálja a lehetőségeit optimálisan kihasználni. Az otthoni játékra szánt gyorsítókártyák egyáltalán nincsenek az AMD prioritásai között, ezért is jelennek meg az új technológiák (MCM, 3D V-Cache) először a CPU-k területén, ami aztán átszivárog a gyorsítókártyákba is. Az Nvidia ezzel szemben lényegében csak a gyorsítókártyáiból él, ezért azokra fókuszál.

Az AMD a gyártási kapacitásait nem a VGA-kra használja el, mert a konzol APU és a Zen3-as CPU több hasznot hoz. A workstation CPU-kra elhasznált kapacitást elhasználhatták volna GPU-kra is, és akkor sokkal jobban állnának a GPU eladások területén, de többet ért az AMD számára például az Intel 60:40 arányú beelőzése a prebuilt rendszerek egy fontos területén. -

Alogonomus

őstag

válasz

Busterftw

#56632

üzenetére

Busterftw

#56632

üzenetére

Hát hogy melyik gyártó kártyáiért fognak sorban állni, az kérdés

A leak alapján csak az tippelhető, hogy az RDNA3/Lovelace váltás még az RDNA2/Ampere váltásnál is nagyobb ugrást jelent majd. Amennyiben az Nvidia szintén előránt valahonnan legalább 60-80% sebességnövekedést, akkor továbbra is versenyben maradhat, ellenkező esetben viszont előáll a Polaris/Vega vs Pascal, vagy RDNA1 vs Turing helyzet, amikor csak a felsőközép-kategóriáig volt valódi verseny, a csúcskártya pedig annyiért mehetett, amennyit nem szégyellt kérni érte a gyártó/összeszerelő/eladó hármas közül bármelyik. Abban az esetben pedig valószínűleg az AMD is nagyon ráfeküdne a piac letarolására, vagyis nem tolná a fontossági sor legvégére a GPU ellátást.

Ráadásul a táblázatot úgy kell olvasni, hogy az RTX 2080 Ti nem egy 4K90fps kártya, az RTX 3090 pedig nem 4K120fps kártya, hanem ahogy a CP:20770 eredmények is mutatják, medium beállítás mellett is a csúcs Turing egy 1440p80fps és 4K40fps kártya, míg a csúcs Ampere egy 1440p120fps és 4K70fps kártya. Vagyis 2022 végén az RTX 3090 egy akkor megjelenő játékokhoz 1440p100fps vagy 4K60fps kártya lehet majd. -

Alogonomus

őstag

válasz

KillerKollar

#56595

üzenetére

KillerKollar

#56595

üzenetére

A konzolokon szinte minden játék dinamikusan változó felbontással működik, hogy a célként meghatározott fps folyamatosan meglegyen az adott kimeneti felbontás mellett. A konzolok az upscaling eredeti célterepe. Egy erősebb konzol esetén pedig ritkábban kellene a 4K helyett akár FHD szintig visszaváltania egy konzolnak, hogy tartani tudja a célként meghatározott mondjuk 120 fps értéket az adott játékban. Az új drágább konzollal végeredményben szebb képminőséget kapna a felhasználó.

-

Alogonomus

őstag

válasz

KillerKollar

#56576

üzenetére

KillerKollar

#56576

üzenetére

Legnagyobb hiányként az MMO-k nem jönnek ki konzolokra. Az RTS-ek népszerűsége már inkább hanyatlóban van.

A Decima motoros játékoknál, mint a Horizon: Zero Dawn pont megjelent egy lényeges grafikai ugrás a PC-n megjelenéshez. Az eredeti konzolos szint az a közepes beállítási szintnek felel meg, fölötte pedig van még két minőségi szint. -

Alogonomus

őstag

válasz

KillerKollar

#56574

üzenetére

KillerKollar

#56574

üzenetére

Bizonyos játéktípusok eleve nem érkeznek konzolokra, de amikből érkezik konzolokra is játék, abból a típusból is sokkal nagyobb a választék PC-n. Aki csak akármivel, de játszani szeretne, annak tökéletes lehet a konzol, de a játékosok jelentős részének nem megoldás a konzol, így azok mindenképpen eltartják a PC gaming piacot.

És persze igaz az is, amit te is leírtál, hogy a konzolok most még nagyjából jó teljesítményt nyújtanak (RTX 3070 és RX 6800 XT közötti kategória effektív teljesítményt), de egy 2022-ben összerakható komolyabb gaming PC-vel szemben valószínűleg már játékteljesítményben sem lesz esélye egy konzolnak.

A konzol pár exkluzív címre vágyó játékos esetétől eltekintve régen is a kompromisszum/megalkuvás eredménye volt. Ezért is fogadták el a konzolosok például a 30 fps melletti játékot, míg PC-n 60 fps alatt már tikkel a játékosok szeme, és ideálisnak a 120 fps fölötti üzemelést tekintik. -

Alogonomus

őstag

válasz

#32839680

#56519

üzenetére

#32839680

#56519

üzenetére

Na a TSMC 10%-os áremelése még a CPU tekintetében sem okozhat 10%-os áremelkedést, míg a kártyáknál maximum 1-2%-ot jelenthet majd. A CPU sem csak a TSMC chipből áll, a kártya pedig túlnyomó részben nem a TSMC termékeiből áll.

A TSMC áremelését úgy kell kezelni, mint ha egy vasmű jelentene be áremelést. Emelkedne valamennyit egy autó előállítási költsége, de messze nem csak fémből áll egy autó. -

Alogonomus

őstag

válasz

huskydog17

#56503

üzenetére

huskydog17

#56503

üzenetére

Köszönöm a magyarázó kifejtést b. kolléga számára.

Annyiban nem egyezik a véleményünk, hogy az AMD nem adta föl az Nvidia elleni küzdelmet, csak a processzorok - még a jelenlegi játékkártya-árak mellett is - sokkal nagyobb haszonkulccsal adhatóak el, ezért RDNA2 chipek helyett Zen3 chipeket rendelt a TSMC-től. Processzorok terén nincs is már komoly hiány a piacon.

Annyit pedig hozzátennék még a magyarázatodhoz, hogy az Intel nem is csak a gyorsítókártyák irányából készül támadni a közeljövőben, hanem a processzorok irányából is, sőt ez utóbbiba valószínűleg sokkal több energiát is fog fektetni, mert a processzorok piaca sokkal jövedelmezőbb, ezért ott inkább szeretné visszaszerezni a teljesítménytrónt, míg a gyorsítókártyák csak a portfólió teljessé tételéhez kellenének az Intel számára.

-

Alogonomus

őstag

válasz

tisztelturam

#56500

üzenetére

tisztelturam

#56500

üzenetére

Hát ez most tényleg nekünk játékosoknak igazán gond, mert a piaci felhasználókat annyira nem zavarják az árak, maximum ők is árat emelnek a munkáiknál, a gyártók köszönik örömmel emelnek árat, meg a kereskedők is örömmel árulják a kártyákat extra haszonnal.

Ráadásul a hírek szerint tavaszig nem is nagyon fog javulni a helyzet, mert milliónyi játékos vár még kártyára, így amint kicsit lemennének az árak, azonnal elkapkodják az olcsóbb kártyákat, és megint hiány keletkezik. Ezt láthattuk is a 180 ezres 6600 XT kártyáknál, amikből hiába volt jelentős mennyiség, azt is felvásárolták. Ráadásul a karácsonyi szezon közeledtével az árak pont feljebb szoktak menni, mert sok gyereknek például biztosan megígérték a szülők az újkártyát egy jó tanulmányi eredményért. Ja meg a karácsonyi prémium is sokakat költekezésre csábít. -

Alogonomus

őstag

válasz

tisztelturam

#56497

üzenetére

tisztelturam

#56497

üzenetére

Teljesítményben ott van az RDNA2 széria az Amper szériával minimum egy szinten;

"húzhatóságban" még jobbak is, sőt az N6 csak javítani fog ezen;

a következő generációra pletykált 5120-15360 shader egység pedig lényegében overkill lenne a jelenlegi játékokhoz, hacsak nem legalább 4k-ban játszanának majd a vásárlók milliói. Ahhoz pedig nincs még elég 4k 120+ Hz-es megjelenítő az otthonokban.Amíg az Nvidia nem lép át Lovelace alapokra, addig az AMD inkább az Intel ellen készül, mert abból az irányból komolyabb támadásra számíthat a következő 6 hónapban.

-

Alogonomus

őstag

válasz

Yutani

#56481

üzenetére

Yutani

#56481

üzenetére

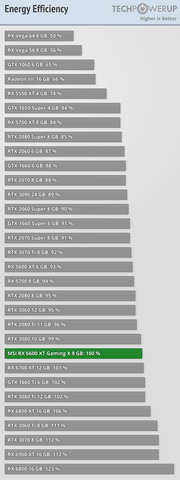

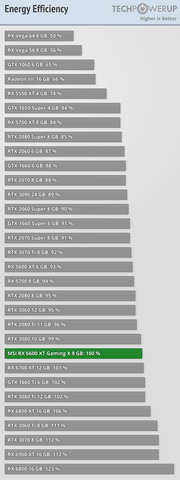

Igen, a korábbi AMD kártyáknak rettenetesen rossz volt az energiahatékonysága. Még a mostani Ampere kártyákat is bőven alulmúlták. Akkor jogosan is ekézték a Polaris/Vega/RDNA1 kártyákat, mert a teljesítményükhöz képest nagyon fűtötték a gépházat. Ebben a generációban pedig fordult a helyzet, és azzal a jogos ekézés iránya is megfordult.

-

Alogonomus

őstag

Elfogadom a kötődésedet, de a tények attól tények, és hiába hozod fel számodra ideális példaként a 6600 XT fogyasztását, ha az a 3060-hoz hasonló fogyasztási érték mellett 137 fps elérésére képes, míg a 3060 csak 119-re elég.

Egyébként pedig az általam említett "túlfeszültséges" esetek a komolyabb teljesítményű 3080-as és 3090-es kártyáknál jelentkeztek, amik a második lista alapján is észrevehetően a hatékonysági görbéjük leszálló ágáig vannak erőszakolva, hogy "versenyben maradhassanak" a 6800-as és 6900-as kártyákkal. Aztán ezt a "megerőszakolást" nem mindegyik alkatrész tudja stabilan elviselni a kártyákon, és lehet garanciáztatni, vagy új BIOS-szal visszább venni a kártyák teljesítményét.

-

Alogonomus

őstag

válasz

Petykemano

#56475

üzenetére

Petykemano

#56475

üzenetére

Én nagyon örülök, hogy az AMD elengedte a FineWine technológiát, és különválasztotta a termékeket RDNA és CDNA vonalra. A FineWine technológia csak arra volt jó, hogy az AMD kártyák sokkal jobban tartották az értéküket, de újkorukban nem voltak csábítóak az Nvidia aktuális igényekhez tervezett, aztán hamarabb kiöregedő kártyáihoz képest.

Pont ugyanaz volt a helyzet, mint a mobiltelefonok terén, ahol egy neves nyugati gyártó évekig működő és támogatott készüléke helyett egy Xiaomi/Honor/Doogee telefont vesznek az emberek, mert az a vásárlás pillanatában olcsóbban adja ugyanazt a teljesítményt, bár a második évében valószínűleg tönkremegy, de addigra úgyis lecserélik ugyanannak a kínai gyártónak az aktuális modelljére.

Az AMD több RDNA2-es kártyája egyébként továbbra is tartalmaz valamennyi FineWine technológiát a nagyobb memória, és a konzolok AMD alkatrészeiből eredő előny kapcsán. Elég csak azt nézni, hogy a direkt Nvidia specifikációra megírt CP 2077 annyira csapnivaló teljesítményt nyújtott a konzolokon, hogy a Sony "kidobta" az áruházából. A konzolra is kiadni tervezett játékokat mindenképpen az AMD specifikációkhoz kell hangolniuk a kiadóknak, ha komolyabb eladásokat szeretnének elérni.

Ja meg persze az is egy FineWine tulajdonság, hogy az AMD kártyákban a kisebb fogyasztásuk miatt jelentősen kisebb áramerősségek "keringenek", ezért sem az Ampere kártyák kezdeti POSCAP problémája, sem a most nyári elpukkanó MOSFET és biztosítékproblémák nem érintik, nem használják el annyira gyorsan az alkatrészeiket, meg a gépházat sem fűtik be nagyon. -

Alogonomus

őstag

válasz

Petykemano

#56456

üzenetére

Petykemano

#56456

üzenetére

Több helyen is emlegették, hogy a high end chipgyártás kapacitását végső soron az ASML kapacitása határozza meg, mert az ASML gyártja az EUV levilágító készüléket minden piaci szereplőnek. Komoly licitháboró van az ASML készülékeiért, és valószínűleg az AMD is próbálja megoldani a termelést EUV nélkül, ahol csak lehet, mert a még 7 nm-en működő gyártósor waferárai valószínűleg határozottan alacsonyabbak a TSMC árlistáján, mivel ahhoz még nem kell egy aranyárban vesztegetett ASML levilágító.

-

Alogonomus

őstag

Az AMD a Navi 21 alatti kártyákat nyilván gyártásban fogja tartani, és valószínűleg nem is viszi át az új 6 nm-es gyártósorra, mert az a Zen4 és RDNA3 termékekhez kell majd. Egy kicsit optimalizált 7 nm-en készülő RDNA2 kártya még évekig elég lehet FHD és WQHD felbontáshoz, 4k 144Hz, vagy WQHD 240 Hz monitorok pedig még nem annyira elterjedtek. Ha a Zen3 helyett is RDNA2 készülhet majd, akkor lesz talán esély kiszolgálni a vásárlói igényeket.

A Navi 1x kártyákat is csak azért kaszálta el az AMD, mert ugyanaz a gyártósor kellett a jövedelmezőbb Navi 2x chipekhez (meg CPU, meg konzol APU). A Navi 3x bemutatkozása után is simán készülhetnek még 7 nm-en Navi 2x chipek. A tömegek valószínűleg egyébként sem az akárhány ezer dolláros MCD kártyákat fogják keresni. -

Alogonomus

őstag

-

Alogonomus

őstag

Azért azt is vedd hozzá, hogy a 2 évvel ezelőtt bemutatott 5700 XT szinte ugyanezt a teljesítményt tudta szinte ugyanezen az áron. Ráadásul az 5700 XT magasabb felbontásra is jó (sőt jobb), mert a 6600 XT 1080p fölött elvérzik a csak 32 MB Infinity Cache miatt. Persze a 6600 XT takarékosabb kártya, meg már képes sugárkövetést számolni, de utóbbit ugyanúgy értelmetlen bekapcsolni vele, mint egy 2060 vagy 3060 változatnál.

Szóval egyáltalán nem jó a 6600 XT ár/érték aránya az előző generációhoz képest, viszont így is kedvezőbb vétel, mint egy drágábbként is gyengébb 3060, vagy kicsit erősebbként masszívan drágább 3060 Ti.

A 6600 XT egy olyan kártya, amivel az AMD tökéletesen kihasználja az Nvidia magasabb előállítási költségből eredő hátrányát. -

Alogonomus

őstag

Az olcsó 1080p 60 fps kártyákat keresők egyedül az Intelben bízhatnak, hogy az a piacszerzés érdekében ugyanúgy olcsón fogja piacra dobni a kártyáit, ahogy az AMD tette az RDNA2 sikeréig.

-

Alogonomus

őstag

válasz

GeryFlash

#56255

üzenetére

GeryFlash

#56255

üzenetére

Az RX 6800 kategóriájában bő egy év múlva az a 8 GB kevésbé komolytalan tipp, mint az RTX 4090-et kihívó RX 7900-en a 12 GB. Na a minimum 4k-s kártyára tényleg több memória kellene.

Az RX 6900 TDP pedig egyenesen hibásan szerepel, de teljesítményben is túlzás, hogy 3 százalékkal az RTX 3090 előtt lenne. Komolytalan a táblázat, és még AMD irányultságúként sem örülnék egy olyan helyzetnek, ahol egy 480 wattos RTX kártya kell a 300 wattos RX kártya ellen. Egy Vesuvius elég volt. -

Alogonomus

őstag

válasz

#32839680

#56245

üzenetére

#32839680

#56245

üzenetére

Ráadásul az is megütötte a szememet, hogy az Intel esetén "planned" szerepel, míg az Apple esetén "using". Elképzelhető, hogy az Intel csak "tervezi", hogy majd ha egyszer a "tervezés" "valósággá" válik, akkor mennyit rendelne.

Aztán persze ez már kicsit szőrszálhasogatás is lehet a részemről, és talán csak a cikkíró próbálta kicsit változatosabbá tenni a mondatot a szerinte szinonimáknak tekinthető kifejezésekkel. Mindenesetre sokáig az volt a hivatalos álláspont a TSMC részéről, hogy ha az Intel csak rövid ideig tervezi használni a TSMC gyártósorait, akkor az Intelnek nem ad kapacitást, hanem majd várjon az Intel a többi megrendelő után maradó fölös kapacitásokra. -

Alogonomus

őstag

válasz

#32839680

#56242

üzenetére

#32839680

#56242

üzenetére

A Nikkei azért szerényebben fogalmazott.

"Currently the chip volume planned for Intel is more than that for Apple's iPad using the 3-nanometer process"

Vagyis az Intel által befoglalt mennyiség az Apple tabletekben használt mennyiségét haladja csak meg. Az Apple pedig jelentősen több telefont és laptopot gyárt, mint tabletet. Szóval tippre az Apple mennyiségének a 20%-ánál lehet több a teljes Intel mennyiség. -

Alogonomus

őstag

válasz

GeryFlash

#56237

üzenetére

GeryFlash

#56237

üzenetére

A végfelhasználóknak leszállított konzolok is sok hónappal korábban készülnek. Amelyik Stean Deck 2022 Q3-ban kerül kiszállításra, annak a chipje valamikor 2022 Q1-ben készül el a TSMC gyártósorán. A nyers chip is sok összeszerelési fázison megy még át valahol a bolygónkon, aztán valahol a bolygónkon még össze is kell szerelni az alkatrészekből a kézikonzolt, majd onnan sem repülővel szállítják szét, hanem konténerhajókkal, és még például itt Európában is több hét telhet el, mire a hajóról lerakodott kézikonzol a vásárlóig eljut.

@ morgyi

Még ha nem is a konkrét fizikai vonalvastagságot jelöli, de az N6 az EUV levilágítás miatt elvileg sűrűbb kialakítást tesz lehetővé, vagyis ugyanabból a szilíciumkorongból több chip jön ki N6 technológiával, mint N7 technológiával. Ez pedig a kapacitást növeli, mert ugyanabból a korongból így több chip lesz. -

Alogonomus

őstag

válasz

Petykemano

#56215

üzenetére

Petykemano

#56215

üzenetére

A PCIe5 valószínűleg nagyságrendnyi ugrást jelentene a késleltetésben, de a sávszélessége sem az onboard GDDR6 szintjén van, ami 128 bit esetén a PCIe5 x16 128 GB/s sebességének legalább a duplája lenne.

Az FSR viszont reális magyarázat, bár annál is csak az Ultra Quality ad még éppen szép képminőséget. -

Alogonomus

őstag

válasz

Petykemano

#56209

üzenetére

Petykemano

#56209

üzenetére

Az a 8 GB nagyon kevésnek tűnik annak fényében, hogy a csúcs RDNA 3 kártyák is csak valamikor jövőre érkeznek, így az RDNA 3 belépőszintű modelljei már valószínűleg átcsúsznak 2023 elejére, és 2023 elején a 8 GB már nagyon szűk lehet.

Akkor már jobb választás lesz egy addigra már pár éves N22 alapú RX 6700 XT már kedvezményes áron, mert hiába lesz az új kártyának akár RX 6800-as ereje, ha a memóriakapacitás miatt úgyis csak az FHD marad lehetőségnek, sőt 2023-ban valószínűleg az is már csak kompromisszumokkal. -

Alogonomus

őstag

válasz

Raggie

#56180

üzenetére

Raggie

#56180

üzenetére

Annak ellentmondana az, hogy nem akarnak túl magas fogyasztást, hogy ne kelljen komolyabb tápegységet vennie mindenkinek. "so potential users are not forced to buy bigger power supplies and replace the cooling solutions like with Nvidia's RTX 3000 cards."

A kisebb RTX 3000 kártyáknak nagyjából rendben van a fogyasztásuk, csak az RTX 3080/90 kártyáknál lett igazán kiugró a fogyasztás, amihez már erősebb tápegységre és 3 slotos kártyaméretre kellett váltani. -

Alogonomus

őstag

Jelenleg a tippek ahogy az angolt mondaná "all over the place".

A valószínűleg talán leginkább komolyan vehető nyilatkozat Rick Bergmantól származik, aki úgy fogalmazott, hogy:

"... Bergman quickly pointed out that the performance-per-watt gains should be similar to the improvements achieved with the leap from RDNA 1 to RDNA 2. “... We have the same commitment on RDNA 3… We focused on that on RDNA 2. It's a big focus on RDNA 3 as well.” Bergman notes that the key here is to maintain a similar TGP while delivering 50% more performance so potential users are not forced to buy bigger power supplies and replace the cooling solutions like with Nvidia's RTX 3000 cards."Vagyis nagyjából az RDNA2 fogyasztási keretében gondolkoznak, és szeretnének abból 50%-kal több teljesítményt kihozni az RDNA3 kártyákkal.

Persze a tervek változhattak azóta, de az 50% és 200% nagyon messze vannak egymástól.Az 5 nm nagyjából 15% sebességet, vagy 30% spórolást jelent. "Compared to TSMC 7nm node, the N5P (5nm) delivers a 15% speed improved or about 30% reduction in power consumption."

A pletykák szerinti 2x80 CU-s Navi 31 nagyjából bele is illik ebbe a képbe. Egy 6900 XT elfűt 320 wattot, amiből a Navi 21 chip jelenthet mondjuk 235 wattot. A 30% spórolással az lenne 165 watt bármilyen optimalizálás nélkül, csak a 7 nm-ről 5 nm-re váltásból következően, vagyis a 2 tömb kis optimalizálással együtt teljes terhelésen is beleférhetne 300 wattba. Mind a két tömb viszont biztosan nem tudna olyan kihasználtságon üzemelni, mint most az egy tömb a 6900 XT kártyákon, így mondjuk 80%-on használva a két tömb mellé még beleférhet a többi alkatrész, és a 320-350 wattból meg is lehet a kártya. -

Alogonomus

őstag

válasz

Komplikato

#56165

üzenetére

Komplikato

#56165

üzenetére

A háromszoros teljesítményről szóló pletyka "súlyát" sokan már csökkentették azzal, hogy elvileg nem az RDNA2, hanem az RDNA1 kártyához képest lesz meg a háromszoros teljesítmény, vagyis a Navi 21 kártyához képest csak nagyjából 50% lehet az ugrás, ami viszont abszolút hihető lehet a dupla adagnyi feldolgozóegység alapján.

-

Alogonomus

őstag

Olvasd azért végig a cikket, és megtalálod, hogy:

"A DirectX 12 esetében tehát klasszikus értelemben nem igazán lehet a meghajtó többletterheléséről beszélni. Ugyan létező jelenségről van szó, de egyáltalán nem olyan jelentős mértékű, mint például a DirectX 11-es API-nál, és pláne nem okozhat ilyen extrém különbségeket, amiket a fenti tesztben lehet látni."

Vagyis Abu szerint a teljes problémát bár nem lehet kizárólag a driver hibájára fogni, de az tény, hogy a probléma jelentkezik az Nvidia kártyákon.

Ráadásul felhívom a figyelmedet Abu az első cikket 2 héttel követő második cikkében szereplő megállapításra:

"Az egyik érdekes információ, hogy bár a DirectX 12 esetében nincs kernel meghajtó, tehát a driver nem futtat egyetlen kernel szerver szálat sem. Ezzel együtt a Microsoft az API implementációjánál elég nagy szabadságot ad a gyártóknak, vagyis amíg egy megfelelő meghajtó képes teljesíteni a hitelesítési tesztet, addig igazából a redmondi óriáscéget nem nagyon zavarja, ha bizonyos funkciókat egy DirectX 12 implementáció csak emulál."

Utánaérdeklődött a jelenségnek, és az új információk alapján egy második cikkben is foglalkozni akart az okok feltárásával. A végmegállapítás pedig a következő lett:

"Ezzel kapcsolatban megpróbáltunk informálódni a fejlesztőknél, és a válaszok alapján arra jutottunk, hogy egyik felvetett gondot sem lehet úgy kiemelni, hogy egyértelműen jelentős CPU-limitet okozna a GeForce-okon gyengébb teljesítményű processzorok mellett. Ellenben a különböző tényezők (Radeonokon való alkalmazásfejlesztés, bizonyos szintű emuláció alkalmazása a DirectX 12 bekötési modelljére, a DirectX 12 meghajtóimplementáció komplexitása, valamint ennek az optimalizálásába fektetett idő relatív módon értékelt rövidsége) hatása esetlegesen összeadódhat, és ezek már okozhatnak olyan limitációt, ami erősebben visszafoghatja a GeForce-ok tempóját bizonyos CPU-kon. Sőt, egyes gondok felerősíthetik egymást."

-

Alogonomus

őstag

Felnőtt emberként szembe kell nézni a valótlan PR-állításokkal, de felnőtt emberként akkor a valós értékekkel is kell számolni.

Örülök, hogy te biztos vagy az állításodban, de a piaci helyzet nem téged igazol, hanem azokat, akik szerint az MSRP értékek kamuk, és a boltok polcain levő termékek árai a tényleges árak. 329 és 399 dollárért legfeljebb pár látványos PR-eladást bonyolítanak le, de a valós árak folyamatosan bőven a hivatalos MSRP fölött alakulnak még az olcsó árak miatt sokszor felhozott tajvani boltokban is, és mire onnan Európába/Amerikába jut a kártya, addigra újabb 10-20% rakódik az árra plusz a helyi ÁFA. -

Alogonomus

őstag

válasz

Petykemano

#56109

üzenetére

Petykemano

#56109

üzenetére

"Egy RX 480-on pontosan mit segít az FSR?"

A tesztek alapján - ha nem is egy RX 480, de egy RX 580 - több játékban az 1440p esetén már éppen csak játszható sub 50 fps állapotból 60-80 fps-re ugrott.

-

Alogonomus

őstag

Nvidia valójában ugyanúgy emelt árat, csak a PR anyagokba beírt egy olyan MSRP értéket, amit ő maga sem tekint valósnak. Belistázzák a kártyát a honlapjukon is a látszat kedvéért 329 dollárért, de folyamatosan out of stock minden kereskedőnél. MLiD helyesen mutatott rá, hogy az AMD egyszerűen csak nem játszotta el a Nvidia "fake MSRP" módszerét. Az AMD eleve a 3060 és 3060 Ti valós bolti árához lőtte be a 6600 XT MSRP árát. A 3060 a 12 GB miatt alapkiépítésben is stabilan egy $400+ kártya lesz, míg a 6600 XT a 8 GB miatt az alapkártyák esetén tud $380 kártya lenni.

-

Alogonomus

őstag

válasz

#32839680

#56073

üzenetére

#32839680

#56073

üzenetére

Arra akartam utalni vele, hogy a Zen/Zen+ még inkább a gyengébbik opció volt, ahogy az RDNA1 is. Ezért olcsóbban is kellett adni, hogy azt válasszák a vásárlók. A Zen2 és az RDNA2 már simán beérte a konkurencia termékét, ezért lehetett nagyjából azonos áron adni. A Zen3 pedig már egyértelműen az erősebb termék lett a piacon, ezért drágábban is lehet adni.

-

Alogonomus

őstag

válasz

Petykemano

#56074

üzenetére

Petykemano

#56074

üzenetére

Fogyasztóként a helyzethez kell alkalmazkodni. Lehet morogni, hogy miért ennyire drága minden, de fogyasztóként akkor is a haszonmaximalizálásra kell törekedni, ha kénytelen vagy a drágák közül egyet választani.

-

Alogonomus

őstag

válasz

.Ishi.

#56066

üzenetére

.Ishi.

#56066

üzenetére

De az AMD ezzel nem lesz rosszabb perf/$ tekintetben, mint egy 3060/3060Ti, csak nem is lesz jobb ajánlat. A határozottan gyengébbnek tűnő 330 dolláros 3060-at bőven túlteljesíti, a kicsit erősebb 400 dolláros 3060Ti pedig drágábban erősebb opció. A két Nvidia kártya közé beárazta az AMD az átlagos teljesítménye alapján. Az RDNA2 ugyanott tart az úton, mint a Zen2 tartott.

-

Alogonomus

őstag

válasz

olymind1

#56039

üzenetére

olymind1

#56039

üzenetére

Kicsit soknak tűnik egy RX570-hez az a 200-230 watt. Nem RX580-ra gondoltál? Az RX580 Nitro+ rendszer evett az itteni tesztben együttesen 355 wattot.

-

Alogonomus

őstag

válasz

Petykemano

#56036

üzenetére

Petykemano

#56036

üzenetére

Csak az történik, ami az eddigi összes AMD kártyánál. Ha már az Nvidia konkurens kártyája kettő és háromventis kivitelben van a piacon, akkor miért fogták volna vissza az RX 6600 XT kártyát egy határozottan gyengébb hűtéssel? Így még csendesebb is lehet.

-

Alogonomus

őstag

válasz

Hellwhatever

#56002

üzenetére

Hellwhatever

#56002

üzenetére

Kis eltérés lehet, de a 45-55 megoszlás nagyon távol van a 19-81 megoszlástól.

Kevés 8 éves kártya éri el egy pár éves IGP teljesítményszintjét, így ha egy GT 710, vagy egy R5 220 beleszámít, akkor az IGP-k is bele kellene számítsanak, amivel pedig az összehasonlítás dominánsan elcsúszna az AMD javára.

-

Alogonomus

őstag

válasz

solfilo

#55998

üzenetére

solfilo

#55998

üzenetére

Csak valahogy a JPR számai nagyon nem igazodnak a Mindfactory valós eladások alapján meghatározott számaihoz. Jobbik esetben a JPR csak beleszámolta a gyárszalagról egyenesen a bányászfarmokra kerülő eleve monitorkivezetés nélkül gyártott kártyákat, rosszabbik esetben pedig téves adatokkal dolgozik a cég.

Alternatív magyarázat lehet még, hogy NVidia és AMD kártyákból is az összes még üzemelő példányt nézik, szóval ugyanúgy egy egységnek vesznek egy 10 éves kártyát, mint egy 2 éves kártyát. Na úgy tényleg lassan fog változni az arány, mert még úgy is sokára fognak kikopni a régi kártyák, hogy nemrégiben mind a két gyártó elkaszálta a régebbi kártyáik szoftveres támogatását. -

Alogonomus

őstag

válasz

Busterftw

#55995

üzenetére

Busterftw

#55995

üzenetére

Vagyis a 2020 végi helyzetből következtetsz a bő fél évvel későbbi jelenlegi helyzetre. 2020 Q4 alatt az Nvidia már 3 hónapja árulta a kártyáit, míg az AMD még éppen csak bejelentette azokat, de közben teljes erőből konzol APU-kat gyártatott. Azóta elég nagyot ugrott az összeszerelt AMD kártyák száma. Ja és azokból elég kevés került a játékosok gépei helyett bányászfarmokra.

-

Alogonomus

őstag

válasz

GeryFlash

#55979

üzenetére

GeryFlash

#55979

üzenetére

Ahogy b. is rámutatott, "Pártatlan RT játékot nehéz mutatni manapság,majd a grafikus motorok beépített megoldásai lesznek azok,unreal,ID, stb.". Jelenleg vannak az NV-címek, az AMD-címek, meg van néhány független cím, amelyikek közül a preferenciától függően a megfelelőt lobogtatni lehet. Jelenleg a játékhoz kell választani a kártyát, ha a legjobb teljesítmény kell.

-

Alogonomus

őstag

válasz

Hellwhatever

#55974

üzenetére

Hellwhatever

#55974

üzenetére

Nyilván a jó értéknél linkeltem a videót, de azért a griffes utazásnál is bőven megvolt a 4K/60fps.

Arra akartam utalni, hogy az egy dolog, hogy a Nv-címekben tényleg egy csőd az AMD RT-teljesítménye, de egy kvázi független címben, mint a WoW a két gyártó kártyája nagyjából egálban van. Egyik esetben egyik működik jobban, másikban másik, de a 4K/60fps az nem jelent egyiknek sem gondot. A minimumok mindkettőnél beesnek 60 alá, az átlagok pedig jellemzően 100 környékétől indulnak. -

Alogonomus

őstag

válasz

GeryFlash

#55963

üzenetére

GeryFlash

#55963

üzenetére

Masreszt meg mire eleg egy csucs 6900XT? Csak mert 4K 60FPS Raytracingre peldaul nem.

Az oké, hogy az Nvidia RTX kártyáinak a kialakításához programozott Control, Metro, Minecraft nagyon gyengén fut az új AMD kártyákon, de egy tisztességgel leprogramozott sugárkövetéssel egyáltalán nem működnek rosszul az AMD kártyái.

A tesztekből egyértelműen az a kép rajzolódik ki, hogy amelyik játékot még "Nvidiához csinálták", azokban 1 2 3 4 az Nvidia kártyák erősebb teljesítményt nyújtanak, amelyiket pedig már az "AMD idejében csinálták", abban 1 2 az AMD kártyák egálban vannak. Jelenleg még a legtöbb raytracing játék az Nvidia-érából származik, ezért az Nvidia kártyák vannak jobb helyzetben. -

Alogonomus

őstag

válasz

#32839680

#55942

üzenetére

#32839680

#55942

üzenetére

Na hivatalos áron tényleg sokára kapsz konzolt, mert mindenki beelőz, aki a feltöltődő raktárkészletek miatt 400 ezer helyett 240 ezerért már megveszi a konzolt. 185 ezerért tényleg nem nagyon lesz idén kapható, mert mire lemenne annyira az ára, addigra megérkezik a karácsonyi ajándékvásárlási roham, ami viszont megint felveri az árát.

-

Alogonomus

őstag

Én is meglepődtem a tegnapi állításon, de aztán szerintem rájöttem a magyarázatra. Mivel az Nvidia csomagban árulja a GPU és memória lapkákat, így az Nvidia határozza meg az árakat. Ha olcsóbban adja a Microntól megvett GDDR6X lapkákat, az az Nvidia döntése. A konzolokat is önköltség alatt adják.

Ha GDDR6X kell a nagyobb kártyákra a versenyképes teljesítményhez, akkor azt kell biztosítania melléjük.

Ha az AIB-k sírása jogos, és túl magas a GDDR6X kártyák bekerülési költsége, arra is egy megoldás, hogy az Nvidia nyomott áron adja a lapkákat, hogy gyártsanak nagy kártyákat is az AIB-k, ne csak a sima GDDR6-os kis kártyákat. -

Alogonomus

őstag

válasz

#32839680

#55919

üzenetére

#32839680

#55919

üzenetére

2020 második fele és 2021 elő harmada alatt az AMD 7nm-es kapacitásainak lényeges részét valószínűleg lefoglalta a legyártott 25-30 millió konzol. A 25-30 millió konzol helyett, ha csak az eredetileg tervezett 10-15 millió konzol készült volna el, akkor a maradék kapacitásból legyártott mondjuk 15 millió GPU eredményeként valószínűleg be sem következett volna a kártyaínség.

Most már nem kell annyira sok konzolt gyártaniuk, és a jövedelmezőbb CPU mellett már jut elég kapacitás a GPU-k gyártására is. 150 ezres 6700 XT, meg 200 ezres 6800 XT persze nem lesz, de az árak már határozottan csökkenést mutatnak, és valószínűleg még tovább fognak csökkenni. -

Alogonomus

őstag

válasz

Petykemano

#55911

üzenetére

Petykemano

#55911

üzenetére

A fejlődés és teljesítményugrás abban mutatkozik meg, hogy a 6700XT már képes sugárkövetést számolni, valamint a nagyobb teljesítmény és lapkaméret, na meg a +50% memória ellenére sem nőtt igazán a fogyasztása az 5700XT-hez képest.

-

Alogonomus

őstag

válasz

Petykemano

#55907

üzenetére

Petykemano

#55907

üzenetére

Az APU érdemben sose fog egy önálló kártyához hasonló teljesítményt nyújtani, mert még a hamarosan érkező DDR5-ös memóriák is jelentősen lassabbak, mint a régebbi kártyákon levő GDDR5-ös memóriák, hogy ne is említsük a GDDR6 és GDDR6X memóriákat. Ráadásul a kártyán levő memóriamodulok, de még a kártya áramkörei is csak a GPU "füttyentésére várnak", míg egy APU grafikus része az alaplapi DDR-ös modulokon és az alaplapi kommunikációs csatornákon osztozni kényszerül az APU egyéb részeivel. Ja és persze külön CPU és külön dGPU esetén a CPU és a dGPU is külön "elfűtheti" a maga 100-300 wattját a másik egység zavarása nélkül.

-

Alogonomus

őstag

válasz

Yutani

#55903

üzenetére

Yutani

#55903

üzenetére

A fő probléma az, hogy a mostani generációval akkorát ugrott a kártyák teljesítménye, hogy az egy éve még bőven felső kategóriásnak számító kártyák már szinte a felső középkategóriából is kiesnek. Sőt az előző generáció csúcskártyái is majdnem a felső középkategóriáig csúsztak vissza.

A jelenlegi technológiával már nem igazán éri meg 200-300 dolláros kártyákat készíteni, mert azokon minimális lenne csak a haszon a nagyokkal közös gyártósor, memória, node, SMD-k miatt. Az új játékokhoz sugárkövetés nélkül is kell legalább egy 3060/5700, az óriási teljesítményugrás miatt pedig a használt piacon megjelent sok 1-2 éves kártya, amik a régi játékokhoz még bőven elegek, még bőven elfuthatnak azok a kártyák évekig.

A kártyák esetében ugyanaz játszódik le most, ami pár éve a mobiltelefonoknál, vagy régebben például az autóknál. Az egyre modernebb technológiákkal egyre hatékonyabb termékeket kapunk, de a felpörgő fejlesztési verseny miatt sokkal rövidebb idő marad a fejlesztési költségek megtérülésére. Ahogy búcsút inthettünk az 50 ezres középkategóriának a mobilok terén, vagy az 1 milliós Swiftnek az autóknál, úgy a 100 ezres kártyák ideje is lejárt. -

Alogonomus

őstag

válasz

Petykemano

#55886

üzenetére

Petykemano

#55886

üzenetére

Vagy az AMD rájött, hogy még a részben selejtesre sikerült, ezért csak csökkentett teljesítmény mellett stabil termékeket is érdemes piacra dobnia, mert a súlyos keresleti nyomás miatt mindent el lehet adni.

Ráadásul a Ryzen 5700G sem lett elég erős a legtöbb játékhoz. Csak az IGP-k között ért el új rekordot, de még egy "non Ti" GTX 1050 is erősebb nála. Ez a "selejt PS5" processzor viszont már tényleg elég erős lehet egy 1080p szituációhoz.

Az AMD legnagyobb gondja jelenleg az, hogy mivel a 7 nm-es TSMC kontingensének nagy részét nem a dVGA szektorba kellett csatornáznia, hanem a konzolokra és a processzorokba, így még most is gyenge a RDNA2 piaci penetrációja. Eközben az Nvidia szinte a teljes 8 nm-es Samsung kontingenséből Ampere kártyákkal áraszthatta el a piacot, amit el is kapkodtak a vásárlók, mert RDNA2 kártya alig került a polcokra. -

Alogonomus

őstag

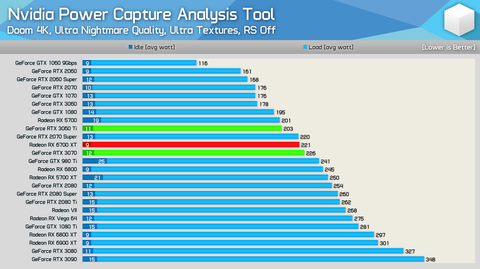

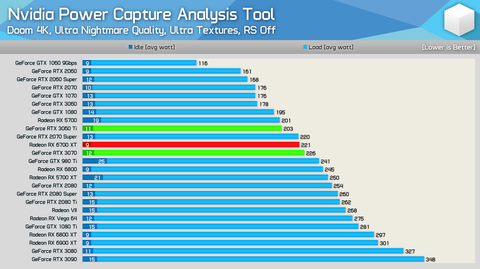

Ha vitatkozni próbálsz, legalább téged igazoló tesztről linkeljél mérést. A Tom's Hardware tesztje szerint is az alap RX 6800 XT 302/307 Wattot, míg az alap RTX 3080 332/334 Wattot fogyasztott.

De akár vessél akkor erre egy pillantást.

Az ugyanolyan kialakítású AIB kártyák ventilátorsebessége is a HWU és az általad linkelt értékeket igazolja. Még a Tom's Hardware listája alapján is erősebb az RX 6800 XT, mint a valójában 30 Wattal "éhesebb" RTX 3080.

Józanodj ki a legénybúcsú után. Vagy a fentieket már elvileg kijózanodás után írtad?

-

Alogonomus

őstag

válasz

Jack@l

#55856

üzenetére

Jack@l

#55856

üzenetére

A tensor magok használata nélkül is magas már az Ampere kártyák fogyasztása. Munkára fogott tensor magokkal vagy még vadabb fogyasztási értékek jelentkeznének, ami 2,5 kilós 4 slotos kártyákat eredményezne, vagy a tensor magok "felzabálnák" a fogyasztási keretet a hatékonyabb feldolgozók elől, ami meg simán teljesítményveszteséget okozna csak.

-

Alogonomus

őstag

válasz

Petykemano

#55840

üzenetére

Petykemano

#55840

üzenetére

Több helyen olvastam olyan fejtegetést, hogy az Infinity Cache az óriási adatátviteli sebességének és elhanyagolható késleltetésének, meg a kisebb felbontásból származó nagyobb találati aránynak köszönhetően bizonyos szempontból már tekinthető az FSR "hardveres gyorsítójának" is.

-

Alogonomus

őstag

-

Alogonomus

őstag

válasz

Petykemano

#55715

üzenetére

Petykemano

#55715

üzenetére

A 25% valószínű magyarázata:

- Dirt 5 és Assassin's Creed: Valhalla kb. annyira az RDNA2 képességeire készült, amennyire a CP2077 vagy Metro az Nvidia kártyához.

- WoW: Shadowlands nagyjából az első "független" játék, ahol kijön az RDNA2 rugalmas kialakításának az előnye a Turing és Ampere kártyák fix kialakításához képest.

- Hitman 3: Na ez pedig egy erősen CPU-gyilkos játék, ahol határozottan számít az Nvidia driver overhead az 1080p-re szánt RTX3060/RX6600 kártyák összemérésekor. -

Alogonomus

őstag

válasz

Petykemano

#55602

üzenetére

Petykemano

#55602

üzenetére

Nem hiszem, hogy a Navi23 és 24 a Polaris teljesítményszintjére jönne. A jelenleg leggyengébb Navi22 nagyjából pont kétszer olyan erős, mint a legerősebb Polaris, az RX570-hez képest pedig már majdnem háromszoros a különbség. Még a Navi24 is jóval erősebb lenne, mint egy RX590. Ráadásul ha ki is jönnének egy mondjuk 10 CU-s Navi25 verzióval, akkor is még le kellene gyártaniuk a jelenleg használatban levő akárhány tízmillió GCN4 kártya helyett megvehető Navi23-24-25 kártyákat. Mindezt egy olyan időszakban, amikor gyilkos licitháború folyik a 7nm-es kapacitásokért, és pont a dGPU a legkevésbé nyereséges termék.

Az FSR viszont pont egy lélegzetvételnyi (pár évnyi) szünetet biztosít a low-end szektor kiszolgálásában, és így nem kell a 1080p játékosok számára új kártyát kihozni a még drágán mért 7-8 nm-es gyártósorokon. Itt eléggé jól összefoglalták, hogy szerintem is mi az FSR igazán nagy haszna. "The real strength of FSR is that it enables higher frame rates for low-end graphics cards."

Persze a címlapokat a 4K mellett kimaxolt sugárkövetéssel 200+ fps-sel futó játékok fogják uralni, de sokkal fontosabb, hogy a már 5 éves kártyákba "új életerőt pumpál" az FSR, ami az AMD számára mindegy, mert az összes fizikailag legyártható új kártyát úgyis megveszik az emberek, de a lecsökkenő vásárlói igényt már nem tudják annyira meglovagolni a scalperek. -

Alogonomus

őstag

válasz

Petykemano

#55596

üzenetére

Petykemano

#55596

üzenetére

Mindenekelőtt szerintem sem volt elegáns az AMD részéről ez a lépés.

A GCN4 és azon belül is a Polaris esetében viszont nem érzem annyira sötétnek a jövőt. A GCN3 "kivégzésére" komoly utalás volt már az is, hogy az FSR kapcsán nem számoltak velük, pedig bőven hoznák egy Ryzen APU teljesítményszintjét, az FSR követelményeit pedig bőven túlteljesítik.

A GCN3 7 éve debütált, és 5 éve adták ki vele az utolsó érdemi terméket, ha nem számítjuk az OEM kiadásokat. A GCN4 ezzel szemben 5 éve debütált, és 2,5 éve is kiadtak még vele érdemi terméket. Még a gyártói garancia sem járt le sok GCN4-es terméken. Ráadásul GCN3-as termékből már nem olyan sokat használnak aktívan, viszont a GCN4-es termékek teszik ki az AMD kártyák nagy részét, ami az FSR bevezetésével várhatóan hosszú időre meg is marad, mert az FSR biztosítani fog beállítástól függően valahol 30% és 100% közötti pluszteljesítményt. A GCN4 addig biztosan támogatott marad, amíg darabszámban a legnagyobb halmazt jelentik a használatban levő AMD játékkártyák között, és az az állapot a nyilatkozatok szerint még évekig elhúzódó chipválság miatt akár az évtized közepéig is eltarthat. -

Alogonomus

őstag

válasz

gejala

#55582

üzenetére

gejala

#55582

üzenetére

Azért a "sok" definíciója kicsit nagyobb darabszám. Persze lehetnek beragadt fejlesztések, amiket már nincs idő/pénz átírni, meg például ott van a Guild Wars 2, ami máig DX9-es, viszont szinte minden frissebb AAA játék már DX12-es vagy Vulkan alapokon van, mert azokkal lehet az erősebb GPU-k teljesítményét kiaknázni. DX11-el szinte minden esetben a CPU lesz a szűk keresztmetszet.

-

Alogonomus

őstag

válasz

Busterftw

#55528

üzenetére

Busterftw

#55528

üzenetére

Drágábbnak drágább lehetett, de maximum egy nagyon túlhúzott RTX 2060 volt teljesítményben az RTX 2070 referenciamodell szintjén, ezért egyértelmű volt a kártyák célközönsége. Az RTX 2060, 2070, 2080 és a Ti között még volt annyi távolság (15, 15, 19%) teljesítményben, hogy simán közéjük fértek a Super variánsok egy modellfrissítés keretében.

-

Alogonomus

őstag

válasz

Busterftw

#55518

üzenetére

Busterftw

#55518

üzenetére

Csak a túl szűk különbségek miatt így az eggyel kisebb kártya gyárilag húzott kiadásának a teljesítménye már eléri a nagyobb kártya alapváltozatát. A 3080-3080Ti-3090 esetben pedig egy gyárilag húzott 3080 fogyasztásban és teljesítményben is lényegében egy alapváltozatú 3080Ti-3090 szintjén van, csak némileg kisebb memóriával, de sokkal olcsóbban. Az Nvidia ezzel a saját kártyáinak állított ellenfelet, mert az AMD kártyái továbbra is jobb ár/érték és fogyasztás/teljesítmény arányúak maradtak.

Az AMD az XTX és XTXH kártyákkal valóban többet ad, mert csak a legmagasabb szintre vezette be új szintként, és megemelte rajtuk a paraméterek maximálisan beállítható értékét. -

Alogonomus

őstag

válasz

Petykemano

#55511

üzenetére

Petykemano

#55511

üzenetére

A macOS mint platform aránya 17%, míg a Windows 76,5%. Alig is adnak ki macOS rendszerhez játékot, mert egyszerűen nem éri meg fejleszteni a 17%-ra. Általában csak egy már kész játékot portolnak át macOS rendszerre, hogy további piacokra eljussanak. Speciálisan a macOS rendszerhez és az Apple processzoraihoz komoly kártyát csak a grafikus programok gyorsításához lehetne érdemes fejleszteni, mert a grafikus szektorban valóban komoly az Apple eszközök részaránya. Azok a gyorsító kártyák viszont játékokban valószínűleg nem lennének kiemelkedőek, mert nem a játékok igényeihez alakították azokat.

-

Alogonomus

őstag

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

A csúcskivitelek mindig is drágák voltak. Ezért is fogalmazott úgy, hogy az AMD csak átveszi a Titan helyét és árazását a rangsorban. A Titan már korábban is 2500 dollár volt.

Egy csúcsot jelentő sportkocsi, vagy luxuslimuzin is bőven 100 millió forint fölött van, de az igazán elrugaszkodott példányok közel milliárd forintos tételek. Ennek ellenére bőven lehet találni általános használathoz tizenpár milló forintért észszerű igények esetén kompromisszummentes élményautót.

Az RDNA3-nál az lesz a kérdés, hogy egy UE5 szintű látványvilághoz és legalább 100 fps-hez milyen felbontás mellé milyen szintű kártya kell majd. Egy közepesnek számító RDNA2 kártya is elég jelenleg szinte maximális grafikai beállítások mellett a 1440p 144fps játékélményhez. A pletykált csúcs RDNA3-as kártya a csúcs RDNA2-es kártya teljesítményének duplájával (triplájával?) a jelenlegi játékokban már valószínűleg raytracing mellett is maximum 4k 144fps esetén lenne pár esetben gondban. Amennyiben egy majdani közepes RDNA3 kártya a jelenlegi 600-700 dolláros csúcskategória áráért hozza a jelenlegi 1000-1500 dolláros csúcskategória teljesítményét, akkor nagy gond nem lesz. A csúcskategória pedig mindig is az extrém árakról és extrém rossz perf/$ mutatókról szólt szólt, de extrém teljesítményt nyújt. -

Alogonomus

őstag

válasz

Petykemano

#55476

üzenetére

Petykemano

#55476

üzenetére

nagyjából ugyanazzal a ~40% és ~80%-kal drágábbak is, az 1660S-hez képest, amennyivel gyorsabbak

Csak közben beléjük került a hardveres sugárkövetés lehetősége, RTX kártyáknál a pár játékban előnyt jelentő DLSS lehetősége, RX kártyáknál a - pont a középkategória célterületét jelentő - kisebb felbontásokat gyorsító Infinity Cache.

Sokakat az vezet meg szerintem, hogy az RTX 3060 "elődjének" az RTX 2060-at tekintik, pedig az RTX 2060 nem középkategóriás kártya volt. Középkategóriánál egyértelműen erősebb volt a sugárkövetés és DLSS miatt, viszont a felső-középkategóriát nem képviselhette, mert oda az RTX 2070 volt pozicionálva. Azért is hozta létre az Nvidia a Turing architektúrán a GTX 16xx sorozatot, mert az RTX 2060 helyett kellett valami, ami tényleg a középkategóriát jelenthette.

De akár össze lehet hasonlítani a $400-os 2060 Super és a $330-os 3060 kártyát is, ahol olcsóbban kap a vásárló némileg még nagyobb teljesítményt is.

-

Alogonomus

őstag

válasz

#32839680

#55466

üzenetére

#32839680

#55466

üzenetére

Amikor 1-1.5 éve a PC középkategóriára elég sokaknak megvolt az anyagi lehetősége. Most meg luxus lett. Azért ne a vevő legyen már a hibás.

Egy közepes gépet kihoztál 350-400k-ból. Amiből 120-130.000 Ft volt a videókártya.

Most ugyan ez a videókártya 300.000 Ft. Az utódja meg 350-370.000 Ft.A csak az árakat összehasonlítók - a kriptoőrületen túl - azt nem veszik figyelembe, hogy az 1-1,5 évvel ezelőtti generációhoz képest óriásit ugrott a teljesítmény, és főleg pont a videokártyák tekintetében. Egy 2019-20 karácsonyra összerakott közepes gépben még szinte biztosan egy 6 GB- os 1660 Super volt a kártya, ami a jelenlegi elméleti erősorrend alapján nagyjából 38%-on áll, míg a mostani generáció közepesnek titulálható kártyái (3060Ti-6700XT-3070) 70-75% között szóródnak. Vagyis a szokásos 15-25% fejlődés helyett most a középkategóriát nézve az új generáció egy laza

80%-ot ugrott, de még a minimumot képviselő 3060 is 40%-kal lett erősebb, és az a 1660 Super $230-os árához képest már nem annyira vészes $330-os áron jött ki hivatalosan.

80%-ot ugrott, de még a minimumot képviselő 3060 is 40%-kal lett erősebb, és az a 1660 Super $230-os árához képest már nem annyira vészes $330-os áron jött ki hivatalosan.

Ezzel arra akartam rámutatni, hogy a mostani "középkategória" valójában az előző generációs felső- és csúcskategória közötti, vagyis a 2080 Super és a 2080 Ti közötti szintre érkezett. Egy mostani középkategóriás kártya valójában a 2070 Super és 5700 XT által képviselt szintre tette rá a generációnként megszokott plusz teljesítményt. A 2070 Super pedig $500-on indult, míg az 5700 XT $400-on. Szóval azokhoz képest stimmel a generációnként nagyjából 20% erősödés azonos áron.Mondom. Az RX5600XT-met annyiért tudnám eladni, ami majdnem a teljes konfigom (3600X + 16GB RAM + RX5600XT) került. Egy évvel a vásárlás után.

A kriptoőrület miatt nyilván én is majdnem annyiért el tudnám adni az RX580-amat, amennyi anno a kártya + proci + alaplap + memória volt. Ez most egy ilyen világ, de már kezd normalizálódni a helyzet.

A te példáddal élve, nem a Tesla miatt sírnak, mert drága. Senki se a 3080 miatt sír, amire akkor se lenne pénze ha nem volt áremelkedés.

Persze némileg elrugaszkodott volt a Tesla példának, bár a 15 milliós Model 3 azért inkább csak 3070 szint.

-

Alogonomus

őstag

válasz

paprobert

#55461

üzenetére

paprobert

#55461

üzenetére

Az elhiszem, hogy te $200-ért szeretnéd megkapni a $400-os 3060 Ti kártyákat.

Az a legszomorúbb, hogy miközben szidod az állítólagosan átb*xott rétegeket, nem veszed észre, hogy téged kapott el a fogyasztói társadalom "gépszíja", és olyat akarsz venni, amire ezek szerint nincs meg az anyagi lehetőséged. Ez az oka a rengeteg személyi kölcsönnek.

Persze én is elfogadnék féláron egy Teslát, de nem hőzöngök, hogy miért olyan drága egy Tesla. -

Alogonomus

őstag

válasz

olymind1

#55457

üzenetére

olymind1

#55457

üzenetére

200 $, de még 200 € körüli keretből sem lehet a jelenlegi architektúrára új kártyák összerakni, amire igazán lenne kereslet. Persze csábító lenne egy új kártya annyiért, de annak az új kártyának meg a teljesítménye lenne már kevés, így pedig inkább egy használt komolyabb Turing/RDNA1 kártyát venne a delikvens, amivel jobban járna ár-érték tekintetében.

-

Alogonomus

őstag

válasz

gejala

#55413

üzenetére

gejala

#55413

üzenetére

A hírek szerint az ütemezővel van a gond, ami ugyanúgy hiányzott a Turing GPU-ból, de még a mostani Ampere GPU sem tartalmazza, helyettük az Nvidia drivere végzi el az adatok jó időben átküldését, de ehhez a CPU erőforrásait kénytelen használni. A jelenlegi driverre így ugyanúgy támaszkodik a legújabb architektúra, ahogy akár egy Maxwell kártya. Ezért is esik pont ugyanúgy vissza jelentősen egy sok éves Nvidia kártya a gyenge processzor miatt, ahogy egy vadonatúj Nvidia kártya. Eközben egy AMD kártya nagyjából egyenletesen reagál az egyre gyengébb processzorokra.

Amíg az Nvidia a Turing érában egyértelműen legalább egy "célegyenesnyi" előnnyel rendelkezett, addig lett volna lehetőségük egy új drivert nyugalomban kifejleszteni, vagy legalább az Ampere kártyába már beletervezni az ütemezőt. Talán a 4k-8k gaminget is az ütemező miatt erőlteti az Nvidia, mert a tesztek alapján a magasabb felbontásból következő alacsonyabb fps miatt már nem jelent komoly gondot a gyengébb processzor.A Pascal kártyák még sok évig velünk maradnak, mert a 1070-1080 kártyák FullHD felbontásra még abszolút jók, és az FSR valószínűleg csak még tovább nyújtja majd a használhatóságuk idejét. Legfeljebb nem a legújabb és kevésbé optimalizált játékhoz fogják használni. Ez a játék például majd valamikor 2023 környékén fog valószínűleg megjelenni, de már a mostani alfa állapotában is gond nélkül elfut egy GTX 1080Ti kártyán 4k felbontáson UE 4.26-os motorral.

A Turing/RDNA előtti architektúrák még sokáig a kártyák túlnyomó többségét fogják képviselni, így amelyik játék legalább a Pascal/Vega/Polaris architektúrán nem fut hibátlanul, annak a játéknak nagyon bekorlátozott lesz a piaca. -

Alogonomus

őstag

válasz

gejala

#55410

üzenetére

gejala

#55410

üzenetére

Csak egy alapjaitól újragondolt driver sok buktatót rejt, amiről az AMD is tudna mesélni az RDNA1 kártyák esetén néhányaknál előforduló hibák kapcsán. Persze az az új megközelítésű driver az AMD kártyáit mára az eredeti konkurensük fölé segítette, de az addig vezető úton számos problémával szembesült az AMD szoftverrészlege. Minden valószínűség szerint az Nvidia útja sem lesz problémamentes, és míg ezt a Turing-éra elején-közepén simán "kimozoghatta" volna a teljesítményelőnyével, addig a mostani head-to-head helyzetben pár itt-ott bugos driver bőven az AMD termékei felé terelhetik a nem elkötelezett vásárlókat.

-

Alogonomus

őstag

válasz

awexco

#55406

üzenetére

awexco

#55406

üzenetére

Nem erős procival hoz több fps-t, hanem elég erős procival nem veszít fps-t egy Geforce egy Radeonhoz képest.

Amíg a CPU maradéktalanul ki tudja szolgálni a GPU-t adattal, addig a két gyártó azonos szintű kártyái, nagyjából azonos erőt is képviselnek.Persze ez az jelenti, hogy az egyik felbontásban/játékban egyik erősebb, másikban másik. Ennél az fps-nél akkor sem tudna többet kiizadni az adott GPU, ha a CPU-t feltekernék 150%-ra folyékony nitrogénnel. Ezt hívják GPU-limitnek, mert az elérhető fps-t a GPU ereje határozza meg.

Amikor a CPU nem tud lépést tartani a GPU igényeivel, akkor a GPU kénytelen addig várakozni az adatra, amíg a CPU nem tud foglalkozni a GPU adatkérésével, addig pedig a GPU üresen vár, addig nem tud újabb képet legenerálni, vagyis leesik az fps, vagy kimarad pár ütemnyi kép, mert több ütemig csak ugyanazta képet tudja a monitorra kiküldeni. Ez az, amikor a képernyőn látszólag eltaláltad a célpontot, de a célpont valójában már arrébb van, ezért mellélőttél. Ezt a helyzetet hívják CPU-limitnek, mert az elérhető fps-t a CPU ereje határozza meg.

A Geforce kártyák nagyjából 20%-kal intenzívebben dolgoztatják a CPU magjait, így annyival is hamarabb érik el a CPU képességeinek a határát, vagyis ütköznek CPU-limitbe.

-

Alogonomus

őstag

válasz

gejala

#55381

üzenetére

gejala

#55381

üzenetére

Viszont aki jelenleg egy játékban csökkentett beállításokkal tudja csak elérni a neki megfelelő fps-t, az az FSR segítségével például már nagyobbra állíthatja a draw distance értékét, bekapcsolhatja a speciális effektusokat, átválthat HD textúrákra, és hasonlók. Ezek még a valamivel életlenebb kép mellett is komolyan megdobják a játékélményt.

-

Alogonomus

őstag

HUB Tim nem rég tesztelte az AOC Agon AG273QG G-Sync monitort, és annak azért bőven 1000 dollár alatt volt már az ára. Mondjuk Tim így is arra jutott, hogy nem igazán éri meg a plusz árat a G-Sync, de azért már nem teljesen elrugaszkodott egy G Sync modulos monitor felára.

-

Alogonomus

őstag

Annyiban igazat adok az RX 4xx hivatalos támogatásának hiánya miatt zúgolódóknak, hogy az AMD ezzel valószínűleg egy fölösleges PR hibát követett el.

Az viszont remélem senki számára nem lesz meglepő, ha a SAM vs. reBar esete ismétlődik meg, vagyis az AMD minden valószínűség szerint az RX 4xx kártyák esetén így is komolyabb gyorsulást fog biztosítani az FSR képességén keresztül, mint amennyi egy GTX 10xx kártyán elérhető lesz. Már ha egyáltalán elérhető lesz, vagyis ha az Nvidia valóban integrálja is a funkciót a driverébe. Simán elképzelhető, hogy komolyabb elérhető gyorsulás hiányában inkább nem fogja tolni az AMD szekerét az Nvidia, és kihagyja a funkciót valami olyan kifogással indokolva, hogy instabillá vált az idegen működési követő kódsoroktól a driver. Az FSR engedélyezése Nvidia kártyákon hosszabb távon biztosan az AMD hasznára válna, már csak a működés közben generálódó rengeteg tesztadat miatt is. Sőt egy hatékony FSR valószínűleg át is csábítana az AMD oldalára sok Geforce tulajdonost az AMD kártyáin elérhető még komolyabb gyorsulás miatt. A Geforce kártyákon elérhetővé tett FSR egyfajta "trial version" is lenne az AMD kártyáin elérhető FSR képminőségének bemutatására. -

-

Alogonomus

őstag

válasz

Novver

#55236

üzenetére

Novver

#55236

üzenetére

Nekünk végfelhasználóknak egyszerűbb lenne, de a kereskedőnek minden ország egy külön eset. Minden országban az érintett hivataloktól be kell szereznie az üzemelési engedélyt; az ország adójogszabályai szerint adóznia kell; az országban alkalmaznia kell embereket, ahhoz létesítenie kell egy céget, vagy meg kell bíznia egy helyi disztribútort; az országban biztosítania kell a garanciális ügyintézést; és még sok egyéb nyűg. Ez pedig a termék végső árát is megdobná.

-

Alogonomus

őstag

válasz

KillerKollar

#55152

üzenetére

KillerKollar

#55152

üzenetére

"Ne a 3080-at hasonlísd össze a 2080-al"

Azért a 3080 vs. 2080 szituációt idéztem, mert azt maga az Nvidia állította a saját sajtóanyagában. És arra utaltam vele, hogy még ha igaz is lesz egyes speciális esetekben ez a 2,5-3x , az nem azt jelenti, hogy maga a kártya lesz annyival erősebb.

"a 3090-et a 2080 Ti-vel vagy még inkább a Titán RTX-el"

Ami a 3080 vs. 2080 szitációban előjött azért, mert a mínusz 2 GB VRAM miatt az egyiknek már "swapelnie" kellett, az előjönne a 3080 vs. 2080 Ti esetén is, ha 11 GB-nál többet igényelne a beállítás. A Titan RTX sem azért lenne így erős, mert több aktív SM van rajta, hanem mert az eleve szélesebb memóriabuszra még dupla kapacitású memóriamodulokat is tettek, így nem lenne memóriaelőnyben a 3090.

Azért is nem a Titan RTX vs. 3090 összehasonlítással reklámoztak, mert a 280 wattos RTX Titan helyett a 350 wattos 3090 a perf/watt terén nem hozott nagy előrelépés. 126% teljesítmény 125% fogyasztás mellett."a sima 2070-et még épphogy verte"

A simát mondjuk már induláskor is abszolút verte, 2020 közepétől pedig a 2070 Superrel is egálban volt.

Abszolút csúcskategóriában valóban nem volt AMD kártya, de a középkategóriás kártyák esetén a vágatlan 5700 XT és a vágatlan 6700 XT között például meglett a 30% nyers erő különbség, miközben a fogyasztás sem nőtt, pedig még az RT is belekerült. És persze az a 30% is úgy jön ki, hogy az 5700 XT-n kipörögte magát a ventilátor a maximumig, míg a 6700 XT-n az AMD bekorlátozása miatt félteljesítményen megy csak a ventilátor.

Az RDNA3 már kisebb csíkszélességgel is jön, plusz az Nvidiának "köszönhetően" a fogyasztásban sem kell már annyira takarékosra belőni. -

Alogonomus

őstag

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

A 2,5-3x teljesítményugrás nyilván csak pár speciális esetben lehet majd igaz, ahogy az "RTX 3080 dupla olyan erős, mint az RTX 2080" állítás is csak a Doom Eternal 8 GB VRAM fölött, de 10 GB VRAM alatt igénylő játékbeállítása esetén volt meg néhány esetben, míg általánosságban az a 200% inkább a Tomshardware listájának megfelelően 150% lett a játékokban.

Na ez a top RDNA3 is adott esetben hozhatja majd egy RX 6900 XT teljesítményének 250-300%-át egy speciálisan az RDNA3-ra programozott helyzetben, nagyon eleresztett fogyasztással, 8 csatornás DDR5 memóriákra támaszkodó és továbbfejlesztett SAM segítségével, sőt talán némi driverrel megtámogatott CPU előfeldolgozással is megtámogatva. Szóval ez a 2,5-3x ugyanúgy nyilván a best case lehet majd, úgy pedig nem sokkal elképzelhetetlenebb annál, mint amit az AMD hozott ebben generációban. -

Alogonomus

őstag

"Meg jo, hogy egy akkora batar 3 ventis gyari hutovel csendes"

Közben viszont a 6700XT szintű 3070, amiről a hűtő van, az mégis intenzívebben kénytelen használni azt a batár gyári hűtőt.

"Nezted mar a 6600 hutojet, 1 ventivel?" Te láttál már 6600-as kártyát? Én még nem, csak a fentebb linkelt leakelt fotót, aminek a mérete nagyon nem 1 ventis kialakítást sejtet. Az eddigi kártyák alapján valószínű, hogy nem fognak külön 1 ventis hűtést tervezni a 6600-as kártyákhoz, mert az sok időt elvinne, drága mérnökórákat is igényelne, plusz külön présszerszámok és egyebek is kellenének hozzá. Mindezzel pedig csak 1-2 %-ot spórolhatnának a kártya legyártási költségeiben, mert nem az anyagköltség a tétel, míg a méretben úgyis az Ampere kártyák "törik a jeget".

"Nem azt mondtam, hogy nem fogja elerni, hanem nem sokszor fogjuk latni ekkora turbo orajelen sokaig. Nezd mar meg a hivatalos orajeleket. base: 1692 boost: 2684."

Intel talán nem pont ugyanezt játssza? i5-1400 base: 2600 boost: 4400. Sőt egy laptopba szánt i5-1145G7E base: 1500 boost: 4100.

Eddig minden RDNA2 kártyánál nyilvánvalóan látszott, hogy iszonyatos mennyiségű tartalék van bennük, hiszen a AMD által engedélyezett maximumig kitolt fogyasztásnál sem akartak "elszállni" a ventilátorok a kártyákon. Az AMD direkt lekorlátozta a kártyákat, mert még úgy is hozták a konkurencia szintjét, közben pedig a "meleg és hangos" sztereotípiákat is gyengíthette velük az AMD.

Na a 6600-as kártyáknál talán elengedi a fogyasztást az AMD, hiszen spórolásból úgyis valószínűleg a 180 wattos 3060 hűtését teszik fölé a gyártók, ami a 6600-asok 100-130 wattos TDP-jéhez képest orbitális tartalékokat biztosít."Kulonben a 6600XT nagyon hamar a non-XT 6700 nyakara maszhat ekkora orajelen.

Szerintem ezert sem hallottunk rola meg semmit."

Simán lehet, hogy nem is lesz sima 6700, ahogy nincs sima 6900 sem. Valószínűleg ugyanazért, amit írtál is. Az eggyel kisebb verzió "XT" változata lényegében hozza már azt a teljesítményt. Bár a 96 megás helyett 64 megás Infinity Cache azért valószínűleg nagyon visszafogja majd a 6600-as kártyákat 1080p fölött. -

Alogonomus

őstag

Az Ampere chip korlátaihoz méretezett hűtőkkel a 6700XT AIB kártyák abszolút csendesen dolgoznak, a ventilátorok sebessége masszív kihasználás mellett is ritkán megy 50% fölé.

A 6600-as kártyáknál is rengeteg tartalék lesz a hűtési teljesítményben, és egy esetleg magasabb ventilátorsebességgel simán elérhető lehet a 2,7 GHz, hiszen a 6600-as kártyákhoz sem terveznek majd valószínűleg külön hűtést, hanem a 6600-as kártyákkal azonos kategóriába tartozó 180 wattos 3060-as Ampere kártyák hűtését teszik rájuk. Ami pedig a 180 wattos 3060-assal elbír, az a 100-130 wattos 6600-6600XT kártyákra egyébként is overkill lesz, ahogy overkill az összes többi AMD kártyán is a Ampere kártyáktól megörökölt hűtés. -

Alogonomus

őstag

válasz

Yutani

#55090

üzenetére

Yutani

#55090

üzenetére

A csak a fekete jövedelmek megadóztatására akkor már jobb megoldás lenne, ha az SZJA terhére le lehetne írni az ÁFA jelentős részét, mert ezzel a fekete jövedelmes sem tudná visszaigényelni az ÁFA jelentős részét, valamint már a cégtulajdonosnak sem érné meg magát minimálbérre bejelenteni, és a cég nevére vásárolni mindent, hogy azok után az ÁFA összegét visszaigényelhesse.

-

Alogonomus

őstag

"A 3 éves Turing elérhető az RDNA2 vel szemben? vagy mi?"

Látom a szövegértelmezés továbbra sem erősséged. Azt írtam, hogy "bőven jobb ajánlatok lennének, mint az előző generációs RDNA1, és messze jobb, mint a Turing kártyák". Vagyis az RDNA2 kártyákat az RDNA1 és a Turing kártyákhoz mérve határoztam meg abban a mondatomban. Tehát az "azonos időben elérhető" alatt egyértelműen az RDNA1 és Turing architektúrát értettem.A piacra valóban előbb kerültek ki az Ampere kártyák, bár az RDNA2 architektúra már legalább 2020 elejétől kezdve ott működött a konzolra fejlesztő stúdiók tesztgépeiben, csak önálló kártyaként még nem hozta ki az AMD, míg az Nvidia kapkodva kihozta szeptemberben, és az elkapkodott kiadással érkezett is a stabilitási probléma.

"és ezt megint honnan, hogy az IC. miatt erősödik1080P ben?"

Például abból, hogy 1080p-ben garantáltan kevesebb adattal kell dolgoznia a chipnek, így nagyobb eséllyel lesz még az IC tárhelyében a szükséges adat, vagyis kisebb késleltetéssel tudja a feldolgozást végezni az RDNA2 chip.

Pedig reméltem, hogy ez az összefüggés azért nyilvánvaló számodra.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Bomba ár! Lenovo ThinkPad X390: i5-G8 I 8GB I 256SSD I 13,3" FHD I HDMI I Cam I W11 I Gari!

- 174 - Lenovo Legion Pro 7 (16IAX10H) - Intel Core U9 275HX, RTX 5070Ti

- HIBÁTLAN iPhone 13 Pro 128GB Sierra Blue -1 ÉV GARANCIA - Kártyafüggetlen, MS3750, 96% Akkumulátor

- Hp USB-C/Thunderbolt 3 dokkolók: USB-C Universal, G2, G4, G5, Hp Elite/Zbook- Thunderbolt 4 G4

- ÁRGARANCIA!Épített KomPhone Ryzen 5 7500F 32/64GB DDR5 RTX 5060 8GB GAMER PC termékbeszámítással

Állásajánlatok

Cég: NetGo.hu Kft.

Város: Gödöllő

Cég: Promenade Publishing House Kft.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Alig van AAA cím, amihez ne lenne DX12-es mód. Persze sok AAA játék rendelkezik korábbról még DX11-es móddal is.

Alig van AAA cím, amihez ne lenne DX12-es mód. Persze sok AAA játék rendelkezik korábbról még DX11-es móddal is.