Új hozzászólás Aktív témák

-

PCProfessor

aktív tag

Igen, elég ütősre sikeredett a belépője. Az emberek meg ugatnak a fogyasztás miatt mikor lényegében ugyanakkora mint ami ezelőtt volt. Az, hogy fel lehet nyomi 2-3x akkorára már más dolog. Akinek kell, az meg fogja venni és nem érdekli a fogyasztás sem, főleg ha ezzel időt spórol.

-

ddekany

veterán

válasz

PCProfessor

#128

üzenetére

PCProfessor

#128

üzenetére

Az nem para, hogy több mint 100%. Amikor valaki fejleszti a rendszert, gyakran egyszerre több alkatrészt vesz. Pláne RTX 4000-et... táp vásárlás esélyes, meg hát na, kell CPU hogy kihajtsa.

![;]](//cdn.rios.hu/dl/s/v1.gif)

De amúgy én nem nagyon vonnék le semmit a piacra a 4090 miatt... Ez szándékosan egy extrém termék, ami egy kicsi piacot céloz. Nem is beszélnének róla tán ennyit, ha nem csinálják ilyen elborultra... PR fogás.

-

PCProfessor

aktív tag

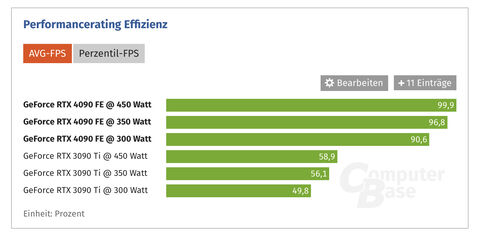

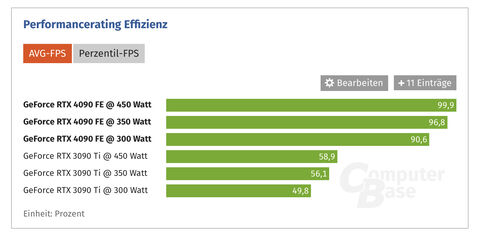

Azért amiért pl. hub is tagadásban él és buzdítja a népet, hogy most megéri dd5-t venni 4 helyett még ha 5%is jobb 2-3-szoros áron. Pont ugyanez a cél is a linkelt grafikonnál. Nincs leírva mi alapján jutottak ilyen ereményre. Még egy ovis is tudja, hogy ha összeadja ezeket a számokat akkor bőven 100%fölé jön ki az eremény és valami nem stimmel.

-

arn

félisten

válasz

PCProfessor

#126

üzenetére

PCProfessor

#126

üzenetére

Aha, mert te azt mondod. Miert allna erdekeben a cb szerkesztosegenek barminek a kiforgatasa? Kicsit tulgondolod a dolgokat.

-

arn

félisten

válasz

PCProfessor

#124

üzenetére

PCProfessor

#124

üzenetére

Hanem mit? A cb felhasznaloinak valosagat… Vagy a te bemondasra gondolt valosagod, valosagosabb, mint 5582 embere. Bocs, de inkabb ez utobbinak hiszek.

-

arn

félisten

válasz

PCProfessor

#122

üzenetére

PCProfessor

#122

üzenetére

Nem igazan ertem az osszefuggest, amit irsz… miert is kellene fejleszteni minden aron?

-

PCProfessor

aktív tag

-

arn

félisten

válasz

PCProfessor

#120

üzenetére

PCProfessor

#120

üzenetére

Valszeg tobbet lehetett valasztani.

-

arn

félisten

Jah… nem erdekli a usereket. A (cpu/gpu)gyartokat nem erdekli, de a piac majd olyan pofont, ad, hogy a fal adja a masikat. Es most a hwt ertekelo userekrol beszelunk, akik szuksegtelenul fejlesztenek, mi lehet a masik oldalon?

A hwgyartasi koltsegek amugy is torvenyszeruen novekednek a chipek bonyolultsaga miatt, nem kellene erre ratenni szuksegtelenul egy lapattal. Pl az apple is dragan gyartja oket, de ugyel a hatekonysagra is, mert tudja, hogy az o zsebeben is tobb marad.

-

arn

félisten

Jah, vegyel uj tapot, kolts dragabb kartyara, nagyobb hutore, a mai energiaarakrol nem is beszelve. Itt a hatekonysagrol van szo, nem az architektura szuksegleteirol, ami sokkal jobb is lehetne. Gyk a legujabb generacios jobb hweknel tobbszaz euro megy el a felso par szazalek elereseert. Es az sem igaz, hogy ez nem erdekli az embereket, nem en vagyok az egyetlen, akinek ez mar szurja a szemet - prociknal ugyanez tortenik pepitaban, eddig kulon fizettel a tuningos cuccokert, most megfizettetik veled, ha akarod, ha nem. Mint a ledes vilagitas.

-

Kansas

addikt

Te meg undervoltolhatod, ha neked elég a 10%-kal lassabb cucc. Már ha az tényleg csak 10%, persze... Eddig OC headroom volt a barkács szakkörnek, most UV buttroom van...

Vagy veszel egy tier-rel alacsonyabbat, az nem csak kevesebbet fogyaszt, de olcsóbb is.Régebben amikor "minden jobb volt" meg a "csúcskártya is feleennyit fogyasztott"(ja, huszadennyi grafikus képességgel), nem azért nem jártak a maihoz hasonlóan csúcsra húzva a videokártyák, hogy megcsinálják "kevesebb wattból", hanem mert akkor egy-egy sorozatnak csak töredék része bírta el a magasabb órajeleken való üzemet, mostanra megvan ez a boost technológia, aminek a használatával gyakorlatilag az összes bírja.

Mivel a nép túlnyomó többsége a teljesítményre gerjed és nem a fogyasztásra, természetes, hogy gyárilag minden kártyát a lehető legnagyobb közös nevezőre húznak, ahol még elfogadható a selejtarány. Nem fogják megengedni(Jensen különösen nem, neki presztizskérdés a dolog) hogy a konkurens kártyája elhúzzon a benchmarkokban, csak mert ők feláldoztak 10% erőt az alacsonyabb fogyasztás oltárán. -

Kansas

addikt

válasz

ElEvEn11

#113

üzenetére

ElEvEn11

#113

üzenetére

A 15 évvel ezelőttiekhez képest vagy 50x-ére nőtt a teljesítmény/fogyasztás arány, a megemelkedett fogyasztás ellenére is. Egyszerűen ez kell a mostani teljesítményigények kielégítéséhez a jelen technológiai szinten.

Gyak. a 4090 az maximum gyári OC-t kap, elszállt fogyasztással, de esélyesen a 4080 is veri a 3090-et teljesítményben, de az már kevesebbet fogyaszt... nem feltétlenül a topon levő kirakat-modell alapján érdemes megítélni az egész szériát. -

ElEvEn11

senior tag

válasz

BusinessGuy

#111

üzenetére

BusinessGuy

#111

üzenetére

Nem teljesen értek veled egyet. 15 évvel ezelőtt még megvettem egy HighEnd kártyát és nem fűtött ennyire, nem fogyasztott ekkora mennyiségű áramot sem. Most meg ez van a felső szekcióban és ez már nekem sok. Ennyi. Lovagolni nem akarok rajta. Csak leképesztőnek tartom ezt a fogyasztást és soknak. Ezért cserébe nekem már nem éri meg az a teljesítménynövekedés. IMO

-

BudaZ

csendes tag

És én még azt hittem hogy a 3000széria nagy de ezek.....

És igazából a tesztek alapján elég lenne annyi hűtés is ami a 3000szérián volt...

Én nekem még ez a limit nagyságban ami még elfogadható ennél nagyobb viszont már azért na ne legyen. Az meg hogy mennyit fogyaszt nem lényeg legalább meleg van a szobában.

-

BusinessGuy

őstag

Ja. Végülis a 3080 fogyasztására "butítva" csak 50%-al gyorsabb mint egy 3090ti...Borzalmas.

Nem fanvita. Hülyeségen lovagoltok mintha nem lenne brutális ugrás. Egy highend vga fogyasztásán lovagolni olyan mint egy Ferrari fogyasztásán lovagolni. Nem több nem kevesebb.

Ugyan olyan fogyasztás mellett brutálisan erősebb az előző 3xxx-es szériánál? Igen. End of story. -

ricsip

addikt

válasz

PCProfessor

#107

üzenetére

PCProfessor

#107

üzenetére

Úgy értem én hőfokot adtam meg, mint felső határ. Órajelet is meg lehet adni ugyanígy? Most nincs előttem, de nem emlékszem hogy azt tudtam volna. Illetve ezzel az alacsonyabb boost-nélküli base órajellel is felfuthat 80 fokosra?

-

ricsip

addikt

nincs hozzá semmi letölthető bios a gyártó oldalán

(gigabyte 2070 super windforce 3x vagy vmi hasonló).

Játék közben semmi perc alatt 80 fokra felugrik a hőmérséklet, mondjuk a ventilátort nem hagytam neki 100%-on pörögni. Inkább MSI afterburber-ben belőttem a max temp.-et 79 fokra. -

arn

félisten

Csereld le a biost, en anno 2070bol epp olyat kerestem, amin normalis huto van, de alapon megy. Ha 200w koruli kartyat akarnek, ami mittomen 2x gyorsabb… igy ket generacioval kesobb sem vagyok benne biztos, hogy osszejon - arrol nem is beszelve, hogy a csucs kozeli kartyak helyett lassan a lowendben kell keresgelnem, mert mar a kozepkategoria sem fog beleferni ebbe a tdpbe. En mar kieltem magam a 2000es evek vegen az ilyen szornyeken, nem kell megint.

-

ricsip

addikt

válasz

PCProfessor

#101

üzenetére

PCProfessor

#101

üzenetére

olyat lehet csinálni, hogy ne boostolgasson nekem pl a 2070 Superem, hanem csak a base clock-on menjen, annak megfelelő (alacsonyabb) fogyasztással? Boost eleve elkezdi 1910-en, onnan 1 perc után már csak 1875, aztán pár perc után már inkább csak 1845 v. 1830. A base clock meg valami 1750. Olyan óriási sebességcsökkenés ennyi órajelcsökkentéstől még nem kellene legyen.

-

PCProfessor

aktív tag

Lehet undervoltolni ahol 5% teljesítményt veszítesz, 100W-al kevesebbet fogyasztasz és -30°C hűvösebbé teheted. Van megoldás csak bele kell nyúlni a beállításokba. Igen, átlagfelhasználóként nem kéne ezt megcsinálni, mert ők kimaxolnak mindent, hogy legfelül legyenek a grafikonokon...

-

ddekany

veterán

Az lenne "mérnökileg" az ésszerű, ha lenne hely fenntartva ugyan olyan hűtőknek, mint amit CPU-ra teszünk. Torony, 120 mm-es ventillátor, ház hátulján luk ahol kifúj. Persze itt el van fordítva oldalra, szóval kell izom a PCI-E csatlakozóba... vagy valami szabványos támasztó. Ne persze ilyen sosem lesz...

-

Yany

addikt

Jaja, Ampere szériában kifejezetten picik a TUF kártyák, ezért van most is az a gépemben (no meg mert nem spórolták le a minőségi alkatrészeket), de 4xxx-nél nincs mese, a TUF kártyák mérete is kilőtt. Amúgy én abszolút támogatom a vastagság növelését, akár úgy is, hogy merőlegesen 8~10cm-es ventit rá lehessen tenni, halk, hűs és menő is lenne, úgysem használja a kutya sem már az alaplap lentebbi részeit, aki meg igen, az talál magának kisebbkártyát bőven.

-

Yany

addikt

válasz

JóképűIdegen

#88

üzenetére

JóképűIdegen

#88

üzenetére

Mondjuk az én házamba pont nem férnek bele ezek a monstrumok, pedig nem is olcsó és talán nem is annyira réteg. Bár a FE lehet, hogy éppen belemegy.

-

Cefet

aktív tag

Valószínűleg nagyon jó lesz az AMD kártyája, ha az NV ezt volt kénytelen kiadni...

Dettó mint a Zintel... Csúúúúcsteljesítmény... de milyen áron?

-

ddekany

veterán

Nem 50%-el, hanem 100/55 - 100% = 82%-al gyorsabb 3090 Ti-nél 300W-on. A benchmark megnyerésre szánt termékekkel mindig ez az esztelenség van, minden gyártónál. Elég kétélű kard ez a fajta PR... Annyit megtehetnének, hogy max fogyasztású, és az épelméjű beállítás tesztelésére is biztatják a szaksajtót. Mondjuk ettől a hűtés mérete nem fog csökkeni, de legalább csendesebb lesz alacsonyabb fogyasztáson.

-

ElEvEn11

senior tag

válasz

BusinessGuy

#36

üzenetére

BusinessGuy

#36

üzenetére

Fogyasztások, mert mindkét oldalon túl nagy. Ezt nem fogom ilyen faszkodós fan-boy vitába elvinni. Semmi értelme. Mindkét gyártó óriási fogyasztású kártyákkal tud csak előállni. Ez nem jó. Pont.

-

JóképűIdegen

tag

Marcsak ezzel a merettel is elvittek a show-t, mindenki errol beszel hogy Wow mekkora. Azert ne essunk mar tulzasba hogy alig van gephaz amibe belefer. Egy O11D Mini-be is siman elvan.

Jo ne a 20 euros hazak kozott nezegessunk, de gondolom 120 euro nem fog senkit falhoz vagni aki 4090-et vesz.

Szornyulkodunk itt mekkora aztan meg 360as Aio-t teszunk a 105w Tdp-s procira ez meg le kell hutson 500w-ot

-

BaJaZo

aktív tag

Ez már vicc kategória. Akkora, mint egy PS5 valamivel jobb grafikával... Ki se számolom hány konzolt adnának érte, és akkor hol van még a PC többi része?

Talán a 60/70 széria normálisabb lesz ilyen szempontból kivéve az árát. Mivel a forint az utóbbi időben kapott néhány nagy pofont és megroggyant, sok jóra nem számitok.

Viszont érdekelne, a 3060/70/80/90-es szériából mennyit adtak el külön-külön? Érdekes következtetéseket lehetne levonni belőle, igaz, a bányászat erősen torzitja az egészet. Ilyen információt még sehol nem láttam, valaki tud ilyet? -

Fücsök007

őstag

-

Fücsök007

őstag

válasz

Cyberboy42

#81

üzenetére

Cyberboy42

#81

üzenetére

Viszont a túlzottan nagy hűtő miatt sok esetben be sem fér az RTX4090-es még nagy gépházba sem, ezt illetve volna figyelembe venniük! Ugyanez igaz az RTX4080 16GB-ra is, AMD-nél erre is ügyeltek a kisebb fogyasztás mellett.

-

Cyberboy42

senior tag

Az embereket nem érdekli hogy ki mekkorát bukik vagy nyer a kártyákon, az is mindegy hogy mekkora böhöm kártyák vannak. Azt nézik hogy a két gyártó csúcs kártyájából melyik az erősebb. tehát ha nvidia 3-5%-al elveri a amd-t (mindegy mien áron) akkor az nvidiához fordulnak, mert hát ugye ők a jobbak. Aztán persze választnak valamit a középkategóriából, és persze lehet hogy ott meg is fordul a helyzet, de hát az már majdnem mindeggy, mert a csúcson az nv a jobb, oda akarunk tartozni!

-

Yany

addikt

Az hogy van, hogy tegnap árasztotta el a netet, gyakorlatilag minden sajtóorgánum beszámolt a meglepően erős 4090-es teljesítményről, de itt 2 napja nincs hír az új generációról?

Azt reméltem a ph!-n is megér egy bekezdést, hogy az iparág egyik legkomolyabb teljesítménybeli ugrása következett be a minap.

Azt reméltem a ph!-n is megér egy bekezdést, hogy az iparág egyik legkomolyabb teljesítménybeli ugrása következett be a minap. -

tibaimp

nagyúr

Sajnálom, hogy Nálad nincs így, én imádom az RT-t, így tuti marad az Nv, ha váltásra kerül is a sor.

Ha teheted, a CP2077-et próbáld ki! Én is irtózom konkrétan még a tetoválásoktól is, meg nem gondoltam volna, hogy egy ilyen cyberpunk világ ennyire megfog, de a városnak és játéknak nagyon meg van az atmoszférája. Beszippantott.

-

Sundesz

addikt

Azért valljuk be egy jól implementált RT game changer tud lenni, csak amíg nem látja az ember egymás mellett/után, addig nem fog a raszter sem hiányosnak tűnni. Ugyan ez igaz a DLSS-re is, van ahol marha jól működik. De ahogy írtad is, ha valaki nem játszik olyan címekkel akkor felesleges fícsőr.

-

Kansas

addikt

Csak a raytracing a kutyát se érdekel, kb. egy kézen meg lehet számolni a játékokat amik minden komponensét implementálták(pl. CP2077), a másik kezeden meg azokat amik részlegesen implementálták és jók(mármint jó játékok és nem közepes vagy rossz játék techdemó-szintű RT-vel).

Talán most az új szériás VGA-kkal már bekapcsolni is érdemes lesz, a 4090 tesztek elég bíztatóak...#66tibaimp: és hány olyan játékba tettél komolyabb játékidőt(legalább a feléig-harmadáig elmentél benne), amiben érezhető pluszt ad az RT, és akkor is játszottál volna vele ha nincs benne RT?

Nem kötözködés végett, őszintén érdekel... nekem pl. PC-n egy sincs, konzolon is csak a Spiderman Remastered. -

Kansas

addikt

Hááát, nemtom, ahogy nézem, az NV elég nagyot gurított a 4090-nel, ha a lentebbi tierekben is hasonló lesz a gyorsulás, akkor a DLSS visszazorul belépőszintre meg magasfrekis játékra, mert nem lesz rá szükség a 60fps-hez RT mellett...

"azzal nem fogják megfordítani a 20-80%-os NVIDIA VGA előnyt."

Erősen kétlem, hogy ez lenne a cél a profit kárára. Nyilván nem bánnák, ha közelednének az NV-hez, de kétlem hogy durva árversenyre ragadtatnák magukat érte... arra ott lesz az Intel Arc... -

PuMbA

titán

Most az AMD-nek nagy esélye van, de megint ott fog eldőlni, hogy hoznak-e valami újdonságot November 3-án vagy csak az NVIDIA után megcsinálják a ugyanazt mögöttük kullogva. Ahogy sok nagy YouTube csatornán is mondják, fícsör vagy valami nagy ok kell, amiért az AMD-t választják az emberek. Az hogy kicsit gyorsabb meg valamivel alááraznak, kevésbé számít....azzal nem fogják megfordítani a 20-80%-os NVIDIA VGA előnyt.

-

Kansas

addikt

Nem tudom, miről beszélsz...

Az előző generációban se egymáshoz voltak árazva, még azok se amiknek az MSRP ára megegyezett, a boltokban az AMD érezhetően olcsóbb volt, időnként egy komplett tierrel alá árazva az NV kártyáknak... mikor a mostani kártyámat vettem, az RTX3060 is drágább volt, mint a 6700XT, a csúcskártyák között pedig MSRP-ben másfélszer annyiba fájt egy RTX3090 mint egy RX6900XT... -

Sundesz

addikt

Brutális lett az RTX 4090 a tesztek alapján, perf/watt mutatója sem rossz. Azért egy hírt igazán megérdemelne itt a PH!-n is.

-

tibaimp

nagyúr

Ha jól tudom holnap jár le az embargó és jöhetnek a tesztek! Kíváncsi vagyok mit tolnak ezek a szörnyek, főleg úgy, hogy 3GHz-ig is elmegy a turbó órajele a GPU-nak!!

-

Kansas

addikt

Csak ha nincs a NYÁK-ra szabott coldplate-ed, vagy ha nem ugyanazzal a coldplate-tel/körrel akarod hűteni őket, mint a GPU-t.

De ha standard NYÁK-ot használ akkor azért az ilyen cégek, mint az EK, szoktak rá passzoló coldplate-et gyártani.

Ha custom NYÁK-os karid van, akkor esélyesen így jártál, ha nem férsz hozzá CAD-hoz/CNC maróhoz, stb-hez... de ezért szoktak a vízhűtés-rajongók stock karikat venni... a nagypénzűek meg gyárilag vizezett karikat(bár nem biztos, hogy nem a custom vizezés a drágább). -

Kansas

addikt

válasz

BusinessGuy

#36

üzenetére

BusinessGuy

#36

üzenetére

Meg egy generációval fiatalabb... Mennyit is evett a 6900xt-vel közel megegyező tudású 3090? Csak nem 15-20%-kal(~50W) többet? Nem TBP, tesztelők által kimértfogyasztás szinten... ja, de.

Amíg az AMD evett többet, addig jöttek a radiátoros-kazános beszólások... de már második generáció jön ki, amiben az NV kártyák(főleg a csúcson) étvágya jelentősen nagyobb... mégis mit gondoltál, hogy senki nem fogja szóvá tenni?

"4080 16gb annyit eszik mint egy 6900xt cserébe 30%-al gyorsabb"

Ezt vajon a független tesztek is alá fogják támasztani, vagy csak úgy bemondásra higgyük el? -

JóképűIdegen

tag

-

arn

félisten

válasz

JóképűIdegen

#40

üzenetére

JóképűIdegen

#40

üzenetére

Epp azert nagy, mert sokat fogyaszt

-

JóképűIdegen

tag

Hat nem tudom engem nem zavar a nagy merete (a nagy fogyasztasa mar inkabb) legalabb van mit nezni az uveghazakban, mert a mai gep mar csak egy fuggoleges alaplap, az meg onmagaban benan nez ki egy "50literes akvariumban"

-

ttt

senior tag

Egyiknek sem kell, ha olyan a lakásod vezetékelése, csak illik. Hogy ne kelljen túlméretezni minden vezetéket észszerű célvezetéket húzni. Az inverteres klímának az alap funkciója a hűtés, oda nem kellenek nagy áramok, mint fűtésére - a mostani lúzungokkal ellentétben - az átmeneti időszakra alkalmasak csak, nem folyamatos lakásfűtésre. Ha mégis erre lesz mostanság beépítve, ott is erősen ajánlatos célvezetékkel meghajtani és akkor nem lesz random áramszüneted a lakásban.

-

hardzsi2

aktív tag

...és téglából is a méretesebb falazóblokk: How big is the Nvidia RTX 4090?

Sok előttem szólóhoz hasonlóan én sem látom ezt életképes iránynak.

-

zetor2000

őstag

Mert egy VGA nem feltétlen szabványos felfogatású hűtéssel rendelkezik. Még talán a csavarok, meg a 4 luk távolsága egy ideje talán azonos, de ez sem biztos.

Ja, lehetne kidolgozni rá egyfajta sztenderdet, hogy ittésitt van a felfogatás, alá kéne tenni a grafikus izét, aztán hajrá. De valamiért nem teszik.

Pedig régen volt Zalman VGA hűtés... de leszoktak róla. -

arn

félisten

ha a 4090 200 watt lenne, egesz jo szeria lehetne - nem mellesleg vmivel olcsobb is.

-

Terek

tag

Bizony,hogy nemvagy vele egyedül.Én már az rtx 2060 super megvételekor láttam annó,hogy ez a vonat elment és nemjön vissza

A 4060-70-hez nemkell nagy reményeket fűzni(ha minden igaz 96-128 bites memóriabuszt kapnak

A 4060-70-hez nemkell nagy reményeket fűzni(ha minden igaz 96-128 bites memóriabuszt kapnak  ) Biza az Amd követni fogja az nv-t árazásban(láthatjuk az új processzoraik árain is)

) Biza az Amd követni fogja az nv-t árazásban(láthatjuk az új processzoraik árain is)

-

BaJaZo

aktív tag

Úgy gondolom számora itt a vége a VGA cserélgetésnek és gyanitom nem leszek egyedül. Még kiváncsi leszek a 4060/70 teljesitményére, fogyasztására, méretére, árára, de nincsenek illúzióim. A folyamatos cserélgetés mostanra olyan súlyos kompromisszumok mentén lehetséges csak, ami elgondolkoztató. Meglátjuk mivel rukkol elő az AMD, de nem számitok csodára. Marad ami van, (3060ti) megy amig megy, aztán lesz ami lesz - vagy nem lesz...

-

fanti

addikt

Miért nem tervezték mindjárt ipari áramra?

Mert ha ez még nem, a kövi gennek már tuti kelleni fog, vagy pedig mint a kombi gáztűzhelyek, amiknek hőlégkeverős villanysütője van, külön ágat kell húzni a lakás biztosítékszekrényéből...de oda se neki, éljen a zöldenergia, és a szandálunk újrahasznosítása... -

janos666

nagyúr

Már régóta vannak after-market full-cover VGA blokkok, sőt olyan termékek is, mikor a VGA gyártó szereli fel ezeket (amit általában apró design módosításokkal rendel a vizes cégtől, mint pl. hogy egyedi logót gravíroznak rá, RGB LED-et is tesznek bele, amit a VGA tud vezérelni, stb) és még garanciát is vállal rá. Jobb esetben ez azt "OC" NYÁK-ra teszik rá (bár nem mindig).

-

válasz

undercover

#20

üzenetére

undercover

#20

üzenetére

Egyértelműen videótégla.

-

Televan74

nagyúr

válasz

undercover

#20

üzenetére

undercover

#20

üzenetére

Kisméretű tégla, fűtőszállal!

-

Ixion77

addikt

Ha már a GPU-k fogyasztása akár nagyobb is lehet, mint a CPU-ké, miért nem lehet itt is megoldani mint a CPU-k esetében hogy a szabványos foglalatra a user olyan hűtőt rak amilyet akar?

Akkor aki csendet szeretne, szépen rákötné a 360-as radiátoros AIO-t, és probléma megoldva. -

undercover

őstag

Szerintem ezt már nem videókártyának kéne hívni

Hanem mondjuk videó blokk.

-

tibaimp

nagyúr

válasz

Armagedown

#17

üzenetére

Armagedown

#17

üzenetére

Igen, kb! Nekem is ez jutott eszembe.

-

Armagedown

őstag

Ez a Fermi reinkarnációja?

-

Abu85

HÁZIGAZDA

Ahhoz, hogy a legforróbb pontot megtaláld és valóban mérd nem elég egy szimpla hődiódás rendszer. Egyfajta szenzortömeg kell, ami a terhelést térképezi fel, és onnan számolja a legforróbb pontot. Az NVIDIA rendszere egyszerűbb. Van egy dióda, ami mér, és a tesztek során számos különböző szimuláció alapján meghatározzák, hogy a legforróbb pont az a különböző terhelések mellett mennyivel magasabb a mérték értéknél. Ezt kódolják le a rendszerbe, ami végül a diódát kiméri, majd hozzáadja a lekódolt értékeket, és annyira becsüli a legforróbb pontot. Ez az érték tehát egy tipp, de elég közel lehet a valósághoz.

-

ricsip

addikt

MIért nincs hotspot monitoring? Egyáltalán nincs, vagy csak az nvidia titkolja az értéket a külvilág felé, a GPU viszont látja tisztán? Csak mert állítólag az RTX2000-en sem volt hotspot mérés, a HWinfo viszont talán tavaly óta egyszercsak elkezdte mutatni 1 update után. Az kamu érték (becslés / tippelés) vagy konkrétan a GPU kezdte el megmondani ezt az adatot a külvilágnak?

-

ddekany

veterán

-

ElEvEn11

senior tag

-

Tomassy00

senior tag

Te vagy már a 3725. aki belinkeli...

-

nihill

őstag

-

BaLee

addikt

Egyszer vettem kisméretű kártyát, mert hallgattam a tanácsra, hogy "jaj de hát, ezek nem melegednek annyira". Soha többet. Terhelés alatt még a 2 ventis kártya is olyan hangos volt, hogy szinte fejhallgatón keresztül is behallatszott a hangja.

Azóta inkább nagyobb (ha a házban amúgy is elfér) jobb hűtésű kártya akár 5-10% felárral is...

-

Anno a 20-as szériánál iszonyatosan nagyok voltak a chipek, mintha ott is pont ugyanez lett volna pletyka, hogy eredetileg kisebb csíkszélen gyártották volna a Samsungnál, de végül valamiért a TSMC-nél kötöttek ki, egyedi gyártósoron (12 nm FFN, azaz FinFet Nvidia).

Aztán a 30-as szériát ugye a Samsungnál gyártották.

Most a 40-es szériánál meg habár nem nagyok a chipek, de úgy zabálnak, mintha azok lennének, és megint nem a Samsungnál készülnek, hanem a TSMC 4N-en, ahol ugye N = Nvidia, tehát egyedi gyártósor.

Új hozzászólás Aktív témák

- iPhone 14 Pro Max 128GB Space Black -- 100% EREDETI AKKU, 1ÉV

- Eladó megkímélt Samsung A71 6/128GB / 12 hó jótállás

- Bomba ár! Lenovo ThinkPad T430s - i5-3GEN I 8GB I 320GB I 14" HD+ I Cam I W10 I Garancia!

- Tablet felvásárlás! Samsung Galaxy Tab S10+, Samsung Galaxy Tab S10 Ultra, Samsung Galaxy Tab S10 FE

- Gamer PC-Számítógép! Csere-Beszámítás! I7 6700K / RTX 2060 6GB / 32GB DDR4 / 500 SSD

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Azt reméltem a ph!-n is megér egy bekezdést, hogy az iparág egyik legkomolyabb teljesítménybeli ugrása következett be a minap.

Azt reméltem a ph!-n is megér egy bekezdést, hogy az iparág egyik legkomolyabb teljesítménybeli ugrása következett be a minap.

A 4060-70-hez nemkell nagy reményeket fűzni(ha minden igaz 96-128 bites memóriabuszt kapnak

A 4060-70-hez nemkell nagy reményeket fűzni(ha minden igaz 96-128 bites memóriabuszt kapnak