-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

HSM

félisten

válasz

S_x96x_S

#59699

üzenetére

S_x96x_S

#59699

üzenetére

Ajánlások... Azért az is megérne egy külön elmélkedést, vajon mennyire volt ez jó a szoftverfejlesztőknek/piacnak, hogy az egyik, igen meghatározó gyártó a saját ajánlásaival gyakorlatilag az ellentétét ajánlotta, mint amit a szabvány, és a platform tulajdonosa.

#59720 Petykemano : Szerintem itt a karizma is szerepet játszik. A zöldeket és víziójukat kitűnően el tudja adni a bőrkabátos. A piros oldalon nincs egy ilyen stabil, évtizedes múltú, karizmatikus vezető, jönnek mennek az emberek. Lásd, az almások sem buktak bele az iPhone4 antennás történetébe [link] ...

"... az emlékezetben mégis az marad meg, hogy az AMD folyamatosan bénázik, az Nvidia meg király"

Egyébként ebben benne lehet az is, hogy pl. a "poor volta" meg hasonlók után nem úgy alakultak a dolgok... Ehhez képest a zöldek, ha úgy adódott, inkább megépítettek valami irdatlan nagy és drága csúcs-GPU-t, mindegy hogyan, csak az legyen az aktuális benchek tetején... Ez pedig erősen kompetenciát sugall. Ehhez képest a pirosaknál néha komplett termékkategóriák estek ki...#59721 fLeSs : "kiderült, hogy user error"

A tökéletlen csatlakoztatás user error. Az viszont, hogy miért csak dísznek vannak a kommunikációs erek, és miért ilyen "félkész" állapotban lett ez az újfajta csatlakozási fajta kiadva, na az már nem annyira."Azt nemtom megmondani, hogy mi miért van többszáz millió ember fejében."

Egy ideig egyébként tényleg volt valóságalapja, hogy rövidebb pórázon voltak tartva a gyártópartnereik. A pirosaknál jobban meg kellett válogatni, ha jó kártyát akartál, nagyobb szórás volt. De ennek már elég sok éve, RDNA előtti időkben volt ez igaz... Ehhez képest ma ugyanúgy vannak gondok zöld oldalon is, pl. [link] , de a 3090-eken a VRAM hűtés sem volt sok példányon kielégítő, tele a net leírásokkal, hogyan lehet az elspórolt, silány gyári hőpadokat jobbakra cserélni, mindezt egy 1500$-os MSRP-jű terméken... -

HSM

félisten

Ebben az is benne lehet, hogy a 4070Ti mindenhol nagy számban kapható, ezerféle modell. Ehhez képest 7900XT és XTX alig és kevés fajta van készleten, főleg az AIB modellek ritkásan.

Én egyébként gondolkozás nélkül egy jó AIB 7900XT-t vinnék 4070Ti-k helyett. Van egy 3060-am, engem nem győzött meg különösebben sem a DLSS, sem a driver. Ugyanúgy teszi a dolgát a 6800XT is. Persze, valamivel több a bug, de ezt nálam ellensúlyozza, hogy nincs regisztrációhoz kötve egy halom hasznos funkció, és ezerszer kényelmesebb a felület. -

HSM

félisten

"Magyarul ott is megmaradt e ez vagy az RDNA3 mar elter a 2-tő."

Ha már találgatós... Nem hinném, hogy eltérne. A blokk alapján maradt a parancskiosztás alapvető felépítése, így a driver sem hinném, hogy jelentősen eltérne, legfeljebb a shader fordítás bonyolódott picit meg a dual-issue miatt.

RDNA2: [link] , RDNA3: [link] . -

HSM

félisten

Én nemrég próbáltam a next-gen Witcher 3-ban mindkettőt minőségi beállításon, ugyanaz a minőségvesztős homályos kép.

A DLSS kicsit kevésbé, mint az FSR2.1, de inkább maradtam natív, de alacsonyabb felbontáson ugyanahhoz az FPS-hez TAUU-val, tűéles, részletes, gyönyörű képpel.

A DLSS kicsit kevésbé, mint az FSR2.1, de inkább maradtam natív, de alacsonyabb felbontáson ugyanahhoz az FPS-hez TAUU-val, tűéles, részletes, gyönyörű képpel.Ami meg a tempót illeti, max RT-vel az RX 6800XT-n volt natív FHD-n 30-35FPS, a 3060-al natívan 20, minőségi DLSS-el épphogy 30, de úgy meg a képminőség ment a sutba. Számomra egyáltalán nem lett volna ez így alternatíva. Persze, a 6800XT nyilván drágább, de van is mögötte teljesítmény. Az RT-hez szükség is van rá.

-

HSM

félisten

Tényleg nem értem, mi nem érthető azon, hogy a CPU-t próbálta tesztelni, kiiktatva a GPU limitáló hatását?

De volt ott azért gyengébb VGA is, szemléltetve a reálisabb összeállítást.

De egyébként nekem WQHD alatt is már kevésnek érződött bizonyos címek multijában az R5 3600-asom (kb a tesztbe az 5500 szintje) egy RX6800XT mellett, az 5600-al viszont már kellemes a tempó mindenhol. -

HSM

félisten

Fussunk neki mégegyszer! H264 videót kell készíteni, mert azt eszi meg a platform. Innentől kezdve édesmindegy, mit tud az AV1. H264-ben pedig az RX6000-es szériáig az Nv enkódere jobb képminőséget adott a tesztek szerint azonos bitrátán. És ezek szerint a 7000-eseken sem érdemes javulást várni...

Persze, releváns, hogy az AV1 minősége milyen, ezt a kört még megnyerhetik, de a streaming kapcsán a H264 is ma még releváns.

-

HSM

félisten

válasz

TESCO-Zsömle

#59567

üzenetére

TESCO-Zsömle

#59567

üzenetére

Jó ajánlat amúgy.

Mondjuk nekem is az egyik legjobb 6800XT van (XFX Merc 319), 1200rpm-en rendkívül csendesen megy bő 1V körül közel 2.4Ghz-et, szóval nem is biztos, hogy előrébb lennék vele...

Mondjuk nekem is az egyik legjobb 6800XT van (XFX Merc 319), 1200rpm-en rendkívül csendesen megy bő 1V körül közel 2.4Ghz-et, szóval nem is biztos, hogy előrébb lennék vele...

#59568 Abu85: Hiába "elavult", ha bizonyos platformokon ma is ezt használják...

Amíg így van, addig ez egy előny Nv kártya mellett.

Amíg így van, addig ez egy előny Nv kártya mellett.#59570 Abu85 : "Ezért is lettek új formátumok, mert a limitjeit így lehet kezelni."

Amíg az Nv enkódere azonos bitrátán jobb képminőséget képes biztosítani, addig az nem a H264 korlátja.

-

HSM

félisten

Az elmúlt ~1 hónap HA-s árai alapján 220-250K között láttam garis 6800XT ajánlatokat, 6900XT-ből viszont nem igazán volt 300K alatt, ebből indultam ki. Aztán persze ez folyamatosan változik, éppen mit mennyiért adnak.

Kicsit csodálkoztam is, hogy ahhoz képest, hogy teljesítményben a 6900XT-hez van közelebb, árban alig kerültek többe a sima 6800-nál a 6800XT-k. Így elég hamar elvetettem a 69x0XT upgrade lehetőségét.

-

HSM

félisten

Jelenleg szerintem ami jó vétel, az egy használt 6800XT. Azért gondolom, mert amit kapnék érte használtan mindig arra jutok, hogy annyiért nem érné meg eladni.

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz.

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz."és ugye még mindig ott a DLSS, RT, fasza NVENC, stb, ami mind mind extra a puszta számokon túl"

Ezeket egyébként Radeonon is megkapod. DLSS helyett ott az FSR2, szvsz nem lényegesen rosszabb. A natívhoz képest egyik sem győzött meg képminőségre.

RT-t a Radeon is tud. Lassabban, de bőven nem használhatatlan. Az NVENC helyett ugyanúgy van bennük enkóder, csak azonos, alacsony bitrátán van képminőség hátrány, de ez szvsz csak streamereknél lényeges hátrány, ahol fontos, hogy a lehető legalacsonyabb bitrátán a legjobb képminőség legyen elérhető.A használt 3090 ellen szvsz azért szól jópár érv. Egyik a bánya. A kétoldali, erősen melegedő 24GB ram hűtése kevés kártyán volt elfogadhatóan megoldva, ami rengeteg moddoláshoz vezetett, és elfáradt memórialapkák lehetnek a következménye. Ami persze kis szerencsével megfelelő tudású és felszereltségű szakember által persze javítható, de nyilván nem olcsón. A másik a koruk. 300-350 000 forintot adni aprón egy 1-2 éves kártyáért, amin legfeljebb egy, másfél év garancia van, és könnyen lehet sülve a ramjuk?

Szerintem ezzel szemben (és a hasonló áron, 450k körül kínált 4070Ti-al szemben is) jó alternatíva az újonnan, kiskerben, készletről 450 000 forint körül megvehető 7900XT. MSRP alapján az XTX lenne a jobb vétel, de mivel nem kapható, és ha igen, akkor is 600 000-et karistoló árral, annyiért nem tűnik annyival jobbnak.Én arra leszek kíváncsi, mikor fog szelídülni picit az árazás. Mert igazából az elért teljesítmény szvsz egyáltalán nem rossz, a perf/$ arányon lehetne még csiszolni picit.

No, meg megoldani, hogy ne 100W körüli fogyasztású legyen egy videólejátszás/multi-monitor, de remélhetőleg ezt csak idő kérdése lesz a driveres csapatnak kicsit javítani. A Navi21 is először elég magas értékekkel jelent meg, ami pár hónappal későbbi driverekkel lényegesen javult még.

-

HSM

félisten

válasz

Raggie

#59539

üzenetére

Raggie

#59539

üzenetére

A többi mondatból szvsz világosan kiderül, pl. "Úgy lett volna az egész, mint az RDNA 2-nél". Ott sem volt nagyobb csip a 6900-ason.

"Engedélyezték az összes feldolgozót, és levitték az órajelet, hogy energiahatékony legyen."

Tehát a 6800XT-vel ellentétben az eredetileg 7800XT-nek szánt verzió letiltott feldolgozóit engedélyezték, és így lett egy visszafogottabb, kisebb hűtős, hatékonyabb 7900XTX belőle, mint ami a mostani 3x8 tűs OC verzióknál látható.

-

HSM

félisten

válasz

Csokissütis

#59536

üzenetére

Csokissütis

#59536

üzenetére

"az eredeti 7900-es kari ki lesz e adva"

Ki van adva, ahogy Abu jósolta, gyári tuningos kártyaként. [link]

Tulajdonképpen minden stimmel, 3x8 Pin, 450W fogyasztás, 3Ghz körüli órajel, össszes feldolgozó engedélyezve....Az is jól látszik, miért nem így adták ki, +100W fogyasztásért elenyészően gyorsabb csak. Nekem sokkal jobban tetszik így, hogy hatékonyabb lett a gyári modell, vágatlan GPU-val, és aki akar, még mindig vehet szobafűtésre optimalizált OC kiadást.

-

HSM

félisten

válasz

Petykemano

#59508

üzenetére

Petykemano

#59508

üzenetére

-

HSM

félisten

válasz

Petykemano

#59505

üzenetére

Petykemano

#59505

üzenetére

"Ha tippelnem kéne ... hogy a Packed Math feature nem jött be"

Szerintem más oka lehet. Pl. az utasítás kódolás oldaláról már lehet túl bonyolult lett volna 4db FP16-ot sűríteni egy utasításba, az már elég sok operandus címet igényelne. -

HSM

félisten

"A wave32 leginkább azért fontos, hogy mondjuk egy wave32 mellé be tudj szúrni egy RT vagy egy kikódolási műveletet mondjuk a DirectStorage-hoz. Ezzel az RT és a DS ingyenessé válik, mert ugyis van már egy wave32-d, ami fut, csak mellette nem fut semmi."

Köszi a levezetést, valami ilyesmire számítanék az elmélet alapján, ha kiforrta magát a driver.

Azért írom, hogy ha kiforrta magát a driver, mert a mai tesztekben úgy tűnik, ez még nem működik ilyen jól, első ránézésre ugyanúgy megrogyik RT alatt, mint a Navi21, arányaiban is hasonlóan.

Persze, lehet ez ennyit tud, vagy valami más fogy el, de akkor igen csalódott lennék...

-

HSM

félisten

válasz

Petykemano

#59457

üzenetére

Petykemano

#59457

üzenetére

Egyébként az Amper architektúrán is megfigyelhető, hogy a dual-issue azért nem olyan hatékony, mint az elméleti maximum, pl. hiába tud a 3080 "papíron" 30 Tflops-ot, RT nélkül sebességben ott van vele egy ligában a 20Tflops-os 6800XT....

"Mindenesetre a kötöttségek sokasága magyarázza..."

Igazából az RT-re leszek kíváncsi, ha majd kicsit jobban kiforrta magát a driver. Úgy emlékszem, azzal (is) magyarázták az új felépítést, hogy a dual issue jól használható RT mellé. -

HSM

félisten

válasz

Petykemano

#59455

üzenetére

Petykemano

#59455

üzenetére

Az out-of-order vajon honnan jött? A forrásban independentet látok. Ez a limit Nv-n is adott.

Érdekes adalék, hogy ilyen sok megkötés van. Nv-nél is izgalmas lenne megnézni ezt, bár ők nem kötik ezt a publikum orrára.

-

HSM

félisten

válasz

Petykemano

#59432

üzenetére

Petykemano

#59432

üzenetére

Benne van. Ugyanakkor én a részükről is érteném a dolgot, nyilván nekik jelentős felesleges pluszköltség lenne, ha hirtelen boldog-boldogtalan, akinek különböző okokból eléri a 110 fokot (pl. rosszul szellőző gépház) egyből szaladni garizni, hogy hibás....

#59433 Ribi : Emelkedik az itt is, csak kezdetben gondolom a hirtelen jelentősen emelkedő ventilátor majd a kezdődő throttling még ellensúlyozza a melegedést valahogyan. Látszik, hogy ott kezd a dióda csökkenni, ahol már nagyon közelíti a hotspot a 110 fokot.

Nem leáll a chamber, hiszen továbbra is nagyjából kordában tartja a kártya hőtermelését, csak drasztikusan esik a hatékonysága valamiért. -

HSM

félisten

válasz

Petykemano

#59425

üzenetére

Petykemano

#59425

üzenetére

Én csak azt mondom, nem önmagában a 110 fok a baj...

Hanem hogy pl. üvölt a venti, vagy hogy nem ez volt a review-okban.

Hanem hogy pl. üvölt a venti, vagy hogy nem ez volt a review-okban.Én nem tartom kizártnak, hogy számítási hiba súlyosbítja az amúgy sem túl rózsás helyzetet. Nekem azonban a fő oknak valami gond tűnik a Vapor-chamberrel. Ahogy der8auer is mondja a videóban, akár tervezési (a forma), akár gyártási (pl. bizonyos példányokba nem töltöttek elég folyadékot) is lehet a probléma forrása. Ezt nem tudjuk még. De az biztos, hogy nem egészséges, ahogy vertikálisan beépítve némely kártya viselkedik.

A dióda által mért, számítási hibáktól vélhetőleg mentes adat is egyértelmű és jelentős hőfok emelkedést mutat a ventilátor szignifikánsan magasabb fordulatszáma ellenére, ami szintén a rendellenes hűtés működést erősíti meg.#59426 Abu85: Szerintem te is tudod, hogy ha max 6% órajelkülönbség volt power virusban, akkor normál játékban sem lesz ennél több. A probléma, hogy közben halláskárosult lesz a kártya 'boldog' tulajdonosa.

-

HSM

félisten

Nem nyert. Nézd meg jobban a videót az időbélyegnél, amit linkeltem (elég rápillantani, kikerestem a releváns 1 másodpercet a GPU-Z ablakkal). Beton stabilan, tartósan vízszintes volt a ventilátor fordulatszám a GPU-Z ablakban, amíg nem fordította át vertikális állásba.

Minden kétséget kizáróan az elfordítás okozta a változást, nem az idő. -

HSM

félisten

Ez nem igaz... Itt van kimérve ugyanaz a kártya.

Vízszintesen: 2500Mhz@1725RPM [link]

Függőlegesen: 2352Mhz@2850RPM [link]

Ez igen jelentős különbség. Persze az látszik, hogy a kártya inkább a felhasználó fülét bünteti, hogy meglegyen az elvárt órajel.#59421 Ribi: Egyértelmű, hogy nem jó, de nem a 110 fok miatt nem jó...

Egyébként ez is felvet érdekes kérdéseket, hiszen úgy tűnik, a specifikált 2300Mhz "game" órajel megvan (legalábbis furmarkban, lol), tehát a specifikáció az első mérések alapján teljesül, ugyanakkor az egy érdekes kérdés, mit tehet, aki mondjuk a vízszintes tesztek alapján jogosan egy lényegesen halkabb kártyát várt....

Lásd pl. [link] , ez alapján egyértelműen egy kényelmes hőfokokon ~1700rpm környékén üzemelő kártyára lehet számítani, ami még így sem valami halk 39dBA-val.... Milyen lehet 2800rpm-en?

-

HSM

félisten

válasz

Petykemano

#59418

üzenetére

Petykemano

#59418

üzenetére

"a lapka igénybevétele, vagy más mérési pontok jóval alacsonyabb hőmérséklete alapján sok esetben ott azon a bizonyos mérési ponton sem kellene 110°-nak lennie."

Egyfelől igen. Egy "mérési pont" van, ha Abu információi helytállóak, amit látunk is pl. a linkelt videóban, ez az alacsonyabb. Illetve van egy "hotspot", ami számolt, így akár téves is lehet bizonyos körülmények között. A mérési pont és a számolt hotspot között a vertikális állásban 35 fok a különbség, ami erősen szélsőségesnek tűnik. Bár a hűtő hibája is okozhat szélsőséges viselkedést, de ez annál nagyobbnak tűnik, önmagában vapor kamra vörösréz falának át kellene vinnie egy csomó hőt ilyen kis távolságra.Nekem úgy tűnik, hogy egyfelől a vertikális pozícióban nem működnek jól az érintett hűtők (~10 fokkal magasabb hőfok 1750 helyett 2850rpm fordulattal

) másfelől ezáltal mintha valami bugba is belefutna, és irreálisan elszállna a hotspot hőfok, ami miatt elkezdi visszavenni magát a kártya.

) másfelől ezáltal mintha valami bugba is belefutna, és irreálisan elszállna a hotspot hőfok, ami miatt elkezdi visszavenni magát a kártya.Természetesen, előfordulhat, amit írsz. Ugyanakkor nem tartom valószínűnek. De azt is fontos kommunikálni egy ilyen esetben, hogy a 110 fokos hotspot még nem szükségszerűen jelent működési gondot, mivel az emberi természet hajlamos túlpánikolni ilyen eseteket, és már most látszik, hogy sokakban az marad meg, hogy ha 110 fok akkor az hibás, és nem garizzák. Miközben ez ennél mint láttuk sokkal összetettebb. Nyilván, a gyártónak épp elég költség lesz a valóban hibás példányokat cserélni, pánik nélkül is...

-

HSM

félisten

Bennem is megfordult a számítási hiba lehetősége. Viszont még így is van egy megoldandó feladvány... Miért csak akkor bolondul meg, ha más pozícióban van a kártya, és néhány fokkal melegebb? Illetve a vertikális beépítésnél kicsit soknak tűnik, amennyivel többet pörögnek ventik és még így is 10-15 fokkal többet mér a dióda is....

Volt nekem Vapor-chamberes kártyám, az nem borult így meg, ha vertikálisan használtam.

Volt nekem Vapor-chamberes kártyám, az nem borult így meg, ha vertikálisan használtam. -

HSM

félisten

válasz

Petykemano

#59408

üzenetére

Petykemano

#59408

üzenetére

Én itt nem a 110 fokban látom a problémát... Hanem abban, hogy az érintett kártyákon bizonyos pozíciókban üvölt a refhűtő, és közben a kártya throttlingol, ami szerintem egyáltalán nem az elvárható működés egy prémium videókártyánál.

Egyfelől amúgy úgy látom, Abu magyarázata szerint is hibás a kártya, hiszen a 110 fokos jelenségnél 35 fok volt a dióda és a hotspot között, míg a normális működésű szögben csak 25.

Szerintem ez azon fog múlni, el fogja-e érni a kártya a specifikált "game clock"-ot, ami 2300Mhz [link] . Ha eléri, akkor bajos lesz üzemzavart rájuk bizonyítani, hiszen amit hirdettek az megvan, ha viszont ezek a kártyák nem érik ezt el, akkor bizony garisnak kellene lenniük.... -

HSM

félisten

válasz

Busterftw

#59405

üzenetére

Busterftw

#59405

üzenetére

Az első egy, másfél perc innen megválaszolja a kérdésed: [link], röviden, tömören, szórakoztatóan.

Nekem a kábelszámmal soha nem volt az égvilágon semmi bajom. A centi vastag vackokkal, amikkel bebugyolálták és értelmes kábelvezetésre alkalmatlanná tette őket néhány gyártó, na azzal már volt bőven.

De ezt persze nem oldja meg ez a remekmű...

De ezt persze nem oldja meg ez a remekmű...

Volt nekem egy szuper Seasonic Platinum passzív tápom [link] , csupasz szalagkábel volt a PCIE tápkábele [link] , azzal egy álom volt dolgozni minden felesleges marhaság nélkül, soha olyan szép, rendezett nem volt belül a gépházam, mint azzal. -

HSM

félisten

Ezért is lett volna rajta a tetején az a néhány pin, hogy azok csak akkor érintkezzenek, ha teljesen bedugtad. Volt is róla szó, hogy talán rövidebbre kellene hagyni emiatt.

A képeden látható 4 pines CPU csatlakozók nem a rossz csatlakoztatástól égtek le, hanem a rájuk kötött, 150-200W-ra agyonhúzott CPU-któl.

-

HSM

félisten

válasz

Petykemano

#59401

üzenetére

Petykemano

#59401

üzenetére

A 110 fok hotspot normális, de ha közben a GPU hideg, akkor nem... [link] Ezt Abu is megerősítette, hogy ezügyben vizsgálódnak.

-

HSM

félisten

Óriási tervezési hiba, hogy be lehet úgy dugni, hogy nem csatlakozik jól... Meg ne hajlítsd meg 3 centin keresztül... Hol élt aki ezt így elképzelte?

Szerintem el lett kapkodva igazából az egész, ahogy ezt bevezették.

Szerintem el lett kapkodva igazából az egész, ahogy ezt bevezették.

#59398 Devid_81 : Azt hiszem, jó lesz nekem az XFX Merc 6800XT még egy darabig. Se bohóckodó Vaport chamber, se csinos mini-gyulladó csatlakozó.

Unalmasan Plug&Play...

Unalmasan Plug&Play... ![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

Sundesz

#59393

üzenetére

Sundesz

#59393

üzenetére

"A 7900 XT valójában a 7800 XT"

Szerintem helyesen jártak el abból a szempontból, hogy a x800-as sorozat eddig tipikusan 256bites volt, az efelettiek kerültek az x900-as szériába. Számomra inkább a 6900-as lógott inkább ki a sorból, különösen egy 6800 és egy 6800XT nevű testvérmodellel... Annak kellett volna inkább 6800XTX-nek lenni.A 4080 esete viszont erős lett volna, különböző GPU-val, lényegesen különböző shader-számokkal, és bit-szélességgel. Persze, volt hasonló pl. a GTX1060-nál, de ott legalább csak minimális különbség volt a shader-számban, úgy az még belefért a 3GB/6GB modell differenciálásába.

-

HSM

félisten

válasz

Petykemano

#59381

üzenetére

Petykemano

#59381

üzenetére

Értem a célzást. De így is nagyon érdekes, mert pl. szerintem ez egy SOKKAL fontosabb, és vélhetőleg olcsóbb dolog, mint pl. a bemenő levegő hőfok mérő, amit meg mégis ráraktak.....

#59382 X2N : Nekem is nagyon tetszettek a refek, míg ez ki nem derült róluk.

Számomra inkább az a szomorú, ahogy ehhez hozzáállnak, hogy ez így specifikált működés... Kár a remekül sikerült ref 6800-as sorozat után.

Számomra inkább az a szomorú, ahogy ehhez hozzáállnak, hogy ez így specifikált működés... Kár a remekül sikerült ref 6800-as sorozat után.

-

HSM

félisten

válasz

Petykemano

#59369

üzenetére

Petykemano

#59369

üzenetére

Osztom a feltételezésed.

"De ez a feltételezés csak akkor állná meg a helyét, ha tudnánk, hogy tényleg eltért a CPU."

Még csak a CPU sem feltétlen kell eltérjen....

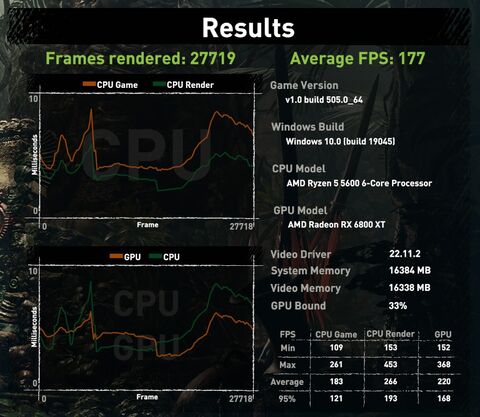

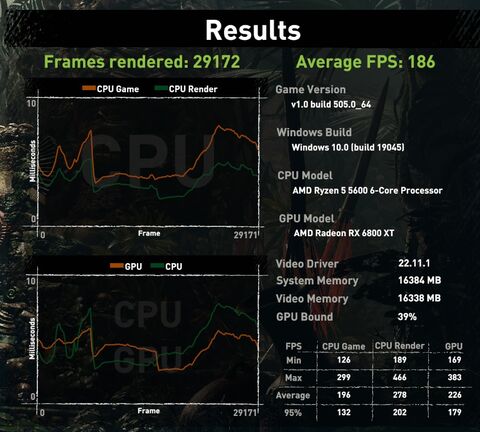

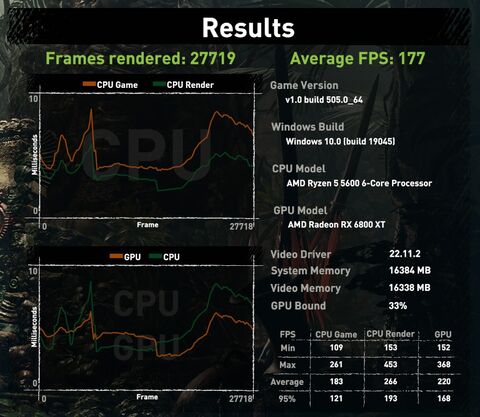

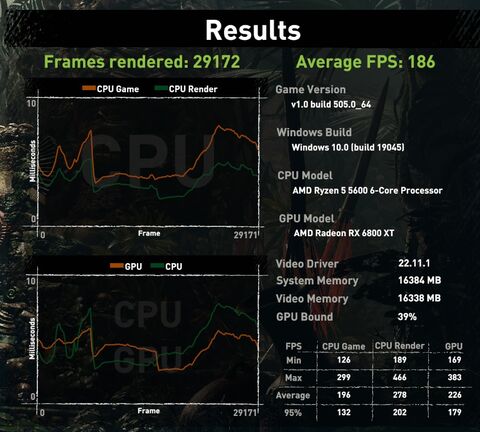

Pl. azonos, alapórajeles, de emelt limites 5600-as CPU, SOTTR bench FHD + Highest preset AA és RT nélkül, ramok azonos 3733Mhz-en, CL16-16-16-32-48-1T-n, csak a második esetben kézzel megpaprikázva a subtimingeket egy XFX "Merc319 Core" 6800XT tuning nélküli VGA-n:

Ennyi kell 5% eltéréshez.... Én még review-t nem láttam, ahol írták volna a subtimingeket....

Én még review-t nem láttam, ahol írták volna a subtimingeket....

Ilyen bivalyerős VGA-k alá WQHD-n már erősen kell kakaó az alatta lévő platformtól.

-

HSM

félisten

válasz

TESCO-Zsömle

#59284

üzenetére

TESCO-Zsömle

#59284

üzenetére

Emlékeim szerint driverrel rakták rendbe. Gondolom a "referencia" értékek maradtak a korábbi teszteredményekből.

-

HSM

félisten

válasz

szmörlock007

#58690

üzenetére

szmörlock007

#58690

üzenetére

4 slot?

Nekem szimpatikusabb a referencia a konzervatívabb méreteivel. -

HSM

félisten

"- a 7900XT egy átnevezett 7800XT (á la 4080 12GB, ami szvsz még 4070Ti néven is átverés), az elődjéhez (6800XT) képest $250-al drágábban"

Egyébként szerintem annyiból jogos a 7900-as "átnevezés", hogy a 8-as kategória általában a 256 bites kártyákat jelentette AMD-nél. A 7900-asok határozottan feljebb léptek ebben a tekintetben pl. a 6800-asoktól, ami csak 256 bites volt. Persze, ott is kellett a 6900, mint elnevezés, ami eléggé kilógott. A korábbi nevezéktan alapján annak illett volna 6800 XTX-nek lenni.

A 4080 12GB vs. 16GB esetén nincs is miről beszélni, más GPU is lett volna a 12-es, ők is belátták, hogy ez így nem oké...

-

HSM

félisten

válasz

paprobert

#58508

üzenetére

paprobert

#58508

üzenetére

"Az RDNA3-mal pedig RT-beli felzárkózás helyett még nagyobb lemaradás várható inkább, sajnos."

Az elmondottak alapján én nem erre számítok. A masszívan felizmosított feldolgozók és memória alrendszer igen jót tehetnek az RT-nek is.Egyébként erősen kíváncsi lennék, mennyire tűnne zsákutcának az RDNA-féle RT, ha ki lennénk használva a LOD nyújtotta lehetőségek a "szoftveres" bejárással, amit Abu is gyakran említ.

-

HSM

félisten

válasz

#36531588

#58411

üzenetére

#36531588

#58411

üzenetére

Sok évnyi Ryzen-legózás után úgy gondolom, kellene legyen annyi tapasztalat, hogy az összerakásból ne képződjön túl sok selejt.

De még ha jelentős is lenne, a 600mm szemben 300-al gigantikus plusz költség, már csak a nagyobb méretből fakadó szükségszerűen gyengébb kihozatal miatt is.Szerintem egyébként zseniálisan jól ki lett találva ez a Navi31. Jól lehozták ide is a stratégiát, ami a Ryzeneknél is bejött, hogy ne mindent a legdrágább eljárásokon kelljen legyártani. Főleg, ha összejönne egy új csipverzióval a 3Ghz, azért az szépet menne.

-

HSM

félisten

Mondjuk itt a csipméret annyiból erősen félrevezető, hogy míg az AD102-nél az óriási, 608mm2-es méret egy monolitikus, drága eljáráson akkora, addig a Navi31 esetén csak a 300mm2-es GCD, ami komoly költség, a mellé rakott 6db, fejenként 37mm2-es MCD egyfelől a végletekig bejáratott és a rendelkezésre álló információk alapján lényegesen olcsóbb 6nm-en gyártódik, vélhetőleg arcpirítóan magas kihozatallal. Nem lennék meglepődve, ha olcsóbb lenne előállítani még a 378mm2-es AD103-nál is a Navi31-es GPU-csomagot. Persze, a körítés már lehet olcsóbb az AD103-hoz a 256bit miatt.

-

HSM

félisten

Akkor gyakorlatilag megcsinálhatják az AIB-ok, ami eredetileg lett volna a 7900XTX, három csatival, nagy fogyasztással, 3Ghz órajellel?

Nekem egyébként az energiatakarékosabb irány tetszik, nincs széthajtva a csip az utolsó néhány tíz %-nyi teljesítményért.

#58385 paprobert : Cache terén is nagyon jól ki lett gyúrva az RDNA2-3 generáció, én ezt sem vetném el, mint az előny lehetséges forrását.

-

HSM

félisten

válasz

Petykemano

#58202

üzenetére

Petykemano

#58202

üzenetére

Szerintem az is tényező lehet, hogy a zöldek évekig a hatékonyabb architektúrájuk révén (Maxwell-től) simán tudtak azonos kategóriában hűtésében, felépítésében erősebb kártyákat kínálni, míg a pirosaknál sokszor nagyon meg kellett nézni, mit vesz az ember. Szerencsére úgy látom, az RDNA2 genarációnál már jóval magasabbra tették hardveresen is a lécet, az irány jó ebben is.

Várjuk az RDNA3-at.

Várjuk az RDNA3-at.

-

HSM

félisten

"Amúgy ha jobb minőséget ad, akkor azért az implementálási idő nem vesz el feleslegesen."

De, feleslegesen ment el. Egy nyílt, szabvány eljárásnak kellene lennie, ahol az iparág szereplői belerakják a tudásukat, és akkor az jól futhat és jó minősége is lehet, hardvertől függetlenül. A specializált, egyedi blokkok pedig lehetnek opcionális gyorsítók, vagy minőségjavítók.#58188 Yany : Én ezt éppen fordítva látom.

A Radeonnal nagyon könnyen lehet rögzíteni játékmentet, könnyen lehet monitorozós OSD-t a képre rakni, mindenféle marhaságot tud a driver. Ehhez képest nekem a zöldek csomagja tűnik kissé fapadosnak, ráadásul sok tudás külön szoftverbe van csomagolva, regisztráció és egyebek mögé, ami nálam kizáró tényező.

A Radeonnal nagyon könnyen lehet rögzíteni játékmentet, könnyen lehet monitorozós OSD-t a képre rakni, mindenféle marhaságot tud a driver. Ehhez képest nekem a zöldek csomagja tűnik kissé fapadosnak, ráadásul sok tudás külön szoftverbe van csomagolva, regisztráció és egyebek mögé, ami nálam kizáró tényező.Azzal egyetértek viszont, hogy piros oldalon azért előfordultak hónapokig kísértő idegesítő szoftveres hibák, ami sokmindenkinek elveszi a kedvét. A zöld oldalról nincs sokéves tapasztalatom, azt passzolom. Én úgy éreztem, hogy a pirosaknak nem mégtöbb új feature bevezetésére, hanem inkább a bugok kigyomlálására lenne érdemes fókuszálni az erőforrásaikat, ezáltal javítva a felhasználói élményt és idővel helyreállítva a felhasználói bizalmat.

-

HSM

félisten

válasz

Petykemano

#58174

üzenetére

Petykemano

#58174

üzenetére

Bár nem követem túlzottan közelről ezeket a technológiákat, de számomra volt pár nem túl szimpatikus vonása a DLSS-nek, gondolok a temporális és az AI skálázásból eredő hibákra. Emlékeim szerint egy ideig az FSR-t beépíteni is egyszerűbb volt, mert nem kellettek hozzá mozgásvektorok. Én azt mondanám, így más volt a képminőség, hogy kinek jobb, vagy rosszabb, megítélés kérdése.

#58177 PuMbA : Te mint felhasználó pl. ott nyersz, hogy nyílt technológiákkal nem vagy kiszolgáltatva a gyártónak, hogy kénye kedve szerint "optimalizálja" a zárt kódját a különféle hardverekre. A fejlesztő munkáját is megkönnyítheti ez, ami megint neked fog hozni jobb minőségű végeredményt. Az is nyereség a felhasználónak, hogy nyílt, szabványos megoldásokkal nem leszel gyártóhoz kötve, lásd a példád.

-

HSM

félisten

"...mutassa az utat, az első legyen és a legjobb képminőséget adja"

Ennek semmi köze nincs a nyílt forráskódhoz. A nyíltságnak elsősorban ahhoz van köze, hogy ellenőrizhető, hogy pontosan mit csinál az eljárás. Ezzel pedig mindenki csak nyer.

A nyíltságnak elsősorban ahhoz van köze, hogy ellenőrizhető, hogy pontosan mit csinál az eljárás. Ezzel pedig mindenki csak nyer.Az említett esetnél szvsz a játék fejlesztőire kellene mutogatnod, az ő dolguk lenne beépíteni, ha igény van rá, nem az AMD-é.

-

HSM

félisten

Nem látom az ok-okozati összefüggést a nyíltság és a rosszabb minőség között.

Én egyébként sokkal inkább preferálom a nyíltságot, legyen bármilyen a megvalósított minőség, mint amikor egy zárt forrású gyártói szoftvercsomag van a fejlesztők elé dobva, amiről azt sem lehet tudni, mit is csinál pontosan.

-

HSM

félisten

válasz

Petykemano

#57252

üzenetére

Petykemano

#57252

üzenetére

"Valószínűleg még dolgozni kell a Samsung gyártástechnológára való adaptáción."

Vagy magán a gyártástechnológián...

"Samsung’s 5LPE process appears to be lacking .... At lower performance levels, we noted that the 5LPE node doesn’t look to be any different than TSMC’s N7P node, as the A55 cores in the Snapdragon 888 performed and used up exactly the same amount of power as in the Snapdragon 865. At higher performance levels however, we’re seeing regressions – the middle Cortex-A78 cores of the S888 should have been equal power, or at least similar, to the identically clocked A77 cores of the S865, however we’re seeing a 25% power increase this generation." [link] -

HSM

félisten

válasz

KillerKollar

#57237

üzenetére

KillerKollar

#57237

üzenetére

Sajnos nem nagyon volt időm az utóbbi 5-6 évben játszani, így nem tudok érdemben nyilatkozni a felhozatalról.

Ami nekem ennek ellenére nagyon felkeltette az érdeklődésem, az a Metro Exodus Enhanced Edition, bár az tudtommal teljesen jól fut egy 3090-en, akár kimaxolva is, és talán a konkurens 6900XT is megüt egy elfogadható szintet, és elég komoly lett az RT-s kivitelezés [link]. Én egyébként azt gondolom, az RT az az effekt, amivel rengeteget lehet most nyerni képminőségben megfelelően implementálva (főleg a GI/megvilágítás effektekre gondolok), de ennek komoly ára lehet teljesítményigényben. Kíváncsi leszek, hova fog fejlődni a technika, és milyenek lesznek a kifejezetten erre optimalizált játékok, motorok. Illetve az UE5 Nanite rendszerére is kíváncsi leszek majd pár év múlva a gyakorlatban, miket lehet majd kihozni belőle.

-

HSM

félisten

válasz

KillerKollar

#57235

üzenetére

KillerKollar

#57235

üzenetére

"de akkor se mentegessük már a fejlesztőket"

Félreértés ne legyen, még véletlenül sem a rossz kivitelezés miatt gyengén futó alkotásokat próbálom védeni. Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

Mind az általam felsorolt Crysis, mind a GTA4 esetén jó oka volt az erőforrások használatának felhúzott grafikán. -

HSM

félisten

Halkan teszem hozzá, én abba a kis számú csoportba tartozom, aki kifejezetten értékeli, ha az "ultra" grafikai beállítás nem a "ma hardverének" szól.

Ha már egyszer megvettem a játékot, akkor nálam az egy óriási plusz, ha hagynak benne "tartalékot", hogy esetleg 4-5 év múlva újra elővéve egy friss vason is lehessen még rá képminőséget pakolni, és ne az legyen az ember benyomása, hogy ez bizony már szörnyen néz ki.

Ilyen volt annak idején a Crysis is, és a GTA4 is, mindkettőt szidták megjelenéskor, mint a bokrot a max gépigény miatt, mégis mindkettőt tudtam játszani egy akkori erős középkategóriás vason kicsit visszavéve, de pár év múlva komolyabb gépen elővéve is még bőven tudtak újat mutatni, mivel a grafikai beállításoknak szerencsére nem a megjelenéskori hardverek képességeinél volt a vége.

-

HSM

félisten

-

HSM

félisten

válasz

Petykemano

#44973

üzenetére

Petykemano

#44973

üzenetére

Nem feltétlen ugyanekkorát, hiszen azokon többnyire nincs lespórolva a sávok fele, pl. RX580... Az 3.0-n tud annyit, mint az 5500XT 4.0-n.

Mindenesetre, nem véletlen vettem már egy éve is 8GB-os RX580-at...

-

HSM

félisten

Persze, világos.

Írják is a végén: " If the finding here is accurate, then the 4GB RX 5500 XT will consequently become very difficult to recommend as the majority of the people shopping with this budget will likely not opt for expensive PCIe 4.0-capable X570 motherboard offerings.".

Írják is a végén: " If the finding here is accurate, then the 4GB RX 5500 XT will consequently become very difficult to recommend as the majority of the people shopping with this budget will likely not opt for expensive PCIe 4.0-capable X570 motherboard offerings.".

Az is szépen látszik, a 8GB-os szépen elvan 3.0-n is, míg a 4GB-os mindkét illesztőn szenved, csak a 4.0-n kicsit kevésbé látványosan. [link]

[link] -

HSM

félisten

-

HSM

félisten

Nekem csak a kezdeti árazás volt a bajom.. Mikor megjelent, itthon 130K-ért volt pár darab, aztán a bányaláz felvitte az árát 200K közelébe, annyiért azért már nem találtam annyira jó vételnek.

Kíváncsi leszek, hova és milyen áron fogják pozicionálni a Navikat.

Engem nem érdekel, ha lassabb lesz, mint a 2080Ti, ha korrekt hozzá az árcédula. -

HSM

félisten

válasz

TTomax

#40834

üzenetére

TTomax

#40834

üzenetére

Én a 9700K-ról beszéltem, azt hittem, ahhoz a vonalhoz szálltál be eredetileg.

Persze, sokat lehet nyerni némely generációnál OC-val, ez kétségtelen, nálam is 4Ghz-en jár az eredetileg 2,8Ghz-es elsőgenerációs hatmagos Xeon, de itt nincs is gond a levegős hűthetőséggel.

Szval, ha a 3770-esed korát kérdezed, azt hiszem én nyertem.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

TTomax

#40827

üzenetére

TTomax

#40827

üzenetére

A probléma, hogy azért az (erősen optimista) +30-40%-ért durván el kell rontani a proci perf/watt mutatóját. Tehát praktikusan, ha nem akarod a kellemetlen mellékhatásokat, akkor egy több maggal rendelkező példányt kellett volna venned... Alapból is 150W körül megy, az allcore gyári 4,6Ghz turbóján a legtöbb lapban [link], ezen max egy szűk 15-20%-ot tudsz csak javítani, és akkor nagyon-nagyon optimista voltam... Ehhez képest ha valakinek annyira több sebesség kell, akkor bőven van miből válogatni... [link]

Oké, nyilván drágábbak, de ha kiszámolod, mennyit kell költeni egy 9700K-ra, mire mondjuk egy kultúrált kimaxolt allcore 5Ghz meglesz vele (top lap + top hűtő + top ram sem épp olcsó móka ehhez), már lehet kijött volna belőle egy sokkal komolyabb rendszer, ami péppé veri átlagos körítésben, tuning nélkül is.(#40828) Tyrel: Szerintem egy Vega56 (vagy akár 64) megfelelően belőtt áramfelvételi limitekkel, referencia órajelen a mai napig teljesen jó perf/watt mutatójú. A RT-en kívül mindenben megállja a helyét szerintem. Nagyjából 200W-ból remek teljesítményt nyújt, és már az ára is egész korrekt lett.

A Polaris viszont tényleg már kicsit "öreg", pár ziccer hiányzik belőle, de ettől függetlenül azért szépen teljesít az árához képest, FHD-ban azért jól el lehet vele lenni, ahogy a Vega-val is 1440P-ig.

-

HSM

félisten

Kérdés, érdemes-e húzni... Kevés magon terhelve alapból magas órajelen jár, ha meg mind a 8 mag kapja az ívet akkor akár gyári 3,6Ghz is elég korrekt tempó, amit még mindig felturbózhat 4,6Ghz-re, ha akad hozzá még kihasználatlan TDP a beállított, gyárilag 95W keretből.

-

HSM

félisten

A zöldek szvsz amin óriásit nyernek, nem csak az órajel. Hanem a sávszélességet sokkal kímélőbben használó ROP-ok.

Illetve, a szoftveres ütemező miatt sokat tudtak trükközni a DX11 alatt driverből a CPU kárára, ami miatt kb. duplaannyi rajzolási paranccsal is elbírtak.(#40679) Abu85: Nekem az tetszett, mikor azt írta, hogy a Tahiti igazából nem is DX12.

-

HSM

félisten

válasz

Petykemano

#40675

üzenetére

Petykemano

#40675

üzenetére

Azért nem véletlen mentek rá a Vega-nál többek között az órajel növelésére, főleg a Radeon VII-nál, nincs is bekapcsolva az összes CU, de az órajel közelíti a 2ghz-et, ami azért így már masszív előrelépés a Polarisok többségéhez képest.

-

HSM

félisten

válasz

huskydog17

#40664

üzenetére

huskydog17

#40664

üzenetére

Nem állította.

Így szólt az eredeti hozzászólás: "Magyarán megszületett a második teljes értékű 16 GB-os játékkártya AMD oldalon."

Ezzel szemben a te állításod, amire írtam, hogy ezt senki nem írta: "Akárhogy nézzük ez nem mezei konzumer játékos VGA."A prosumerben benne van a játékos felhasználás is, tehát a fórumtárs eredeti állítása megállja a helyét. Azt te keverted bele, hogy mezei meg konzumer, nyilván így nem igaz, de ezzel nem a fórumtárs állítását cáfoltad meg.

-

HSM

félisten

válasz

huskydog17

#40657

üzenetére

huskydog17

#40657

üzenetére

"Ugye tudod, hogy a machine learning és data center között elég szoros kapcsolat van?"

Nem nyert. Attól, hogy datacenterekben is van gépi tanulás, attól még nem lesz egy GPU datacenter, csak mert képes rá.... Ez elég gyenge érvelés volt.

Attól, hogy datacenterekben is van gépi tanulás, attól még nem lesz egy GPU datacenter, csak mert képes rá.... Ez elég gyenge érvelés volt.Az AMD honlapján is világosan szerepel a specifikációknál, hogy "Platform: Desktop". Nem datacenter, vagy szerver, mint az Instinct MI25-nél, hanem desktop, mint a Vega56-nál is.

"Akárhogy nézzük ez nem mezei konzumer játékos VGA."

Senki nem is állította ezt. Ez egy tipikus prosumer kártya mezei asztali számítógépekbe. A munkaállomás, asztali gép pipa, de hogy se nem szerver, se nem datacenter, az 100%.

-

HSM

félisten

válasz

huskydog17

#40654

üzenetére

huskydog17

#40654

üzenetére

Az nem datacenter, sosem volt.

Alapvetően tartalomkészítőknek és játékfejlesztőknek készült, azért volt driverből kapcsolható, hogy játékos vagy profi driverrel menjen.

Alapvetően tartalomkészítőknek és játékfejlesztőknek készült, azért volt driverből kapcsolható, hogy játékos vagy profi driverrel menjen. -

HSM

félisten

Van amúgy egy szuperjó írás az input lag témájában, szerintem aktuális.

[link]

[link]A probléma, hogy felhős játékoknál ezek a tényezők ugyanúgy számítanak, csak még hozzájuk jönnek újak, ráadásul ahogy írod, ami erősen RTT függőek is, ami azért baj, mert a "való életben" elég sokszor találkozni durván ingadozó RTT-vel, miközben adott esetben az átlag sávszélesség egész magas.

Illetve szerintem a két képkockás buffer is az abszolút minimum, nem véletlen van pl. az összes videó streamelő szolgáltatáson 30s körüli buffer (még élő közvetítésnél is minimum 4-5s!!!), minden szempontból kímélőbb és megbízhatóbb, mint alacsony késleltetéssel realtime átvinni ugyanazt.

A QoS esetében két óriási probléma van. Az egyik, hogy a teljes láncon, értsd, a user számítógépétől kezdve (nem elég, ha a streamelő alkalmazás tudja, minden másnak tudnia kellene) egészen a kiszolgáló szerverig mindennek kellően konfigurálva kell(ene) lennie ehhez, mégpedig úgy, hogy mindenki a te játékod priorizálja. Nekem pl. egyáltalán nem tűnik reálisnak, hogy nagy sávszélességű játékokat priorizáljanak, amikor tipikusan a kommunikáció (hang, videó, VOIP) szolgáltatások szoktak itt lenni, mivel a sávszélesség igényük mérsékelt, viszont a késleltetésre érzékenyek. Az nem reális alternatíva, hogy ilyen nagy fogyasztókat priorizáljunk, ráadásul ha megzabálták a szolgáltató sávszélességét, akkor már nem is tudsz priorizálni, mert nincs már miből adni.... A másik, ha ezek a kevéssé életszerű feltételek adottak is lesznek, még mindig az elérhető sávszélesség. Ha foglalt bárhol a csatorna, akár csak egy rövid torlódás idejére, már buktad a játékot. Pl. egy VOIP hívásnál ilyenkor van egy rövid kimaradás a hangban, de megoldod, vagy játékban is, de amikor a kép is elkezd durván bedöcögni, az azért nem túl szép játéknál.

Szerintem ezeknél a Gbites neteknél is legfeljebb addig tudsz normális megoldást adni, amíg nem használják túl sokan egy adott területen, mert minél többen használják, annál rosszabb kiszolgálási garanciákat fogsz tudni adni.Amúgy az sem véletlen, hogy pl. egy BF4 szervernél, ha 10 feletti a pinged, már erősen érezni azt is. Még nem játszhatatlan, de nem olyan élmény, mint amikor alacsony késleltetésű rendszeren, minimum 60hz-es szerveren tolod, szűk 20ms pinggel....

Ezért is írtam, biztos lesz ennek is szuper felhasználási területe, de kiváltani szvsz nem fogja a lokális PC-s/konzolos játékot.

(#40582) -Solt-: Ezt egyébként meg tudom erősíteni. Nálam viszonyítási alap "csak" a 60Hz-es közönséges IPS monitorom, 8ms GTG panellel. Már azt erősen észrevenni, ha 80Hz-re tuningolom, de tovább megyek, valami miatt DP porton is csökken a késleltetése a DVI-hoz képest, és az is érzékelhető. Sőt, BF4 multiban régebben azt is érezni lehetett, ha a Mantle móddal toltam, ami kevesebb képkockát bufferelt be CPU-n, mint a DX11 mód. Itt alapvetően néhány ms difikről beszélünk, képzeld akkor el, mekkora difi lehet ennek a nagyon sokszora....

(#40584) -Solt-: A monitor paneljének GTG válaszidejét szokták így jelölni.

-

HSM

félisten

válasz

Petykemano

#40563

üzenetére

Petykemano

#40563

üzenetére

Egy késleltetés szempontjából optimális PC/játék kombó akár 30-40ms késleltetés környékére is levihető. Ezt hol fogják tudni hozni felhővel, ennyi idő elmegy kb. míg utazik az adat ide-oda... Tehát minimum 80ms-ről indulunk... És akkor még jóindulattal eltekintettem attól, hogy a net bizonytalanságai miatt nem ártana legalább egy néhány képkockányi buffer, ami 60FPS-nél mondjuk csak 3 képkockával számolva, ami szvsz extrém optimista, éppen +50ms mindezeken felül.... Ez így kapásból 130ms.

Amúgy igen, gyenge PC-ken, vagy más kütyükön (pl. notebook gyenge GPU-val, ebből rengeteg van) nagyon erősen casual játékokat játszani jó lehet az ilyesmire kevésbé érzékeny/igényes közönségnek.

-

HSM

félisten

válasz

awexco

#40552

üzenetére

awexco

#40552

üzenetére

Itt a probléma, hogy hiába van QoS-ed, ha nagy az átvinni szükséges adat, messze van a szerver, és forgalmas a csatorna akkor nem fog a QoS segíteni. Nem fogja senki a gémedet mondjuk a telefonhívások elé tenni, csak hogy neked ne 200ms legyen, hanem mondjuk csak 160ms a késleltetés az FPS-eden. Arról nem is beszélve, hogy nincs garancia a késleltetésre QoS-el sem, ha nagyon rövidre konfigurálod a választ, akkor könnyen hoppon maradhatsz. Na, ez lenne aztán a játékélmény, hopp kis lagspike itt, egy nagy lagspike ott....

A jelenlegi multis mókánál is éppen elég magas sokszor a ping, pedig ott tényleg minimális adatforgalom kell csak a komplett input, kép és hangátvitelhez képest.

-

HSM

félisten

válasz

Petykemano

#40434

üzenetére

Petykemano

#40434

üzenetére

A gyors GDDR6 miatt elvileg alapból nem lesz olcsó a PCB. A tápcsatikkal pedig úgy vagyok, a lehető legjobb a 8+8, az adja a legstabilabb tápfeszültséget, és a csatlakozó felrakása kb. 0 költség. Hogy aztán mekkora VRM-et kötnek mögé, 4-5 vagy 10 fázist, már más kérdés... Lásd pl. Vega VII, ott is 4 fázis végül nem lett bekötve. [link]

Nyilván, a költségérzékenyebb kártyákon azért idővel elspórolják az ilyesmit, de főleg az elején nem mindig szokták.

A legrosszabb forgatókönyv szerintem az, mint amit a referencia RX480-nál csináltak, hogy csak 6 pines, dejó, és akkor éppen nem rogyik meg alatt az alaplap némi utólagos driveres korrekció után... Legyen inkább 8+8, és ne vegyen fel sok kakaót az alaplapról. Nyilván, a referencia 480-nál eredetileg jóval alacsonyabb órajelre tervezték az egészet, aztán ez visszaütött.

Legyen inkább 8+8, és ne vegyen fel sok kakaót az alaplapról. Nyilván, a referencia 480-nál eredetileg jóval alacsonyabb órajelre tervezték az egészet, aztán ez visszaütött. -

HSM

félisten

válasz

Devid_81

#39699

üzenetére

Devid_81

#39699

üzenetére

"hogy az elso generacios Vega olyan mocskos jo banyaszasra mint meg soha a foldon masik VGA"

Pedig ez bizony így van... Legalábbis az akkori algoritmusokkal torony magasan ez tudta a legjobb perf/watt arányt. Nem véletlen, hogy hónapokig egy darab nem volt a boltok polcain, mert azonnal felvásárolták mindet...

Nem véletlen, hogy hónapokig egy darab nem volt a boltok polcain, mert azonnal felvásárolták mindet... -

HSM

félisten

válasz

Petykemano

#39665

üzenetére

Petykemano

#39665

üzenetére

Az AVFS-es Rx580-am is szépen lehet UV-zni, 1,125V gyári alapfesz (1340Mhz) helyett hónapok óta használom hibátlanul 1,055V-on, és még 10Mhz OC-t is kapott...

Tény, az AVFS megy, ahogy csökkentem az órajelet, minden órajelhez kitalál egy alkalmas feszültséget (felfelé is, 1411Mhz-en már 1,2V-on hajtaná magát), de főleg magasabb órajeleknél ez szvsz sokszor lényegesen több a kelleténél.

Én nem tartom életszerűnek, amit írsz. Az UV szvsz azért kerülhetett be a driverbe, mert a "bátrak" így beállíthatnak egy takarékosabb beállítást, esetleg minimális stabilitás rovására, míg akiknek fontos a perfekt stabilitás használhatják tovább az atombiztosra menő gyári feszen. Mindenki nyer.

(#39667) Jack@l: Nekem az összes kártyám tőlük eddig bírta az alulfeszelést, némelyik nem is keveset. Pedig volt pár, 7870XT (Sapphire), 7950 (PowerColor custom), 7970 (több Dual-X meg egy ref is), 280X (Toxic, sok Vapor-X) 290 (Windforce3, DC2 OC), 290X (DC2 OC), most pedig Rx580 (Nitro+) is. Igaz, mind magas minőségű darab volt, jó hűtéssel és VRM-el.

-

-

HSM

félisten

válasz

Komplikato

#39302

üzenetére

Komplikato

#39302

üzenetére

Kérdés, mi az ok... Nem megfelelő BIOS? Nem megfelelő PCB árnyékolás? Nem megfelelő hűtés?

Ugyanis a GDDR5 óta ezeknek egycajta ECC funkciója is van, ha valami rosszul ment át nem feltétlen okoz hibát, hanem megpróbálja újra elküldeni, ami nyilván teljesítményvesztéshez vezet, ezért tud a túl tuningolt GDDR5 először lassulást produkálni és csak utána hibákat.

Amd kártyákon meg is tudod nézni, méri GPU memory errors néven, ami jól működő kártyákon szépen 0 marad. -

HSM

félisten

" itt ment a siras, hogy a polaris savszel limites is. Lett volna 384bit, problem solved."

Szvsz nem a sávszél a fő szűk keresztmetszet, az azért akad elég. A 32 ROP viszont kevés. Láttuk a Tonga-nál is, nem sokat dobott rajta a 384bit verzió. Pedig ott szvsz szűkösebb volt arányaiban a sávszél.

Pedig ott szvsz szűkösebb volt arányaiban a sávszél."Masodjara mondom, ha az M$-nek megfelelt akkor "good enough"."

Honnan tudod, a M$ miért rakta bele? Nem-e mondjuk azért, mert így olcsón rá tudtak kötni +4GB ramot?"Masodjara irom 1060-1070 kozotti gap."

Akkor most másodjára nem a kérdésemre válaszolsz. Ez mitől sweet spot? Már írtam, szvsz FHD-ra egy 8GB-os RX580 untig elég, fölé meg már inkább Vega56 szintű kártya a sweet spot, ami jól meghajtja a felbontást és nem is feleslegesen drága.

Már írtam, szvsz FHD-ra egy 8GB-os RX580 untig elég, fölé meg már inkább Vega56 szintű kártya a sweet spot, ami jól meghajtja a felbontást és nem is feleslegesen drága."Erdekes a mokolt 590 ebbe az arsavba erkezett"

Nem ide érkezett. A prémium Rx580 kártyák kaptak egy jobb képességű GPU-t. Ez egy értelmes lépés volt, hiszen gyártani nem kerül többe, nem kellett hozzá sem új kártyákat sem új GPU-t tervezni. Praktikusan egy új gyártási revízió. Ha megnézted (volna), nem is került lényegesen többe az Rx580 megjelenésekor egyik sem, mint ugyanazon kártya Rx580 változata.280$ volt megjelenéskor: [link], a Giga XTR-je is (270): [link].

Nekem sem véletlen van drága Nitro+ 8GB Rx580-am, az olcsó verziók annyit is érnek. Az olcsó modellek az alacsonyra szabott TDP-vel küzdenek, miközben nem csak lassabbak, de még hangosabbak is. Szóval szépen néz ki, hogy 50 dollárral olcsóbb, de annyit is érnek, számomra annyit sem."a funkico amiert hasznalnam nem mukodik."

A problémád az volt, hogy UVD órajelen megy, vagy kifagy ébredéskor. Ezzel a programmal nem megy UVD módban, felébred, és a normál, 10W körüli üresjárati fogyasztásán marad, ami teljesen élhető érték. Persze, ha csak a problémázás a cél, akkor remek apropó.Érdekes ez a nem ébredés, a 290 ugyanaz a generáció, mint a Bonaire, és az hibátlanul ébredt nálam Giga WF3 és Asus DC2 is, a 290 és 290X is.

-

HSM

félisten

"Es boven jo lett volna 384bit-tel es 32-rop-pal (nem kell tulzasokba esni)"

32ROP már az Rx580-ban is igencsak kevéske, érzem azért a 290X után, erre nem tudom, miért nem reagáltál az előbb. Hiába jóval erősebb a GPU, emiatt azért érzéssel kell neki adagolni pl. az élsimítást, és a WQHD-hoz is már elfogyogat. A GCN felépítéséhez pedig vagy ez a 32ROP passzol, vagy a 64, de a 64-hez édeskevés lett volna a 384bit. Sehogy sem jó.

"Hatalmas res egy meg nagyon jol eladhato es utokepes termekhez (sweetspot 2.0)."

Mi lett volna ebben a sweet spot? Ezt is írtam az előbb, FHD-ra feleslegesen erős, WQHD-ra meg túl gyenge kártya lett volna. Ez kinek sweet spot? FHD-ra így is úgy is Rx580-at vennék, WQHD-ra meg minimum Vega56-ot.A "kettő közé" (MSRP árakon) ott voltak az igényesebb Rx580-ak, pl. a Sapphire Nitro SE 8Gb, 280 dolláros MSRP-vel.

A ZeroCore-ra pedig ez egy tökéletes megoldás: [link]. Nem fog UVD módban menni a kártya, de Zero-zni sem fogja hagyni.

Nem vagyok benne amúgy biztos, hogy az AMD sara, hogy bizonyos lapokban nem ébrednek a kártyáik, de ebbe ne menjünk bele.

Nálam szépen ment a 280X-eken és a 290X-en is. Most az Rx580-on nem tudom, mert így is úgy is passzívba megy.

(#39149) Petykemano: Amennyire olvasgattam a témában, a fő gond az elérhető regiszterek száma, mérete, ami miatt gyakran nem tud optimális mennyiségű konkurens wavefront futni, elfedni a késleltetéseket és megtölteni a SIMD motorokat. (A regiszterméretes dolog amúgy nem AMD sajátosság, ez tudtommal a zöldeknél is probléma.) Ezen is próbál segíteni pl. az utasítás előbetöltés a Polaris óta, nem döglik annyira meg a hardver regiszterpusztító kód alatt sem, mint egy hagyományos architektúra.

(#39151) lezso6: Én főleg a ROP hatékonyság/ram sávszélesség (hatékonyság) valamint a frontend oldalán látom a szűk keresztmetszetet. Kb. ezeket próbálták a Vega-n is javítani több kevesebb sikerrel.

-

HSM

félisten

"Milyen megemelt frekvencia?!"

Az, hogy videolejátszás vagy multimonitoros módban az üresjárati órajelről az általad írt 5000Mhz-es órajelre emelte meg a memória órajelét ami fogyasztásban bő 50W-ot lökött feljebb a fogyasztásmérőn. Több, mint a másfélszeresére emelte az i5-ös gépem üresjárati fogyasztását, vicc."Az uvd orajeleit nem tudom, de azt eleve vissza kell fogni es force-olni kell."

Yepp, ezt tettem én is, de ez is egy vicc. Így nem +50W-ot kért, hanem mondjuk csak a felét, mert azért túlzottan nem vihetted le a memória órajelet, mert azt sem szerette ám.A Polarisoknál azt nem sikerült tökéletesen megoldani, hogy ne zabáljon videólejátszásnál és multimonitornál. A Scorpion a 384 bites buszhoz képest teljesen takarékosan játszik le videókat, tehát ott úgy tűnik már vették az akadályt. Az új, Polaris20 köztes memória módja már egész jó, ott 8Ghz helyett (de csak egy monitorral, mert a multimonitor móka maradt, lol) már tudja videókhoz csak 1Ghz-en járatni a ramot, vagy akár még annyin sem, így max 20W ideális esetben a videólejátszás. Az is még a duplája annak, amit a konkurencia már évekkel ezelőtt hozott (GTX980 durván 10W), de már egész elfogadható.

Én ezekről beszélek, amiket Te is elismersz, hogy ezek el vannak faragva, ha kihozod a nagy Polarist, 512 bites rammal (384bit kevés lett volna, plusz ahhoz nem biztos, hogy GCN-en tudtál volna 48ROP-ot kötni, 64 ROP meg kidobott tranzisztor lett volna memória sávszél nélkül) ezek a problémák nagyságrendekkel súlyosabban megmutatkoztak volna. Ezért is nem látom jó opciónak.

Értem a felvetésed, hogy a 200 és 400 dolláros GPU között elfért volna mégegy, de gyakorlatilag semmi értelme nem lett volna. Mégpedig azért, mert FHD-re untig elég az Rx580. WQHD-re pedig már nem árt valami komolyabb, oda éppen jó belépő a Vega56. A köztes GPU-val azt érték volna el, hogy FHD-re nagyon sok, WQHD-re meg nagyon szűkös. Amúgy erősen túlzó az ár-összehasonlításod, az Rx580 soha nem volt 200 dollár, egyedül az agyig spórolt referencia Rx480 érte el ezt az árszintet.

Ha most megnézem, most már kapni 8GB-osat is 200 dollár körül, de már a Vega56 sem 400, hanem inkább bő 300.A ZeroCore nem mindenkinél működik jól ez tény, de nekem eddig nem volt problémám vele. Van amúgy rá workaround, akinek pl. olyan lapja van, ami megkotlik tőle. Nálam vígan aludt/ébredt eddig minden kártyám, pedig nem mai csirke az X58 rendszerem. De az előd Z97+i5-4690K-n sem volt semmi gondom vele, se R9 290-el, se R9 280X-el, se utána a HD7770-el, se az Rx560-al, se most az Rx580-al.

-

HSM

félisten

válasz

Petykemano

#39105

üzenetére

Petykemano

#39105

üzenetére

Igen, részben javították, az 5xx-es Polarisokban már nem teljes órajelre rántja fel a videomemóriát, hanem csak 1Ghz-re. Ugyanakkor, ha nem két tökélesen egyforma beállítású megjelenítőt használsz, akkor is maxra tekeri a ram órajelet, és már az is zabál olyankor rendesen: [link].

A 40W multimonitor fogyasztás és 20W videolejátszós már oké, kb. arányban van a 256bites GDDR5 interfésszel.

A 290X-es Radeonomon is így volt, kb. 70W-ot kért max memória frekvencián multimonitorral és videólejátszásnál, a memória órajel kézei levételével azt is kb a felére, olyan 40W magasságára lehetett szelidíteni. [link]

Ugyanakkor ezek botrányosan rossz értékek, már a 290-esen is kicsit ciki volt ez szvsz, amikor a konkurencia mindezt letudta nagyságrendileg 10W-ból: [link].

Szóval ez nagyon fájó pont lett volna a nagy Polarison szvsz.A Vega-n szvsz a fő baj a HBM memória, és az ahhoz szükséges interposer, ami így együtt szvsz nem éppen olcsó. Ugyanakkor szükséges, mert a fogyasztási keretbe is sokat spórol, illetve ezzel a botrányos multimonitor és videós fogyasztás is teljesen korrekt szintre volt csökkenthető. [link]

(#39114) Z10N: Nem hiszem, hogy az elég lett volna. A mostani Polaris is szvsz erősen ROP-limites, legalábbis úgy érzem a saját Rx580-amon a korábbi 290X-emhez képest. Utóbbin felraktam 4X-es MSAA-t, nem történt semmi, a Polaris viszont nélküle lényegesen jobban szedi a lábát.

A Hawaii-nál nem a GPU volt torkos üresjératban ezekben az esetekben, hanem a megemelt frekvenciájú memória. Oké, a Scorpion-ban megoldották, de látod, hogy az Rx-ekben sem sikerült tökéletesen.

Ez sem igaz, amit írtál, nem GCN sajátosság, a HD5850-emmel ugyanígy botrány rossz volt a videós, multimonitor fogyasztás, de előtte a HD4890-esemen is. De a 6850 is ugyanígy becuppantotta a 40W-ot: [link].

Viszonyításként egy akkori Ivy Bridge CPU kb. 10W-ból letudta ugyanezt a feladatot, az IGP-je 3W-ból. Téptem is a hajam, a hülye 5850-en minek megy kötelezően a hardver gyorsítás YT alatt, +30W, köszi...Középkategóriának amúgy szvsz tökéletes és kiegyensúlyozott kártya volt az Rx480/Rx580. FHD-ra a mai napig untig elég. WQHD-ra pedig már szvsz kell legalább egy Vega56 ereje, ha jó sebességet is akar a gamer. A "normális" bányászláz előtti árán teljesen jó alternatíva volt azoknak, akiknek erősebb VGA kellett a Polarisoknál.

-

HSM

félisten

A probléma ott is az lett volna, mint a Hawaii-nál. Az extra széles (384 vagy 512 bit) gddr5 memóriabusz zabálta volna az áramot, mint a disznó.

Nem lett volna szép egy 70w-os multimonitor vagy videólejátszós mód. A Vega-nál ezzel nincs gond, és az órajelei is magasabbak tudtak lenni a feljavított CU-k révén.

Egy ilyen big-polaris-nak szvsz egyedül az ára, esetleg a legyártott darabszáma tudott volna kedvezőbb lenni a Vega-nál. -

HSM

félisten

válasz

Petykemano

#39072

üzenetére

Petykemano

#39072

üzenetére

Valamelzik képen én hosszában futókat látni véltem Máshogy ilyen hűtés nem is működhetne.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Most már tényleg itt az Ítéletnap, premier előzetesen a Terminator 2D: NO FATE

- Arc Raiders

- Szívós, szép és kitartó az új OnePlus óra

- Battlefield 6

- AliExpress tapasztalatok

- Amlogic S905, S912 processzoros készülékek

- Assetto Corsa EVO

- ASUS routerek

- The Division 2 (PC, XO, PS4)

- Luck Dragon: Asszociációs játék. :)

- További aktív témák...

- Megvigyázott ASUS TUF RTX 3070 OC, dobozzal, garival

- Asus ROG Strix RX6600XT Gaming OC

- Készpénzes / Utalásos Videokártya és Hardver felvásárlás! Személyesen vagy Postával!

- 27% - SAPPHIRE RX 7900 XTX Nitro+ 24GB DDR6 Nitro+ Videokártya! BeszámítOK!

- SAPPHIRE RX 9060 XT 16GB GDDR6 PULSE OC - Új, Bontatlan, 3 év garancia - Eladó!

- ÁRGARANCIA!Épített KomPhone Ryzen 7 7700X 32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

- GYÖNYÖRŰ iPhone 13 mini 128GB Blue -1 ÉV GARANCIA -Kártyafüggetlen, MS3885, 94% Akkumulátor

- LG 55B4 - 55" OLED - 4K 120Hz 1ms - NVIDIA G-Sync - FreeSync Premium - HDMI 2.1 - PS5 és Xbox Ready

- ÁRGARANCIA!Épített KomPhone Ryzen 5 7600X 32/64GB RAM RTX 5060 Ti 16GB GAMER PC termékbeszámítással

- BESZÁMÍTÁS! Apple Mac Mini 2023 M2 16GB 256GB + billentyűzet/egér garanciával, hibátlan működéssel

Állásajánlatok

Cég: BroadBit Hungary Kft.

Város: Budakeszi

Cég: ATW Internet Kft.

Város: Budapest

A DLSS kicsit kevésbé, mint az FSR2.1, de inkább maradtam natív, de alacsonyabb felbontáson ugyanahhoz az FPS-hez TAUU-val, tűéles, részletes, gyönyörű képpel.

A DLSS kicsit kevésbé, mint az FSR2.1, de inkább maradtam natív, de alacsonyabb felbontáson ugyanahhoz az FPS-hez TAUU-val, tűéles, részletes, gyönyörű képpel.

Mondjuk nekem is az egyik legjobb 6800XT van (XFX Merc 319), 1200rpm-en rendkívül csendesen megy bő 1V körül közel 2.4Ghz-et, szóval nem is biztos, hogy előrébb lennék vele...

Mondjuk nekem is az egyik legjobb 6800XT van (XFX Merc 319), 1200rpm-en rendkívül csendesen megy bő 1V körül közel 2.4Ghz-et, szóval nem is biztos, hogy előrébb lennék vele...

Amíg így van, addig ez egy előny Nv kártya mellett.

Amíg így van, addig ez egy előny Nv kártya mellett.

Változott egyébként a h264 rész a Navi21 óta?

Változott egyébként a h264 rész a Navi21 óta?

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Unalmasan Plug&Play...

Unalmasan Plug&Play...