-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

szmörlock007

aktív tag

-

PuMbA

titán

Azért ez már használható kategória

Radeon Chill-lel 79-re limitált fps esetén, amiből ugye 158fps-t csinál 8ms plusz a késleltetés az eddigi 21ms helyett, az nem észrevehető: [link]

Radeon Chill-lel 79-re limitált fps esetén, amiből ugye 158fps-t csinál 8ms plusz a késleltetés az eddigi 21ms helyett, az nem észrevehető: [link]Ja és gyors mozgásnál nem kapcsol ki, mint a régi verzió. Szokásos AMD...kiadnak valamit, ami elsőre használhatatlan, aztán majd használható lesz a második és harmadik verzióra.

-

huskydog17

addikt

Pont ez az előnye az XFX új termékének, hogy ahhoz semmilyen szerszám nem kell, mert a Nitro-nál kell ugye egy csavarhúzó, de a Magnetic-nél az sem, ezen felül utóbbinál mindegy hogyan rakod rá, azaz nem csak egy fix pozícióban lehet, mert az áram 360 fokban körbe van vezetve. Emiatt gyorsabb és egyszerűbb a csere. Szerintem ez pont hogy egyszerűbb, ennél csak bonyolultabb venti cserék vannak.

-

-

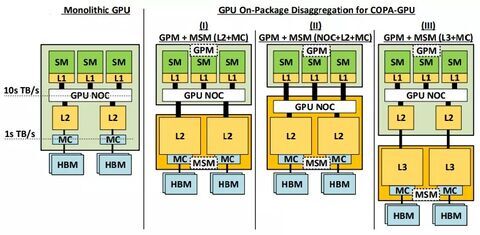

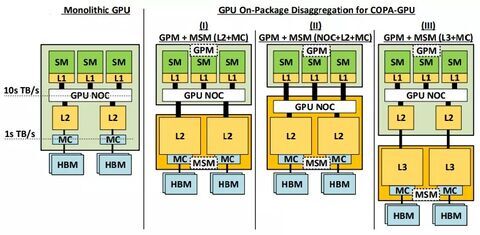

Többen azt írják problémának Pl redddit Nvidiás topikban,hogy nem jó a bontása a z RDNA3 nak.

Olyat is olvastam,hogy nem igazi chiplet dizájn,egyfajta átmenet.Nem tudom ez mennyire valós,nem vagyok hardver mérnök.

Allítólag Nvidia megoldása más megközelítést használ majd,azt kísérletezik melyik a legkifizetődöbb késleltetés,gazdaságosság és gyártás terén és állitólag AMD is ebben gondolkodi az RDNA5 nél.Azaz szerintem is jó a meglátásod.

Nem tartom kizártnak,hogy felhasználástól függően más bontás fognak használni professzionális -AI-Gaming szegmensben

Nvidia féle COPA-GPU verziók.

-

Petykemano

veterán

> az új, jobban feldarabolt struktúra egyéb változásokhoz is vezetett volna, amit vélhetőleg máshogy optimalizált driverekkel kellett/lehetett volna kezelni

A multi-GCD, vagy ebből az ábrából kiindulva több aktív interposeres megoldás esetén igen, valószínűleg a szoftvernek oda kellett volna figyelnie, hogy az egyes szeletek között a késleltetés megnövekedett, ezért oda kell figyelni.De attól még ez egyáltalán nem zárja ki, hogy az 1db aktív interposer + Xdb SED életképes legyen. Úgy értem, hogy ahhoz szerintem nem szükséges az általad említett driver-átalakítás.

Mondjuk nekem még mindig hiányzik a képletből valami. Gondolom, hogy az aktív interposer / base die tartalmazná a Command Processort és a L2$-t is. De vajon hogy oldod meg a különálló Command Processzorok együttműködését? Azt gondolnám, hogy épp ez az a kritikus pont, ami meghatározza, hogy láttatható-e ez az egész egy GPU-ként vagy sem. (emlékszem valami gazda-szolga kialakításra) Ha valami nem működött, akkor elképzelhető, hogy pont ezt a részt nem sikerült összehozni.

-

Petykemano

veterán

Még azt felejhtettem el írni, hogy az előzőben, hogy valószínűnek tartom, hogy a kitűzött cél a >3Ghz lehetett, ám nem biztos, hogy elrontották, hanem - az architektúrát a gyártástechnológiát elv alapján - egyszerűen magától nem jött ki belőle, az architektúra alapjaihoz meg ez a team nem mert vagy nem akart hozzányúlni.

Ha jól emlékszem, arról van szó a N31 esetén, hogy túl sokat fogyaszt. De egyébként skálázódna még. Azt gondolom, hogy ha arról lenne szó, hogy túl sűrűre tervezték, akkor egy bizonyos frekvencia/feszültség fölött túlságosan megnőne a hősűrűség és ott hirtelen megállna a skálázódás. De említhetném a 7900GRE-t is, ahol meg az látszik, hogy az elengedett 200Mhz sem csökkentette drasztikusan a fogyasztást. Ez alapján nem sokat segítene egy kevésbé sűrű design és/vagy nagyobb, több CU-val rendelkező, alacsonyabb frekvencián járatott lapka se.

Nekem alapvetően nem lenne bajom ezzel a tick-tock módszerrel, ha egyébként az iterációk/generációk gyorsan váltanák egymást.

A 7900GRE CB tesztjében van egy százalékos perf/W grafikon [link] ami elég jól mutatja, hogy az Ada inkább egy 50%-os perf/W növekményt, míg az RDNA3 inkább 30% körüli előrelépést hozott. Ez lemaradás, sőt a korábbi orrhossznyi előnyből közepes mértékű hátrány lett.Ha a GPU iterálás a chipletezéssel felgyorsult (volna), akkor persze most mondhatánk, hogy nincs ok aggodalomra, mert az RDNA4 majd biztos gyorsabban érkezik majd, mint a szokásos 2 év.

Volt is szó arról - én is mondtam -, hogy az RDNA4 majd hamar jön. De ennek akkor és úgy lett volna értelme, ha mondjuk 2024 első felében elkezdik kipörgetni azokat az RDNA4 termékeket, amik a 2022 év végén elindult Navi31 fölé érkeznek. Sajnos az RDNA4-ből pont ezt a szintet kaszálták el. Valaki azt emlegette, hogy a Navi31 még sokáig marad flagship. RGT egy Navi36 névvel kapcsolta össze egy a 400mm2 RDNA3 lapka lehetőségét. Ez mind arra utal, hogy az RDNA4 megmaradt lapkái legfeljebb a Navi31-et nyaldoshatják alulról. Egyébként az biztos remek lenne. De ugyanakkor nagyjából erre a szintre épp néhány héten belül indítják útnak a Navi32-t. Bár azt mondják, hogy a Navi32 is már egy ideje le van gyártva, áll a raktárakban az RDNA2 kártyák kifogyására, de azért az elég különös lenne, ha lényegében mindössze 3-4 negyedévet élne meg a Navi32 a piacon. Ennélfogva én már mégsem várnám az RDNA4 hamar történő megjelenését. -

Petykemano

veterán

Az CU-ba épített AI acceleratort, már ha az nem a mátrixszorzás képesség marketingneve, kihagytad.

Nekem az a gyanúm, hogy a GPU fejlesztésnél van egy tick-tock módszer, mint amit a prociknál látunk. A zen2, és a zen4 is főként egy a meglevő architektúra új gyártástechnológiára való portolását, vagy struktrurális átalakítását szolgálta kisebb (ez alatt nem feltétlenül a jelentőségét, hanem a bonyolultságát értem) kiegészítésekkel. Ott van pl a zen4, ami duplázta ugyan az L2$ méretét, de az asszociativitáson nem változtatott.

És aztán a zen3 és zen5 azok, amik teljes újratervezést jelentenek egy már kipróbált gyártástechnológiára adaptálva. -

Petykemano

veterán

Szerintem teljesen irreális elvárás a regisztereiben megnyirbált, 5 helyett 6nm-en gyártott, erősen költséghatékonyságra kigyúrt, belépő verziótól is hasonlót várni.

ezzel azt mondod, hogy a GPU teljesítmény teljesen architektúra-független és a gpu fejlődést kizárólag a sűrűbb és/vagy alacsonyabb fogyasztású tranzisztorok teszik ki, a fejlesztés pedig csupán arról szól, hogy ezt az előnyt a haza tudod-e vinni, vagy sem.Márpedig ez nem lehet igaz, mert az Intel nagyjából ugyanezt a teljesítményt 2x akkora lapkából hozza ki.

De a Kepler - Maxwell váltás is látványos architekturális fejlődés volt.Azt gondolnám, hogy a teljesítmény, energiahatékonyság és tranzisztorhatékonyság bizonyos mértékig egymást kizáró szempontok és qz AMD bevallottan utóbbira fókuszált. Az n7->N6 váltás 15%-a látszik a kisebb lapkaméreten. De az nem, hogy mire ment el a több tranzisztor. Semmilyen architekturából fakadó előnyt nem eredményezett az RDNA3. Lehet persze azt mondani, hogy architektúrát gyártástechnológiára tervezünk, de az RDNA3 eredményei - mármint amit nem lehet a gyárrástechológiához kötni - szerintem úgy sem túl meggyőzőek.

-

Én is jónak tartom ,az 7900XT-t főleg, de azért nem lett egy lehengerlő fejlesztés az RDNA 2 hőz nézve.

A CB tesztek szerint amit írtál RT előrelépés nem jön elő például raszterben. 1 % kal lassabb mint a 6950, RT ben viszont csak 1 % kal gyorsabb. Érdekes kártya lett,

Nvidiánál ez kb a 4070 TI.

Igazából a fogyasztást valóban elő lehet hozni előrelépésként. Ha itthon ezt 7800 XT ként adják 5-600 Euro körül akkor tényleg jó kártya lesz, de szerintem 800-900 euros áron érdektelen,mint amit most rebesgetnek, hiába akasztották/ marketingelték rá az 900 végződést ( like 4080 12 GB.)

Igazad van hogy nem korrekt ,hogy kompletten levonja a következtetést az Architektre.

De az van hogy valóban az AMD/ RDNA3 legnagyobb konkurenciája saját maga az RDNA2 vel.

Az az 50 % kijelentés sehogy nem volt korrekt ,ez tény. -

PuMbA

titán

"Érdekesebb összehasonlítások születhetnek majd, ha a 80CU-s 7900 GRE-t hasonlítják majd azonos órajelen a 80CU-s 6900XT-hez, vagy 6950XT-hez."

Ez már most megvalósult, ugyanis a 7900GRE 2245MHZ-es boost clock-kal rendelkezik, a 6900XT pedig 2250MHz-essel

A 7900GRE teszteket pedig nem rég linkeltük, a két kártya hasonló tempót hoz, tehát ugyanaz látszik kirajzolódni, mint az RX7600 kontra 6600XT tesztben, regiszter ide vagy oda.

A 7900GRE teszteket pedig nem rég linkeltük, a két kártya hasonló tempót hoz, tehát ugyanaz látszik kirajzolódni, mint az RX7600 kontra 6600XT tesztben, regiszter ide vagy oda. -

PuMbA

titán

Szerintem ez nem probléma egyébként, csak ahogy már pár hete írtam ide, tisztában kell lenni a dolgokkal. Nem véletlenül vettem meg a 6700XT-t, mert láttam, hogy itt nem lesz előrelépés az RDNA3 kártyáknál, így felesleges megvárnom őket.

Örüljünk, hogy az AMD és az NVIDIA jelenlegi generációja kuka, hiszen használtan olcsón megvehetjük az ugyanolyan sebességű RDNA2 kártyákat

Mi ezen csak nyertünk, hiszen több pénz marad a zsebünkben és a játékfejlesztők kezében sincs egy olyan új generáció, ami többlet sebességet ad, tehát a gépigények se fognak nőni.

Mi ezen csak nyertünk, hiszen több pénz marad a zsebünkben és a játékfejlesztők kezében sincs egy olyan új generáció, ami többlet sebességet ad, tehát a gépigények se fognak nőni. -

A architektúra tervezését igen, biztos évekkel előre elvégzik, de a gyártásra tervezésnél az árazassál már tisztában kell lenniük.

Azért olyan nagy eltérés nincs a megjósolható árazásban hisz például a 3 nm már most is elérhető árajánlattal, az Apple használja ezerrel, már 2020 ban lefoglalta , 2 év múlva is elérhető lesz mire az Ada next piacra kerül ez így volt az 5 nm gyártással is.Ez egy nem rossz kis videó matekról., igaz nagyon leegyszerűsítve. [link]

Minkét architektúra 5 nm gyártáson készült és AMD nek kiegészítve 6 nm gyártással azaz egy olcsóbb gyártással és még így is állítólag közel annyi a Navi 31( 140-160$ + interposer és csomagolási költség hozzáadódik ehhez, kb 200$) az egészhez a monolitikus dizájnnal szemben.

És ne elejtsük el hogy a csúcs navi 31 a 4080 nal versenyez ami AD103@ 309 mm2 teljes értékű AD102( 4090TI) közel 45 % kal gyorsabb lehetne , mint a Navi 31...

Kepler és nerdtech szerint a 7900XTX teljes előállítási költsége 4-500$ [link] az RTX 4080 költsége 300-350$[link]

ha egy csúcs AD102 ( nem a 4090) 5-600 dollár és közben ennyivel gyorsabb akkor a matek jó volt még akkor is ha a Navi 31 4090 sebességű lett volna ,mert cserébe nem tartalmaz kockázatot, kísérleti státuszt.

Ha jól néztem a Navi 31 533 mm2 az AD102( 4090) 609mm2 és le van tiltva egy csomó részegység és az L2 egy része a 4090-ben -

Petykemano

veterán

Én hajlamos lennék elhinni azt, hogy az ilyen - sikeres - cégek vezetőinek valóban magasfokú az előrelátása. Persze azért ugye tudjuk, hogy az évtizeteken keresztül sikeres politikusok nem csak annak köszönhetik sikereiket, hogy csupán remekül tapogatják le a néplelket, hanem megfogják és agyagként formálják is azt.

Azt nem bírom (akkor lóg ki a lóláb), amikor meg valamilyen PR szempontból "kellemetlen" dolog történik, akkor elkezdenek takarózni váratlan és/vagy kiszámíthatatlan piaci folyamatokkal.

Máskülönban azzal - sajnos - egyet kell értsek, hogy valószínű, hogy az Nvidia nem azért nem hozott még piacra chipletes terméket, mert nagyon le vannak maradva ennek a területnek a kutatás-fejlesztésével. Több alkalommal előfordult már (pl tesszeláció, HBM, gyártástechnológia), hogy az Nvidia valamivel látszólag később rukkolt elő, de amikor az megtörtént, az nagyon profin történt és megsemmisítőleg hatott az azt megelőző évek arra irányuló érvelésére nézve, hogy az AMD azért volna valamilyen vonatkozásban előnyben, mert már X generáció óta termék formájában ki is adják.

Ha esetleg tudsz olyat mondani, ahol az látszott, hogy az Nvidia kapkodott, vagy tapasztalatlanság miatt bukdácsolt és az AMD képes volt néhány éves előnyét megtartani, akkor kiváncsi vagyok rá.

Én nem gondolom, hogy az Nvidia ne folytatna kutatás-fejlesztést ebben a témában. Csak nem jelentetnek meg belőle terméket. Nem feltétlenül azért, mert még sehogy se állnak, hanem talán azért, mert nem szorulnak rá arra, hogy egy megoldást a nagyközönséggel béta-teszteljenek, vagy épp azért, mert van erőforrásuk párhuzamosan futtatni többféle fejlesztést. Másként fogalmazva, lehet, hogy az Nvidiának volt - chipletes - B terve arra nézve, ha nem így alakulnak a wafer árak. Másként fogalmazva: Jensen nem látnok, csak rendelkezésére állnak az ahhoz szükséges erőforrások, hogy többféle szcenárióra is felkészüljön.

Tartok tőle, hogy benne van az a lehetőség, hogy ugyanez fog történni a chiplettel is: hogy amikor az nvidia megjelenteti a saját megoldását, akkor az addig többéves előnynek tűnő AMD erőfeszítés hirtelen más megvilágításba kerülve többéves értelmetlen és kézzelfogható hasznot nem hajtó szerencsétlenkedésnek (pionírkodásnak) fog tűnni.

-

Én nem írtam olyat hogy tudták az 5nm árazását sehol előre,de abban biztos lehetsz hogy mielött egy architektúrát el kezdenek fejleszteni egy gyártásra akkor már lekötik bizonyos feltételekkel az árazást. ( előrendelt mennyiség, kötbér, előleg befizetés stb) Én teljesen más területen ,de ebben dolgozom és ez nálunk is így megy.

Amúgy szó volt arról hoyg Nvidiának van egy B terve arra hogy a MCM dizájnt hoz az RDNA ellen a csúcsra, de aztán Jensen eltörölte. Itt volt róla szó:[link]Miért kellene hogy nyoma legyen? az RDNA1 architektúrájában volt nyom arra hogy az RDNA3 chiplet lesz ?

Az Ada2 is monolitikus lesz még.2027 kb amikor jön geforce szintre.

Az Nvidia ütemterve szerint előszőr a professzionális szintre hozzák be az MCM vonalat, meg kisebb autó gyártás, 5 G Mediatek, stb.

Szerintem tökéletesen tisztában voltak azzal mindkét cégnél, hogy TSMC kb mekkora árazást ad a wafferre hisz ez nem napi árfolyam előre megegyeznek, nem ma kezdték. Egy termék ára tól-ig van meghatározva valószínűleg. -

a világ legsikeresebb GPu gyártójaként nem láthatta gondolod?[link]

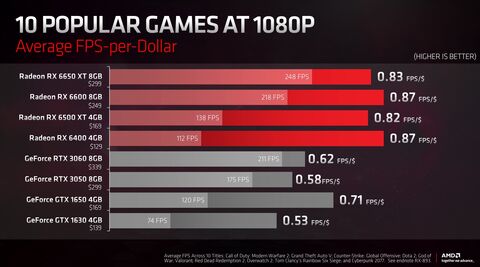

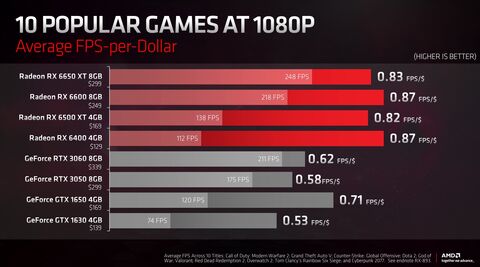

Szerencséjük volt? Az a óriás GPU energiahatékonyabb és olcsóbban gyártható minta 7900XTX :

Az a óriás GPU energiahatékonyabb és olcsóbban gyártható minta 7900XTX :Amúgy már a Volta a GV 100 ban is évekkel ezelött már speciális fabric interfészt használtak.

Abu cikke 2017 ből : [link]

Nvidia MCM : [link]nekem kissér fura, alulról nézve felfele állítjátok be vesztesnek Nvidiát, elmaradottnak, és lúzernek a fejlesztések szintjén. Ilyenkor kicsit értetlenül állok, hogy ugyan abban a moziban ülünk e, mert szerintem nem.

-

Petykemano

veterán

Egyet tudok érteni veled. Az alacsony CU szám egészen arra utal, hogy Maxwellt akartak volna húzni - vagyis azon a 3.5GHz-en járatni, amin egyes compute workloadok futottak.

De vajon hogy illik a képbe az, hogy a megjelenés előtti pletykákban volt egy 30%-os csökkenés a CU-k számát illetően? Benézték volna a 3.5GHz-et, a kisebb lapkát küldték volna gyártásba és az utolsó pillanatban jöttek volna rá, hogy gaming workload esetén mégse hozza azt a frékvénciát? Azért ez elég amatőr lenne.

-

paprobert

őstag

Én két dologban látom, amiben megtört az RDNA felfelé ívelő pályája.

1. Az AMD nem tudott olyan ütemben CU számot növelni. Egy kisebb növekmény volt, míg az NV könnyedén duplázott. Ez skálázódási problémát jelez, és valószínűleg ez az oka, hogy miért nincs egy még nagyobb GCD.

Amíg ez nincs megoldva, addig a chipletezés is elveszti az pozitívumai nagy részét.2. Órajel. Nem kell részleteznem, az RDNA3 alapú kártyák újra GCN szintű órajelbeli lemaradásban vannak, pedig 2 generáción keresztül előny volt.

3. Amikor pedig energiahatékonyságbeli hátrány is van (most az van), az egyébként is behatárolja a maximális méretű GPU ütőképességét.

Szerk: Ezt egy 7900XTX-nél nagyobb GPU-ra értem.

-

Petykemano

veterán

"Nekem az szokatlan, hogy ha már a kis GPU-k elkészülnek, akkor miért ne csinálnák meg a nagyobb verziókat, főleg, ha igény is lenne rájuk?"

Úgy érted, hogy ha már beleteszik a tervezési költséget az RDNA4 architektúrába - elvileg ez a drága és hosszadalmas -, és készítenek belőle 2db fizikai implementációt, akkor miért nem skálázzák és miért nem készítenek belőle még kettőt - nagyobbat?

Elképzelhető, hogy ugyanúgy skálázódási problémákba ütköztek, mint hajdanán. Végső soron az RDNA3-nál is volt egy letekerődése a várható SKU számítási egységeinek számára vonatkozólag.

Ugyanakkor azt gondolnám, hogy ennek már most is látnunk kéne majd a jeleit, hogy mondjuk 4K/4K+RT esetén a 60CU-tól a 96CU-ig nem megfelelően skálázódik a teljesítmény. Ennek akkor abban kéne megnyilvánulnia, hogy a Navi32 méretéhez és számaihoz képest igen jó teljesítményt hoz. A Navi33 ismert számai viszont pont nem utalnak ilyesmire.A másik lehetőség az, hogy a nagyobb verziók eleve multi-chiplet alapon készültek volna.

Például:

Navi41: 400mm2 (2x Navi43)

Navi42: 300mm2 (2x Navi44)

Navi43: 200mm2

Navi44: 150mm2

De ha nem sikerült összehozni a multi-chipletes skálázódást, akkor a két nagyobb verzió törlése érthető volna. -

Petykemano

veterán

"Nem lehet a leírtaknak olyan értelmezése,"

Mivel nem tudjuk, hogy a megmondóemberek pontosan milyen anyagot láttak, ezért lehetne feltételezni, hogy akár félreértés is lehet. Korábban az AMD kitesztelte a 256b + infinity-cache és a 384b kombinációkat. Ez alapján nem elképzelhetetlen az sem, hogy a biztonság kedvéért terveztek nagyobb lapkát is, amit sikeres multi-chiplet GPU esetén el lehet engedni.

De sajnos legalább ennyire jól hihető az is, hogy multi-chiplet GPU-t nem sikerült összehozni.Az RDNA3 esetén a Navi 31-32 egyszerre jelent egy egyedi N5-ön készülő GCD-t és magát az abból összerakható GPU-t is. Sikeres multi-chiplet GPU esetén a kettő elválhat egymástól. De hogy a Navi41 és Navi42 elkaszálása csupán 1-1 monolitikus chipletet jelentett-e, ami szükségtelenné vált, vagy épphogy a - monolitikus, vagy chipletekből összerakott - GPU-t, azt épp az tudná megválazolni, ha tudnánk, hogy az AMD-nek működik-e a multi-chipletes megoldás.

Nekem túlságosan valószerűnek tűnik a kesergés ahhoz, hogy csupán egy félreértésről legyen szó.

-

Alogonomus

őstag

Az valószínűleg egy külön terület. A professzionális kártyák és a fogyasztói kártyák GPU-ja valószínűleg nem csereszabatos. a W7800/7900 GPU-ja állítólag 57,7 milliárd tranzisztorból áll, míg az RX 7900-as kártyák GPU-ja 58 milliárd tranzisztort tartalmaz. Ráadásul a W7800/7900 GPU-ja dupla kapacitású EEC memóriákhoz alkalmas MCD-hez illeszkedik, míg az RX 7900-asok sima memóriát kezelő MCD-t tartalmaznak.

-

PuMbA

titán

"Nyílt kódnál ha jó vagy, ki tudod javítani magadnak"

Ha a nyílt kód rosszul szervezett és a dokumentáció hiányos, akkor előfordulhat, hogy a javítás nagyon sok időbe telik. És tesztelned is neked kell...

"Zárt kódnál meg megkérded a srácokat, aztán?"

Ha fizetsz és van szerződés, akkor meg kell csinálniuk. Nincs aztán. De sok lesz az off, úgyhogy visszavonulok

Abu85: Ez is előfordulhat, de remélem nem sok ilyen nem becsületes cég létezik, hogy nem ismerik el, ha tényleg övék a hiba.

HSM: Egy olasz céggel voltunk kapcsolatban, jeleztük a hibát, mondták, hogy igen, az ő hibájuk és javították a zárt DLL-t. Ez nekem egy jó tapasztalat volt a zártságról.

-

Petykemano

veterán

"A Navi32-nek nem kell borítania semmit, ha javítva jön, majd úgy állítják be az órajeleket/TDP limiteket, hogy a 7900XT-t azért ne érje utol. Mellékhatásként versenyképesebb lehet perf/watt-ban."

Remélem igazad lesz. Örülnék, ha inkább takarékos lenne az energiával, megelégedne a 2 ventis hűtéssel és egyebekkel, minthogy őrült húzással kihozzanak belőle még 10-15%-ot. -

paprobert

őstag

"dual-issue elvileg viszonylag kevés tranzisztorból jött létre"

Tranzisztor- és terület takarékos, valóban. De biztos hogy fogyasztás-takarékos is? Pont ebben lehet a trade-off.

Kilő az elméleti számítási kapacitás, viszont ezt multi-fin, szivárgó tranzisztorokkal érik el, azokat sokszorosítják."Az órajel/fogyasztás görbe egy adottság, és jól látszik, hogy pl. a 7900XTX eléggé a tetején jár ennek. A tuningos verziók minimálisan gyorsulnak csak jelentős fogyasztástöbblet mellett."

Nem tud tovább gyorsulni, igen, de miért nincs az ilyen túlhúzási esetre jellemző hatékonyságnövekedés akkor, amikor kézzel visszavesszük a terhelést?A bekapcsolt V-sync melletti fogyasztási értékekben van irtózatos különbség a két márka között. Talán Igor tesztelte.

A 4090 tud olyan fogyasztás mellett üzemelni egy nem terhelő játékkal V-sync mellett, hogy egy 3050 szintű kártya is megirigyli a fogyasztást, míg ugyanebben a játékban az RDNA3 továbbra is felsőközépkategóriásan, sokat fogyaszt.Igazából az RDNA3 aktív állapotban nem skálázódik lefele úgy, ahogy kellene. Ha csak gyári beállítás és biztonsági tartalék miatt lenne ez, akkor csodás energiahatékonyságot látnánk egy kézi UV után, de ha őszinték vagyunk, ez is elmarad a várttól.

-

bitblueduck

senior tag

van ami sosem változik. HD5850-el egész boldog voltam, de szeretek régi gamekkel is játszani aztán vicces hogy (kis túlzással) minden driver update után máshol volt egy kis grafikai glitch

meg 1000 apróság, hogy pl úgy emlékszem AMD driver után a 2 monitoron a desktopon lévő fájlokat 1 monitorra dobta mindig aztán pakolgathattam. még mintha az R9 280 esetén is így lett volna. NV update után meg most minden marad a helyén miután kész a frissítés. ez már azóta megoldódott, tudja-e valaki?aztán itt fórumon is megy a hiszti, hogy AMD mindig másodhegedűs innovációban, de azt lehetne ellensúlyozni betonstabil szoftverrel. sőt, igazából csak arra lehetne építeni, jó az az asztalos hasonlat. de ez úgy tűnik nem prio.

-

Hogyne tudnád :

Amit linkelsz abban is 2014 januári a javaslat Nvidia 2013 Októberben mutatta be a Gsyncet.

[MSA Timing Paramater Ignore ]2014 januárban nyújtotta be AMD a kérelmet a CES -után a DP1.2a szabvány módosítására.

Áprilisban ezt elfogadták, majd 2014 májusában jelentette be a Vesa az A-syncet a DP szabvány részeként, mert igazából minden adott és kész volt, AMD meg leegyszerűsítve erre rávilágított, hogy hülyék vagytok ha ezt nem teszitek bele mikor a saját szabványotok évek óta egy más területen.

Addigra a Gsync már boltok polcain volt, kis túlzással.

Tehát jóval előbb megszültetett a gsync, mint hogy a DP az adaptive szinkronizálást bejelentettete a szabványon belül.

Ezért írtam, hogy nem feltétlenül kell mindig a rossz szándékot feltételezni. Valószínűleg ha ez előbb kiderül, akkor nem öntöttek volna bele egy csomó pénzt a Gsyncbe, de akkor meg már visszatáncolni nem akartak, mert a monitorgyártók egy valag pénzt fecceltek bele állítólag az egyedi gyártásba.. Szóval belekerültek egy elég szar szituációba amihez 3 évig próbáltak ragaszkodni de 2018 őszén már ment a pletyi hogy jön a hivatalos támogatás. -

Busterftw

nagyúr

Az nem erv, hogy forras nelkul te hasrautve leirtad, hogy a G-Syncet az Nvidia osszedobta, gyorsan az AMD CES elott, ami meg csak bejelentes! volt, mukodo prototipust csak fel evvel kesobb mutatott az AMD.

Ekozben mar lassan 1 eve volt mukodo prototipus Nvidiatol es piacon megjeleno megoldas, tobb monitorgyartotol.

Illetve teljesen irrelevans, mert arrol szolt a vita, hogy az AMD mindig orok masodik, sajat innovacio nelkul.A tenyek pedig azok, hogy az Nvidia elsokent lepett ezzel a piacra, evekkel az AMD elott mar olyan allapotban amit az AMD csak sokkal kesobb tudott lekovetni.

-

-

Ez egy oltári nagy baromság, már bocs.

Így próbálsz kijönni abból hogy hülyeséget írtál az elején ezt tetézted ezzel.

Elég lett volna annyi hogy fogalmad sem volt a dátumokról , bocs, az is jobb lett volna mint ez a komment.

Én nem írtam hogy oltári nagy innováció volt bármi is vagy kritizáltam AMD-t ilyesmiben. Pont azt írtam hogy rendben van a dolog amit csináltak.

Azt írtam hogy Nvidia elöbb jött ki a szabványnál és Amd nél a saját egyedi megoldásával ami a mai napig az egyik legjobb. -

Azért írtam, mert Onnan indultunk, hogy Nvidia szerinted a Freesync miatt összedobta a Gsyncet gyorsan. Az Nvidia 2013 decemberében már kész, legyártott, kereskedelmi forgalomba hozható monitort mutatott be és forgalomba jöttek az Asus gsync monitorjai, majd rá fél évre , 2014 ben az Vesa bejelentette az Adaptive Syncet.

Elkönyvelhetjük hogy 2013 decemberére a monitorokban jelenlévő hardvert már legalább 2012 ben elkezdte Nvidia tervezni azt gondolom az Alterával, és ellátni a hozzá való interfésszel és az egész köré felépíteni a szükséges szoftveres hátteret együttműködve a 4 kezdő monitorgyártóval.Igen tisztában vagyok mi az a szabvány. Ezért írtam hogy most a 2.0 Dp és a HDMi 2.1 megjelenésével kezdi értelmét veszteni valójában a Freesync és a Gsync megnevezés, lassan egy egyszerű tanúsítássá degradálódik szerintem a dolog mindegyik oldalon. Én ennek örülök amúgy.

A HDMI 2.1 azért kell nekem hogy a PS5 mehessen rá frankón.

-

Busterftw

nagyúr

De most pontosan mit akarsz mondani?

Innen indultunk:

"...továbbra sem látom, hogy mit innovál és miben jár saját(!) utat a cég. Örök másodhegedűs..." - YANY

"Pedig bőven van náluk is, sőt. De valamiért nem tudják ezt megfelelően marketingelni, eladni. A kedvencem a G-sync esete volt, amit gyorsan kiadtak a zöldek, gyakorlatilag egy prototípus szintű megoldással, miközben az AMD azon fáradozott a VESA-n belül, hogy szabványos formában mindenki számára elérhetővé tegyék... Lásd p"Tehat a FreeSynccel itt az AMD mit innovalt, amirol szo van?

"Persze, azért jöttek ki egy kutya közönséges Altera gyártmányú kész FPGA-val"

Ez miben vitatja a G-Sync innovaciojat es elsoseget?

A scaler quality control miatt kellett, mert amig az AMD-nek kb +6 ev kellett a FreeSync premium bevezeteseig, az Nvidia sajat scalerrel megoldotta a teljes tartomanyt."Ugyanúgy 2015-től elérhető volt ez a technológia is"

Tehat 2 evre ra amit a G-Sync mar tudott. Tudod, gyorsan, az Nvidia elott, innovaltak. -

A G-sync 2013 ban debütált amúgy és már akkor is 30 Hz-t írtak minimum majd 1 Hz tól már ment rá pár hónapra. A Vesa 2014 ben, fél évre rá kb jelentette be az Adaptive sync technológiát amire a Freesync épült.

Természetesen jó dolog, hogy a nyomás hatására engedett Nvidia mert őszintén megmondva a hardveres Gsync szuperül működött az Asus monitoromon de a panel önmagában tragédia volt. Kb 3 helyen világított át meg hasonló nyalánkságok. A Samu ebben mérföldekkel jobb.

A Samu ebben mérföldekkel jobb.

Nekem szerencsére jól működik az A-sync a Freesynces monitoron, de erősen gondolkodok, hogy váltok egy HDMI 2.1 vezióra az a biztos. Nem lehet itt megbízni egy cégben sem

-

Busterftw

nagyúr

"Szerencse, hogy nem kevered össze-vissza az AMD implementációját (FreeSync) az annak alapját képező VESA Adaptive sync technológiájával."

Nem keverem, mindketto Adaptive Sync-re epul, az innovacio itt a G-Sync modul volt es piacon elsoseg. Nem "gyorsan" jott ki ezzel az Nvidia, mar csak a sajat hardveres modult kifejlesztese es gyartasa miatt sem volt ez lehetseges.

Az AMD sajat megoldasaval csak kesobb jott ki, masodikkent.

"Ehhez nem kell G-sync. A széles tartományú szabványos monitorok is tudják, az AMD FreeSync LFC technológiájával (mai nevén AMD FreeSync™ Premium). Ugyanúgy 1FPS-től működik."

A FreeSync Premium 2020-ban debutalt, olyan feature-rel amivel a G-Sync mar 5+ eve piacon volt.

A gond azzal van, hogy hiaba van ez a funkcio a Freesync monitorok tobbsege 48hz-tol mukodik.Szoval adhatjuk hozza a tobbihez, RT, DLSS, esatobbi, amikkel az AMD csak jatsza evek ota a catch-upot.

-

Nem akarok az időrendekbe belemenni,de az a kulcs abban amit írsz. Érdemes utánanézned az akkori szabványnak és a gsync modullal megjelent monitorok akkori tudásának Hz , tartomány stb terén. Tényleg prémiumok voltak. ( árban is)

A szabványos megoldások simán kiszolgálják a hétköznapi igényeket ma már,de apróságokban a gyártói megoldások jobbak és egyfajta tanúsításként működnek ma már. ( ideértve a freesync prémiumot is, ami szintén apróságokban jobb mint a szabványos vesa szerintem ) nem más működési tartomány terén plusz jött az ULMB is.

Amúgy a szabványos HDMI az RTX 3000 kártyákon ugyan úgy működik DP-n át meg már pár éve szintén szabványos megoldásként jelen van . Az RTX 3000 és onnantól felfele tulajdonképpen három féle sync áll rendelkezésre. HDMI 2.1 et támogató szabványos, DP-t támogató szabványos és a Hardveres G-sync.jacek: nem egészen. Ez egy jó cikk.[link]

A Freesynccel nem vagy gyártóhoz kötve, ami jó dolog. -

Busterftw

nagyúr

Aha, mese habbal.

2013 oktober Montreal eventen bejelentettek a G-Syncet (mukodo prototipussal demozva), decemberben mar voltak tesztek az elso kaphato monitorokrol.

4 honapra ra CES-en az AMD bejelentette, hogy dolgoznak a FreeSyncen.Tehat te azt mondod, hogy az AMD bejelentese utan az Nvidia gyorsan osszelapatolt egy sajat verziot, gyorsan osszelapatolta a hardveres G-Sync modult, gyorsan osszelapatolta a monitor gyartokat akik aztan kijottek sorra a G-Synces monitorokkal.

Ez aztan az alternativ valosag.Mikozben FreeSynces monitor meg 2015 januari cikkben szerint nem is volt piacon.

"AMD offers a similar technology called FreeSync that's compatible with that company's current R7 and R9 series desktop graphics cards. It, too, uses DisplayPort, but requires a monitor with the adaptive sync specification, which is free to use so it could be more widely available than branded G-Sync monitors (although adaptive sync monitors for FreeSync are not yet for sale)."2014 Junius Computex-en az AMD mutatott egy prototipust, 2014 decembereben jelentettek be az elso monitorokat.

Es ez a FreeSync kanyarban sem volt a hardveres G-Synccel, sot, a mai napig nem az, mert a legtobb FreeSynces monitor 48Hz-tol mukodik, nem teljes tartomanyon.Ez nem marketing, hanem innovacio, AMD meg mint kb minden massal, kijott masodikkent.

Yany

A chiplet ugye a DARPA CHIPS-tol szarmazik, csak az AMD hozta le consumer CPU piacra. -

Az a hardveres Gsync a mai napig az egyik legjobb változó frissítési megoldás amivel a szabvány nem igen tudott még ma sem konkurálni. megszabta hogy az a monitor amibe az belekerült minimum mit tud, és az a mai napig is egyedülállóan széles tartományban működik, 1 FPS- től.

-

Yany

addikt

Akkor én is hadd egyszerűsítsek: tehát akkor a piacon másodikak voltak.

Másrészt... innovációnak én azt nevezném, ami előremozdít valamit egy aktuális állapothoz képest. Perpill a chiplet nemhogy nem járt látható előremozdulással, de vannak hangok, amelyek szerint éppen egyik oka a konkurens termékekhez képesti lemaradásnak. Noha nemcsak a chipletes implementációk maradnak le, részben az erre (látszólag, legalábbis egyelőre hiába) fordított erőforrások is magyarázatot adhatnak. Csak gondoljunk bele, ha mindezt energiahatékonysági fejlesztésekre fordították volna, miben lenne más a helyzet... Amúgy az NVIDIA szerintem a Tegra kifejlesztése óta messze többet tud az energiahatékonyságról, mint az AMD. (picit felidézi bennem a Core processzorok izraeli kifejlesztését, amikoris az Intel visszalépett a P4-től ugye és állva hagyta az AMD-t).

-

Alogonomus

őstag

Igen a dual issue kialakítás lehet magyarázat a kiugró értékre, bár olyan híreket hallottunk már, hogy a sugárkövetés hatékonyságában az N33 nem lesz lényegesen jobb, mint amilyen az N23, szóval valószínűleg lesz egyszerűsítés az N31-hez képest a feldolgozóegységek vonatkozásában is.

Mindenesetre ezekkel az értékekkel még a dual issue feltételezése mellett sem a 6650 XT szintjének tűnik a 165 watt esetén jósolt teljesítménye, hanem minimum 6700 XT-nek, de jó eséllyel a 6750 XT is meglehet. Már ahol a memória kapacitása nem jelent majd gondot. -

PuMbA

titán

Nekem is egy 5600X miatt kevés a gépem összfogyasztása. Van beállítva rá egy -15-ös all core alulfeszelés PBO Curve Optimizer-rel és így 80-90%-os terhelésen is a gyári 77W maximum helyett 50-60W körül megáll játék közben 4.6 GHz-es átlagos órajellel. Továbbá a gépemre nincs ráaggatva sok minden. No RGB, 1db NVME SSD-m van, billentyűzet, egér. webcam és ennyi.

-

Nem íródott semmi arra hardverre, ez urban legend. Az Intel belépett a piacra és az Arc 770 sok esetben hozza a vele egyenrangú Nvidiás társát RT alatt. [link]

A Miértjét leírtam miért nem láthatsz .mert ezek elméleti számok és semelyik gyártó nem saját megoldásra fejleszt( szerencsére), kivéve pár techdemót. Ott a Portal próbáld meg futatni egy 7900XTX-en.[link] hányszoros sebességre képes az RTX 4090 ..[link]

Ha megosztódik a piac ez várható.

Nem értem miért lehetetlen elfogadni itt ezt hogy egyszerűen RT alatt szükséges mérlegelni hogy az AMD hardverek gyengébbek ebben. Lehet elhitetni hogy majd szoftveresen be lehet ezt hozni de csak úgy ha a másik gyártó kártyában benne hagyjuk a sebességet és /vagy a minőséget. Mind a két út szükséges. -

PuMbA

titán

Én úgy tudom, hogy nem az NVIDIA féle működéshez van szabva, hanem az NVIDIA elkezdte gyártani a hozzá legjobban passzoló hardvert. Ez eddig még bejött. Az AMD óvatosabb volt, kisebb területet szánt az RT egységnek és a hardver se olyan, ami a DXR-hez idomul. Az AMD arra brazírozik, hogy nagyban változni fognak még az RT dolgok és inkább nem ölt bele annyi pénzt.

Illetve a DXR 1.0 már halott, szóval a DXR alatt csak az 1.1-et értjük már. A Fortnite alatt a HW RT az elvileg ugyanaz, mint a DXR. Abu majd pontosít.

-

PuMbA

titán

Igen. Sima magas beállításokra gondoltam, RT nélkül. Kivétel Fortnite, ahol szoftveres RT-vel együtt is megvan

Azért példálózok a sima 6800-zal, mert magasan a legjobb teljesítmény / fogyasztású kártya az előző generációból A többi alternatíva egy kazán a mostani generációhoz képest, szóval szerintem azok felett erősen eljárt az idő.

-

huskydog17

addikt

A 4nm valójában tovább fejlesztett 5nm, a TSMC saját maga - ahogy láthatod a saját weboldalukon - az 5nm kategóriába sorolja (5nm technology), szóval a 4nm is csak marketing név.

"In addition, TSMC plans to launch 4nm (N4) technology, an enhanced version of N5 technology."

Az, hogy az NV hogyan nevezte, teljesen lényegtelen, akár enhanced N5 (N4) akár nem, a TSMC saját maga 5nm-be sorolja mindkettőt.

A TSMC az Intel korábbi + jelölése helyett inkább másik számot rakott oda, pedig ők is megtehették volna, hogy N5+ jelölést használnak (7nm-nél meg is tették). -

huskydog17

addikt

Marketing, a TSMC ugyanezt csinálja.

-

Ez teljesen más jellegű, mint ez, ahol egy Nvidia oldalon egy Nvidia Blogban egy charton megemlítik hogy konkurens GPU miközben alul apró csillagban meg van jelölve hogy milyen konkurens GPu ról van szó.

igen ez nem chart,ez egy finomabb marketing.

Eközben :[link] csak 1-2hónapon belül Sasa a Marketing igazgató:

Szóval nem olyan elveszett báránykák, beleállnak a direkt marketingbe.

-

PuMbA

titán

Na ilyenekre gondoltam

Ez a kiváló marketing. A streamerek agyába már el is ültették, hogy megint NVIDIA-t kell venni, ha a legjobb minőséget akarják. Az AMD hol van az Abu által beharangozott világverő AV1 enkódolásával, amit a Xilinx-től szed? Sehol. Az AMD csak magának köszönheti, hogy az NVIDIA legyalulja részesedésben.

Ez a kiváló marketing. A streamerek agyába már el is ültették, hogy megint NVIDIA-t kell venni, ha a legjobb minőséget akarják. Az AMD hol van az Abu által beharangozott világverő AV1 enkódolásával, amit a Xilinx-től szed? Sehol. Az AMD csak magának köszönheti, hogy az NVIDIA legyalulja részesedésben. -

hahakocka

őstag

Igen viszont a kevès Vram bajt hozhat mert 1.5-2gb Vram többletet kèr a nemrèg linkelt Jedi 2 ben, de Last of Us is, Resi 4 remake , a Hogwarts legacy is ugyanezt adta ki teszteken. S pont az Nv Achilles sarka a kevès Vram akadályozhatja az Rt használatát amiben meg pont jók lennènek önön tökön rúgás esete. 1440p-4K ra vannak kitalàlva az új kártyàk S ezekben eszik 10.5-14 GB közt ez a pár game Rt vel . Necces azèrt.

-

PuMbA

titán

"Ez a rengeteg bug, bénázás és szoftveres kiforratlanságok szerintem sokkal több vásárlót riasztanak el, mint a hardvereik teljesítménye, ami alapvetően rendben lenne."

Ebben egyetértünk

A mostani CPU fiaskó miatt jó pár évig sokan nem fognak AMD CPU-t venni, de a 7900XTX induláskori szoftveres dolgai is megadták sokaknak az irányt. Évek óta ugyanezt csinálják és még mindig nem találják az ellenszert....egyszerre szomorú és hihetetlen.

A mostani CPU fiaskó miatt jó pár évig sokan nem fognak AMD CPU-t venni, de a 7900XTX induláskori szoftveres dolgai is megadták sokaknak az irányt. Évek óta ugyanezt csinálják és még mindig nem találják az ellenszert....egyszerre szomorú és hihetetlen. -

A Witcher 3 mint a legdurvább terhelésű RT játék? ok .

Na én írom azt erre hogy kábíts mást ezzel. kevered azt ,hogy egy utólagos belefoltozott RT nem fut elég gyorsan minden kártyán .

Na én írom azt erre hogy kábíts mást ezzel. kevered azt ,hogy egy utólagos belefoltozott RT nem fut elég gyorsan minden kártyán .

A CP2077 a legdurvább RT játék a piacon és a Portal.

Nincs itt kábítás, ez tény.

Azt hogy neked mi a véleményed és az igényed az a te dolgod attól a tény tény marad a két felskálázás minőségében és külön leírtam hogy az én értékrendszerem szerint amiben :

1, számít az RT

2, és pont ezért számít a felskálázás minősége. Ebben nem fog a 6800XT jobb lenni a plusz Vram miatt , mint a 3080 és pont ezért nem időtálóbb számomra. Anno hány ilyen kommentet olvastam a Turing vs RDNA1 kapcsán. -

Mert milyen hátránya van egy 3080 12 GB nak egy 6800XT hez nézve ? nehogy azt mond hogy a 12 GB kevés ahhoz nézve. A 10 sem az.

Pont ezekkel a gondolatokkal tudnám neked leírni az én 3080 vásárlásom csak megfordítva... megfordult a fejemben a 6800 XT de aztán gyorsan elvetettem és nem bántam meg soha egy perce sem. sőt..

Ez a "lehetne picit erősebb RT ben 1-2 címben " kb pont olyan elkicsinyítés és túlzás mint a 10-12 GB vramot használhatatlannak minősíteni. Attól hogy a 6800XT-n 16 GB vram van messze elmarad mind RT ben mind felskálázási minőségben az Ampere szériától. Erősebb RT címekben 40 % fölötti elmaradása van egy 3080 hoz képest( CP2077 natívban 60% fölött) a DLSS 2.3 meg ehhez még hozzá tesz egy lapáttal. Kb a 3-400 dolláros 3060 hoz lehet hozzámérni.[link]

Mondjuk úgy hogy mindkét kártya családnak meg van a maga gyengesége és erőssége. Pont a fenti dolgok miatt én a saját értékrendem szerint messze nem érzem a 6000 szériát a jövőre nézve éppen időtállónak a plusz Vram ellenére az Ampere szériával szemben a saját igényeimhez mérten.

Ti elfogadjátok a kisebb RT teljesítményt mi meg a néhol kompromisszumos Vram mennyiséget.

Ettől függetlenül természetesen a mostani 4070 Ti fiaskót ilyen drága GPU nál a vram spórolást én is elítélem. A 4070 TI egy sokkal jobb kártya lehetne 16 GB vrammal. -

Busterftw

nagyúr

A 3080 10GB 1440p-ben kb 1%-al marad el a 6800XT-től, 4K-ban pedig kb 3%-al gyorsabb annál. Ennél a 12GB verzió csak pár FPS-el gyorsabb.

Nem értem mi volt előre borítékolható és miért ne merülhetett volna fel, mint opció.

Ahogy kb minden generációban, az AMD több vrammal hozta a kártyáit, teljesen feleslegesen. -

S_x96x_S

addikt

na végre .. valami hír ... Április 30;

AMD Ryzen 7040 Phoenix rumored to launch in late April, nearly 5 months after being announced"

The leaker also claims that the Ryzen 7 7840U, the 15W Phoenix, would launch on the 1st of May. It’s claimed it is very likely that all Phoenix APUs will launch within one week.

Interestingly, despite numerous leaks featuring the low-power Phoenix series, AMD has not officially confirmed the Ryzen 7040U SKU lineup yet. The company did mention that 15W Zen4 processors are coming, but thus far, AMD has been reluctant to share the specs.

As of now, we are aware of nine Phoenix SKUs featuring H, HS and U-series models. The series will be divided by the TDP and clocks.

However, the basic core-count and integrated RDNA3 GPU specs should remain similar."

akkor májusban jön a termékcunami .. -

Petykemano

veterán

-

paprobert

őstag

Tudsz ilyenre példát?

Lassú játékmenet példa: 3rd person sztori alapú játékok. pl Cyberpunk, GTA és társai.

De ide tartozik bármilyen játék, ami Geforce Now-on használható kategóriába esik. Az a játék, ami GF Now latencyjével elviselhető, ahhoz képest a DLSS3 meg se kottyan, vagyis széles a paletta.CPU limites példa: MS Flight Simulator. Illetve egyre több érkező, PS5-XSX only játék ebbe a kategóriába kerül.

Bármilyen játék, amikor megkerülhetetlen CPU limited van, vagy régi platformon ragadtál.Soha nem kapcsolod be:

-50-es képkockaszám alatti tartományban

-multiplayer / kompetitív játékban.#60891 Abu85

Én egyedül attól tartok, hogy univerzális, frame buffer alapú bűvészkedés lesz az AMD verziója, azaz egy átlagos TV smoothness filter. De ne legyen igazam. -

Abu85

HÁZIGAZDA

A DirectStorage az csak ront a memória problémáján, mert a GPU-s dekódolás miatt nem csak a dekódolt textúrákat kell tárolni, hanem a kódoltakat is. Tehát az lehet, hogy ez a technika gyorsabb betöltést és jobb streaming képességeket biztosít, de ennek az ára, hogy jobban zabálja majd a VRAM-ot.

Ezen egy olyasmi módszer segítene, hogy lenne egy API a lapalapú menedzsmentre, hogy ne teljes nagy allokációkat, hanem szimplán 4 kB-os lapokat mozgasson a rendszer. De ez PC-n nincs csak konzolon.

-

Persze hogy nem pótolja( nem is ezt írtam) , csak némileg javít rajta, főleg a nagy L2.

500$ lenne a reális ára. ebben a formában. Olyan érzésem van hogy az összes SKU elcsúszott nevezékben egyel feljebb.

Szerintem amikor látták hogy az AMD 20-25 % kal lassabb az előzőleg beharangozotthoz képest fogták aztán a 4060Ti ból lett 4070 Ti a 4070Ti ből 4080 és így tovább , ott lapul még egy 15-20% kal gyorsabb SKU a tarsolyban amire nem volt így szükség behozni. -

Alogonomus

őstag

Minden csak a tálaláson múlt volna.

Úgy rossz lett volna az üzenete, hogy az ígért 70% helyett az artifacting kockázata nélkül csak 40% jött össze. Úgy viszont nem lett volna igazán kínos, hogy lám a 70% nem lehetetlen, de még csiszolniuk kell rajta a végső engedélyezés előtt.

Akár még úgy is kiadhatták volna a kártyákat, hogy a felhasználó választhatott volna a korlátozástól mentes driver és a korlátozó driver között. Előbbinél pedig elfogadta volna a felhasználó, hogy a X óránként újra kell indítania a játékát.

Az elmondás alapján valami szinkronizációs hiba lehet az MCD és GCD között, aminek a mértéke hosszú játék alatt a tűrési határ fölé halmozódik. A kiadott driver is állítólag egy pillanatnyi szünetet "stall" illeszt be időnként a végrehajtási sorba, és azalatt az MCD és a GCD valószínűleg újra tudja szinkronizálni az adatkapcsolatát.

Az AMD valószínűleg biztonságosan nagy szünetet tett az első driverbe, és most azt vizsgálják, hogy mekkora hosszúságú szünet mellett tud még biztonságosan működni a kártya, illetve esetleg a driverbe, vagy a kártya BIOS-ába be tudnak-e tenni egy artifacting jelenséget detektáló rutint, és így elég lenne csak az artifacting megjelenésekor újraszinkronizálni a GCD és MCD-k közötti kapcsolatot. Mivel állítólag csak több órányi játék hatására jelenik meg az artifacting, senki sem venné észre, ha mondjuk 2,5 óra játékidőnként egyszer beesne az fps 25%-ra. -

-

Busterftw

nagyúr

Igen, amit 2015-ben atadtak. De a DXVK 2018-2019 release.

A Wine-t fejleszto sracok dolgoztak be a Protonba, hiszen az egy Wine fork.Kb annyi koze van az AMD-nek ahhoz, mint a BOE-nek, hiszen ok szallitjak a displayt.

Nem arrol van szo, hogy a Vulkan nem relevans a modern jatekokhoz, hanem arrol hogy a DXVK-hoz az AMD-nek semmi koze. -

Raymond

titán

OK, ha nem hagyod akkor tessek. A #60690-re eloszor akartam valaszolni de mondom hagyom hogy meglegyen neked ez a "saving face" dolgot de latom nem volt sok ertelme nem leirni hogy fantasztikus hogy megtalaltad vegre az irast amit linkeltel akkor es el is olvastad, azzal kellett volna az elejen kezdened.

Egyebkent itt megint nem tudom mirol beszelsz. Amit en kifogasoltam az a "VR-nal nem fontos a minoseg" kijelentesed. Ami termeszetesen badarsag. Amit most ideztel ott sznten nem azt mondom, hanem ezt: "A VR-ban sokkal fontosabb a kesleltetes mint a 2D jatekoknal." Az hogy nem erted vagy szandekosan nem akarod erteni a gyakorlatban lenyegtelen.

Azon se valtozott semmi hogy egy edge case-eket is bemutato videobol itelsz meg valamit ami nem igazan szerencses. En es rengetegen masok is evek ota latjak hogy nez ki a gyakorlatban az osszes valtozata. Az hogy bizonyos esetekben nem idealis azt nem vitatka senki, csak amikor az esetek 99%-ban nem latod vagy nem zavar akkor azzal a maradekkal egyutt tud elni mindenki.

A DLSS3-nal is amit en az osszes eddigi videoban lattam az hogy a UI a legnagyobb problema. Legyen az MSFS vagy az F1 floating elements. De az hogy egy scene valtasnal amikor a ket kep 100% kulonbozo nem tud normalis eredmeny generalni az nem meglepo es nem is igazan problema 120FPS-nel az az egy frame. Vagy amikor a HUB videoban 10% sebessegel (es egyszer raadasul 3%) kell valamit lejatszani hogy megmutassa a "problemat" akkor az a kakan a csomo kereses kategoria szerintem.

-

Raymond

titán

"Mert az egérmozgást nem lehet előre jósolni? Pont annyira lehet, mint az IMU-val."

Minek josolgatnal egy PC-s jateknal? Senki nem josolgat, akkor tudod mi az uj input amikor megtortent aztan az alapjan kezdesz renderelni. VR-nal viszont fontos hogy a kesleltetes minel alacsonyabb legyen igy az IMU adatok alapjan megy a josolgatas fuggetlenul attol hogy fut vagy nem valami jatek vagy csak a menuben vagy es a kompozitorban van a megjelenites elott meg rapasszintva a bejovo kep az epp aktualis helyzetre. Ez az ATW/PTW es fuggetlenul attol megy hogy fut vagy nem a jatek es hogy hasznal vagy nem a jatek ASW-t ami akkor fontos amikor a jateknal nincs meg a kivant FPS."Persze, értem én, hogy érvelés helyett könnyebb olyasmikkel dobálózni, hogy "nem értesz hozzá"

Nem en vagyok az aki ertelmetlen dolgokkal dobalozik. Mar a legelejen vilagos volt hogy nincs semmilyen hasznalhato informaciod a temaval kapcsolatban es ezt le is irtam neked. Azota ahelyett hogy utannaneztel volna csak meg tobb bizonyitekkal szolgaltal arrol hogy az elso megiteles helyes volt.

-

Raymond

titán

"Ugyan miért ne lenne? Ugyanúgy megvannak PC-n is az input adatok, csak nem az IMU-ból, hanem az egérből jönnek... Ne állítsuk már be varázslatnak, ami nem az..."

Mert nincsenek. VR-ban az IMU adatok feldolgozasa, prediction, stb. egy teljesen mas dimenzio mint az hogy a PC-n meghuzod az egeret. De mondom, ha nem ertesz hozza akkor legalabb kezd azzal hogy megnezed milyen egy VR pipeline mielott irsz valamit ami aztan egy badarsag lesz."Épp elég panaszt olvastam a VR generált képeire, hogy legyen róla elképzelésem."

Ergo fogalmad sincs mirol beszelsz

"Maradjunk annyiban, hogy ez amolyan "educated guess". Informatikai végzettségűként van némi fogalmam ezen technológiák korlátairól anélkül is, hogy részletes analízist kellene készítenem róla..."

Abbol amit eddig irtal az jon le hogy az "educated guess"-tol egyelore merfoldekre vagy.

-

Raymond

titán

Tehat fogalmad sincs milyen a minoseg csak "nem tudod elkepzelni". Akkor javaslom jarj utanna eloszor es ha van lehetoseged akkor tapasztald meg aztan folytathatjuk.

"Nyilván ezért vezették be itt a késleltetett megjelenítést, hiszen itt alapvetően a jó minőségű interpolált kép elérése az elsődleges cél."

VR-nal ott az IMU-bol az adatok a jovo joslasara, ez a 2D PC-s jatekoknal nincs igy valami kellett a masik oldalra is. Peldaul, de mondom eloszor jobb ha picit jobban erted, mert addig felesleges a diskura.

-

így van, tökéletesen leírtad.

Annyi csak, hogy nem az utána jövő képkocka teljes kialakulásáig alkotja meg a köztest, mert az OFA (Optical Flow Accelerator ) a beérkező mozgásvektor adatok alapján már megalkotja a köztes képkockát az előző 8-ból mintavételezéssel és az utána jövő mozgávektor adataiból, tehát az utána lévő képkockából a bemeneti információkra van "csak" szüksége, így gyorsítja a folyamatot és alkot pontosabb képet , ebben tér el egy sima két képkocka közé beszúrt blindframe megoldástól. -

Frame G:

" ami a számolt képkocka szín- és mélységadatai, illetve a mozgásvektorok mellett, a korábban elkészült kép információit is beolvassa előzményminták formájában, és ezekből a részadatokból próbál optimálisan felskálázott új képkockát generálni."8 már lerenderelt képkockát, mozgásvektort vesz alapul az új képkocka generálásához. és ebből tér el a petyke által leírttól, de természetesen ez lassabb.

-

PuMbA

titán

Senki nem kötelezi az AMD-t, hogy félkész dolgokat engedélyezzenek. Sajnos ez menedzsment probléma

Ha nem működik 100%-osan, akkor hagyják a fenébe, mert az egyszeri felhasználó nem fog venni AMD-t soha az életben. Nem tudom, hogy miért nem veszi észre az AMD, hogy maga alatt vágja a fát, de már nem meglepő ennyi év után.

Ha nem működik 100%-osan, akkor hagyják a fenébe, mert az egyszeri felhasználó nem fog venni AMD-t soha az életben. Nem tudom, hogy miért nem veszi észre az AMD, hogy maga alatt vágja a fát, de már nem meglepő ennyi év után. -

#90868690

törölt tag

Nem nekem írtad, de rólam beszélsz, így válaszolok. Azért mert nem volt regem, olvashattam a fórumot. Hogy milyen hosszú életű egy új fiók nem tudom, de csomó rangú reget látok, valahogy csak lettek ők is... ha nem az idők alatt, a megírt hsz-ek száma miatt, akkor elég fanboynak lenni egy félistenhez? Ne vedd magadra, csak kérdeztem, ahogy te is...

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- PlayStation 5

- Motorolaj, hajtóműolaj, hűtőfolyadék, adalékok és szűrők topikja

- One otthoni szolgáltatások (TV, internet, telefon)

- Apple asztali gépek

- urandom0: Száműztem az AI-t az életemből

- Kertészet, mezőgazdaság topik

- Milyen processzort vegyek?

- Real Racing 3 - Freemium csoda

- Call of Duty: Modern Warfare III (2023)

- Az SK Hynix elárulta, hogy meddig nem lesz elég memória

- További aktív témák...

- ASUS RTX 3080 TUF Gaming , dobozával

- ASUS RTX 5070 12GB GDDR7 PRIME OC - Új, 3 év garancia - Eladó!

- MSI Radeon RX 5700 XT MECH OC 8GB használt videókártya számlával és garanciával eladó!

- EVGA GeForce RTX 3080 FTW3 ULTRA GAMING 10GB

- MSI Radeon RX 6700 XT MECH 2X OC 12GB használt videókártya számlával és garanciával eladó!

- ÁRGARANCIA!Épített KomPhone Ryzen 5 4500 16/32/64GB RAM RTX 3060 12GB GAMER PC termékbeszámítással

- Keresünk iPhone 13/13 Mini/13 Pro/13 Pro Max

- GYÖNYÖRŰ iPhone XR 128GB Black-1 ÉV GARANCIA - Kártyafüggetlen, MS3985, 100% Akkumulátor

- Keresünk Galaxy S23/S23+/S23 Ultra/S23 Fe

- HIBÁTLAN iPhone 15 Pro 128GB Natural Titanium -1 ÉV GARANCIA - Kártyafüggetlen, MS4226

Állásajánlatok

Cég: BroadBit Hungary Kft.

Város: Budakeszi

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Radeon Chill-lel 79-re limitált fps esetén, amiből ugye 158fps-t csinál 8ms plusz a késleltetés az eddigi 21ms helyett, az nem észrevehető:

Radeon Chill-lel 79-re limitált fps esetén, amiből ugye 158fps-t csinál 8ms plusz a késleltetés az eddigi 21ms helyett, az nem észrevehető:

te is hasonlóan számoltál.

te is hasonlóan számoltál.

Az a óriás GPU energiahatékonyabb és olcsóbban gyártható minta 7900XTX :

Az a óriás GPU energiahatékonyabb és olcsóbban gyártható minta 7900XTX :

A Samu ebben mérföldekkel jobb.

A Samu ebben mérföldekkel jobb.