-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Quadgame94

őstag

válasz

paprobert

#71805

üzenetére

paprobert

#71805

üzenetére

Ilyen alapon az AMD még az ADA-hoz képest is lemaradásban van, hiszen a Blackwell az egy Ada iteráció, nagyon sok szempontból.

A GB203 és a Navi 48 fogyasztást tekintve is nagyon hasonlóak, pedig sokkat több tranzisztor van a 9070 XT-n. Az 5080 pedig főleg a legújabb játékokban alig gyorsabb a 9070 XT-től. 5-10% az előnye.

-

S_x96x_S

addikt

válasz

paprobert

#71801

üzenetére

paprobert

#71801

üzenetére

csak két hónap múlva( nov11) kapunk új infót.

AMD To Present Next-Gen Product & Technology Roadmaps at Financial Analyst Day on November 11, 2025

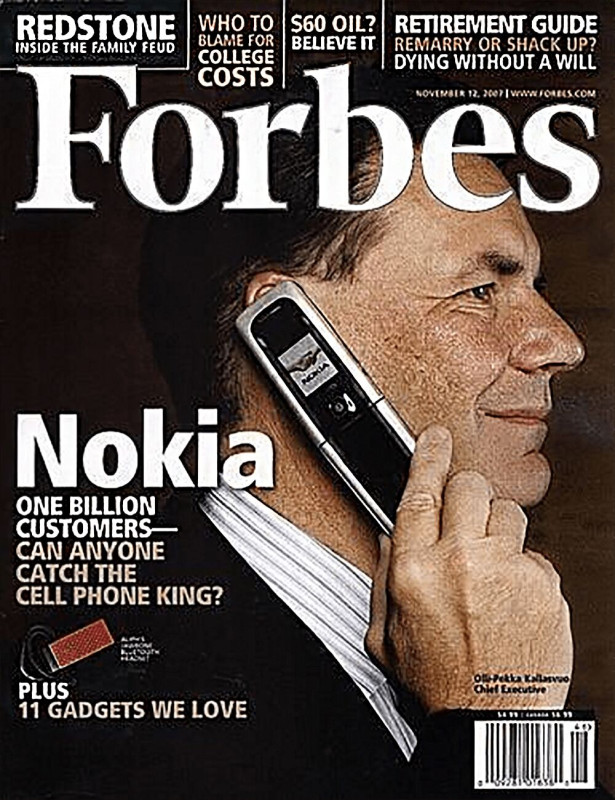

1. ) Hogy lesz gépi tanulásra kigyúrva a következő generáció úgy, hogy a méretek nem szállnak el?

valószínüleg az RDNA5/UDNA elkezd közeledni

a CDNA4 / CDNA next -hez bizonyos AI/ML képességekben. ( FP4,FP6, ... )"AMD’s CDNA 4 Architecture Announcement" ( Jun 17, 2025 )

https://chipsandcheese.com/p/amds-cdna-4-architecture-announcement -

S_x96x_S

addikt

válasz

paprobert

#70925

üzenetére

paprobert

#70925

üzenetére

TLDR: Bár az NPU jövőjében hiszek - de elég göröngyös lesz az első 5 év.

--------

az NPU - forradalmat éppen a desktop procik

gyenge vagy hiányzó - NPU teljesítménye akadályozza.pl. egy

- Intel®Core™ Ultra 5 Processor 245K - NPU Peak TOPS (Int8) = 13

- az AMD desktop CPU - többségében ( pl. 9800X3D ) meg NPU sincs.-----------

és persze ott vannak a régi konfigok felokosítása is.

Vagyis a "pótszerekre" is lesz igény.

Emiatt egyre több cég kezd rá-startolni az USB-s NPU-r a;

pl. Lenovo - USB-s monitorba és USB(Thunderbolt) sticks NPU n is dolgozik.

"

AI Display with NPU Inside – Stunning Proof of Concept Now with NPU Inside

Another demonstration of Lenovo’s commitment to “smarter technology for all”, Lenovo’s AI Display, a proof of concept that leverages AI to optimize user experience, comes with a discrete NPU inside. The dNPU not only enhances the monitor’s abilities, but also empowers non-AI PCs with AI computing power. With the AI Display with NPU inside, non-AI PCs will be able to use Large Language Models, receiving commands from the user, analyzing and recognizing the intent, and allowing the Assistant to execute the request. The AI Display with NPU inside still adapts to the user’s movements by automatically rotating, elevating and tilting the screen to optimize viewing angles."Lenovo AI Stick – Plug-in Local AI Capability

The Lenovo AI Stick is a proof of concept that allows users with a non-NPU-equipped PC access to advanced AI features such as local Large Language Models (LLM) and AI-enhanced graphics apps on their device. The Lenovo AI Stick contains a 32 TOPS NPU that connects to a PC via a USB-C Thunderbolt port, allowing the PC to leverage Lenovo AI Now11 functionalities. It can also be plugged into a wall socket to unleash maximum performance for demanding AI tasks.

"""--------

Amúgy nem csak a GPU -nak - de az NPU -nak is kell rendes memória sávszélesség;

emiatt a kétcsatornás CPU - mellé rakott integrált NPU - egy picit szenvedni fog.a Strix Halo -nál - az AMD például a CPU memória prioritását hátrébb sorolja mint az NPU/GPU- ét :

"So but again, with the right mix of the right mix of traffic between reads and writes, like I said, a couple of CPU threads can saturate bandwidth. So it's not. But again, when it comes to bandwidth, we believe that NPU and the GPU are the ones that benefit more than from a CPU standpoint." ( https://chipsandcheese.com/p/amds-strix-halo-under-the-hood ) -

S_x96x_S

addikt

válasz

paprobert

#70846

üzenetére

paprobert

#70846

üzenetére

> A "berakunk egy NPU-t, majd csak lesz valami"

> és a "hozzáad a játékélményhez

> a mindig másképp reagáló AI" között kilométeres a szakadék,

> és gyakorlati példát nem láttunk az utóbbira, főleg nem filléres NPU-n.------> "Hamarosan foghatja a kezét a Copilot a játékosoknak"

https://prohardver.hu/hir/microsoft_copilot_for_gaming_hamarosan.html

"A rendszer követelményei még nem nyilvánosak, de valószínűleg ugyanolyan NPU-t igényel majd, mint a normál Copilot, elvégre nagyon eltérő dolgot nem csinál, ha pusztán a technikai hátteret nézzük. Emellett az NPU miatt a rendszer még a CPU és a GPU erőforrásait sem terheli, amelyekre a játékok futtatásánál szükség van." -

S_x96x_S

addikt

válasz

paprobert

#70846

üzenetére

paprobert

#70846

üzenetére

> Persze, amíg böfögi fel a szöveget a játék,

> addig 2D-s háttérképeket fogunk nézegetni, nem?

A felvetés jó .. és sajnos nIncs egyszerű és megnyugtató válaszom ...

Egy nVIDIA ACE (Artificial Intelligence Character Engine) -hez hasonló technológia

bevezetése logikus lépés lenne a Sony részéről ( PS6 )

https://www.youtube.com/hashtag/nvidiaaceRáadásul egy fix konzollal - sokkal egyszerűbb

az erőforrások optimális elosztása,

mint egy az extrém heterogén PC-s ökoszisztémával

- [ ada .. vs. blackwell vs. rubin ] vs. [ rdna3 .. rdna4 .. rdna5 ] vs. [ arc. ]

- [ 050 ... 060 ...070 ..080 ...090 ] különböző teljesítmény kategóriák

- [ 8GB .. 12GB ... 16GB ... ] VRAM-os konfigokHa a Sony megtartja jó szokását és megkérdezi a fejlesztőket,

akkor a PS6 -nak is kell olyan szolgáltatásokat nyújtani mint az nVidia ACE -nek.

- Beszédfelismerés (Speech Recognition)

- Szöveg-beszéd átalakítás (Text-to-Speech - TTS)

- Természetes nyelvfeldolgozás ; LLM chat

. ....

> A "berakunk egy NPU-t, majd csak lesz valami"

a XiLINX -nek vannak alkalmazásai , de azok jellemzően a beágyazott - B2B piacot célozták eddig; De rengeteg munka van még, hogy a consumer szinten is elérhető legyen - rendes fejlesztő eszköz támogatással.

( Én például már ~16h órát már elcsesztem , hogy Linux -on működésre birjam az NPU-t ... de még mindig nem vagyok a végén - és nincs is sok XDNA-s alkalmazás. )

, hogy Linux -on működésre birjam az NPU-t ... de még mindig nem vagyok a végén - és nincs is sok XDNA-s alkalmazás. ) Amúgy még a Microsoft dolgozik az NPU-k DirectX-be integrálásán.

-

bjasq99

tag

válasz

paprobert

#70248

üzenetére

paprobert

#70248

üzenetére

"A fejlesztők kényelmét (is) szolgálja, indirekten a szoftver-kompatibilitást növelheti, és az AMD driver költségeiből faraghat. Ebből a szempontból nyerő fejlesztés, de valóban, ettől még nem a farok fogja a kutyát csóválni."

Szerintem pont, hogy drágább a driver frissités, mert egyre több hintet használnak szofveresn ők is, akár az nvidia. Valamint igaz, hogy jelenthet elönyt ez az implementáció, de szerintem rendesen igényel tranzisztort, mindjárt le is írom azt is, ami helyett több CU lehetne. -

bjasq99

tag

válasz

paprobert

#70248

üzenetére

paprobert

#70248

üzenetére

Nem értem teljesen, vagy valamiben lemaradtam a hardverek terén.

Nem tudom, hogy fogalmazzam meg jól, szemléltetem egy leegyszerűsített példával:

Legyenek a szoftveres regiszterek nevei a, b, c, d a fizikai regisztereké x, y, w, z és 2 futtatott szál.

Az 1. szál a végrehajtása során használja a-t és b-t is de legtönször csak a-t míg a 2. szál szintén így csak c, d vel. Most úgye statikus allokáció esetén lefoglalunk 2-2 szoftveres és jelen esetben fizikai regisztert is mindkét szállnak.

Nézzük a dinamikus allokációt: A compiler megcsinálja a regiszter allokációt szofveres szinten 3 szálra: az 1 szál hazsnál egy "rendes" a -t és egy dinamikusan allokált d-t, A 2. egy b-t és d-t a 3. egy c-t és d-t. Na amikor fut a shader és első szál észleli hogy nek kell egy d regiszter akkor ellenörzi, hogy van e szabad fizikai neki és ha van akkor allokál, majd befejezi a d vel a munkát és felszabadítja, majd jön a 2. szál szintén így majd a 3. is. A gond akkor keltkezik ha jön mondjuk a második szál hogy használja a d regisztert (amihez a z fizikai regiszter van hozzá rnedetlve), de nem tudja mert a z fizikai regiszter le van foglalva az 1. vagy a 3. szál által. (Nyilván a 2. szálnak regisztert kell használni, nem változtathaja meg dinamikusan a kódot hogy valamit kiír a memóriába és a helyére betölti a szükséges adatot.) És ilyenkor nincs más mint hogy felfüggeszti a hardver ezen szál futását hisz nincs regiszter. Továbbá az implementáció része hogy csekkolni kell hogy van e szabad fizikai regiszter -

bjasq99

tag

válasz

paprobert

#70235

üzenetére

paprobert

#70235

üzenetére

Kifejtenéd ezt jobban! Szerintem nem lehet rendesen kiegyensúlyozni, mert nem dönthető előre el, hogy egy adott szál mikor jut el egy bizonyos állapothoz, szerintem statisztikai alapon lehet a használatát megfontolni, vagy esetleg a wave ütemezőt megspékelni, hogy a peakeket eltolni egymáwtól, de csak a parancsamotorokkal szerintem nem lehet megoldani. Igen én is egyetértek, hogy ez nem egy olyan megváltó fejlesztés (mindenesetre az utóbbi 15 év legizgalmasabb hardveres fejlesztése), hisz szerintem azért bőven bőven igényel tranzisztort hisz kell valami tag szerű tároló ami a foglalt regisztereket tárolja, az is kérdéses, hogy hány százaléka a regiszter állománynak dinamikusan foglalható és hogy milyen asszociatívitással rendelkeznek az egyes szálak foglalás szempontjából, a full asszociativ nehez kivitelezhető nem releváns szerintem, míg a minél kisebb asszociatívitás esetén csökken foglalható regiszter több szál foglalása esetén. Annak fényében különöden nem értem, hogy az amd miért ilyeneket csinál, hisz a regiszter területük így is sokkal nagyobb mint a geforcoké és nyilván azért a fejlesztők nem hagyják megdögölni a geforce implementációját, (hisz övék a piac), így az amd ilyen tipusú elönyei csökkennek, míg több az elköltött tranzisztor és fogyasztás.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#67555

üzenetére

paprobert

#67555

üzenetére

A PS5-ön tuti van nyeresége a Sony-nak. Az összes gépen. A Prón talán a legtöbb. De azért a 800 euró reális ár, mert ez ugye kiegészítő szerződés, és az AMD is többet szokott kérni a köztes dizájnokért. Naná, itt nincs versenyhelyzet.

Meg nagyon sokat számít a konzolokon, hogy a GDDR6 ára nagyon-nagyon lecsökkent már.

Meg nagyon sokat számít a konzolokon, hogy a GDDR6 ára nagyon-nagyon lecsökkent már. -

S_x96x_S

addikt

válasz

paprobert

#66963

üzenetére

paprobert

#66963

üzenetére

> de vajon mekkorára fog hízni az új architektúra ...

Ne aggódj, az AMD konyha is - már rég tele van séfekkel ( ~ mérnökökkel ),

akik tudják, mit főznek ( sütnek )

Mi pedig majd csak élvezzük az ételt – ha kész lesz,

és ha ízlik, többet kérünk belőle.

Ha meg nem jó, akkor megnézzük, hogy Jensen mit sütött ki,

vagy megvárjuk a következő kört.> hogyan lesznek a zöldek befogva,

technikailag - szerintem - meglesz az UDNA-s chipletes GPU - ami méltó kihívója lesz gaming szinten is az akkor ~ RTX 6090 -nek.

És a Jack Huynh - által ismertetett tervet/korrekciót ( ~ receptet ) jónak tartom.

Persze majd a tálaláskor ( 2025 CES ) eldől, hogy a kivitelezés is jól sikerül vagy sem ..A szoftveres problémák megoldása ( AMD vs. CUDA moat )

sokkal nehezebb lesz és az teljesen ismeretlen terület az AMD-nek is,realistán nézve: Az nVidiának megvan a technikai előnye és rengeteg pénze amit Kutatás&Fejlesztésre fordíthat. és az AMD erőforrásai sokkal kisebbek - emiatt lézer fókusz kell. hogy a jelenlegi hátrányukat folyamatosan lefaragják.

én amúgy versenypárti vagyok, és örülök az Intel belépésének a piacra.

-

S_x96x_S

addikt

válasz

paprobert

#66954

üzenetére

paprobert

#66954

üzenetére

> Az AMD-nek azt kell kitalálnia sürgősen,

> hogyan miként fog RT és ML teljesítményt rakni egy olyan architektúrába,A jelenlegi RDNA4 és az UDNA irány

már vagy 1.5 éve ( ~2023 nyarán) el lett döntve, ki lett találva.

és már régóta a végrehajtják.

Január 6 -ig már csak az árazást és a slideokat kell véglegesíteni.> ami éppen befogásra került a gyengébbik konkurrens által mobilban(perf/area/W),

Kepler nem aggódik az Intel miatt.

"Why is RDNA4 a fail? It's a mid range die with mid range performance. Meanwhile Intel is making a mid range die with low end performance and selling it at a loss."

https://x.com/Kepler_L2/status/1871811492372513034 -

Alogonomus

őstag

válasz

paprobert

#66810

üzenetére

paprobert

#66810

üzenetére

A B580 érkezése óta inkább arról szólnak a hírek, hogy az első 250 dolláros kártyaszállítmány óta nem nagyon érkezik újabb MSRP-szállítmány, helyette legfeljebb a 270 dollártól induló custom kártyák érhetőek el, amik annyiért viszont már kevésbé csábítóak, mint a kicsit erősebb és nagyjából hasonló ár-érték arányú 6750 XT.

A hamar elapadó 250 dolláros B580 szállítmányok alapján erős alapon nyugszik az az elterjedt feltételezés,, hogy a kimondottan nagy 5 nm-es chip és a 12 GB VRAM 250 dollár mellett nem igazán éri meg az Intelnek, és jelenleg nagyon nincs pénze az Intelnek dömpingáron kínált termékkel piacot elhódítani.

-

S_x96x_S

addikt

válasz

paprobert

#66752

üzenetére

paprobert

#66752

üzenetére

> az AMD semi-custom részlegének van hatása a desktop roadmap-re

és viszont is.

Az AMD-nek a desktop fronton nincs olyan könnyű helyzet, mert ott van a Microsoft.

pl az asztali kártyáknál ( ~ Windows/ DirectX ) a Microsoft-nak olyan megoldást kell találni amit a fragmentált piacon ( nvidia, Intel, amd ) is működőképes.

pl. a DirectStorage - aminek eléggé rögös a megvalósítása PC-n - a konzolhoz képest.

És persze ott van az a tény is, hogy a Microsoft -nak van egy rivális konzol platformja - szintén nem segít. -

S_x96x_S

addikt

válasz

paprobert

#66242

üzenetére

paprobert

#66242

üzenetére

> Azért abban egyetérthetünk, hogy

> egy spekulatív következtetéshez érdemes nem figyelmen kívül hagyni a jelent.pontosítanám:

Az is probléma, amikor valaki túlságosan a jelenre hagyatkozik,

ami amolyan stratégiai vakságot okozhat.------

Gyors technológia változáskor,

nem tudod milyen fejlesztések zajlanak a háttérben

mert a "publikus jelen" <> " a valós jelen"- el

a leak-ek fele téves vagy direkt megtévesztés,

és nehéz eldönteni, hogy a saját és a rivális technológia mire lesz képes

és melyik technológia lesz zsákutca.Az AMD például a GPU chipletes technológiánál nem várt nehézségekbe ütközött

és bár az MI300X az RDNA3 - tapasztalatain is alapul,

de nem képes a játékok támogatására

ami várhatóan a jövőben az UDNA -val történik meg.A technológia menedezsmenten próbáltak jó pár téves asszociációt kiverni a fejünkből.

pl. nem mindig a jobb technológia nyer, mert sok más dolog is közrejátszik.

- A VHS például rosszabb minőségű volt mint a Betamax.

de mai példákat is fel lehet hozni:

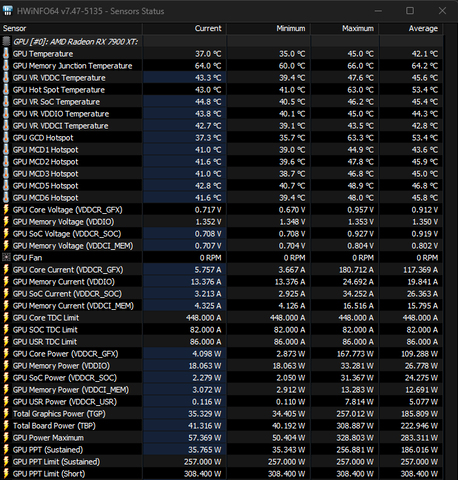

- "AMD FreeSync technology" vs. nVidia G-SyncÉs ha visszamész az időben 2017 -re - akkor a tények pont az AMD ellen szólnak,

amire az Intel rá is mutatott ( "Glued-together" )

És az Intel az akkori jelen és az akkori múlt alapján

egyáltalán nem érezte fenyegetésnek az új AMD stratégiát,

és túl későn kezdett el reagálni.

és ezt amolyan stratégia rövidlátás, hogyha valaki túlságosan a jelenre fókuszál.És az Intel teljesen figyelmen kívül hagyta az alapitó ( A. Grove ) üzenetét.

"Csak a paranoidok maradnak fenn"

„Andy Grove mesterien használja fel saját és az Intel tapasztalatait, hogy meghatározza és elemezze a stratégiai inflexiós pont szerepét egy fejlődő vállalkozásnál.

Aki szívén viseli üzletének sikerét, annak el kell olvasnia ezt a bölcs könyvet, melyet Amerika egyik leginnovatívabb vállalkozója írt.”

Michael S. Ovitz a Wall Disney Company elnökeDe sokan még azt se tudják, hogy mi a stratégiai inflexiós pont - lényege.

"Az úgynevezett inflexiós pont egy olyan változás az üzleti környezetben, amely drámai változást okoz tevékenységünk teljes egészében, vagy annak számos elemében, megkérdőjelezve bizonyos szilárdnak hitt feltételezéseket."

--------

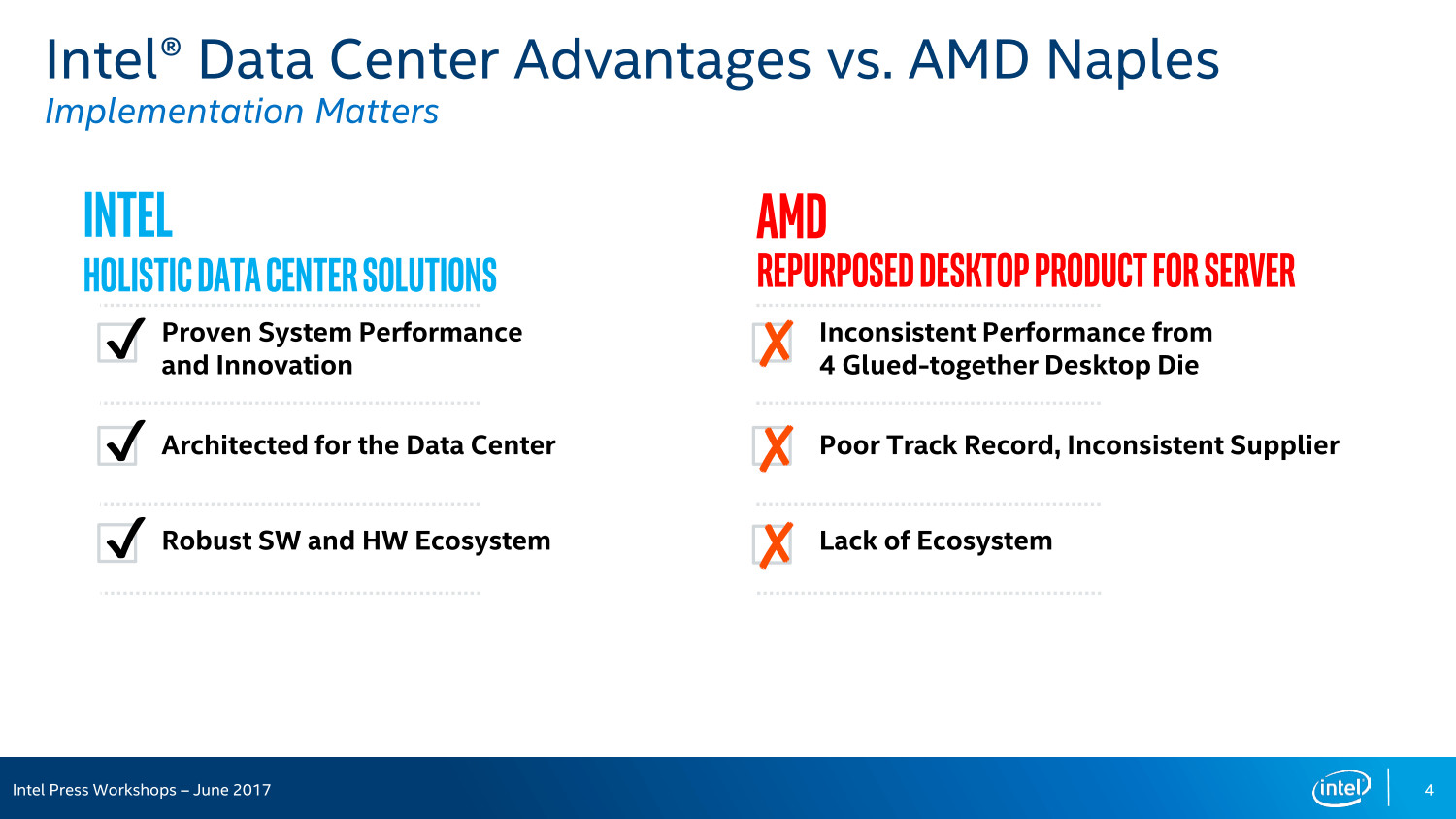

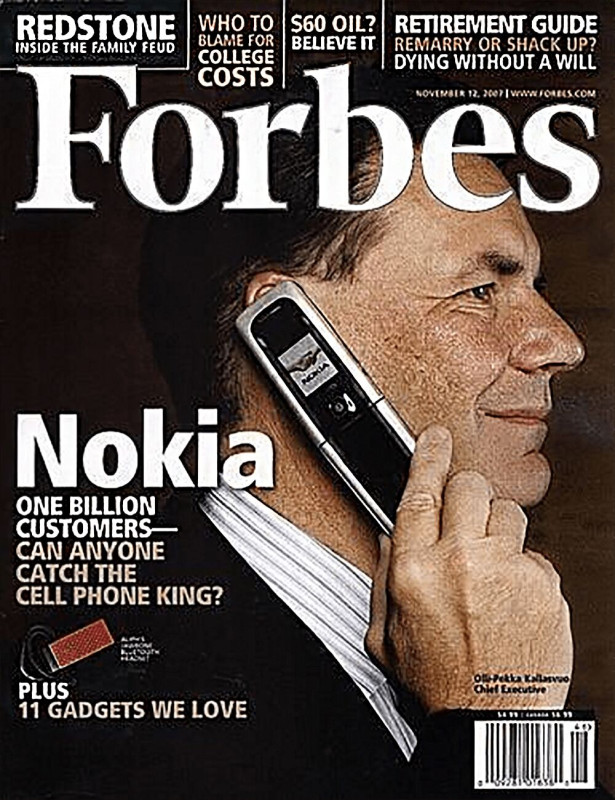

És a Nokia menedzsment is stratégia rövidlátásban szenvedett.

------

Az nVidia amit felismert - hogy a jövőben CPU technológia nélkül nem tud annyira növekedni, mivel az X86-64 területen mindig ki lesznek szolgáltatva.

Próbálta megszerezni az ARM-et, ami nem sikerült,

de a cpu-gpu integrációt elkezdte a grace -el, és dolgozik a desktop arm-os saját megoldásán is. Az első verzió ott is gyenge lesz, és kell 3-4 iteráció, amíg felnő majd a kiforrott Intel-AMD-X86-64 -es platformhoz.Az AI forradalmat az Intel és az AMD félig átaludta - mert senki se képzelte, hogy ilyen gyorsan - ekkora áttörés lesz.

És a gyors technológiai áttörés még az nVidiát is meglepte.Nagyon gyors technológia változások zajlanak most,

és a jelen - nagyon gyorsan elavul.Ha valakit zavarja, hogyha néha a CXL-ről vagy a PCIe 7.0 -ról is posztolok,

akkor az kénytelen lesz ezt megszokni.

-

S_x96x_S

addikt

válasz

paprobert

#66238

üzenetére

paprobert

#66238

üzenetére

> ami a topikba illik. Az AMD GPU-k jövőjéről van szó.

azért nem egyértelmű

![;]](//cdn.rios.hu/dl/s/v1.gif)

mert PuMbA úgy értelmezi, hogy az "AMD GPU-k jelene" a téma.

( ~ "Beszéljünk a jelenről, amit tudunk." ) -

S_x96x_S

addikt

válasz

paprobert

#66233

üzenetére

paprobert

#66233

üzenetére

> Az előre megígért csoda maradt csak el,

A PSSR esetében

sem az extrém felhajtás ( ~ a medve bőrére inni),

sem a túl korai ítélkezés (a PSSR temetése)

nem túl értelmes,Szokásosan minden csúszik,

de a hardver már rendelkezésre áll,

és körülbelül egy évre van még szükség, hogy kiderüljön,

hogyan teljesít az új játékokban.Kérdés, hogy a Ratchet and Clank -ot mennyire okosították fel a fejlesztők,

vagy csak azt használták ki,

hogy a "FSR3 jól együtt tud működni a PSSR" -rel------------------

draft -gépi-fordítással:

"""

A Digital Foundry podcast során a tech szakértő arról beszélt, hogy a PlayStation 5 Pro-ban miért nem található AI-alapú képkocka-generálási technológia. Valószínű, hogy ennek időzítési okai vannak, mivel a Sony már akkor megkezdte a rendszer processzorának fejlesztését, amikor az NVIDIA DLSS 3 Frame Generation technológia még nem is létezett. Továbbá, önmagában a gépi tanulásra alkalmas hardver megléte nem feltétlenül hoz eredményt, hiszen például az NVIDIA képkocka-generálási technológiája több összetevőből áll, amelyek közül a gépi tanulás csupán az egyik. Valószínű, hogy a teljesítmény nem volt akkora prioritás, mint a képminőség, így inkább a felbontás növelésére fókuszáltak a minőség javítása érdekében. Végül, ha mégis szükség lenne képkocka-generálási technológiára, az AMD FSR 3 jól együttműködhet a PSSR-rel.

Egy dolog azonban biztosnak tűnik. A PlayStation 5 Pro gépi tanulásra alkalmas hardvere csupán az első lépés, és várhatóan elindítja a Sony AI-kutatását. Mindezek ellenére ez egy kiváló kiindulási pont, amely az idő múlásával csak javulni fog, ahogy azt a PlayStation 4 Pro checkerboard renderelési technológiájánál is láthattuk. A jövőbeni játékokat már kifejezetten a PlayStation Spectral Super Resolution AI-alapú felbontásnövelő rendszer köré építik majd, amelyek sokkal nagyobb előnyét élvezhetik, mint a jelenlegi játékok.

""" -

S_x96x_S

addikt

válasz

paprobert

#66230

üzenetére

paprobert

#66230

üzenetére

> aminek épp a szöges ellentétét bizonyította a DF a mostani videóban.

A DF videóban - éppen eléggé kihangsúlyozták:

- Ez egy Ratchet and Clank fej-fej melletti összehasonlítási próbálkozás - és hogy ebből még ne vonjunk le semmilyen megalapozott következtetést a többis PSSR-es játékra, mivel a felskálázási megvalósítások minősége játékról játékra változhat.

- valamint hogy a PSSR egy játék alapján sokkal jobbnak tűnik mint az FSR3

És amit még kihangsúlyoztak, hogy az összehasonlítás eléggé problémás:

- a PS5 Pro-t a PC-vel, közelítő minőségi beállítások alapján lehetetlen teljesen egyező eredményt elérni.

- a Rift Apart dinamikus felbontás-skálázást használ, és a PC-s megvalósítás nagyon-nagyon különböző, így minden a tesztképek pixelezését egyenként kellett megoldani.

- ezen túlmenően, bár megpróbálták kikapcsolni a mozgási elmosódást a PS5 Pro-n a tisztább kép érdekében, ez csak az effekt intenzitását csökkenti, így ezt is hozzá kellett igazítani a PC-s képkockákhoz.

- valamint az Nvidia DLSS-sel való összehasonlításnak talán kevesebb gyakorlati haszna van, mivel az FSR 3.1-től eltérően soha nem fogunk látni Sony konzolon ilyen felskálázási technológiát. -

Abu85

HÁZIGAZDA

válasz

paprobert

#66168

üzenetére

paprobert

#66168

üzenetére

Nem is az asztali piac miatt nyomatják a perf/wattot, hanem a mobil piac miatt, mert az mostanra nagyobb lett az asztali piacnál. És ott már számít a jobb eredmény. Döntő fontosságú egy gyártó választásánál.

Az a baj, hogy olyan lehetetlen árakban gondolkodtok, amiket senkitől nem fogtok kapni. Ma a VGA luxuscikk lett luxus árazással. Ehhez igazodik mindenki. Az AMD is. És nem különösebben érdekli, hogy valaki nem tudja megfizetni, mert akkor olcsó konzolra menekül, amiben szintén AMD van.

-

Busterftw

nagyúr

válasz

paprobert

#65700

üzenetére

paprobert

#65700

üzenetére

En is emlekszem, teljesen pozitivnak tartottam a kulon consumer vonalat, en azt gondoltam akkor ezerrel fokuszalnak a gaming piacra ezekkel a megoldasokkal.

Aztan a valosagban meg az latszott, hogy egyre es egyre kevesebb eroforrast tettek bele.

1-2-3 eves csuszassal jonnek az "Nvidia-copy" megoldasok es azok sem tul jol implementalva.Talan az egyesitett arch sporol nekik annyit, hogy marad tobb eroforras a consumer piacra a "we love gamers" szlogenen tul.

-

Yutani

nagyúr

válasz

paprobert

#65700

üzenetére

paprobert

#65700

üzenetére

Szerintem pozitív volt a szétválasztás fogadtatása, mert így lehetett optimalizálni a konzumer GPU-t, de hát nem ad el annyit az AMD, hogy megérje külön kezelni. Sőt, ha belegondolunk, hogy 10-15%-os piaci részesedésnél döntöttek úgy, hogy szétválasztják, amíg az NV 85-90%-os résszel egyben tartja, utólag nem tűnik jó megoldásnak, és hát el is hagyják ezt az utat.

#65699 fLeSs: Hiányzik a munkásságod itt a PH-n és köszönöm a véleményed megosztását!

-

Yutani

nagyúr

válasz

paprobert

#65694

üzenetére

paprobert

#65694

üzenetére

Emlékszem, a GCN-nek is azért volt magasabb a fajlagos fogyasztása, mert olyan egységeket cipelt a GPU-ban, ami gaminghez nem volt használható, de ott volt és többlet fogyasztást okozott. Legalábbis ez volt mondva.

Miközben az Nvidia saját "UDNA" stratégiával hosszú évek óta jó teljesítményben és fogyasztásban, ugyanaz az uarch megy konzumerbe és professzionálisba. Hogyhogy nekik sikerül?

-

proci985

MODERÁTOR

válasz

paprobert

#65689

üzenetére

paprobert

#65689

üzenetére

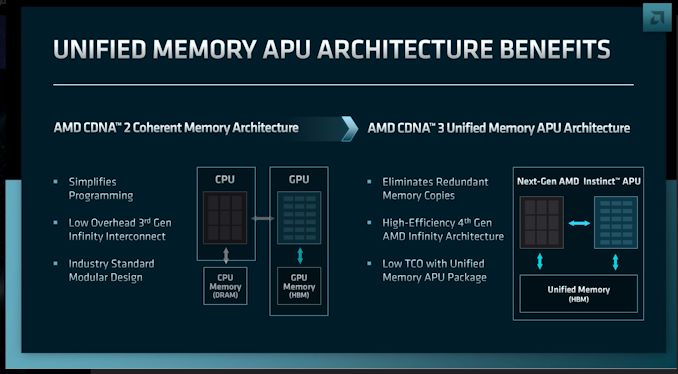

az a hatekonysag addig jatszik, ameddig nem kell RT, pl 7700XT raszterben 4060TInel jobb.

ez a 7900XT/Xnel viszont kb azt jelenti, hogy RT nelkul lazan bir a kartya 7680x1440et, RT alatt meg kb 3090/TI szintu teljesitmenyt tud. nem az FP64 a jelenlegi kartyak gyengeje.

-

S_x96x_S

addikt

válasz

paprobert

#65689

üzenetére

paprobert

#65689

üzenetére

> Az első gondolatom az, hogy az egyesítés a gaming-nek nagy eséllyel ártani fog.

az egységes UDNA-GPU chipletek nagy tömegű gyártása

és alacsony költsége sok mindenre gyógyír lehet.Én hasonló cloud-to-client strategy t képzelek el mint a ZEN5 -nél.

lesz mindenféle alváltozat belőle. [ "C" , "X3D", full-avx-512 és normál-avx-512 , ..]És itt szerintem a fejlesztések iterációs sebessége

és a méretgazdaságosság a legfontosabb> Pont azokat a dizájn shortcut-okat nem lehet majd megtenni,

> ami a gaming-re hegyezett GPU-ban a hatékonyságot hozta.másképpen érik el a hatékonyságot.

<szerintem/spekuláció on>

valamilyen Xilinx -es paraméterezhető AI turpisság is lehet mögötte,

vagyis gaming -re és AI/ML feladatokra is alkalmas hw.

Minden is mátrix ...Az nvidiánál például az AI és a CUDA + Tensor magok elég rugalmasak - és használva is vannak egyes funkcióknál,

<szerintem/spekuláció off>

-

Abu85

HÁZIGAZDA

válasz

paprobert

#65605

üzenetére

paprobert

#65605

üzenetére

Az alaparchitektúra sosem változott a köztes frissítéseknél. Tehát a PS4 például jött egy egyedi GCN-nel, és ugyanaz az egyedi GCN volt az alapja a PS4 Pro verziónak is.

Most az teljesen mindegy, hogy a média azt mondta, hogy váltás történt, valójában nem történt. Ha mondjuk a PS4 Pro a GCN2-ről átállt volna GCN4-re, akkor semmi sem lett volna rajta futtatható, amit korábban kiadtak. Ezt a Sony egy ideig próbálta is megmagyarázni a médiának, hogy baromságokat írnak, amikor GCN4-ről cikkeznek a PS4 Pro kapcsán, de nem sikerült, a média inkább írta tovább a baromságait. Pedig a japánok nagyon szépen levezették, hogy ez meg az az utasítás hiányzik a GCN4-ből, de nem érdekelte a médiát, továbbra is azt mondták, hogy a PS4 Pro az GCN4.

-

hahakocka

őstag

válasz

paprobert

#65452

üzenetére

paprobert

#65452

üzenetére

Mindenki azt vesz amit akar s, amire pénze van ennyire egyszerű. Én a vram és ár érték kérdését feszegettem amiben nem értettem és nem értek egyet azokkal akik szerint nem ér semmit a vram többlet vagy hogy nem lenne jobb ár értékű az Nvidianal. (RT t levéve). RT ha valakinek kell akkor tuti úgyis RTX kártyát vesz. De sokan úgy vesznek hogy odaírja neki nem is kell, nem érdekli. Akkor viszont nincs sok értelme sokkal többet fizetni.

Az AMD ahogy minden cég a profitra megy. NV még jobban. S az AMD elég nagy bevételi és részesedési hátrányban van csoda hogy ha életben is akarna maradni picit, de közben azért olcsóbban adja szépen mint az NV. S mellete ott a Ryzen procik sora, a konzolok, amikből szintén van bevétele is de szintén költség is mindig mint befektetés per új gen. -

hahakocka

őstag

válasz

paprobert

#65448

üzenetére

paprobert

#65448

üzenetére

Trollokat nem az biztos. A vram témát tolja rég óta a kedves fórumozó. Szerinte semmi előnyt nem ad az AMD nek a sok vram... Tesztek, tapasztalatok, 0.1-1% low 10-20 fps es szaggatások jelzik, hogy bezony a 8-12 gb ma már nem optimális. Ahogy a TPU teszt is ezt összegzi a végén is. 12 gb a min. 16 gb az optimális. AMD olcsóbban adta és adja most is sokkal NV konkurenseihez mérten ár értékben a kártyákat. Pl a 200e ft FXF-Sapphire árak 3 ventis változatok 7800xt-ből. Ezen a kettőn rúgóztok. Vram s ár. Pedig ezek tények. Ahogy az is hogy jelenleg NV jobb RT-re. Persze mindig lehetne olcsóbban adni a VGA-t, de pont az AMD van 12% os részesedéssel eléggé hátrányban. Míg az NV élen nagy főlénnyel és csak drágán adja azokat a kártyákat mindig. Míg AMD olcsóbb 30-40 e ft okkal, a 4080 vs 7900xtx 4080 esetén 60-80e ft val a több vram ellenére pedig a +8gb vram drágább is értelemszerűen. NV oldalon persze ott a CUDA-RT magok is.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#65013

üzenetére

paprobert

#65013

üzenetére

A DXR a programozhatóság felé halad, ahogy a DirectX 7 után a T&L. A DirectX 8-tól el is tünt a hardveres T&L részegység a hardverekből, mert a programozahatóság a specifikus gyorsító ellen van. Itt pont arra megyünk, hogy egyre kevesebb részfeladat lesz gyorsítva. Ellenben egyre több ALU lesz erre szabva.

-

sb

veterán

válasz

paprobert

#64984

üzenetére

paprobert

#64984

üzenetére

A váltás viszont mindig extra költség.

- Akkor is ha a meglévő rendszer teljesen kompatibilis módon cserélhető.

- Akkor még nagyobb, ha nem csak kihúzod/bedugod szintű a csere.

- Ha pedig konkrétan valamilyen platformra és sw környezetre vagy úgy bedrótozva, hogy nem is igazán megoldható a váltás (gyk. újra kell írni ezt-azt) akkor brutális költség lehet.Szóval bárhogy is nézem, eleve extra költséggel indul ha az egyik irányba elköteleződsz.

Ez azt jelenti, hogy mindig mínuszból indul az a versenyző aki át akar venni valamit.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#64393

üzenetére

paprobert

#64393

üzenetére

A programozhatóság a LOD-hoz kell, hogy ne kelljen betölteni az összes jelenetben szereplő modellt, max részletességen. Eléggé kívánatos, hiszen pont ezért zabálja a memóriát az RT, és pont ezért nem igazán látod az UE5-ben reklámozva ezt, mert annyira nagy a részletesség, hogy egyszerűen nincs a VGA-kon elég memória hozzá.

Például az Avatar pont azért választott szándékosan programozható RT-t, mert ők is beleütköztek volna ebbe a problémába. Az Ubisoft nem is alkalmaz a saját pipeline-ján klasszikus brute force megvalósítást. Hiába vannak ott a hardverben az bejárás gyorsítására való részegységek, hozzá sem nyúlnak. Tehát jelen pillanatban a programozhatóság hiánya már most is limitál, annyira, hogy már compute shaderben kell írni alternatívákat hozzá.

-

-

válasz

paprobert

#64131

üzenetére

paprobert

#64131

üzenetére

ÉSzek után őszintén bocsánatot kell kérnem [S_x96x_S] -től amiért számonkértem ezek miatt a hírek miatt , nem gondoltam volna hogy ekkora a gond valóban.

nagyon gáz ez és úgy látom hogy elég erősen kipattant most ez a dolog,a Tinycorp által indítva. Remélem valóban tesznek is ezek után az AMD nél valamit.Petykemano: "Az nvidiáról pedig helyzeténél (erőforrás) fogva pont el tudnám képzelni ilyen hálózat üzemeltetését."

ne már. Jön a szokásos hogy ez is az Nvidia ármánykodása? itt is leírták többen hogy propléma van a neten is egyre jobban kibukik ez a dolog. Az AMD bevételileg már egy giga cég óriási jövedelemmel ezt helyre kellene tenniük.

Jön a szokásos hogy ez is az Nvidia ármánykodása? itt is leírták többen hogy propléma van a neten is egyre jobban kibukik ez a dolog. Az AMD bevételileg már egy giga cég óriási jövedelemmel ezt helyre kellene tenniük. -

PuMbA

titán

válasz

paprobert

#64133

üzenetére

paprobert

#64133

üzenetére

Pont jókor kattintottam ide

Igen, de csak a géming az több helyen kevés. Többet ér egy kártya, ha azon kívül bármire nyugodt szívvel használhatod. Például a streaming világban nem véletlenül csak NVIDIA van.

Igen, de csak a géming az több helyen kevés. Többet ér egy kártya, ha azon kívül bármire nyugodt szívvel használhatod. Például a streaming világban nem véletlenül csak NVIDIA van.Az AMD szoftveres megújulására itt az idő, már mutatkoznak jelek, hogy egyes területeken végre belehúztak. Hajrá! Én a finom és ropogós FSR 3.1-et várom nagyon

-

PuMbA

titán

válasz

paprobert

#64131

üzenetére

paprobert

#64131

üzenetére

Legjobb komment:

"They couldn't care less. We've had issues with AMD drivers in a video production house where we ran Vega GPUs under Linux for DaVinci Resolve editing on the desktops and for rendering on the farm.

Those were the worst years of my life where I had to support the investment that failed as soon as the decision to go with AMD was made.

It costed our company the weight of those cards in solid gold.

After years of battling AMD and failing, I made an ultimatum to our ceo and told him directly that I didn't want to support this anymore and that I'd leave if we didn't switch everything to Nvidia and I actually quit the company over this because the response was that it was impossible. 2 months later they sold all the AMD hardware at a fraction of the original price and managed to take a credit to switch everything to NVIDIA.Somebody else even made a huge post here and on r/linux, phoronix covered it slightly and AMD went into full panic mode, their developer advocate came here and on AMD forums and in emails and made many grand promises. Here we are almost 10 years later, same issues still exist.

Oh yeah, and BlackMagic (DaVinci Resolve maker) today officially doesn't support their software on any AMD hardware. Thousands of editors, graders and admins go on forums and ask about AMD only to just get directed to Nvidia by the BlackMagic staff.

Great job AMD! You don't deserve a single customer..."

Amúgy tök jó, hogy végre a neten az emberek kikerülnek az AMD "varázsa" alól

Jajj milyen jó fejek, rendesek, elolvadok, ópen-szósz, NVIDIA rósz, AMD überjó....1-2 éve ez folyt a csapból is. Végre kezd a jónép visszatérni a realitásba, most már ez nincs. Nem véletlenül olcsóbbak az AMD VGA-k, nem véletlenül vesznek az emberek NVIDIA-t még akkor se, ha az AMD több VRAM-ot ad.....semmi sem véletlen.

Jajj milyen jó fejek, rendesek, elolvadok, ópen-szósz, NVIDIA rósz, AMD überjó....1-2 éve ez folyt a csapból is. Végre kezd a jónép visszatérni a realitásba, most már ez nincs. Nem véletlenül olcsóbbak az AMD VGA-k, nem véletlenül vesznek az emberek NVIDIA-t még akkor se, ha az AMD több VRAM-ot ad.....semmi sem véletlen. -

Raggie

őstag

válasz

paprobert

#64096

üzenetére

paprobert

#64096

üzenetére

Én nem értek a témához, de azért gyanítom, hogy az Nvidia kártyán futtatott kód merőben más, mint az AMD kártyán futtatni próbált. Mivel a két gyártó kártyáinak felépítése is merőben más.

Ezt csak azért írtam, mert ha ez így van, akkor az nem érv, hogy a másik gyártó kártyáján lefut a kódja és az AMD-n nem. Mert más kód fut. Ettől még ugyan úgy lehet a hiba az Ő kódjában, nem csak az AMD driverben/firmware-ben/hardverben.

Nem azt mondom, hogy ez így is van, csak azt hogy ez az állítás nem bizonyít semmit("Nvidián lefut AMD-n nem"). -

Petykemano

veterán

válasz

paprobert

#64092

üzenetére

paprobert

#64092

üzenetére

Szerintem sem kedvtelésből csinálta - az volt a terv, hogy olcsó kártyákkal robbant bankot.

Én nem ástam bele magam annak részleteibe, hogy milyen standard API hívás eredményezett hibát.

Szerinted olyan általános felhasználás során is felbukkanó hibáról van szó, ami más esetekben is komoly hátrányt eredményez? (Geohot rátapintott volna az RDNA3 hardverhibájára, amit firmware-re igyekszik az AMD elrejteni?)

Vagy a kártya csak ott és úgy hasal el, ahogy Geohot akarná használni?Akárhogy is van ez, majd biztosan felvilágosítasz, én óva inteném az amdt, hogy megnyissa, vagy titoktartási nélkül bepillantást adjon. A fejlesztők (és villanyszerelők) első reakciója az ismeretlen, elképzeléseiktől távol eső, esetleg örökletes terheket hordozó munkára adott első reakciója.mindig az, hogy az vállalhatatlan, érthetetlen, gány meló, és inkább újra kéne írni az egészet. Nem hiszem, hogy az AMDnek hasznára válna egy újabb lejárató hadjárat,.ami csak tovább fokozná az - bizonyos szempontból megalapozott - negatív megítélést.

Abban pedig akkor megegyeztünk, hogy nem értünk egyet abban, hogy az AMD-nek hasznos-e a negatív hírverés.

-

Petykemano

veterán

válasz

paprobert

#64090

üzenetére

paprobert

#64090

üzenetére

*Kimondja hogy műthetetlen vagy, mert páciensként nem vetted be az előírt előkészítő gyógyszereket. (mulasztás)

Fú, hát szerintem érdekes a driver forrásának megnyitását egy gyógyszerbevételhez hasonlítani. Nekem inkább tűnik ahhoz hasonlatosnak, hogy csak akkor válasz műthetővé - talán - ha nyilvánosságra hozod (tehát nem átadot a téged meggyógyítani kíváni orvosnak bizalmasan, hanem mindenki számára hozzáférhetővé teszed és ismertségedből fakadóan fel is hívod mindenki figyelmét rá) a komplett orvosi anyagaidat onnantól, hogy megszülettél és elvágták a köldökzsinórt, hogy mikor milyen nemi betegségekkel kezeltek odaáig, hogy van-e jelenleg valamilyen lappangó, vagy tartós betegséged.Tessék bevenni őket, ami pénzbe kerül.

Nem tudom, hogy az AMD tett-e valamilyen ajánlatot ennek a jóembernek. De ismerve a hozzáállását és karakterét, nekem nem tűnik valószínűnek, hogy azt ambícionálná, hogy normál fejlesztői fizetésért - egy kisebb teammel - kijavíthatja az általa problémásnak talált dolgokat. Nekem úgy tűnik, nem azért indította a projektjét, hogy biztos munkát találjon vele, hanem annál jobban szeret szuverén módon megmondóemberkedni és/vagy az sem kizárt, hogy az évi mondjuk egymillió dolláros fizetésnél többet remél a startupjától.

Azt egyébként tudja valaki, hogy amiket kért, azt egyébként pikk-pakk meg tudná oldani az AMD, vagy hónapokig tartana átalakítani a szoftver működését?

Én egyébként nem mondtam hogy amiket mond, abban nincs igaza, vagy hogy ez ne lehetne sürgősen pótolandó mulasztás az AMD részéről, csak azt, hogy ha a legártatlanabb szándék vezérelné is, talán akkor is inkább árt a tevékenysége. De miközben úgy tünteti fel magát, mintha az AMD-nek, meg a közösségnek igyekezne hasznára lenni, valójában neki tulajdonképpen üzleti érdeke fűződik ahhoz, hogy közéleti befolyásával (vissza)élve hírnévrontással való fenyegetéssel zsaroljon ki az AMD-ből neki kedvező módosításokat.

-

Petykemano

veterán

-

S_x96x_S

addikt

válasz

paprobert

#64008

üzenetére

paprobert

#64008

üzenetére

mindenki követi a "saga" -t..

De vajon Lisa Su mit fog erre reagálni? is sikerül-e megint menteni ..még Andrej Karpathy -is twittelt ezzel kapcsolatban.. és szerintem biztatóan .. és róla nem lehet azt állítani, hogy "vak" ...

"Follow along the @__tinygrad__ saga, who are (very publicly!) trying to build your commodity ~petaflop compute node.

tinybox specs: https://tinygrad.org

the youtube videos form @realGeorgeHotz are actually quite great

and entertaining, featuring the signature blend of technology

and philosophy and ???:

https://www.youtube.com/@geohotarchive/videos

if you dig deep enough you'll also find excellent rap."

( via https://twitter.com/karpathy/status/1770164518758633590 )és aki merész belehallgathat a rappekbe -is-.

https://www.youtube.com/watch?v=7KofDgOEji0

https://www.youtube.com/watch?v=UxxrhAhdPsc

https://www.youtube.com/watch?v=C4XmFOglBxo -

Raymond

titán

válasz

paprobert

#64008

üzenetére

paprobert

#64008

üzenetére

Uhhh...kemeny az a szekunderszegyen amit azok a blogbejegyzesek olvasasa kozben kap az ember. Annyira atlatszo az amit csinal az hihetelen. Egy kis tapasztalattal a hata mogott a vak is latja mi a helyzet. Az igazi kedvencem a "Someday, we are going to make our own chips" resz

Ja, persze! Majd eloszor eld tul a kovetkezo 1-2 negyedevet ha sikerul talanod meg par bolondot aki a link alatt olvashato szindarabnak bedol es kapsz penzt

Ja, persze! Majd eloszor eld tul a kovetkezo 1-2 negyedevet ha sikerul talanod meg par bolondot aki a link alatt olvashato szindarabnak bedol es kapsz penzt

-

Busterftw

nagyúr

válasz

paprobert

#64008

üzenetére

paprobert

#64008

üzenetére

Par komment eleg szarul oregedett a topikban ezzel kapcsolatban.

Intelhez erdekesseg:

"We are putting resources into Intel now. multiGPU training worked out of the box, and haven't seen a lick of driver instability. The A770 card is currently slow though, we need to add XMX support ($400 bounty added)" -

PuMbA

titán

válasz

paprobert

#64008

üzenetére

paprobert

#64008

üzenetére

Hát igen. Véletlenek nincsenek. Nem véletlenül van az NVIDIA ott ahol a betonbiztos szoftveres körítésével

Az AMD-nek szoftveresen még sokat kell fejlődnie, ezt folytathatják azzal, hogy az RDNA4 indulásra összepakolnak egy rendes drivert, az RDNA3-mal ellentétben. Az év második felében az Intel Battlemage izgi lesz látva milyen tempóban javulnak a drivereik.

Az AMD-nek szoftveresen még sokat kell fejlődnie, ezt folytathatják azzal, hogy az RDNA4 indulásra összepakolnak egy rendes drivert, az RDNA3-mal ellentétben. Az év második felében az Intel Battlemage izgi lesz látva milyen tempóban javulnak a drivereik. -

Abu85

HÁZIGAZDA

válasz

paprobert

#63928

üzenetére

paprobert

#63928

üzenetére

Minden megvan a teljesen generatív felskálázáshoz, egyedül az a gond, hogy a GPU-kon egy ilyen pipeline nem jó, mert eszi a VRAM-ot és a regisztert. Tehát szükség lenne arra, hogy a GPU-kon legalább kétszer több regiszterfájl lenne, illetve +10 GB VRAM. Amúgy hardverileg jó volna akármelyik mai GPU.

Viszont +10 GB VRAM és kétszeres regiszterterület annyira sok extra, hogy az vállalhatatlan, és emiatt a generatív megoldások inkább a DSP-szerű hardvereken fognak először megjelenni, amelyek ugyan erőben nem GPU-k, de kellően sok számítási kapacitás van bennük, hogy megoldják a problémát, és még nem is lassítják le a picsába a képkockaszámítást.

Ez az összes AI feladatra vonatkozik. A GPU-kon ezek azért nem terjedtek el, mert irtó memória intenzívek. Egy életképesebb AI feladat 10 GB terhelésnél kezdődik, aztán sok szerencsét lefuttatni a 8 GB-os VGA-kon. Igazából semmi extra nem kell az AI-nak, leszámítva a memóriát, azt eszi két pofára.

#63927 smc : Az FSR, a DLSS és az XeSS ugyanolyan analitikai megoldás. Konkrétan ugyanúgy állítják elő a valós képi tartalmat. Csak akkor ugorja át az egyik a másikat, ha megváltoztatja a tartalomgenerálás analitikai jellegét.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#63925

üzenetére

paprobert

#63925

üzenetére

Másképp nem tud működni ez. Többször volt már szó róla, hogy a mostani hardverekkel az a gond, hogy hiába van bennük külön ALU kvázi AI-ra, ha ugyanazokból a regiszterekből esznek, amiket a fő ALU-k. Tehát ha elkezded ezeket a kisebb ALU-kat használni, akkor romlik a GPU occupancy, amivel romlik az elérési idő átlapolása. Emiatt van az, hogy nem generálnak tartalmat a mostani felskálázók, mint a DLSS, XeSS, FSR. Pusztán analitikai megoldások. Egyedül az előzményminták felhasználásában alkalmaznak AI-t, de az meg a teljes procedúra kb. 5%-a, tehát igencsak kevés számítás, ráadásul nem generált tartalom.

Amiért a valós AI tartalomgeneráláshoz másik AI hardver kell, hogy ne csökkenjen ettől a feladattól a GPU occupancy, és emiatt kell ezt kivinni egy dedikált részegységre, ami nem ugyanazokat a regisztereket terheli le, amikbe a shadereket tölti be a GPU.

-

válasz

paprobert

#63777

üzenetére

paprobert

#63777

üzenetére

Engedd el, tragédia, fogalmam sincs kinek csinálják ezeket. Már egy kis józan paraszti ésszel is ennél résznél kikpacsoltatod az áramot és elmész jurtába lakni.

Azt mondja az Nvidiának semmi nincs a kezében, csak az 5090 az év végén... amúgy egy 4080-4070 Ti super -4080 Ti nincs is a kezében rettegnek a 7900XT és XTX közé érkező kártyától ami ugyan ott készül, ugyan olyan eljárással ugyan azona csíkszélen...Mint ha a marson lennénk.

Az árra a legkönnyebb reagálni, aki dolgozik a vesenyszférában az nagyon jól tudja ezt.. -

S_x96x_S

addikt

válasz

paprobert

#63724

üzenetére

paprobert

#63724

üzenetére

> *ha igaz a monoltikusságra való visszaváltás

A jó válaszhoz meg kellene várni az RDNA5-öt ..

De amúgy az Instinct gyorsítók alapján én nem hiszem,

hogy az AMD feladta volna a chipletes GPU terveit.

A felső kategória tisztán chipletes lesz ..

Az AMD nagyon hisz a chipletben,

A Ryzen kliens processzorok építésénél,

egy 16 magos Ryzen chip, mint például a Ryzen 9 5950X, monolitikus 7 nm-es chippel való építése 2,1-szer többe került volna, mint a chiplet-alapú megközelítés.és ha kiforrja magát, akkor a termékfejlesztés is sokkal gyorsabb lesz ( és az idő = pénz )

CDNA3 + MI300 -nél a chiplet láthatóan működik.

az RDNA -nál még nem.Vagyis én nem temetném

-

Alogonomus

őstag

válasz

paprobert

#63722

üzenetére

paprobert

#63722

üzenetére

Nem olvastad el alaposan a válaszomat. Egyértelműen utaltam rá, hogy az RDNA 3 chiplete biztosan sokkal komplexebb megoldást képviselhet, mint ami a Zen 4-hez szükséges.

Ian számítását csak a te 15 dolláros becslésed helyesbítéseként linkeltem, vagyis hogy a Zen 4-et alkotó chipek egységes processzorrá összeszerelése is kijön nagyjából a becsült 15 dollárod feléből.

-

Alogonomus

őstag

válasz

paprobert

#63693

üzenetére

paprobert

#63693

üzenetére

"A te elméletedben mennyibe kerül a chipletezés?

Megjegyzésképp, a Zen CPU-knál manapság már csak 15 dollár. Extra komplexitással itt valamivel több kell hogy legyen."Még a különböző generációs Zen CPU-k chipletével szembeni elvárások is különböztek, így nyilván a költségük is. Az RDNA 3 GPU-k chipletének a képességei pedig a Zen 4-es chiplethez képest akár akkora további ugrást is jelenthetnek, amekkorát aztán az RDNA 3-hoz képest az MI 300 "chiplet" képvisel.

Egyébként az egyik legerősebb Zen 4-es CPU-ra "készült" egy valamenynire szakmabeli általi árbecslés, és ott a CCD-k és az IOD CPU-vá összeállítására, vagyis "chipletesítésére" mondott egy nagyjából 7,5 dollárt.

-

S_x96x_S

addikt

válasz

paprobert

#63630

üzenetére

paprobert

#63630

üzenetére

(RDNA 4 Gaming)

Ezek csak a "látható" szoftveres változtatások, amelyek az LLVM kódgeneráláshoz kellenek,

De ami kihathat a gaming performanciára:

- sok apró finomítás ( memóriakezelés, cachelés , prefetch) javítása

- jobb tensoros támogatás a DLSS szerű skálázáshoz.legalábbis én ezeket olvasom ki a cikkből.

-

-

PuMbA

titán

válasz

paprobert

#63400

üzenetére

paprobert

#63400

üzenetére

Főként idővel. A most vagy 2024-ben megjelenő címekben érkeznek oda a programozók, hogy teljesen kihasználják a konzolok lehetőségeit

Ez minden konzol generációnál így van.

Ez minden konzol generációnál így van.A Ratchet & Clank-nél is néztünk, hogy ez hogy lehetséges, aztán PC-re ugyanúgy megoldották jó gépigénnyel. Elvileg tavasszal jön a Spider-Man 2 PC-re, ott megint lehet csekkolni a helyzetet. A GTA VI-ot is szinte biztos vagyok benne, hogy konzol beállításokkal játszhatod PC-n 3 év múlva egy akkor már ősréginek számító 6700XT-vel, ami kicsit gyorsabb, mint a sima a 6700.

-

Alogonomus

őstag

válasz

paprobert

#63396

üzenetére

paprobert

#63396

üzenetére

A 7800 XT egyáltalán nem népkártya, de már a 4070 sem az.

A 6600 a 1080 Ti és 2070 társaságában képviseli nagyjából a népkártya kategória alját, míg a 7600 és 4060 jelenti a népkártyák felső határát.

A 1060 teljesítménye is messze elmaradt az akkori aktuális (PS4 Pro) konzol teljesítményétől. Valóban ez is egy jó meghatározási mód lehet a népkártya kategória behatárolásához.

Eleve el kellene fogadni, hogy egy népkártya nem a legújabb technológiák igényeihez készült, vagyis jelenleg a ray tracing és path tracing bekapcsolása nem reális opció egy népkártya esetén. Technikailag képesek lehetnek rá, de élvezhető sebességgel nem tudják futtatni, ahogy a 1060 is képes volt anno QHD és UHD felbontásra is, csak úgy már a kialakuló eredmény nem volt elfogadható.

Amennyiben a népkártyák a 6700 XT és 7800 XT közötti teljesítményt jelentenék, akkor már egy 2080 Super, vagy a 7600 és 4060 is a "futottak még" kategóriát képviselnék a 3060 társaságában. Nyilván mindenki minél olcsón minél jobbat szeretne, és ebben nagyon elkényeztet minket a CPU-k piaca, amit sokan a videokártyák kapcsán is örömmel látnának.

-

PuMbA

titán

válasz

paprobert

#63396

üzenetére

paprobert

#63396

üzenetére

Cyberpunk 2077: PC Benchmarks Running on PS5 and Xbox Series X - So What Do They Do?

A konzolok teljesítményét tökéletesen lehet replikálni egy kicsit alulfrekvenciált 6700 10GB-tal, ami a legközelebb van specifikációkban

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét.

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét. -

jimpo

senior tag

válasz

paprobert

#63396

üzenetére

paprobert

#63396

üzenetére

" Műszakilag a népkártya minimuma a 6700XT-nél kezdődik és a 7800XT-vel záródik. Egy ilyen kártya elviszi nagyon hasonló, vagy kicsivel magasabb szinten a modern címeket, mint a minőségnek az alsó határát jelentő konzolok. "

Ja csak konzolra a fejlesztők dolga egyszerűbb, PC fronton sok a változó. Már ha csak a CPU - GPU párost is nézzük, de még a memória is fontos. Az optimalizációt meg hagyjuk... Azt szintén hogy konzolok esetében sem minden natív felbontáson fut, vagy inkább semmi nem. Tehát, népkártya esetén a felbontás legalább annyira fontos "mint a minőségnek az alsó határát jelentő konzolok." felbontása. Amik címenként és gameplay közben is nagyon eltérőek, illetve folyton változhatnak.

Tehát akkor most milyen "magasabb szinten" is futnak a konzolokon a játékok

Azt leszámítva hogy kevésbé, vagy egyáltalán nem röccen ha jól van optimalizálva rá. Megnéznék pár címet hogy futna konzolon fix natív felbontással, ja ez nem így működik...

Bár engem pont nem érdekel, mert nem játszok minden friss címmel.

Népkártya ide, vagy oda, 1080p 144Hz 7800XT, bár inkább multizom.

Népkártya ide, vagy oda, 1080p 144Hz 7800XT, bár inkább multizom.  Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

Még a kártya mellé kapott Starfield sem kapott játékidőt, konkrétan a menüig merészkedtem a kártya/játék megjelenése óta. De legalább ha minden igaz fényévekkel jobban futna, hála a patcheknek.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

PuMbA

titán

válasz

paprobert

#63276

üzenetére

paprobert

#63276

üzenetére

Jaja, bár az UI gondok azért még megoldandó feladat. Az idle fogyasztást is orvosolták: AMD RX 7000-series' high idle power draw finally appears to be fixed with the latest 23.12.1 drivers

Micsoda év befejezés, AMD is on a roll.

-

Petykemano

veterán

válasz

paprobert

#63054

üzenetére

paprobert

#63054

üzenetére

> Ha ehhez most hozzányúltak(nem hiszem), akkor lehet meglepetés.

> De ha csak egy nagyobb engine-t építettek ugyanezekből a LEGO kockákból,

> azaz csak felskáláztak, akkor nem fogja megváltani a világot.

Én se gondolnám, hogy megváltották a világot.

A teljesítmény-fogyasztási görbe alapján azt gondolnám, hogy az AMD a SDXE IGP teljesítményét (görbéjét) kb 24CU-val tudná hozni. (a Phoenixben található 12 helyett)Kérdés, hogy a Qualcomm ezt a teljesítmény mekkora lapkaméretből hozza és az AMD ilyen irányú bővítése nem jelentene-e túl (gazdaságtalanul) nagy lapkát.

Elvileg a Strix család 16CU és 40CU lesz.

-

Petykemano

veterán

válasz

paprobert

#63051

üzenetére

paprobert

#63051

üzenetére

Ismert volt előttem az adreno származása, de azt megmondom őszintén, hogy nem tudom, hogy a Qualcomm mennyiben fejleszti. Az adreno, Mali, és az Imagination architektúrai talán valamivel kevésbé tárgyaltak. Mindazonáltal a telefonok bemutatóiban etekintetben is folyamatos fejlődésről adnak számot.

Lehetséges, hogy nem csak a CPU-kra, hanem a GPU-kra is érvényes, hogy nem biztos, hogy létezik "one size fits all", vagyis hogy ugyanaz az architektúra, amivel kiszolgálnak egy 300W-os kártyát, a 15W-20-os kereten belül is a legmagasabb hatásfokú megoldás lesz. (Miközben persze lehet, hogy adreno-ból se lesz 300W-os kárty)

Az igaz, hogy az IGP teljesítménye nem volt sose meghatározó szempont a notebookok eladásában, Viszont az AMD-t több kézikonzolban használják jelenleg, ahol meg pont ez az egyik legfontosabb szempont.

-

PuMbA

titán

válasz

paprobert

#63004

üzenetére

paprobert

#63004

üzenetére

Nagyon úgy tűnik, hogy az AMD a ludas

Azt én se értem, hogy hogy siklottak el afelett, hogy a Valve-től megkérdezték volna, hogy figyelj, ha megkerüljük a játékmotorod egy részét, azt nem fogja az anti-cheat érzékelni? Ha viszont a Valve adott rossz választ nekik, csak abban az esetben a Valve a ludas. De ez sosem fog kiderülni.

Azt én se értem, hogy hogy siklottak el afelett, hogy a Valve-től megkérdezték volna, hogy figyelj, ha megkerüljük a játékmotorod egy részét, azt nem fogja az anti-cheat érzékelni? Ha viszont a Valve adott rossz választ nekik, csak abban az esetben a Valve a ludas. De ez sosem fog kiderülni. -

hokuszpk

nagyúr

-

GhanBuri Ghan

őstag

válasz

paprobert

#62696

üzenetére

paprobert

#62696

üzenetére

Igen, grafikára. Ha a jelenlegi felépítés nem, a következőnek sok előnye lehetne belőle: kisebb lapkák, emiatt jobb helykihasználás a waferen, kisebb selejtarány, könnyebb skálázhatóság, viszont (ha jól értem, akkor) kellene egy IO egység a GCD-k és az MCD-k közé - bonyolultabb felépítés.

-

válasz

paprobert

#62580

üzenetére

paprobert

#62580

üzenetére

Én inkább arra hajlok hogy nem lehet úgy használni, ahogy a DLSS3.5 funkcióját .

Teljesen logikátlan az hogy nem akarják beletenni a szponzorált címekbe sem, főleg hogy nem igényel extra hardvert sem. Gondold végig. Szerinted ez lehetséges ?

Szerintem a kiindulási magyarázat is már sántít.

A 3.5 is vissza fele kompatibilis, egyszerűen a nem támogatott funkciók nem aktívak. -

PuMbA

titán

válasz

paprobert

#62580

üzenetére

paprobert

#62580

üzenetére

Kikényszerítésre a zárt kód a hatásosabb, nézd meg az Apple-t meg az iOS-t

Ez van, így működik, csinálod vagy nem csinálod. Én sok sok év Androidról váltottam iOS-re tavaly és elmondhatom, amit eddig is szoktam, hogy az open source-tól neked, mint felhasználónak nem lesz semmi jobb. Ez egy lényegtelen kérdés. A lényeg, hogy mit adnak neked a pénzedért.

Ez van, így működik, csinálod vagy nem csinálod. Én sok sok év Androidról váltottam iOS-re tavaly és elmondhatom, amit eddig is szoktam, hogy az open source-tól neked, mint felhasználónak nem lesz semmi jobb. Ez egy lényegtelen kérdés. A lényeg, hogy mit adnak neked a pénzedért. -

Abu85

HÁZIGAZDA

válasz

paprobert

#62576

üzenetére

paprobert

#62576

üzenetére

Egy eljárás részben azért szokott open source lenni, hogy a fejlesztő védve legyen. Vagyis az eljárás tulajdonosa nem tudja semmilyen módon rákényszeríteni az akaratát a fejlesztőkre, mert akkor is tudja használni az eljárást, ha a tulajdonosa valami olyat kér, ami összeegyeztethetetlen a piaci realítással. Ilyen formában nehéz erre szerződést kötni, mert azt fogja mondani a fejlesztő, hogy nem, és letöltik a kódot a GitHubról.

#62577 b. : Abból egy csomó cím FSR1-es, és ugye ez fontos szempont, mert azok azért alkalmaznak FSR1-et, mert hiányzik a mozgásvektor, így nem is tudnak alkalmazni temporális felskálázást. De az ilyen tényekkel ne törődj, mert még a véletlenül kompatibilitási problémák lépnek fel a nézeteddel.

A Blizzard pedig inkább azt akarta, hogy ne legyen ennek magas karbantartási költsége. Mert amúgy a játékosok már a low és high grafikában minőség és sebességkülönbséget kapnak, ugyan mit számítana egy alternatív felskálázás itt? Persze sokan beveszik, mert nem néznek utána annak, hogy két eljárás ugyanarra a problémára dupla költség, és hát akarja a fene ezt megfizetni, ha az egyik eljárás fut minden hardveren. A Blizzard persze eladhatja ezt úgy, hogy jót akarnak, de ugye tényleg kilóg a lóláb ott, hogy ha azonos feltételeket akarnak, akkor miért is lehet más effekteket paraméterezni? Ja, hogy más grafikai különbség nem számít? De érdekes...

-

válasz

paprobert

#62559

üzenetére

paprobert

#62559

üzenetére

Elolvastam az FSR csatolt dokumentumait de nekem ebből az nem jön le, hogy valós idejű denoiserként, iletve az helyett/ mellett lehet használni az FSR maszkolását viszont a vékony hálók és vonalak megfelelő megjelenítésére igen ,a mi viszont rohadt jó dolog lehetne.

Alan Wake demója erre is rámutat, ami eddig amúgy erős hiányosság volt a DLSS nél, ( és FSR nél is , érdekes módon az XeSS-nél ahogy néztem a tesztet annyira ez nem volt jellemző)főleg egy-egy villanyvezeték tudott viccesen kinézni, ezt most szépen megoldja a 3,5 meg ezek szerint az FSR 2.0 is tudná, még sem erőltetik.

Itt látható, 30 másodperctől: [link] -

Abu85

HÁZIGAZDA

válasz

paprobert

#62527

üzenetére

paprobert

#62527

üzenetére

Valószínűbb, hogy a minőség mindenhol nagyon hasonló lesz, a driveres modulok inkább jobb sebességet és alacsonyabb késleltetést adnak.

#62528 b. : A Ray Reconstruction az valójában egy tréning eredménye. Ott is ugyanazt csinálja a tensor, amit máskor: kombinálja a korábbi képkockáról származó előzménymintákat és normaladatokat az új képkocka felskálázásához. Ez tényleg a teljes feldolgozásnak egy nagyon elhanyagolható része. Annyira kevés, hogy a DP4a is megfelelne hozzá. Tényleg nem szükséges ehhez semmiféle célhardver, meg lehetne írni úgy is, hogy működjön nagyon régi hardvereken is.

-

S_x96x_S

addikt

válasz

paprobert

#62460

üzenetére

paprobert

#62460

üzenetére

> a "vegyél APU-t"

Elképzeltem az Tech híradót

... amint a bemondó lassan komótosan felvezeti a következő hírt:A gépek világában, ahol az erő és a teljesítmény uralkodik, az AMD 4600G és 5600G APU-k most feltámadnak a hamvaikból. Azok, akik valaha elhanyagolták őket, most visszatérnek, mint a kalandozók, akik elveszett kincseket keresnek. Miért? Mert 16GB VRAM az nem csak 16GB VRAM – ez egy új birodalom ajtaja, egy új lehetőség, ahol a digitális álmok valóra válhatnak. És most, ahogyan a vadászok és gyűjtők újra felfedezik ezeket a kincseket, mi mind együtt nézhetjük, ahogyan az új korszak hajnala köszönt ránk.

AMD Ryzen APU turned into a 16GB VRAM GPU and it can run Stable Diffusion

"The 4600G is currently selling at price of $95. It includes a 6-core CPU and 7-core GPU. 5600G is also inexpensive - around $130 with better CPU but the same GPU as 4600G.

It can be turned into a 16GB VRAM GPU under Linux and works similar to AMD discrete GPU such as 5700XT, 6700XT, .... It thus supports AMD software stack: ROCm. Thus it supports Pytorch, Tensorflow. You can run most of the AI applications.

16GB VRAM is also a big deal, as it beats most of discrete GPU. Even those GPU has better computing power, they will get out of memory errors if application requires 12 or more GB of VRAM. "a hír még a HackerNews-on is kapott 170 pontot ..

https://news.ycombinator.com/item?id=37162762 -

Petykemano

veterán

válasz

paprobert

#62460

üzenetére

paprobert

#62460

üzenetére

Bocsánat, de valakiknek,.valahová, valamilyen célra készítik a belépőszintű VGA-t, amit az APU lenne hivatott leváltani, tehát azzal nem lehet az apuk ellen érvelni, hogy erre a teljesítményszintre nincs valódi szükség.

Én valami olyasmit sejtek a hatalomátvétel okának, hogy amiket elmondtál, azok a desktopra érvényesek - valóban niche, mert vagy elegendő valami, ami képet meg tud jeleníteni, vagy többnyire inkább erősebb kell. Ezeknek a VGA-knak a célpiaca mobil (vagy SSF) lehet, ahol látszólag találkozik a chipgyártó árukapcsolás iránti célja, és a készülékgyártó kompakt kiszerelés (esetleg árkedvezmény) iránti igénye. De csak látszólag. Valójában a készülékgyártó nem szeretné az árukapcsolást és hajlandó vásárlóival némi többletet megfizettetni azért, hogy ő választhassa meg, mikor, kivel és mire szerződik. Másrészt valózsínűleg a kompaktság is csak papíron (desktopon) hangzik jól, egy notebookban megszokott és talán valóban kényelmesebb is két hőtermelő chipet egymástól távol, külön hűteni.

Persze ez csak tipp -

S_x96x_S

addikt

válasz

paprobert

#62227

üzenetére

paprobert

#62227

üzenetére

> Én két dologban látom, amiben megtört az RDNA felfelé ívelő pályája.

> 1. Az AMD nem tudott olyan ütemben CU számot növelni.~ Ez csak az RDNA3-ra igaz,

de jön az RDNA4 - ami már teljesen más lehet.

vagyis én nem általánosítanék még ebből.másrészt ..

Az MI300 + CDNA3 -al a CU skálázódás megoldódott. ( MI300X = 304 GPU CUs )

és ha az RDNA4 is "rendes" Unified Memory -t kap mint a CDNA3,

akkor szabadon kombinálhatja az Amd a CDNA3-at és az RDNA4- ket.

Szerintem elég erős "általános" GPU-t lehetne összerakni:

- 1x RDNA4 chiplet + 3x CDNA3 GPU chiplet -ből.

Amikor is a driver .. amit lehet áttol a backend CDNA3 -rade még

- [ 1x RDNA4 chiplet + 1x CDNA3 GPU chiplet ]

- [ 1x RDNA4 chiplet + 2x CDNA3 GPU chiplet ]

is elég erős lehet - és a moduláris felépítés miatt, a gyárthatóság és a költségek is egybevágnak az AMD filozófiájával.Lehet, hogy játékban az még nem lesz Number01, ( ~ majd csak az RDNA5 )

de Blender/ Rendering / CAD / Műszaki szimulációk / AI / ML - terén

el tudja szívni a levegőt és a felhasználókat az RTX 5090 Ti körül -

S_x96x_S

addikt

válasz

paprobert

#62047

üzenetére

paprobert

#62047

üzenetére

> Igen, CPU-ban egész nagy lehetne az ugrás, csak egyelőre értelmét nem látom,

> mert alig van kint játék CPU izzasztó kóddal.1.) 8K -hoz legalább egy dupla erős proci se árt ..

2.) a konzolban APU-van

és az egy power/thermal keretből gazdálkodik ..

vagyis ha a CPU gyorsabban végez, akkor több marad a GPU-nak.

( mert amúgy mindenki csendes konzolt szeretne .. vagyis nem szaladhat meg extrém módon a fogyasztás )lásd phoronix teszt: https://www.phoronix.com/review/amd-ryzen7040-avx512

Vagyis a "frames per second per Watt" -ban az AVX-512 add egy kis pluszt ..> Az AVX512 például Abu által a földig le volt hordva, (addig főleg, amíg az Intel-only

> feature volt), a szilíciumpazarlást kiemelve. Ez nyomós érv a konzolgyártóknál.igen, ... ezért is nem az Intel csinálja a konzolcsipeket.

de az AMD avx-512 implementácóját mindenki dicséri...

( amúgy is az AMD eléggé skót az szilicium terén és nem jellemző rá a szilícium pazarlás )> Viszont a fillérb*szási elv eddig erősebb volt annál,

> hogy ilyen-olyan potenciálisan kihasználatlan funkcióval hizlalják az SoC-t.a konzolon nem kell több különböző architektúrát támogatni,

amiatt a zen2 és a zen4(zen5?) párhuzamosan elfér egymás mellett,

és majd lesz 2 optimalizált konzol bináris .. ( multi-arch ) ahol a teljesítmény megköveteli ..szerintem ki fogják használni a konzolon az avx-512 -öt , hogyha beleteszik ..

-

Petykemano

veterán

válasz

paprobert

#62040

üzenetére

paprobert

#62040

üzenetére

A zen2->zen5c átmenet szerintem hozzávetőleg 50-60%-os IPC növekedést is jelenthet nem számolva frekvencia növekedéssel. Magszámot nem szokás növelni, de azt esetleg meg lehet kockáztatni, hogy 16 SMT nélküli magot alkalmaznak. Legalábbis volt egy olyan info, hogy magonként lesz megállapítható, hogy van-e SMT.

De ennél szerintem sokkal fontosabb és időszerű az AVX512 és más AI utasítás és/vagy gyorsító beépítése.

A GPU tekintetében szerintem hasznos lesz majd az RDNA3-ban megjelent "béta" fícsörök, mint a szuper tranzisztorsűrűség vagy dual-issue. Lehet, hogy megéljük, hogy az RDNA3 fine wine lesz.

A CU-k számát biztos növelik - a pro erről szokott szólni. A pletykák 36-ról 60-ra növelésről szólnak. Ugyanakkor szerintem az AI mellett megérhetett az RT is, hogy komolyabb támogatást kapjon.De azt is gondolom, hogy a chipletes gyártástéchnológia is van már azon a szinten, hogy konzolban használatba vegyék. Ezzel elérhető, hogy ne legyen olyan drága, vagy épp extra cache-sel lehet felülről megáldani.

Szerintem jóval több potenciál van ebben akár N4P+N6-on gyártva is, mint 30%. És ezek szerintem mind olyan dolgok, amiket a visszafelé kompatibilitás érdekében le lehet tiltani.

-

S_x96x_S

addikt

válasz

paprobert

#62040

üzenetére

paprobert

#62040

üzenetére

> Én még nagyon korainak érzem egy konzol refresh érkezését.

Azért a 8K / ray tracing / RDNA3 vagy RDNA3.5

elég csábító lehet."Speculations also suggest potential support for 8K gaming and high-framerate 4K gameplay."

"Alleged PlayStation 5 Pro console featuring AMD graphics with 30 WGPs, could launch November 2024"

https://videocardz.com/newz/alleged-playstation-5-pro-console-featuring-amd-graphics-with-30-wgps-could-launch-november-2024> Szóval a két korlátozó tényező,

> a megfizethető fejlett node, és nagy GPU-energiahatékonyságbeli ugrás.konzolnál teljesen normális, hogy az elején önköltségi ár alatt adják ..

és jövő év végére a TSMC 3nm -is elég jó állapotban lesz. ( Anandtech )

-

Chiller

őstag

válasz

paprobert

#61784

üzenetére

paprobert

#61784

üzenetére

A 4090 tud olyan fogyasztás mellett üzemelni egy nem terhelő játékkal V-sync mellett, hogy egy 3050 szintű kártya is megirigyli a fogyasztást, míg ugyanebben a játékban az RDNA3 továbbra is felsőközépkategóriásan, sokat fogyaszt.

Jó dolog, hogy ilyen ügyes a tranyó lekapcsoló algoritmusa, de ez kb annyira fontos mérés, mint hogy melyik úszik jobban a vízen

Egyiket se pasziánszra vesznek. -

válasz

paprobert

#61784

üzenetére

paprobert

#61784

üzenetére

A bekapcsolt V-sync melletti fogyasztási értékekben van irtózatos különbség a két márka között. Talán Igor tesztelte.

A 4090 tud olyan fogyasztás mellett üzemelni egy nem terhelő játékkal V-sync mellett, hogy egy 3050 szintű kártya is megirigyli a fogyasztást, míg ugyanebben a játékban az RDNA3 továbbra is felsőközépkategóriásan, sokat fogyaszt.

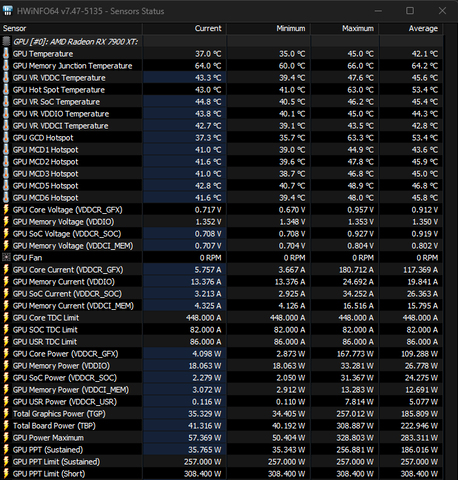

7900XT V-sync off:

AVG TBP: 222W

-

HSM

félisten

válasz

paprobert

#61784

üzenetére

paprobert

#61784

üzenetére

"De biztos hogy fogyasztás-takarékos is?"

Persze. Ha kevés tranzisztort járatunk, akkor kevés tranzisztor fogyaszt áramot. De nyilván nő a fogyasztás ahhoz képest, mintha nem lenne dual-issue, és üresen állna a fél CU.

"...de miért nincs az ilyen túlhúzási esetre jellemző hatékonyságnövekedés akkor, amikor kézzel visszavesszük a terhelést?"

Vissza lehet egyáltalán? Az RDNA3-nál elvették a korábbi, pl. általam az RDNA2-nél jó eredményekkel használt MPT-s paraméterezési lehetőséget, a WattMan pedig amit tud RDNA2-n még viccnek is rossz.

Ha pedig nem tudod hatékonyan korlátozni a feszt/órajelet, akkor pl. az alulfesszel csak azt éred el, hogy az adott fogyasztási limitből magasabb órajelre fog BOOST-olni.

A 6800XT-mmel pl. vidáman tudtam hozni a gyári + 15% power limit (293W) sebességét [link] kicsit finomhangolt, 224W-ra limitált beállításokkal: [link] .

A fogyasztásmérős méréseim szerint egyébként bőven tudott egy RTX3060 fogyasztási szintjén menni, annál nyilván jóval gyorsabban, Witcher 3-al, ráadásul kimaxolt RT-vel tesztelve. De ehhez elengedhetetlen az MPT-s paraméterezés, pedig nem bonyolult dolgokat kellene állítani, kb. csak hogy ne boostolja agyatlanul magát a végtelenségig, de a WattMan-on a legalapvetőbb dolgok is kifognak sajnos."...míg ugyanebben a játékban az RDNA3 továbbra is felsőközépkategóriásan, sokat fogyaszt."

Egyébként a TPU-n nem mértek túlzottan magas V-sync fogyasztást. [link] 123W nekem nem tűnik túlzottan soknak, +44W a 4090-hez képest, és a teljes, felsőkategóriás fogyasztási szinttől jócskán odébb van. -

HSM

félisten

válasz

paprobert

#61782

üzenetére

paprobert

#61782

üzenetére

A dual-issue elvileg viszonylag kevés tranzisztorból jött létre, és épp a CU-k jobb kihasználhatóságát célozza, így én nem nevezném "GCN-esítés"-nek. A sok megkötés is ebből jön, hogy próbálták a lehető legkisebb tranzisztorköltséggel elérhetővé tenni.

A Navi33 nem jó példa szerintem, abban lecsíptek a regiszterméretből, és a gyártástechnológia is régebbi, mint a Navi31-nél.

"terheletlenül sem csökken a fogyasztás annyival"

Ez driveres illetve órajelkapuzás kérdése is. Az órajel/fogyasztás görbe egy adottság, és jól látszik, hogy pl. a 7900XTX eléggé a tetején jár ennek. A tuningos verziók minimálisan gyorsulnak csak jelentős fogyasztástöbblet mellett. Jól látszik a tesztekből: [link] .

Egyébként az RDNA2-nél is a nagyobb verziókat (6800/69x0 XT-k) csúnyán határra pörgették, a saját 6800XT-men is jól látható, ahogy vaskos tartalék maradt az AVFS-ben is, arcpirítóan alul lehet feszelni, 3Dmark TimeSpy-ban a gyári kimaxolt 300W limitű beállítás pontjait kicsit finomhangolva 224W limitből is hozza [link] ...

Nyilván a 4080-at is lehet paraméterezni, arra célzok, hogy ez jelentős mértékben termékpozicionálási kérdés is, milyen teljesítmény/fogyasztás paraméterek mellett dobod piacra a terméket, és ez nem független a konkurencia ajánlataitól sem.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- ASUS GeForce GTX 660 DirectCU II OC 2GB GDDR5 192bit Videokártya

- Új garancias PNY OC rtx 4070 super 3 ventis OC verzio!

- ASUS ROG STRIX RADEON RX 6650 XT V2 OC EDITION 8GB GDDR6

- ASUS RTX 5090 32GB GDDR7 ROG ASTRAL OC - Új, Bontatlan, 3 év garancia - Eladó!

- SAPPHIRE RX 9060 XT 16GB GDDR6 NITRO+ - Új, Bontatlan, 3 év garancia - Eladó!

- GYÖNYÖRŰ iPhone 13 Pro 128GB Graphite -1 ÉV GARANCIA - Kártyafüggetlen, MS3082

- Samsung Galaxy A32 5G 128GB, Kártyafüggetlen, 1 Év Garanciával

- HIBÁTLAN iPhone 15 Pro 128GB Natural -1 ÉV GARANCIA - Kártyafüggetlen, MS3501, 90% Akkumulátor

- JBL ProFlora CO2 Starter Bio Set biológiai CO2 készlet 10-40 l-es édesvízi akváriumokhoz

- Asus Rog Ergo gamer szék

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: NetGo.hu Kft.

Város: Gödöllő

![;]](http://cdn.rios.hu/dl/s/v1.gif)

, hogy Linux -on

, hogy Linux -on

Meg nagyon sokat számít a konzolokon, hogy a GDDR6 ára nagyon-nagyon lecsökkent már.

Meg nagyon sokat számít a konzolokon, hogy a GDDR6 ára nagyon-nagyon lecsökkent már.

).

).

Igen, de csak a géming az több helyen kevés. Többet ér egy kártya, ha azon kívül bármire nyugodt szívvel használhatod. Például a streaming világban nem véletlenül csak NVIDIA van.

Igen, de csak a géming az több helyen kevés. Többet ér egy kártya, ha azon kívül bármire nyugodt szívvel használhatod. Például a streaming világban nem véletlenül csak NVIDIA van.