-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

HSM

félisten

"79-re limitált fps esetén, amiből ugye 158fps-t csinál"

Tehát minden második képkocka, amit nézel gyakorlatilag kamu. Erről beszéltem. Szerintem az összes ilyen feature úgy alapból használhatatlan, felskálázás, frame generation, akár piros open source, akár zöld Ai csoda. A kényszer szülte, hogy olyan beállítások is kevésbé legyenek játszhatatlanok, amik egyébként az adott GPU erejének nem felelnének meg. Aminek értelme van, az egy megfelelő felbontású monitor, hozzá egy megfelelően erős VGA, és a monitorba egy kellően erős és széles adaptív sync képesség. Az jó mozgásélményt ad, kamu képkockák és idegesítő artifactok nélkül is.

Szerintem az összes ilyen feature úgy alapból használhatatlan, felskálázás, frame generation, akár piros open source, akár zöld Ai csoda. A kényszer szülte, hogy olyan beállítások is kevésbé legyenek játszhatatlanok, amik egyébként az adott GPU erejének nem felelnének meg. Aminek értelme van, az egy megfelelő felbontású monitor, hozzá egy megfelelően erős VGA, és a monitorba egy kellően erős és széles adaptív sync képesség. Az jó mozgásélményt ad, kamu képkockák és idegesítő artifactok nélkül is. -

HSM

félisten

válasz

huskydog17

#64793

üzenetére

huskydog17

#64793

üzenetére

Mechanikailag én nyugodtabb vagyok ha van legalább egy csavar.

Viccesnek tartom, hogy egy kb. 1000 Ft-os csavarhúzó probléma egy 400 000 forintos VGA ventilátor cseréjénél.

Az meg, hogy hány pozícióban lehet... Szerintem ezt remélhetőleg megugorja a vásárló.. Ha nem, akkor legalább gondolkozott rajta kicsit, extra kihívás, ingyen.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

huskydog17

#64790

üzenetére

huskydog17

#64790

üzenetére

Az irány jó, de nekem nem tetszett ez a kivitelezés, feleslegesen túlbonyolítottnak tűnik. Nekem sokkal jobban tetszett a Sapphire RX580 Nitro-n alkalmazott megoldása, amin egyetlen csavar tartotta a ventilátort: [link] .

-

HSM

félisten

válasz

Petykemano

#64742

üzenetére

Petykemano

#64742

üzenetére

Szerintem komolytalan, hogy nem lett publikálva, mekkora volt közben a sebesség. Önmagában a fogyasztáscsökkenés értelmezhetetlen.

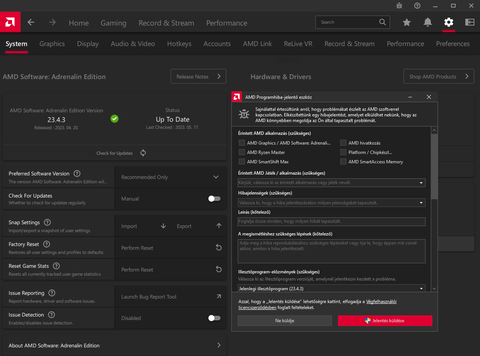

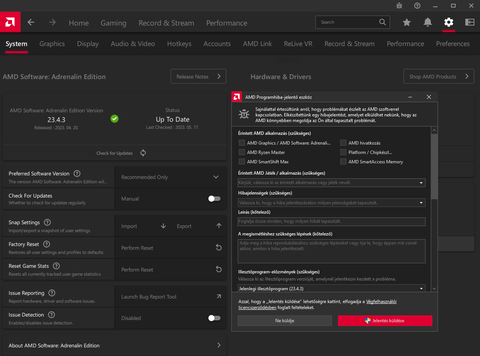

Egyébként én drukkolok neki, hogy NE ez az NPU-s megoldás jusson el hozzájuk, hanem csináljanak végre egy használható felületet a WattMan-nak. Ha nem is MPT-s szintűt, de mondjuk minimum lenne egy feszültség/órajel görbe szerkesztő, értelmezhető keretek között mozgatható fogyasztás limittel. Sajnos RDNA2-n is csak MPT-vel sikerült jó eredménnyel takarékos működésre bírnom pl a 6800XT-m, lásd első két bejegyzés: [link] , RDNA3-tól viszont megszüntették az interészt a kártyán, amivel az MPT és hasonló eszközök működni tudtak.

-

HSM

félisten

válasz

S_x96x_S

#64653

üzenetére

S_x96x_S

#64653

üzenetére

Az AVX512-t az ölte meg, hogy kezdetben sok ezt támogató Intel CPU igen körülményesen, alacsony órajellel és üzemmódváltással támogatta, azaz sokszor lassulást okozott ezek miatt az AVX512-es kód a hagyományoshoz képest. Így pedig eléggé csökkent a fejlesztők lelkesedése a támogatása iránt.

-

HSM

félisten

válasz

huskydog17

#62627

üzenetére

huskydog17

#62627

üzenetére

Én 12GB-ot látok a középkategóriában, és 16GB-ot picit felette. Szerintem teljesen rendben van ez. Ahogy a 7900XT-n is a 20GB. Nem mondta sehol az AMD, hogy eszetlen sok VRAM legyen, csak hogy elég.

-

HSM

félisten

válasz

szmörlock007

#62615

üzenetére

szmörlock007

#62615

üzenetére

Pedig pont ott vágtak, ahol nagyobb valószínűséggel lesz hiba illetve költség, az egyik MCD-t a négyből.

#62619 Petykemano : +1. Szerintem is érdektelen ennyiért, kb. mint a 7900XT a megjelenésekori árán.

Személy szerint +50$-t bármikor kiadnék 12GB helyett 16GB VRAM-ért már önmagában is....

#62618 Raymond : A 6800 annyira szerintem nem is izgalmas, azt azért rendesen megvágták minden szempontból. De ott vannak raktáron 525-550€ körül már a 6800XT-k is, amik közel teljesértékű Navi21-et használnak 72CU-val, korrekt fogyasztási kerettel.

A 6800XT-vel szerintem csak akkor lenne ez versenyképes az eddigi RDNA2-3 tesztek alapján, ha valami elkezdené kamatoztatni az új "AI" képességeket, amiben az RDNA3 lényegesen erősebb. -

HSM

félisten

Én fordítva vagyok ezzel. Pl. egy Ubuntu évről évre jobb, ha az elmúlt 10 évet nézem. A fizetős másik nagy os évről évre rosszabb, lassan fél napokban mérhető, mire egyáltalán kikapcsolod belőle a nem éppen felhasználóbarát működéseket. Néhányhoz már hozzá sem enged nyúlni egyszerűen, mintha nem is a te géped lenne...

-

HSM

félisten

" ... hogy nem jó a bontása a z RDNA3 nak."

Meglehetősen elnagyolt kijelentés ez tőlük. Az RDNA3-nak teljesen jó a bontása egy első generációs chiplet megoldásnak, a bő 300mm²-es GCD mellett sikerült leválasztaniuk bő 200mm²-nyi lapkaterületet 6db apró, régebbi technológián gyártható chipletbe. Ha jól látom, gyakorlatilag a 3. verzió a COPA-ábrádon, egy "monolitikus" GCD, mellé külön leválasztva az L3 és a memóriavezérlő.

Az RDNA3-nak teljesen jó a bontása egy első generációs chiplet megoldásnak, a bő 300mm²-es GCD mellett sikerült leválasztaniuk bő 200mm²-nyi lapkaterületet 6db apró, régebbi technológián gyártható chipletbe. Ha jól látom, gyakorlatilag a 3. verzió a COPA-ábrádon, egy "monolitikus" GCD, mellé külön leválasztva az L3 és a memóriavezérlő.

Ennél azért egy nagyságrenddel komplexebb kihívás magát a GCD-t is apróbb darabokra bontani, lehetőleg úgy, hogy munkavégzés szempontjából logikailag egy GPU maradjon.#62440 Petykemano : Nem gondolom, hogy váratlanul érte őket, de azt valószínűnek tartom, hogy látva az első eredményeket, a még befektetendő munkát, a piaci környezetet és az egyre növő alternatíva költséget (Ai !

) azt mondták, hogy ezt nem éri meg tovább fejleszteni MOST a jelenlegi környezetben és a hozzáférhető erőforrásokkal, és ekkor szépen visszatolták a terveket a fiókba, és a felszabaduló erőforrásokat rászabadították a többszörös profittal kecsegtető Ai/szerver fejlesztésekre.

) azt mondták, hogy ezt nem éri meg tovább fejleszteni MOST a jelenlegi környezetben és a hozzáférhető erőforrásokkal, és ekkor szépen visszatolták a terveket a fiókba, és a felszabaduló erőforrásokat rászabadították a többszörös profittal kecsegtető Ai/szerver fejlesztésekre.

A monolitikus verziók viszont használhatták a korábbi alapokat némi továbbfejlesztéssel, azok nyugodtan jöhetnek, mint frissítések. -

HSM

félisten

válasz

Petykemano

#62436

üzenetére

Petykemano

#62436

üzenetére

"én csak azt próbálom boncolgatni/kitalálni"

Én azt gondolom, az egész moduláris koncepcióhoz lényegesen hozzá kellene nyúlni az architekturális alapokhoz. Akkor is, ha csak egy AID lett volna aktív. -

HSM

félisten

válasz

Petykemano

#62419

üzenetére

Petykemano

#62419

üzenetére

"vajon nem pusztán azért kaszálták-e el, mert kell az advanced packaging kapacitás a Mi termékekhez"

Ez, valamint ehhez kapcsolódóan bennem az is felmerült, hogy az új, jobban feldarabolt struktúra egyéb változásokhoz is vezetett volna, amit vélhetőleg máshogy optimalizált driverekkel kellett/lehetett volna kezelni. Így összességében elég sok erőforrást vonhatott volna el (tervezés, szoftver, gyártás), az éppen erősen felpörögni látszó Ai divízió elől. -

HSM

félisten

Nv-nél volt, amikor a töredékét tudta a GF az azonos Quadro lapka teljesítményének, az akkoriban profi célokra szánt FP64 módban....

"The key enabler for this is that Titan, unlike any consumer GeForce card before it, will feature full FP64 performance, allowing GK110’s FP64 potency to shine through. Previous NVIDIA cards either had very few FP64 CUDA cores (GTX 680) or artificial FP64 performance restrictions (GTX 580), in order to maintain the market segmentation between cheap GeForce cards and more expensive Quadro and Tesla cards." [link] -

HSM

félisten

-

HSM

félisten

válasz

Petykemano

#62379

üzenetére

Petykemano

#62379

üzenetére

A 7900 GRE esetén van némi torzítás, gondolok arra, hogy vélhetőleg nem a legjobban sikerült csipek mennek arra, illetve az is torzít, hogy -1 MCD, azaz kevesebb a gyorsítótár.

A skálázódás vizsgálatához jobb lenne egy fix kártyából kiindulni, pl. 7900XT, és megnézni, mit mutat mondjuk 2.8Ghz-en, 2.4Ghz-en, vagy 2Ghz-en. Szinte biztos szerintem egyébként, hogy szépen skálázódna.

A saját 6800XT-m tapasztalatai is hasonlóak, gyárilag nem éppen hatékony üzemre van paraméterezve, kb. boostol, amíg ki nem maxolta a TDP-limitjét, de MPT-vel kicsit megpofozva meredeken lehet javítani a perf/watt-ját, és itt 100W-os nagyságrendre gondolok, gyakorlatilag minimális tempó-veszteséggel. [link]

Sajnos RDNA3-nél úgy tudom, már nem működik az MPT, mert más interfészre váltottak.

-

HSM

félisten

válasz

Petykemano

#62371

üzenetére

Petykemano

#62371

üzenetére

"már ha az nem a mátrixszorzás képesség marketingneve"

Nem hagytam ki, az éppen az. Legalábbis az Nv tensor magjai is ezt a Matrix Multiply Accumulate funkcionalitást nyújtják.

Legalábbis az Nv tensor magjai is ezt a Matrix Multiply Accumulate funkcionalitást nyújtják.

Érdekes egyébként innen [link] a uses-cases rész."Nekem az a gyanúm, hogy a GPU fejlesztésnél van egy tick-tock módszer..."

Én is így látom. Maradtak az RDNA2-nél kitaposott úton, új, hasznos képességekkel bővítve, de a biztonságra játszva a bevált alapokon és a chipletezéssel. Szerintem egyébként remek munkát végeztek abból a szempontból, hogy a 33-as chipek alapján alig nőtt a rendszer tranzisztorigénye, de bizonyos esetekben igen jelentős sebességelőnyre van benne potenciál. Pl. gyakorlatilag úgy csináltak jelentős tensor-képességeket, hogy nem kellett hozzá külön tranzisztor-büdzé.

Maradtak az RDNA2-nél kitaposott úton, új, hasznos képességekkel bővítve, de a biztonságra játszva a bevált alapokon és a chipletezéssel. Szerintem egyébként remek munkát végeztek abból a szempontból, hogy a 33-as chipek alapján alig nőtt a rendszer tranzisztorigénye, de bizonyos esetekben igen jelentős sebességelőnyre van benne potenciál. Pl. gyakorlatilag úgy csináltak jelentős tensor-képességeket, hogy nem kellett hozzá külön tranzisztor-büdzé.

-

HSM

félisten

válasz

Petykemano

#62363

üzenetére

Petykemano

#62363

üzenetére

"ezzel azt mondod..."

Nem, ezzel csak azt akartam mondani, hogy a dián szereplő akár 50%-al jobb perf/watt szvsz a teljesértékű RDNA3 implementációra lett értve, amiben benne van a nagyobb regiszter és az 5nm gyártástechnológia is."Semmilyen architekturából fakadó előnyt nem eredményezett az RDNA3"

Én azért felfedezni véltem kedvező előrelépéseket, főleg RT-ben, de ahhoz azért nem árt a megnövelt regiszter és kellő memória sávszélesség. De tény, hogy én sem dobtam el magam tőle, de ugyanakkor azt is érdemes elismerni, hogy éppen ott javított jelentősen, ahol erre a legnagyobb szükség volt (RT)."De az nem, hogy mire ment el a több tranzisztor."

Ha már említed... Megnéztem a Navi23 és Navi33 tranzisztorszámait, hiszen abból jól látható, hogy mennyi többletet jelent az új dual-issue és mátrixszorzás képesség, az optimalizált RT motor, az AV1 támogatás, és fejlettebb monitor interfészek, mindezek pedig a nagyobb modellek megnövel gyorsítótár és regiszter mérete és chipletezése nélkül. 13,300 millió tranzisztor áll szemben 11,060 millióval. Mindössze 20% többlet. Ahogy korábban utaltam rá, eléggé úgy tűnik nekem, hogy a tranzisztortakarékosságra hegyezték ki ezt a dual-issue módot, nem kér az RDNA3 alap lényegesen több tranzisztort, miközben hasznos, jelenleg még nem feltétlen kihasznált képességekkel bővült. Nagyjából arányban áll a többlet a sebességelőnnyel. -

HSM

félisten

Írja a hivatalos specifikációknál is a CB teszt, a GRE "game órajele" 1880Mhz, míg a 6950XT-é 2100Mhz. A TBP is árulkodó, a GRE-é mindössze 260W, míg a 6950XT-é 335W. Látszik ezekből is, hogy egy erősebb terhelés esetén a GRE hamarabb fog erős fogyasztási limitbe, így alacsonyabb órajelbe futni. Azért is írtam, hogy kb. fix 1.8Ghz körül lehetne az az órajel, amit biztosan fixen megfutna mindkét kártya a limitjein belül a terhelési csúcsok idejére is.

#62356 b. : No offense, de pl. az up to +50% perf/watt a Navi31 bemutatón hangzott el, és szvsz a Navi31-ben józanul paraméterezve (jól megválasztott TDP és órajel limit) ez benne is lehet. Látszik is a CB tesztből, mennyivel takarékosabban hozza már az alaposan butított GRE is a 6950XT tempóját.

Szerintem teljesen irreális elvárás a regisztereiben megnyirbált, 5 helyett 6nm-en gyártott, erősen költséghatékonyságra kigyúrt, belépő verziótól is hasonlót várni.

Az összehasonlítás persze korrekt a 6600-7600-ra nézve, csak éppen az egész videóban RDNA2 vs RDNA3-at emleget, ami így már korántsem az....

-

HSM

félisten

"Ez már most megvalósult"

Sajnos nem. A GRE jóval szerényebb fogyasztási limitre van korlátozva. Engem azonos órajel érdekelne, olyan magas limittel, ami nem zavar be. Tehát mondjuk mindkét kártya fix 1.8Ghz-en, kitolt limittel. Odafigyelve, hogy a Navi31-ben külön van a frontend és shader órajel, az elődökben még nincs.

A GRE jóval szerényebb fogyasztási limitre van korlátozva. Engem azonos órajel érdekelne, olyan magas limittel, ami nem zavar be. Tehát mondjuk mindkét kártya fix 1.8Ghz-en, kitolt limittel. Odafigyelve, hogy a Navi31-ben külön van a frontend és shader órajel, az elődökben még nincs.

Pl. CB tesztben említik az órajelet, ez azért nem mindegy:

Cyberpunk 2077 + RT: GRE: 2.091 MHz, 6950XT: 2.363 MHz

Vagy van durvább is:

CoD: Modern Warfare: GRE: 2.028 MHz, 6950XT: 2.418 MHz

Akár 20%-al magasabb órajelnél nehéz C2C összehasonlításról beszélni, és számomra az sem derült ki, a GRE-nél ez melyik órajel, és mennyi volt a másik.

"tehát ugyanaz látszik kirajzolódni, mint az RX7600 kontra 6600XT tesztben, regiszter ide vagy oda."

Végülis csak nagyságrendileg 20%-al jár alacsonyabb órajelen a hasonló eredményhez.

Ez minden, csak nem hiteles C2C összehasonlítás az architektúrák között. -

HSM

félisten

Erre gondoltál? [link]

Szokásos RDNA3=RX7600 tévút. Miközben ez csak erre a GPU-ra igaz, mivel összehasonlítva az RDNA2-vel (RX6600XT) ugyanakkora maradt a CU regiszter mérete (RT-nél ez komoly hátrány lehet), valamint ugyanúgy 32MB az L3. Ezáltal kb. csak a dual-issue képesség és az új RT megvalósítás hasznának egy részét mérik ezek ki, ami csak egy része az újításoknak, és nyilván az 5nm használata is kimaradt.

Miközben ez csak erre a GPU-ra igaz, mivel összehasonlítva az RDNA2-vel (RX6600XT) ugyanakkora maradt a CU regiszter mérete (RT-nél ez komoly hátrány lehet), valamint ugyanúgy 32MB az L3. Ezáltal kb. csak a dual-issue képesség és az új RT megvalósítás hasznának egy részét mérik ezek ki, ami csak egy része az újításoknak, és nyilván az 5nm használata is kimaradt.Ehhez képest pl. a 7900 XT esetében az RDNA2-höz képest másfélszer akkora lett a regiszterméret, viszont csökkent az L3 méret. A nagyobb regiszter egyébként komoly segítség RT alatt, amivel már inkább tud domborítani a hatékonyabb RT-s futószalag.

Érdekesebb összehasonlítások születhetnek majd, ha a 80CU-s 7900 GRE-t hasonlítják majd azonos órajelen a 80CU-s 6900XT-hez, vagy 6950XT-hez. Bár erre nem találtam még hivatalos megerősítést, a 7900 GRE-ben meghagyták-e a 6MB-os L2-t és nagyobb regiszter méreteket, de vélhetőleg igen, hiszen Navi31 alapú.

Az első GRE tesztek alapján egyébként hasonló tempót hoz a 6900XT-vel, de lényegesen szerényebb fogyasztási keretből. Személy szerint nagyon kíváncsi lennék, ha valaki csinálna egy TDP korlát nélküli, fix órajeles tesztet.

-

HSM

félisten

válasz

fahrii

#62337

üzenetére

fahrii

#62337

üzenetére

Én egyáltalán nem tartom jó dolognak, hogy a piaci árba egyből bele volt árazva egy ~fél évnyi bánya akkoriban.

Az esetleges haszon jogi/adózási vonatkozásairól, bonyodalmairól, és a tevékenységgel járó kockázatokról nem is beszélve.Ettől függetlenül nem hagytam parlagon, termelt valamennyi ETH-t, de azért sok macera volt vele, és ha egyszer abból pénzt (vagy VGA fejlesztést) akarnék csinálni az megint egy kör utánajárás. Ezzel szemben a villanyszámla és a kártya piaci értékvesztése azonnali, és biztos, adózott pénzbeli, fájdalmas fizetnivaló.

-

HSM

félisten

Én még jó drágán vettem a 6800XT-t, amikor még hiány volt, így annyira nem vidít fel, hogy milyen olcsó lett a használtpiacon...

Én szívesen fejleszteném 7900XT-re a jobb RT miatt, de a jelenlegi árakon ez nem lenne túl racionális fejlesztés. A jobb ár/teljesítmény mutatóhoz pedig komolyabb generációs előrelépések kellenének. -

HSM

félisten

Egyébként elnézve az XT és XTX viszonyát, nem lep meg, hogy fájdalmas az L3 méretcsökkenése és a busz keskenyedése, ráadásul együtt.... Nagyobb felbontásokban pl. jobban lemaradt már az XT is az XTX-től, főleg 1440P és 4K viszonyában jól kivehető volt. A Navi21 pedig hiába kicsit bénább konstrukció, 128MB L3 áll szemben 64MB-al, azért az sokat besegíthet... Látszik is néhány játékban, hogy RT nélkül gyorsabb is a 6950XT, míg RT-ben kb. egál. A 7800 miatt én is aggódom kicsit, a várható órajeleken nem fog túl szépen mutatni, kb, olyan erősnek kellett volna lennie, mint most a GRE, de még ez sem túl meggyőző 80 CU-val, el lehet képzelni mit fog tudni majd a 7800-as 60-al.....

-

HSM

félisten

Nagyjából ezt számolgattam ki én is [link] .

(Nem láttam még a videót, amikor ezeket számolgattam.)

(Nem láttam még a videót, amikor ezeket számolgattam.)

Egyébként, a mostani wafer-árakon az AD103 szerintem eléggé eltalált lett.

A 4090 óriás csip méretét kicsit meredeknek látom még a sok tiltás mellett is, de ettől függetlenül az is nyilván igen jó lett, bár megnéztem volna a bolti árát az eredetileg belengetett közel 20 000$-os 5nm wafer árakon.

-

HSM

félisten

Az architektúra alapjainak sokszor előbb kell készen lennie, mint ahogy elérhető lenne a gyártástechnológia, hát még annak árazása... Szóval kötve hiszem, hogy amikor elkezdték tervezni az Ada-t, akkor már tudták volna, mennyibe fog kerülni az 5nm-es gyártás.

Érdekesség egyébként, hogy párszor előfordult a történelemben, hogy az Nv-nél megbosszulta magát, hogy ki akarták maxolni a gyártástechnológiát. Gondolok itt a GTX280-ra és a GTX480-ra, mindkettőnél túllőtek a célon, amivel igen kellemes piaci helyzetbe hozták a konkurens HD4870 és HD5870 kártyákat."az RDNA1 architektúrájában"

Abban nem. De az RDNA2-ben igen. (L3 beépítése az L2 növelése helyett.)"hogy TSMC kb mekkora árazást ad a wafferre hisz ez nem napi árfolyam"

Nem hinném, hogy bármelyikünk ebbe belelátna, de a pletykált, rendkívül alacsony Wafer-árak szinte biztosan nem jöhettek volna létre az előre nehezen jósolható meredek kereslet (és ebből fakadóan gyártósor kihasználtság) csökkenés nélkül. -

HSM

félisten

Nem állítottam be őket vesztesként. Csupán azt próbáltam kiemelni, hogy az érvelésed gyenge lábakon áll, hiszen nem tudhatta senki előre, hogyan fog alakulni az 5nm árazása. Így "vakon" bevállalni egy 600mm²-es csipet a megjelenésekor brutálisan drága 5nm-en minimum bátor húzás volt.

Illetve, amire utaltam még, hogy játékos felhasználású GPU-ból az AMD már lerakott az asztalra egy alapvetően igen jól működő, konkrét megvalósítást, míg az Nv Ada architektúrájában semmi nyoma, hogy akár csak elmozdultak volna MCM irányba.

-

HSM

félisten

válasz

Petykemano

#62231

üzenetére

Petykemano

#62231

üzenetére

3-3.5Ghz-el, és kicsit ügyesebb driverrel bőven ~40%-al erősebb lenne, ami a mostani CU-számmal is igencsak versenyképes lehetne.

Nem is elrugaszkodott szám ez, hiszen a jobb Navi21-ek már 7nm-en súrolták a 3Ghz-et.

Nem is elrugaszkodott szám ez, hiszen a jobb Navi21-ek már 7nm-en súrolták a 3Ghz-et.Az is érdekes adalék, hogy a CU órajel tartománya el lett választva a GPU többi részéről. Ez utalhat arra is, hogy arra számítottak, hogy a CU-kat sikerült ezáltal magasabb órajelen járatni, de a gyakorlatban ez fordítva sült el, a 7900XTX gyári front-end órajele 2.5Ghz lett, míg a shader órajel csak 2.3Ghz.

Nagyon érdekes még amit itt írnak: [link] ("Frontend Clock Behavior" rész) . Jól látszik a grafikonon, hogy alacsony órajelen egyforma órajelen járatja a 7900 is a frontend/shader tömböt (itt hirtelen nem a frontend a limit?!

![;]](//cdn.rios.hu/dl/s/v1.gif) ), de nagyobb órajelen "lemaradnak" a shaderek... A "hivatalos" magyarázat számomra kevéssé meggyőző, főleg shaderből implementált RT-vel.

), de nagyobb órajelen "lemaradnak" a shaderek... A "hivatalos" magyarázat számomra kevéssé meggyőző, főleg shaderből implementált RT-vel.

#62233 b.: "Jensen több éve már azt mondta hogy 3 nm gyártás felett és megfelelő tokozás hiányában nem érdemes Chipletes GPU -ban gondolkodni. Igaza volt."

Persze, ő mindenki előtt látta, hogyan fog alakulni a kereslet/kínálat (=árazás) a modern gyártástechnológiákon. Ez is kevéssé hihető. Sokkal inkább szerecséje volt, hogy igen hamar olcsó lett az 5nm, így az AMD nem tudta kihasználni a chipletezésből származó előnyöket a Navi31-32-nél, és így az Nv büntetlenül gyárthat ormótlan nagy 5nm GPU-kat, mint pl. a 4090-esé, 609 mm²-el. Volt, amikor nem jött be ez a taktika, abból lettek pl. a Fermi-s mémek, mint pl. ez a gyöngyszem: [link] .

Sokkal inkább szerecséje volt, hogy igen hamar olcsó lett az 5nm, így az AMD nem tudta kihasználni a chipletezésből származó előnyöket a Navi31-32-nél, és így az Nv büntetlenül gyárthat ormótlan nagy 5nm GPU-kat, mint pl. a 4090-esé, 609 mm²-el. Volt, amikor nem jött be ez a taktika, abból lettek pl. a Fermi-s mémek, mint pl. ez a gyöngyszem: [link] ."Azt gondlom az Nvidia első chipletes GPu -i már rég tervező asztalon megszülettek"

Azért ide némi adalék, hogy míg a Navi31 esetén már a memória-alrendszer jelentős részét sikeresen leválasztották az L3-al együtt, addig Nv-nél az L2 növelésével éppen a GPU "növekedett" méginkább. Ez nem tűnik a chiplet felé való lépkedésnek...

#62262 Busterftw : Jelentős butítást kapott, hiába RDNA3, nem kapta meg a nagyobb modellek másfélszer akkora regiszterét a CU, hanem maradt az RDNA2-es méretnél....

-

HSM

félisten

válasz

Petykemano

#62215

üzenetére

Petykemano

#62215

üzenetére

"...akkor miért nem skálázzák és miért nem készítenek belőle még kettőt - nagyobbat?"

Igen, pontosan erre.

"De ha nem sikerült összehozni a multi-chipletes skálázódást, akkor a két nagyobb verzió törlése érthető volna."

Így valóban logikus... És könnyen lehet, hogy most inkább mást priorizáltak, minthogy ezzel szenvedjenek. De ettől függetlenül hagyhatták volna az egészet, és megcsinálhatták volna felskálázva egybe, ahogy az eddigi szériáknál is ment.Érdekes egyébként, hogy egy japán blogon épp a felvetésembe botlottam (GPU=/=SKU) ...

[link]

[link] #62226 Z_A_P : És mindezt egy elég nagy fiaskónak kikiáltott R600 (HD 2900 XT) után.

#62227 paprobert : "Ez skálázódási problémát jelez, és valószínűleg ez az oka, hogy miért nincs egy még nagyobb GCD."

Én azt gyanítom, más állhat a jelenség mögött. Mégpedig az, hogy nem sikerülhetett vagy a tervezett órajelet, vagy a tervezett IPC-t elérni. Az órajelet szinte biztosan, a Navi21-hez képest alig sikerült órajelben előrelépni, és a driver sem biztos, hogy a helyzet magaslatán van, a megjelenéskor a szokásosnál is félkészebb benyomást keltett. Az esetleges egyéb hardveres hibákról nem is beszélve. Szerintem erre utal az is, hogy a teljes portfólión számomra látványosan alulméretezett CU-számok vannak, ami főleg a megjelenés előtt álló N32-nél feltűnő. Számomra ez arra utal, hogy lényegesen magasabb CU-teljesítménnyel kalkulálhattak a fejlesztés korai fázisában.Szerintem egy 120CU-s 8900XTX-nek és egy 80CU-s 8800XT-nek bőven lett volna hely/lehetőség, akár RDNA3 alapokon is... Szerintem bőven lenne érdeklődés ilyen termékekre +1 év múlva is.

-

HSM

félisten

válasz

Petykemano

#62211

üzenetére

Petykemano

#62211

üzenetére

Nekem az szokatlan, hogy ha már a kis GPU-k elkészülnek, akkor miért ne csinálnák meg a nagyobb verziókat, főleg, ha igény is lenne rájuk?

Polaris/Vega időben ennek érthető okai voltak (skálázódási gondok), de ezek már megoldódtak. -

HSM

félisten

válasz

Petykemano

#62202

üzenetére

Petykemano

#62202

üzenetére

Nem lehet a leírtaknak olyan értelmezése, hogy nem lesz nagy GPU? Tehát nem SKU, hanem GPU? Korábban szóltak erről pletykák, hogy a GPU is chipletes lesz, logikus is lenne arra továbblépni. Pl. belépőszint 1GCD+2MCD, középkategória 2GCD+3/4MCD, felső kategória pedig 3-4GCD+5/6MCD.

De lehet csak a közép/felső kategóriánál érné meg, és nyilván itt számít, hányfelé tudják/akarják bontani, akkor mondjuk a Navi32 helyére 1GCD+3/4MCD, és ebből készülhetne high-end, 2GCD+5/6MCD. -

HSM

félisten

válasz

Petykemano

#62156

üzenetére

Petykemano

#62156

üzenetére

"Vagy a Navi32 javítása nem sikerült úgy, hogy elérje ezt a szintet"

Javítás ide vagy oda, szvsz egyszerűen túl kevés lett bele a 60CU.... -

HSM

félisten

válasz

Alogonomus

#62143

üzenetére

Alogonomus

#62143

üzenetére

Ugyanaz a GPU, Navi31...

Az ECC is benne szokott lenni a normál verzióban is, kikapcsolva. Nem éri meg külön verziót gyártani belőle. Ahogy a memória méret is elég nagy baj lenne, ha külön memóriavezérlőt igényelne.

Ahogy a memória méret is elég nagy baj lenne, ha külön memóriavezérlőt igényelne. -

HSM

félisten

válasz

Petykemano

#62139

üzenetére

Petykemano

#62139

üzenetére

És akkor még nem szóltunk a már létező, mindössze 70CU-ra vágott verzióról... [link]

-

HSM

félisten

válasz

Alogonomus

#62069

üzenetére

Alogonomus

#62069

üzenetére

A 16 vs 20 GB mellett a sávszélesség is kevesebb és 16MB Infinity Cache is megy a levesbe az egyik MCD-vel. Azért ezeknek is érezhető hatása lehet, már a 7900XT-nek is fájt néha a kiesett MCD az XTX-hez képest. Ha a TDP keret is csökken, akkor az órajel is érezhetően fog, hiszen a 7900XT sem volt TDP ügyileg eleresztve...

-

HSM

félisten

válasz

Komplikato

#62062

üzenetére

Komplikato

#62062

üzenetére

Ezt pletykálták már a 256bites Navi31 verziónál is, hogy kisebb lehet a csomag.... Ami logikus is abból a szempontból, hogy 128 bittel keskenyebb lett a memóriabusz.

Azt nem tudom, ezen mekkora, de Igor már tesztelte, ami vélhetően ennek a professzionális verziója [link] . -

HSM

félisten

válasz

Petykemano

#62031

üzenetére

Petykemano

#62031

üzenetére

"A 2022-es RDNA3 megint gatya."

Azért ezt kicsit erősnek gondolom. Persze, jópár dolog pocsékul lett kivitelezve, főleg a rajtnál (pl. félkész driver), de maga az újítások hasznosak és jók. Gondolok a jobb RT teljesítményre, nagyobb regiszterre/gyorsítótárakra, a sikeresen megvalósított chiplet dizájnra vagy a bevezetett erősen korlátozott, de alacsony tranzisztor igényű dual-issue képességre.

A 7900-as széria nekem tetszett, éppen ott fejlődött az RDNA2-höz képest, ahol arra a legnagyobb szükség volt. -

HSM

félisten

válasz

Petykemano

#62006

üzenetére

Petykemano

#62006

üzenetére

Megjelenés előtt tulajdonképpen minden kártya prototípus.

Manapság főleg, amikor kis BIOS paraméterezéssel egész sokat lehet ide-oda lökni a teljesítményen a fogyasztás kárára, akár a megjelenés napján is. -

HSM

félisten

"Ha fizetsz és van szerződés, akkor meg kell csinálniuk."

Aha, persze. Biztos jó lesz, olyanok szoktak lenni a javítások, a tapasztalat azt mutatja.![;]](//cdn.rios.hu/dl/s/v1.gif)

Persze, lehet, hogy én vagyok csak ilyen fejlesztő, hogy az van biztosan jól megcsinálva határidőre, amit én magam csináltam meg.

-

HSM

félisten

válasz

Petykemano

#61794

üzenetére

Petykemano

#61794

üzenetére

"ami azt jelenti, hogy fél évet visszatartották"

Notebookokba már elég rég bejelentették, logikusnak tűnik, hogy először az ott jelentkező igényekre tartották a legyártott mennyiséget, főleg, hogy az asztali piacon az elődje is elég jól tartja magát.A Navi32-nek nem kell borítania semmit, ha javítva jön, majd úgy állítják be az órajeleket/TDP limiteket, hogy a 7900XT-t azért ne érje utol. Mellékhatásként versenyképesebb lehet perf/watt-ban.

-

HSM

félisten

válasz

paprobert

#61784

üzenetére

paprobert

#61784

üzenetére

"De biztos hogy fogyasztás-takarékos is?"

Persze. Ha kevés tranzisztort járatunk, akkor kevés tranzisztor fogyaszt áramot. De nyilván nő a fogyasztás ahhoz képest, mintha nem lenne dual-issue, és üresen állna a fél CU.

"...de miért nincs az ilyen túlhúzási esetre jellemző hatékonyságnövekedés akkor, amikor kézzel visszavesszük a terhelést?"

Vissza lehet egyáltalán? Az RDNA3-nál elvették a korábbi, pl. általam az RDNA2-nél jó eredményekkel használt MPT-s paraméterezési lehetőséget, a WattMan pedig amit tud RDNA2-n még viccnek is rossz.

Ha pedig nem tudod hatékonyan korlátozni a feszt/órajelet, akkor pl. az alulfesszel csak azt éred el, hogy az adott fogyasztási limitből magasabb órajelre fog BOOST-olni.

A 6800XT-mmel pl. vidáman tudtam hozni a gyári + 15% power limit (293W) sebességét [link] kicsit finomhangolt, 224W-ra limitált beállításokkal: [link] .

A fogyasztásmérős méréseim szerint egyébként bőven tudott egy RTX3060 fogyasztási szintjén menni, annál nyilván jóval gyorsabban, Witcher 3-al, ráadásul kimaxolt RT-vel tesztelve. De ehhez elengedhetetlen az MPT-s paraméterezés, pedig nem bonyolult dolgokat kellene állítani, kb. csak hogy ne boostolja agyatlanul magát a végtelenségig, de a WattMan-on a legalapvetőbb dolgok is kifognak sajnos."...míg ugyanebben a játékban az RDNA3 továbbra is felsőközépkategóriásan, sokat fogyaszt."

Egyébként a TPU-n nem mértek túlzottan magas V-sync fogyasztást. [link] 123W nekem nem tűnik túlzottan soknak, +44W a 4090-hez képest, és a teljes, felsőkategóriás fogyasztási szinttől jócskán odébb van. -

HSM

félisten

válasz

paprobert

#61782

üzenetére

paprobert

#61782

üzenetére

A dual-issue elvileg viszonylag kevés tranzisztorból jött létre, és épp a CU-k jobb kihasználhatóságát célozza, így én nem nevezném "GCN-esítés"-nek. A sok megkötés is ebből jön, hogy próbálták a lehető legkisebb tranzisztorköltséggel elérhetővé tenni.

A Navi33 nem jó példa szerintem, abban lecsíptek a regiszterméretből, és a gyártástechnológia is régebbi, mint a Navi31-nél.

"terheletlenül sem csökken a fogyasztás annyival"

Ez driveres illetve órajelkapuzás kérdése is. Az órajel/fogyasztás görbe egy adottság, és jól látszik, hogy pl. a 7900XTX eléggé a tetején jár ennek. A tuningos verziók minimálisan gyorsulnak csak jelentős fogyasztástöbblet mellett. Jól látszik a tesztekből: [link] .

Egyébként az RDNA2-nél is a nagyobb verziókat (6800/69x0 XT-k) csúnyán határra pörgették, a saját 6800XT-men is jól látható, ahogy vaskos tartalék maradt az AVFS-ben is, arcpirítóan alul lehet feszelni, 3Dmark TimeSpy-ban a gyári kimaxolt 300W limitű beállítás pontjait kicsit finomhangolva 224W limitből is hozza [link] ...

Nyilván a 4080-at is lehet paraméterezni, arra célzok, hogy ez jelentős mértékben termékpozicionálási kérdés is, milyen teljesítmény/fogyasztás paraméterek mellett dobod piacra a terméket, és ez nem független a konkurencia ajánlataitól sem. -

HSM

félisten

válasz

Petykemano

#61747

üzenetére

Petykemano

#61747

üzenetére

A Vega20 nem így nézett ki.

-

HSM

félisten

válasz

DudeHUN

#61734

üzenetére

DudeHUN

#61734

üzenetére

Egyébként erősen beállításfüggő, mikor lép át a torkosabb multimonitor módba.

Nálam pl. a 60Hz-es monitor mellé nem szeret a másik monitorom 144Hz-en menni, de ha leviszem 120Hz-re, máris takarékos módba lép a 6800XT. [link] Egyedüli monitorként viszont mindegy, 120 vagy 144Hz-en hajtom, takarékos marad.

Nv kevésbé háklis az ilyesmikre, ez tény. -

HSM

félisten

válasz

Petykemano

#61736

üzenetére

Petykemano

#61736

üzenetére

"Nem igazán érhető tetten sem a megnövelt L0-2 cache hatása, sem a dual issue"

Főleg RT-ben azért masszív az előrelépés lett az N31. Részben a nagyobb regiszterterület révén, ami pl. az N33-ból épp kimaradt. [link] Más részben a bevezetett RT-t támogató utasítások révén.

Szerintem egy hasznos inkrementális fejlesztés lett az RDNA3, de egyetértek abban, hogy még nem nagyon látszanak a fejlesztések hatásai. Főleg a dual-issue nagyon korlátozottan lett bevethető, ellenben elég tranzisztortakarékos lett a megvalósítás, így viszont bőven érdemes volt belerakni. -

HSM

félisten

válasz

Raymond

#61691

üzenetére

Raymond

#61691

üzenetére

Már a megjelenésekor is ment a hőbörgés az ára miatt. Ennek ellenére hamar elfogyott a boltokból. Amit nem vittek, de volt bőven, az a 4080 volt 1200$-ért. Mondjuk nem meglepő annak tükrében, hogy az elérhető leggyorsabb kártya, gyakorlatilag kihívó nélkül a 4090, azokat azért vinni szokták, árcetlitől függetlenül.

#61689 Raymond : A 4070-et nem csodálom, hogy viszik. Az egyetlen új kártya szvsz a zöldektől, ami relatív kedvező áron hoz jó teljesítményt, kellően sok VRAM-al.

-

HSM

félisten

válasz

bitblueduck

#61630

üzenetére

bitblueduck

#61630

üzenetére

Nekem gamer felhasználásra ezzel nem volt bajom korábban, jól kiszolgált az R9 290 majd utána a az RX580 sokáig. Ugyanakkor az RDNA óta nem látom, hogy jól lennének menedzselve a dolgok.

Az RDNA2-vel most (RX6800XT) pl. van olyan, hogy vissza kell tegyek egy bő 2 éves drivert, hogy ne bugozzon be pl. a BFV RT módban (természetesen a játék és a win10 is a legfrissebb, hivatalos verzió). És ez nem egy sufni játék, nem túl régi AAA-s cím, és nem is én vagyok az egyetlen, aki belefutott és riportolta, javítás eddig sehol... Mondjuk ezen kívül nálam teszi a dolgát.

Az sem volt amúgy hétköznapi, hogy megjelenés után hosszú időre ki kellett tiltani a foldingból az RX5700-akat, mert egyszerűen hibás eredményeket töltöttek fel...

A hardverrel maximálisan elégedett vagyok, de a szoftveres körítéssel nem igazán. Mondjuk én a zöldekétől sem ájultam el, ott is volt, amikor telepítés közben beállt, mint a szög, és a login-falas experience program sem nyerte el a tetszésem, de legalább így megkíméltek a telepítésétől is.A mostani driverekkel nem szokta már átrendezni szerencsére az asztalt, vagy legalábbis nem vettem észre.

-

HSM

félisten

"2014 januárban nyújtotta be AMD a kérelmet a CES -után a DP1.2a szabvány módosítására."

Miért nem olvasod el, amire hivatkozom? Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy #61592 kisfurko is említi, amikor konkrét javaslat van már, azelőtt már szoktak lenni előzetes egyeztetések. Januárban már GMR fázisról írnak, ami eléggé már a vége a folyamatnak...

Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy #61592 kisfurko is említi, amikor konkrét javaslat van már, azelőtt már szoktak lenni előzetes egyeztetések. Januárban már GMR fázisról írnak, ami eléggé már a vége a folyamatnak...#61595 b.: "Ez egy opcionális funkció, a Vesa nem vezette be a 1.2a szabvány kötelező részeként"

Nem teljesen értem, miért kellene kötelező elemnek lennie. Miért ne gyárthatna valaki ezt nélkülöző monitort? Egy egyszerű irodai monitornak pl. semmi szüksége rá.

Egy egyszerű irodai monitornak pl. semmi szüksége rá.#61596 kisfurko : Az általam linkelt cikk behivatkozta a VESA dokumentumot, kb. mit jelent a GMR fázis. Én sem vagyok tag, de ebből azért már lehet erős következtetéseket levonni.

-

HSM

félisten

válasz

kisfurko

#61579

üzenetére

kisfurko

#61579

üzenetére

"Még sosem láttak készülő szabványt."

Én is így látom.

#61581 Busterftw : "te hasrautve leirtad"

Nem hasraütve, világosan megneveztem az erre utaló, egyértelmű jeleket. Aki kicsit is kiismeri magát a tech szektor működésében, azoknak ez triviális kell legyen.#61584 b.: "tehát nem egy freesync volt az csak egy sima eDP, driveres támogatással, kb zero melóvel."

Érdekes, hogy az előző hozzászólásodban az Nv-től még teljesítmény volt ugyanez. Merthogy az ő megoldásuk is a VBLANK manipuláció a 2008-as eDP szabványból, csak mivel a piacon lévő scalerek nem tudták még, így felprogramoztak erre egy FPGA-t, és egy piacon lévő monitorban kicserélték erre a scalert. Ennyi erővel ez is kb. "zéró munka"...#61586 b.: Az időrendnél nem tudjuk sajnos pontosan, az AMD mikor is adta be a javaslatát a VESA-hoz, hogy legyen ez is a része és mikor kezdték fejleszteni a G-syncet abban a formájában. De amit linkeltem az elején cikk [link] , aszerint előbb volt a javaslat, utána hirtelen a G-sync, és némi szemöldök ráncolás a VESA-nál.... De az FPGA-s drága megvalósítás, valamint egy meglévő termékbe integrálása egyértelműen komoly sietségre utal.

#61587 Busterftw : Az első DLSS minősége szvsz értelmezhetetlen volt, valamint ezer éve létezett az AMD-nél pl. GPU-scaling, sőt, bizonyos játékokban beépítve is gyártófüggetlenül, tehát itt csak annyi az innováció, hogy belekeverték az AI-t egy már régóta létező megoldásba, vegyes eredményekkel.

-

HSM

félisten

FPGA-t nem fognak ilyesmire tervezni, ezt levették a polcról... Ahogy a kezdeti monitor kínálat is kb. úgy készült, hogy az egyedi modult belerakták a scaler helyére, és onnan már csak egy profil kellett a kijelző panelhez. Egy zárt technológiával, polcon lévő, drága, általános célú feldolgozókkal ezt könnyen és gyorsan piacra lehetett vinni. A szabványos megoldásnak éppen ez a hátránya, ki kell dolgozni a szabványt, meg kell várni, mire az ellátási lánc szereplői hardvert készítenek rá (új scalerek, nem drága FPGA!), ez mind idő. Láttak itt lehetőséget kis pénzt/marketingértéket teremteni, ráugrottak. Szvsz kb. ennyi a nagy innováció ebben a zöldektől.

-

HSM

félisten

"A Vesa 2014 ben, fél évre rá kb jelentette be..."

Vegyük figyelembe, hogy akkor már vélhetőleg rég dolgoztak rajta. Az általam linkelt cikk alapján volt a Vesa-n belül is felhördülés a G-sync kapcsán...."Nekem szerencsére jól működik az A-sync a Freesynces monitoron"

Mivel a FreeSync az Adaptive Sync AMD-féle implementációja, így meglepő lenne, ha nem működne. Az Nv is ezért tudja ezeket támogatni, hiszen szabványosak... Csak ezért ne válts HDMI2.1-re....

Csak ezért ne válts HDMI2.1-re.... ![;]](//cdn.rios.hu/dl/s/v1.gif)

#61566 Busterftw : "Tehat a FreeSynccel itt az AMD mit innovalt"

Az AMD itt azt szerette volna innoválni, hogy legyen egy nyílt ipari szabvány, amire mindenki építhet azzal kompatibilis monitort/VGA-t, a mobil eDP példája alapján.

Aztán az Nv gyorsan bedobta a saját megoldását, remekül szegmentálva a piacot, és röghöz kötve a felhasználóit, mindezt eladva "innovációnak" (marketing, amiről írtam)...."Ez miben vitatja..."

Ez nem azt vitatja, hanem a másik állításodat, hogy már mióta készült a garázsban.... Ez azt bizonyítja, hogy az Nv is csupán átmeneti megoldásnak szánta, és expressz sebességgel kellett vele piacra lépni."Tudod, gyorsan, az Nvidia elott, innovaltak."

Igen, megoldották ingyen, szoftverből, aminek az Nv-nél 200$-os pluszhardver kellett, ami még felsőkategóriás monitorok esetén is azért elég jól látható összeg. Ezt inkább tekintem innovációnak, mint az Nv akcióját... -

HSM

félisten

"Tényleg prémiumok voltak. ( árban is)"

Amikor végre kijöttek a FreeSync-es alternatívák, ugyanúgy használhattak prémium, széles tartományú panelt benne, és jópár gyártó meg is tette.#61563 Busterftw : "Nem keverem, mindketto Adaptive Sync-re epul"

Az adaptive sync-re épül szerinted az adaptive sync? Nincs több kérdésem.

Nincs több kérdésem."Nem "gyorsan" jott ki ezzel az Nvidia, mar csak a sajat hardveres modult kifejlesztese es gyartasa miatt sem volt ez lehetseges."

Persze, azért jöttek ki egy kutya közönséges Altera gyártmányú kész FPGA-val saját dedikált célhardver helyett, mert olyan régóta készült a boszorkánykonyhájukban.... [link] (forrás: [link] )

[link] (forrás: [link] )"A FreeSync Premium 2020-ban debutalt, olyan feature-rel amivel a G-Sync mar 5+ eve piacon volt."

Jó volna, ha befejeznéd a súlyos tárgyi tévedések tényként való feltüntetését...

Ugyanúgy 2015-től elérhető volt ez a technológia is, csak akkor még nem tartozott hozzá hivatalos certifikáció... [link]"A gond azzal van, hogy hiaba van ez a funkcio a Freesync monitorok tobbsege 48hz-tol mukodik."

Mint írtam, nem a legolcsóbb gagyi típusokat kell megvenni. Ez nem a FreeSync hibája, hogy a technikailag alkalmatlan monitoron nem tudnak bizonyos dolgokat megvalósítani. Egy épkézláb FreeSync monitor már egyébként régen is tudott legalább 48Hz-120Hz tartományt, amivel már működőképes az LFC. Régi G-sync monitorból sem véletlen nem voltak ilyen olcsó megoldások. -

HSM

félisten

"...tehát akkor a piacon másodikak voltak."

Igen. Nagyszerűen megosztva a monitor-piacot a saját inkompatibilis megoldásukkal épp a szabvány bevezetése előtt. Ez aztán az "innováció".Ami a csipletet illeti... Teljesen igaz rá az innováció, tudtommal korábban senki nem csinált hasonlót. Ami a koncepció mai hasznosságát illeti, valóban nem valami sok és biztosan megvan valahol máshol az ára. Ugyanakkor nem sokan számítottak arra, hogy ennyire vissza fognak esni a csip-eladások, és leapad az 5nm és korábbi gyártástechnológiák árkülönbsége. Egészen más lenne a csiplet megítélése egy jóval drágább, vagy telítődött kapacitású 5nm technológia mellett. Lásd pl. [link]

#61554 b.: Valóban vannak jó tulajdonságai, pl. a szigorúbb követelményrendszer. Ugyanakkor technikailag ezt nyugodtan megcsinálhatták volna a szabvány támogatásával is. A 200$-os kütyü úgy tudom, csak a frissítésfüggő OD megvalósításával tudott többet, mint a korai szabványos megoldások, amik picivel később megjelentek. De ezt implementálhatták volna szabványosan is, ha valakinek ez megért volna ennyi pénzt...

"az a mai napig is egyedülállóan széles tartományban működik, 1 FPS- től."

Ehhez nem kell G-sync. A széles tartományú szabványos monitorok is tudják, az AMD FreeSync LFC technológiájával (mai nevén AMD FreeSync™ Premium). Ugyanúgy 1FPS-től működik.

Lásd: "A display with LFC effectively results in the removal of the minimum refresh rate boundary. All displays in the FreeSync Premium and FreeSync Premium Pro tier are certified to meet mandatory LFC requirements." [link]#61555 Busterftw : "4 honapra ra CES-en az AMD bejelentette, hogy dolgoznak a FreeSyncen"

Szerencse, hogy nem kevered össze-vissza az AMD implementációját (FreeSync) az annak alapját képező VESA Adaptive sync technológiájával.

"...sot, a mai napig nem az, mert a legtobb FreeSynces monitor 48Hz-tol mukodik"

Ez is fals infó... Ezen sorokat is egy 48-144hz-es monitorról írom, ami LFC-vel tökéletesen szinkronizál akármilyen kevés FPS-re is, tapasztalatból mondom. Persze, nyilván a legolcsóbb, minimális tartományt tudó megoldások egy alap G-sync monitor árának negyedéből nem fognak tudni ilyet, de talán ezen nem kellene nagyon meglepődni. -

HSM

félisten

válasz

Busterftw

#61551

üzenetére

Busterftw

#61551

üzenetére

Oké, leírom akkor egyszerűbben. Miközben a lassú standardizálási folyamat zajlott az AMD javaslatára, ők gyorsan kihoztak egy gyorsan összelapátolt saját verziót, drágán, hogy még ebből is legyen némi extra profitjuk és úgy tűnjön, kitaláltak valamit, amikor notebookoknál már gyakorlatilag 2008 óta a szabvány része volt ez....

Ez nem innováció, hanem marketing + nem túl felhasználóbarát stratégia. -

HSM

félisten

"...továbbra sem látom, hogy mit innovál és miben jár saját(!) utat a cég. Örök másodhegedűs..."

Pedig bőven van náluk is, sőt. De valamiért nem tudják ezt megfelelően marketingelni, eladni. A kedvencem a G-sync esete volt, amit gyorsan kiadtak a zöldek, gyakorlatilag egy prototípus szintű megoldással, miközben az AMD azon fáradozott a VESA-n belül, hogy szabványos formában mindenki számára elérhetővé tegyék... Lásd pl. [link] -

HSM

félisten

válasz

Alogonomus

#61435

üzenetére

Alogonomus

#61435

üzenetére

Mivel RDNA3, dual issue képességet kapott, ami azonban korlátozottan használható ki. Papíron a 7900 is nagyon erős lett, vagy 60 Tflops, ugyanezen okból.

-

HSM

félisten

válasz

Alogonomus

#61403

üzenetére

Alogonomus

#61403

üzenetére

Viszont egy minőségi tápnál ráírva az van, ami a tartós terhelhetősége... Pillanatokra annál jóval többet is le illene tudni adniuk. Azért is írtam, fontos, hogy ne gagyi tápról beszéljünk....

-

HSM

félisten

Az alulfeszelt 6800XT sem épp túl torkos, a gyári 254W PPT helyett nálam UV-vel olyan 210-230W körül ilyen értékeket mértem konnektorból egy fogyasztási limitjétől megfosztott Ryzen 5600 mellett: [link] . Egy minőségi fogyasztásmérő hasznos egyébként optiálisan beállítani a hardvereket.

Arra kell még vigyázni, a fogyasztási tüskéket a gagyi tápok nem komálják, részben ezért is ajánlanak mellé a kelleténél erősebb tápot.

Arra kell még vigyázni, a fogyasztási tüskéket a gagyi tápok nem komálják, részben ezért is ajánlanak mellé a kelleténél erősebb tápot. -

HSM

félisten

Ez is pl. arra utal, hogy nem a metszésvizsgálat miatt lassú pl. az RDNA2 RT-je [link] .

A második bekezdésed nem tudom hova tenni, de biztos nem arra reagál, amiről beszéltem.

Azzal teljes mértékben egyetértek, hogy egy épkézláb API nagyon kéne, ami mindkét hardverre elég jó. -

HSM

félisten

Itt megint az a gond, hogy az RT nem csak Ray-triangle intersection vizsgálat... Jól néz ki papíron ez, de a gyakorlati haszna szvsz erősen kérdéses az alapján, amiket eddig láttam RT-s shader elemzések.

Abból is világos lehet, hogy pl. semelyik mai játék semelyik beállításán nem hoz a 3090Ti másfélszeres tempót a 7900XTX-hez képest, és a 4090 is legfeljebb csak dupla tempó, a 4X-esnek a közelében sincs. A 4090 esetén ezt rá lehet fogni az API-ra, a 3090Ti esetén viszont nem, hiszen a mai 1.1 DXR API kb. arra a hardverre íródott. -

HSM

félisten

válasz

kopi72

#61363

üzenetére

kopi72

#61363

üzenetére

Igazából ki és miért venne 200+ W-os, 20 Tflops-os VGA-t, ha 15W-ból, 2Tflops-al is elég lenne tizedannyi pénzből?

Ha a költői kérdés nem elég, nézd meg őket, kipróbálták: [link] . Szóval, medium/low 720P-n egész jól elfut pár hardverigényesebb cím is. Biztosan nagyon jól nézne ki egy 4K monitoron...![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

Dehogy javították, hogy is gondolhattam volna, hogy 2 hónap elég nekik erre a végtelenül komplex kihívásra...

Persze, mint írtam, a win10-emben mint alapértelmezett UI nyelv a magyar van beállítva, ugyanakkor azt gondolom, hogy ha angolra állítottam a drivert, akkor annak minden részének illene ezt követnie.... -

HSM

félisten

Az AMD arra apellált, hogy a jelenlegi rendszer meglehetősen korlátozó "black box", és mivel szerintük emiatt ez változni fog, így csak bizonyos részeket csináltak "hardveresen". Számomra ez egyébként szimpatikus, és a gyakorlatban láthatóan a nagyobb GPU-kon elég jól működő megközelítés, főleg RDNA3 esetén, de az RDNA2-es 6800XT-m is bőven megüti a használhatóságot RT-vel.

Ami még számomra rendkívül érdekes, hogy nem is ALU/RT vagy hasonló nyers erőforrások fogynak el bizonyos RT kódok alatt, hanem a regiszterek túlnyomása miatt aggasztóan kevés a párhuzamos munkafolyamat, ami miatt rossz a hardver kihasználtsága... Lásd pl. [link] .

Ezért is leszek igen nagyon kíváncsi, ha valaki esetleg PC-n kijön egy motorral, ami az AMD-féle megoldásra van optimalizálva, ott mit tudnak kihozni a konkurencia RT-s megoldásához képest. Az lesz az igazi tesztje, mennyire is jó valójában az AMD koncepciója.

-

HSM

félisten

És tegyünk ide mégegy változót, a "HW RT" is többféle lehet ám. Mert most DXR alatt kétféle van (DXR1.0 és 1.1), de ezek az Nv-féle működéshez vannak szabva, míg a Radeon szoftveres bejárása révén elérhető optimalizációkra így nincs lehetőség. Talán az új Snowdrop motort pletykálták régebben, hogy építeni fog erre az Amd saját RT Api-ján keresztül.

-

HSM

félisten

válasz

huskydog17

#61234

üzenetére

huskydog17

#61234

üzenetére

A 6nm is a 7nm családva tartozik, mégis látod remélhetőleg a különbséget és egyértelműen jó az elnevezés, senki nem is akarta soha 7nm+-nak hívni. Az Nv N4 viszont egy egyedi igények szerinti 5nm, nem 5nm+ vagy 4nm.

-

HSM

félisten

válasz

huskydog17

#61230

üzenetére

huskydog17

#61230

üzenetére

Igen. De a TSMC-nél az N4 a 4nm-es node-juk, míg az Nv 4N-je kb. sehonnan nem derül ki teljes biztonsággal, de elvileg egy testreszabott 5nm eljárás.

-

HSM

félisten

válasz

huskydog17

#61228

üzenetére

huskydog17

#61228

üzenetére

Csak a zöldeknek valamiért nem felelt meg az egyértelmű "TSMC 5nm" elnevezés, így a félreértések elkerülés végett gyorsan elnevezték "TSMC 4N"-nek.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

S_x96x_S

#61135

üzenetére

S_x96x_S

#61135

üzenetére

Egyébként ha nem a szénné hajtott OC-verziókat nézzük, akkor teljesen versenyképes a perf/watt: [link] .

Persze, azzal a kisbetűs résszel, hogy nyilván a hardveres bejárás miatt az RT energiahatékonyabb (is) lesz az RTX-eken, amíg ehhez van írva a DXR API és a játék is, ez egy átmeneti előnye a zöldek megoldásának. -

HSM

félisten

Egy szó: menedzsment.

Mire, és mennyi pénzt költenek. A 7900-ast el kellett volna pár hónappal csúsztatni, javítani a hardvert is, befejezni a drivert, és egy sokkal pozitívabb képpel lehetett volna nyitni vele mondjuk idén februárban.

Mire, és mennyi pénzt költenek. A 7900-ast el kellett volna pár hónappal csúsztatni, javítani a hardvert is, befejezni a drivert, és egy sokkal pozitívabb képpel lehetett volna nyitni vele mondjuk idén februárban.

Az AM5 ugyanez. Azt pletykálják, már megjelenés előtt voltak ilyen leégős esetek, és így kiadták, és hónapokig nem történt semmi... Én azért is maradtam még AM4-en, azért nem fogom kifizetni az AM5 igen vastag felárát, hogy még béta hardver tesztelő is lehessek. Fordítva kéne, nekik kéne nekem fizetniük, hogy kitesztelem a vackukat...

#61093 b.: Ez nem csak a gyártástechnológia volt.

A 6800XT/6900XT-k igen jó energiahatékonyságra lettek volna képesek, ha erre állítják be őket. Sajnos gyárilag csak a sima 6800 volt erre hangolva, látszott is az eredményein, az erős vágás ellenére is igen jó számokat hozott.

A 6800XT/6900XT-k igen jó energiahatékonyságra lettek volna képesek, ha erre állítják be őket. Sajnos gyárilag csak a sima 6800 volt erre hangolva, látszott is az eredményein, az erős vágás ellenére is igen jó számokat hozott. -

HSM

félisten

"Itt lassan már tényleg az lesz a kérdés, hogy az AMD ne még szarabb kártyákkal jöjjön ki, mint az NVIDIA."

Azért én ennyire nem látom borúsnak a helyzetet.

"mert a Zen 4 rohadtul nem bírja kezelni a hipergyors memóriákat meg szétég a chiplet"

És nem is kell neki, mert mint látható a tesztekből, egy 7800X3D "lassú" 6000Mhz memóriákkal, 8 maggal is fele fogyasztásból lelépi a konkurencia 24 magos csúcsmodelljét, és a sima modellek teljesítménye is több, mint kielégítő. A chiplet szétégése pedig vélhetőleg rengeteg hiba szerencsétlen együttállásának következménye, amit remélhetőleg mihamarabb javítanak majd AGESA/BIOS oldalról. Sajnos az AM5-öt sikerült egy bughalmazként piacra dobni, ahogy az RDNA2-3 szoftveres oldalára is ráférne egy komolyabb rendberakás, pl. egy épkézláb működésű, értelmes módon használható WattMan piszokul kellene. Ez a rengeteg bug, bénázás és szoftveres kiforratlanságok szerintem sokkal több vásárlót riasztanak el, mint a hardvereik teljesítménye, ami alapvetően rendben lenne.

Ez a rengeteg bug, bénázás és szoftveres kiforratlanságok szerintem sokkal több vásárlót riasztanak el, mint a hardvereik teljesítménye, ami alapvetően rendben lenne. -

HSM

félisten

Elég hasonló FPS-eket tud elvileg RT-vel a CP2077, mint a Witcher3. Persze, a friss Overdrive mód Path Tracing-el nyilván durvább, és elvileg a Portal is az, ha nem tévedek. Egyébként a Portal hardver kihasználása borzalmas rossz, illetve nyilván az Nv-s eszközökkel készült portok az ő technológiájukat fogja előnyben részesíteni. Itt még várnék picit a konklúzió levonásával, kb. mint ahogy a 20+GB-ot fogyasztó játékokat is kizárnám a VRAM témából. Az RDNA2-3 extra RT-s képességeit jelenleg csak a konzolok használják (programozható bejárás), személy szerint ebben is látok némi kihasználatlan lehetőséget.

-

HSM

félisten

A 3080 (Ti) 12GB-nak az ára volt gáz. A 12GB-ra azt mondom, már rendben van, tekintve a kártya korát. A 10GB viszont nagyon gáz volt az elején, még a mai szemmel kedvezőnek ható kezdő 700$ MSRP-ért is.

Nézd, a "lehetne picit erősebb RT ben 1-2 címben" a gyakorlatban azt jelenti, hogy pl. a Witcher 3 RT, ami az egyik legdurvább RT-terhelésű játék, kénytelen voltam levenni 1188P-re, hogy csont maxon FSR és hasonlók nélkül meglegyen bő 30 FPS. Mivel vajsima bő 30 FPS, így Radeon Anti-laggal tökéletesen játszható és élvezhető alacsony input laggal. Ellenben mikor a 10GB kezd kifogyni, akkor sem vajsimaságról nem beszélhetünk, a kimaradozó vagy rossz minőségűekkel helyettesített textúrákról nem is beszélve.

Ezt nem ellensúlyozza, hogy Witcher3-ban lenne mondjuk 30%-al magasabb FPS-em, mert ott épp van RT és ez fekszik a 3080-nak. Jó lesz majd utódnak egy 7900 később, alig kerül többe, mint egy 12GB-os 3080.

Ezt nem ellensúlyozza, hogy Witcher3-ban lenne mondjuk 30%-al magasabb FPS-em, mert ott épp van RT és ez fekszik a 3080-nak. Jó lesz majd utódnak egy 7900 később, alig kerül többe, mint egy 12GB-os 3080."messze elmarad mind RT ben mind felskálázási minőségben az Ampere szériától"

Ezzel a felskálázási minőséggel kábíts kérlek mást, teszteltem Witcher3-ban az FSR-t és a DLSS-t is legmagasabb minőségben (friss verziók voltak benne), ezeket a homályosító csillámporos vackokat inkább meghagyom másoknak, nem vagyok híve a kamu magas felbontásnak. Ami meg az RT-t illeti, egy RTX 3070 sebessége általában megvan vele, így 16GB-al teljesen jó a mindennapokban. A sima 12GB-os OC 3060-amat körbefutotta Witcher3 RT-ben, annyira, hogy az DLSS-el sem érte utol, szóval azért annyira messze nem marad el ebben sem.

Ami meg az RT-t illeti, egy RTX 3070 sebessége általában megvan vele, így 16GB-al teljesen jó a mindennapokban. A sima 12GB-os OC 3060-amat körbefutotta Witcher3 RT-ben, annyira, hogy az DLSS-el sem érte utol, szóval azért annyira messze nem marad el ebben sem.

Pedig hidd el, nagyon tetszett volna, ha a feleannyiba kerülő kártya DLSS-el utolérte volna RT-ben, akkor most az lenne a játékos gépemben, nem a 6800XT.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

Busterftw

#61013

üzenetére

Busterftw

#61013

üzenetére

Pár példa, marha vicces. Ilyet egészen biztosan nem szeretnék egy 600$-os VGA-tól... [link]

De ez sem valami szép [link] .

De ez sem valami szép [link] .

Aki 1, max 2 évre vett 3070/3080-at annak nem volt baj, de aki kicsit hosszabb távban gondolkozik, annak tökéletes volt a 6800-900-as széria a 16GB-al. Nem túlzó, épp megfelelő. Én több, mint 2 éve vettem a 6800XT-m, és egyáltalán nem bántam meg, hogy ezt választottam. 1440P kimaxolt RT-hez néha 1-2 címhez lehetne kicsit erősebb, ez vele az egyetlen kifogásom, amiért egyáltalán felmerült bennem idén a 3080 12GB, amit aztán gyorsan el is vetettem.

Én több, mint 2 éve vettem a 6800XT-m, és egyáltalán nem bántam meg, hogy ezt választottam. 1440P kimaxolt RT-hez néha 1-2 címhez lehetne kicsit erősebb, ez vele az egyetlen kifogásom, amiért egyáltalán felmerült bennem idén a 3080 12GB, amit aztán gyorsan el is vetettem.

#61016 Busterftw : Sok minden függvénye. Nem mindegy, milyen motor, mekkora textúrák, az RT is elvileg kér, most bejött a DirectStorage, elvileg annak is kell majd...

-

HSM

félisten

válasz

Busterftw

#61011

üzenetére

Busterftw

#61011

üzenetére

Szvsz ez már a megjelenésük idején is borítékolható volt, hogy a 3070 és a 3080 is igen szűkös VRAM-ból a teljesítményéhez és árához képest, korrektebb review-ok meg is említették. Nekem ezek miatt fel sem merültek soha. 3080 12GB-on azért volt, hogy elgondolkoztam, de maradt végül a 6800XT.

-

HSM

félisten

válasz

Yutani

#60981

üzenetére

Yutani

#60981

üzenetére

"Van egy lila hajú lány is az egyik képen, ahol mindegyik upscaling sz@rul néz ki"

Éppen ez a baj az upscaling-ekkel, a hiányzó részleteket egyik sem tudja elővarázsolni... Egy egyszínű falon meg nyilván egyik sem fog rosszul teljesíteni.

#60980 Petykemano : Azért azt is meg kellene nézni, melyik eljárás mekkora erőforrásigényű. Épp a kézikonzol, stb miatt lehet más az ideális működése pl. az FSR-nek, mint a többinek (energiaigény a célzott hardvereken).

-

HSM

félisten

válasz

S_x96x_S

#60945

üzenetére

S_x96x_S

#60945

üzenetére

"Ott nyilvánvalóan valami probléma van .. "

Minden jel arra utal szvsz, hogy az RDNA3-al lehet(ett) valami gubanc.

Érthető lépés lenne, ha a Navi31-nél felmerült esetleges gondokat már kijavítsák a később érkező változatokban. Főleg, hogy pl. egy mainstream APU, vagy egy mainstream-ebb GPU (Navi32) sokkal szélesebb piaci réteghez jut el. Ezt erősíti, hogy február végén már csökkentett GPU-órajelek szerepeltek a specifikációban... [link] -

HSM

félisten

válasz

Petykemano

#60926

üzenetére

Petykemano

#60926

üzenetére

Nem tartom elképzelhetetlennek, hogy látva a konkurenciát, hozzácsapjanak 10CU-t, hogy versenyképesebb legyen. Már az első pletykáknál kicsit keveselltem a 60CU-t a beharangozott célokhoz.

Még így is bőven elég pici lenne a gazdaságos gyárthatósághoz. Inkább a csipletelés tűnik problémának, hiszen bonyolítja a gyártást, miközben kellően olcsó lett az 5n, hogy ebben a piaci környezetben túl sok haszna ne legyen. -

HSM

félisten

válasz

Petykemano

#60923

üzenetére

Petykemano

#60923

üzenetére

60 helyett 70 CU-val megpaprikázva szerintem elég ütős lenne a Navi32.

-

HSM

félisten

válasz

DudeHUN

#60904

üzenetére

DudeHUN

#60904

üzenetére

Engem különösebben sosem zavart, ha mondjuk csak 60-100FPS-el ment a 144Hz monitorom, annyira pedig főleg nem, hogy extra késleltetést és képhibákat is bevállaljak miatta. De akkor úgy tűnik, vannak akiknek van erre igénye így is.

#60905 PuMbA : Hű, de boldog lennék, ha a gyors, gamer 144Hz IPS monitorom csak a közelében lenne a 120Hz AMOLED-nek a mozgáskövető képességéhez, ami a telefonomban van...

A mai átlag monitortechnológiáknál az a gond, hiába gyors, hiába 120 vagy 240Hz, keni a képet mozgásnál akárhány FPS-el hajtod.

A mai átlag monitortechnológiáknál az a gond, hiába gyors, hiába 120 vagy 240Hz, keni a képet mozgásnál akárhány FPS-el hajtod.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- ÁRGARANCIA!Épített KomPhone i5 12400F 16/32/64GB RAM RTX 3060 12GB GAMER PC termékbeszámítással

- Apple iPhone 13 Mini 128GB,Újszerű,Dobozával,12 hónap garanciával

- HP Elitebook 735 G6 13 3 FHD Laptop AMD Ryzen 5 Pro 16 GB RAM 512GB SSD 6 hónap garanciával

- Corsair T3 RUSH gamer, irodai szék

- Samsung Galaxy A50 128GB, Kártyafüggetlen, 1 Év Garanciával

Állásajánlatok

Cég: ATW Internet Kft.

Város: Budapest

Cég: BroadBit Hungary Kft.

Város: Budakeszi

Szerintem az összes ilyen feature úgy alapból használhatatlan, felskálázás, frame generation, akár piros open source, akár zöld Ai csoda. A kényszer szülte, hogy olyan beállítások is kevésbé legyenek játszhatatlanok, amik egyébként az adott GPU erejének nem felelnének meg. Aminek értelme van, az egy megfelelő felbontású monitor, hozzá egy megfelelően erős VGA, és a monitorba egy kellően erős és széles adaptív sync képesség. Az jó mozgásélményt ad, kamu képkockák és idegesítő artifactok nélkül is.

Szerintem az összes ilyen feature úgy alapból használhatatlan, felskálázás, frame generation, akár piros open source, akár zöld Ai csoda. A kényszer szülte, hogy olyan beállítások is kevésbé legyenek játszhatatlanok, amik egyébként az adott GPU erejének nem felelnének meg. Aminek értelme van, az egy megfelelő felbontású monitor, hozzá egy megfelelően erős VGA, és a monitorba egy kellően erős és széles adaptív sync képesség. Az jó mozgásélményt ad, kamu képkockák és idegesítő artifactok nélkül is.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Az RDNA3-nak teljesen jó a bontása egy első generációs chiplet megoldásnak, a bő 300mm²-es GCD mellett sikerült leválasztaniuk bő 200mm²-nyi lapkaterületet 6db apró, régebbi technológián gyártható chipletbe. Ha jól látom, gyakorlatilag a 3. verzió a COPA-ábrádon, egy "monolitikus" GCD, mellé külön leválasztva az L3 és a memóriavezérlő.

Az RDNA3-nak teljesen jó a bontása egy első generációs chiplet megoldásnak, a bő 300mm²-es GCD mellett sikerült leválasztaniuk bő 200mm²-nyi lapkaterületet 6db apró, régebbi technológián gyártható chipletbe. Ha jól látom, gyakorlatilag a 3. verzió a COPA-ábrádon, egy "monolitikus" GCD, mellé külön leválasztva az L3 és a memóriavezérlő.

Miközben ez csak erre a GPU-ra igaz, mivel összehasonlítva az RDNA2-vel (RX6600XT) ugyanakkora maradt a CU regiszter mérete (RT-nél ez komoly hátrány lehet), valamint ugyanúgy 32MB az L3. Ezáltal kb. csak a dual-issue képesség és az új RT megvalósítás hasznának egy részét mérik ezek ki, ami csak egy része az újításoknak, és nyilván az 5nm használata is kimaradt.

Miközben ez csak erre a GPU-ra igaz, mivel összehasonlítva az RDNA2-vel (RX6600XT) ugyanakkora maradt a CU regiszter mérete (RT-nél ez komoly hátrány lehet), valamint ugyanúgy 32MB az L3. Ezáltal kb. csak a dual-issue képesség és az új RT megvalósítás hasznának egy részét mérik ezek ki, ami csak egy része az újításoknak, és nyilván az 5nm használata is kimaradt.

Sokkal inkább szerecséje volt, hogy igen hamar olcsó lett az 5nm, így az AMD nem tudta kihasználni a chipletezésből származó előnyöket a Navi31-32-nél, és így az Nv büntetlenül gyárthat ormótlan nagy 5nm GPU-kat, mint pl. a 4090-esé, 609 mm²-el. Volt, amikor nem jött be ez a taktika, abból lettek pl. a Fermi-s mémek, mint pl. ez a gyöngyszem:

Sokkal inkább szerecséje volt, hogy igen hamar olcsó lett az 5nm, így az AMD nem tudta kihasználni a chipletezésből származó előnyöket a Navi31-32-nél, és így az Nv büntetlenül gyárthat ormótlan nagy 5nm GPU-kat, mint pl. a 4090-esé, 609 mm²-el. Volt, amikor nem jött be ez a taktika, abból lettek pl. a Fermi-s mémek, mint pl. ez a gyöngyszem: