Új hozzászólás Aktív témák

-

-

Abu85

HÁZIGAZDA

Olvasd el a linkelt hírt.

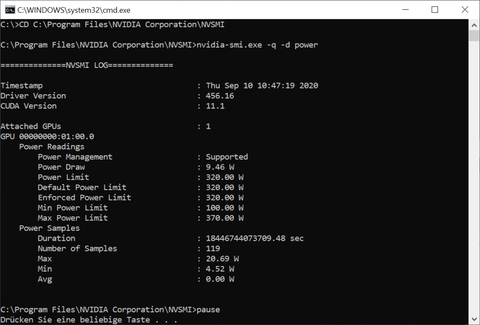

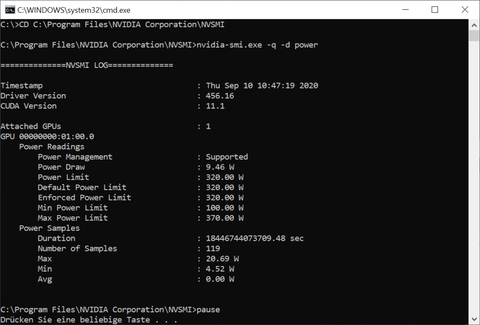

[link] - de itt is leírtam, hogy milyen változásokat hozott a driver. TL;DR: a problémás dizájnok ID-jét azonosítja és nem engedi 2010 MHz fölé, az összes dizájnra pedig bevezeti a gyorsabb órajelváltást. Gyakorlatilag 60-75 MHz-es szintekben pattog oda-vissza. Azért nem látod, mert a driver kiolvasási mechanizmusa másodpercen kívüli, míg a belső rendszer órajelváltása másodpercenként 100-szor is megtörténik. És az NV még ma sem számol átlagos órajelet a kiolvasási mechanizmusra, tehát alapvetően nagyjából ~100 órajelváltást nem lát a kiolvasási mechanizmus.

Amikor ilyen gyorsan kezd órajelet váltani egy hardver, akkor már nem elég az aktuális értéket kiolvasni, be kell majd az NV-nek is vezetnie, amit az AMD alkalmaz, hogy a hardver maga átlagolja a beállított órajeleket, és így a kiolvasási mechanizmus kap némi segítséget.

-

nexplo

őstag

Benéztem a topikba, mert kósza gondolataimban felmerült egy 3*** kártya vétele de úgy látom megy a vita a félig üres félig teli poháron. Minden gyártó kapkod és hasznot akar. Szerintem csak később (vagy igazán sosem talán) fog kiderülni hogy mi volt a 100% hibaok. Az NV most tarol, ez nekünk vevőknek rossz ,mert nincs piaci verseny épp ezért horror drágák az NV csúcs kártyái. Az AMD válasza (ha lesz egyáltalán megfelelő) akkor ezen a helyzeten javíthatna. Én mint leendő NV vásárló ezért is őrülnék a bignavinak

Azt ki tudom jelenteni hogy amelyik haver vett most 3080 karit annál nem jött elő hiba. Hozzáteszem mind már "javított" verzió volt pedig elsőként kapták az országban kb. Egyszóval nem egyszerű ez az egész kérdéskör

-

Kansas

addikt

Nem biztos, hogy az interferencia a kérdés, Igor's Lab szerint pl a fogyasztási csúcsok okozzák a galibát - ami ugye szorosan összefügg az órajellel és konzisztens azzal is, hogy miért a csúcson jön elő.

-

ez igazán értelmezés kérdése hogy a kondi vagy az órajel. igazából azért a kondiösszeállítás, mert bizonyos órajelen interferencia keletkezik ezért hiába bírna a kártya még pár Mhz-t crashel helyette.( nem értek hozzá, csak olvastam azoktól akik értenek, szóval vitatkozni ebben nem tudok

)

)

Az most más téma vagy inkább szerencse, hogy ez már a GPU elérhető ( ha elérhető egyáltalán neki) teljesítményének az utolsó százalékaiban megy, és így driveresen tudták orvosolni,de nem tudom hogy mi lett volna hogy ha ez éppen egy közép tartományú órajelen adódik, mondjuk 1860 MHz-nál. ( azt sem tudom ilyen előfordulhatott volna e,de most úgy gondolom , hogy igen.) -

Kansas

addikt

Attól függ, mi nálad a hiba definíciója.

Szerintem jelentősen a gyári specifikációk fölött járatva hibát előhozni nem tartozik ezek közé - a hivatalos 3080 boost órajel 1,71GHz, ez a "hiba" pedig 2GHz fölé jutva jön elő...Ha megnézed a Hardware Unboxed videóját, ott elmondják, hogy nekik és másoknak is előjött a hiba olyan kondi setuppal is, ami nem az Igor's Lab szerint "rosszul tervezettek" közé tartozik. Ebből nekem az jön le, hogy nem a kondik okozzák, hanem a túl magas órajel.

-

válasz

#92116480

#82

üzenetére

#92116480

#82

üzenetére

vagy azért mert marketing értékkel bír az, hogy nem a navi 2 váltja le a 2080 Ti-t hanem a saját kártyájuk...

Itt leírtam ezt már szerintem miért kapkodtak : [link]Kansas :

bár örülök, hogy megvádoltak hogy Nv fan vagy

de azt hozzá kell tennem hogy hardveres hiba miatt kellett módosítani a drivert. Leszabályzással működik most, szerencsére nem érezhető különbséggel, max mérési hibahatárral kimutatható.Pug :

nem volt az 220 ra tervezve. Nagyon sok gyártó pl MSI eleve nem alkalmazta az FE 370 wattos max power limitjét , hanem 350 wattra szabályozták BIOS ban.nem is volt 2000 Mhz fölött igazán sehol,de mégis gyorsabb 3-5 % kal mint az FE a hűtés miatt. -

Igen, 3rd party gyartok azert voltak kenytelenek bizonyos verziokat visszatartani es attervezni, mert a driver a hibas...

Az eredetileg tervezett max boost clock-ot bizonyos CAP kombinaciok (nV ajanlott varioaciok) nem vettek hibamentesen, ezt orvosolta driverrel alacsonyabb max boost clock-kal az nV.

Hogy az autos hasonlatoddal eljek (btw legaszarabb analogiak IT vonalra), itt 220 volt a tervezett, de csak 190-et bir...

-

Kansas

addikt

válasz

-Skylake-

#87

üzenetére

-Skylake-

#87

üzenetére

A többi volt marhaság... ha szerinted nem, támaszd alá pls.

Az kb. tény, hogy az NVidia elkapkodta az Ampere kártyák rajtját úgy driver mint készlet szempontjából. A miértet nem tudjuk.

Azt sem tudjuk, az AMD miért vár ennyit az RDNA2 kártyák bejelentésével... lehet hogy azért mert a fejlesztés és/vagy gyártás le van maradva... lehet, hogy ők nem akarják elkapkodni, lehet hogy így is el lesz kapkodva, csak nem tudnak már tovább várni nézve ahogy az NV letarolja(tarolná, ha lenne elég készlet) a piacot...Csodát én se várnék, ha a 3080-nak érdemben ellenfelet tudnak állítani, én már elégedett leszek...

A módosításaidra:

1. a 3080 továbbra sincs közel sem kétszeres erejű a 2080-hoz képest, max 2x2070S-t tud, ami meg... na ugye.

2. a 3090 nem játékos kártya, megírta kb. minden komolyan vehető reviewer, csak azért tűnik annak, mert nem sokkal drágább(elméletben, persze), mint a 2080Ti volt megjelenéskor(meg a neve miatt) -

-Skylake-

addikt

Értő olvasás ? Én nem arról beszéltem, hogy melyik kártyának melyik a párja , én arról beszéltem, hogy a radeonnak melyik a legnagyobb kártyája és az nvidianak melyik a legnagyobb. Az 5700XT az elérhető legnagyobb radeon ? Igen. Ha a kövi kártya szó szerint megduplázza a teljesítményt akkor kapunk egy 2X2070 Supert. Ami nemhogy a 3090-et nem éri utol , de még a 3080-at sem. És ez az az eset , amikor konrkétan 100%-al erősebb az új kártya. Ezért nem értem , hogy milyen hatalmas félelemről van itt szó. Az már önmagában csodálatos lesz , ha a radeonnak a 3080-ra lesz egy válasza , azt szerintem senki nem gondolhatja komolyan , hogy a 3090-re lesz.

-

Kansas

addikt

válasz

-Skylake-

#85

üzenetére

-Skylake-

#85

üzenetére

Azért marhaságot ne írjunk már, az RX5700XT egy 400 USD kártya volt, annak az NV oldali párja az RTX2070, aminél a Radeon erősebb is, illetve a 2070Super, amivel meg jelenlegi driverek mellett pariban van.

Hogy a BigNavi mit fog tudni, arról majd 28-án lesz némi fogalmunk.A pletykák arról szóltak, hogy CU-számban duplája lesz az 5700XT-nek, de ahhoz még az IPC- és az órajel-viszonyokat is tudni kéne, hogy valódi teljesítmény-viszonyokra lehessen következtetni.

A 3080 teljesítménye pedig nem duplája a 2080-nak, átlag 50-70%-ot ver rá... ~50%-ot 1440p-ben, ~70%-ot 4K-ban

-

-Skylake-

addikt

válasz

#92116480

#82

üzenetére

#92116480

#82

üzenetére

Jelenleg a legerősebb aktuális konzumer radeon az a 5700XT. Azt a kártyát a vele aktuális 2080 Super (direkt nem említem a TI-t) gyakorlatilag szarrá verte. Most a 3080 (3090-et direkt nem említem) ~ 2X2080-nak felel meg. Megmagyaráznád kérlek, hogy mire alapozod azt a feltevésed, hogy az nvidiának valamitől "nagyon félni kellett" ezért volt gyors a start ? Ha az AMD csinál egy kártyát ami 100%-ot ver az előző csúcskártyájukra , még akkor sem érték be az nvidia második legnagyobb kártyáját , nemhogy a legnagyobbat.

Kérlek prezentáld már nekem, hogy miből gondoljuk , hogy az új radeon majd szétalázza a piacot. Tényleg érdekel, mert én még semmi olyanba nem futottam bele a bignavi-val kapcsolatban amiért azt kellene gondolnom, hogy októberben új időszámítás kezdődik a vga piacon. -

Kansas

addikt

OK, feladom, elismerem, hogy a te elméleti világodban élve ez egy potenciális teljesítmény csökkenés.

Cserébe ismerd el, hogy ez a csökkenés nem a gyakorlati órajeleket érinti, hanem az elméleti maximumot, ahol az idő érdemi részében eddig sem üzemeltek ezek a kártyák.

A teljesítményt nem MHz-ben mérik, hanem fps-ben, netán Watt-ban... utóbbi valóban csökkent, valamivel 1% feletti mértékben.A hibajelenséget pedig az okozza, hogy a kezdeti driver engedte a kártyákat nem stabil órajelre boostolni időnként.

Az NVidia specifikációi szerint az RTX 3080 boost clockja 1,71 GHz. A hiba mennyinél jön elő?

Szóval de, driver probléma, azt az órajelet eleve nem szabadott volna elérnie a kártyáknak.Pusztán a tárgyilagosság kedvéért.

-

Felteszek egy egyszeru, eldontendo kerdest.

Csokkent a kartyak maximalis elerheto clock speed-je?

Igen, vagy nem?

Ha ezt megvalaszoltad es tisztaban vagy azzal, hogy a hibajelenseget mi okozza, akkor egyreszt nem irsz akkora baromsagot, hogy a hiba "driveres" volt es azt sem, hogy nulla maximalis teljesitmeny csokkenessel ertek el a problema orvoslasat.

Arra mar nem mondok semmit, hogy 1-2%-os max orajel csokkentes mellett miert is varsz szazalekokban erezheto teljesitmeny visszaesest. Mondom, szakmai targyilagossag,

Facts:

HW fault mitigated by SW, close to zero (but not zero) loss of maximum performance

-

Kansas

addikt

Ha nem tudod, mi az a statisztikai hibahatár, akkor te csak képzeled magad szakmai fórumozónak... tényszerűleg.

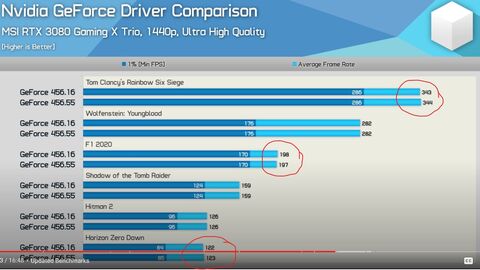

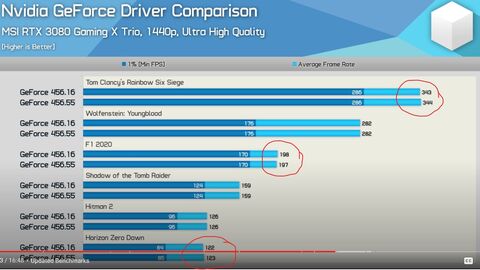

Tessék, a statisztikai hibahatár másik oldala(HU), ezek szerint gyorsult:

Az pedig, hogy nem lehetett több órányi játék után se reprodukálni a problémát üzembiztosan, azt jelzi, hogy az idő nulla egész soknulla kevés százalékában ment fel a "biztonságos" boost órajel fölé.

Magyarul az idő 99,99999...%-ában eleve nem ment annyit a kártya. -

Kansas

addikt

válasz

#92116480

#73

üzenetére

#92116480

#73

üzenetére

Write only?

NEM vették lejjebb a teljesítményt!

Nézd már meg a linkelt videót, van ott teszt is - a teljesítmény-különbség mindenhol a statisztikai hibahatáron belül változott, esetenként fölfelé - a 6 mért esetből 3-ban változatlan, egy esetben csökkent az fps, két esetben pedig nőtt. 1-1 fps különbségekről beszélünk százas nagyságrendű fps-értékek mellett.

A fogyasztás minimálisan csökkent...Az más kérdés, hogy ezeknek a kártyáknak közel nulla a stabil átlagos tuningpotenciálja, de azt meg meg kell szokni, az új turbó-működés bevezetése óta ez mindkét gyártónál kb. így van, és nem is valószínű, hogy jelentősen változni fog...

A másik oldalról nézve: a kártyák alapműködésben kihoznak mindent a GPU-ból, amit lehet, gyakorlatilag helyetted megoldják a tuningot, garanciálisan.

Akinek a kedvenc játéka a tuning, az kb. így járt, mindenki másnak ez jó hír. -

Kansas

addikt

No, kiderült, hogy az egész "csak" driver-probléma volt, hiába izgult mindenki rá a kondenzátorokra.

Mivel volt aki letesztelte Linuxon is, és ott semmi hasonló nem jött elő, ráadásil az új driverrel Windows-on is megoldódott, nyugtázhatjuk tán, hogy felesleges volt a kialakult hisztéria, bár a hype és beszerzési mizéria után nagyjából várható volt, hogy bármi probléma lesz, az is túl lesz tolva... és tényleg... -

Kansas

addikt

válasz

MeszesKPT

#69

üzenetére

MeszesKPT

#69

üzenetére

Ez az "early adopter" olyan szép eufemizmus... kár, hogy az esetek egy jelentős részében egyszerűen neofíliásokat és konzumidiótákat takar. A cégek meg kiszolgálják őket, naná, hülyék lennének nem megszabadítani őket a pénzüktől...

Aki meg nem konzumidióta, hanem valódi early adopter, az pedig tisztában van ennek a velejáróival és azok tudatában dönt a beszerzésről. -

Ragnar_

addikt

válasz

#72042496

#51

üzenetére

#72042496

#51

üzenetére

"Nekem ez azért kusza, mert a specifikációban 1,71 GHz boost clock szerepel, itt pedig ilyen 2 GHz körüli értékekről van szó."

Csakhogy az AIB verziók általában egyedi hűtéssel, és némileg magasabb boostfrekikkel jelennek meg. Igazából gond akkor van, ha nem tudja a dobozra írt boost frekiket. Mert egyébkén akkor azt is reklamámhatnák, hogy 2500MHzen el se indul a kártya. Manuális OC-re többnyire nincs garancia.

-

válasz

SindaNarmo

#66

üzenetére

SindaNarmo

#66

üzenetére

igazából a kártya alap default power TDP-je 320 watt és van egy úgynevezett max power limit ameddig felmehet boost közben ha a hőmérsékletek is még megfelelőek. Ha felmegy 370 W ig akkor kezd el csak leszabályozni az órajelből ha a GPU hőmérséklet sincs leszabályozási határon. Gondolom ez több dolgotól függ, felbontás ,tensor magok működése,stb,mennyire van leterhelve a GPu .

Az FE kártyán 370 Watt a max power limit az MSI gamingon pedig például 350 W pedig 3x8 a tápcsatija ami kicsit érthetetlen számomra.

Így néz ki a 3080 FE BIOS TDP beállítása :

kíváncsi vagyok hogy ez most módosúlt e a tegnapi BIOS-sal más gyártóknál. -

SindaNarmo

tag

Akkor az nem rossz.

Még az előzőre reflektálva, nekem az is kicsit furcsa, hogy nem az az irány vonal, hogy itt ez a kártya ezen max boost Mhz-en ekkora a TDP-je és pont. Utána már kézi OC van.

Ezzel ellentétben itt az van hogy mint írtad is 350W-ig megy el, de akkor a gyári értékeken pl 280W.

Szóval akkor mért nem a gyári értékeket lövik be úgy hogy nagyobb legyen a TDP és akkor lesz egy 3xx W-os kártya, mert ez így egy 280W-os kártya ami automatikus OC-val fölmegy egy határig. Amit most nem minden kártya bírt.

Megjegyzem az értékek amit használtam, hasra ütéssel keletkeztek, csak szemléltetés céljára

-

válasz

SindaNarmo

#63

üzenetére

SindaNarmo

#63

üzenetére

-

válasz

SindaNarmo

#63

üzenetére

SindaNarmo

#63

üzenetére

Igen ilyesmi de elméletileg a TDP ad neki határt. Pl MSI nél a max 350 W míg a gyárin 370.nem a kártyák hajtják túl magukat, hisz erről szól az előző cikk is, A GPU és a VRM bírná , vannak 2100 MHz körül hasító 3080 karik is,de a kondik összeállítása érzékeny bizonyos frekikre ha jól értettem a profikat és ez jelent néhány esetben gondot. de azok az öszeállítások sem gagyibbak minőségre. Ha rosszul mondom akkor bocs, abszolút laikus vagyok, csak olvasgatom mostanában azért a híreket és ezt tudtam leszűrni.

-

SindaNarmo

tag

Egyetértek. Nincs azzal gond.

Ezzel még mindig baromi jó a teljesítménye a kártyáknak.Nekem inkább az a furcsa, hogy van egy olyan funkciója hogy kvázi a gyári megadott érték fölött boost-ol addig ameddig bír és nincs / legalábbis én nem találtam hogy le lenne írva hogy ezt meddig teheti meg (igaz annyira azért nem erőltettem meg magam).

Ebből nekem az jön le, hogy egyes kártyák túl hajtják magukat, amit simán meg tudtak volna előzni azzal amit most csináltak. (vagy benne lenne a spec-ben hogy hol a határ) -

Khelben

nagyúr

Ha ezt a teljes képernyős magenta színt nem veszitek le, visszakapcsolom a reklámblokkolót. Kiég a szemem tőle.

-

válasz

SindaNarmo

#56

üzenetére

SindaNarmo

#56

üzenetére

ahogy olvastam 2 GHz fölé nem engedik, a gyári az 1,7 GHz szóval így is engednek tuningot . szval ha 1,9 körül lekorlátozzák azzal sem vesznek ki nagyon senkineka zsebéből teljesítményt.

-

SindaNarmo

tag

válasz

-Skylake-

#59

üzenetére

-Skylake-

#59

üzenetére

Nem kell hogy meg álljon (addig biztos hiba mentes), de 2025MHz-nél se legyen hiba.

Igazából arra vonatkozott az a kijelentés hogy nincs a specifikációban benne, csak az van hogy boost frekvencia az 1,71GHz. És a fölött nincs infó hogy automatikusan meddig megy, vagy legalább is én nem láttam. Mennyivel egyszerűbb lett volna ha azt mondják hogy max 2GHz és még a hiba sem jött volna elő.

Vagy akár magát a boost határt feljebb vinni. -

-Skylake-

addikt

válasz

SindaNarmo

#54

üzenetére

SindaNarmo

#54

üzenetére

Miért álljon meg 1,71ghz-nél ha a hiba 2025mhz-nél jelentkezik ?

-

SindaNarmo

tag

válasz

#72042496

#57

üzenetére

#72042496

#57

üzenetére

Egyetértek veled, ez lenne jogos.

Alapvetően nem lett volna itt gond még így sem, ha pl alapból ez a korlátozás meg lett volna adva, ki sem derült volna hogy bizonyos kártyák nem bírják.

Mert az már megint más amikor szándékosan OC-znek az előbb utóbb instabil lesz, max rá lett volna mondva hogy nem igazán lehet tuningolni és kész. -

#72042496

törölt tag

válasz

SindaNarmo

#56

üzenetére

SindaNarmo

#56

üzenetére

Ez alatt azt értem, hogy specifikáción felüli. Szerintem tisztább lenne ha vagy 1,71-ig mennének a kártyák, vagy magasabb frekvenciát írnának a specifikációba is.

-

SindaNarmo

tag

-

#72042496

törölt tag

Nekem ez azért kusza, mert a specifikációban 1,71 GHz boost clock szerepel, itt pedig ilyen 2 GHz körüli értékekről van szó.

-

Hát ez eléggé nagy szégyen egy ilyen felső kategóriás drága kártyánál.

-

#52931072

törölt tag

válasz

-Skylake-

#43

üzenetére

-Skylake-

#43

üzenetére

Az inkább azon múlik, hogy egy 3080 kategóriájú kártyából eladnak- e eleget világszerte, hogy érdemes legyen pénzt feccölni egy konkurens kifejlesztésébe. Az igazán nagy darabszámok hozzák a pénzt, az meg desktop fronton szerintem a 2060- tól lefele van (jövőre gondolom 3060 lesz az erős közép) és oda ziher lesz versenyképes cuccuk. Azt ők is le tudják játszani, hogy kiglettelik tranyókkal az egész nyákot aztán rátesznek 4x8 tápcsatit.

Ami meg az amd “ hozzáállását” illeti, 20 éve cserélgetem a karikat geforszt radeonra és vissza. Tapasztalatom szerint kb öt éves váltásban mindkét oldal próbál átcimkézett cuccokat ránksózni, ez a profit maximalizálás nevű varázslat, minden piaci szereplő használja. -

válasz

#09256960

#39

üzenetére

#09256960

#39

üzenetére

A tesztek alaporajeles kártyákkal készültek. Az hogy most nem engedik 2000 MHz fölé boostolni az első szériás kártyákat nem fog nagyon befolyásolni semmit az eredményeknek azt gondolom, főleg hogy van olyan összeomlott kartyatipus aminek másik példánya 2100 MHz re is felmegy.

-

-Skylake-

addikt

válasz

#09256960

#39

üzenetére

#09256960

#39

üzenetére

Ismerve az AMD hozzaallasat a piachoz, szerintem ezen nem kell elore aggodni. Hozzateszem sajnos, de ettol meg igaz. Nagyon nagyon (NAGYON) meglepodnek, ha a Big Navi akarcsak egyenlo teljesitmenyt nyujtana mint az orajel lockolt 3080. Azert ne menjunk el a tenyek mellett, hogy az elmult mondjuk 10 evben ezen olyan sokat sosem kellett izgulnia senkinek sem.

-

kovsol

titán

Ezt nem kicsit reagáltad túl. A HSZ amire reagáltam kb úgy állítja be, mintha csak a csúcs kártyáknál nem megengedett.

Az alsóbb kategóriában azért nem megengedett a tróger munka, mert sokkal de sokkal több terméket adnak el darabra, és ha azokkal nem elégedettek az emberek abból nagyobb gond van, minthogy pár darabbak kevesebb csúcs kártyát adnak el. -

Kansas

addikt

Szerintem ha tetszik, ha nem, olyan komplex rendszerekről beszélümk úgy hardver mint szoftver szintjén, hogy minél kevesebbet akarsz érte fizetni, annál több potenciális hibalehetőségnek hagyod nyitva a kaput... Se a tervezés, se a tesztelés nem ingyen van, se pénzben, se időben(pláne időben), szóval egy ponton minden gyártó kénytelen rámondani a termékeire, hogy "elég jó" és kiadni, nem lehet a végtelenségig fejleszteni. ha meg a minőségbiztosítást szigorítják, a selejtarény fut fel...

Hogy aktuálisan mennyi hiba lesz benne, az részben szerencse, részben minőségbiztosítás kérdése, de biztos lehetsz benne, hogy nem létezik olyan termék a világon, a vasgolyót is beleértve, amire rá lehetne mondani, hogy 100% biztonsággal hibátlan.

Ezért fontos a jótállás/garancia kérdésköre. Az élettartam garancia se azt jelenti, hogy nincs hiba, csak azt, hogy olyan kevés vagy olyan olcsó javítani, hogy a gyártónak anyagilag megéri az ingyenes csere/javítás vállalása.

Ha nem tudod elfogadni a hiba lehetőségét, ne vegyél semmit. Ez az egyetlen mód, hogy 0% legyen a hibás termék megvételének az esélye. -

#09256960

törölt tag

Ez olyan mint a játékokkal hogy alfateszter vagy már lassan mindenhol.

Viszont arra oda kell figyelni hogy amikor majd jön a Big Navival az összehasonlítás akkor a visszafogott órajeles adatok legyenek az összehasonlítótesztben, vagy legyen ott a kontrában működik csak kicsit füstöl

-

-

#92116480

törölt tag

haha micsoda seggfájás lehet most a scalpereknek de még mekkora az nvidia fanboyoknak.

mondjuk aki első körben vesz frissen megjelent hardvert az meg is érdemli, tanulópénznek jó lesz. -

koko52

nagyúr

Amikor 1 FPS-ért is megölik egymást az emberek vagy kiad egy prociért 100+k -val többet, mert akkor 290 helyett 295 FPS-e lesz akkor nem hiszem hogy a 400k-s VGA.nak elnézik, hogy a modolt BIOS korlátozni fogja a teljesítményt, bármilyen kicsi is a teljesítménycsökkenés. Vissza kell szépen hívni az összes selejtet és lehet szétbontani vagy mehet a darálóba.

-

Lehet a Vargáné+Trsa tápokhoz nem jó az adott konfiguráció...

-

nyakdam

aktív tag

Én még azt sem mondanám 100%-ra, hogy az NV sara. Új gyártás tech., új RAM és megemelt fogyasztás. Lehet a megszokott tesztsorokon simán végigment, de nem biztos, hogy a teljesen új dolgokra fel lehet készülni a múlt tapasztalatai alapján. A kisebb kártyáknál a kisebb fogyasztás miatt biztos nem lesz semmilyen gond. Szerencsére javítható és minimális teljesítmény veszteséggel.

-

Kókuszdió

nagyúr

Megy a sumákolás ,Zotac sem annyira fain ha a facebook post ot törölte ,inkább cinkes.

Többi gyártó is szépen kiadta az új utasításokat a gyártósoron és megy minden úgy ,mint ha meg sem történt volna.

Evga volt az első aki felvezette a témát ,ott érzek egyedül csak őszinteséget. -

Ragnar_

addikt

Elvileg driverből megoldották a problémát, Youtubeon van akinek az előtte 2000MHz-en futó kártyája problémás volt, új driverrel 2100MHz-en is stabil.

-

#16939776

törölt tag

Azzal hogy a PCB-n többféle méretű padot tesznek fel, álltalában helyet akarnak hagyni arra az esetre, ha nem áll szándékukban rev.2 pcb-t gyártani, vagy mint itt, nem adnak időt a tesztelésre és gyártás közben derülnek ki a turpisságok.

De ez arra is alkalmas, hogy az Aib partnerek nagyobb hasznot realizáljanak (nyomott árak nagy alkatrész igény mellett), vagy a mostanában oly gyakori alkatrész ellátási probléma ne szabotálja el a termék gyárthatóságát, azt tegyenek fel a pcb-re, amiből van elég a raktárban.A tesztelésre küldenek programot, kizárt hogy ők váladjalak a terméket, 1 -1 darab nem is lenne elég, mert van az alkatrész, meg van a gyártástechnológiai szórás is.

-

Abu85

HÁZIGAZDA

-

nem kell szerintem ártesnie Nvidia ellenőrzésen. A megadott specifikációk alapján készítenek egyedi dizájnt, megadott tűréshatárokkal és kikötésekkel és a saját minőségellenőrzésüknek kell megfelelniük. A jelek szerint erre nem volt elég idejük.

Nehezen hiszem hogy Nvidia tesztel le több száz féle kártyát a gyártóktól. -

menpee

aktív tag

Az összes partner modellnek át kell esnie egy nVidiás ellenőrzésen, mielőtt gyártásba kerülnének. Na ha ott rábólintottak, mert mint az élet mutatja, rábólintottak, akkor innentől fogva le kell nyelni a békát és vagy komolyabban venni a QC folyamatot vagy felvállalni, hogy jól van ez így.

-

ezzel nincs baj, ezt így kell megodlani, a gond az hogy vannak kombinációk, ahol előfordulhatnak hibák. Nyílván senki nem mérte ki a lehetséges összes variációt, az összes elérhető órajelen, teszteléni meg nem volt idejük.

Inkább ezért az Nv sara, mert időt nem adott nem a megadott specifikációk miatt. -

Kansas

addikt

Ja, hogy ez szarkazmus volt... gyakorold még, lesz ez jobb is...

Ez a mostani gond az NV kártyákkal hardverhiba(AIB-partnerek hibája, nem az NV-é), akármilyen csodadriver sem fogja megoldani.

Két módszer van:

- gariztatni

- megvárni a BIOS patch-et és reménykedni, hogy nem buksz vele sok teljesítményt -

Predatorr

őstag

válasz

afterwhite09

#9

üzenetére

afterwhite09

#9

üzenetére

Marketing. Tőlük pl. elvették az androidot...

-

afterwhite09

tag

Ugyan ezt csinálták a telefonokkal is... ráadásul az egyik legnagyobb... Huawei... Amikor kiküldték tesztelésre azt hiszem a P20 Pro-t, az akkori legerősebb mobiljukat, akkor a tesztprogramok futása alatt irrális módon megemelte az órajeleit a telefon, hogy magasabb pontszámot kapjanak

-

evitiguF

senior tag

Az mi már, hogy tesztekre nem ugyanolyan hardvereket adnak, mint amit a pórnép megvesz majd?

Pár éve autóknál s trükköztek ilyesmivel, hatalmas botrány lett belőle, ami még most sem ült el teljesen. -

Kansas

addikt

Az megvan ugye, mekkorát mondtál most?

- 3080-ad van másfél éve, tényleg?

- vagy 2080-ad van inkább, ami 2 éve jelent meg? Valóban nagyon sokat vártál, hogy kiforrja magát... gondolod, abban a fél évben áttervezték, vagy mi?

- a "zsír új hardver=teszteletlen szemét" kijelentésed pedig nettó marhaság(vagy hívhatjuk demagógiának is, ha precízek akarunk lenni) még ha a direkt sarkítást le is vonom belőle, de gondolom csak neked csak most még tervezett avulás is van rajta...

-

Steve_Brown

senior tag

Ha ennyire pofára esnék egy ideig én is meghúznám magam

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Predatorr

őstag

Sosem veszek zsír új hardvert (= teszteletlen szemét), így ez a széria sem okoz nálam semmiféle stabilitási hibát, a 3080 meg másfél éve stabilan ül a gépemben. Jó az elavult, régi vas a háznál...

-

Lassan reagálnak a gyártók az új GeForce-ok stabilitási problémáira

Meg a PH! is![;]](//cdn.rios.hu/dl/s/v1.gif) ... már napok óta ettől hangos az internet...

... már napok óta ettől hangos az internet...

Új hozzászólás Aktív témák

- HIBÁTLAN iPhone 13 Pro 256GB Sierra Blue -1 ÉV GARANCIA - Kártyafüggetlen, MS3022

- Samsung Galaxy S23 Ultra / 8RAM 256GB / Gyárifüggetlen / 12 Hó Garancia

- DELL PowerEdge R630 rack szerver - 2xE5-2680v4 (28c/ 56t, 2.4/3.3GHz), 128GB RAM, 10G, áfás szla

- Apple iPhone 8 64GB, Kártyafüggetlen, 1 Év Garanciával

- SzinteÚJ! HP Elitebook 860 G9 i7-1255U 32GB 1000GB 16" FHD+ Gar.: 1 év

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) Nekem is volt ilyenem csak X verzió. Jó kis kártya volt én szerettem

Nekem is volt ilyenem csak X verzió. Jó kis kártya volt én szerettem