Új hozzászólás Aktív témák

-

HSM

félisten

Ez a VR tudtommal csak annyi, hogy a fejed mozgását követi a kép, tehát nem az egérrel rángatod, hogy merre nézzél, hanem a fejeddel is tudod pozicionálni amit látsz. Ettől még a játék játék marad, szerencsére.

Hogy a látásra hogy hat nem tudom, de szerintem épp elég sz@rok a mai lassúcska monitorok is, meg a sok pici képernyő kütyü... Ez lesz a legkevesebb....

Árban nem biztos, hogy olyan durva lesz, csak két kicsi kijelző meg hozzá a körítés kell, szerintem egy óriási monitort legyártani sokkal-sokkal drágább.(#9842) h1mpi: A jelenlegi elhúzott piacvezetőségét csak annak köszönheti, hogy kihasználták a beragadt 28nm és a szintén jól beragadt DX11 miatti stagnálást a Maxwell-ekkel. Ez nekik pont kapóra jött, hiszen mobil lapkákban is utaztak már egy ideje, így nagyot tudtak vele villantani. Csak ugye, azt nem kötötték az emberek orrára, hogy ennek ára is lehet még....

Az AMD csak azt kalkulálta el a GCN-ekkel, hogy olyan lassan mozdul csak majd előre a piac, mint ahogy láthatjuk. Ezzel az Nv nyert egy durván egy év komoly előnyt a Maxwell-nek. -

HSM

félisten

Most úgy eléggé nem látom bennük a koncepciót. Elmentek a Maxwell-el a kis fogyasztás irányába, ez egy remek ötlet volt, de amúgy most nem látok náluk ütőkártyát a közeljövőre.

(#9833) imi123: VR, DX12, mindegyik fontos újítás. Nem hiszem, hogy addigra a Fury gyűjtőkhöz kerül.

(#9835) TTomax: Nem írtam ilyet.

(#9836) Ren Hoek: Ha GDDR5-el hozzák ki, az kapásból jelentős hátrány fogyasztásban. Fura lenne a Maxwell-es energiatakarékos vonal után tőlük.

-

HSM

félisten

válasz

#85552128

#9761

üzenetére

#85552128

#9761

üzenetére

DX12-nél elvileg már nem fog annyit számítani a fizikai/logikai mag és a priorizálás, ott újra meg kell nézni, mi a jobb, HT vagy nem HT, bár egy i3-nál sanszosan a HT lesz az egyetlen opció a marha kevés nyers erő okán.

Fejlődött... Édeskeveset. Ugyanazt csinálja, ugyanúgy. Max benchekben a modernebb processzormag nem 40%-ot gyorsul tőle, hanem 45-öt. A technológia meghatározó tulajdonságai semmit nem változtak. Mint írtam, a Sandy Bridge procis gépemen is pontosan úgy viselkedik a HT.

(#9764) TTomax: Kérdés, hogy low-level-ben használja-e a konzolt..

-

HSM

félisten

válasz

#85552128

#9755

üzenetére

#85552128

#9755

üzenetére

Az első generációs i7-en tökéletesen működött a HT, pontosan ugyanúgy, mint az újabb procikban. Ráadásul Win7-el használtam, annak is jónak kellett lennie alá. Az elsőgenerációs X58 i7-eknek ráadásul elég durva 3 csatornás memóriarendszerük volt, szóval nem kéne alaptalanul így leszólnod őket, elég rendesen volt bennük erő főleg húzva.

Amivel a "baj" volt, hogy HT-vel nem lehet jól priorizálni, amire viszont nagy szükség van DX11 alatt. HT-vel már a 920 nyers, átlagos teljesítménye is igencsak javult, viszont ahogy (#9752) schawo is írta, igencsak a minimális teljesítmény rovására. Közelsem volt olyan kiegyensúlyozott a rendszer, mint HT nélkül.

Ezt amúgy a mostani Sandy Bridge procis notimon is ugyanígy érezni. Mondjuk itt én is bekapcsolva használom a HT-t, mert különben a nyers erő lenne nagyon kevés és többet buknék a dolgon, de megvan az ára. -

HSM

félisten

válasz

#85552128

#9744

üzenetére

#85552128

#9744

üzenetére

Könyörgöm, egy i3-nál? LOL

Nekem 3,675Ghz-re húzott i7 920-as volt tesztalanynak, és igencsak volt, ahol ártott a HT, mivel a CPU-ban megvolt a nyers erő is, ellentétben az i3-al.(#9752) schawo: Részemről is.

Bár igaz, hogy nekem csak kb. 4 éve volt utoljára HT-s procim, mivel nem vált be (pár napnyi teszten kívül végig OFF-on volt a 920-ban is), utána HT nélküli i5-öket vettem csak.

Bár igaz, hogy nekem csak kb. 4 éve volt utoljára HT-s procim, mivel nem vált be (pár napnyi teszten kívül végig OFF-on volt a 920-ban is), utána HT nélküli i5-öket vettem csak.(#9749) Yllgrim: Sajnos jópár éve meghatározó a PH-n az önigazolás és a fikázás/trollkodás.

Én sem véletlen írok egyre kevesebbet....

Én sem véletlen írok egyre kevesebbet.... -

HSM

félisten

válasz

tibcsi0407

#9635

üzenetére

tibcsi0407

#9635

üzenetére

Pedig pont ez lenne az async lényege, hogy a compute és a graphics nem összeadódik, hiszen az a soros végrehajtás.

Jól működő Async módnál gyorsabbnak kellene lennie ennél a végrehajtásnak.

Jól működő Async módnál gyorsabbnak kellene lennie ennél a végrehajtásnak.Szerk.: a kép alapján éppen hogy nem működőnek tűnik Nv-n, míg AMD meg igen. Az más kérdés, hogy a kisebb compute munkákkal úgy tűnik, hamarabb végez az Nv, de az egy egészen más téma.

-

HSM

félisten

válasz

tibcsi0407

#9627

üzenetére

tibcsi0407

#9627

üzenetére

Van egy kis bibi a fő állítással:

"NVIDIA GPUs are programmed as a sequence of kernels. Typically, each kernel completes execution before the next kernel begins, with an implicit barrier synchronization between kernels. Kepler has support for multiple, independent kernels to execute simultaneously, but many kernels are large enough to fill the entire machine. As mentioned, the multiprocessors execute in parallel, asynchronously."Az, hogy ez nem zárja ki a feltételezett problémát, miszerint bizonyos grafikai állapotok esetén csak kontextusváltással tudnak futni az "async" shaderek. Tehát tényleg tudja, csaképpen nem feltétlen lesz tőle gyorsulás, hiszen éppen az lenne a kívánatos, hogy amíg bizonyos grafikai műveletekkel foglalatoskodik a GPU, addig futhassanak más dolgok is rajta.

-

HSM

félisten

válasz

daveoff

#9572

üzenetére

daveoff

#9572

üzenetére

Én abban láttam annak a VGA-nak a gyenge pontját. Eléggé nem tudok elképzelni rá normális megoldást DX12 alá 4GB rammal.

Nem várok önigazolást, de tény, hogy semmi kedvem nem lenne az Nv-sektől a savazást hallgatni újabb hónapokig, ha esetleg nem jönnének be, amiket korábban írtam.

-

HSM

félisten

Jelenleg úgy fest a dolog (találgatás?), hogy az Async-et tudja, spec pipa, csaképpen akár még lassulhat is tőle, tehát nem egészen azt kapod, amit AMD alatt. Kb. mint ahogy 4GB-os a 970.

Ott van azon is a 4GB, a spec pipa.

Ott van azon is a 4GB, a spec pipa. ![;]](//cdn.rios.hu/dl/s/v1.gif)

Szerintem ez semmi amúgy a 970-es dologhoz képest. -

HSM

félisten

Egy árban volt minden típus, +/-5000Ft. Az nem tétel már egy ilyen drága kártyánál, vagy legalábbis nem lenne szabad az legyen. A Gigát ehhez képest pár napig 25 000-el adták olcsóbban a többinél, akkor vettem, hülye lettem volna kihagyni. Úgy viszont piszokul megérte, nem is bántam meg. Nekem tökéletes volt néma csendben 900/1250MHz-en, a gyárihoz képest -50W-ot fogyasztva. A különbözetből később le is vizezhettem volna valami komplett rendszerrel, így nem volt vesztenivalóm és ott volt a 3 év gari is.

Amúgy a tuningot is szépen bírta, csak akkor már visított rajta a hűtés, azt meg én nem bírtam.

Amúgy a tuningot is szépen bírta, csak akkor már visított rajta a hűtés, azt meg én nem bírtam.

Normál 290 árakon megtartottam volna amúgy a Vapor-X 280X-em.

Így viszont a kíváncsiság győzött.

Így viszont a kíváncsiság győzött. -

HSM

félisten

A GF-ok picit takarékosabbak voltak. Az a durván +50W [link] az épp annyi, hogy a GF még szépen elvan, a 290-es meg "kazánkodik". Kicsit nagyobb hűtő kellett volna, mint a GF-okra és nem lett volna gond.

Házhűtés szempontjából is számít ez a plussz hő. Pláne, ha összeadod a két hatást... Ugyanabban a házhűtésben +50W, és ráadásul a VGA-n is egy 50W-al kisebb VGA-ra tervezett hűtés... Már meg is van a "baj". -

HSM

félisten

Persze, csak utána az olcsójános nem a gagyi kártyáját vagy a saját rossz döntését szidta, hanem az AMD 290-et, mert hogy kazán, meg szétég meg mindenbajavan... Ez az óriási probléma.

El kell fogadni, azonos áron 3 év garival nem lehet ugyanazt a színvonalú kártyát adni piaci verseny esetén, a +1 év garancia ugyanis egy szolgáltatás, ami pénzébe kerül a gyártónak. -

HSM

félisten

válasz

gtamate2

#9463

üzenetére

gtamate2

#9463

üzenetére

Az Asus nem volt elvileg vészes, csak kicsit joban meg kellett pörgetni rajta a ventit, mint gyárilag tették. MSI-vel már voltak rosszabb tapasztalatok.... Én amúgy nem is értettem, minek vettek annyian olyan típust, ami melegedős, ha zavarta őket... Van már manapság ezer teszt, utána lehetett volna nézni időben...

-

HSM

félisten

válasz

gtamate2

#9461

üzenetére

gtamate2

#9461

üzenetére

A ref modellnél spóroltak a hűtéssel, azért volt forró, ugyanazt kapta, mint a jó 50W-al kevesebbet fogyasztó 7970. Az gáz volt, ez tény.

A leírtakon kívül teljesen jó volt még a PowerColor PCS+ is. Igazából csak néhány modellel voltak a melegedési gondok, más téma, hogy valamiért azok elég nagy számban voltak vásárolva az emberek által.

-

HSM

félisten

válasz

Televan74

#9450

üzenetére

Televan74

#9450

üzenetére

A 290-el csak a BS volt bizonyos lapokkal a gond. A melegedés a gyártók spórolása volt a hűtésen. A hőtermelésnek megfelelő hűtőt kellett volna rá tervezni, és akkor nem melegedtek volna. Ahogy a 390-nél már azért nagyjából sikerült nekik.

Azért így is volt pár jól sikerült típus.

-

HSM

félisten

Itt a jelentéssel volt gondom. A nem tökéletes megoldás azt sejteti, hogy egy problémának a megoldásáról van szó, miközben itt nem megoldják a problémát, csak odébbtolják, oldja meg a fejlesztő vagy vegyél alá húzott kórájszevönt.

Na, na... Az Intel nagyon is csinált. Egyszerű drivert, mint a faék. Nekik ugyanis a lehető legkisebb CPU munka árán kell teljesítmény, és az IGP-t se feltétlen kell nagyon megetetni optimálisan. Mindkettő oka, hogy a TDP keretben maradjon, és agresszíven turbózhasson a csip. Tehát ők szándékosan mentek erre a végletre.

Az AMD eredetileg egy köztes utat próbált tartani, de a friss drivernél ott is elmentek kissé az Nv driverének irányába, megjegyzem érthető okokból.

Ami a mostani játékok kiadáskori állapotát illeti, ebből kiindulni hiba lenne. Jelenleg azért lehet ilyen vacak kódot kiadni, mert nem komoly gond, ha lehal a játék. Ezt nem engedheted meg magadnak, ha BSOD a következmény, tehát nem ennyire tré játékok fognak jönni, mert a kiadó sem fog akarni bajt magának.

Én Mantle-vel toltam sok órát BF4-ben, és egyáltalán nem fagyogatott. Szóval amit eddig láttam, tetszett.

Értem már az érvelésed. Van benne ráció, de rengeteg gyakorlati apróságon elvérezne szerintem a koncepció.

-

HSM

félisten

De ez nem megoldás! Éppen ez a lényeg! Ez egyfajta kompromisszum, az AMD egy másik, az Intel pedig egy harmadik. Mindegyiknek megvan a maga előnye és hátránya.

A BSOD-t okozó hibák szvsz igen hamar ki fognak bukni. Ha pedig kibuknak, ki lesznek javítva, amivel már játszani fogunk, nem nagyon fog BSOD-zni.

"Ha limitálom a szálak számát, akkor nem teszek nekik félre erőforrást, hanem maximálom, hogy mennyit vihetnek el. Ha ez nem elég a grafikára, akkor kevés lesz az FPS, és vissza kell venni a beállításokból."

Az AMD pontosan ezt csinálta, nem indított annyi szálat, mint az Nv drivere, és pontosan az is történik, pl. BF4-ben kicsit lejjebb kell venni a grafikát DX11 alatt (Ultra-->High), mert nem bír el a driver a sok repkedő szirszarral, amiket szétszór a játék Ultra-n.

Kicsit fura, hogy azt a megoldást írod rosszabbnak, amit magad is javasoltál megoldásnak egy másik hsz-ban. Most akkor hogy is van ez? Vagy én értettem félre valamit? -

HSM

félisten

válasz

Ren Hoek

#9311

üzenetére

Ren Hoek

#9311

üzenetére

Szerintem nem fog ehhez 5 év kelleni. Konzolokon már ki van taposva az út.

Az AoTS sebességéből pedig kár kiindulni, mivel még béta állapotú sincs.

Egy ilyen programot NEM SZABAD olyan kész programokhoz hasonlítani, amik a végletekig lettek optimalizálva kiadás előtt.(#9313) gbors: Ja, látom.

Igen, pontosan ez a gond, hogy a játék szimulációjához tartozó dolgokat elég nehézkes skálázni, mint pl. a fizika, vagy AI. Itt persze nem a particle-esőre gondolok amit pl. a GPU-PhysX tud, hanem a valódi, játékmenetre ható fizikára. Ha viszont nem tudod skálázni, akkor a megcélzott leggyengébb procin is futnia kell, amire a kiadó igényt tart, az összes egyéb folyamat mellett is, kiemelve a GPU driverét is. Ugyanez komolyabb gépeken, mivel ugye az is elvárás, hogy az aktuális gamer konfigokon is jól menjen.

Igen, pontosan ez a gond, hogy a játék szimulációjához tartozó dolgokat elég nehézkes skálázni, mint pl. a fizika, vagy AI. Itt persze nem a particle-esőre gondolok amit pl. a GPU-PhysX tud, hanem a valódi, játékmenetre ható fizikára. Ha viszont nem tudod skálázni, akkor a megcélzott leggyengébb procin is futnia kell, amire a kiadó igényt tart, az összes egyéb folyamat mellett is, kiemelve a GPU driverét is. Ugyanez komolyabb gépeken, mivel ugye az is elvárás, hogy az aktuális gamer konfigokon is jól menjen.

Szval én arra akartam utalni, hogy userként, ha csak a most érdekelt, jobban jártál az Nv-vel, de ennek mindenki más itta a levét. Ami már a DX12-vel nyilván remélhetőleg csak a múlt, de ide tartozik, ha meg akarjuk ítélni az Nv és az AMD driverét.(#9321) sayinpety:

Mondjuk nekem a véleményem, hogy egyik gyártót sem kell félteni.

(#9324) gbors: Remélem nem akarod a BSOD-s gumicsontot ismét előszedni... Rendesen megírt programokat kell használni, és nincs gond. Aki meg sz@rt akar majd eladni, annak úgyis híre megy majd.

(#9335) Abu85: Hát ez a forma hatalmas.... Azóta is ezen röhögök: [link]...

(#9350) gbors: Számtalan gondot vet fel ez a modell is. Pl. a szál nem feltétlen független egy másik száltól. Pl. 4 szál vs 4 szál egészen más egy i3 és egy i5 esetén, vagy egy FX4000-nél.

Azonkívül gond, hogyha fixen limitálod a driverek szálait, akkor vagy túl sok erőforrást teszel nekik félre, vagy más szituációkban a sok is kevés lehet. Szerintem ez nem lenne kellőképpen rugalmas.

-

HSM

félisten

Szerintem elég szélsőséges. Az egyik olyan játék, ahol DX-ben látványosan gyorsabb az Nv drivere maxgrafikán olyankor, amikor mindenféle szirszar repked a levegőben.

A felvetésem lényegi részére hogy nem válaszoltál, egyetértést jelent?

(#9273) rocket: A profit termelés kinek jó? Nekik! Nekem édesmindegy, nem vagyok egyik cégnél sem részvényes. Pontosabban nem mindegy. Ugyanis én még 3 év múlva is szeretnék PC-s játékokat játszani, és nem olyanokat, amik a csilli-villi grafika kedvéért a béka segge alá vannak minden más téren butítva, hogy az Nv drivernek is maradjon elég CPU-ideje a játékot vinni a hátán.

Bár lehet, végülis ez sem érdekel. Már egy ideje tizedannyira sem érdekel a PC játék, mint régen.

(#9289) cyberkind: Engem hagyj ki ebből, nem piacrobbanást vártam a DX12-től, hanem egész más dolgokat. Amik nagyjából megvalósulni is látszanak.

-

HSM

félisten

válasz

deadwing

#9252

üzenetére

deadwing

#9252

üzenetére

Az én elképzelésem a helyzetről, hogy mivel az Nv drivere több szálat futtat, így a kritikus részek, amikor rengeteg munka hárul a driverre, ott kevésbé fogy el, mint AMD alatt. Ezért nem öli meg. Ennek viszont az az ára, hogy gyengébb procikon elméletileg gyengébben szerepel, valamint a játékfejlesztőknek is ehhez kell alkalmazkodni. Tehát az Nv-nek jó, az Nv felhasználóinak addig jó, míg az FPS-t nézik csak, ugyanakkor a PC-s játékok és játékosok szempontjából nem biztos, ha emiatt (is) gyengébb alkotások születnek. Tehát úgy fest, csak az Nv nyer ezzel.

(#9254) Egon: A gond, hogy ehhez kellett egy AMD és egy Mantle is.

Közben meg az Nv hülyére kereste magát a Maxwellekkel és a Dx11 driverükkel, az AMD pedig eléggé nem áll jól most. De amúgy a DX12/Vulcan API-nak maximálisan örülünk.

Közben meg az Nv hülyére kereste magát a Maxwellekkel és a Dx11 driverükkel, az AMD pedig eléggé nem áll jól most. De amúgy a DX12/Vulcan API-nak maximálisan örülünk.

(#9255) Ren Hoek: Akinek ehhez nincs képessége, azoknak marad a DX11.3. Rosszabb nem lesz nekik sem, mint eddig, de akinek megvannak a képességei, már fog tudni jobbat alkotni, mint amit a DX11 megenged.

(#9260) gbors: Kicsit sarkosan fogalmaztál. Az AMD drivere sem esik össze, egy-két szélsőséges esetet leszámítva. Nekem pl. 4,4Ghz-re húzott i5 4690K volt a BF4 alatt, és a 290-essel sem esett a legdurvább jelenet alatt multiban 45-50FPS alá FHD maxon, pedig nagy pálya, és 64 fő volt rajta. Ultra helyett High-ra rakva már végig stabilan 60 felett volt, de inkább 70-100, grafikailag is alig látszott valami a némileg kevesebb repkedő szirszart leszámítva. Mantle alatt is hasonlóan jól ment, Ultra-n.

Szóval én úgy gondolom, az Nv részéről ez a driveres taktika nem "megoldás" egy problémára (ahogy fogalmaztál), hanem egy kompromisszumot igénylő helyzetben egy szélsőség. Az optimum az lett volna, ha hasonló szintre lövik be egymást a gyártók, és egyik sem próbál előnyt kovácsolni magának mindenki más kárára...

-

HSM

félisten

Az a gond, hogy nem nehezebb leprogramozni, hanem hogy nem lehet. Tehát ahogy Abu leírta kicsit felettem nagyon jól, játékötletek végzik a kukában. Ezenkívül olyan a mesterséges intelligencia, mint 10 évvel ezelőtt. A hang is olyan, mint 10 évvel ezelőtt, sőt talán még rosszabb, 10 éve az EAX révén néhány játéknak még komolyabb hangzásvilága volt, mint a maiak 90%-ának.

Az, hogy az AMD VGA-k is profitálnak a CPU-ból az kicsit bonyolultabb történet, mint amit itt célszerű lenne levezetnem, annyit írok csak, nem ilyen egyszerű. Hint: maga az API is erősen egyszálon dolgozik.Tehát gyakorlatilag az a helyzet, hogy a user örül, hogy az Nv hardveren megy jobban a játék, közben meg nem látja, hogy a színfalak mögött azért sem lehet komolyabb a játék más szempontokból, mert a brutál erőforrászabáló drivernek szabadon kell hagyni elég CPU-erőforrást.

(#9242) Abu85: Igen, erre gondoltam.

Viszont azt nem jól írtad szerintem, éppen ez a gond, hogy NEM tudják a fejlesztők DX11 alatt előre megbecsülni a dolgok erőforrásigényét, mert egy bazinagy feketedoboz az egész a működési elvei miatt. Ezért utólag kell addig pofozni, míg jó nem lesz, illetve már előre is nagyon óvatosnak lenni.(#9243) Ren Hoek: Hát ezaz, a user örül, de csak azért, mert nem tudja, miről marad le emiatt....

(#9250) sayinpety:

(#9240) deadwing: A többieknek adott válaszomból és a többiek hsz-eiből remélem megkapod a választ.

Az Nv drivere gyors, de megvan az ára.

Az Nv drivere gyors, de megvan az ára.

AMD sebességét multiban DX alatt nem a többi játékos öli meg, hanem a komplex pályák. Ultra helyett High grafikával pl. teljesen megszűnnek a sebesség gondok, látványos minőségvesztés nélkül. Azt is megfigyeltem egy éve, mikor játszottam, hogy mindig akkor esett le a GPU-használat és az FPS, amikor pl. rengeteg törmelék szállt a levegőben, ami driver/Api limitnek tűnik. Arról nem is beszélve, a játék/driver is véleményem szerint inkább a "biztonságra" van optimalizálva DX alá, sebességnek ott van a Mantle.

Ultra helyett High grafikával pl. teljesen megszűnnek a sebesség gondok, látványos minőségvesztés nélkül. Azt is megfigyeltem egy éve, mikor játszottam, hogy mindig akkor esett le a GPU-használat és az FPS, amikor pl. rengeteg törmelék szállt a levegőben, ami driver/Api limitnek tűnik. Arról nem is beszélve, a játék/driver is véleményem szerint inkább a "biztonságra" van optimalizálva DX alá, sebességnek ott van a Mantle.

-

HSM

félisten

válasz

sayinpety

#9235

üzenetére

sayinpety

#9235

üzenetére

Igen, ezt nem látják a játékosok nagyrészben, hogy a "jó" DX11-es Nv driver szépen megzabálja az erőforrásokat más dolgok elől. Persze, a teszteken szép FPS-t fog felmutatni az 5Ghz-re húzott 6-magos Intel vason...

Mondjuk az AMD lépése is érthető, hogy behoztak több szálat, ha olvastad a fórumot, évek óta köpködve van, hogy nem megy olyan szépen extradurva procikon, mint az Nv-é, és nem csak a fórumokon, cikkekben is legtöbbször ez volt a vélekedés, ritkaságszámban említve azt a tényt, hogy az agresszív multithreadingnek egy VGA-driver esetén komoly árnyoldala is van.(#9237) Egon: A felhasználók aztán képben vannak, mi megy a színfalak mögött.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

daveoff

#9213

üzenetére

daveoff

#9213

üzenetére

A kérdés meglepően jó.

Rajongói nyomás? Plusz reklám, hogy "első DX12 program"? M$, Nv, esetleg AMD nyomásra? Passz.... Ettől még ez egy alfa állapotú program....

Rajongói nyomás? Plusz reklám, hogy "első DX12 program"? M$, Nv, esetleg AMD nyomásra? Passz.... Ettől még ez egy alfa állapotú program....(#9214) gtamate2: A külsőségeket passzolom, én az optimizálásra gondoltam, ami általában az utolsó fázisa egy játék készítésének.

(#9215) Ren Hoek: Én sehol nem olvastam, hány futószalaggal dolgozik ez a motor.

Amennyire tudom, a draw callok olyan hívások, hogy rajzolj ide egy ilyet, oda egy olyat.... Ha sokminden van a képen, sok a draw call. Ez egy dolog. Viszont, hogy ezeket a létrehozott objektumokat utána hány pipeline dolgozza fel, az egy egészen más kérdés....A procis kérdésedre asszem kicsit lejjebb Abu megadta a választ.

Jó 3D RTS pl. a StarCraft 2.

(#9221) Abu85: Az lesz még izgalmas... Ha kiadjáka véglegs verziókat (és még más játékokat) DX12, Vulcan esetleg Mantle alá is. Lesz itt csetepaté.

(#9224) gbors: Tetszik a konklúziód. Én is erre jutottam. Amúgy a felhasználó majd időben megtudja, miért kell a DX12. Ha érdekli. Ha nem érdekli, akkor meg majd ha kelleni fog neki, megy és perkál a kasszánál.

![;]](//cdn.rios.hu/dl/s/v1.gif)

(#9230) gbors: Szerintem ez egy jó dolog. Ha ugyanannyi pénzkeretből kevesebb fog elúszni az optimalizálásra, és kevesebb processzoridőt eszik a játék a semmire, így ugyanabból a játék kiadói keretből jobb játékok születhetnek majd. Szerintem ez állati jó.

-

HSM

félisten

Magam is így szoktam. Általában beválik, de korántsem mindig.

(#9186) asdxv: Akkor ezért maradt ki. Az első évben nem vettem GCN-t, elég volt az 5850-em, és a 180K-s ára a 7970-nek és a 100k körüli 7870 se hozta meg a kedvem hozzá.

2013 márciusában viszont már jó volt, 60K körül 7870XT, majd egy hónappal utána a 7950 75K-ért.

2013 márciusában viszont már jó volt, 60K körül 7870XT, majd egy hónappal utána a 7950 75K-ért.  A 7950 még ma is megállja a helyét, pedig 2,5 év eltelt....

A 7950 még ma is megállja a helyét, pedig 2,5 év eltelt.... -

HSM

félisten

válasz

daveoff

#9182

üzenetére

daveoff

#9182

üzenetére

Szerintem a userek többségének se szeme nincs ehhez, se kellően gyors monitora.

Nem sok mindenki tolta vagy tíz éven keresztül 100hz CRT-n az FPS-eket....

Ezenkívül manapság a monitorok nagyon nagy többsége is dög lassú és csak 60hz-es... Ott nincs nagy difi, elveszik a monitoron.(#9183) asdxv: Lehet, akkor ez kártyafüggő is.

A csodadriverek sosem izgatták a fantáziám, úgyhogy azt passzolom, azt se tudom, melyik volt az.

-

HSM

félisten

Volt Nv-nél egy komolyabb driveres fejlesztés, amikor sokat javítottak a Keplerek regiszterkezelésén. Ott is sokaknál instabillá vált a korábban kitesztelt órajelük, és vagy visszatették a régi drivert, vagy vissza kellett vegyenek a korábban stabil 24/7 tuningjukból.

Arra reagáltam, hogy nincs olyan általánosan, hogy "stabil tuning", otthon nem tudod kitesztelni. Olyan van, hogy adott körülmények között stabil tuning. A DX11 DX12 váltás viszont elég drasztikus változás a körülményekben.

Itt is olyan terhelések érhetik majd a VGA-t, amire DX11 alatt nem volt példa.

Itt is olyan terhelések érhetik majd a VGA-t, amire DX11 alatt nem volt példa.

BS-em tényleg nem volt, csak ha elkottáztam a tuningot/alulfeszelést.

(#9180) daveoff: "Persze, Te már csak tudod, hogy nálam mi hogy működött"

Te magad írtad le, hogy nem láttál input lag különbséget, nem változott a tuning, és nem változott a hőmérséklet sem. Én csak levontam az egyetlen logikus következtetést.

Én csak levontam az egyetlen logikus következtetést."Ezt a tuningos dolgot is ugyanúgy beseggelted, mint Abu minden egyes mondatát....."

Igazán kedves a feltételezés, de ez saját kezű tapasztalat.

-

HSM

félisten

válasz

Ren Hoek

#9150

üzenetére

Ren Hoek

#9150

üzenetére

A draw call-ok és a compute pipeline-ok teljesen más fogalmak, itt lehet nálad a félreértés.

Jelenleg amúgy sok kérdés kering bennem. Először is, nem vagyok meggyőződve, hogy a DX11 és DX12 mód 100%-ban ugyanazt a képet számolja-e. Nem volt időm utánanézni még. A másik, hogy sokaknak eltérő az eredménye, ami minimum érdekes. Harmadrészt, alfa állapotú teszt, elsőkiadású mindennel, DX, Win, driver téren.

Én azért ebből még nem vonnék le messzemenő következtetést.

(#9170) ffodi: Stabil volt pedig az. Amúgy ha nekem nem hisztek, tekerjétek vissza a 780-as topikot, ott is volt egy durvább driveres "javítás", ami után sokaknak az addigi stabil 24/7 beállításukból vissza kellett venni.

(#9173) daveoff: Nálad akkor valami nagyon nem volt kerek Mantle-vel... Ugyanaz a tuningpotenciál, difit se láttál a DX módhoz képest, ugyanaz a működési hőfok, WTF? Szerintem szénné throttlingolta magát a kártyád.

-

HSM

félisten

válasz

deadwing

#9006

üzenetére

deadwing

#9006

üzenetére

Emlékeim szerint még azt is ki tudja írni, mennyi időt tartott a CPU-n és mennyit a GPU-n a feldolgozás, tehát látod, melyik a szűk keresztmetszet.

(#9007) gézu: Szerintem még így sem teljesen pontos. Inkább azt teszi lehetővé, hogy a lehető legjobban kihasználható legyen, amennyiben a fejlesztő rendelkezik a megfelelő tudással ezt előhozni. A DX11-ben ez elérhetetlen, akkor is, ha a fejére áll a fejlesztő. A durva CPU-s és VRAM kezelési korlátokról nem is beszélve DX11 alatt.

-

HSM

félisten

A fényest én sem szeretem a tükröződések révén, de a nagyon durva tükröződésmentes réteg is nagyon erősen rontja a képminőséget.

(#8912) TTomax: Ezekszerint tökéletesen képben vagy a témával.

Mondjuk elvileg takarítható marad, utána is, csak jóval óvatosabban kell csinálni...(#8914) Keldor papa: A kérdés inkább az, a panel mennyire gyors. A 144hz inkább csak katalógusadat, önmagában nem sokat jelent.

-

HSM

félisten

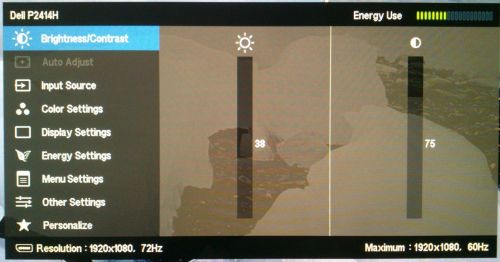

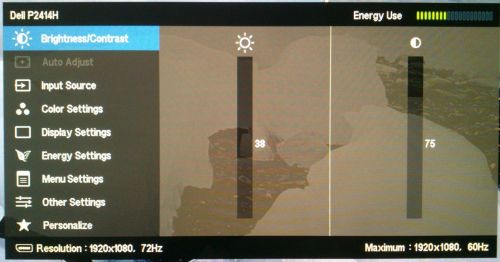

Olyanom van. [link] Ráadásul 72hz-en, úgy még gyorsabb. De nyilván meg se közelít egy jobb, 144hz-es TN-t.

24" teljesen jó filmezni, ha pici a hely....

(#8908) cyberkind: Kicsi a szobám, nagy TV be sem férne. No, meg mivel egyáltalán nem nézek TV-t csak filmezek, meg néha pár sorozat, így túlzottan ki sem lenne használva.

Ellenben a kalibrált 24"-os IPS-en kb. mindent meg tudok csinálni, amire szükségem van.(#8909) TTomax: A coating nem az IPS sara... Sokan le is áztatták, és kész is volt a gyönyörű tükrös IPS.

Amúgy az újabbakon már nem olyan erős, régebbi DELL-eken volt nagy divatja annak a brutális matt rétegnek.

Amúgy az újabbakon már nem olyan erős, régebbi DELL-eken volt nagy divatja annak a brutális matt rétegnek.

De nyilván, mindkét technológiának megvannak a jellegzetes előnyei/hátrányai, sajnos.

-

HSM

félisten

Azon a részen mit nem lehet érteni, hogy valakit zavarnak a betekintési szög függvényében kisebb/nagyobb mértékben elmászó színek, valaki meg észre sem veszi?

Én szeretek izegni-mozogni a gép előtt, és eszement mód utálom, ha az elvileg homogén színbe árnyalatok "keverednek". Vagy ha elcsúsztatja a TN a "gammát" (az szokott lenni függőleges irányba). Nem, köszi, maradok az IPS-nél.

Én ezt szeretem: [link].

Így tudok olyan egyszerű dolgokat csinálni, mint pl. barátnővel filmezni úgy, hogy nem kell a nyakamban ülnie.... -

HSM

félisten

Hát, érdekes egy elgondolás ez az asztalos G-sync...

A notimban tudom, hogy kritikán aluli a panel (mondjuk 14" méreten 1600*900 pixel nem rossz) viszont az asztali monitoromban eléggé jóféle panel volt.... Mind1, a Prad.de képéről is látszik, amit linkeltem, hogy bár valóban jobb valamivel, mint a régiek, a jelenség kevéssé meglepő módon ugyanúgy érinti, mint bármelyik másik TN technikásat.

Egyszer ha megszokod a szép fix stabil színeit egy IPS-nek, utána már nem fog tetszeni a TN... Ez van... Pedig a sebességének örülnék, elhiheted....

Ez van... Pedig a sebességének örülnék, elhiheted....(#8894) TTomax: Az ULMB jó dolog, de mivel egy hardveres technika, ami nem is kompatibilis a G-sync-el, így továbbra sem egészen értem, ez most hogy jött ide.

Amúgy ezt a monitornak kell tudnia, és akkor megy Radeonnal is. Pl. van ilyen technikája a BenQ és az Eizo-nak is. De ha nem tévedek, a sima LightBoost is megy velük, ami ugyanezt csinálja, mint az ULMB.

-

HSM

félisten

Nem az a lényeg, hány fok, hanem hogy minimális szögváltozás esetén is kismértékben elmásznak a színek. Mint írtam, van, akit ez zavar, van akit nem. (Valakinek az űrhajó jobb, valakinek a repülő.)

Amíg nem voltak elérhető áron az IPS monitorok, nekem is TN volt, egy drágább, jobb fajta, de hiába tudott belépő IPS szintű színeket, semmire nem mentem vele, mert a panel közepén stimmeltek a színek, a szélén már nem....

Itt amúgy nem 2-3X-os árú panelekről van szó, hanem hasonló árú, sima sRGB modellekről.(#8881) h1mpi: A szemeim nagyjából ott vannak, mint mindenki másnak, akivel eddig találkoztam. De akkor én is kérdeznék... Te sosem mozdulsz meg míg a gépnél ülsz? Vagy húzol át egy ablakot a képernyő egyik sarkából a másikra?

![;]](//cdn.rios.hu/dl/s/v1.gif)

De igazából mindegy is, ha nem zavar a színtorzulás, akkor neked csak előnyöd lesz a TN-el... Gyorsabb és olcsóbb technológia, mint az IPS.(#8883) Keldor papa: Csak érzékeltetni tettem be. Én elhányom magam ettől a jelenségtől, nem tehetek róla. A notimban elviselem, úgyis főleg az asztali monitorról megy, de ha van választásom, akkor köszönöm, nem kérek belőle.

Főleg olyan dolgokra, amit gépen csinálni szoktam... Netezés (képekkel), képszerkesztés, filmek, játékok...

Főleg olyan dolgokra, amit gépen csinálni szoktam... Netezés (képekkel), képszerkesztés, filmek, játékok...(#8884) gbors: Egyszerűen nem látom, mihez kellene a bufferelés. Meghajtod azt a nyamvadt pixelt egy feszültséglökettel, hogy hamarabb a helyére álljon. Ehhez nem kell buffer, eddig sem kellett.

Amúgy technikailag a G-syncben is van egy csúnyácska hiba, 144hz-nél megnő az input lagja, mivel plusz kommunikáció kell olyankor. Szóval papíron a FreeSync még bizonyos tekintetben jobb is.

(#8885) -Solt-: Nekem is pont ez volt a bajom a cikkel... Hogy a technológiát temeti az adott monitorok helyett.

-

HSM

félisten

Ennél a képnél nincs többre szükségem.

[link]

[link](#8878) TTomax: Nézd, ha van kis affinitásod grafikai dolgokhoz (én pl. fotózom), akkor látod, hogy mennyire nem pálya egy TN monitor. Folyamatosan másznak el a színei, akármit csinálsz. Mint írtam, ez van, akit zavar, van akit nem. Engem piszokul zavar.

-

HSM

félisten

-

HSM

félisten

"ha egy bitang erős kártya lenne, ez kb a kutyát nem érdekelné."

Szerintem egy bitang erős kártya lett, teljesen függetlenül attól, hogy pár százalékkal gyorsabb nála (még) a nagy Maxwell...

(#8631) gbors: Viszont a tuningpotenciál rendesen meg fog változni. A 290-esem is több feszt kért Mantle alatt azonos órajelhez BF4-ben, mint bármilyen DX-es játékban.

-

HSM

félisten

Nem játszottam még 4K-ban. Viszont mivel hobbi szinten foglalkozom fotózással, képkezeléssel, így van róla némi fogalmam, milyen hatása van....

A 3D-nél úgy látom, nem igazán ment át, amire gondoltam. Mind1, nem olyan fontos.

A 4x-es SSAA az megvan, hogy 4K sebesség, de a 4X-es MSAA-nak töredéke a gépigénye. Tény, hogy sajnálatos módon sok motor nem támogatja, és azoknál marad a rossz minőségű FXAA, vagy a teljesítményzabáló SSAA. Olyankor persze, jobb a 4K megjelenítés AA nélkül.

-

HSM

félisten

Ja, bocs, az egye szám első személy az első bekezdésben megzavart.

Sajnos ez pszichológia, kiadsz egy rakat lóvét egy halál felesleges dologra, aztán próbálod magadnak is megmagyarázni, hogy az milyen jó.... A gyártók meg ezt pontosan tudják. Ez volt a 3D TV-nél is... Megvetted horror drágán a 3D TV-t, aztán vehettél hozzá horror árú 3D BR lejátszót, horror áron 3D BR filmeket, meg gépbe is duplaerős VGA-t... Ez meg a gyártóknak hatalmas $$$$$$$$$$$$$$$$$.... Most bizonyos szempontból ugyanez a 4K, valamivel rá kell venni az embereket, hogy újat vegyenek az amúgy tökéletes pár éves FHD TV-jük helyett...

(#8616) TTomax: DOF, BLUR nálam alapból OFF, ha lehet.

A fénykezelést viszont nem butítanám vissza, elég csúnya. Az élsimítás persze, hogy normál felbontásoknál kell, nem is vitás, de a töredéke a gépigénye, mint a 4K renderelésnek.

A fénykezelést viszont nem butítanám vissza, elég csúnya. Az élsimítás persze, hogy normál felbontásoknál kell, nem is vitás, de a töredéke a gépigénye, mint a 4K renderelésnek. -

HSM

félisten

Nagyobb felbontásban akarod nézni a gyengébb minőségű objektumokat, gyengébb minőségű textúrákkal, gyengébb minőségű effektekkel? Ennek így semmi értelme szerintem....

Játszottál már mondjuk egy BF4-et mediumon? Ultra és High között nem látni nagy difit, főleg játék közben, de egy medium azért már nagyon látszik, már FHD-ben is.... Ugyanez igaz a legtöbb játékra. Ahol már komoly sebességet nyersz, az igencsak látszik.(#8610) ffodi: Ne vedd sértésnek, de az érveléseid a fogyasztói társadalom tipikus csapdái.

Amikor többe kerül a leves, mint a hús, és próbáljuk megmagyarázni.

Amikor többe kerül a leves, mint a hús, és próbáljuk megmagyarázni. -

HSM

félisten

válasz

MiklosSaS

#8595

üzenetére

MiklosSaS

#8595

üzenetére

Köszönöm szépen, mindig jól esik az embernek pár jó szó.

Nekem a BF4 alatt volt vele nagyon pozitív tapasztalatom, egy új játék lett belőle a DX11 módhoz képest, pedig az még épphogy a low level irány legtetejének kapargatása volt csak...

(#8601) gbors: Én meg azt nem értem, miért nem lehet fele felbontásban (~FHD) használni a 4K TV-t filmeken kívül. Ugye, TV-t, mivel monitoroknál legalább olyan elterjedt a DP, mint a HDMI, ahol a Fiji-n is megoldott a 4K@60hz. Máris dupla FPS, és még jobb képminőség is, mintha nagy felbontás lenne butított részletességgel....

-

HSM

félisten

Jelenleg ha akarnák se tudnák jobban optimalizálni, mivel az az optimális, ha nem törölsz a VRAM-ból, csak a pályatöltések alatt, amiket meg minimalizálni kell. Mi lesz ebből? VRAM zabáló játék. DX12 alatt viszont közvetlen memóriaelérés lesz, nem fog beakadni, ha törölsz, végre memóriamenedzsment is lesz, nem csak telepakolás, hanem végre a felesleges tartalom is törölhetővé válik.

Mellesleg ezzel a pályatöltések is eltüntethetőek.

Mellesleg ezzel a pályatöltések is eltüntethetőek.  Lesz azért itt sok kis csoda, bár nem biztos, hogy egyből.

Lesz azért itt sok kis csoda, bár nem biztos, hogy egyből.(#8589) miklosss2012: Nagyjából igyekszem csendben maradni, unalmas az ellenszél néhányaktól, no, meg van jobb dolgom is mint a PH előtt bosszankodni miattuk. Bár az utóbbi napokban egész jól el lehetett beszélgetni szinte mindenkivel.

-

HSM

félisten

válasz

MiklosSaS

#8585

üzenetére

MiklosSaS

#8585

üzenetére

Nincsenek konkrét méréseim. Csak morzsák, kibontakozó trendek, fejlesztési irányok....

Talán Abu-tól van a legtöbb érdekes konkrétum: [link] [link] [link] [link].

Van még rengeteg morzsa innen-onnan, de azokat egy fél nap se lenne elég összegyűjteni.

(#8586) Asbee: Nézz már magadra ember! Ki magyarázkodik? Hint: [link].

Nincs több kérdésem.

-

HSM

félisten

4GB egyáltalán nem kevés, ha értelmesen van használva. DX11 alatt is azért kell a borzalmas irreális nagy memória egyes játékok alá, mert nem törlik a felesleges dolgokat, mert nincs rendesen megoldva, megakasztja a játékot, így a fejlesztők leginkább elkerülik a törlést, és csak pakolnak, paklolnak befelé mindent...

A HBM1 Fiji tapasztalatok az AMD-nek fognak versenyelőnyt adni, nem a konkurenciának.

(#8583) Asbee: Ez ám a megszakértés!

-

HSM

félisten

Igen, amit leírsz tipikusan elfogyó processzor vagy API/Driver limit.

Leginkább ezen javítottak azóta, amennyire követem. Amúgy magam is észrevettem ezeket, pl. BF4-ben maxgrafikán DX11 módban a sok apró szirszar egyes páláykon sokkal jobban megfektette az AMD-ket, mint az Nv-ket. Mantle-ben ennek máris nyoma sem volt... A monitorozáson is látszott ilyenkor, hogy a VGA terhelése esik vissza, a proci meg szenved.

Nekem 2014 novemberig volt meg az asztali gépem a 290-el, emlékeim szerint valamelyik 14.7 környéki béta driverrel. Nekem nem volt különösebb bajom a teljesítményével amúgy az időnkénti lassabb teljesítmény ellenére sem. Pl. BF4-ben amíg nem volt Mantle, DX11-ben High-ra tettem, és máris ment, mint a huzat, játék közben meg nem látszódott különbség a High és az Ultra beállítás között. Mantle-n meg mehetett aztán Ultra-n... -

HSM

félisten

-

HSM

félisten

válasz

cyberkind

#8576

üzenetére

cyberkind

#8576

üzenetére

A Crysis 2-t remekül végig lehetett játszani egyszem 5850-en is.

Annyi volt a trükk, hogy nem tetted fel a város alatt óceánt szimuláló extra "DX11" pakkját. [link]

Annyi volt a trükk, hogy nem tetted fel a város alatt óceánt szimuláló extra "DX11" pakkját. [link]Ami a mostot illeti, úgy írod ezt, mintha most nem lehetne AMD kártyákkal játszani. Most 20%-al gyorsabb a 980 Ti, mint pl. a Fury, de a 290X/390X már beérte a 980-at DX11 alatt is, és könnyen az előbbiek is erre a sorsra juthatnak. Ugyanis a MAJD-ból lesz a MOST.

Amúgy az 5850 az egyik legjobb VGA-m volt, 3 éven keresztül szolgált és vitt majdnem mindent padló grafikán, és eközben alig vesztett 33K-t az értékéből. Na, ez szerintem egy korrekt életciklus, ezt ugorják majd meg a Maxwell-ek, ha tudják.

-

HSM

félisten

A HBM2-nek ott kéne kezdődnie, hogy megvalósítasz egy egyszerűbb, HBM1 dizájnt.

(#8554) miklosss2012: A "csonthülye" 980 Ti-ben nyers grafikai erő eléggé bőségesen van, és a DX11 driverük is gyorsabbnak tűnik... Nem véletlen húzott most nagyon bele az AMD is a driverfejlesztésbe...

A DX12 összecsapások viszont még érdekesek lehetnek néhány hónapon belül, sok szempontból is.

Gondolom, nem kell leírjam, melyik kártyák megerősödésére számítok.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

Így interposer nélkül "wireless" bekötött HBM memóriával túl sok félnivalója nincs egyik AMD GPU-nak sem... Mivel is szoktak jönni az Nv-sek? Hogy nekik a MOST kell, nem ígéretek? Tessék megnézni MOST, kinek van működő, piacképes HBM-es terméke. Ehhez képest ezen az elméletileg Pascal próbapanelen meg csak dísznek van a GPU mellett a memória....

Azt se felejtsük el, nem olyan könnyű a semmiből összerakni egy ütőképes, jól működő architektúrát, és az AMD már évek óta polírozza a GCN-t... Szóval az eddig látottak maximum némi kacagás kiváltására voltak jók az Nv-től....

-

HSM

félisten

Lehet valami abban, amit írsz. Ugyanakkor tuti nem teljesen úgy van, ahogy írod, ugyanis akkor rengeteg képkockával előre kéne dolgozzon a CPU (pipeline lépcsőnként egy), és a csillagos egekben lenne az input lag.

Jelenleg a legtöbb játék ha jól tudom, durván 3 képkockával működik előre, tehát akkor logikusan ennyi "átfedés" lehet a pipeline-on, ami azért nem valami acélos.

Egyben magyarázat lehet, miért is marad egy rakás szabad kapacitás a GPU-ban.(#8414) Asbee: Már megint egészen másról beszélsz, mint én. Az, hogy nálad egy jobban sikerült 980 tud 1660Mhz-et, örülök neki, de ez attól még nem reprezentatív, ha én veszek egyet, nem biztos, hogy ennyit fog tudni. A Tahiti-s alulfeszelés ezzel szemben nagyszámú kártyán lett próbálva, és mind tudta. Ha a usernek nincs tehetsége beállítani, az nem a kártyának a hibája.

-

HSM

félisten

Nem igazán érdekel, a világ hány %-át érdekli ez a lehetőség. Adott, ha valakit érdekel, élhet vele. Ennyi.

(#8395) Erdei88: Ha gyárilag 1200MHz-ekhez is csak ilyen 1V-okat kap, ott már túl sok tartalék nem lesz lefelé szvsz. De kíváncsi leszek, mire jutsz.

Inkább a BOOST "kikapcsolásában" látok komoly lehetőséget a spórolásra.

Inkább a BOOST "kikapcsolásában" látok komoly lehetőséget a spórolásra.

(#8397) Ren Hoek: Szerintem túlzottan biztosra mennek a jó kihozatal érdekében. El tudom képzelni, hogy mondjuk van egy csip mondjuk 100-ból, ami tényleg igényli a delejt.

(#8397) Ren Hoek: A nálam járt 290 is cudar módon alulfeszelhető lett volna, ha nem kellett volna ehhez kikapcsolni a powerplay-t. Szóval azokban is több van, csak bajosabb az alulfesz a jóval okosabb PP miatt.

Amúgy nem azt mondtam, hogy jobb a fogyasztása, csak hogy nem szignifikánsan rosszabb.

(#8396) cain69: Nálam a lejátszóprogram is sokat számított. Pl Firefox+Flashplayer kiakasztotta a 290-et, +90W, míg asszem a Chrome HTML5 beérte a felével. De leginkább prociból toltam, a 4690K 10W nagyságrendben letudta a FHD videókat.

(#8404) gbors: Én a találékony hobby-user szemszögéből vizsgáltam a helyzetet, nem általánosan a piacot.

Az async témában úgy gondolom, persze, lehet rosszul, hogy a GPU jelenleg egyszerre egy állapotban lehet, vagy a shaderek futnak, vagy a ROP műveletek, vagy a memóriások, ezek eléggé kötötten, sorban. Tehát párhuzamosan futnak a shaderek, de olyankor nem működik pl. a tesszalátor. Persze, lehet rosszul tudom/gondolom, ebben a témában nem nagyon mélyedtem el. Ezt az async dolgot én úgy képzelem el, hogy külön futnak különböző feladatok a GPU-n, egymástól függetlenül, így több részegység dolgozhat majd párhuzamosan, mint jelenleg, nyilván a program támogatása esetén.

A memóriavzérlős téma nehéz ügy (pláne, hogy kevés az elérhető infó), azt most függőben hagynám, de én kevesebb buktatót látok a jelenlegi tudásommal a Tahiti-féle HUB-ossal, mint az Nv féle prioritásos megoldással. Ez nem kettős mérce, csak az álláspontom.

(#8409) Laja333: Az én 290-em disznó módon bírta (volna) az alulfeszelést, de nekem is ki kellett lőnöm a powerplay-t, mert különben -20mv felett 2D-ben (és/vagy köztes órajelekben) elfogyott volna a tudomány. De ja, egy BIOS-editor lenne erre a legjobb megoldás, nem ez az Offset marhaság.

-

HSM

félisten

Nézd, körübelül 15db különböző (bár 1-től egyig jóminőségű), és különböző gyártási időszakból származó Tahiti csipes kártya ment át a kezeim között 2 év alatt, amit alaposabban tudtam tesztelni, és egyetlen egy sem bírta kevésbé az alulfeszelős mókát a többinél. Persze, voltak 5-10W-os különbségek, különböző tuningpotenciálok, sőt, durva tuning mellett akár 30-50W különbségek a határra járatott csipeknél a jobbak/rosszabbak között, de 1Ghz környékén mindegyik remekül belőhető volt masszív alulfeszelős, megbízható működésre, amit a tesztemben is láthatsz. Nem írnám, ha nem így lenne. Ez szerintem már messze túlmutat a véletlen kategóriáján. Ezenkívül mindenki, akinek fórumba/privátban segítettem alulfeszelni is hasonló pozitív eredményről számolt be. Szóval ezen kártyáknál én továbbra is kitartok az "igen kedvező fogyasztásúra belőhető" állításomnál.

Ami a DX12 feature leveleket illeti, sok szempontból komolyabb tudású a csip, mint a Maxwell2, szóval ha ők nem aggódnak, akkor a Tahiti tulajoknak sem kell szvsz.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Ami az async taskokat illeti, én máshogy gondolom a működést. De majd úgyis kiderül, mi/hogy fog változni.

A ringbus tényleg jó volt, csaképpen kifejezetten rossz energiahatékonyságú volt kis terhelésen, és rengeteg tranzisztort evett. Igen, ez történt, bizonyos szempontból kicsit lebutították, hogy más részeknek is maradjon elég tranzisztor és kedvezőbb legyen a fogyasztás. Ez pl. az én szememben egy elfogadható kompromisszum, amiből csak előnyük lett a vele elkészült termékeknek. A Maxwell esetén meg majd az idő eldönti....

(#8392) Erdei88: Az nehezebb ügy a BOOST2 miatt.... A TPU szerint pl. a Strix 960 feszei: 1250 - 1430 MHz 1.025 - 1.200 V.

Namost, az 1.025V és az 1.2V fogyasztásban elég durva difi. Érdemes lehet azt is megnézni, mit lehet belőle kihozni. Ezzel sajnos nincs tapasztalatom, pláne, hogy tömegesen mit bírhatnak.

A Tahitikről viszont tudom, hogy gyakorlatilag mind jókora feszcsökkentést elbír.

Az azért nagyon nem mindegy, pl. a 7950-em, hogy gyárilag 1,18V-ot adott 925MHz-hez, míg bőven elég lett volna neki ehhez 1,02V. 1050MHz-es órajelhez is elég volt 1,1V, ami még mindig óriási különbség egy ekkora GPU-nál a gyári 1,18V-hoz képest... -

HSM

félisten

A 7950 egyáltalán nem fogyaszt sokat, ha jól be van lőve,egy 7970 meg még annál is takarékosabb.

A Logout tesztemben ezt elég alaposan körbejártam. Csak jól kell belőni, és boldogság. Egy játék közben 160W körül fogyasztó (és amúgy 1050/1400MHz-re és +20% powerre tuningolt a gyári 925/1250-ről) VGA-ról nekem sokminden eszembe jut, csak a magas fogyasztás nem. [link].

Pláne nem sok, ha azt veszed, a GTX960 fogyaszt valahol 110 és 130W között [link], és ezen még ott figyel +1GB ram is.

Amúgy napi poén, alulfeszelve a gyári órajelén maximum power limittel a 7950 pariban van a GTX960 fogyasztásával, 124W-ra számoltam.

Tesztekben viszont nem érdemes a 7950 sebességét nézni, mivel általában nem férnek bele a gyári TDP-be, és dobálják az órajelet lefelé szorgalmasan, +20% limittel meg nem sokan tesztelnek sajnos. A 7970-en nincs ilyen gond általában, abból lehet következtetni egy jól belőtt 7950 sebességére.

Ami a feature hiányokat illeti, két feature hiányát látom mindössze. Az egyik a TrueAudio, ami a zöldeknél sincs, a másik a FreeSync, de az sem egy akkora nagy dolog, hogy ne lehetne nélküle élni, pláne ebben az árkategóriában.Az aszinkron ALU-s érveléseddel egyáltalán nem értek egyet. Itt linkelt két kép és érvelés érvényes ide is, amit Ren Hoekn-nek írtam [link]. Gondold végig, ha most "ROP limitált" valami, akkor is amíg a ROP-ok dolgoznak, más folyamatok nem tudnak dolgozni, pl. memóriabetöltések. Vagy éppen a fizikai műveletek futhatnak, míg a ROP hosszasan dolgozik. Szóval a lényeg, hogy valóban a legnagyobb haszon, hogy így jóval több shader futhat, hiszen GPU-idő szabadul fel, viszont nem gondolom, hogy ez csak shader limitált esetben hozhat látványos előrelépést.

Ami a memóriát illeti, tényleg eléggé ködös AMD-nél a megvalósítás. Pláne az architektúrás ábrák alapján. [link]

Elvileg amúgy külön szedték az első HUB-ok NV-szerű megvalósításához képest a GCN-nél a ROP-okat, legalábbis a Tahiti-nél: [link]

A cache hierarchia is érdekes: [link].

Szerintem több van itt a háttérben, mint amit megmutatnak.

(#8386) Ren Hoek: A manuális freesync-et a notebookom Intel HD3000-ese is tudja már, FreeSync mentes monitorral, most is 72Hz-en írok róla.

De ja, a Tahiti-n, meg Hawaii-on lehetett ilyeneket csinálni. Csak a monitor képességein múlt, hány Hz-en hajthattad.A 370 tényleg kicsit övön aluli, ugyanakkor azt is nézni kell, hogy az eléggé alsóház már. Aki meg csak úgy OEM kap valamit, ott nem tartok tőle, hogy Freesync monitora legyen mellé....

-

HSM

félisten

válasz

Ren Hoek

#8371

üzenetére

Ren Hoek

#8371

üzenetére

Nagy pofon a freesync? Az elejétől lehetett tudni, hogy nem fog vele menni.

Jó dolog ez a szinkronosdi, de ha választhatok, inkább egy olcsó Tahiti szinkron nélkül, mint egy szinkronos GTX960.

A cache rendszernél azért csodát ne várj, a sávszélességet nem nagyon pótolja. 1MB szemben 2MB-al (290 vs GTX 980), az azért nem nagy csoda mondjuk egy 4GB memóriához képest. A Tahitiben is van azért 768kb.

Meglátjuk, izgalmas lesz.

-

HSM

félisten

Annyiból nem "klasszikus" hogy szvsz régen nem volt 3 éves VGA ennyire "modern", naprakész, mint most a régi "csúcs" GCN-ek, gondolok az összes 7900-ra és R9 280-ra...

Valahol mindig volt valami "bibi", vagy sokat fogyasztott, vagy lassú volt, vagy a szolgáltatáskínálata volt már korszerűtlen. Ehhez képest a Tahitin nem sok komoly fogást találok.... (A fogyasztás igen kedvezőre belőhető minimális időráfordítással, azt nem veszem emiatt hátránynak.)

(A fogyasztás igen kedvezőre belőhető minimális időráfordítással, azt nem veszem emiatt hátránynak.)A 2900XT természetesen nem fogja utolérni a GTX960-at, nem is állítottam hasonlót. Hiába van sok memória-sávszélesség, ha nincs hozzá elég erős GPU, ahogy fordítva is igaz, az erős GPU sem ér semmit, ha nincs alá elég sávszél. A DX12 előreláthatólag csak annyit csinál majd, hogy lehetővé teszi a GPU jobb kihasználását, amit gyorsulásként lehet majd reaalizálni, ha a memória alrendszer is partner ebben és bírja az iramot.

Az Nv memóriavezérlője nem tudom, mi alapján írod gyorsabbnak az AMD-seknél, viszont a Maxwell-ek egy szempontból nagyon jók, lényegesen nagyobb L2 van bennük, mint a GCN-ekben, ami jó hatással lehet a teljesítményükre.

-

HSM

félisten

válasz

Erdei88

#8345

üzenetére

Erdei88

#8345

üzenetére

A játék memória sávszélesség igénye nem igazán függ a VGA gyártójától.

(#8348) ffodi: Ne a Mhz-eket nézd, hanem azt, mennyit hoznak... A % sokkal reálisabb.

A 290 esetén a +250Mhz az 20% tuning.

A GTX980-on 23%, amit írtál 2150Mhz. Én amúgy ~2Ghz-el kalkuláltam (+250Mhz), amit általában még bírnak, az csak 14%.

A Fury-X-en az a +100Mhz az szintén +20%.Szóval ja, annyira nem vészes a helyzet, így végigszámolva.

-

HSM

félisten

Kompetitív szempontból nézve tegyük gyorsan hozzá azt is, hogy a Maxwell-eken tipikus alig van tuningpotenciál hagyva a memóriákon (gyárilag is igen magasak az órajelek), míg a Radeonokon lényegesen több van.

Amúgy a 960 ellen vicces ellenfél a régi 7950/280-as Radeon, ami ugyan "papíron" 380-as sebesség környéke, csaképpen "picit" durvább memória-potenciállal. De szerintem a Te számaid is éppen elég beszédesek.

(#8329) Ren Hoek: A növekedést az váltja ki, hogy eltűnnek komoly korlátok a rendszerből. Pl. a megjelenő async compute, többszálon renderelő API.

Én nem beszéltem semmi extrém növekedésről. De ha a GPU mondjuk 30-50%-al jobban kihasználhatóvá válik DX12-ben, akkor oda kelleni fog alá 30-50%-al erősebb memória alrendszer, különben a GPU-t vissza fogja fogni.

Természetesen nem konstans a memória sávszélesség igény, ahogy írod, jelenetfüggő erősen. Ha elfogy a sávszélesség, akkor a GPU sebességet veszít. Ez nyilán az AVG és MIN FPS-eken is látható lehet.Gondold végig, már önmagában az async shader... Olyan dolgok futhatnak majd egyszerre a GPU-n, amik eddig egymás után futottak...

Lásd: [link] [link].

Ezek mind csak akkor fognak szépen működni, ha van rá elég sávszélesség (meg még pár dolog megfelelően működik).

Ha a sávszélesség belimitál, akkor hiába futnak ezek párhuzamosan, nem lesz sok sebesség nyerve, mivel ugyanúgy várni fognak a folyamatok, csak nem a másik folyamatra, hanem a memóriára.... -

HSM

félisten

válasz

Ren Hoek

#8301

üzenetére

Ren Hoek

#8301

üzenetére

De, ez pont ilyen egyszerű. Ha mondjuk 3+4=7, és ez egy képkocka, ami 20ms alatt készül el, akkor ehhez be kell olvasnod a GPU-ba először a 3-at és az 4-et. Ha ez az olvasás 20ms-ig tart, akkor hiába tudná a GPU 10 ms alatt is kiszámolni, ha 20ms-ig tart, míg megérkezik az adat hozzá, 10ms-ig akkor pihenni fog a GPU adatra várva. Fordítva is igaz (ami a mostani DX11-es helyzet), hiába olvassa be a Fiji vagy Hawaii memóriája 5ms alatt a 3-at és a 4-et, ha a számolás az API korlátai miatt sokáig tart, mondjuk 20ms-ig. A Maxwell2 hiába olvas a memóriából 10ms-ig, ha azon is 20ms a számolás ideje, nem lesz lassabb. Remélem átmegy.

A furmarkhoz nem kell nagy sávszél, tudtommal direkt úgy van megírva, nem használ sok memória-tartalmat, viszont rengeteg egyszerű számolást csinál azzal a kevés adattal.

(#8312) gbors: Úgy gondolom, jelenleg a GTX960 a valódi képességeihez képest ma durván túlteljesít, ahogy sokszor a GTX980/970 is. Ha nő a memória sávszélesség igény, akkor az árához/pozicionálásához képest messze a legnagyobb pofáraesés a GTX960 lesz, pláne, hogy az ellenfelei, ami a 280-as, 380-as Radeonok, akár GTX980 pukkasztó sávszéllel rendelkeznek. A GTX970 is bukhat, a tuningolva 224GB/s nem túl acélos, de kész csoda így is a GTX960-hoz képest, miközben annyival nem drágább kártya. A GTX980-nál megint az ár miatt lesz gázos, nem olyan olcsó kártyák voltak azok, és 256GB/s.... A 980 Ti esetén pedig azért nem látok olyan nagyon durva gondokat, mert bár annak is éppen annyira fog fájni a nagyobb sávszél-igény, de abban marad annyi nyers erő is, hogy az ember ne nyúljon a szívéhez annyira, ha az lesz a limit.

-

HSM

félisten

válasz

mcwolf79

#8289

üzenetére

mcwolf79

#8289

üzenetére

Igen, a majd és a ha jövő időt és feltételes módot kifejező szavak.

Megjegyzem, a múltról is szoktam írni, csak akkor nem jövő időben és feltételes módban, hanem kijelentő mód és múlt idő. Annak a szava a "volt". Szép dolog a nyelvtan.

3-4 év? Ugyan... Ez a következő fél, max egy év. Márpedig most is kapni a boltokban a Maxwell-eket, és az űrtechnika AMD-t... De a legöregebb Maxwell2 GTX-ek sem lesznek öregebbek 2 évesnél egy év múlva.

Ez itt a "bibi", hogy masszívan a nyakunkon a DX12, nem 3 meg 4 évek kérdése.

Abu igencsak bőven ír okos dolgokat, csak kell fül értelmezni tudni belőle a lényeget.

Akinek ez nincs meg, vessen magára.

Akinek ez nincs meg, vessen magára.(#8293) Ren Hoek: Amennyire nő a GPU kihasználása, úgy nő a sávszélességigény. Gondold végig, ha ugyanazt a képkockát nem 30ms-ig rendereli, hanem 20-ig, akkor máris 20ms alatt kell a képkockányi adatot a GPU-ba tölteni, nem 30 alatt. 1,5X-ös gyorsuláshoz 1,5X-ös sávszélesség is kell. Ha a sávszélesség nem tartja a lépést a GPU-val, nem lesz jó a skálázódás.

(#8295) Erdei88: 100%, hogy nőni fog, egyedül az a kérdés, mennyivel.

NV-s méréseket olyannak kéne csinálnia, akinek NV karija van. BF4, maxgrafika MSAA-val, FHD. Megy vele kicsit multiban és már van is egy szám.

BF4, maxgrafika MSAA-val, FHD. Megy vele kicsit multiban és már van is egy szám.

Amúgy senkit nem buzdítottam AMD kártya vásárlására, én csak leírom, hogy látom a mostani helyzetet. Értelmes emberek vagyunk, magunk döntünk.

-

HSM

félisten

Nem vagyok benne biztos, hogy nem lesz idén ilyen játék... Abu írta valahol, hogy év végén jön az új Frostbite motor pl., de az AOTS is halad, elvileg hamarosan benchmark is jön belőle... [link]

Ami a memória sávszélességet illeti, neked is ezt tudom mutatni: [link]. Nem csoda, hogy nem profitál a sávszélből sem a Hawaii, sem a Fiji, sem a nagyobb NV-k nem profitálnak a 300GB/s feletti sávszélességükből, ha a játék 100% GPU használat mellett megelégszik kb. 100-160GB/s-el egy 290-es GPU esetén... Ezt a GTX970 is kirázza a kisujjából...

Ugyanakkor ha nagyobb mértékben megnő a GPU kihasználtsága a DX12-vel, akkor ez a sávszélességigény könnyen a többszörösére nőhet...(#8276) gbors: Ezzel pontosan tisztában vagyok.

Pontosan, ahogy írod egyfelől picivel jobb a sávszélesség/számolók aránya, másfelől számold bele azt is, hogy a 1,5-ös szorzó nem kevés. Ez a sávszélesség így már versenyképes a piros oldal felsőházával, tehát bár arányaiban nem sokkal több, ezt már nem nevezném szívószálnak.

Pontosan, ahogy írod egyfelől picivel jobb a sávszélesség/számolók aránya, másfelől számold bele azt is, hogy a 1,5-ös szorzó nem kevés. Ez a sávszélesség így már versenyképes a piros oldal felsőházával, tehát bár arányaiban nem sokkal több, ezt már nem nevezném szívószálnak.

Arányaiban nézve a GTX960 sem jobban szívószál, mint a GTX980, mégis úgy gondolom, ott fog először fájni, ha majd elkezdi a memória éheztetni a számolókat.... Pláne, a mostani, 70K-s áráért.... -

HSM

félisten

A 980 250GB/s-je nem lenne rossz, ha nem azon az áron adnák.

A rivális 290X-ek kis tuninggal 40%-al többel gazdálkodhatnak, jóval olcsóbb ár mellett. A 390-ek meg még ennél is többel.

A rivális 290X-ek kis tuninggal 40%-al többel gazdálkodhatnak, jóval olcsóbb ár mellett. A 390-ek meg még ennél is többel.(#8270) monosz: Nézd, én csak beszélgettem a témában pár fórumtárssal. Nem tudom, ez neked mitől lett "szánalmas vergődés", meg okítás, meg térítés, de igazából túlzottan nem is érdekel.

Normális felfogású ember helyén tudja kezelni a másik ember véleményét, és akkor nem bántja meg.... -

HSM

félisten

válasz

Ren Hoek

#8250

üzenetére

Ren Hoek

#8250

üzenetére

Jó, de ha mondjuk 400GB/s lenne az ideális, akkor a 320GB/s-el még mindig klasszisokkal jobb leszel, mint mondjuk 224GB/s-el a GTX980-on.

Amúgy nem csak a motortól fog ez függeni, hanem a játéktól, tartalomtól, szóval izgalmas lesz az első pár DX12 fecske.

(#8251) Keldor papa: Jó, hát az a Batman.....

(#8252) gbors: A GTX980 Ti éppen nem szívószálas, azt korábban is írtam. Ami szívószálas, a konkurenciához képest az a GTX960, valamint a GTX970 és 980.

-

HSM

félisten

válasz

Ren Hoek

#8242

üzenetére

Ren Hoek

#8242

üzenetére

Persze, csaképp PC-re szokás plussz effekteket is beletenni valamint nem 30fps a cél, hanem minimum a duplája. Máris kell a PC-re a 400GB/s, mikor konzolra elég a 150.

Ami a Nano-t illeti, nem tudom, milyen olcsóságról beszélsz. Már írtam, vagy olcsó lesz és béna, vagy jó csip kell majd, de akkor igencsak jó lesz, de nem olcsó...

Nézd, attól hogy megvágják, a 14/16nm nem lesz olcsó... Ugyanúgy kelleni fog rá a memória, az interposer, ha HBM-el jön, a fejlesztési költségek...

(#8244) Keldor papa: Persze, nem megy vele semmire, ha nincs használva...

De nem biztos, hogy ez örökre így marad, pláne a körülmények ismeretében...

De nem biztos, hogy ez örökre így marad, pláne a körülmények ismeretében... -

HSM

félisten

válasz

Ren Hoek

#8228

üzenetére

Ren Hoek

#8228

üzenetére

Azt nem tudjuk, mikor fog elterjedni, és hogy pontosan milyen igényei lesznek a korai megvalósításoknak. De ezeket hamarosan meg fogjuk tudni...

A megnövekedett sávszélesség igényhez nem fog amúgy rengeteg pipeline kelleni, bőven elég, ha 2 compute és egy grafikai izomra terheli a csipet. Ez az elvileg preferált a fejlesztők körében, nem az 1+1.

Ha mondjuk egy FPS-ben gondolkozol, ott is sokminden megnövelheti az igényeket. Pl. részletesebb táj, részletesebb modellek, csomó lehetőség van ott is fejleszteni a megjelenítésen.Ami a VGA-k jövőbeli értékét illeti, azon fog az egész múlni, mennyibe kerül az új, és mennyire használható a régi.

(#8237) Sir Ny: Véletlen se zavarjon, hogy praktikusan ugyanaz a csoda a kettő.

Mellesleg a Mantle nálam már bizonyított BF4 alatt a régi 290-es VGA-mon.

Mellesleg a Mantle nálam már bizonyított BF4 alatt a régi 290-es VGA-mon.  Pedig az még csak épphogy a lehetőségek felszínének legtetejét ha picit megvakargatta.

Pedig az még csak épphogy a lehetőségek felszínének legtetejét ha picit megvakargatta.

(#8238) Petykemano: A cégnek ez nagyobb hasznot termel, ugyanakkor a piacnak meg árt, mivel megvetted a marhadrága VGA-t és azt látod, egy év múlva költhetsz rá megint egy vagyont... Az emberben meg az marad meg, hogy mennyire drága dolog a PC-játék, közben meg csak jól lehúzták...

Szerintem szomorú, hogy az emberek ennyire nem látják, merre navigálják a piacot a vásárlási döntésükkel....(#8239) Ren Hoek: Azt ugye beleszámoltad, hogy 14/16nm-en, HBM memóriával azok NAGYON úgyértem pokoli drága csipek lesznek?

Pláne egy óriásnagy VGA.....

Pláne egy óriásnagy VGA.....

Nem az lesz, mint eddig, hogy huss, itt az új gyártástechnológia, kisebb, gyorsabb, olcsóbb... Kisebb lesz, talán gyorsabb is, de állati drágán. Sajnos nagyon közel a fizikai határok.... -

HSM

félisten

válasz

Ren Hoek

#8225

üzenetére

Ren Hoek

#8225

üzenetére

Arra céloztam ezzel, amit már korábban leírtam, hogy az oké, hogy betegre keresik magukat, a gáz csak az, hogy ez nem fog jót tenni a játékosoknak, mert az egységsugarú Maxwell vásároló ha majd azt látja, nem futnak jól a játékok az egy éves 150K-s kártyáján, akkor nem lesz túl boldog.

A szegmentációról, egyéb piaci manipulálásokról nem is beszélve.Az async shadert persze, gyorsít szívószálon is biztosan, de az optimális működéséhez elég sávszél fog kelleni. Amúgy nem is tudom, valamelyik készülő DX12 játék kapcsán volt róla szó, hogy jelenleg úgy fest, a sávszélesség lesz a legnagyobb limit DX12 alatt. Végülis logikus is, ha sokkal jobban ki lehet használni a GPU-t, akkor sokkal több adat fog kelleni azonos idő alatt feldolgozni.

Az átlag user majd akkor fog fejet vakarni, ha majd nem megy jól az új BF a gépén, míg a haver srácnál meg mondjuk igen. Szóval az AMD-nek az lesz a jó reklám, ha majd tényleg jól mennek DX12 alatt.

-

HSM

félisten

válasz

Ren Hoek

#8218

üzenetére

Ren Hoek

#8218

üzenetére

A Tonga elvileg 384bites buszú, csak sanszosan nem erőltetik még a fullos verzióját valamiért (pl. mert jóval drágább úgy a tokozás, a PCB, a körítés, kivárnak vele). Tényleg nem a legszerencsésebb a 256bites buszával, de nézzük azt is, mennyiért adják.

Kapaszkodj, 75K-ért kapod meg a 4GB-os verziót, annyiért, amennyibe egy 128bites GTX960 is kerül. Ezen két kártya közül egy pillanatnyi gondolkozás nélkül hoznám el a 380-at....

A Delta Color-ról az Nv ilyen ~25%-os növekedéseket írt, amit vélhetőleg a lehető legoptimálisabb körülmények mellett mértek. Mindezt az óriási L2-vel együtt. "Thanks to the improvements in caching and compression in Maxwell, the GPU is able to significantly reduce the number of bytes that have to be fetched from memory per frame. In tests with a variety of games, Maxwell uses roughly 25% fewer bytes per frame compared to Kepler. "

A Maxwell2 "ledadogás" ellen elég lesz, ha annyit csinálnak, hogy a GTX980 Ti-n fusson valahogy a maxgrafika. Ott azért bőven van sávszél, gyárilag közel 340GB/s, ami tuninggal akár 380 környékére is növelhető.

Ehhez képest egy GTX980 a 224GB/s-el, vagy a GTX970 a 3,5GB-ján elérhető 196GB/s-el elég halovány.

Egyébként egyetértünk, AMD-től főleg a Fiji és Hawaii csipes kártyák fognak remekelni, majd meglássuk mennyire. Ugyanakkor a már lassan ősöreg Tahiti is szépet alkothat még, ha nem botlik el pár korából fakadó apróbb hiányosságán (gondolok pl. a "mindössze" 2 compute futószalagjára).Szóval már ma is van tisztességes sávszélességű Maxwell, csak épp vastagon megkérik az árát. Jelenleg kb. dupla áron méri az Nv a Maxwellhez a sávszélességet az AMD-hez képest, ami azért nem éppen bíztató.

Az AMD-nek nem fog kelleni ilyen trükk az eladásokhoz, van bőven ember, aki most Nv-t használ, de át lehet csábítani. Vagy akinek már régebbi, lassabb AMD-je van, azok is vesznek előbb utóbb újat.

"Szépen bemész egy webshopba és rendelheted a 14/16 nm-es csendes, halk és brutális teljesítményű kártyákat."

Ha lehetek őszinte, ez az a verzió, amitől nem tartok. Persze, jön a HBM is, meg minden jóság, de hogy olcsó nem lesz, az is 99%.

Persze, jön a HBM is, meg minden jóság, de hogy olcsó nem lesz, az is 99%.(#8221) Ren Hoek: A régi GCN-eken hardveres okokból nem megy a Freesync. Ez ilyen, amelyik újításhoz hardver kell, azt nem tudják szoftveresen hozzáadni utólag. Erről nem az AMD tehet. Ahogy az Nv sem fog tudni utólag még 128GB/s sávszélt adni a GTX980-akhoz vagy GTX960-akhoz.

Ha szétszakad a piac, azt köszönheted az Nv-nek, mert betegre akarták keresni magukat a Maxwell-el.

A vékony busz meg kellett a költségek és fogyasztás alacsonyan tartásához.

A vékony busz meg kellett a költségek és fogyasztás alacsonyan tartásához. -

HSM

félisten

válasz

gtamate2

#8194

üzenetére

gtamate2

#8194

üzenetére

Teljesen hibás az érvelésed.

Először is, ott a konzol. Pl. PS4 kapásból 176GB/s-el. A Box kevesebb, de abban ott a SRAM a gyakoribb dolgoknak.

A fejlesztők elsősorban arra fognak még sokáig fejleszteni, az pedig GCN.

Ami a piac szeletét illeti [link], nézzük a mai sláger-Maxwell-t, jelenleg a Steam felhasználók 2,84%-a rendelkezik olyannal (GTX970). Ehhez képest az öreg 7900-asok 1.95%-al vannak jelen.

GTX960 az a piac mindössze 0.89%-a.

A GTX780-ból is annyi van, mint GTX980-ból, 0.74%.

És ott vannak az R9 200-asok, 0.85%-al, amikről sajnos nem derül ki, pontosan melyikből mennyi.

Szóval ez így nekem nem 80%-nak tűnik....(#8195) TTomax: Ebben nagyon tévedsz, ez nem az új szériáról találgatás, ami a másik topik.

Írtam, hogy nem a legjobb példa, mivel GPU is erősen kell neki. Amúgy az a 680 alatt azért nézd a procit is, 3960X @4.9, az azért nem csirke. Ha alárakod a 290X-nek a 4930k @4.7-t, máris igencsak elment a 290X....

Amelyik 290-est utolérte, CPU 1090T @4.1, hááát...

-

HSM

félisten

válasz

gtamate2

#8192

üzenetére

gtamate2

#8192

üzenetére

Ha nem érdekel a dolog, skippeld kérlek Te is. Én továbbra is tisztában vagyok vele, hogy DX11 alatt szépen mennek a Maxwell-ek, mivel ott nem fáj ez a spórolás, ezt nem is tagadtam sehol.

A sávszélességigény megtorpanása egyfelől a DX11 sara (nincs kihasználva a GPU, nem kell annyi adat sem), másfelől a programozók, akik látták a piacon lévő hardvereket, és spóroltak a sávszél igénnyel, amennyire lehetett.

-

HSM

félisten

A jelenlegi játékok többsége igencsak kímélően bánik a memória sávszélességgel. Ennek egyik oka a DX11.

Amúgy tudok egy viszonylag memóriasávszél-igényes játékot, a Sniper Elite V2 tesztprogi.

De ahhoz mondjuk GPU-ból is elég erős kell.

De ahhoz mondjuk GPU-ból is elég erős kell.Ha a majd nem érdekel, akkor skippeld kérlek a hozzászólásaim. A jelenhez nem kell fórum, mindenki el tudja olvasni a teszteredményeket, szakadásig van velük a net....

(#8190) TTomax: Ott lesz az aszinkron compute is, ami igencsak dobni fog a dolgokon... Egyszerre több részét kellene ott a GPU-nak etetni a memóriából, ami szintén garantáltan meg fogja növelni a sávszélességigényt.

-

HSM

félisten

Memória sávszélesség zabáló motorú játékban? Ott hiába a GPU erő, ha nincs sávszél etetni. Mellesleg a 7970/280X sem éppen egy gyenge GPU, pláne egy GTX960-hoz képest. De egy 7870/270X se sokkal gyengébb GPU-ban.

De ja, ha nincs elég sávszélesség etetni, mindegy, milyen GPU-t teszel rá. -

HSM

félisten

válasz

gtamate2

#8178

üzenetére

gtamate2

#8178

üzenetére

Itt van a BF4 FHD maxgrafikás memóriahasználata a 290-es Radeonomon (GPU memory utilization): [link].

Szépen látszik, hogy a 20-50%-át használta ki a 320GB/s-nek, szóval nem túl meglepő, hogy a kőkemény 128GB/s-el rendelkező GTX960-on sem ütközik akadályba. Ugyanakkor egy olyan játékmotorban, amiben a memória intenzíven használva lenne, a GTX960 a béka feneke alatt nem lenne, nemhogy egy R9 280X-hez vagy 7970-hez, de még egy 7870-hez képest sem.... -

HSM

félisten

A GTX480 jó cucc volt. Első ránézésre azt szúrták el, amit az AMD most, túl okos csipet tettek le az asztalra, és a "butább", egyszerűbb,kevesebbet fogyasztó, sokkal olcsóbb 5800-as Radeonok lemosták őket.

Most csak ami más, hogy a nyakunkon egy API-váltás, és friss konzolgeneráció is van...

(#8165) Ren Hoek: A 280-as Radeonok közel 300GB/s-et tudnak, kicsit megcibálva simán 300GB/s fölé lőhetőek. A 270 és társai no igen, de azok meg a 128 bites GTX960 ársávjában mennek, ami azért elég szignifikáns difi.... Az AMD-nél az ősrégi 7950/7970-ek többsége is 300GB/s magasságába hozható. A 290-ek tuning nélkül 320GB/s-jéről nem is beszélve, és itt az új 390, 384GB/s-el,és a Fury 512GB/s-el...

Amúgy ami a piaci részesedést illeti, elég sok 7900-as kártya fut, rengeteg 280-as, 290-es, szóval azért bőven van. Nv-től is a 780-ak tisztességes sávszélességgel gazdálkodnak, azokból is szép számmal találni a játékosoknál.Marha egyszerű amúgy. Kinn van a játék, Ultra grafika mehet amelyik kari bírja, a többieknek meg marad a medium meg low fokozat. A BF4 is ilyen volt, GTX780/290-es Radeon alatt nem igazán volt érdemes maxgrafikán erőltetni....

Akkoriban ezek voltak a csúcs....

Akkoriban ezek voltak a csúcs.... -

HSM

félisten

válasz

FLATRONW

#8142

üzenetére

FLATRONW

#8142

üzenetére

Nem feltétlenül. Ha a következő generációs API-knál bejön az aszinkron számítósdi, az önmagában erősen megnövelheti a memória igénybevételét, hiszen az lehetővé teszi, hogy a GPU különböző részei egymás mellett is működhessenek. Abu írta régebben, hogy jelenleg úgy fest, a memória sávszélesség erősen meghatározó lesz az új API-k esetén a kártyák erősorrendjében.

-

HSM

félisten

válasz

FLATRONW

#8138

üzenetére

FLATRONW

#8138

üzenetére

Az a gond, hogy ez így nem teljesen igaz, mivel az időzítések a gyári órajelhez vannak belőve, szóval ha csökkented az órajelet, akkor durván nőnek az elérési idők is, ami viszont visszaüt a sebességnek, hiába nincs kihasználva a sávszélesség.

Viszont a 290-es méri, mennyire van kihasználva a memóriája, ez pl. egy BF4 multi, FHD maxgrafikán Mantle-vel: [link]

Szépen látni, hogy a GPU 100%-on teker, a memória meg ugrál olyan 20 és 50% között, néhány rövid, de magasabb csúcs mellett.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- ASUS TUF Gaming RTX 3070 Ti 8GB GDDR6X OC Edition

- Megvigyázott ASUS TUF RTX 3070 OC, dobozzal, garival

- PowerColor RX 9060 XT 16GB GDDR6 Reaper - Új, Bontatlan, 3 év garancia - Eladó!

- Készpénzes / Utalásos Videokártya és Hardver felvásárlás! Személyesen vagy Postával!

- Sapphire Pulse RX 6700 XT 12GB használt videókártya számlával és garanciával eladó!

- BESZÁMÍTÁS! Apple iPhone 12 Mini 64GB mobiltelefon garanciával hibátlan működéssel

- iPhone 13 mini 128GB Midnight -1 ÉV GARANCIA - Kártyafüggetlen, MS3086

- Apple iPhone 15 256GB,Újszerű,Dobozával,12 hónap garanciával

- Eredeti Microsoft Windows 10 / 11 Pro OEM licenc Akciós áron! 64/32 bit Azonnali kézbesítéssel

- G.SKILL Trident Z RGB 32GB (2x16GB) DDR4 4800MHz

Állásajánlatok

Cég: BroadBit Hungary Kft.

Város: Budakeszi

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) Nembaj, DX11-ben picit gyorsabbak.

Nembaj, DX11-ben picit gyorsabbak.

Én sem véletlen írok egyre kevesebbet....

Én sem véletlen írok egyre kevesebbet....

Jól működő Async módnál gyorsabbnak kellene lennie ennél a végrehajtásnak.

Jól működő Async módnál gyorsabbnak kellene lennie ennél a végrehajtásnak.

Amúgy a tuningot is szépen bírta, csak akkor már visított rajta a hűtés, azt meg én nem bírtam.

Amúgy a tuningot is szépen bírta, csak akkor már visított rajta a hűtés, azt meg én nem bírtam.

A 7950 még ma is megállja a helyét, pedig 2,5 év eltelt....

A 7950 még ma is megállja a helyét, pedig 2,5 év eltelt....