Új hozzászólás Aktív témák

-

Ciccuka

veterán

-

Busterftw

nagyúr

válasz

makkmarce

#157

üzenetére

makkmarce

#157

üzenetére

Fogalmam sincs mirol beszelsz megint.

Olvasd el a hsz-em, hogy mi a lenyeg. Meg azt is irtam, hogy regadtal a chillnel.

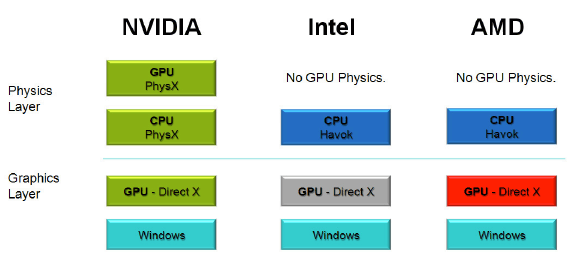

Az Nvidianak nem kell megosztani semmit, ahogy az AMD-nek sem kell.

Ezert nincs *insert proprietary AMD cucc* Nvidian, es ezert nincs *insert proprietary Nvidia cucc* AMD-en.

A kulonbseg az nalad, hogy emiatt az Nvidia csunya rossz bacsi, az AMD meg nem.

End of story."Az mókás, hogy megtaláltad azt a funkciót, ami a lőtéri kutyának se hiányzik, mert SENKI az égvilágon senki se támogatja már"

Te hoztad fel a PhysX-et, ami a mai napig el es virul illetve a hardveres PhysX ugyanugy ott van a 100+ jatekban. -

hokuszpk

nagyúr

majd ABU mondja a frankot, de ugyemlexem aszonta 1:1 -ben megvalositotta az AMD a CUDA fuggvenyeket, a portolas is nagyjabol annyi, hogy a forrasban a hivasok neveit ki kell cserelni az AMD verziora es ujraforditani.

ha lehetne szerintem még a fuggvenynevek is 1:1 -ben stimmelnenek ; nyilvan HW gyorsitassal jobban menne, de ha nincs oka, akkor az AMD annyira nem hulye, hogy feleslegesen egy source to source forditora is eroforrast aldozzon. -

válasz

Busterftw

#149

üzenetére

Busterftw

#149

üzenetére

még mindig nem osztotta meg az nvidia a szükséges információt, nem a gonosz AMD nem ad chill-t, hanem az nvidia nem akarja, az, hogy te mit akarsz, nem releváns.

Az mókás, hogy megtaláltad azt a funkciót, ami a lőtéri kutyának se hiányzik, mert SENKI az égvilágon senki se támogatja már

-

válasz

hokuszpk

#148

üzenetére

hokuszpk

#148

üzenetére

ha jól emlékszem volt valami Intel ellen, hogy kötelezte őket valami biztosság vagy szerv, hogy adjanak licenszet NV nek,de nem éltek vele. tartottak Inteltől szerintem, hogy később ellehetetleníti.

CUDA fordító azért kényszer mert ha hardveresen nincs támogatva akkor mindenképpen lassabb les z és ehhez AMD nek dedikált egységre lenne szüksége. Érthető, hogy inkább külön utat járnak.

-

Busterftw

nagyúr

válasz

hokuszpk

#147

üzenetére

hokuszpk

#147

üzenetére

Ugyanabból az indokból, amiért makkmarce Physx hardveres gyorsítást akar(t) Radeonon, de a csúnya Nvidia lezárta.

De ha AMD teszi ezt saját proprietary cuccal, az okés.

(ez volt végig mondandóm lényege, a Chill csak egy példa volt aminél mindenki leragadt, de mondhattam volna az AMD logót is.)

Az is proprietary cucc és "le van zárva". -

hokuszpk

nagyúr

"Amúgy a Chill szerintem sem jó példa de pont az általatok említett X86 - A64 azlehetne. Azt sem kapja meg bárki."

Tenyleg jobb pelda.

a jegyzokonyv kedveert jegyzem meg, hogy az X86-64 licencelest nem az AMD akadalyozza, ( bar most, hogy erosen huz a Ryzen, már lehet nem a licencbevetelt latnak benne ) Anno az elso XBoxba allitolag tervezett az NV X86 magot, de az Intel beintett. Sima X86 -rol volt szo ( ugye valami 800Mhz P3 lett vegul az XBox procija ? ) amire az AMDnek nagy rahatasa nincs azon kivul, hogy kipereltek maguknak, hogy gyarthatnak olyat, aztan az X64 utan meg lett keresztlicenc-egyezmeny.

Az NV felé tortent Inteles fityisz ota nem is probalkozott komolyabban senki X86 licencet szerezni. -

Ciccuka

veterán

2010 előtt

PhysX

Bullet

Havok -

válasz

makkmarce

#144

üzenetére

makkmarce

#144

üzenetére

Szerintem azért nem annyira rossza helyzet [link]

ha nem megy a multiGPu akkor az a szoftver problémája, a hivatalos támogatás meg van hozzá de nem az elsődlege felületük, ebben igazad van.

Amúgy AMDn is Firepro-t igényel Nvidián meg Qadrot és teslátnekem nem baj, hogy nincs Chill, az szerintem sem jó példa arra amiről beszéltek inkább az X86/ A64.

A CUDAt támogathatná AMD is,soha nem is tervezték, hogy támogassák azt. Ezt már leírta több Nvidás fejlesztő az Nvidia developer fórumán. Gondolom nem fogja Nvidia felkeresni őket ez miatt, hogy rájuk erőltesse -

az opencl-nél direkt van tiltás, nem pedig azért, mert nem lenne képes rá.

Szándékosan készült olyanra, amilyenre, hisz az nvidia is benne volt, simán megoldható lett volna, hogy olyan legyen, ami jól kezeli a multigpu-t is, de ez nekik nem volt szempont. (azért jó egy ilyen társ a szabványban, aki ellenérdekelt annak működésében). Nem azt várom el, hogy ingyen adja oda bárkinek a CUDA platformot, mondjuk azt nem várnám el, hogy az opencl-t elgáncsolja szándékosan. Azt viszont igen, hogy licenselhető legyen egy idő után.

Szép új világ lenne, ha mondjuk az nvidia nem kapná meg a videocodec-ek licensét, aztán software-ből dekódolhatnák a 8k h265-öt, mert úgy viselkednének a piac többi szerelpői is, ahogy ők.Tehát nemkell nekik a chill, akkor miért is baj, hogy nincs nekik?

-

válasz

Busterftw

#142

üzenetére

Busterftw

#142

üzenetére

a physix külön megvásárolható bővítőkártyaként került a piacra az Aegia által amúgy anno .

hogy az Nv megvette annyi változott a zöld kártyákhoz nem kellett PPU a radeonosok meg választhatták hogy vagy PPu-t vesznek vagy egy öregebb Nv VGA-t gyorsítónak. 5 éve ingyenesen elérhető bárkinek.

Amúgy a Chill szerintem sem jó példa de pont az általatok említett X86 - A64 azlehetne. Azt sem kapja meg bárki. -

Busterftw

nagyúr

válasz

makkmarce

#139

üzenetére

makkmarce

#139

üzenetére

Az Aegia is kulon ceg volt, egy jo otlettel/termekkel, megvettek es az Nvidia hasznalja oket.

Miert osztanak meg az AMD-vel?A versenyszferaban, profitorientalt cegekrol beszelunk, ne gyere nekem itt a keresztlicense-el.

Ha az AMD meg akar osztani valamit, ossza meg. De ne ekezzuk mar emiatt az Nvidiat, amikor az AMD-nek is vannak Radeon only cuccai. Ez alszent, hipokrita allaspont.Pontosan, ez a lenyege a versenynek. Miert lenne barmelyik cegnek erdeke, foleg amikor o hozza a jobb cuccot, hogy konkurenciaja legyen?

De ugyanaz, az AMD AMD exkluzivva tette a Radeon Chillt, az Nvidia meg Nvidia exkluzivva tette a gpu gyorsitott Physx-et.

Te azzal vedekezel es ervelsz, hogy Chill nem ugyanaz mint a PhysX, hat no shit Sherlock, nem ez a lenyeg.hokuszpk #140

Az AMD-nek meg megvolt a lehetosege, hogy megvegye az AGEIA-t. -

válasz

makkmarce

#139

üzenetére

makkmarce

#139

üzenetére

Azért ez nem ilyen egyszerű Az Open Cl azért ingyenes mert a CUDA mellett nem igazán rúg labdába ami piac 70 % részét elviszi.

Ráadásul nem csak NV-n hanem Amd -n is problémás a multi GPU támogatás, szóval ez nem egészen Nvidia specifikus probléma.

Fut több GPU-n de megnő sokszor a késleltetés.

Baromi sok erőforrást emészt fel egy szabvány támogatása, gondolom nem azt várod el hogy jófejségből ugyan úgy támogassanak egy nyílt, konkurenciának nagyon megfelelő szabványt, mint a saját maguk által fejlesztett CUDA platformot, amire építkezik az egész professzionális kártya részlegük.. érdekes elképzelésed van az üzleti világról, hogy szerinted jótékonysági intézmények a cégek.Chillre pedig nem volt éppen szükségé az Nvidiának ha megnézed a GTX / pascal fogyasztás teljesítmény grafikonját a vega GCN mellett.

-

válasz

Busterftw

#138

üzenetére

Busterftw

#138

üzenetére

nemsikerült utána olvasnod, itt lentebb pont linkelték.

a HiAlgo a csőd szélén volt egy jó ötlettel, amihez a gpu gyártóktól kértek segítséget.

Lentebb le is írták, hogy miért nincs radeon chill az nvidián, ahhoz bizony megkéne osztani a hozzá szükséges információkat. Míg a HiAlgo külön cég volt, akkor se tették meg, most szerinted, hogy az AMD alá kerültek, majd megfogják?

Tudod e mi az a keresztlicense szerződés.. ahogy az amd-nek van mondjuk x86-tja, az intelnek meg x64-e.. Igazad van, sokkal jobb a usereknek, ha játsza az nvidia a bunkót, és miután beszált az opencl fejlesztésbe is, korlátozta azt 1 gpu-ra a saját kártyáin, nehogy a cudanak konkurenciája legyen

Nem ugyanaz, mert az AMD nem tett AMD excluzívvá se az openclt, se a vulkánt, se az új hangrendszerét(ezt kb 5 percig megpróbálta, de nagy lett a felháborodás).

-

Busterftw

nagyúr

válasz

makkmarce

#137

üzenetére

makkmarce

#137

üzenetére

Forrást linkeljél már. Fogalmam sincs ki mos itt össze dolgokat.

Az AMD megvette a HiAlgot és csak Radeonon tette elérhetővé a Chillt.

Az Nvidia megvette az Aegist és csak a saját kártyáin tette elérhetővé. Ahogy a cuda-t sem adták oda az AMD-nek mert puszipajtások.Tessék utána néztem. De amint írtad, mondhattam volna az AMD-s logót Nvidia kártyán és fordítva. Mert ugyanaz.

-

válasz

Busterftw

#136

üzenetére

Busterftw

#136

üzenetére

pont ezaz, hogy nem, mivel a vulkan kint van, és az Nvidia nincs letiltva róla, ráadásul pont az nvidia mondott le a chillről, nem a gonosz AMD nem adta oda neki.

Ahogy az amd egyből opencl-t csinált nyitottan, az nvidia meg ráerőszakolta a partnereire a cuda-t. 2:0

Neked annyira futotta, hogy hasraütésszerüen próbálsz összemosni mindent mindennel, de valójában utána se nézel. -

Busterftw

nagyúr

válasz

makkmarce

#133

üzenetére

makkmarce

#133

üzenetére

Mindkettő saját cucc.

Te azon voltál fentebb felháborodva, hogy az Nvidia csúnyán lezárta a Physx-et. Azon már nem vagy felháborodva, hogy az AMD ugyanazt teszi, a saját cuccával, ugyanabból az üzleti megfontolásból.Annyira futotta tőled, hogy a Physx és a Chill nem ugyanaz, mintha ez magyarázatra szorulna.

-

hokuszpk

nagyúr

válasz

makkmarce

#134

üzenetére

makkmarce

#134

üzenetére

ja-ja, ABU is ezt irta

-

hokuszpk

nagyúr

válasz

Busterftw

#131

üzenetére

Busterftw

#131

üzenetére

akkor megmondom miert nemtudod a Radeon chill -t NV -n futtatni :

mert az NV nem adta at az implementaciohoz szukseges reszletes doksikat az AMDnek. *

pont mint a CUDA eseteben

* pontosabban annak a startupnak, aki elkezdte fejleszteni, mielott az AMD tokkal-vonoval megvette.

-

Busterftw

nagyúr

válasz

makkmarce

#126

üzenetére

makkmarce

#126

üzenetére

Már hogy ne tudnám. Viszont nem a kettő közti különbségről van szó, hanem a hasonlóságról.

Ugyanis mindkettő proprietary cucc. Ez a lényeg.

És mivel a cégek versenyeznek egymással, beleölik a cuccaikba a lóvét és erőforrást, abból lóvét akarnak látni, mert nem szeretetszolgálat egyik sem. -

-

a physX pont amiatt fut CPU-n, mert nem mehet át GPU-ra, az csak NVIDIA-n mehet, tehát rigid body pár darabból mókás, de a ruha és folyadékszimuláció az már más tészta.

Nem azt mondtam, hogy engedjék át CUDA-t ingyen, bár a vulkánnál ezt az AMD megtette. Hanem azt, hogy az zárt, a partnereire ráerőltette és pont. Ettől függetlenül licenszelhetővé tehették volna.

Az NV nem gyárt játékot, tehát az NV nem használ semmit se a játékaikban, azt az engine fejlesztők döntik el, akik egyik felét az NV, a másik felét az AMD fizeti majd le. A végeredményben meg a user fog szívni, mert X játék jó lesz, Y meg vagy jó, vagy nem, vagy nagyonnem (lásd minecraft RTX vs amd kártya).

A legutóbbi AMD-s RT-s cikkben a LOD-al volt gond, nem azzal, hogy fix e vagy sem az RT blokk, teljesen egyértelmű, hogy az AMD nem fogja utolérni ezzel a módszerrel az nvidiát RT-ben, hisz az RT egy másik egységtől von el erőforrást. (kivéve ha találnak valami trükköt, amit a programozhatósággal megkerülnek, de ez most mindegy).

-

válasz

Busterftw

#115

üzenetére

Busterftw

#115

üzenetére

Őőő, a Radeon Chill, ahogy a nevéből következik, egy Radeon kártyákra kialakított szolgáltatás, ami az AMD VGA meghajtóba van építve. Miért támogatná a GeForce-okat? Már a kérdés felvetése is abszurd.

Más: Van teszt a Neon Noirral az új Radeonokon. Hát, eléggé lemarad a 6800XT a 3080 - tól.

-

Busterftw

nagyúr

válasz

makkmarce

#112

üzenetére

makkmarce

#112

üzenetére

Te, a Radeon Chillt hol tudom bekapcsolni GTX 1080-hez?

Bárhol keresem a listában csak AMD only kártyák támogatottak.

A nagy open source miatt csak nem zárták le "szándékosan", üzleti érdekek miatt?Ez most komoly? Profitorientált cégekről beszélünk.

Egyik cégnek sem érdeke, hogy a saját fejlesztéseit nyitottá tegye, amibe dollármilliókat ölt. A 20-25%-os piaci részesedéssel rendelkező AMD-nek esetleg.

-

válasz

makkmarce

#112

üzenetére

makkmarce

#112

üzenetére

Mert a physx évek óta nyitott és CPU-n fut talán? VGA független.

A CUDA professzionális szintén brutal sok pénz és eroforrasba került ne várd már el hogy ezt majd úgy atengedik mindenkinek. Ez nem egy effekt. X86 és 64 is licensz köteles ha megkapid egyáltalán.Sehol nem olvastam olyat egy cikkben sem hogy Nv megkeruli. Mutasd meg. Mire gondolsz. Már a megjelenés napján nyilatkoztak, hogy minden játékukban szabvány Vulkant fognak használni. Az összes játékuk szabvány RT, kivéve Quake 2. A crytek megoldása nem szabvány. Egy demó. A Windows Dx 12 alapú. Arra tudsz építkezni és Vulkanra.

A programozható bejárás nem azt jelenti hogy nincs dedikált hardver RT re. Mindegyik mai konzol és VGA amin értékelhetően fut hardveres blomkokjal gyorsítja azt. Az RDNA 2 nem fix funkciós blokkokat használ. Magyarul ha RT aktív akkor a dedikált hardver RT szamitasokat végez és elvész a raszter képességbol ha nincs RT akkor természetesen megmarad a teljesítmény. Természetesen nehéz megmondani melyik jobb. Attól hogy van fixfunkció egy adott RT re a bejarható út nyitott marad míg fordítva nem igaz. De viszont ha a fixfunciós blokk nem támogatott akkor csak nehezék a GPU-n. Plusz idővel elavul, de cserébe az RT számítás közben a texturazas nem jelent plusz terhet a GPU többi elemének.

-

hokuszpk

nagyúr

válasz

Busterftw

#106

üzenetére

Busterftw

#106

üzenetére

ahogy olvasgatom, eppen a programozhato bejarast.

csak a szokasos, NV megoldja erobol fixfunkcios blokkokkal, AMD meg kitalalt valamit a konzolok miatt, amit megprobal athozni PC -re, mert elonye lenne belole, de persze megy a szabvany / nemszabvany bennevan nincsbenne, deakkor miertnincsbenne, stb.

Majd b megszakerti. -

az nvidia mindig zárt mindent, aztán megadta a konkurenciának, hogy software-esen emulálja, de tilos volt hw-ből gyorsítani.

miért is nem lehet AMD oldalon hw gyorsított physX?

tipikus másik példa a CUDA, ami megint nvidia exclusive, hiába álltak be az opencl mellé, miközben lefizették a partnereket, hogy csak a CUDA-t támogassák.

Nincs is ezzel semmi gond üzletileg(max a hülye userek szopnak, minek vettek mást), de ne tegyünk már úgy, mintha nem szándékosan lenne minden zárt az NV oldalon.Pont azért linkeltem a crytek-et, hogy ez egy effect, ami RT magok nélkül is köszöni, elvan, és néz úgy ki, mint bármely mostani RT-s játék (tudom, techdemó, játékban lassabb lenne), viszont vígan futott egy régebbi 480-ason is.

Ha olvastad az AMD-s cikket, láthattad, hogy mind az nvidia, mind az AMD meg fogja kerülni, mert elcseszték. (érthetetlen is, hogy mind a DX-en , mint a vulkanon az AMDvel karöltve kuzdenek, aztán csinálnak egy olyat, ami mindenre jó, csak arra nem amire nekik kell, ez igazán balfék lépés volt

).

). -

válasz

makkmarce

#109

üzenetére

makkmarce

#109

üzenetére

Abu mondta ezt többször az nvidia találgatósban volt is több vita erről köztünk.

A Crytek megoldása nem DXR alapú, egy hibrid megoldás egy demó, a crysis és amúgy a DXR is megy Pascalokon .

Nem éppen egy darab effekt, GI, Reflection, stb . Control 6 féle RT eljárást tartalmaz.

A vulkannal összehasonlíthatod, mert épp Nvidia több mint egy éve támogatja RT-t , az összes raytracing játékuk nyílt szabványra épül, Dx 12 és Vulkan alapú, ezért lehetett tesztelni a 6800 kártyákat RT alatt, mert nyitott szabványos megoldás.

Ezzel a 2 hete megjelent szabványos Vulkan RT-t, Nvidia már kijelentette hogy támogatja és áttér rá attól függetlenül hogy van saját megoldása, ma meg az a hír jött hogy AMD megkerüli . [link] érdekes hogy akkor ki zárt és ki nyitott az utóbbi időkben nem igaz? -

válasz

Busterftw

#108

üzenetére

Busterftw

#108

üzenetére

ki mondta, hogy mehetnek a kukába.. vagy 3 cikk jelent meg itt róla, amik kb arról szóltak, hogy az AMD nem lesz már annyira lassú, mint most a régivel.

Az RT 1 darab effect, ami vígan működik RT magok nélkül is.

lásd crytek

Most hasonlítsuk össze mondjuk a vulkánnal, amit meg az amd csinált, csak míg az NV szinte mindent magának tart meg, addig az AMD sok esetben nyíltá teszi a fejlesztéseit. -

Busterftw

nagyúr

válasz

makkmarce

#107

üzenetére

makkmarce

#107

üzenetére

Nem nagyon valasz a memoriara, mert jatek sincs, ez a cucc sincs implementalva, illetve rengeteg hasonlo remhirt talalni ebben a temaban PS4/GCN/Vega temaban, amibol aztan nem lett semmi.

Ugye az is be lett itt lengetve RDNA2 elott, hogy a DXR1.1 miatt a Turinok mehetnek a kukaba,

hat nem igy nez ki.Amit en allitok az az, hogy az RT elhozasaval az Nvidia tobbet hozott el a jovobol mint sok ev alatt az AMD ideigert.

-

Busterftw

nagyúr

válasz

#32839680

#103

üzenetére

#32839680

#103

üzenetére

Ja tudom, a megagyazas utan 5-6 evvel talan jott az elso dx12 jatek es a Radeonok milyen jol szerepeltek ott is az Nvidia multban elo vga-ival szemben. Ja nem.

Ahogy a mai napig nepszeruek a dx11-es jatekok.Nyilvan nem az Nvidiatol vettek at az RT-t, de az Nvidia egy gennel tobbet rakott le az asztalra mint az AMD a sok csoda technologiajaval.

-

wattafaka

senior tag

Ez nem rossz ötlet. A 3070-en is vicc a 8GB.

-

Alogonomus

őstag

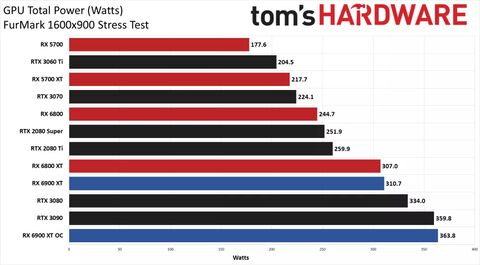

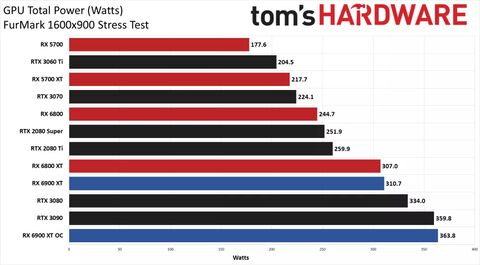

Amit videót linkeltem, abban azt mondja, hogy alapon 377 wattot evett a kártya, míg elengedett fogyasztással 421 wattot evett.

Igazából a kártyáknál nagyon attól függ a fogyasztás, hogy miben méri az ember. Én ezért linkeltem mind a két kártyától ugyanabban a játéknak jelentkező fogyasztást, ugyanattól a tesztelőtől, és így ugyanazon a nyomvonalon mérve.Tavasszal kiderül a fogyasztási helyzet, ha kiadja az Nvidia a duplázott memóriás kártyákat. Addig csak tippelni tudunk.

-

Busterftw

nagyúr

Linusek tesztjeben pl megemlitik, hogy overall kevesebbet eszik a 6900XT vs 3090, de voltak kiemelkedo spike-ok, ahol benyalt 462W-ot.

-

válasz

Alogonomus

#96

üzenetére

Alogonomus

#96

üzenetére

Nem esznek ezek a 3090 kártyák 420 wattotlejjebb belinkelem a CB fogyasztás tesztjét.

Az Asus Strix OC val a 3090 386W a 6900 XT OC pedig 363 W - 8 GB és lassabb rammal... és erről feletted tettem be képet és az FE kártya sebességét hozta. 4 K ban ahogy nézem azt sem. [link]

tehát megy egyszer : nem fog gondot okozni a több ram a fogyasztás szempontjából.

itt se felejtsd el hogy a 3090 24 GB lényegesen gyorsabb Ramot tartalmaz ha a kisebb kártyáknál úgy gondold hogy a fogyasztás gondot okozhat a RAM rátétel szempontjából.

ár / hűtés/ stb nem tudom miért vagy hogy jön ide, de nem igazán kompetens a kiindulási téma szempontjából. -

Alogonomus

őstag

Abban van nagy előnye az AMD kártyáinak, hogy látszólag 450 watt környékén "elfogy" a 3-slotos kialakítás hűtési kapacitása még 1,5 kilónyi hűtőfelület esetén is. Ezért mennek azok a kártyák 2000-es fordulatszám környékén. Mindeközben a 300 wattos 6900 XT kártya ventilátora 1100-at forgott, és úgy is majdnem hozta egy 420 wattos Asus ROG Strix Gaming RTX 3090 teljesítményét.

A referenciakártyákat összehasonlítva (1080p, 1440p, 4K) pedig egyedül a 4K esetén kapott ki átlagosan 6%-kal az RTX 3090-től, de ezt 15%-kal alacsonyabb fogyasztásból érte el. Ezt pedig az overclocking le is dolgozta, amivel még mindig valószínűleg az RTX 3090 fogyasztása alatt maradt.A gyárilag tuningolt RX 6900 XT kártyák minden bizonnyal a szintén gyárilag tuningolt RTX 3090 kártyákat vagy lehagyják, vagy az RX 6800 XT kártyákhoz hasonlóan az AMD döntéséből következően korlátozva lesznek a riválisukkal egyező átlagos teljesítményre, de azt akkor határozottan alacsonyabb fogyasztáson tudják majd nyújtani.

-

-

válasz

Busterftw

#78

üzenetére

Busterftw

#78

üzenetére

olvasd, amit írtam, az nvidia diktálja a jövőt, pont ezt írtam, viszont azt is, hogy a fejlesztők többsége egyre jobban az AMD-s ökoszisztémához fognak kötődni, és nem hiszem, hogy mondjuk 2-3 év múlva ne az AMD-t is támogató RT-vel adnák ki a játékokat. Bizonyos új eljárásoknak nagyobb a memória igénye, amiket még a játékok nem támogatnak, de fognak, ezért van a vram limit, tudják, hogy kelleni fog.

-

válasz

Alogonomus

#86

üzenetére

Alogonomus

#86

üzenetére

nagyon túlzásokba azért nem kell esni.Az hogy OC zol egy kártyát teljesen más eset mint hogy normál módban használod. Ez egy mai teszt a 6900Xt vel és egy 320 ról 350 wattra kiengedett 3080 kártyával.

ha kap még 2x ennyi ramot se fog kardjába dőlni senki mert mint írtam nincs akkora előnye a konkurenciának fogyasztásban hogy ez miatt esetleg ne dobnának rá több ramot ha megoldható lesz.Pár % difi. -

Ciccuka

veterán

válasz

Alogonomus

#86

üzenetére

Alogonomus

#86

üzenetére

Egészen elképesztő, hogy mennyit zabálnak ezek az új csúcskártyák.

-

Busterftw

nagyúr

Tekintve, hogy 2080ti-vel van egyszinten, nem is 4K-ra van kitalalva, mert elobbi sem volt eleg 4K-ra.

Itt pl rtx 3080-el tesztelt a csavo az uj Afterburner betat, ami mar valos hasznalatot is mutat.

Metro Exodus: Max settings (no DLSS) @ 4K (DSR 2.25x) (5.3GB usage, 9.5GB allocated. Lowered to 5.1GB usage soon after) -

edward2

addikt

válasz

andy19770128

#88

üzenetére

andy19770128

#88

üzenetére

3070essel a gépben csak annyit tudok mondani ez a kártya 4K-n teljesítményben már most határeset a 8 giga vram ki sincs használva. Mire kilenne ez a kártya már nem fog annyit teljesíteni így felbontást kell csökkenteni.

Példák amivel játszottam:

Metro exodus 1440 extreme, rt ultra: 60fps (vram 5g körül)

Gta V: 4k max (redux mod) 2xmsaa éppen 60fps (7g ram)

Death stranding: 4kban éppen 60fps (ramot nem néztem) -

andy19770128

aktív tag

válasz

Alogonomus

#86

üzenetére

Alogonomus

#86

üzenetére

Gddr6x és ramok fogyasztása több mint a sima ramoké

-

Alogonomus

őstag

Az biztos, hogy a dupla ramos kártyákból fele annyit tudnának gyártani, bár arról máig nincs biztos információ, hogy a ram, a gpu, vagy egyéb ok korlátozza a kártyák boltokba kerülését.

A fogyasztás azért lényeges, mert már az RTX 3080 húzott változatai is 360 wattról indulnak, és 420 wattig mennek az ahhoz tartozó 2200 rpm ventilátorsebességgel, míg az RX 6800 XT húzott változatai 320-330 wattról indulnak, és 350-360 wattnál be is érik az RTX 3080 OC kártyák eredményeit 1700 rpm ventilátorsebességgel, és csak azért nem lehet továbbhúzni, mert az AMD mesterségesen bekorlátozta a gpu és ram sebességét.

A plusz 20-30 watt a dupla memória miatt az RTX 3070 és 3080 mutatóit abszolút elrontaná. Az RTX 3080 380-450 wattos fogyasztással és hűvös környezetben is 2500 rpm ventilátorsebességgel nem lenne versenyképes.

Ráadásul az AMD simán feloldhatja (feljebb engedheti) a mesterséges korlátozást a saját kártyáinál, ha az Nvidia a dupla memóriával érdemi gyorsulást mutatna. -

Busterftw

nagyúr

válasz

andy19770128

#84

üzenetére

andy19770128

#84

üzenetére

Hat a cegek szerint ez a jovo. Ezert hozta ki Nvidia utan az AMD, a konzolok is tudjak es az Intel gpu-ja is. A kulonbseg csak annyi, hogy mire eleg a hardver.

Az elso 3D jatekok es a mostani kozott is van kulonbseg.

2D eraban pedig az volt a jovo. Itt sincs maskepp. -

Robitrix

senior tag

értelme nem is igen vaqn a 6-8 GB-nak csúcs erejű GPU-k mellett. ilyen nyers erőket már inkább 4K-ban használ az ember. oda meg akkor már kevés 6-8 GB. közepes GPU-k esetében van értelme 6-8 Gb-nak mert azokkal inkább a FHD vagy esetleg QHD van megcélozva.

-

válasz

Alogonomus

#80

üzenetére

Alogonomus

#80

üzenetére

Bármikor jöhetnek, meg van engedve a rajt óta a gyártóknak hogy dupla ramos verzióval is gyárthatnak. Egyelőre Micron 2021 első hónapjaira írja a 2 GB GDDR6X modulokat. Épp pár napja lett bejelentve a 16 GB rammal szerelt Mobil 3080 valószínűleg az sima GDDR6 lesz. Nincs megkötés az Nv részéről.

Akár már holnap is jöhetne.

Az ok amiért nem jön az az tulajdonképpen, mert így 2x annyi kártyát tudnak legyártani azonos ramból a gyártók a 3070 és 3060 Ti/ RDNA 2 esetében, mivel állítólag GDDR6 sincs elég.Senkit nem érdekel hogy 320 vagy 350 W a fogyasztása ha cserébe 20 GB gyorsabb sebességű ramot kap vagy esetünkben 16 GB-ot kap azonos sebességen. A Konkurenciának messze nincs annyival jobb fogyasztási tényezője,- 10 %-15% nem az- hogy ez számítson, de a 2x annyi ram már viszont számíthat főleg 1440P- 4K képes kártyáknál.

A kérdés ki lesz az első fecske aki nyarat csinál a gyártók közül és duplázza ramot, mert onnantól követni fogják a többiek is. Tippre EVGA lesz. -

Alogonomus

őstag

A dupla ramos verziók addig valószínűleg nem érkeznek, amíg nem halaszthatatlan, mert az a fogyasztást is feljebb tolná még úgy is, ha 2 chip helyett a dupla kapacitású chipeket teszik a kártyákra. Az Ampere pedig már most is határozottan az "éhesebbik" versenyző.

Egyedül a pletykált RTX 3080 Ti korai kihozása lehetne hasznos, ha valóban egy RTX 3090 lesz, csak fele annyi memóriával, és így 30-40 watt spórolással. 12 GB már valószínűleg elég lenne a 2021-es játékokhoz is 4K és ultra beállítások mellett. Persze ezzel az RTX 3090 piaca zuhanna legalább 80%-ot, mert 24 GB valóban csak a professzionális szintre kell.

-

Busterftw

nagyúr

válasz

makkmarce

#76

üzenetére

makkmarce

#76

üzenetére

Tehat a jovo diktalasat abban merjuk, hogy melyik gyartotol van CPU/GPU a konzolokban?

Igen ezt mondtam, ez volt a duma a PS4/XBOX-nal is, ami 7! eve megjelent.

Azota is varjuk a jovot.Ezzel szemben az Nvidia 2 eve elhozta az RT-t PC-re (es a DLSS-t), azota jott megegy gen, most koveti az AMD es a konzolok. Persze 16GB vrammal, elso genes RT teljesitmennyel.

Az Nvidia mar sokkal tobbet elhozott a jovobol 2 ev alatt, mint az AMD az elmult 7 evben.#77 andy19770128

"a 10 GB is 3080 egy elbaszott tétel. Pöpec GPU kevés van. Ennek spórolás szaga van"

Ezt a gent kiszolgalja, nincs mas szaga. Ha 2 ev mulva keves lesz, akkor ott lesz a 3090 24GB vrammal, RTX 4080 12-16GB vrammal vagy AMD megoldas. Lehet feljebb valtani. -

andy19770128

aktív tag

válasz

Busterftw

#16

üzenetére

Busterftw

#16

üzenetére

Csak azért írtam hogy f4 mert az a kedvencem. Az meg tény hogy a foglalás nem azonos a használattal. Ez olyan mint amikor van 3 gyereked és nem zafirát veszel hanem egy caddy maxit....holott egy Zafira is elég többnyire. a 10 GB is 3080 egy elbaszott tétel. Pöpec GPU kevés van. Ennek spórolás szaga van

-

válasz

Busterftw

#75

üzenetére

Busterftw

#75

üzenetére

nem, az nvidia bizonyos szintig diktálja a jövőt pc oldalon, de kisebb a rálátása a konzol oldalon.

A piac 80%-a az csak a DIY szektor, hisz ha hozzávesszük a konzolt, akkor már közel sem 80% az a 80%, de abban biztos lehetsz, hogy az összes nagy címnek az a target HW, nem az asztali pc-d. Ha abban van valami, amihez több VRAM kell, akkor bizony több VRAM kell, és lehet, hogy visszabutítják a kedvedért PC-re, de lehet, hogy nem. (lásd gta3 ps3-ról portolt pc verzió. Az elején diafilm volt az egész, mert 9 mag mégse 2, hiába erőlködött az intel, hogy 2 mag elég mindenre).Nem hiszem, hogy az AMD bármikor olyat jelentett volna be, hogy lesöpri az nvidiát, ez inkább a fanboyok elvárása volt, én azon meglepődtem, hogy a 6800xt hogy szerepel, egy kategóriával lentebb vártam kb. a 3070 szintjére.

-

Busterftw

nagyúr

válasz

makkmarce

#70

üzenetére

makkmarce

#70

üzenetére

Szerintem meg a piac 80%-ával rendelkező Nvidianak legalább ugyanannyi ha nem több rálátása van a jövőre.

Pontosan ez volt az AMD gondja eddig. Hozták nekünk a sok jövőt, Oszkár bácsi meg nem gyütt.

Ez volt a narratíva itt PS4-kor is, meg minden egyes Radeon rajt előtt, ment a hype épp melyik jövőbelátó ígérgetés forgatja majd fel a piacot és söpri le az Nvidiát.Lásd RadeonVII vs 2080 esete.

Azt már nem említem meg, hogy ott is volt balhé, amikor a DMC 5 bemutatón fejlesztők 12gb vramot emlegették az AMD kérésére, vegye mindenki a 16gb RadeonVII-et. Az userek védelme miatt természetesen.

Valóság meg kicsit más volt. -

Feri7619

tag

Azt senkitől nem olvastam eddig, még csak említés szintjén sem, hogy az Nvidia 20-40%-ot javított a 20-as szériához képest a Vram tömörítési eljáráson!! Vagyis ennyivel több adat fér el ugyanannyi fizikai memóriába! Ezek tudatában írták, hogy nem igényel a 3080-as 10 Gb-nál több memóriát! Egyébként is, a lefoglalás, és a tényleges szükséglet közt van különbség!

Aki 4k-ra használja, és mondjuk 27-es monitora van, simán kikapcsolhatja az Anti aliasing-et.. már ez is önmagában nagyjából -800MB!!

A jövőre nézve, 4k -ban a 60fps fix lesz a sarkalatos pont! A jelenlegi játékokon is épp elérik, picivel túlhaladják a 60-at, de a next gen játékoknál 60-altt lesz mind a 3080, mind a 6800XT!

Ahhoz, hogy a 60-at elérjék majd, lejjebb kell adni a beállításokat, viszont ezzel együtt csökken a Vram igény is! Vagyis itt is életbe lép, hogy elég lehet a játékok 95%-ánál a 10Gb. Na meg egyébként is... legfeljebb nem használunk 8k textúrát, hanem csak 4-et, máris elég, és szinte észrevehetetlen különbség. Nem kell annyira kétségbe esni!!! -

válasz

Busterftw

#33

üzenetére

Busterftw

#33

üzenetére

egy openworld játéknál a vram szükséglet az kb végtelen+1GB.

Nem panikkeltés van, hanem egy meghatározott cél. Szerinte aki most vesz mondjuk egy 6900XT-t, amit holnap bemutatnak, az kidobja egy év múlva, ha kijön az új? Nem mindneki cserél évente, visont az AMD-nek jóval nagyobb a rálátása az eljövendő technológiákra, mint nekünk, biztos meg van az oka, hogy ezt kéri.

Ez a kérés az AMD részéről a usereket védi, ezt hisztériakeltésnek nevezni mókás. -

haxiboy

veterán

Nvidia természetesen védi a saját álláspontját, így majd a 4000 széria eladható lesz azonos teljesítmény mellett már megfelelő mennyiségű VRAM lesz.

AMD ismét előre gondolkodik, biztosan van valamilyen memóriaintenzív fejlesztésük amit még nem akarnak bemutatni. -

g@norbert

tag

válasz

kikikirly

#58

üzenetére

kikikirly

#58

üzenetére

,, Ettől még van fejlődés csak nem annyira szembeötlő"

Gondolom Ciccuka is pontosan erre gondolt, hogy nincs olyan robbanásszerű fejlődés mint régen volt, fantasztikus, jól látható különbség az előző szériához képest, aminek a kedves játékosok nagyon örülnek.

Megmondom őszintén, nincs szerves igényem arra egy autós üldözés játék közben, hogy a kukás autó mögötti alkalmazottat, ahogy a telefonját nyomkodja, teljesen élethűen lemodellezzék, hogy még a telefon márkája is kivehető legyen, netán az üzenet tartalma is a kijelzőn, mert ez biztosan roppant erőforrásigényes, és értelmetlen is szerintem.

Felvetődik a kérdésemre kapásból a válasz is, ilyenkor, ha egy játékban rengeteg olyan dolog van hihetetlenül aprólékosan, szakszerűen, bár szerintem teljesen feleslegesen kidolgozva, akkor lehet hogy párhuzamosan hihetetlen sok felesleges dolognak van olyan profi árnyéka, hogy az ember szeme könnybe lábad, és ezért a 20gb vrammal szerelt vga, amit nem lehet majd se megvenni mert nem lesz, se kifizetni, mert olyan hihetetlen drága lesz.

-

Piistii

tag

Én nem rég vettem 3070-es karit. Jobban járok ha elállok tőle és várok egy kicsit ?Főleg wqhd-ban nyomom a játékokat .

-

akaido

addikt

Bár ezt már akkor is váltig tagadta. Annyit elismert, hogy sok hülyeséget mondott - ki nem?- de ezt a 640-es elszólást nem ismerte el, mégis rajta ragadt.

Lehet csak annyi történt, mint amikor Dr.Aga Jánosnak ellopták a kabátját, aztán a harmadik szomszéd már úgy adta tovább a 4. szomszédnak, hogy: "Hallottad, a Dr.Agának volt valami kabátlopásos ügye..." -

g@norbert

tag

Teljesen jó egyébként ez a vram matek, mivel az rtx 3060Ti 8gb kártya lenne a megváltó, az a bizonyos nagyon várt, és ,, alacsony költségvetésű népkártya ", ami fullhd felbontáson, bekapcsolt sugárkövetéssel, elvileg magas, vagy ultra beállításokkal lehet játszani az új, játékokkal, ami egy nagyon jó hír a fullhd felbontáson játszó játékosok népes táborának, beleértve engem is.

Csak az itt a bibi, hogy természetesen nem is lehet kapni, de a hardveraprón ma láttam fennt 205-235 ezer körül már lehet kapni, egy olyan videokártyát, amelyiknél a sugárkövetés bekapcsolásával kompromisszummentesen lehet már játszani fullhd felbontáson.

Ok, de most ez ennyi pénzért miért is népkártya?

Mivel ez lesz a fullhd high, ultra + RT on kártya, nem hiszem hogy olyan nagyon le fog menni az ára, mivel fullhd felbontás alatt nem nagyon játszanak,így elképesztő lesz rá a kereslet.

Ez akkor így szinte tökéletes, ismét jól alárugtak a ,, csak " fullhd felbontáson játszó játékosoknak, de sajnos nem is vártam mást, sebaj majd ha olcsóbb lesz kicsit a mostani felénél, akkor majd veszünk egyet,

-

egyetértek, 2020 ban 250-300 K-s, 6-700 dolláros kártyákról beszélünk.ne itt spóroljanak a rammal.

Amivel nem értek egyet illetve hogy ez megint honnan származó infó:

" Ezen a ponton ráadásul gyökeresen eltér az AMD és az NVIDIA véleménye, ugyanis utóbbi cég szerint még nem kellenek nagyobb kapacitású VRAM-ot alkalmazó VGA-k."ha így lenne nem jönne 16 GB rammal a 3060 és 3070 majd később vagy 20 GB 3080.

Az hogy most kiadták kevesebb rammal nem azt jelenti amit írtál Abu, hanem hogy ennyivel voltak kénytelenek kiadni mert nem volt elég GDDR6X. A gyártóknak a kezdetektől megengedték, hogy legyenek több ramos verziók. -

Yany

addikt

Ezt az egész "mire elég a VRAM" cirkuszt le lehet tesztelni mesterségesen lefoglalt VRAM-mal elindított játékokkal. Erre is lehet csinálni benchmarkokat és nem kell szájkaratézni a valós/teoretikus lefoglalásról.

-

Ciccuka

veterán

válasz

zoltszalay

#55

üzenetére

zoltszalay

#55

üzenetére

Grafika igen javult, de nagyon lassacskán megy ez végbe manapság. Régebben robbanásszerűnek hatott. Abból kiindulva ennél jobb minőséget vártunk volna.

Egyre kevesebb újítást hoz a DirectX is.

16 év után is érdemes elővenni, főleg ingyen

És itt még PhysX nélkül megoldották a jó fizikát -

kikikirly

senior tag

Ezzel én is vitába szállnék.

Nyers grafika igenis egyre szebb(modellrészletesság,objektum szám,textúrák felbontása stb, emberek, autók mennyisége).

Azért érzékeled lassúnak a fejlődést mert úgy 8 éve elértünk egy olyan szintet aminél nem érzed kevésnek a grafikát. Gondolok itt pl a Quake 3 aréne steril/üres termeire VS GTA4 utcák is ki vannak dolgozva részletesen, emberek és autók járkálnak fel alá, szóval él is a város.

Ettől még van fejlődés csak nem annyira szembeötlő.

Fizikába tényleg nincs egetverő előrelépés, viszont ott vannak az animációk, animációk minőségébe és komplexitásába egyaránt történtek előre lépések. Vagy ott a sérülés modellezés, 2020-ban szinte minden AAA játékba van valamilyen formában, és mindegyik megvalósítás elég jól néz ki. Játékmechanikákról nem is szólva, mostanra minden játékba fejlesztheted a karaktert és felszerelésedet, eltérő felépítésű mellék küldetések, felfedezés extra lootokért stb.

GTA 4 valóban minőségi ugrást jelentett minden szempontból. -

Puma K

nagyúr

válasz

zoltszalay

#55

üzenetére

zoltszalay

#55

üzenetére

A játékmechanikákat és fizikai interakciókat azért kell sajnos egyszerűsíteni vagy akár teljesen kivenni (leragasztott hordók, bútorok, asztali elemek vagy akár járművek... stb-stb), mert a játékosok jelentik a legnagyobb bug forrást...

Nem csak hogy extra számítási igényt támaszt amit ugyan nem lenne nehéz megugrani adott időközönkénti csepegtetéssel az újdonságokat, de a játékosok olyan szintű problémát jelentenek amik miatt le kell butítani adott dolgokat.

Nekem pl semmi bajom nem volt a GTA IV-gyel... legalább 1500 órám belement anno online-offline vegyesen. Viszont vannak a sima egyszerű játékosok akiken kifogott a játék fizikája és az autók vezetése... ami miatt nem volt jó élményük és inkább letették a játékot ha megvették. Ha pedig másnál próbálták ki akkor nem vették meg mert küzdelmes volt az irányítása adott járműveknek...

A való életben sem tud bárki elvezetni egy autót

Nem hogy még egy több száz lóerős sportkocsit amik rendszerint hátul hajtanak![;]](//cdn.rios.hu/dl/s/v1.gif)

Mindig az ember a hibák forrása

-

zoltszalay

tag

Megtorpant? Ugyan https://youtu.be/FCeEvQ68jY8 de a gta4nek is jobb fizikája volt, élethűbben reagáltak az emberek mint az gta5ben.

A grafika különben sokat javult azzal nem teljesen értek egyet, de az Xbox classicnál van nálam az a szint, amire azt mondom hogy mai szemmel is elmegy

-

tupacamaru

veterán

Az AMD ugyan egy rövid ideig kínál még referenciadizájnra épülő új generációs Radeonokat, de hosszabb távon ezeket kivezetik, így a gyártópartnerek saját dizájnjai átveszik a terepet. A Radeon RX 6800 és 6900 sorozat esetében erre várhatóan tavasszal kerül sor, vagyis jövő nyáron már elég nehéz lesz referenciamodelleket szerezni,

Mikor lesz majd könnyű?

-

Ciccuka

veterán

Ezt még hozzátenném:

Crysis, Half-Life 2, FarCry után eltelt idő óta grafikai vonalon túl nagy előrelépés nem történt az elmúlt 1.5 évtizedben azt lehet mondani. Az ez irányú fejlődés borzasztóan visszalassult.PhysX (fizikai gyorsító motor) fejlesztése is teljesen megtorpant.

Sorozatban jönnek az újabb és újabb vga-k, de általában nincs kézzelfogható érdemi fejlődés. A játékok pedig egyre silányabbá válnak, csak a grafika lesz "szebb?" valamivel. Legalábbis én így látom.

-

Ciccuka

veterán

válasz

Alogonomus

#48

üzenetére

Alogonomus

#48

üzenetére

2020

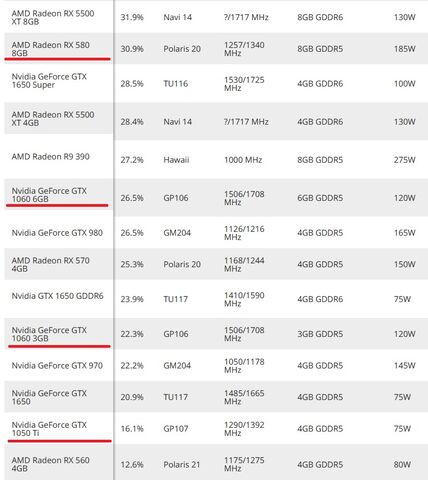

Kiszámoltam itt 17%-nyi a különbség (de mint írtam a GPU megnyirbálása is benne van erősen).

Tomshardware-t nem érdemes komolyan vennigbors

TechPowerUp-nál is GTX 1060 3GB a leggyengébb vga, amivel még tesztelnek ezen a szintenShing

Ez inkább "Pro user" szinten jelenthet problémátMég USÁ-ban se vesznek meg mindenféle drága vga-kat. A game készítőknek úgy kell alkotniuk, hogy amennyire csak lehet elég nagy réteget fedjenek le már, ami a játékok megfelelő színvonalú futtathatóságát illeti. A GTA5 például egész jól lett optimizálva ilyen szempontból.

-

paprobert

őstag

Végre normális a hozzáállás.

Generációváltás elején vagyunk. Nem az elmúlt 6 év kritériumainak megfelelő VGA-t kell gyártani/venni, hanem a következő 6-nak.

-

Alogonomus

őstag

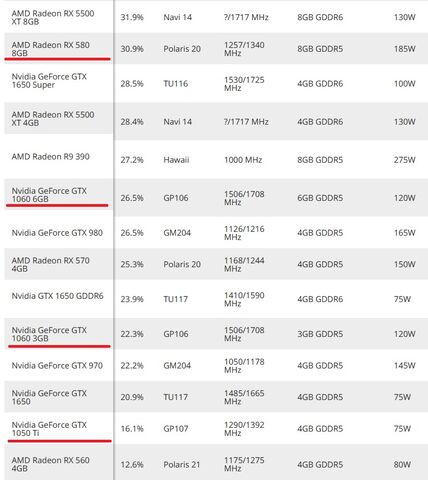

Fontos különbség, hogy egy GTX 1050 Ti esetén általában már elfogadták a tulajdonosok, hogy egy 2020-as játékhoz az kevés, és kész. GTX 1060 esetén viszont a tulajdonosok még a kártya múltbeli teljesítményéhez mérnek, és úgy vannak vele, hogy ha egy RX 580 elég a 2020-as játéknak, akkor a GTX 1060 is elég lesz.

2020-ban ez viszont már nem volt igaz.

-

Shing

őstag

Igen, ma már sokáig bírják a GPU-k összességében. De azt képzeld el ha mondjuk a GTX1070 4GB-ot kap. Nehogy már azért ne lehessen feljebb venni a grafot mert a VRAM kevés. Az AMD a legújabb széria, legerősebb kártyáiról beszél. Egy ilyennel már elleszel 6 évet simán. Akkor már nagyon kevés lesz a 6-8GB VRAM.

Ahogy az 1060-t is limitálja mára a 3GB, hiába volt még megjelenéskor elég. pl. Cyberpunk-nál biztos nagyon érezhető lesz. -

Ciccuka

veterán

Egyébként meg nem véletlen butították le a 3GB-os változat GPU-ját. Ha ezt nem tették volna meg, akkor lennének olyan tesztek, ahol csak 1% lenne a különbség (biztosan nem lett volna akkora hype a nagyobb memóriás változat körül).

Pug

GTX 1050 Ti 4GB-al is sokan elvannak még, pedig az jóval gyengébb, mint a GTX 1060 3GB. Átlagembernek ez a teljesítmény még megfelel ma is. Maximum a grafikai részletességnél kötnek egy kis kompromisszumot. Egyébként játékfüggő is nagyon, de az biztosan ritka, hogy a kevesebb memóriás ugyanolyan vga-n nem fut jól, de a több memóriáson viszont simán megy esete. -

Ivy.4.Ever

őstag

Nem elég lesz, hanem jelen időben elég mindenkinek. Ha már kiemeled kontextusból legalább pontos lehetne, de még az se

Másrészt ezt Bill Gatesnek tulajdonítják, de sokkalta nagyobb blama volt inkább Neumanntól az, hogy nincs szükség lebegőpontos számításra utasításkészlet szintjén mert egy "valamire való matematikus észben tudja tartani".

Másrészt ezt Bill Gatesnek tulajdonítják, de sokkalta nagyobb blama volt inkább Neumanntól az, hogy nincs szükség lebegőpontos számításra utasításkészlet szintjén mert egy "valamire való matematikus észben tudja tartani". -

Ciccuka

veterán

válasz

Alogonomus

#40

üzenetére

Alogonomus

#40

üzenetére

De itt ebben az esetben kb. max átlagosan csak 10%-nyi sebességdifferenciáról van szó és az se számottevően a ram mennyiségéből ered, ami nem olyan eget verő különbség. GTX 1060 3GB vs 6GB

-

Shing

őstag

Ennek van értelme. Ki vesz manapság 2-3 évre kártyát? Még aki csúcskategóriából is válogat. 6-8GB semmire nem lesz elég a jövőben, miközben a GPU nyers teljesítménye még mindig elegendő lenne.

Anno a HD7000, GTX600-as szériát is az 1GB VRAM nyírta ki, pedig lett volna még kakaó. A 2GB+-os változatok sokkal tovább voltak használhatóak.

-

SindaNarmo

tag

válasz

Busterftw

#33

üzenetére

Busterftw

#33

üzenetére

Szóval nem nézted meg, valószínűleg nem véletlenül van 10GB-ra belőve az igény.

Szóval az NV sem fog kifutni a memóriából, nem kell félni.

Így ami különbség van az nem a memória mennyiségből fog adódni.

Arról nem is beszélve, hogy egyenlőre csak NV-ken lesz RT ha jól tudom. -

gzoli2

tag

hát ez visszaüthet a 300 dollár alatti új kártyáknál ha az Nvidia emitatt olcsóbban tud 8 gigas válozatot kinálni a 6700 ellen

-

Busterftw

nagyúr

válasz

makkmarce

#29

üzenetére

makkmarce

#29

üzenetére

"érdemes megnézni a CP2077 VRAM igényét, RT-vel és annélkül."

Aztan majd lehet magyarazkodni, hogy a 10GB 3080-en miert fut jobban a jatek RT alatt mint a 16GB-os Radeonon. (Nem neztem teszteket)Mire lesznek olyan konzolportok az meg kb 2-3 ev. Addigra kijon megegy gen.

En csak azt mondom, hogy jelenleg felesleges a panikkeltes. -

16Ks textúra = 16.384x16.384 pixeles textúra.

#25 Yutani : a határ ott van, ahol a játékok készítői megszabják a beállításokkal, ugyanis sokan (különösen a high end kártyák vásárlói) ragaszkodnak a "minden max" megközelítéshez. Ha ennél szofisztikáltabb akarsz lenni, akkor minden egyes játékban meg kell nézd, van-e érdemi különbség mondjuk a high meg az ultra szint között, és ehhez hozzá kell vedd a nagyobb VRAM miatti árkülönbséget. Szóval sok meló.

-

janeszgol

félisten

Nagyon helyes. Az AMD a közeljövőre tervez! (A távoli jövő meg ki tudja mit hoz, de biztosan nem 6 meg 8 gigás vram igényeket.)

-

-

válasz

Busterftw

#16

üzenetére

Busterftw

#16

üzenetére

az SMA , és az RT miatt is kell

eddig mindig a ram-ba betöltötték a modelleket és a texturákat, utána fellőtték a GPU-nak, épp ami kellett, most majd az SSD-ről közvetlen a GPU-ba megy a nagy része, így nem kell redundánsan tárolni CPU oldalról, viszont azért SSD-ről kicsit lassabban tölti, ezért jobb, ha nem fél frame-nyi adat fér el benne, de ez nem mostani, hanem a jövő, ezt még kevesen használják.A másik az RT, ahol írták, hogy az új megoldások simán gigákat zabálnak, és nem akar az AMD csonka kártyákat, ahol minden döcög, mert kisprórolta a külső gyártó a ram-ot. (érdemes megnézni a CP2077 VRAM igényét, RT-vel és annélkül.)

Mivel minden konzol cím RT-s lesz, így a PC-s átíratok is, ezért mindenképp biztosítani kell az RT zavartalan működését pc-n, ami 8 gigába 4k-s felbontásnál használt textura minőségnél már most se fér bele 8 gigába (ahogy a fentebb említett CP-nek se fért). -

genlog

aktív tag

De mi az, hogy 16K-s textúra? Kis darabokból áll össze az egész látvány, objektumonként külön textúrákkal, nem? Természetes, hogy ha közel mész egy tárgyhoz, részletesebb legyen, mintha 2 km-ről néznéd.

A GTA 6-nak valószínűleg a világ memóriája sem lesz elég ezekhez a kártyákhoz képest. -

GhostRider93

tag

Akinek jelenleg 8gb-os 5700/2060super vagy jobb karija van fullhd felbontason max beállításokkal is el lesz de ha nem fontos a 60+ frame qhd is menni fog max nem lesz minden maxon és a 6gb is elég lesz nagyon sok embernek fullhd-ra egy 2060/5600xt személyében . 4k-ra már kelleni fog a 8+ de az emberek elenyésző százaléka használja (itthon) ezt a felbontást. Nekem nagyon tetszik az új radeon 6800 de az 5700xt-t nem fogom lecserélni mert egyrészt rengeteget kellene ráfizetni másrészt inkább megvárom a kövi generációt es akkor esetleg ha lesz nyomott áron 6800xt talán veszek (vagy 3080-at ha lesz több vramos kiadása).

-

-

A magasabb felbontású textúra nem elsősorban a magasabb felbontás miatt kell, hanem azért, hogy amikor közelebbről nézed a cuccot, akkor ne kezdjen el pixelesedni / homályosodni (nyilván nagyobb felbontásnál ez látványosabb).

Ebből következően, bár a memória szűkössége először valóban 4K-ban fog jelentkezni, a többi felbontás sokkal gyorsabban fogja követni, mint ahogy sokan arra számítanak. -

GodGamer5

addikt

Azért ennek örülök, hogy egy "olcsóbb" 100k körüli kártyán (rx6600) végre alap lesz a minimum 8giga ram. Az alap rtx2060 is nevetséges ilyen szempontból a 6 gigájával, de most még kb pont elég.

-

A Radeon RX 6800 és 6900 sorozat esetében erre várhatóan tavasszal kerül sor, vagyis jövő nyáron már elég nehéz lesz referenciamodelleket szerezni,

Mert most nem nehez, csak eppen lehetetlen...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

ALBY

senior tag

Biztos emlékeztek hány és hány különböző lebutított VGA verzió került pluszban forgalomba régebben.Volt egy csomó kártya az aktuális menő sorozat nevén, de megnyomorítva DDR4-el, más órajellel, felezett sávszéllel stb.

Szerintem ezt nem akarja az AMD, ami nem is baj.

Aki olcsóbbat akar vegyen a régebbiekből, nem kell mindig a teljes sorcsere, és főleg nem a sok félrevezető modell.Képzeljétek el, Ifj. Veér István hónapok óta ugrál apukájának hogy milyen jó az a 6800 kártya nagyon szeretne olyat szülinapjára (direkt nem a karácsonyt írtam

). Apuka elszánja magát hogy Pistike jó gyerek volt végülis és elmegy a kompúterboltba hogy szeretne egy hatezernyolcszázat. Lát a listában 16 féle darabot, fogalma sincs, megveszi a legolcsóbbat fele rammal de egy halom pénzért.

). Apuka elszánja magát hogy Pistike jó gyerek volt végülis és elmegy a kompúterboltba hogy szeretne egy hatezernyolcszázat. Lát a listában 16 féle darabot, fogalma sincs, megveszi a legolcsóbbat fele rammal de egy halom pénzért.

Pistike örömmel bontja az ajándékot, aztán indul a hümmögés mikor az FPS számláló meg sehol sincs a várthoz.... -

-

Puma K

nagyúr

Az AMD a kedves öreg és védtelen néniből kezd harcias és házsártos öregasszony lenni

-

Busterftw

nagyúr

válasz

andy19770128

#7

üzenetére

andy19770128

#7

üzenetére

Lefoglal, nem hasznal.

Ne egy 5 eves jatek legyen mar a merce, ami a a 9 eves Skyrim oskovulet motorjara epul.

A Skyrim is hasonloan pazarlo a VRAM lefoglalasat illetoen.Nezz 10GB-al szerelt 3080 teszteket 4K-ban.

-

Én előszeretettel kritizálom az AMD-t a túlzottan jövőbe mutogató megoldásaik miatt, de jelen esetben egyetértek velük. A 8GB / 6GB 2016-ban jött be ezekben a kategóriákban, lassan el fog jönni az idő, amikor sorban jönnek azok a játékok, ahol súlyosabb kompromisszumra lesz szükség az ilyen kártyákkal. Senki nem tudja, mikor, de ha ők arra számítanak, hogy 2021-ben, az éppenséggel nem hangzik irreálisan.

-

CoroStar86

senior tag

Az AMD vastag borítékot kaphatott a Microsofttól a FS2020 miatt.

-

andy19770128

aktív tag

hát pl A fallout 4 4k patch melett 4k felbontáson ultrán . 12-14 gb-t lefoglal..... amennyiben egy vga alkalmas 4k gamingre lehet hogy van értelme a 12-16 gb re. az alatt meg minek

-

kikikirly

senior tag

Amig nincsenek kint a 16 és 20gbos Ampere kártyák persze hogy ezt mondják zöld oldalon.

Tudnám akkor miért terveznek kiadni 16gb-os 3070-et és 20gb-os 3080-at?

Másrészt milyen jól hangzott DX12 istenitése során hogy a többszörös gpu kihasználtság, az Async compute és társai miatt csak úgy ,,izzani" fognak a multiprocesszorok stb. Fantasztikus előrelépés hogy nem hatékony GPU kihasználtságat sikerült leváltani pazarló memória menedzsmentre...

Gépigények alakulására is kiváncsi leszek 2 év múlva amikor a játékok már csak a Next Gen konzolokra jelennek meg és nem fog limitálni a PS4/Xbox1 számítási kapacitása.

-

Turmoil

senior tag

Másfél hete, ugyanitt: https://prohardver.hu/hir/radeon_vegtelen_gyorsitotar_amd_rx_6000.html

"Multimédiás szinten újítás lesz az AV1-es formátum támogatása a dekódolás oldalán, illetve az AMD kiemelte, hogy az új VGA-k támogatják a DirectX 12 Ultimate, illetve a DirectStorage API-kat is. Főleg utóbbi miatt van 16 GB VRAM egységesen a termékeken, ugyanis az utóbbi fejlesztés megnöveli a GPU fedélzeti memóriájának terhelését."

-

akaido

addikt

...mert "640 kilobájt elég lesz mindenkinek"...

-

#60662784

törölt tag

Amennyibe kerülnek, még jó, hogy nem spórolnak a ramon

Új hozzászólás Aktív témák

- GYÖNYÖRŰ iPhone Xs Max 256GB Black -1 ÉV GARANCIA - Kártyafüggetlen, MS3537, 100% Akkumulátor

- HIBÁTLAN iPhone 13 256GB Pink -1 ÉV GARANCIA - Kártyafüggetlen, MS3422

- ÁRGARANCIA!Épített KomPhone Ryzen 7 5700X3D 32/64GB RAM RX 7800 XT 16GB GAMER PC termékbeszámítással

- Samsung Galaxy S24 Ultra 8/256 GB Titanium Gray 6 hónap Garancia Beszámítás Házhozszállítás

- AKCIÓ! Apple Macbook Pro 16" 2019 i9 9980HK 64GB 500GB Radeon Pro 5500M notebook garanciával

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Nem igazán húzó ficsőr. UE és Unity is nagyon szépen használja, ez jó dolog , hardvertől függetlenül min fut.

Nem igazán húzó ficsőr. UE és Unity is nagyon szépen használja, ez jó dolog , hardvertől függetlenül min fut.

ma is használja egy csomó motor.

ma is használja egy csomó motor.

es most erzem elerkezett idonek a cserejet.

es most erzem elerkezett idonek a cserejet.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

). Apuka elszánja magát hogy Pistike jó gyerek volt végülis és elmegy a kompúterboltba hogy szeretne egy hatezernyolcszázat. Lát a listában 16 féle darabot, fogalma sincs, megveszi a legolcsóbbat fele rammal de egy halom pénzért.

). Apuka elszánja magát hogy Pistike jó gyerek volt végülis és elmegy a kompúterboltba hogy szeretne egy hatezernyolcszázat. Lát a listában 16 féle darabot, fogalma sincs, megveszi a legolcsóbbat fele rammal de egy halom pénzért.