Új hozzászólás Aktív témák

-

jedis

senior tag

válasz

oraihunter

#145

üzenetére

oraihunter

#145

üzenetére

Ez a hires Woodoo 6 6000-res videókari, amit csakpár mérnöki példányban készítettek el, mert mire sorozatba került volna, a 3DFx becsődölt ! A gyűjtők Szent Grál-ja !!!!

-

Abu85

HÁZIGAZDA

A több GPU nem ilyen egyszerű. Az igazából a motor szintjén semmilyen formában nincs leprogramozva. Ügyelni kell rá, hogy kevés legyen az interframe kommunikáció, de mást a motorban ezzel nem lehet tenni. Az adott játék problémája, ha a több GPU nem megy, vagy nem úgy megy, ahogy kellene.

-

TTomax

félisten

válasz

FragMaster

#141

üzenetére

FragMaster

#141

üzenetére

Igen és ez a legnagyobb baj,mert ha lenne alternatíva a piros oldalon,akkor az nV nem tudna pofátlanul árazni...

-

Abu85

HÁZIGAZDA

Ne tekintsünk a Crytek gondjaira úgy, hogy ezek állandóak. Nyilván nem volt tökéletes a stratégiájuk az utóbbi időkben, de léptek és különböző licencek (főleg játéklicencek) és stúdiók eladásából stabilizálódott az anyagi helyzetük. Ráadásul ez pont nagyon rosszul jött ki nekik, mert akkor kerültek gondba, amikor be kellett építeni az AMD API-ját a CryEngine 3.5-be, de nyilván logikus volt meglépni, mert egyszerűbb lesz majd DX12-re portolni. Szép lassan visszakerülnek a normális mederbe, és újra lesz pénz arra, hogy ne csak az AMD és az Intel, hanem az NV architektúráit is vizsgálják, ami majd jobb optimalizációt eredményez a GeForce-ra is. A mostani helyzet csak egy átmeneti probléma, és ilyenkor logikus, hogy csak a fontos architektúrákra koncentrálnak.

-

Abu85

HÁZIGAZDA

Megint belekeverünk a dologba olyan szoftveres tényezőket, amik javíthatók. Mind tudjuk, hogy a Cryteknek az elmúlt időszakban gondjaik voltak, ami bizonyosan érintette a cég fejlesztéseit. A CryEngine 3.4-en már korábban is látszott, hogy a GCN-en kívül nincs más architektúrára igazán jól optimalizálva. Ez a hátránya annak, amikor egy szoftvercég anyagi problémák elé néz. Megvágják a K+F-et és elsőként bizonyosan azoknak az architektúráknak az optimalizálása kerül háttérbe, amely drága lenne, és igazából nem is kritikus fontosságú. Ez megint nem egy tisztán hardveres probléma. Majd ha újra lesz kellő pénzük, akkor NV-re is jobban fognak optimalizálni.

-

TTomax

félisten

válasz

#32839680

#135

üzenetére

#32839680

#135

üzenetére

Ugye az eljutott tudatig,hogy mindkét gpu 28nm-en van,és hogy a zöld -100W fogyasztással 256bittel veri el pirosat?Majd még az nV lesz a hibás mert a pirosak nem hajlandóak fejleszteni,mert olyan okos gput terveztek,hogy ahhoz már nem is kell nyúlni,és igen a 980at van hova hizlalni,majd meglátjuk a 290Xet hova lehet...

De mindegy is.... az eladások is azt igazolják amit firkálok,és ezek a cégek ebből élnek,és ebből tudnak fejleszteni...

(#137) Abu85

'Majd ha újra lesz kellő pénzük, akkor NV-re is jobban fognak optimalizálni."

Ha csak nem nyernek a lottón,mert komoly hiba a piac 5%ra (talán még annyira sem) optimalizálni...

-

-

jedis

senior tag

válasz

#32839680

#122

üzenetére

#32839680

#122

üzenetére

Értelek , de szerintem egy GTX980 a 180EFt-os árával semmiféle képen nem nevezhető középkategóriának ! Sőt, amíg ki nem jött(GTX), az R9 290X-et sem nevezném, a tavaly őszi 160EFt-os árával középkategóriának ! Én ezeknek a "kétfejű szörnyeknek", és a professzionális ( aranyárú) érából visszabutított sznob kártyáknak adnék egy külön kategóriát, mondjuk lehetne "SuperTOP" kategória, ami a csúcskategória felett helyezkedik el ! Ennek a "SuperTop" kategóriának meg nem sok értelmét látom, ha máshogy nem ár/érték arányilag tuti, mert a "herélt" Quadro-kba sok olyan dolog van alapból, amit a játékok nem nagyon használnak, de az árat azért nem kicsit sokszorozza ! A dupla GPU-s kártyák, (vagy legyen SLI, vagy CF) meg soha sem skálázódtak 100%-osan , pár programot/játékot kivéve, de azért a dupla ( extra ) "póvert" meg bekajálták !

-

-

jedis

senior tag

válasz

#32839680

#119

üzenetére

#32839680

#119

üzenetére

Azért nem hiszem, hogy a "gondtalan" nyugaton minden második gépben GTX980 SLI, vagy R9 295 van !

Ezt csak azért írtam, mivel egy GTX980-as kint sem középkategória attól függetlenül, hogy simán megengedhetné magának, akár melyik Gamer a 3-4000 Euro-s fizetéséből ! Ettől függetlenül életem legdrágább ( keresetemhez arányosan nézve ) videókártyája, a híres Diamond Monster woodoo 1 volt anno 97'-ben !

Ezt csak azért írtam, mivel egy GTX980-as kint sem középkategória attól függetlenül, hogy simán megengedhetné magának, akár melyik Gamer a 3-4000 Euro-s fizetéséből ! Ettől függetlenül életem legdrágább ( keresetemhez arányosan nézve ) videókártyája, a híres Diamond Monster woodoo 1 volt anno 97'-ben !  37800Ft-ért vettem, és azidőben olyan 40EFt körül kerestem. Szóval potom egy havi fizum volt ! Most elképzelhetetlennek tartanám ( ÉN ), hogy kiadjak 220EFt-ot egy VGA-ért !

37800Ft-ért vettem, és azidőben olyan 40EFt körül kerestem. Szóval potom egy havi fizum volt ! Most elképzelhetetlennek tartanám ( ÉN ), hogy kiadjak 220EFt-ot egy VGA-ért !

Azt a 70-et is "fogszívva" adtam ki a 3 hónapos DirectCU2-es 290-ért ! Igaz közel sem játszom annyit mint anno , de azért azt elvárom a géptől, hogy sima High-ba elvigyen mindent normális sebességgel 2560x1080-ba ! A 300-as széria nem nagyon érdekel , el vagyok 1-2 évig a mostani konfiggal ! Majd ha jön az FM3+ DDR4-el, meg a 16-20nm-es dVGa-k, akkor váltok ! Az AMD úgy is az APU+dVGA páros felé nyomja az ipart, de amíg az begyűrűzik, az AM3+ -nak, meg a 8350-esemnek lesz egy-két jó napja !

Azt a 70-et is "fogszívva" adtam ki a 3 hónapos DirectCU2-es 290-ért ! Igaz közel sem játszom annyit mint anno , de azért azt elvárom a géptől, hogy sima High-ba elvigyen mindent normális sebességgel 2560x1080-ba ! A 300-as széria nem nagyon érdekel , el vagyok 1-2 évig a mostani konfiggal ! Majd ha jön az FM3+ DDR4-el, meg a 16-20nm-es dVGa-k, akkor váltok ! Az AMD úgy is az APU+dVGA páros felé nyomja az ipart, de amíg az begyűrűzik, az AM3+ -nak, meg a 8350-esemnek lesz egy-két jó napja !

-

sb

veterán

Vagy nem érted amit írok vagy terelsz.

Most jött ki pl. egyik régi kedvencem, a HoMM 3 HD verziója. PC-re, droidra, iOS-re.

Ez most attól függetlenül, hogy nagy kedvenc volt rókabőr, nem? Semmi hozzáadott értéke nincs.Írtam, hogy a PC hw-k nem fejlődnek (amit egyébként te is írtál már korábban más topicban) és így nincs sw oldalon fejlődés.

Erre hoztad példának, hogy az energiahatékonyság viszont nagyon hasít. PC-ből is vannak már kazánnál kisebb csúcsteljesítményűek, ill. leszivárog lassan a régi átlagdesktop teljesítmény mobilba: telefon/tablet.

Erre írtam én, hogy ez igaz, de ettől még nem lesz játékokban innováció és ez rókabőr. Ezt nem érted, pedig elég egyszerű:

1. PC-n, mivel nincs előrelépés csak azt értük el, hogy 300W helyett 100W-ból ugyanaz a komplexitású game, mint 5 éve. De ebben a hw/sw környezetben újat, nagyobb komplexitásút nem fogsz kapni. Összerakhatsz SLI-ben 980-al egy 300W-os konfigot ma is, mégsem kapsz semmivel jobb grafikát/AI-t/fizikát. Mert behatárolt az sw/api része. Ez a lényeg, amiről beszélünk már egy ideje. És ez attól független, hogy most milyen jó, hogy 100W PC-vel elvagyunk. Az jó, de tök más téma.

2. Mobilba leszivárogni megint nem fog semmi új. Tudsz mobilon COD-ozni, HL2-őzni meg HoMM3-azni.

Pont ugyanazt, mint 10 éve. Ezt kinek adod el újra? Ill. majd harmadik körben megint? Érdekesnek érdekes és technológiailag megsüvegelendő, de ezen kívül még gyakorlati haszna se nagyon van. HoMM3 pl. tabletre pont frankó, de egy COD??? Soha nem lesz az. Monitorra (vagy inkább TV-re), egérre jó. Mindig is az marad.Szóval ez így mind nulla ahhoz, hogy igazi előrelépés legyen. Hogy legyen egy jobb AI-d, mint 10 éve, jobb fizika, mint a HL2-ben volt, vagy jobb grafika is akár a kevés rajzolási paranccsal.

Ehhez kell a low level api, a heterogén programozás (persze az integrált hw mellett).Vagy ezt fejleszted és sw-re gyúrsz. Akkor tud valami újabb/jobb születni, hw fejlődésből mint fentebb látható már nem. (De ha fejlődne a hw akkor se, mert pl. a draw call az limit. Akkor is limit ha most kijönne egy 100W-os, 3x980 teljesítményű gpu.)

Vagy sehova nem lépünk előre… cserébe pl. egy ilyen HoMM3 újraírás meg ugyanúgy fejlesztői munka volt. Szerintem tök feleslegesen…

Persze nekem jól jött. Ha el tudják adni újra akkor a kiadónak/fejlesztőnek is. De a világ nem lépett előre vele. Harmadjára nem lehet majd eladni. Vagy a HoMM4-5-6-ot pl. ilyen formában droidra. Ebből nem lehet a végtelenségig megélni sem, ha csak az lenne a cél és nem a hosszú távú, nagyobb/fenntarthatóbb/eladhatóbb fejlődés.szerk: Írom ezt úgy, hogy egyébként a legnagyobb fan vagyok energiahatékonyság terén. "Nagygép", ITX terén is évek óta nyomom itt ezeket. De a hw abszolút mértékű fejlődése és az sw oldali lemaradás ettől független.

Ill. ha összefügg akkor pont fordítva: sw oldali optimalizációval már ennél is sokkal jobb lenne a hatékonyság. -

proci985

MODERÁTOR

miert, 970 SLI ket honapja kevesebbet fogyasztott a 295nel (145Wos tdpvel szamoltam, mondjuk az se fedi a valosagot), olcsobb is volt, nagyobb volt a hutofelulet, ket kartyara is pciE 3.0am van, plusz 4kban is hOCP teszt alapjan kb egyformat mentek.

---

decemberben valtottam 7850 CFrol, en megvagyok lejjebb vett grafikaval es 60 alatti fpssel is. plusz nagyreszt meglepoen eleg volt mindenre a 970 egyedul is, szoval nem ereztem, hogy ne tudnam megvarni a kivezetes koruli learazast a masodik kartya megvetelere

XaraX: arra azert ugyelj, hogy a gyakorlatban 200W korul esznek a gyari tuningos 970ek is. csak tesztekbol ez kevesbe tunik ki, mert aranyaiban a 290es szeria se TDPn fogyaszt ahogy neztem.

nagy gamer en se vagyok, viszont altalban igy szoktam pihenni, amennyire keves a szabadidom, abban meg nem finomhangolassal akarok szorakozni. 7850eket emiatt csereltem, mert egy kartya mar sajnos lowra se volt eleg harom kijelzon ha nem ment a CF a driveren meg meg csiszolni kellett volna.

Drizzt: hetfon lesz postazva, csutortokon kaptam feladovevenyt de pentek nem volt idom elfutni a postara.

-

XaraX

addikt

válasz

proci985

#110

üzenetére

proci985

#110

üzenetére

Nekem nem sürgős, nem vagyok nagy gamer.

Kivárom a döntést, hogy mi lesz a vége, vagy veszek használtat

A 970 számomra megfelelő a "hibájával" együtt is, ami érdekel, a kielégítő teljesítmény, ha szükséges, ( még ha apró kompromisszumokkal, az sem zavar), viszont mindez aránylag kis fogyasztással, ezáltal kevés hőtermeléssel, alacsony zajszinttel.

Ahogy a topicban olvasom, sokaknak az MSI, Asus Strix az álló ventijei miatt nem nyerte meg a tetszését, számomra az egyik vonzereje.

-

LordX

veterán

"According to that little test, it seems that OpenGL applications are not concerned by the VRAM allocation limitation of the GTX 970 (but they are certainly affected by the reduced speed of the 0.5GB memory that run at 1/7th of the speed of the 3.5GB memory pool). Most of the video games are Direct3D applications and that explains why many people have seen that issue."

Szóval pontosan ugyanaz van ott is.

-

Jack@l

veterán

Ezen is érdekes rágódni egy sort:

http://www.geeks3d.com/20150127/opengl-apps-not-impacted-by-gtx-970-vram-limitations/ -

proci985

MODERÁTOR

pedig valahol igaza van, ha tudok a problémáról, nem vettem volna 970et. 290xet sem biztos, de 970et biztos nem. viszont a 970nek helyettesítő terméke a 290x.

XaraX: nem tudom mi lesz. használtpiacon számítanak sokan a kártyákra, de mindenki küldi vissza őket, sajátom is megy vissza. eladni bukó lenne. persze, használtam két hónapot, de másik oldalról meg valakinek ki kellett tesztelni, hogy hibás a kártya, úgy meg a szokásos óránkénti produktivitásomat nézve a total cost of ownershipemhez képest visszaküldeni is bukás lesz így is.

nagyon kevés szabadidőm van mostanában, és elment két napom hogy rendesen utánnajártam.

-

XaraX

addikt

Egyébként, hogy teljes legyen, meg is fogom venni.

Viszont e miatt kivárok, vagy csak használtat veszek, ami a "kirobbanás" előtti vásárlás.

Csak biztonsági okokból, mivel nem gondolnám, hogy az Nvidia bármit is tenne, max driverben mókolnak valamit.

Számomra, mivel nem vagyok nagy játékos, így is megfelelő lesz, nem hajtom meg a fogatot annyira, hogy lesántuljon.

A gyártó hozzáállása viszont semmiképpen nem nevezhető pozítivnak, azt gondolom.

Lásd a P67-es B2-es lapok esetét, az talán lehetne példaértékű. -

XaraX

addikt

Bárhogy nézzük, ez mindenképpen megtévesztés, azt gondolom.

Az egésznek a legnagyobb vesztese anyagilag az AMD, az USA-ban mindenféle tyúkperekben borzasztó összegeket ítélnek meg hasonló esetekben.

Ha helyes specifikációval adták volna ki alapból, ki tudja, hányan nem vették volna meg.

És ugyancsak ki tudja, hányan választottak volna helyette AMD terméket...

Nem kétséges, hogy ha két 4 lovas fogat van eladó, és az egyiknél azt állítják, hogy jóval kevesebb takarmánnyal is megelégszik, melyiket választod.

Viszont, ha X teljesítmény fölött az egyik lónak eltörik két lába biztosan ebben a fogatban, hát az nem hiszem, hogy szerencsés.

Tulajdonképpen ott van a törött lábú ló is, mint ahogy ígérték, de minek.

Ha ezt előre tudod, tudsz mérlegelni, hogy ebben az esetben is megveszed, vagy inkább a másikat, még ha többet is fogyaszt.

-

sb

veterán

A raytrace egy példa voltcsak amúgy. Nem az a lényeg sikerült-e. Az, hogy HA sikerül technológiát váltani akkor általában az előző úgyis kuka. Vagy ha nem kuka akkor ragaszkodni kell a régi korlátokhoz és határokhoz.

Írtad még a 970/980-at mint középkat. Ott se mész semmire azzal ha jön egy 2x gyorsabb kártya. Felbontást talán tudsz vele skálázni, de 2x részletesebb/jobb/több AI-t, fizikát tudó játék attól se lesz. Ha 4x gyorsabb vga-t gyártasz akkor se. Oda is az sw oldali paradigmaváltás kell: új api, hogy a 2-3-4x vga-t ne egy cpu szál fogja vissza. Meg gpgpu párhuzamos programozás x86 helyett... plussz heterogén programozás.

-

sb

veterán

Olyan van, de az nem abszolút mértékű fejlődés. Csak hatékonyság.

10 éve a csúcs PC-den futott a Far Cry, ma egy mobilon. Ennyi.Ettől jobb/szebb játék nem született. Szvsz engem pl. hidegen is hagy, hogy ugyanazt most lenyomják pár év alatt mobilon ami előtte PC-n ment. Rókabőr.

Persze ebből tökéletesen megélnek bizonyos fejlesztők, mert van akinek kel ugyanaz harmadjára is. De ez nem fejlődés és innováció.

A komplett PC-s hw+sw játékfejlesztés nem tud és nem fog mobilra váltani.

Márpedig PC-n nem tudsz jobb sw-t és hw-t eladni ha nincs előrelépés. Ott és nem mobilon. -

arn

félisten

azert kozben van hwfejlodes epp az alacsonyabb tdpszinteken... tobbszorosore nott az elerheto teljesitmeny a par evvel korabbihoz kepest. ez lesz a kulcs a feljebb skalazasnak es az alacsonyfogyasztasu rendszereknek is.

a raytrace vagy 20 eve jon... amikor eloszor talalkoztam vele demokban a 90es evek elejen, epp ugyanebben a cipoben jart a dolog

-

#72042496

törölt tag

A legfelső kategóriát nyugodtan telepakolhatják, gondolom jól jön amikor LN2-vel a kártya lelkét is kihajtják. Ez az ami egyébként egy kicsit sem érdekel, az viszont annál inkább, hogy a GTX 970-et szemlátomást trehányul rakta össze a legtöbb gyártó, ezért sípolnak rajta a tekercsek.

Ez speciel a VRAM fiaskónál jobban aggaszt, legalábbis amíg a nagy többséghez hasonlóan egy szobában vagyok a géppel.

-

sb

veterán

Értem miről szól a probléma.

Nem azt mondom, hogy generációkat lépkedve nem okoz gondot a low level api. Mindig gond volt, mindig gond lesz.De elértünk oda, hgoy amit írsz az már nem igaz: pc-n volt hw fejlődés ezért nem kellett innováció. Viszont ez leállt több éve, ezt te magad is beláttad.

Konzolon is leállt, oda is kell a "nextgen" kinézet eladni. Mit raktál volna be a nappaliba? 400W-os hw-t? A konzolokban is a hw fejlődés leállása okozta kényszer a low level felé indulás. (Ill. ott régi adottság is a platform zártsága miatt a low level és jó optimalizáció)Azt írod ha megint lépünk pár generációt. Hova? Mivel? Ez az ami nem néz ki ma, de ha te látod hova lépnénk konkrétan akkor írd le.

És a fentebb írtakat is megfordíthatod: Hova lépsz konzolon tovább? Hova lépsz pc-n tovább hw-ben?A 970 fixet meg nem érted... vagy én nem értem.

Miért kell külön jobban figyelnie a 970-re a fejlesztőnek? Eddig is voltak 1, 2, 4GB-os kártyák. Ha írsz egy kódot ami nem skálázódik és benyal 10GB vramot akkor eddig is cseszhetted. Akár van driver akár alacsony szinten vagy.(Plussz driverben megírni is költség... csak a hw gyártónak. Erről beszélek, hogy rendszerszinten a költség az költség.)

Most már nem akarom tovább ragozni, mert egyszerű szerintem mint az 1x1.

Ma X költségszinten van az egész gamer hw+sw ipar. Ebből kapsz hw szinten Y teljesítményt, a játékon belül 0.5Y-öt mondjuk.

3 felé tudsz továbblépni:

1. Hw-ből gyártasz 2Y teljesítményűt és az sw marad a régi, nem kell rajta semmit átírni. Megúsztad az sw költségeket, kérdés, hogy a 2Y teljesítményhez mennyivel nő az X költség. El tudod képzelni, hogy tudunk nagyokat ugrani teljesítményben azonos költségszinten, mint 10 éve? Cpu-ban? Gpu-ban?

2. Marad az Y teljesítmény és megpróbálsz sw-t fejleszteni, hogy pl. 0.8Y jöjjön ki belőle. Ez is növeli az X összköltséget, mert erre ma a megoldás az alacsony szint ami sokkal több optimalizációt és kompatibilitási fejlesztést igényel. Az a kérdés, hogy az 1. pontnál nagyobb a költség vagy kisebb.

3. Marad az Y hw és 0.5Y kihasználtság. Meghal az ipar: nem tudsz újat eladni, se hw-t, se sw-t. X lecsökken (mert a bevétel is lecsökken) 0.5X-re.Az 1.pont a kulcs, ha szerinted tud hosszú távon, mondjuk 1-2 évente duplázódni a teljesítmény akkor OK. Ha nem tud akkor az 1. pont költsége végtelen gyakorlatilag, tehát a 2. mindenképpen jobb út. Költséget is lehet vágni, mert nem kötelező támogatni minden hw-t. (ráadásul 1-2 gen után lehet váltani és kényszeríteni a usert, hogy vegyen újat. ez így sw oldali költségstop + hw oldali keresletnövelés)

A 3. út meg fenntarthatatlan. Nyilván visszalépésből fejlődni nem lehet.Azt már nagyon off-ként írom, hogy technológiailag is a 2. a jobb modell. Olcsóbb egy ideig a régi dolgok és a kompatibilitás fenntartása, a'la x86... de egy idő után az innováció kerékkötője és elérkezik a pont amikor többet veszítesz mint nyersz. Aki fejleszt szerintem mind érezte már a "nem írom újra a régit, mert túl sok munka, inkább kiegészítem..." majd pár év után, a "p*csába, jobb lett volna kihajítani és újraírni, már rég jobb lenne és költséget is kevesebbet vinne" érzést.

Renderben majd jön egyszer a raytrace, amikor a raszteres rendert és gpu-kat kidobhatod. És igen, nem fog futni rajta a 20 éves FarCry1. Nincs más lehetőség, el kell várni néha a régi utat a fejlődés miatt.

Általános számításban meg a hetergoénnek kell jönnie. Cpu-ban +5-6% évente... miközben a "költséges" újraírt cpu+gpgpu-s proginál lenne 5-10x gyorsulás. Egyszer muszáj váltani különben leragadunk végképp. -

arn

félisten

pcnel ez mindig is igy volt... sokkal tobbet ki lehetett volna hozni az aktualis hwbol. az innovacio inkabb azert maradt el, mert az elsodleges piac a konzol, es az onnan kipotyogo portok nem igenyeltek tobbet. a pcs hw elerte azt a szintet, hogy marmilyen ramaty kodot rohogve futattott egy kozepszintu hw is.

most itt a valtas, ez nem mukodik, ha hasonlo konzol-pc minoseget akarnak csinalni, mint korabban. elkezdek keresni a megoldast a meglevo "gyenge" architekturak miatt, ujra elojott az alacsony szintu api.

viszont ha megint lepunk par generaciot, megint eloall az a helyzet, hogy a ratyi kodot a sokszorosan gyorsabb hw is rohogve kiszolgalja, mi a fenenek optimalizalnanak tovabb? raadasul a lassu jatek adja el az ujabb hwt, nem a gyors. az elmult evek belassulo es arakat felvero spiralja, most jol is jon nekik. konnyen lehet, hogy a mostani 970/980 megy a kozepkategoriaba (az elmult evek tdp osztalyai alapjan oda is tartozik), mikozben dragabban adjak, mint korabban a felsokategorias kartyakat valaha.

a 970et most fixelhetik drvbol, de alacsony szinten kulon kell ra figyelni. ez plusz raforditas a swfejlesztok reszerol.

-

sb

veterán

Hw és sw külön gyártó, de kéz a kézben jár.

Korábban is így volt, amikor a játék miatt vettél új hw-t.Ez kopik ki lassan, de biztosan.

Hogy adod el a 22. COD-ot? Vagy bármelyik címet? Mostanában csak sz*r AAA-król olvasni. Mit adsz el hw gyártóként? Szinte sehova nem fejlődünk.

És ezzel állítsd szembe a hw kihasználtságát, amit leírtam. Parlagon hever a gép 50%-a.Ha zárt rendszerként nézed a hw+sw piacot akkor is megéri a hw gyártónak inkább sw fejlesztésbe invesztálni, mert -4-6nm vagy egy komplett architektúra újratervezés (ami amúgy ugyanúgy kompatibilitási gondokat jelent) is egyre drágább. Egyébként meg ott a kihasználatlan teljesítmény a mai hw-kben is.

De nem zárt rendszerként nézd ezt a két piacot. A költséget a bevétel fedezi, a bevétel kívülről jön a fogyasztótól. Ha a két piac együtt süllyed a lefelé tartó spirálban - mert nincs út a fejlődésre - akkor mindkettőnek szar.

Vagy te azt látod, hogy a hw gyártóknál pörögne az innováció az elmúlt 4-5 évben és a fejünket kapkodjuk, hogy melyiket vegyük? Esetleg a gyártástechnológiai forradalmak zajlanának? Sw oldalon? Jönnek a jobbál jobb, úttörő grafikájú vagy AI/fizikai/játékmenetű alkotások? Avagy a rakás sz*rnak tűnő, összedobált vackok?

Előbb utóbb ki kell lépni ebből, mert nem hoz pénzt.

Szóval ez számomra tisztán elvi/költség oldali kérdés. Ha a jelenlegi bevételek nem tarthatóak, ill. a költségszint sem tartható (vagy adott szinten csak kisebb bevétel elérhető) akkor valamerre muszáj lépni. Méghozzá arra amerre a legkevésbé fáj.szerk: A 980/970 "optimalizálás" problémát nem igazán értem. Ez nem optimalizálás, le kell korlátozni 3.5GB-ban a memhasználatot. Amíg driveren keresztül megy addig ott, amint a játékfejlesztő menedzseli, ott. De ez csak annyiból áll, hogy X ill. X/2 memóriahasználatra kell felkészítened a kódot. Ez eddig is létezett. Vagy ha nem akkor ugyanúgy belassult a program. Ill. részben automatikus is, mert textúramérettől, felbontástól függ nagyrészt, hogy mennyi vramot foglalsz le. Tehát egy része menni fog amúgy is. Ez nem low level optimalizálás hanem alapszintű programozás szvsz.

-

#06658560

törölt tag

Volt már több cikk itt is, hogy jelenleg van cirka tíz GPU architektúra a piacon, amire optimalizálni kéne. AMD oldalon is több

hiába GCN mind, a memóriakezelés terén akkora eltérések vannak, hogy nem elég egy optimalizáció. Vagy lásd jelen cikket, egy architektúra, két működés. -

nemlehet

őstag

Mondjuk azért annyira sokféle szabvány nincs mint régen volt. Van 2 processzorgyártó (jó meg a VIA de az szinte nem is kimutatható), 2 videókártyagyártó. Az Intel sem változtat gyökeresen architektúrát állandóan+ a hardverközeli APIknál ugye látjuk, hogy jelentősen esik a processzorterhelés.

Az Nvidia most mutatta be a Maxwellt, az AMD meg egy jó ideig a GCN mellett fog maradni illetve már egy jó ideje a GCN-t nyüstöli kisebb nagyobb módosításokkal.

Szóval egyáltalán nem lehetetlen a dolog a kérdés, hogy van-e rá szándék. Amúgy meg a sokak által emlegetett az "újabb kártyán szarabbul fog menni a játék" mert nem lesz rá optimalizáció szerintem nem annyira veszélyes, mert nyers erőből is menni fog. 2-3 év alatt egy felső kategóriás kártyából lesz kb középkategóriás szóval én nem aggódnék annyira.

-

stratova

veterán

No ez szerintem most egy teljesen korrekt cikk lett.

-

arn

félisten

nem a koltseg a lenyeg, hanem hogy ki fizeti

a swfejleszto, vagy a hwgyarto. a hwgyartonak kenyelmes atpasszolni a munkat, de szvsz par szponzoralt neven kivul sokan nem fognak raugrani. max ugy tudnak kikenyszeriteni a dolgot, hogy sokaig hagyjak a piacon a termekeket, de ha a hwgyartok elkezdenek egymasra licitalni, nem fognak egy generacion belul is x fele optimalizaciot csinalni.

a swfejleszto, vagy a hwgyarto. a hwgyartonak kenyelmes atpasszolni a munkat, de szvsz par szponzoralt neven kivul sokan nem fognak raugrani. max ugy tudnak kikenyszeriteni a dolgot, hogy sokaig hagyjak a piacon a termekeket, de ha a hwgyartok elkezdenek egymasra licitalni, nem fognak egy generacion belul is x fele optimalizaciot csinalni.ha mar egy ilyen szintu dolgon (970/980) bukik a dolog, mi lesz ket gyarto vagy generacio kozotti valtasnal? ezt most szepen fixelik drvbol, de mennyire orulnenek a jatekfejlesztok, ha a kiizzadt 980 optimalizacio utan egy alig butitott kartyanal is csinalhatnak egy alternativat.

de ez az en velemenyem - a jelenlegi felallassal nem fog mukodni. vagy az api vagy a hwoldalrol kell megkoteseket csinalni. konzolnal a hw is kotott volt, a pcnel csak az api.

-

arn

félisten

mint eddig, altalanos api... az alacsonyabbszintu dolgok pcn sose mukodnek. nem csak winen, dos alol se. ott is mindenfele szabvanyokat (vesa, sb, etc) meg libeket hasznaltak a videohoz, hanghoz a vegen. par kiveteltol eltekintve, nem hatekony alacsony szinten fejleszteni csillio fele hwre.

ha mongy lenne egy gyarto, aki sokaig nyomat egy architekturat, vagy keves fele hw van, mint a macnel. ott talan. pcn? kizart... tudom, hogy most megakadtak a dolgok, de majd talalnak mas utat. ennek a megakadasnak amugy szvsz sokkal inkabb a konzolok az okai, okafogyotta valik a jobb hw, ha nincs mit megjeleniteni ra. erdekes modon ez addig senkinek sem tunt fel, amig nem jott az ujabb konzolgeneracio.

most jott egy ujabb loket, es persze az elmult evekben nem igazan volt tul sok elorelepes a korabbi fejlodesi szinthez kepest, keves hozza a hw. kezenfekvo volt ehhez nyulni. de az ujabb hwgeneracio majd feljebbemeli a lecet - biztos vagyok benne, hogy hwes szinten is nagyobb lesz az elorelepes, mint mongy ket eve volt. az nv mar el is inditotta a maxwellel - eddig nem lattuk, hogy mi fer a megszokott tdpbe, de majd a amd 3xxel kiderul, hogy hol is allunk hwileg.

-

válasz

#72042496

#85

üzenetére

#72042496

#85

üzenetére

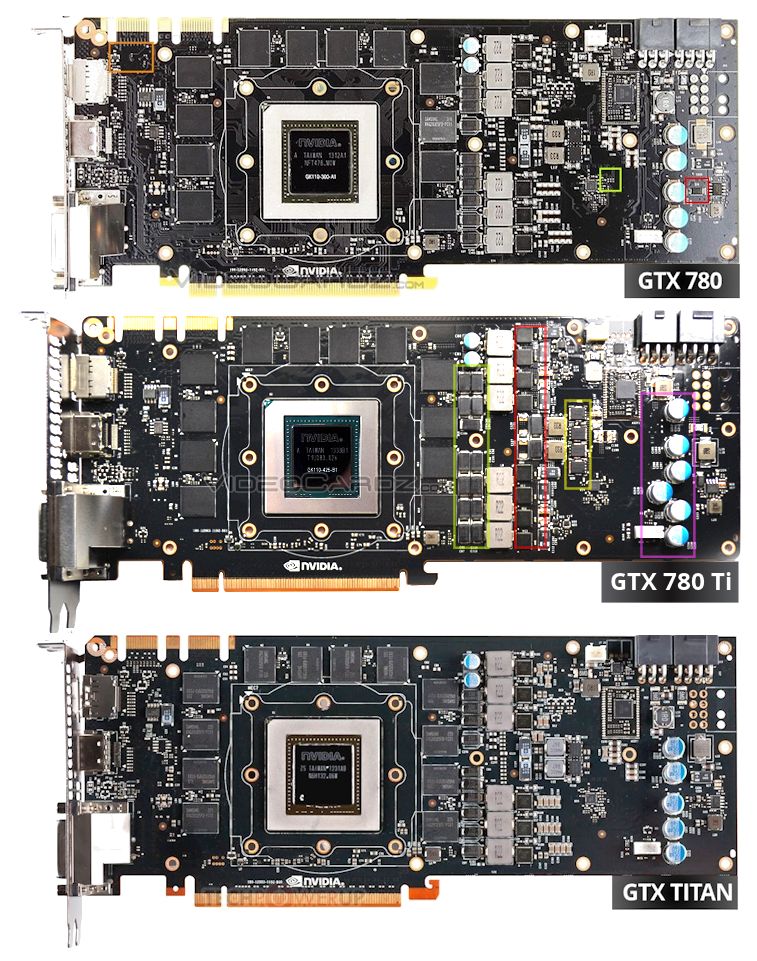

márpedig minden kártyát "ugyan úgy kell felépíteni", fogyasztástól, memóriaszervezéstől és gpu arhitekturától függetlenül

akkor is feleslegesen meg kell szórni a nyákot mindenfélével, ha arra semmi szükség, így a meztelen kártyafotókon is látszik majd: van benne anyag, csúcskategória.

akkor is feleslegesen meg kell szórni a nyákot mindenfélével, ha arra semmi szükség, így a meztelen kártyafotókon is látszik majd: van benne anyag, csúcskategória. -

ALLAT001

senior tag

Ha GTA V normálisan fog futni rajta, akkor megtartom, ha nem akkor

kukacsere.

-

proci985

MODERÁTOR

Akkor ellenvelemeny, mert felhasznalokent nem ertek egyet:

A megjeleneskori tesztekbol en nem talaltam olyat, amibol a crossbar megvagasara egyertelmuen lehetett volna kovetkeztetni. Ha tudsz olyanrol aminek az adataibol egyertelmuen latszik, akkor szivesen latnam, mert nekem nem sikerult anno ilyet talalnom vasarlas elott

hOCPnel irtak hogy kevesbe smooth a 970sli mint a 290x cf/980 sli 4Kra, de ez csak kvalitativ harmadlagos adat volt, kvantitativ adatok (konkret frametime amin latszik a fluktuacio) itt sincs meg. plusz eleve csak valos jatekokban, jatszva jon ki, az automatizalt avg/min plotter ezt nem fogja meg 1secundumos mintavetelezessel.

eleve jatszva is nehez kiszurni, mert az afterburner OSDje megint nem fogja meg. frametimeot kell plottolni, lehetoleg egyeb limitek (fps, target power draw, thermal) nelkul, mert azok miatt is throttlingol a kartya ami confounding variable.

lehet, hogy kihagytam egy adatot, lehet kihagytam egy tesztet, viszont harom ev 5760x1080 tapasztalattal kb tudtam, hogy a memoriabusz buktato, szoval ezeket az adatokat kerestem. Tisztaban vagyok a (#43)ban leirtakkal, viszont a teszteken szerintem nem latszott a 290x elonye.,Az latszott, hogy a 970slivel 4kban az avg meg a min is egesz jo. Persze, csak a szombati teszt utan ket napig fajt a fejem a mikroakadastol, vasarnaptol pedig egy kijelzon hasznaltam a kartyat, mert ugy volt egyedul elfogadhato a teljesitmenye. Mindezt ugy, hogy amin ugy tenyleg megfajdult a fejem, az 50-60fpssel ment.

Ugyanugy fut a kartya mint megjeleneskor? Igen, csak akkor meg azt hittuk a Far Cry 4nek is kell ket honapnyi patch, hogy menjen. arra meg a fene se gondolt, hogy 3.5GB mem felett a kartya nekiallja a rendszermemoriat hasznalni es nem az Ubinak kell ido.

A kozeljovoben levo driver updatere csak annyit mondok, hogy kizartnak tartom, hogy a driveresek automatikus test suiteja nem fogta meg a problemat. Cudanal eleg egyszeruen ra lehetett futni, es tervezett mukodesnek tunt. Szep, hogy a marketing probalja a mernokokre tolni a fiaskot, csak ez nem igy mukodik.

Btw a sajatom eppen a gariztatasi process kozepen van.

reliabilityt, validityt ketsegbe lehet vonni a sajat tesztjeimnel, de kb 12 ora meloval ennyit tudok. meg egyebkent se pl publikacio volt a cel, hanem megvalaszolni azt az egyszeru kerdest, hogy erintett vagyok vagy se, ha igen mennyire, vegeredmenyben pedig visszakuldjem a kartyat vagy se.

Casoli: passz, nem tudom mi lesz helyette. 980t vehettem volna, de SLIben gondolkodtam, a 2x980at meg a celra dragalltam (a kulonbozetbol kb leugrok egy hosszu hetvegere nyaralni valahova repulovel). meg halo product, kijon a 980ti es buko lett volna. plusz 20% tempoert fizessek 60%al tobbet? ugyanmar...

-

Sokan írjátok, visszavinnétek a kártyát, mert szerintetek hibás. Ha vissza is vennék, mit vennétek helyette? Vagy mit vártok a kereskedőtől/gyártótól? Cserélje be egy az egybe 980ra? Ez viccnek is rossz lenne. Akinek meg tellik 980-ra egyáltalán minek vett 970et?

-

seawolf570

aktív tag

válasz

Petike1007

#25

üzenetére

Petike1007

#25

üzenetére

"Ettől függetlenül a nagytöbbség szerintem nem érez semmit az egészből, mivel egy korábbi felmérésből kiderült, hogy az átlag még mindig full hd alatt játszik, de szerintem még full hd-nél sincs szükség egyelőre a 4gb-ra, szóval nem lázadni...

A teszteredmények valósak voltak...amíg nem játsszunk 2-3 monitoros verzióban, aki meg úgy játszik, az vegyen 980-at"Egy szinte még ropogós mérés, pár perce készült.

Assassins Creed Unity

1280x1024 felbontás, tesztalany R9 280X (3G VRAM)

Szemrebbenés nélkül teleírta a 3GB VRAM-ot. Ugyanígy a 4GB VRAM-ot is teleírnja.

Hol van ez a felbontás FullHD-tól esetleg a több monitoros vagy QHD stb felbontástól?

-

igen

pl 40x CAV vagy 24x ZCLV (hasraütöttem)

ha utánanézel, látod h ezek mit jelentenek: változó sebességet a lemez felületénvolt jelölve a 970gtx olyan módon, hogy következtetni lehetett a selejtes ramsebességre?

980gtx 4gb RAM vs. 970gtx 4gb fakeRAM és utóbbit megguglizva rá tudtál jönni, h a fakeRAM jelentése, h a 3.5 gb feletti rész használatakor a kártya összef*ssa magát?

-

Scholes9

nagyúr

válasz

rambustibi

#66

üzenetére

rambustibi

#66

üzenetére

Majd számolj be, ha kérhetlek, sztem nem csak én vagyok kíváncsi

-

sb

veterán

Én is arra vagyok kíváncsi mi a jobb alternatíva szerinted?

Ez az egész költség kérdése.

És mivel ma ott tartunk, hogy egy 3tflops gpu + 6-800gflops igp + 100gflops cpu kombóból kihasználnak jó esetben 1,5-2tflops + 0 + 40-80gflops -ot, utóbbi fele az api-ra megy el, és mindebből kapsz 30fps-t, 10 éve ugyanazt az AI-t és fizikát... ebből talán érezhető, hogy egy kis limitbe ütköztünk és nem nagyon van merre fejlődni.Te is írtad már elégszer, hogy 2xgpu kazánokat (amik semmit nem segítenének ezen) + 2-3x gyorsabb cpu-kat 6-8 éve nem várhatunk. Se tervezésben se gyártástechnológiában.

Szóval hiába irtózatos költség sw oldalon ennyi felé optimalizálni alacsony szinten, most ez tűnik a legolcsóbbnak így is, ha a fenti kihasználtságot mondjuk duplázni szeretnéd 2-3 éven belül.

Tudathasadásos a dolog, mert úgy látszik, hogy 5x annyit kell fejleszteni. De még mindig ez látszik olcsóbbnak.

(Azt halkan hozzátéve, hogy ha a visszafelé optimalizálást hanyagolják akkor még olcsóbb lesz és újra lesz érv lecserélni a 4-5 éves hw-ket. Olyan érvek amik ma nincsenek már egyáltalán. Tehát még jobb is lehet a helyzet mint gondoljuk. Mármint a fejlesztőknek nem nekünk akik 2 éves hw-n nem tudnak majd elindítani valamit. De ha a fejlesztőknek jó akkor kétség ne legyen, megcsinálják.

-

sb

veterán

Hát ott a grafikonon a 26 vs 8fps azé' nem ezt mutatja, vagy rosszul látom?

Elk*rta az NV. Már ezerszer le volt írva:

- Ha összecsuklik 3.5GB felett az bizony hiba, mert rohadtul nem erre számított a kedves 4GB-ot vásárló user. És belassul, ez tény. Tehát így ebben a formában nagyon nem igaz amit itt minden második hsz-ben benyög valaki, hogy belassulós szar-e a kártya. Az.

- Ha meg lekorlátozzák a memhasználatot 3.5GB-ra akkor minden OK. Csak a dobozra is azt kellett volna ráírni.

Nem egy bonyolult sztori. -

rambustibi

őstag

Azt várom a lépéstől, hogy visszakapjam a vételárat vagy beszámolják egy erősebb VGA árába.

Szerintem megéri, mert minél több idő eltelik, annál nagyobbat fog zuhanni az ára és most itt nem az amortizációra gondolok, hanem kevesebbet adnak érte a kirobbant hamis specifikáció miatt. Jönnek a nagyobb RAM igényű játékok, alkalmazások, és ennek tudatában egy 4GB-os VGA csak 3,5GB-ig működik 100%-osan, e felett pedig -44%? teljesítménycsökkenés....

Szóval ez is egy nagy probléma, és az, hogy majd 1 hét eltelt, de még itthon MO-n semmi nem történt.

Egyébként 20 perccel ezelőtt írtam a fogyasztóvédelemnek egy e-mailt, és tanácsukat kértem....

-

jacint78

addikt

Csak azért, mert nem kell akkora áram neki és kisseb nyákon is elfér az áramkör? A kategória pedig a telejesítmény alapján dől el nem a 256bit és a nyák mérete alapján és a teljsítménye ott van az AMD kazánjai mellett, szóval hanyagold szerintem ezt az értelmetlen trollkodást.

-

Zorel

senior tag

válasz

Outsiderman

#55

üzenetére

Outsiderman

#55

üzenetére

Felesleges ezen vitatkozni, mert egyértelmű, hogy TTomax-nak igaza van. NV is azzal hirdette a 970/980-at, hogy a 670/680 utódjai, illetve a saját tesztjeibe is ezekkel hasonlította össze. Ezek a kártyák sosem készültek felső kategóriának, látszik a specifikáción, csak mivel az AMD nem jött ki semmivel így jelenleg ellehet őket adni annak. Kb ugyanaz fog történni mint a kepler esetében. (680vs780)

-

TTomax

félisten

válasz

Outsiderman

#55

üzenetére

Outsiderman

#55

üzenetére

Nem!Az egy G1 egyedi nyákkal,az még csak véletlen sem az...de mindegy is ugyanolyan nevetséges... 4réteg PCB minusz,256bit,VRM a front oldalon... középkategória,az hogy ,ki mit vesz az lényegtelen,ha csúcs lenne a 980 akkor 30-50%-ot vert volna a 780Ti-re,nem pedig ötöt,de nem is azért jött, a 680/770et váltotta... majd a fullos maxwell az lesz a csúcs...

Az baj,hogy le vagytok ragadva az árakkal én meg technikai dolgokról beszélek...

Amughy ha már hoztál egy G1 PCB-t akkor had mutassam meg a 780Ti Kingpinét,meg a 290X Lighningét... mer az csucs...

-

Outsiderman

tag

Ez egy kis méretű változat, nem a normál 970.

Egyébként a véleményem az, hogy a 970 már egy komoly kártya Magyar viszonylatban. A 980 már felső kategóriás a 780Ti is. A csúcs a Titan. AMD oldalon 290X x2.

Az Aqua.hu-n a Palit GTX 970 97.390Ft a 980 160.000Ft a 780ti 130.000. Akkor inkább ez mint a 980.

Átlag ember nálunk 750(ti)/760-nál és AMD 260(x), 270(x) nagyobb kártyát nem igen vesz. Egy kis réteg engedheti meg, vagy akar magának nagyobb kártyát. -

válasz

rambustibi

#45

üzenetére

rambustibi

#45

üzenetére

Es mit varsz eme lepestol? A max a kartyad visszavetele lesz. Megeri? Most jo aron el tudod adni...

-

TTomax

félisten

Mielőtt falnak mennél.. a 980 nem egy csúcskategóriás kártya... a 970 meg föleg nem... úgy ahogy az elődje a 670/680 se volt az...ezt a teljesítményt szinte megkaptad egy 780Tivel is... ez bizony a középkategória frissítése,csak ez még sok embernek nem jutott el tudatig... majd a fullos maxwell ezer dolcsiért...

-

jedis

senior tag

Csak azt nem értem, hogy miért is kéne nekem kompromisszumokat kötni egy csúcskategóriás kártyánál ??????

Mert úgy látom, sokan "felsőközépkategóriás" kártyának tartják, mert hogy fullHD-ra elég, meg , bőven jó ! És mi van ha valakinek 2560x1080 -as, vagy 2560x1440-es, vagy netán 3840x2160-as monitora van ????

Mert úgy látom, sokan "felsőközépkategóriás" kártyának tartják, mert hogy fullHD-ra elég, meg , bőven jó ! És mi van ha valakinek 2560x1080 -as, vagy 2560x1440-es, vagy netán 3840x2160-as monitora van ????  Ez egy Gamer kártya, kimondottan Gamer-eknek ( gondolom ), és a Gamer-ek között nem ritka, a fentebb felsorolt három képfelbontású monitortípus, nagyjából kb. 20-szorosa ( csak saccoltam ), az átlagfelhasználók által használt monitorokéhoz viszonyítva ! FullHD ? Ember ! Annál kisebb felbontást, már nem is nagyon lehet kapni ! 28EFt-tól vannak 21"-os TN-es FullHD-s monitorok ! Ki az a hülye, aki újonnan, ennél kisebbet vesz ? Ha összeszedem az összes Gamer kártyát, ami a mai legmodernebb játékokat is el tudja minimum indítani low-on, akkor van mondjuk 50 típus, a HD5770-től a 290X-ig, meg a GTX460-tól, a GTX980-ig ( most a dupla GPU-s szörnyeket ne vegyük ide )! Ha a legrosszabb eshetőséget is veszem, a GTX970-es az 50-ből a minimum a 3-adik ! Szóval dobogós ! Ne keljen már kompromisszumokat kötnöm !

Ez egy Gamer kártya, kimondottan Gamer-eknek ( gondolom ), és a Gamer-ek között nem ritka, a fentebb felsorolt három képfelbontású monitortípus, nagyjából kb. 20-szorosa ( csak saccoltam ), az átlagfelhasználók által használt monitorokéhoz viszonyítva ! FullHD ? Ember ! Annál kisebb felbontást, már nem is nagyon lehet kapni ! 28EFt-tól vannak 21"-os TN-es FullHD-s monitorok ! Ki az a hülye, aki újonnan, ennél kisebbet vesz ? Ha összeszedem az összes Gamer kártyát, ami a mai legmodernebb játékokat is el tudja minimum indítani low-on, akkor van mondjuk 50 típus, a HD5770-től a 290X-ig, meg a GTX460-tól, a GTX980-ig ( most a dupla GPU-s szörnyeket ne vegyük ide )! Ha a legrosszabb eshetőséget is veszem, a GTX970-es az 50-ből a minimum a 3-adik ! Szóval dobogós ! Ne keljen már kompromisszumokat kötnöm !

-

rambustibi

őstag

Én is írtam a kereskedőnek és jelenleg még nem történt semmi, várni kell. Az Nvidia, amikor kiadta az új(valós) specifikációt kb 1 hete, akkor jogilag megtörtént a vásárló megtévesztése. Ezért elgondolkodom a dolgon, hogy nem várok se a kereskedés, sem pedig az NV válaszára, egyszerűen elindítom a jogi lépést, amivel élhetek (ha nem sikerül megegyezni a kereskedővel).

Természetesen jogilag csak azok élhetnek a vásárló megtévesztése dologgal, akik az új kiadott specifikáció előtt vásárolták a kártyát.

-

Bakitm

tag

Csak én nem értem, miért van ekkora felháborodás? Ez lenne az első, hogy egy gyártó "átveri" a vásárlókat. Ha valaki azt várta, hogy lehozza az égről a csillagokat a 970, akkor már alapvetően magában keresse a hibát, ne a kártyában.

Ugyan nem úgy teljesít, mint az elvárt, viszont nem lehet felróni neki, hogy szar, ipari hulladék stb. Főleg ha figyelembe vesszük, hogy a teljesítményt ami a kártyában van, azt mekkora fogyasztás mellett állítja elő, akkor még most is egész jó a helyzet. Jó persze ha valaki 4k-n meg ultra very high és 16x-os elsimítás mellett is csilió fps-t akar annak nem ez megfelelő, de az a réteg nem olyan nagy, hogy érdemes legyen kártyát tervezni rájuk.

A kezdeti betegségeken szépen lassan úgyis javítanak valamennyit a driverekkel, így nincs mitől félnünk. Én nem bántam meg. -

Abu85

HÁZIGAZDA

válasz

#32839680

#42

üzenetére

#32839680

#42

üzenetére

Nem a memória miatt bírja jobban a 290X a 4K-t a 980-nál. Maga az alaparchitektúra az AMD-nél magas felbontásra van tervezve, mert belül igen széles univerzális buszra van kötve az összes részegység, míg a 980-nál az NV inkább ultramobil GPU-knál alkalmazott dizájnra épít a belső adatbuszok szempontjából, ami könnyebben túlterhelhető. Emellett a memória-sávszélességben is lényeges előnye van a 290X-nek.

Nem véletlen, hogy a 4K-t főleg az AMD kampányolja, mert a technikájuknak ez dizájnból fekszik, és memóriatechnológiákban is előrébb járnak, vagyis a jövőben is nagyobb memória-sávszélességet tudnak majd felmutatni. -

barnibal

tag

Látom itt mindenki csak azt látja mi van most. Szerintem minden hw gyártó cégnek volt már ilyen húzása! De ilyen kártyát senki nem 1évre vesz meg és ha 2 év múlva esetleg lesznek olyan gamek amiknél a 4gb vram alap lesz akkor már eléggé tré lesz az arckifejezése minden 970 tulajnak!

-

Thrawn

félisten

Összegezve a hírben olvasottakat:

- elhazudták a specifikációt, utólag (nem önszántukból) helyesbítettek (/fuuuuuuuu)

- nem írtak külön drivert a 970-hez, pedig kellett volna, ennek ellenére továbbra sem tervezik, hogy írnak hozzá másikat ami a helyén kezeli a kártyát (/facepalm)Továbbra is az a véleményem, hogy ha megjelenéskor tiszta lappal indítják el a kártyát most nem lenne ez a vihar a biliben. Nade ugye nem így történt, szóval egyék csak meg amit főztek.

Másrészt felmerült bennem a kérdés, hogy mi a helyzet itthon? Próbált már valaki visszavinni 970-et "nem ilyen lovat akartam" címszóval? Ha igen, mi történt? Visszakapta a pénzt? Vagy visszadobták, hogy a kártyának kutya baja? Mi a véleménye a boltoknak, nagykereknek, disztribútoroknak? Visszaveszik, nem veszik vissza? Ez megérne egy cikket, érdekelne a dolog erősen.

-

Olajka02

aktív tag

Csak annyit tennék hozzá, személyes tapasztalatként, hogy 1080p-ben BF4 alatt bizonyos pályáknál a 290-esem 3,280 GB-ot használ a memóriából.

Lehetséges hogy WQHD-ban ez egy picit még több lenne, de ha nem is, más újabb fejlesztésű játékoknál - pl.

Star Wars Battlefront 2015 - szerintem biztosan előfordul majd, hogy 3,5 GB-nál több memóriát fog használni a játék.

Az már eléggé a közeljövő.

Persze ezek csak feltevések (talán valamennyire nem is, mint ahogyan egyes játékoknál már most jelentkezik ez a probléma), de pártatlanul el kell döntenie a felhasználóknak, hogy nekik kell-e így ez a termék, vagy sem. -

Zorel

senior tag

A tesztek nagy része gyorsan születik általában 1080p és 1440p-s felbontáson és nem feltétlenül vannak benne olyan játékok melyeknek nagy lenne a memória igénye.

A másik dolog pedig, hogy amit akkor láttunk az az volt hogy 4GB VRAM van a kártyán, amit teljes sávszélbe tud használni. A hírek hallatán, hogy egyre inkább nagyobb VRAM igénye lesz a játékoknak ez megnyugtató volt, hogy a közeljövőben érkező címeknél nem lesz vele VRAM probléma. Szóval oké, hogy ugyanolyan gyors mint megjelenéskor, de nem biztos, hogy olyan időálló kártya lesz, mint ahogy akkor gondoltuk, pont a VRAM esete miatt. -

LackoMester

addikt

Csak annyit fűznék hozzá, miért kellett 3 hónap ahhoz, h. rájöjjenek a nagy szakik, h. itt valami bibi van a kártya körül?

Nálam, marad a kártya. FullHd- ra tökéletes.

-

Stunts666

őstag

válasz

bandika0626

#26

üzenetére

bandika0626

#26

üzenetére

Ha veszek egy 1.4-es Audit, akkor elvárom, hogy 1.4-esként menjen ne 1.2-esként.

Ha elmegyek valahova dolgozni és igérnek 200k-t, akkor elvárom, hogy annyit kapjak, ne 150k-t. Ha valaki megigér valamit, akkor elvárom, hogy meg is adja.

Szerintem ez teljesen korrekt...

-

Zorel

senior tag

Köszi Abu a cikket!

Jól sejtettem hogy erről fogsz írni amikor megjegyezted, hogy ez nem feltétlenül a hardver hibája. Ami igaz is, viszont mivel az NV jelenlegi álláspontja az, hogy ezt driver szinten nem tudja vagy nem akarja javítani, így szerintem a felhasználók szempontjából semmit sem változtat az, hogy ez most hardveres vagy szoftveres gond.Azt is tegyük hozzá, hogy a felhasználók többsége FHD vagy alatti felbontáson játszik és ilyen felbontáson a jelenlegi játékok max 0,5% érinti a probléma. Nyilván ez az egész memória ügy leginkább azoknak fáj, akik mondjuk FHD feletti felbontásra vették a kártyát, főleg ha SLI-be.

-

batt

aktív tag

Nem értem ,azokat akik azt mondják ,hogy nem volt korrekt az nvidia de ez a kártya remek mivoltán nem változtat! Ez részben így is van,a kártya teljesítménye remek de ez a tényen nem változtat!

Véletlen vagy direkt de hibás specifikációkkal árulták a kártyát,tesztoldalaknak [link] ez lett kiküldve ezek alapján csinálták a teszteket ,a hivatalos oldalon is ez szerepelt,sőt a tesztprogramok sokasága is a false adatokat írja ki és olvassa ki a nv driverből is! Nevetséges! Ja a mai napiig! Az Nv-nek és a gyártómnak is írtam és leráznak hülyének néznek és linkelgetik a copy past szövegeket! Ahelyett,hogy elismernék a hibát és felvállalnák!

Ez nem változtat nálam semmin akkor is NV párti maradok de ez gusztustalan,hogy egymásra mutogatnak és hárítanak! A memória dolog csak hab a tortán! -

huskydog17

addikt

Ez történik, ha a GTX970-en elfogy a 3,5 GB VRAM.

A többi összehasonlító videó itt található.

-

jozsef8

aktív tag

Én is lefuttattam a RAM tesztet. Nekem a 29-es blokknál lefagy az egész, kifagy az nvidia driver és újraindul. Az én utolsó pár száz MB-om teljesen hibás. Ilyenkor mit csináljak?

-

SirCsimbók

tag

"A hardver működését nagyban befolyásolja a grafikus meghajtó, így nem érdemes elhamarkodott következtetést levonni a kényes eredményekből."

ez egy nagyon helyes megfogalmazás.

mindenkinek adott a lehetőség, hogy saját szemével győződjön meg róla, hogy a kártyán 4 GB RAM van

ennyit ígért az nV. és az rajta is van

ezt még az AMD is megerősítheti a szlogenjével: "A 4 GB az 4 GB"

-

bandika0626

senior tag

válasz

Televan74

#23

üzenetére

Televan74

#23

üzenetére

Nevetséges ez a siránkozás. Nyilvánvaló dolog, ha valaminek a karcsúsított változatát veszi meg az ember akkor benne van a pakliban, hogy egyszer valahol előjön a karcsúsítás miatti teljesítmény csökkenés.

Ez olyan dolog, hogy veszel pl: egy Audi-t amibe csak 1.4-es motor van és azt várod tőle, hogy úgy menjen mint amibe 3.0-ás TDI. Pedig mind a kettő Audi. -

Petike1007

tag

Az AMD-s cikkek után mindig szét van fikázva az AMD (és a prohardver) az NVIDIA-s oldalról, hogy miért kell isteníteni...

Most viszont senki nem beszél arról,h az NVIDIA átbaszott mindenkit...pedig igen...

Ettől függetlenül a nagytöbbség szerintem nem érez semmit az egészből, mivel egy korábbi felmérésből kiderült, hogy az átlag még mindig full hd alatt játszik, de szerintem még full hd-nél sincs szükség egyelőre a 4gb-ra, szóval nem lázadni...

A teszteredmények valósak voltak...amíg nem játsszunk 2-3 monitoros verzióban, aki meg úgy játszik, az vegyen 980-at

-

kekegsm

őstag

Én teljesen megértem a haragos embereket. Nekem is 647373x447374 felbontású a monitorom, és laggol a 3Dfx Voodoo kártyám. Szerintem visszaviszem...

-

Tudod mennyit esznek meg? Amennyi rendelkezésre áll. Ha 8 GB vramod van, azt is televágják, legfeljebb kevesebbszer kell a tartalmat cserélni.

Az, hogy azt mondja a készítő, hogy ehhez x mennyiségű vram kell, csak annyit jelent, hogy azzal valószínűleg már semmilyen helyzetben sem lesz problémád, de rá van még rakva egy mérnöki faktor is.

Kb. mint az ajánlott gépigények. Rá van írva valami durva, aztán rájössz, hogy egy jóval gyengébb gép is simán viszi, csak sokat írtak rá, hogy utána ne lehessen őket szidni/perelni, hogy keveset mondtak.

Ezért van az, hogy a legújabb játékokkal is elvannak sokan a 2 GB vrammal is. -

Duck663

őstag

Ezt a VGA-t 3.5GB memória mennyiséggel kellett volna kiadni és ennyi. Nem machinálni össze-vissza. Ez ennyire egyszerű. Most pedig azt kellene tenni, hogy 3.5GB-ra korlátozni, és a felhasználóktól mély bocsánatkérések közepette, felajánlani a visszavásárlást, vagy cserét. Ez lenne a korrekt. És egy új 970-et vagy 975-öt tervezni eleve 3.5GB memóriával. Főképp, hogy egészen biztos a GPU további butítását tervezték. 960Ti?-t talán. Azt sem szeretnék gondolom, hogy a nyakukon maradjon. Ott pedig 3GB memória 192 biten és ennyi. Akkor mindenki tudni fogja mit vett. Persze a sebességnek nem tenne jót, mert a 256bit is erősen limitálja, de ezt ők cseszték el már a tervezésnél.

-

Én is ludasnak tartom az nV-t ebben az ügyben, mert akkor legalább elsőre is kiadhatták volna normálisan a specifikációt, valszeg senkit nem érdekelt volna. De azért ez a ComputerBase teszt is khm... erősen marginális.

Az egyik QHD felbontás felett a másik meg egyenesen 4K és mindkettő 4x MSAA-val. Azt hiszem nagy biztonsággal kijelenthető, hogy a kártyának nem ez a rendeltetésszerű használata.

Vagy van olyan, aki vesz egy 4K monitort amivel úgy szeretne játszani, hogy még megküldi egy jó kis élsimítással is, és vesz hozzá 1 db GTX 970-et? Genius

-

Abu85

HÁZIGAZDA

válasz

#32839680

#16

üzenetére

#32839680

#16

üzenetére

Ezzel a szintetikus méréssel semmi baj. Ez mutatja azt, hogy miképp működik maga a kártya. Azt kell megérteni, hogy gyakorlati szinten az egyes akadásokat nagy valószínűséggel nem ez okozza. Vagy legalábbis a hardver működése CB teszthez hasonló jelenséget nem kellene, hogy okozzon.

-

antikomcsi

veterán

De a legborzasztóbb az, hogy mégsem tudtam használtan venni ebből az ipari hulladékból, senki nem adta el ezt a mérhetetlenül hibás selejtet olyan áron ami ilyen silány termékhez passzolna. Ezért kellett boltban megvennem ma is egy darabot.

Az a szerencse, hogy nem nekem lesz, aki meg használni fogja annak nem árulom el, mert amúgy biztos nem is kéne neki.

-

Scholes9

nagyúr

-

Jack@l

veterán

A korlátozást vagy mappinget egy sima fw upgrade-el is meg lehet oldani, sztem. Onnantól kezdve meg nincs gond 3.5 gigáig.

Még senki se tudja hogyan is fognak viselkedni a kártyák dx12-es játákokban, szóval annyira azért nem aggódnék még... (win 10 és dx12 debütálás szeptemberben, az első játékok kb karácsony körül lesznek rá) -

Stunts666

őstag

Vajon ha ki lehetne használni a kártyát 4 Gb-al, teljes sebességen, amit nem tud (az nVidia eltitkolta, hogy elcseszte és közben átverte a vevőket), akkor boldogabbak lennének az emberek??? Én sem lennék boldog, ha kiderülne, hogy a 7950 "csak" 2,5 Gb-ot bir és malmozik az utolsó 0,5 Gb...

-

LordX

veterán

"Ugyanez vonatkozhat az alacsony szintű hardverelérésre is. Az új API-kban ugyan a grafikus meghajtónak nincs túl sok szerepe, de figyelmeztethetők a programozók, hogy a GeForce GTX 970 és a 980 még az azonos lapka ellenére is eltérő memóriamenedzsmentet igényel, így a GeForce GTX 970-re különállóan írható akármilyen specifikus optimalizálás az adott alkalmazáson belül."

Na, ez miatt a teljes cucc bukó. El lehet felejteni, hogy egy kártya miatt elérő memóriamenedzsmentet fognak írni a játékfejlesztők. Meg fogja kapni a standard Maxwelles kódutat (és már azzal is szerencsésnek tekinthetjük magunkat, hogy van külön Maxwelles, és nem csak egy általános 'nVidia' verzió), profi támogatás esetében max be lesz limitálva a kártya 3,5 GB-re, és csókolom. Standard esetben viszont simán rá fog futni a +0,5 gigára minden, és máris meghalt a kártya.

Ma még jó cucc a 970, de nem terveznék vele hosszú távra..

-

Dyno

veterán

Nekem csak egy kérdésem van, amíg erre a problémára nem derült fény mindenki aki magának tudhat egy ilyen kártyát, boldogan használta?

-

arn

félisten

siman le kell korlatozni 3.5gra, es alacsony szinten elerhetove tenni a maradekot, akinek olyanja van. igy nem forulhat elo, hogy ugy es olyanok irogatnak arra a teruletre, akiknek elkerulte a figyelmet ez a sajatossag. 3.5 gigas kartyakent baromi keves lesz a helyzet, ahova a 980 franko meg, a 970 meg keves.

siman orvosoljak a kov drvnel.

-

Habugi

addikt

Most akkor mégiscsak járható út a driveres buher?

Már nem tudom követni..

, először arról volt szó hogy nem, utána az NV közölte hogy igen, két napra rá lenyilatkozták hogy mégsem és nem is foglalkoznak vele, most pedig mégis járható út de az NV nem foglalkozik vele (hivatalosan..)?

, először arról volt szó hogy nem, utána az NV közölte hogy igen, két napra rá lenyilatkozták hogy mégsem és nem is foglalkoznak vele, most pedig mégis járható út de az NV nem foglalkozik vele (hivatalosan..)?Lehet a felfogóképességemmel van probléma vagy túlságosan leegyszerűsítem magamnak mert számomra egy ponton túl érdektelen, de egyik cikkben "ez" van a következőben meg "az"..

Esetleg senki (gyártók/teszterek/végfelhasználók) nem érti igazán a helyzetet és ezért a látszólagos fejetlenség?

Szerk.:

Sry Drizzt, nem neked szerettem volna címezni..

-

SylverR

senior tag

Hehe...

Bukta. Két lehetőség van. Egy, elfogadjuk az első eshetőséget, miszerint a hardware rossz, vagy szándékosan lett rossz, és reménykedtek, hogy eltelik 2 év mire kiderül. Vagy a mostani infókat tartjuk reálisnak. De ez esetben pedig a sokat istenített nvidia-féle driverek perfekcionizmusának álomképét zúzzuk össze. Szép öngól, kedves nVidia.

-

Abu85

HÁZIGAZDA

A Dragon Age Inquisition tesztelése nem szerencsés ebből a szempontból, mert magának a DirectX 11-es leképzőjének vannak problémái. Azt a program oldaláról lehet javítani. Ha akadásokat érzel ennél a játéknál, akkor az nem feltétlenül driveres vagy hardveres gond. Sajnos nem tudnak mit tenni vele a gyártók DirectX 11 alatt. Ezt el kell fogadni, hogy ilyen.

-

Drizzt

nagyúr

Elmehetnek a verbe, tovabbra is ez a velemenyem. Mindenestre ha valaki kijarta mar, hogy itthon Ipon/Asus eseten vissza lehet-e vinni, az szoljon. Dragon Age Inquisitionben nem tapasztaltak ilyesmit? Mert szerintem ott is van.

Új hozzászólás Aktív témák

- Apple Watch SE 2 44mm Wifi

- GYÖNYÖRŰ iPhone 11 Pro Max 64GB Graphite - 1 ÉV GARANCIA - Kártyafüggetlen, MS3260, 100% Akkumulátor

- BESZÁMÍTÁS! MSI B450M R5 3600 16GB DDR4 512GB SSD GTX 1080 8GB Rampage SHIVA ADATA 600W

- Okosóra felvásárlás!! Samsung Galaxy Watch 5 Pro, Samsung Galaxy Watch 6 Classic

- Apple iPhone 13 Pro 128GB,Adatkabel,12 hónap garanciával

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Laptopműhely Bt.

Város: Budapest

Szerintem annó nem is volt akkora gépház amibe ez kivágás nélkül befért volna.

Szerintem annó nem is volt akkora gépház amibe ez kivágás nélkül befért volna.

Lehet ezért nincs normális verseny köztük?

Lehet ezért nincs normális verseny köztük?

Ezt csak azért írtam, mivel egy GTX980-as kint sem középkategória attól függetlenül, hogy simán megengedhetné magának, akár melyik Gamer a 3-4000 Euro-s fizetéséből ! Ettől függetlenül életem legdrágább ( keresetemhez arányosan nézve ) videókártyája, a híres Diamond Monster woodoo 1 volt anno 97'-ben !

Ezt csak azért írtam, mivel egy GTX980-as kint sem középkategória attól függetlenül, hogy simán megengedhetné magának, akár melyik Gamer a 3-4000 Euro-s fizetéséből ! Ettől függetlenül életem legdrágább ( keresetemhez arányosan nézve ) videókártyája, a híres Diamond Monster woodoo 1 volt anno 97'-ben !

Soha tobbet nem rendeltem toluk, pedig finom volt.

Soha tobbet nem rendeltem toluk, pedig finom volt.

Azért írtam, rögtön az elején, hogy Magyar viszonylatban. Nemzetközileg a helyzet teljesen más, de mi itt vagyunk otthon.

Azért írtam, rögtön az elején, hogy Magyar viszonylatban. Nemzetközileg a helyzet teljesen más, de mi itt vagyunk otthon.