-

Fototrend

"A Proxmox Virtual Environment (röviden: Proxmox VE, PVE vagy proxmox) egy szerver virtualizációra optimalizált nyilt forráskódú Debian alapú Linux disztribúció. Lehetővé teszi a virtuális gépek és konténerek egyszerű telepítését és kezelését web konzol és command line felülettel. A programcsomag két LXC és OpenVZ konténerek, valamint a KVM alapú virtualizáció kezelését támogatja" (Wikipédia)

Hivatalos oldal: https://proxmox.com/en/

Hivatalos fórum: https://forum.proxmox.com/

Backup center, mail gateway, proxmox hypervisor és datacenter letöltés: https://enterprise.proxmox.com/iso/Véreshurka hozzászólásából

Új hozzászólás Aktív témák

-

Szvsz az ilyen, én ezért nem használok *cloud meg hasonlókat sem, a webfelületes php+adatbázisos motyó nem lájkolja, ha a háttérben smb-n variálok.

Ezt találtam guglizva kicsit:

"When Syncthing is accessing a folder over SMB it needs to rely on periodic scans instead of change notifications. Changes still get picked up, but with slightly higher latency." -

OMV-t anno próbáltam, megölte magát, elengedtem. Unraid jó, de fizetős, akkora dolgokat nem terveztem itthon, h erre egy headless ubuntu áránál többet herdáljak. TrueNas-ról lebeszéltek, pont azért, mert nem használnám ki, freebsd (használtam, próbálgattam anno, de nem a barátom).

Igen, ez az oldal kell... ehh, azt gondoltam, h több port van és itt van elírva bármi, de nem.

Ha csak megosztás kell a VM/LXC-nek, akkor arra tényleg overkill a TrueNas, azt egy headless ubuntu/debian + Webmin/Cockpit és beállítod, kész. Szerintem. -

AcCEsS

senior tag

Gyakorlatilag teljesen átköltöztem raspberry/docker alól proxmox/vm/docker alá. Eddig egy probléma merült fel: a VM-en belül mountoltam egy NFS megosztást, ami működik jól, de valamiért a Docker alól futtatott Syncthing nem veszi észre az NFS-en történt változásokat, csak ha manuálisan indítok egy "Átnézést" (vagy ha az időzített teljes átvizsgálás fut le). Mintha a Syncthing nem kapná meg a kerneltől a fájlrendszer változásáról az értesítést. Van valami ötletetek a megoldásra?

-

PHenis

senior tag

Mikor keresgéltem, hogy mi hogy legyen majd a házi szerveren akkor fő oprendszernek is a tárban volt. Volt még az OMV de az nem tetszett valamiért, meg az unraid aminek mindeféle fizetős verziói vannak. Így összességében a truenas volt a legszimpatikusabb. Meg több helyen írták, hogy kezdőknek nem annyira jó én meg az vagyok és szeretem kínozni magam

lehet overkill, amúgy ajánlásokat meghallgatok szívesen.

lehet overkill, amúgy ajánlásokat meghallgatok szívesen.Igen, csak share-ek vannak egyelőre. NFS, SMB és FTP. Később majd szeretnék több lemezt is, valamilyen NVR lxc is oda ment majd szerintem...

Felraktam frissen egy külön vm-be a core-t és a friss telepítés is ugyanazt a tünetet produkálta, ezért döntöttem az upgrade mellett.

Erre az oldalra gondoltál?

-

-

PHenis

senior tag

-

PHenis

senior tag

Sziasztok,

egy ideje szenvedek az NFS share-ek mountolásával és tegnap rájöttem, hogy mért nem konzisztens a probléma megoldása, egyszer miért működik egy módszer és egyszer miért nem... Az tűnt fel, hogy unreachable üzenetek voltak mountoláskor, egyszer ment, egyszer nem. Egyik lxc-ből ment, aztán nem. Felraktam mégegyszer ugyanazt egy új lxc-be akkor ment. Újraindítottam nem ment wtf

Szóval ping -f (ez darálja a pinget rendesen) parancsot használva a truenas vm-en van egy kb 30% packet loss. Bárhonnan csinálom a truenas VM-re ez van, truenas-ból csinálva mindenfele működik kivéve saját magával nem, tehát ha truenasból pingelem a saját ip-t akkor is 30% packetloss van.

Konfig:

sff gép, i5 6500, 48GB ram, truenas és homeassistant VM-ek, pár kisebb lxc (omada, adguard, plex, qbittorrent). Truenas-nak disk pass egy 1TB HDD ZFS-ként.Truenas: VirtIO-t használok (alapbeállítás volt) de végigpróbáltam az összessel, odaadtam már mind 4 cpu magot (alapból 2 volt neki) bár a proci kihasználtság alacsony proxmoxból és truenas felületen nézve is (20% alatt még ping -f terheléskor is), a ram használat (8GB-ról indultam, most 16GB-ra növeltem már) mindig fullon van de gondolom ez a ZFS miatt van.

Google keresések alapján (proxmox high packet loss VM, truenas vm proxmox...) az első 2-3 oldalt kb végigpróbálgattam amiket írtak, mindenféle buffereket meg cache-ket növeltem (igazából már magam sem tudom sajnos) de akármit csinálok stabil a 30% csomagvesztés. Nehezíti a helyzetet számomra, hogy még linuxban sem vagyok nagy szamuráj de a truenas core freebsd alapú és a parancsok is máshogy néznek ki...

MAC ütközést nem találtam nmap és omada client export alapján sem. A fontosabb dolgok fix ip-n vannak. A legtöbb dolgot a proxmox helper script gyűjteménnyel telepítettem.

Van valakinek ötlete, hogy mit nézek be?

Nemtom milyen infó fontos még ide, kérdezzetek

-

-

Balinov

titán

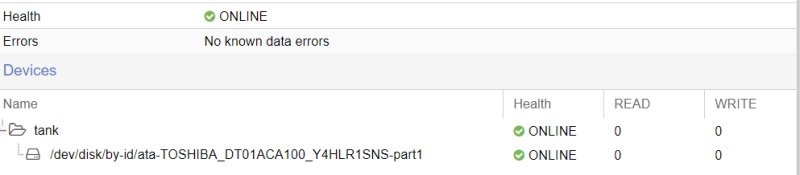

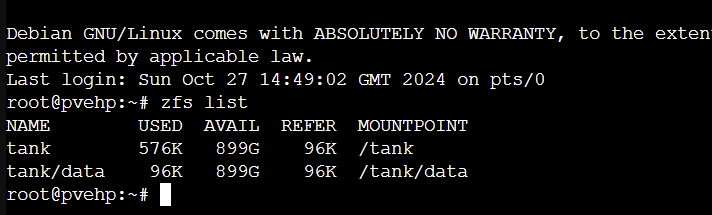

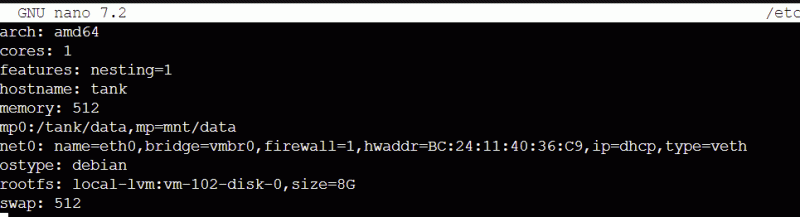

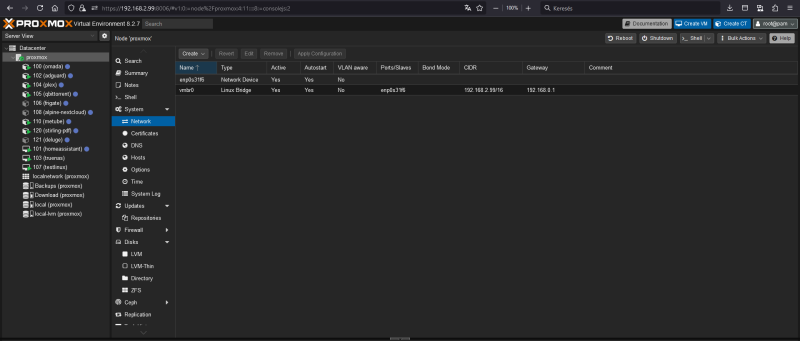

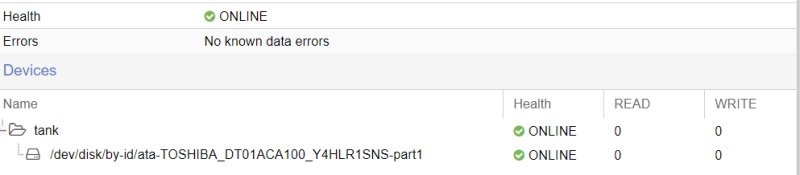

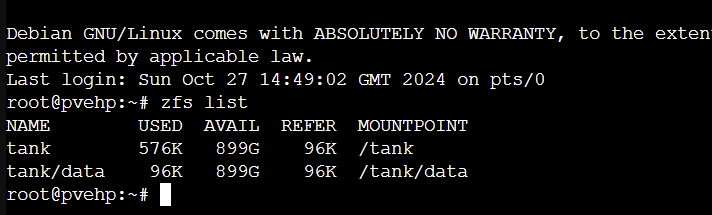

Sracok, segitseg kellene. Ez alapjan a tutorial alapjan szeretnek egy TK Linux file servert letrehozni.

A PVE egy SSD-rol megy, tarolo egy 1TB hdd

Letrehozom az LXC containert

PVE-n letrehozom a ZFS Poolt

Majd a Poolon belul a dataset-et (data konyvtar)

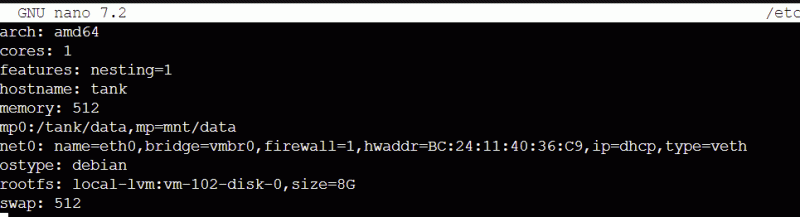

node-on (CT, ID#102) nano /etc/pve/lxc/102.conf-ben hozzaadom a

mp0:/tank/data,mp=/mnt/data

elmentem, kilepek vissza a PVE shell-bemajd

pct start 102-vel inditanam a kontenert, a kontener elindul, de pve errort dob, ilyesmit hogy "()Task viewer: CT 100 - DestroyOutputStatusStopDownloadTASK ERROR: unable to parse directory volume name 'subvol-100-disk-0'"belepek a webinen keresztul rendben, szoval a TK fileszerver fut, de nem latom a mountot az istennek seMar ujracsinaltam vagy 5x, kontener gyalu, kontener ujraletrehoz, ZFS pool gyalu, letrehoz, nem latja a mountotBiztos vagyok benne, hogy valami trivialisat ba*zok el, de nem jovok ra, mi azVAlakinek 5lete?KosziBali -

Magnat

veterán

válasz

tasiadam

#2877

üzenetére

tasiadam

#2877

üzenetére

16GB, nem fut rajta semmi erőforrásigényes dolog, egyébként annyira nem rossz ez a vas erre az otthoni szerver/nas felhasználásra, ahogy néztem, egy 7. generációs I7 és 8-9. generációs I5 szintjét hozza kb. Ráadásul 6 watt a tdp-je, szóval 12 volt 2A-s táppal nagyon vígan elmegy egy ilyen konfig tokkal-vonóval.

-

kutga

félisten

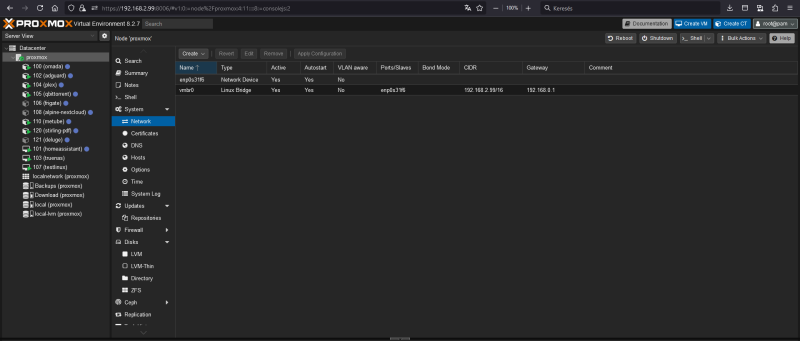

Amikor telepítetted a Proxmoxot, akkor melyik csatolót használtad, vmbr0 vagy vmbr1? Úgy tudom, amit a telepítésnél megadtál, az lesz onnantól a menedzsment interfész, tehát azon keresztül tudsz kommunikálni a hosttal. Vagyis, ha ez a telepítésnél a vmbr0 volt, és az új, 2,5GB-os csatolót szeretnéd a menedzsment interfészként használni, akkor annak kellene lennie vmbr0-nak.

-

Magnat

veterán

Üdv,

van egy n100-as minigépem, pár hete legyalultam a HyperV-t és felkerült egy Proxmox. Most tettem bele egy 2.5Gb-s csatolót (felül az eddig használt gigás, alul az új 2.5-ös):

Ahogy látszik, az új csatoló a DG, illetve a virtuális gépeket is átállítottam az új bridge-re (le is próbáltam, gigánál gyorsabban kommunikálnak), meg a host host táblájában is az új címre tettem a nevét, így a datacenterben is az új címét mutatja a szervernek a nodes szekcióban, a Proxmox webfelület pedig mind a két címen bejön. Viszont ha a régi csatolóból kihúzom a madzagot, az új címen sem lesz elérhető a PVE, illetve a ping sem működik, szóval mintha nem lenne ip címe (ami egyébként manuálisan van kiosztva), viszont a virtuális gépek a saját címükön elérhetőek.Mit csinálok rosszul?

-

danih

veterán

válasz

tasiadam

#2869

üzenetére

tasiadam

#2869

üzenetére

Van maga a node a bal oldali menüben, annak van egy Console-ja, pl. erre gondoltam.

De már nem érdekel igazából a dolog, mert nem fogok VM-be passthrough-t csinálni mégsem. LXC-be csináltam végül (Jellyfin transcode) - faszán működik, és ami plusz, hogy más LXC-k is tudják használni (mert igazából nem is passthrough a dolog). -

amargo

addikt

Sziasztok!

Csináltam egy kis tesztet, nem tudom mennyire volt értelme (a cache miatt), a lényeg pve alatt felcsatolt tárból adtam oda egy VM-nek egy zfs volume-ot, amit a VM alatt is zfs-ként kezeltem 1GB-os fájllal dolgoztam, de lehet megnézem majd nagyobbal is. Csináltam egy ext4-es tesztet is, de az nagyon kiábrándító volt.

A lényeg, hogy pve alatt ilyen beállításokat használtam:

[kép]Itt vannak az eredmények chart-ba rakva

Read: [kép]

Write: [kép]Én ezek alapján scsi7-io választottam, itt nem kapcsoltam be a writeback-et.

Mit gondoltok mire érdemes beállítani vagy ki hogyan használja, akár ext4 esetén is?

-

lehet smb-t csatolni, de itt van pár csapda. Azt is mentenéd, amihez csatoltad, akkor itt ne legyen pipa a backuphoz.

Sztem jobb megoldás a pve-nek adni és létrehozni rajta mappát a VMnek. Egyik kolléga itt anno azt írta, h az a mentés ér valamit, amit vissza is tudsz állítani. OK, ha ext4 a vinyó, akkor megtalálod, ha a host vm elhullik, de macerásabb, mert pve-hez kell mégis csatolni, visszaállításkor meg máshova csatolná...

-

kutga

félisten

Hölgyek/Urak!

Új pve konfig, van benne egy 32GB-os msata ssd az oprendszernek, egy 120GB-os sata ssd a vm-eknek, konténereknek, és rá van kötve a gépre egy terabájtos usb3 merevlemez, ami jelenleg át van adva egy debian alapú vm-nek, erre mennek a letöltések és erről megy a visszatöltés is, de szeretném befogni backup feladatra, tehát, a jelenlegi két vm-ről erre szeretnék készíteni mentést, amennyiben megoldható.

Az usb merevlemez a hoston nincs felcsatolva, csak a debian alatt, viszont smb-n keresztül megosztottam, lehet olyat csinálni, hogy a pve host alatt csatolom az smb megosztást, és arra készítem a mentést?

-

danih

veterán

Milyen mellékhatásai vannak a host masinán annak, ha csinálok egy GPU passthrough -t egy VM-be? Milyen funkciót veszítek el? Spice a többi VM-ben? Host console?

-

AcCEsS

senior tag

Szépen haladok a Proxmox "belakásával", de ezért belefutottam pár problémába is. Az elég gyorsan kiderült, hogy a Lenovo M720Q alaplapi Intel I219-V ethernet kártyája kicsit magasabb terhelésre "Detected Hardware Unit Hang" hibákat dobál, amire - a fellelt infók alapján - csak a rx és tx checksumming hwoffload kikapcsolása segített, aminek nem igazán örültem, habár nincs őrületesen nagy hálózati terhelés, dehátakkorisnanemá'. Mivel volt egy 4 portos Intel I350 hálókártyám (és mert a gépben van egy pci-e elosztó), beépítettem, és kihoztam belőle a maximum "tudást":

post-up ethtool -G enp1s0f0 tx 4096 rx 4096

echo "3f" > /sys/class/net/enp1s0f0/queues/rx-[*]/rps_cpus

echo "3f" > /sys/class/net/enp1s0f0/queues/tx-[*]/xps_cpusráadásul minden offload helyből működik, tehát az ethernet chip rendesen tehermentesíti a CPU-t. Úgy tűnt semmit hiba, nagy terhelésre se nagyon mozdul meg a CPU, nincs hibaüzni, minden szép! Viszont a hálózati teszteléshez plusz terhelésnek backupokat is akartam indítani, met az a NAS-ra megy, tehát jó ki kiegészítő terhelés a hálókártyának. Hát itt kaptam egy hibaüzenetet: "ERROR: Backup of VM 100 failed unable to open file /etc/pve/nodes/proxmox/lxc/100.conf.tmp.2358 Input/output error" Mi van? És mindegyik VM és mindegyik LXC-re ugyanez, és a clone is ugyanezt dobja, persze az adott configra hivatkozva. De hát a hajnali automata backup még jól ment! Hmmm. Mi a franc ez? Végig túrtam a beállításokat, a jogosultságokat meg mindent, de nem leltem meg az okot. Viszont a neten elég sok hasonló beírást találtam, végül az egyik hozott megoldást! A "systemctl status pve-cluster" infójában volt egy "proxmox pmxcfs[894]: [database] crit: sqlite3_step failed: database disk image is malformed#010" bejegyzés. Az adatbázis itt található: /var/lib/pve-cluster/config.db Valamiért megsérült. A hálókártya beépítése meg a beállítás során jó párszor újraindítottam a gépet, de mindig szabályos leállítás volt, és megvártam míg lekapcsolja a gép magát. Ettől függetlenül a config.db sérült. Gondoltam kidumpolom, visszaimportálom, és majd kiderül mi lesz!

sqlite3 /var/lib/pve-cluster/config.db

sqlite> .mode insert

sqlite> .output config.sql

sqlite> .dump

sqlite> .exit

mv /var/lib/pve-cluster/config.db config.db.original

sqlite3 /var/lib/pve-cluster/config.db < config.sql

rebootAz újraindítás után az adatbázis hibaüzi megszűnt, és láss csodát, megy a backup, a clone meg minden.

Ami kicsit idegesít, hogy megoldás már van, de a hiba eredeti okára nem jöttem rá. Bocs, kicsit hosszú lett a szöveg (és nem is túl hasznos), de ki kellett írnom magamból a tapasztalatokat!

Tuti ami ziher, ezt a fájlt (meg mindent is) betettem a mentésbe.

Tuti ami ziher, ezt a fájlt (meg mindent is) betettem a mentésbe. -

+1 a PVE stabil, a kezdeti bénázásaim, próbálgatásaim elmúltával...

Ahogy írtam korábban, én "megszabadultam" a ZFS-től és az LVM-től is (Clonezilla nem tudta jól menteni/helyreállítani sajnos). A probléma csak annyi, h nem értek hozzá / rengeteget kellene guglizni, ha valami baja van, akkor gyorsan tudjam helyreállítani.ZFS mellett vannak érvek (bitrot főleg ami miatt érdekes nekem), de az én felhasználásomra overkill, ext4 korábban is kiszolgált. Másrészt, ha egy VM vagy a host elhullik, akkor is pikk-pakk újratelepíthető, csatol és kész. Nem mondanám, h ez az ajánlott hozzáállás, mindenkinél más az igénybevétel. Nekem inkább az okosotthon köti le az időmet, LVM és ZFS próbálgatása (tönkre kell rakni, h tudjam sikerül-e helyrerakni

![;]](//cdn.rios.hu/dl/s/v1.gif) ) nem fér bele. XFS és BRTFS meg a mindenféle fancy fájlrendszerek nem tudtak meggyőzni, h PVE alá kerüljenek, az EXT4 már ismerős, több hirtelen áramszünet után is újraéledt a rendszer hibátlanul. Sokat nem segítettem...

) nem fér bele. XFS és BRTFS meg a mindenféle fancy fájlrendszerek nem tudtak meggyőzni, h PVE alá kerüljenek, az EXT4 már ismerős, több hirtelen áramszünet után is újraéledt a rendszer hibátlanul. Sokat nem segítettem...

-

amargo

addikt

Sziasztok!

Tudom már többször felmerült és tök szubjektív is tud lenni a dolog, de kérdeznék, mert bízok a tanácsokban

Szeretnék a gépből 2 hdd-t (2-4TB) és egy ssd-t kipakolni. Szóval beszereztem pár komolyabb háttértárolót..

Gyakorlatilag mindenhol ZFS-t használok már elég régóta (4-5 éve) és bár az elején PVE alatt megszívatott ssd-n a ZFS, de mára tudom miket kell beállítani és alapból bele került egy csomó disztróba is. Jelenleg is van kb állandó 20GB szabad RAM-om, tehát ez sem gond.

Az utóbbi 1 évben atom stabil volt a PVE, de tényleg, semmi gond semmivel

Összegezve én alapból simán maradnék ZFS-en, de hátha van valami ajánlottabb, XFS esetleg vagy simán csak ext4. ZFS-ből nem használom ki a raid-et, csak a tömörítést és copy-on-write, ami azért fontos.

Vélemények, köszönöm előre is?

-

inspiroyhome

senior tag

https://tcude.net/monitoring-proxmox-with-influxdb-and-grafana/

En ez alapjan elkezdenem monitorozni a rendszert, lehetoleg egy masik geprol. Ha lehet, ne a proxmox ala tedd fel a monitoringot.

Ilyen minden is lehal dolgot altalaban az IO teljes megsemmisulese szokott okozoni, NFS is kepes ilyesmire.

Feltennem a fentebb linkelt megoldast, es monitoroznam az IO wait-et, vagy ennel egyszerubb egy sima top / htop a proxmox node shelljen, SSH-n keresztul (ne bongeszon keresztul) egy masik geprol, es nezd meg mi tortenik.

Syslolban nincsenek veletlenul iowait / txc / sync issue-ra hajazo logok?

-

Aksomatic

senior tag

Olyat lehet-e csinálni hogy az alaplapi videokártyát egyszerre két VM is elérje melyek egyszerre futnak?

-

PHenis

senior tag

Újraindítás után most működik a rendszer, töröltem a jobot és az NFS megosztást mert már este volt és amúgy függ tőle az egész ház kb

Nemtom milyen joggal futott, ezt a részét egészen biztos nem babráltam, gyárin van. Valamit csinált amúgy mert amíg az újraindítással küszködtem a backup job futott a háttérben és a NAS-on lett is egy pár gigás file amit a proxmox rakott oda. Csak közben kimeredt kb teljesen az egész valamiért.

-

-

-

PHenis

senior tag

Sziasztok,

történt egy furcsaság tegnap amit nem értek. Backup készítés téma.

Egy sff gépen fut a proxmoxom, 6gen i5, 16GB ram, nvme ssd-n a proxmox, sata 500GB hdd disk pass a truenasnak. Kissebb konténerekben omada, adguard, qbittorrent, plex, VM-ben homeassistant, truenas és egy játszós ubuntu linux.Backupot szerettem volna készíteni egy nagyon alap qnap nas-ra. NAS-on csináltam egy NFS megosztást, proxmox-on felvettem NFS-ként csináltam egy job-ot az összes lxc-re és vm-re heti rendszerességgel és rányomtam hogy most fusson le.

Az történt, hogy kb lehalt az egész rendszer, a webes felületen kb mindenre timeout-ot dobott, akármelyik konzol megnyitásra a végén már a summary fülön ahol a terheltséget mutatja, ott is... Nagy nehezen újraindítottam tápkirántás nélkül és most megy mint előtte.

Azt gondoltam, hogy a qnap nas-nak a 100 megás lan portjának alacsony sávszélessége miatt majd nem terheli majd meg a szervert se a helyi hálót a backup és szépen elketyeg majd hetente csendben, úgy sem változtatgatom a rendszert túl sokat...

Ha kézzel csinálok backupot a helyi LVM-be akkor szépen megcsinálja pár másodperc alatt.

Hol a hiba az elképzelésemben és mit rontottam el, mitől történhetett ez?

-

danih

veterán

válasz

inspiroyhome

#2835

üzenetére

inspiroyhome

#2835

üzenetére

Mondjuk az merész, még VM esetén is félnék egyetlen dologra pakolni mindent

Amúgy a dockerben pici service-ek futnak amiknek egyszerűen nem éri meg natívan LXC-t adni. Egyetlen kivétel az Ollama, de az most csak teszt jelleggel van ott, majd külön veszem ha kell. -

akkor én a dhcp range-t levenném pár címre és restart vm

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

AcCEsS

senior tag

válasz

markussandor

#2845

üzenetére

markussandor

#2845

üzenetére

Köszönöm, ezt az infót én is megtaláltam, de ehhez telepíteni kell a VM-ben a qemu-guest-agent csomagot. Lehet, hogy csak ezen a módon megy, egyelőre nem találtam más megoldást, de még keresem. De nagyon köszönöm a segítséget!

-

-

markussandor

senior tag

Ez megmutatja:

pvesh get /nodes/<hostname>/qemu/<vmid>/agent/network-get-interfaces -o yaml | grep ip-address

pl nálam "pve" a gép neve, és a 101-es gép címét akarom megtudni:

root@pve:~# pvesh get /nodes/pve/qemu/101/agent/network-get-interfaces -o yaml | grep ip-address

ip-addresses:

- ip-address: 127.0.0.1

ip-address-type: ipv4

- ip-address: ::1

ip-address-type: ipv6

ip-addresses:

- ip-address: 192.168.5.211

ip-address-type: ipv4

- ip-address: 2001:4c4e:10d8:fb00:df1a:55e8:34e0:b0a1

ip-address-type: ipv6

- ip-address: fe80::e22a:87ad:65cd:5e41

ip-address-type: ipv6

ip-addresses:

- ip-address: 172.17.0.1

ip-address-type: ipv4

- ip-address: fe80::42:eaff:fe2f:1261

ip-address-type: ipv6

ip-addresses:

- ip-address: 10.51.0.1

ip-address-type: ipv4

- ip-address: fe80::42:c1ff:fe2b:78f1

ip-address-type: ipv6

ip-addresses:

- ip-address: fe80::4821:a5ff:fe6a:f530

ip-address-type: ipv6

ip-addresses:

- ip-address: fe80::f899:4fff:fe89:8729

ip-address-type: ipv6

ip-addresses:

- ip-address: fe80::5099:d1ff:fef4:349f

ip-address-type: ipv6 -

AcCEsS

senior tag

arp -a nem adja le, mert ha jól tudom, az arp táblába csak akkor kerül be, ha a forrás és a célcím már kommunikáltak egymással. (pl. azért nincs webes elérés, mert grafika nélküli linuxos konzolból lépek be. Emiatt kilőve a router webes felülete is, ahol a kiosztott IP-t meg tudnám nézni.) Tehát csak SSH van, amivel elérem a Proxmox-ot futtató gépet. Namármost, ha azon kiadom a "qm list" parancsot, akkor látom a VM-ek listáját, utána mehet pl. egy "qm start 105", erre elindul az VM, amibe szintén be kellene lépnem SSH-val, de ha DHCP volt a VM-ben beállítva, akkor nem tudom milyen IP-re kell hivatkoznom. A Docker esetén simán le tudtam kérni az "inspect" paraméterrel, de itt vajh hogyan tudom meg az IP címet?

-

-

AcCEsS

senior tag

Ha nincs webes hozzáférésem, de ssh-val be tudok lépni a Proxmoxot futtató gépre, és egy adott VM-et elindítok a qm start <vmid> paranccsal, hogyan tudom lekérdezni, hogy az adott vm dhcp-n keresztül milyen IP címet kapott?

-

válasz

inspiroyhome

#2835

üzenetére

inspiroyhome

#2835

üzenetére

unprivileged-nél lehetnek jogosultság bajok, ha az LXC-hez akarsz megosztásokat létrehozni. De azért ez is megoldható. Eddig még nálam (ami abszolút home user level) nem volt olyan probléma, amire nem találtam megoldást. Max ha túl körülményes volt, akkor skippeltem

szpeti40: azt a wifit miért nem egy VM (openWRT, opnsens vagy ilyesmi) kapja passthrough és nem a PVE? Csak kérdezem, nem tudom igazán, h mi a terv, nem olvastam vissza

-

inspiroyhome

senior tag

-

danih

veterán

Nézegettem én is a doksit, szerintem elég régen volt megírva és lehet ez is bent ragadt - azóta elég jól kiforrta magát a dolog, én sem tapasztaltam eddig semmi negatívat.

Én személy szerint jelen tudásom alapján úgy állok hozzá, hogy ha nem Linux a rendszer és/vagy emelt szintű biztonság kell valamilyen okból: VM, minden másra pedig ott amastercardLXC.

Térképezz csak nyugodtan, tölts azzal el minél több időt - én is úgy jártam hogy találtam valamit, rápörögtem, szórakoztam vele, hegesztgettem, aztán mire jól ment két napra rá, találtam jobbat

Most így néz ki a "rencer" (takart dolgok nem pornó de az is lehetne )

)

-

AcCEsS

senior tag

Köszi!

Sok olyan beírással találkoztam ahol a Docker simán LXC alól volt használva, és annak ellenére, hogy a Proxmox doksi nem ajánlja, évek óta hibátlanul futtatják. Nálam már működik két VM, mindkettőben egy-egy Docker konténer fut, melyek elérik egymást, és a konfigokat felmountolt NFS-ről töltik. Nekem ez így már jó irány. Eöröm ebódottá!

Sok olyan beírással találkoztam ahol a Docker simán LXC alól volt használva, és annak ellenére, hogy a Proxmox doksi nem ajánlja, évek óta hibátlanul futtatják. Nálam már működik két VM, mindkettőben egy-egy Docker konténer fut, melyek elérik egymást, és a konfigokat felmountolt NFS-ről töltik. Nekem ez így már jó irány. Eöröm ebódottá!  Egyelőre a lehetőségek feltérképezése tart...

Egyelőre a lehetőségek feltérképezése tart... -

AcCEsS

senior tag

@inspiroyhome, @tasiadam, @markussandor, @ViZion, köszönöm a tanácsokat, tegnap éjfélig nyomtam, ma 4-kor keltem!

A Proxmox egyszerűen lenyűgöző, de tényleg! Több mindent kipróbáltam, ma este folytatom!

A Proxmox egyszerűen lenyűgöző, de tényleg! Több mindent kipróbáltam, ma este folytatom!

-

inspiroyhome

senior tag

Amit mar masok is leirtak:

Telepits VMeket, azokra dockert es igy oszd el oket. En is kerulnem az LXC-t elsosorban.

Csinalj majd egy VM-et a PBS (proxmox backup server)-nek is, PBS-en belul tudsz synology NFS-t megadni mint lemez ha jol emlekszem, es akkor tudsz egy tok jo, tomoritos deduplikalos backup megoldast is felhuzni.

Arra figyelj, hogy a miniPC integralt GPU-jat nem fogod tudni VM-en belul hasznalni, amig at nem adod a VM-nek. Hirtelen ugy remlik, hogy intel CPU-knal az iGPU passthrough problemas es fajdalmas, ezert ott indokolt az LXC.

A legfontosabb: a regi rendszeren addig ne barmolj szet semmit, amig az uj nem mukodik teljesen ugy, ahogy akartad. Ez a traefikos, cert masolos dolog nagyon balul is elsulhet, es lehet hogy tobb napig fogsz vele szarakodni.

-

tasiadam

Topikgazda

Legegyszerűbben: Aminek kell power, az VM-be, ami dockerben van most, azt dockerbe is hagyhatod, LXC-t nem használnám. De ha kell neked share + letöltő központ, akkor ne szarakodj szerintem külön dockerrel, hanem xpenology VM-re 2 szálon, azmeg tovább fogja osztani ezt 8 threadre. Ugye ez a tákimáki synology oprendszer, de benne van minden is, ami kell.

-

markussandor

senior tag

Ha a proxmox mellett döntesz (jó cucc, imádom), akkor ne használj LXC-t dockerrel, nem ajánlott. Csinálj egy rendes VM-et, arra tedd fel a dockert, és az futtasson minden konténert.

Pl. ha felhúzok egy Traefik konténert, hogyan tudom úgy eldobni, hogy a beállításaim (pl. cert-ek stb.) ne vesszenek el?

Ennek is csinálhatsz volumet-t a synologyra.A konfigok mentéséhez javaslok egy saját git repót.

-

Szia!

Domo saját vm, a dockereknek meg kell egy a dockereket kezelő vm, ilyen a CasaOS, vagy akár egy ubuntu server vm, de van Fedoranak is dockeres disztrója.

ha a dockerek helyett lxc-be raknád ezeket (nagy részére van 1 klikk lxc telepítő), az lxc frissítés is 1 kattintás, 2 gomb nyomás .. összeset frissíti.

Proxmox helper scriptsre keress rá a neten.

Ha valamiben, akkor backup-ban kiváló a proxmox, a cert dologra a topikgazda vagy más tud válaszolni, azzal én lusta voltam szuttyogni.

Szerintem a külön vAson kezdjed el a vm és lxc telepítést, akkor majd látod, h jó ip címek, net beállítása szokott probléma lenni, ezekre figyelj.

ip címek, net beállítása szokott probléma lenni, ezekre figyelj.

Visszaállítani bármit pár kattintás. Amikor a tűzfalat hangoltam, akkor jól jött. De VM alatt is lehet pl. hdd "cserélni", meg minenhova lehet megosztást több módon csatolni, nagyon rugalmas. És angolul mindenre van leírás, yt videó, stb... meg itt vagyunk mi is, hejj

-

AcCEsS

senior tag

A tanácsotokat szeretném kérni. Jelenleg egy Raspberry PI4 intézi az otthoni dolgaimat Raspbian alapon, amihez egy Synology NAS biztosítja a tárhelyet, ami NFS-en keresztül van felcsatolva a PI4-hez. A smarthome rendszeremet (40-50 eszköz) natívan telepített Domoticz vezérli, ezen kívül minden Docker alatt fut, kb. ezek a konténerek:

node-red, pyload, calibre-web, uptime-kuma, filebrowser, changedetection, mariadb, syncthing, homarr, traefik, pihole, airsonic, transmission, watchtower, pigallery2, wireguard, influxdb, grafana stb., részben smarthome, részben kényelmi funkciókat (meg sok más feladatot) ellátva.

A konténerek minden configja/adata a PI4-re kötött SSD-re, illetve közvetlenül a Synology NFS-re dolgozik. Mivel minden konténerleíró compose formátumban van (és az adatok a konténeren kívüli adattárolóva vannak bindolva), bármikor eldobható a konténer, újrarakható, és újratelepítés után ott folytatja, ahol abbahagyta. Eddig ok. Viszont szeretném megismerni a Proxmoxot is, szereztem egy M720Q-t 32GB rammal és egy 500GB-os SSD-vel, amire szeretném leváltani a Raspberry-t. Hogyan bontanátok szét a jelenleg futó Docker konténereket? Docker konténerek egyenként LXC-be, vagy külön a Netről elérhető / helyi kiszolgálásra használt konténerek egy-egy LCX-be Dockerrel, esetlen valamit VM-be, pl. Domoticz? És hogyan oldjátok meg a configok mentését/visszaállítását? Egyelőre próbálom megismerni a VM és a CT rejtelmeit, de nem igazán tudom hogyan induljak el. Pontosabban amellett, hogy nagyon teszik a Proxmox a remek lehetőségeivel, úgy érzem a későbbi felügyelet jóval több munkát igényelne, mert a VM vagy a CT frissítések plusz munkát jelentenek, és minél több van, annál rosszabb a helyzet. Ha azokon belül meg Docker is lenne, akkor még azok frissítése is plusz figyelmet igényelne, pl. ne törjön el egy LXC frissítés után, működjön rendben stb. (most a Watchtower megoldja), bonyolultabbnak tűnik sokkal, mint a jelenlegi rendszer. A lényeg: kicsit úgy érzem, nem előrelépést hozna az átállás a Proxmoxra, hanem csak plusz munkát. Vagy rosszul gondolom? Valszeg még egy csomó mindent nem ismerek, rengeteg kérdés és kétség van bennem, és emiatt érzem így. Pl. ha felhúzok egy Traefik konténert, hogyan tudom úgy eldobni, hogy a beállításaim (pl. cert-ek stb.) ne vesszenek el? -

-

adabra

senior tag

Sziasztok!

mennyire kivitelezhető (és elvetemült) ötlet, hogy a PVE-t a jelenlegi LAN-ról wifi-re költöztetem át? Egy Intel N100-as mini PC-n fut (6 db LXC + 1 db VM fut rajta).

Most is egy nem mesh router-en lóg kábelen (de a router wifi-n kapcsolódok a fő router-hez). Arrébb kellene telepítenem a router-t olyan helyre, ahova a mini PC-t nem tudom vinni...

-

paizinho

tag

válasz

paizinho

#2812

üzenetére

paizinho

#2812

üzenetére

Üdv!

A probléma megoldódott! tasiadam kolléga tippje volt a "nyertes", a tápegység lett a hiba forrása. Asztali táppal simán indult. Így is többször gondolkodtam egy számmal nagyobb házon, hogy a PCIe slotba LAN kártyát rakjak, most aktuális lett.

Köszönöm a segítségeteket.

Ha már hozzányúlok, akkor már RAW diskeket leváltanám a Vizion kolléga által már belinkelt ext4-s lehetőségre. Ha jól emlékszem hasonlóan használjuk (OMV-ben vannak a docker cucaim, nekem kényelmi okokból) Mindenről van mentésem a világban, de kényelmesebbnek gondolom, ha valami gond van, akkor másik gépbe átrakva a diszket olvashatóak maradnak a dolgaim.

CPU csere is felmerült már korábban bennem, így annak is utána nézek, mert szerintem most nem nagy kajásak a dolgaim, de Wireguard miatt mennék feljebb, mint a mostani i3-6100T-m.

Szóval megyek olvasgatni. -

válasz

markussandor

#2813

üzenetére

markussandor

#2813

üzenetére

létrehozol pve network részén egy új bridge-t, amihez nem rendelsz lan portot. Ezeket adod a VMnek, akkor csak egymással beszélgethetnek. Annak nem néztem utána, h ilyenkor óra szinkronizálás a pve-vel müködik -e.

B terv, a pve tűzfal beállítása. Ha van opnsense, akkor egyszerűbb, lehet időzíteni, stb.

-

markussandor

senior tag

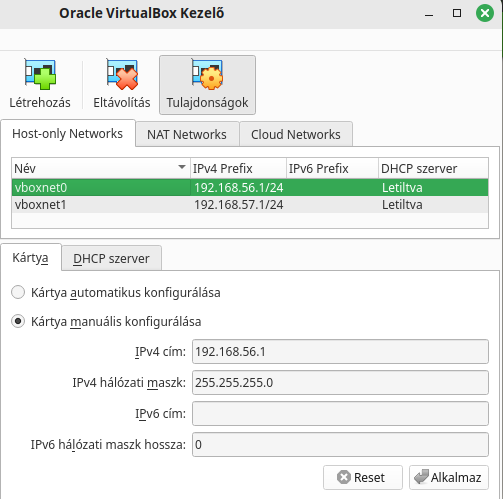

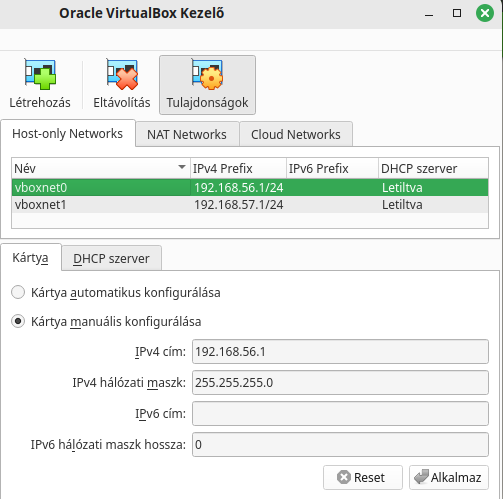

Sziasztok. Szükségem lenne egy PVE-n belüli virtuális switchre. Olyanra, mint a virtualbox esetén használt host-only network:

Ilyet lehet csinálni a webes felületen? Vagy csak parancssorból?

Köszi!Az lenne vele a célom, hogy a rákötött gépek csak egymással tudjanak kommunikálni, a külvilággal nem.

-

paizinho

tag

Nem láttam kifolyást, de még egyszer megnézem vasárnap.

A táp méregetés nem annyira triviális nekem és sajna multiméterem nincs. A tápot a házzal együtt vettem.@tasiadam : igazán nagylelkű már a lehetőség is

, még ha le is maradtam róla

, még ha le is maradtam róla  . Az aprón épp egy 6100T-t sikerült fognom. Ha nem boldogulok, akkor az új alaplap irányába mozdulok el. De a "remény hal meg utoljára".

. Az aprón épp egy 6100T-t sikerült fognom. Ha nem boldogulok, akkor az új alaplap irányába mozdulok el. De a "remény hal meg utoljára". -

válasz

paizinho

#2809

üzenetére

paizinho

#2809

üzenetére

TasiAdamnakigaza lehet, meg kell nézni mindent is.

Alaplapon a VRM környéke rendben van? Nem folyt ki kondi, nincs gyanús dolog rajta?

Tápot el tudod indítani az ATX24 pint (mindenhonnan húzd le) lehúzva is, zöld és GND/COM (fekete) kell egy vezetékkel, gemkapoccsal összezárni. Utána mérj rá, ha van multimétered. Ez sem ad 100% eredményt, mert lehet, h terhelés alatt áll meg, de ha így nem jó, akkor terhelve sem lesz az.

LC Power az vésztartalék megoldás legyen inkább. Aprón vannak FSP és más minőségi brand SFX, ATX tápok, szerintem olyasmit szerezz be. -

-

paizinho

tag

Nagyon köszi a gyors választ és a javaslatokat és biztató hírt, hogy össze kéne szedni magát.

Az üzi előtt már megtörténtek az általad is javasolt takarítások, porcica elég kevés volt. Így nálam már csak a CPU és a venti jöhet szóba.

Aprón láttam most i3-6100T-t 4kért, tőlem nem túl távol, annyi nekem még belefér. Ha nem megy akkor meg biztató, hogy a Proxmox összszedi magát. Köszönöm .

.

(A Proxmoxban futott az opnSensem is,. Így még jó, hogy van B tervnek egy sima router, így az internet mentesség csak rövid ideig volt, a család nagy örömére) -

válasz

paizinho

#2803

üzenetére

paizinho

#2803

üzenetére

Szia! Ne keseregj, ha az adatok rendben vannak, akkor a Proxmox összeszedi magát, az 99%

Régi vasaknál is alaplap szokott elhullani inkább, bár egy haldokló vrm viheti a procit is... de ilyet ezerbéve nem láttam.

Mindenképp a csatlakozásokat nézd át, ramot kifúj, visszarak, stb. alap dolgokat csináld meg, mielőtt vásárolsz.

Procit is kiveheted, kitakarítani, megszaglászni,h ténylek onnan jött az amperszag....

Volt itt javításon olyan gép, aminél a cpu alatt és környéke volt tele porcicával, inkább gyapjú volt már... random fagyott, nem indult. Hátha csak ilyesmi a baj. -

paizinho

tag

Sziasztok!

A proxmox alatti vasam egyszer csak megállt. Email-ben sem jött semmi, ami alapján előzetesen valamire ugrottam volna. A miniITX házikó egy kicsit melegebb volt, de nem sokkal, mint a korábbi kézzel ellenőrzésekkor. Egyelőre bekapcsolni sem tudom, de a CPU a gyanúsított, mert van egy kicsi "pörkölt" szaga. A lap nem egy mai darab, de eddig ment probléma nélkül (Asrock Z270M-ITX/ac).Ha berakom a két disket egy másik Intel-s gépbe, akkor a Proxmox (mivel Linux alapú) magára találhat? Vagy mindenképpen a mostani lapot kellene életre lehelni? CPU csere nem tűnik annyira egyszerűnek mert 6/7-ik generációs 1151-s procit fogad, de benézek az apróra is.

Volt már valamelyikőtöknek hasonló tapasztalata?Köszi ha lesz időtök válaszolni !

-

Nem kell feltétlenül. Itt egy jó videó a hálózatokról, h mit lehet PVE-vel megoldani.

A jóembernek rengeteg jó proxmox videója van, érdemes átfutni párat.

Meg a Traefik-et nézd meg. [link]

Új hozzászólás Aktív témák

- Mini Pc HP ProDesk 600 G2 G3 G4 /// 6-8. gen //// i3 / i5 /// garancia /// Budapest / MPL / Foxpost

- Újszerű Apple Macbook Air 13 - M2 - 8/256GB (MLY33MG/A) éjfekete - 141 Ciklus - 1+ év garancia - HUN

- 123 - Lenovo Legion Pro 5 (16ARX8) - AMD Ryzen 7 7745HX, RTX 4070 (ELKELT)

- HIBÁTLAN iPhone 12 mini 64GB Red -1 ÉV GARANCIA - Kártyafüggetlen, MS2036

- darkFlash GR12 Darkstorm Blue/Green

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Laptopszaki Kft.

Város: Budapest

lehet overkill, amúgy ajánlásokat meghallgatok szívesen.

lehet overkill, amúgy ajánlásokat meghallgatok szívesen.

![;]](http://cdn.rios.hu/dl/s/v1.gif) ) nem fér bele. XFS és BRTFS meg a mindenféle fancy fájlrendszerek nem tudtak meggyőzni, h PVE alá kerüljenek, az EXT4 már ismerős, több hirtelen áramszünet után is újraéledt a rendszer hibátlanul. Sokat nem segítettem...

) nem fér bele. XFS és BRTFS meg a mindenféle fancy fájlrendszerek nem tudtak meggyőzni, h PVE alá kerüljenek, az EXT4 már ismerős, több hirtelen áramszünet után is újraéledt a rendszer hibátlanul. Sokat nem segítettem...

. Az aprón épp egy 6100T-t sikerült fognom. Ha nem boldogulok, akkor az új alaplap irányába mozdulok el. De a "remény hal meg utoljára".

. Az aprón épp egy 6100T-t sikerült fognom. Ha nem boldogulok, akkor az új alaplap irányába mozdulok el. De a "remény hal meg utoljára".