Új hozzászólás Aktív témák

-

Loha

veterán

válasz

scarabeus86

#39871

üzenetére

scarabeus86

#39871

üzenetére

A HDMI alapvetően egy házimozis, HDTV -khez szánt csatlakozó, ahol hagyományosan minden tartalom limited (16-235) RGB -ben van, tehát az összes DVD, Blu-Ray, TV adás, H.264 -es videó, és az összes házimozis cucc limited jelet küld és fogad, a full range (0-255) RGB -t csak opcionálisan tudják.

-

Loha

veterán

"Az NV-nek az új konzolgeneráció betesz. Nem éri meg ebbe pénzt invesztálni, amikor a mobil piacon a Qualcomm is nagyon keményít. Ellenük van esélye az NV-nek. Az AMD hardveres felépítését követő konzolok ellen nincs."

"Az NV-nek most az a cél, hogy a konzolra kiadott játékokat lehessen játszani felhőből, mert más lehetőségük nincs a versenyzésre, leszámítva azt, hogy rábeszélik a fejlesztőket a PC-s port butítására és újradizájnolására, ha szükséges."

-

Loha

veterán

válasz

Petykemano

#39523

üzenetére

Petykemano

#39523

üzenetére

Ilyesmikre gondoltam: #980

"Az Intel és az NV távolodik a Windows gamingtől, mert marha nagy gyomros nekik a low-level elérés hiánya, ha egy konkurens ehhez hozzájut. A SteamOS-re mennek, mert a Valve open kezdeményezéseket akar. Az NV elveszti a PhysX-et és a CUDA-t is, de legalább nem lesz Mantle."

-

-

Loha

veterán

válasz

Petykemano

#39252

üzenetére

Petykemano

#39252

üzenetére

Fontos különbség, hogy a hivatalos megjelenése előtt, vagy lehozod a gyártó grafikonjait, vagy nem hozol le semmit között lehet csak választani, a Radeon VII meg már több mint egy hónapja megjelent, és vannak "rendes" tesztek, nem vagyunk már kénytelenek a propaganda anyagokra hagyatkozni.

-

Loha

veterán

válasz

Devid_81

#38782

üzenetére

Devid_81

#38782

üzenetére

GTX 1080 Ti -vel is csak a vásárlók szemszögéből versenyképes a Radeon VII...

A Ti -t kevesebb mint fele annyiból le lehet gyártani mint a VII -et, sőt még duplázott VRAM mennyiséggel (22-24GB) és butítás nélküli GPU -val szerelve is olcsóbban gyártható lenne, ha nem lenne az RTX széria és árversenyre kerülne sor...

-

Loha

veterán

2010-ben az AMD már rég demózhatta volna a FreeSyncet laptopokon, ugyan úgy ahogy ezt megtették a G-Sync bemutatása után...

"Az meg nem úgy működik, hogy az AMD szépen meglátta a G-Sync-et, és gondolt egyet, majd gyakorlatilag egy év alatt áttolt az iparágon egy full szabványt a VESA-val."

Pedig pontosan így volt, mert nem kellett semmit senkin áttolni, csak az VESA eDP szabványából áttenni a VRR-t a VESA DP1.2 -be mint opcionális kiegészítést és kész.

Azért tudta az AMD olyan gyorsan demózni a FreeSyncet laptopokon, mert csak módosítani kellett hozzá a VGA drivert, és erre használni a már ott lévő 2009 -es eDP szabványt...

A bökkenő ott volt, hogy a laptopokban nincs monitor vezérlő chip, a GPU közvetlenül kommunikál a kijelzővel, viszont az asztali monitorokban meg van, amik nem támogatták a VRR-t, ezért az NV csinált magának egy monitor vezérlő chipet (a G-Sync modult), az AMD meg megvárta amíg a monitor vezérlő chip gyártók beépítették a VRR-t az chipjeikbe, ezért vártunk olyan sokat a FreeSynces monitorokra, ha csak firmware frissítésre lett volna szükség (ahogy azt páran állították) az 1-2 hónap alatt meglett volna...

-

Loha

veterán

Mert az NV nem kommunikálta elég jól, hogy a G-Syncnek nincs alsó határa, de ha megnézed ezt a friss táblázatot, akkor itt már az összes régi/új G-Sync modullal ellátott monitornál 1Hz szerepel mint alsó határ.

-

Loha

veterán

válasz

FLATRONW

#37553

üzenetére

FLATRONW

#37553

üzenetére

A G-Sync modullal szerelt monitoroknak nincs alsó frissítési határa (függetlenül a használt paneltől), tehát 1Hz - 240Hz (vagy a monitor által tudott max.) között működik, alacsony inputlaggal, adaptive overdrive-al, amit szintén nem alapértelmezett FreeSync-es monitorok esetén...

-

Loha

veterán

Ha a 1070 Ti shadereinek számát 79%-ra csökkented (1070), akkor a fogyasztás is csökken 82%-ra (1070), de be fog-e férni a GDDR5X-es 1060, a 1070 Ti fogyasztásának 65%-ba (ugyan azzal a GPU-val), ha shaderek számát 53%-ra csökkented (nem csak azt), és még megspékeled a kevesebbet fogyasztó GDDR5X-el is (meg 8GB helyett 6GB)?

1080 azért kér kevesebbet a 1070 Ti-nél, mert GDDR5 helyett GDDR5X van rajta, ami még vagy ~10%-kal csökkenti a fogyasztás, úgy hogy közben magasabb órajeleken is jár...

-

Loha

veterán

A laikus felhasználó pontosan egy 6GB-os 1060-at fog kapni, akármelyiket is kapja, és számára teljesen mind1 is lesz...

Vess egy pillantást mondjuk a 1070 és a 1070 Ti viszonyára a fogyasztás tekintetében: A 1070 a 1070 Ti shadereinek ~79%-val rendelkezik és ~82% fogyasztással...

-

Loha

veterán

Még ez sem igaz, mert a gyártópartnerek feltüntethetik a GDDR5X-et a kártyáikon, ahogy ezt a Zotac meg is tette.

Nem biztos, hogy nagyobb távolságok vannak, mert ha a GP104-es chip egyik felét letiltották, a másik fele ami aktív, kb. ugyan akkora mint a GP106.

A fogyasztás legnagyobb részét nem a távolságok okozzák, hanem a tranzisztorok ki-be kapcsolgatása. -

Loha

veterán

De a pirosak butítottak, itt meg ugyan olyan speckókkal rendelkező kártyáról van szó, semmilyen butítás nem történt, sőt hozzáértők számára ezek a kártyák még vonzóbbak is lehetnek, mert a GDDR5X-es chipek tuningpotenciálja jóval nagyobb lesz a sima GDDR5-ös változatnál, és az azonos shaderszámmal rendelkező, de nagyobb chipet könnyebb is lesz hűteni, az meg csak hab lesz a tortán, hogy még a nyák felépítése is közelebb lesz a 1080-hoz...

A GDDR5X azonos órajelen (az alacsonyabb feszültség miatt) kevesebbet fogyaszt mint a GDDR5, maga a chip fogyasztása pedig nem lesz nagyobb, mert a letiltott részek nem üzemelnek.

-

Loha

veterán

Azért találok nehezen szavakat, mert tényleg kb. csak a selejt/felesleg kukázása,

Igen az, de senki nem is állította az ellenkezőjét, még csak nem is szerepel külön termékként a GDDR5X-es 1060... Ha előrelépésnek szánta volna az NV, akkor az a termék nevében jelezve lenne, ahogy azt az AMD is megtette az RX590 esetében...

Voltak az NV-nek régebben is ilyen selejt kukázós kártyái, csak azok általában nem jutottak el a retail piacra csak az OEM-ekhez, a korlátozott darabszám miatt.

-

Loha

veterán

"Reflections' experience suggests that the PlayStation Shader Language (PSSL) is very similar indeed to the HLSL standard in DirectX 11, with just subtle differences that were eliminated for the most part through pre-process macros and what O'Connor calls a "regex search and replace" for more complicated differences." Forrás.

1:1-ben nem, de nincs vele sok munka...

-

Loha

veterán

"Piaci részesedésük révén elérték, hogy ne is nagyon legyenek a pirosak extra képességeit kihasználó alkalmazások..."

Mindig jót mosolygok az ilyen tévképzeteken, miközben szinte minden multiplatform játékkal a PS4 GCN 1.1 -es GPU-ját célozzák a fejlesztők, mert ott számítanak a legtöbb eladásra, nem véletlen, hogy a GCN 1.1 asztali változatai is olyan jól öregedtek...

-

Loha

veterán

Csak a legkisebb Pascalokat gyártotta a Samsung (GP107, GP108), ez valszeg jobb alku pozíciót adott az NV-nek a TSMC-nél, és köze is lehetett ahhoz, hogy saját gyártósorhoz kaptak a TSMC-nél.

A Samsung gyártósorai pont az olyan kicsi, alacsony fogyasztású csipekhez lehet ideális mint a 1030 és 1050 (Ti), valszeg nem is alkalmasak csúcs GPU-khoz...A forrás itt is ugyan az a japán nyelvről Google fordítózott pletyka...

lezso6: Gyártott a Samsung valaha is nagy méretű, nagy teljesítményű lapkákat?

Biztos most fog lelépni az NV a TSMC-től, miután először eljutottak arra a szinte, hogy kaptak egy személyre szabott gyártósort...

-

Loha

veterán

válasz

lezso6

#35791

üzenetére

lezso6

#35791

üzenetére

Szerintem meg a Turingot pontosan a TSMC 12nm-es FFN (Fin Fet Nvidia) gyártósorára tervezték, mert máshol nem is lehetett volna ilyen nagy méretű (TU102) és teljesítményű chipet gyártatni...

Jövőre nagyon valószínű hogy jön az új NV (és AMD) generáció, de szokásosan a TSMC 7nm-én, mert másnak nem nagyon lenne értelme...

-

Loha

veterán

válasz

lezso6

#35141

üzenetére

lezso6

#35141

üzenetére

Az előd GTX580 (Fermi) is compute-ra készült, meg a konkurens HD7970 (GCN) is, a GHz Edition ellen pedig bőven elég lett volna egy GTX770 4GB, egészen a R9 290(X) (Hawaii) érkezéséig.

A GK210-ből pedig ezért nem jött GeForce, mert amikor megjelent, már elérhető volt a GTX980 (Maxwell) és készenlétben a GTX980 Ti (Maxwell), így semmi értelme nem lett volna egy drágábban gyártható kártyának... -

Loha

veterán

válasz

proci985

#34726

üzenetére

proci985

#34726

üzenetére

Hogy miért született meg ez a cikk?

Tom's melyik cikkjéről beszélünk mi is a kettő közül?

Tom's "korrekt" cikkje a saját olvasótáborukon kívül senkit nem érdekelt, viszont az ellentmondásos véleménycikkel foglalkoztak a Tom's weboldalán kívül is, ami sok extra bekattintást hozott nekik és valszeg visszajáró új olvasókat is, a saját olvasótárboruk meg SZVSZ tudja hova kell tenni ezt a véleménycikket.

-

Loha

veterán

válasz

TTomax

#34502

üzenetére

TTomax

#34502

üzenetére

Ez a kérdés a gyakorlatban szinte soha nem merül fel, mert akinek nincs PC-je, annak nincs igénye a PC nyújtotta extrákra, elég neki az okostelefon, neki jobb választás egy konzol, de nem elsősorban pénzügyi okok miatt, hanem mert megnyomod a gombot aztán játszol, nincs semmi komplikáció...

Akinek meg van már egy PC-je, ő valszeg igényt tart a PC nyújtotta extra szolgáltatásokra és a komplikációkkal is megbirkózik miattuk, neki az eldöntendő kérdés a PC gameresítése (ami jórészt csak egy VGA-t takar) vagy egy konzol a PC mellé.

-

Loha

veterán

Írják is a ComputerBase-en, hogy az SDR tesztek tömörítetlen RGB (4:4:4) színtérrel készültek, a 10bit HDR-hez meg valszeg a DisplayPort sávszélesség limitje miatt (a 4k 10bit HDR 120Hz-hez kevés a DP1.4 RGB-ben) veszteséges színtömörítést (YCbCr 4:2:2) állítottak be a driverben:

"SDR-Spielen nutzt der Monitor den RGB-Farbraum bei 8 Bit, in HDR YCbCr mit einer Farbunterabtastung von 4:2:2 bei 10 Bit. Die AMD- und die Nvidia-Grafikkarte wurden entsprechend im Treiber konfiguriert."

és valszeg ez a színtömörítés okozza a teljesítményveszteséget, a GTX 1080-on többet mint a VEGA-n. -

Loha

veterán

válasz

lezso6

#34191

üzenetére

lezso6

#34191

üzenetére

Az NV valszeg egy standard tokozást választott a TSMC-től, ahogy az MS is, nem tudok róla hogy ennek ellentmondó bizalmas dokumentumok kiszivárogtak volna.

TSMC gyártotta és tokozta az NV notebook GPU-it és az Xbox 360 GPU-ját is, közös volt még az alulméretezett hűtés, meg az hogy jelentősen az iparági átlag felett döglöttek meg ezek a GPU-k.

Hogyan reagált erre az MS? Az Xbox 360 alapértelmezett 1 év gariját kitolta 3 évre ezen hiba estén, és le volt tudva a dolog.

Az érintett notebookok esetében ugyan így a notebook gyártók feladata lett volna az érintett gépek gariját ezen meghibásodás esetén kitolni 3 évre, ha nem eleve annyi garival kapták a vásárlók a gépet, aztán a notebook gyártói az NV-vel lefájtolták volna hogy ki viseli a javítás költségeit, erre az NV már előre félretett egy nagyobb összeget.

Az általad linkelt cikkekben lévő információk nagy része a konkrét hibáról az NV OEM-nek szánt dokumentumából származik, amiben tájékoztatja őket a hibáról és a megoldásról.

Egy egész iparág épült rá az ebben az időszakban készült különböző chipek forrasztásának és tokozásának reflowjára.

Leírom még1szer, de ott van az általad linkelt cikkben is, hogy peren kívül egyeztek meg a felek, a bíróság nem kötelezte semmire az NV-t, mert nem volt ítélet. A peren kívüli megegyezés része volt amit a perelők is elfogadtak, hogy az NV nem ismeri el hogy hibázott, de fizeti a hibás GPU-k cseréjének költségeit.

Ja és a lényeg, hogyan lesz ebből mocskos NV?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Loha

veterán

válasz

lezso6

#34183

üzenetére

lezso6

#34183

üzenetére

A tokozás és a chipek nyákra forrasztása is megadhatja magát, pont úgy mint az Xbox 360 (meg még sorolhatnám) esetében.

Javíts ki ha tévedek, de az NV-hez tokozva érkeznek a chipek a TSMC-től, és peren kívüli megegyezés történ, tehát az NV-t nem jogilag kötelezték a kártérítésre, hanem a nyomás hatására önként felvállalták.

-

Loha

veterán

válasz

zovifapp111

#34179

üzenetére

zovifapp111

#34179

üzenetére

FreeSync esetén a VGA driver (ami a CPU-n fut) érzékeli a monitor paramétereinek tudatában, hogy képkocka ismétlésre lesz szükség, és utasítja a VGA-t hogy az utolsó képkockát küldje el újra a monitornak.

A G-Sync esetében ezt a monitorba épített modul végzi önállóan.

Szerk.: Az emberek alapvetően nem szeretik ha az ólom kapcsolatba kerül velük, de elbeszélsz mellettem...

-

Loha

veterán

válasz

Callisto

#34174

üzenetére

Callisto

#34174

üzenetére

A FreeSync modulok a monitorban nem tárolják el az utolsó képkockát, így ha ismételni kell, akkor a VGA-nak kell újra elküldenie az utolsó frame-et, a G-Sync esetén ezt a monitorba épített modul automatikusan végzi.

Tipikus ilyen eset, amikor a Low Framerate Compensation (LFC) működésbe lép.

zovipa: Az ólommentes (RoHS) forrasztások kevesebb ciklust bírtak mint a korábbi, kevésbé környezetkímélő változatok, de ehhez akkor még nem igazodtak megfelelően a gyártók.

-

Loha

veterán

válasz

lezso6

#34148

üzenetére

lezso6

#34148

üzenetére

Csak néhány dolog:

Az AMD vádjai konkrét bizonyítékok hiányában nem álltak meg a bíróságon:

Tech co. can’t sue ex-employees over computer use, tehát s.bala31 remekül megsejtette, hogy mi volt a szitu.Nem csak az NV notis GPU-i döglöttek idő előtt az ólommentes forrasztás miatt, hanem akkoriban minden aminek a hűtését nem méretezték kellően túl, többet között pl. az Xbox 360 ATi Xenos GPU-ja volt elsősorban felelős a Red Ring of Death -ért, de aztán idővel a CPU, meg a memóriák forrasztása is megadta magát, de arról nyilván nem ATi tehetett, hogy a MS spórolt a hűtésen, ahogy a notebook gyártók is, és a GPU-t sem az ATi forrasztotta a nyákra, ahogy NV is csak magát a TSMC által gyártott chipet adta a notebook gyártóknak, minden másról már ez OEM-ek gondoskodtak.

És igen, ha memória hibás lesz a VGA-d, akkor nem memória gyártójához mész reklamálni, mert nem tőle vetted, hanem a VGA-d gyártójához... -

Loha

veterán

válasz

Dandris

#33842

üzenetére

Dandris

#33842

üzenetére

Már előrendelésben elfogyott az összes GTX 1080. Ami persze egyáltalán nem azt jelenti, hogy a kártyára szerelt GDDR5X miatt nem tudtak eleget gyártani, ha csak a memória ellátással lett volna a gond, akkor nem vártak volna 1,5 évet a sima GDDR5-el szerelt GTX 1070 Ti piacra dobásával.

-

Loha

veterán

válasz

huskydog17

#33815

üzenetére

huskydog17

#33815

üzenetére

Azóta a Titan Xp is elfogyott

, hát ez nem sejtet semmi jót a jövőre nézve...

, hát ez nem sejtet semmi jót a jövőre nézve...

-

Loha

veterán

válasz

huskydog17

#33812

üzenetére

huskydog17

#33812

üzenetére

Azóta már újra el is fogyott minden a NVIDIA Store-ból a Titan Xp és a 1070 kivételével, de azokra is 1 hetet kell várni:

Szerk.: a hozzászólásom megírása alatt a 1070 is elfogyott...

-

Loha

veterán

GDDR5(X) chipenként 1-2W, egy 256bites kártyán van 8db az max. 20W, 384bites kártyán 12db az max. 30W és passzívan hűthető, ez nem tudom hol számít rendkívül soknak...

GDDR6 -ból azonos mennyiség olcsóbb lesz mint HBM2-ből, a drágaság relatív...

Leírom még1szer érthetőbben:

A 8GB-os konzolokon (PS4, Xbox One) kb. 3GB (V)RAM áll rendelkezésre a textúrák számára és a RotTR esetében a PC-s High textúrákat használják, mihez PC-n is elég egy 3GB-os VGA.

A 12GB RAMmal felszerelt Xbox One X -en kb. 6GB (V)RAM áll rendelkezésre a textúrák számára és a RotTR a PC-s Very High textúrákat használja, amihez PC-n is 6GB VRAMmal felszerelt kártya kell.

Tehát azonos textúra (és grafikai) minőséghez ugyan annyi (V)RAM kell a RotTR esetében a konzolokon is mint PC-n.

Ez SZVSZ teljes mértékben cáfolja a PC-s VRAM pazarló elméleted, amit te magad sem támasztotál alá soha semmi kézzel foghatóval...

Keldor papa: SZVSZ következő GeForce generáció még idén jön, a csúcs kártyákon GDDR6-al.

-

Loha

veterán

"32 GB-nyi HBM2 jelenleg 400 dollárba kerül minimum."

Pontosan ezt mondtam, hogy nem az a baj hogy kevés, hanem az hogy drága."Mit csinálsz mondjuk egy középkategóriás VGA-n, amire elég az 1024 bites busz?"

Nem teszel rá HBM-et, mert se a fogyasztással, se a sávszélességgel nem lesz gond, viszont a vásárlók árérzékenyek és szeretik a sok GB-ot.A 8GB konzolok a PC-s High textúrákat (~3GB) használják, míg a 12GB RAMmal felszerelt Xbox One X meg a PC-s Very High (~6GB) textúrákat. Ha a RotTR 1,2 GB-tal ellenne mint ahogy állítod, nem kellene hozzá az Xbox One X.

-

Loha

veterán

válasz

namaste

#33791

üzenetére

namaste

#33791

üzenetére

"Ha már vs, az AMD csinálja jól, nem számozza a GPU-kat, hanem neveket ad és 1. vonalbeli GPU-t küld a 3. vonalbeli ellen."

Szerintem kifejezetten korrekt dolog az NV-tól, hogy nem sumákolják el a GPU-k belső kódneveit, így a hozzáértő vásárlók pontosan tudhatják, hogy mit vesznek.

Abu85: "A HBM-mel egyébként az a problémája az NV-nek, hogy kevés memória építhető a GPU mellé."

A Quadro GV100 -on lévő 32GB HBM2 kevés?

SZVSZ játékra 8GB VRAM bőségesen elég lesz a következő konzolgenerációik (~2020), vagy akár tovább is. Attól függ mennyi RAMot kapnak az új konzolok.

A HBM-el az a gond, hogy nagyon megdrágítja a játékos kártyákat, miközben minimálisak az előnyei.

-

Loha

veterán

Multiplatform AAA játékoknál az eladások kb. 80%-a olyan platformokból származik, amikben nincs PCIe busz a GPU és a CPU között, és nem a leggyengébb láncszemhez igazítják a játékok fejlesztését, hanem a legtöbb bevételt hozó platformhoz, ami most a PS4.

Nem fogják az eladásaik 20%-a miatt lebutítani az összes többit.

Ha PC-re túl sok meló lenne portolni a PCIe busz miatt, akkor egyszerűen ki sem adják, és kész.

Az előző konzolgeneráció végén, ahol az elsődleges célplatform a Xbox 360 volt, több multiplatform AAA játék már meg sem jelent PS3-ra, mert túl sok lett volna vele a meló a PS3 nagyon eltérő felépítése miatt.

-

Loha

veterán

válasz

Carlos Padre

#33784

üzenetére

Carlos Padre

#33784

üzenetére

Úgy van ahogy írod, de a PS4 exkluzívok 10 milliós eladásait nem azért említettem, hogy konzol vs. PC vitát indítsak, hanem aki nem tudná mennyi az a 30 millió eladott PUBG Steamen, legyen mihez viszonyítania...

-

Loha

veterán

"És hogyan adsz ki egy olyan multiplatform játékot PC-n, ami mondjuk alkalmaz a PS4-en visszaírást a CPU memóriájába?"

Például lebutítod a játékot PC-re, amit simán megtennének, mert a PC sokadik fontosságú platform, a PC (vagy PCIe) miatt viszont nem fognak lebutítani semmit PS4-re.Ne keverd már bele a PC Gamingbe a GPGPU -t, meg HPC-t, ahol jóval nagyobb adathalmazokkal dolgoznak mint az egy VGA-n megtalálható VRAM mennyiség, ott ezért szükség is van a gyorsabb buszokra.

-

Loha

veterán

válasz

Puma K

#33776

üzenetére

Puma K

#33776

üzenetére

Köszi a javítást.

core i7: 2016-ban a GTX 1080 -nal gyakorlatilag hibahatáron belül volt a PCIe 2.0 a PCIe 3.0-lához képest: NVIDIA GeForce GTX 1080 PCI-Express Scaling

TTomax, Abu85: Az összes AAA multiplatform játéknál a sima PS4 továbbra is az elsődleges célplatform (az eladások miatt), ami nem használ PCIe buszt a GPU és a CPU között...

-

Loha

veterán

válasz

TTomax

#33769

üzenetére

TTomax

#33769

üzenetére

Mire használnád jobban a PCIe buszt?

PCIe 2.0 -án is 4k (valódi) 60fps-el futnak (csúcs VGA-kon) az elsődlegesen a PS4 APU-jára fejlesztett AAA játékok, úgy hogy nem a PCIe busz a szűk keresztmetszet, hanem a GPU...

PUBG -ből pl. több mint 30 milliót eladtak Steamen, miközben a PS4 -en a legjobban fogyó exkluzívok 10 millió körül járnak...

Sőt így is lehet nézni a dolgokat:

PC had more “good” exclusive & multi-platform games than any console in 2017Mielőtt nagyon belemennél ebbe a megsarcolós témába:

NV vonalon egy GTX 780(Ti)/970/1060(3GB) -al a PS4 grafikai szintjének megfelelő beállításokon tudod tolni a multiplatform játékokat 30fps helyett 60fps-el... -

Loha

veterán

válasz

TTomax

#33759

üzenetére

TTomax

#33759

üzenetére

A PCIe pont az igényeket követi, ezért tartunk még mindig a 3.0 -nál, mert nincs igény jobbra, kb. sehol nem korlátozó tényező a PCIe busz PC-n.

A PC Gaminget kb. 10 éve sokan temetik az AMD-vel egyetemben, ehhez képest minden eltelt évvel csak nagyobbra duzzad és egyre meghatározóbb lesz mint játékplatform. Az NV, meg a játékos kiegészítőket gyártó cégek temetés helyett, szarrá keresik magukat rajta...

-

Loha

veterán

válasz

huskydog17

#33658

üzenetére

huskydog17

#33658

üzenetére

Áh...

a Projects-es Nixxes linket akartam berakni:

a Projects-es Nixxes linket akartam berakni:

We're working on Rise of the Tomb Raider for PC -

Loha

veterán

válasz

huskydog17

#33651

üzenetére

huskydog17

#33651

üzenetére

Nixxes saját weboldalán is kint van:

We're working on Rise of the Tomb Raider for PCGyakorlatilag az eredeti Xbox One -os változatot csinálta a Crystal Dynamics, minden mást pedig a Nixxes.

-

Loha

veterán

válasz

cyberkind

#33517

üzenetére

cyberkind

#33517

üzenetére

GTA V -ben is le kellett butítani egy csomó proci igényes dolgot a GTA IV -hez képest: GTA IV is better than GTA V

Mert a jobb grafikához kell a jobb proci is, ha nem csak nagyobb felbontásról és több shader effektről van szó, a PS4 CPU -ja meg nem erősebb érdemben a PS3 Cell procijánál. -

Loha

veterán

válasz

Yutani

#33113

üzenetére

Yutani

#33113

üzenetére

Csak úgy csinál mintha nem értené, miközben összemos 2 nagyon különböző dolgot, de remekül működik...

Az Intel kedvezményeket adott és fizetett azért, hogy a DELL és egyéb OEM-ek egyáltalán ne építsenek AMD-re épülő rendszereket.

Az NV ezzel szemben most megtámogatná egyes gyártók játékos márkáit, de csak akkor, ha az alatt a márkanév alatt nem árulnak többé AMD-t, ami teljesen logikus és semmilyen törvényt nem sért.

Gondolj bele milyen vicces lenne, ha az NV elkezdené mondjuk az ASUS Strix VGA-kat promózni a weboldalán, miközben azok jelenleg épülhetnek AMD GPU-ra is.

-

Loha

veterán

válasz

Raymond

#31122

üzenetére

Raymond

#31122

üzenetére

Jól ráéreztél a szimpla procilimitre, aminek az oka nem is a játékmotor,

hanem a dupla DRM.

A Ghost Recon: Wildlands kb. ugyan az a motor mint Assassin's Creed Origins, azon csak Denuvo van, de nagyon hasonlóan viselkedik mint AC Origins, meg persze mint a Watch Dogs 2.

-

Loha

veterán

válasz

Raymond

#30902

üzenetére

Raymond

#30902

üzenetére

Szerintem az NV -nak nincs olyan nehéz dolga a TSMC-nél mert:

A TSMC-nél "épp zajlik egy nagy átalakítási folyamat, melynek során az ügyfélkör diverzifikálását végzik el, bővíteni akarják tevékenységi köreiket is, pl. beszállnak a mesterségesintelligencia-kutatásba és az autonóm járművek fejlesztésébe is."

Az NV ebben eléggé otthon van, tehát pont olyan gyártópartner akit a TSMC meg akarhat tartani."Emellett az is nagy kihívás elé állítja a TSMC-t, hogy a jelenlegi legnagyobb chipgyártó, a Samsung erőteljes terjeszkedési célokat tűzött ki maga elé: a következő öt évben meg akarják háromszorozni piaci részesedésüket a foundry üzletágban"

Azzal, hogy az NV már a Samsungnál is gyártat, jelzik hogy nincsenek a TSMC-re rászorulva, és bármikor elléphetnek a legnagyobb konkurenciához. -

Loha

veterán

Szokásosan Abu elfelejti beleírni a hozzászólásaiba, hogy SZVSZ meg szerinte, emiatt sokan tévesen azt hihetik, hogy tényeket közöl, pedig csak a saját véleményét tolmácsolja.

A waferek konkrét ára üzleti titkot, és csak az érintett cégek vezetése tudja hogy pontosan mennyi.

Az NV szerintem ezért gyártat a Samsungnál és a TSMC-nél is, mert egyrészt ez jobb alku pozíciót ad ár tárgyalásoknál, másrészt nagyon valószínű, hogy a Samsung gyártástechnológiája optimálisabb kisebb, alacsony fogyasztású (mobil) chipek esetén, a TSMC gyártástechnológiája pedig optimálisabb a nagyobb, nagy teljesítményű chipeknek.

GloFo 14nm FinFET gyártástechnológiáját a Samsungtól licencelte, tehát lényegében (valszeg árban is) megegyeznek. A Vega esetében SZVSZ láthatjuk is, hogy a GloFo gyártástechnológiája nem ideális csúcs GPU-k számára.

-

Loha

veterán

Pár dolog a GloFlo meg az AMD közötti szerződésből:

- Az AMD 100M USD-t fizet a GloFlonak egy év alatt azért, hogy mással is gyártathasson.

- Az AMD minden egyes mással gyártatott wafer után büntetést fizet a GloFlonak.

- Az AMD azért is büntetést fizet a GloFlonak, ha nem veszik meg az előre megbeszélt számú wafert.

Ha olyan jó biznisz lenne az AMD-nek a GloFlonál gyártatni, akkor ezekre megkötésekre semmi szükség nem lenne, de ezen büntik mellett az AMD-nek tényleg olcsóbb lehet a GloFlo-nál gyártatni, mint gyártatni a TSMC-nél és benyelni mellé a büntiket.

-

Loha

veterán

Csak az effektív órajel magasabb a GDDR5X esetében, amit az egy órajel alatt átvihető adatok duplázásával értek el, a tényleges órajel nem nőtt a sima GDDR5 -höz képest, tehát pl. a 6GHz-es GDDR5 és a 12GHz -es GDDR5X azonos tényleges órajelen mennek.

Petykemano: Kb. 5-6000 USD lehet most egy wafer 14-16nm -en, amire kb. 100db csúcs GPU fér el, de a nagy kérdés mindig az, hogy abból a ~100db -ból mennyi lesz használható, mert az az ami igazán meghatározza egy GPU előállítási költségét.

lezso6: Ha a GloFo jelentősen olcsóbb lenne a TSMC-nél, akkor mindenki ott akarna gyártani, de nincs így.

-

Loha

veterán

A Titánokon a Titan X (Maxwell) -ig bezárólag, a GPU felőli oldalon lévő GDDR5 chipeken voltak a hővezető padok meg a hűtőborda, a kártya hátulján lévő ugyan ilyen chipeken meg nem volt semmi, és a GDDR5 magasabb feszültségen megy mint a GDDR5X...

A Mercury Research régebben csinált VGA gyártási költség kalkulációkat, szerintem ezek most is jó kiinduló alapot képeznek az arányok tekintetében (kattra nagyobb lesz):

Első oszlop az akkori eladási átlagára a kártyáknak, az utolsó pedig a gyártási összköltség, közte pedig részletezve vannak a költségek.

-

Loha

veterán

Nem írtam le, mert nyák egy kis része csak a költségeknek, és a 384 bites nyákban semmi extra nincs.

Az AMD és az NV is használt már 512 bites nyákokat nem csillagászai áru kártyákon, és ha itt nyer vmit az AMD a HBM2 -nek köszönhetően, azt a Vega esetében a drágább 12 fázisú tápáramkörrel el is veszíti.GDDR5X meg valszeg nem is igényel hűtőbordát.

-

Loha

veterán

válasz

korcsi

#30865

üzenetére

korcsi

#30865

üzenetére

"Forrás?"

Na ez az a hozzáállás amiből jóval több kellene ebbe a topikba.

Egyébként az előállítási költségekről hivatalos adatot nem fog találni senki, ezért csak becsülni lehet:

Legdrágább összetevő maga a GPU, de azt a legkönnyebb megbecsülni is, mert hasonló méretű, hibátlan GPU-k gyártási költsége, hasonló gyártástechnológiával, nagyon hasonló lesz:

Vega 64: 484 mm² (hibátlan)

Vega 56: 484 mm² (kicsit hibás)TITAN Xp: 471 mm² (hibátlan)

1080 Ti: 471 mm² (kicsit hibás)Vegákat a HBM2 miatt drágább gyártani, mert míg az NV -nek egy GP102 -re épülő VGA legyártatás annyiból áll, hogy megkapják a TMSC -től a GPU-t, validálják, aztán továbbküldik a gyártó partnereknek akik ráforrasztják a nyákra a memóriákkal együtt, addig az AMD -nek 3 gyártót kel összehangolnia és többször validálnia, hogy elkészüljön egy Vega GPU + Interposer + HBM2 összeállítás, ami nyilvánvalóan drágább és bonyolultabb folyamat.

Ribi: Mi a baj az első pár mondatommal? Nem pontosan úgy van, ahogy írtam?

-

Loha

veterán

válasz

sakal83

#30839

üzenetére

sakal83

#30839

üzenetére

Az AMD a VGA -k Coca-Colája.

A Vegával nem csak egy VGA -t veszel, hanem egy életérzést is, mert hülye nem vagy, és bónuszként bekerülsz egy szűk, elit körbe.

Amikor játék közben olyan modern technológiák dolgoznak a gépedben mint a HBCC, na az az érzés megfizethetetlen.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Petykemano: A Vega előállítási költségei:

Vega 64: TITAN Xp+

Vega 56: 1080 Ti+ -

Loha

veterán

Szerintem a fő probléma az a DX12 -vel, hogy egy early access DirectXet kaptunk új shader model nélkül, ami példátlan a modern DirectXek történelmében, az már csak bónusz, hogy egy early access oprendszerhez is van kötve.

![;]](//cdn.rios.hu/dl/s/v1.gif) Szerintem a DX12 eredetileg most októberben jött volna, a shader model 6.0 -al együtt.

Szerintem a DX12 eredetileg most októberben jött volna, a shader model 6.0 -al együtt.(#30350) namaste:

Kepler tette lehetővé először azt, hogy az NV a középkategóriás kártyáját indítsa az AMD csúcskártyája ellen. Ez fordulópont volt, az AMD gyakorlatilag sarokba lett szorítva, nem csinálhatták a szokásos aláárazunk az NV -nak taktikájukat, mert a GTX 680 a jelentősen kisebb GPU miatt, olcsóbban gyártható kártya volt mint a HD7970. -

Loha

veterán

Igen azt gondolom, hogy az AMD rendszeresen elfelejt tanulni a saját maguk, és mások által elkövetett hibákból.

DX12 -re való átállás nem a GPU gyártóknak okoz nehézséget, hanem a játékfejlesztőknek, meg nyilván a motiváció is hiányzik...

A GCN akkor sem lett volna jó ötlet, ha az NV marad a Ferminél, mert egy 40 nm -ről 28 nm -re átültetett, feljavított Fermi v3 simán hozta volna a 7970 szintjét, csak éppen az AMD a GCN -el elveszítette azt a képességét, hogy kisebb hatékonyabb GPU -val hozza ugyan azt a grafikus teljesítményt mint az NV, és mivel az AMD marketingje is kb. arra épült, hogy olcsóbban adják ugyan azt mint az NV...

(#30332) namaste:

Az nagyon gázos, ha az "AMD is megoldhatta volna a többszálú DX11 drivert", és nem kényszerből mentek csak a Mantle irányába... -

Loha

veterán

Nem jósgömbje vagy szerencséje volt az Nvidiának a DX11-el, hanem tanultak korábban elkövetett hibáikból, és pénzük is volt megvalósítani a szükséges dolgokat.

Konkrét esetben az NV már Ferminél szembesült ugyan azokkal a problémákkal amivel most az AMD küszködik, és ennek tudatában módosították az architektúrájukat a Keplerre.

Az egyik kulcs mozzanat az volt, hogy Fermi hardveres ütemezőjét átültették a GPU-ból a driverbe, ami lehetővé tette azt a rugalmasságot, amivel alkalmazkodni tudtak a DX11 -hez, és ha eljön az ideje alkalmazkodni tudnak majd a DX12 -höz vagy bármilyen más API -hoz is.

Ehhez természetesen elengedhetetlen volt a sokmagos procik elterjedése és egy erős szoftveres csapat, de 2008 körül már egyértelműen látszott, hogy ezzel nem lesz probléma.

SZVSZ a legjobb videó a témában (angol):

AMD vs NV Drivers: A Brief History and Understanding Scheduling & CPU Overhead -

Loha

veterán

válasz

Raymond

#30204

üzenetére

Raymond

#30204

üzenetére

Szerintem remekül kielemezted.

SZVSZ Raja -t nem azért állítják félre mert a Vega nem lett elég jó (ez nem csak az ő sara, meg nem is meglepetés), hanem azért mert a Vega rajtját úgy időzítették, hogy meglovagolják a Threadripper sikeres rajtját (ezzel elrejtve a gyengeségeit), de ehelyett csak belepiszkítottak a Threadripper egyébként sikeres rajtjába, ami megbocsájthatatlan, és nem csak én gondolom így: Something Wrong At Radeon 25:53.

-

Loha

veterán

válasz

FLATRONW

#30171

üzenetére

FLATRONW

#30171

üzenetére

SZVSZ a BF1 irreálisan magas CPU terheléséhez jelentősen hozzájárul a játékon lévő Denuvo másolásvédelem (DRM), így fölösleges messzemenő következtetéseket levonni a BF1 alapján a DX11 / DX12 viszonyáról.

Szerintem semmi nem indokolja a BF1 jelentősen nagyobb CPU igényét a BF3/BF4-nél, és a BF1 Open Beta is lazán hozta min. fpsben a 60-at egy i5-2500k -n, mert azon még nem volt rajta a Denuvo.

A fejlesztők a Doomról utólag levették a Denuvot, így kaphatunk egy kis ízelítőt, hogy mennyivel növeli meg a CPU terhelését:

Doom szerintem nem egy prociigényes játék, főleg nem Vulkan alatt, mégis ebben a tesztben úgy néz ki, hogy procilimit van 1080p -ben az i7-5820k (6 mag / 12 szál) mellett, egy GTX 1060 6GB-al.

Sorolhatnék még pár játékot amiknél szintén irreálisan magas a proci használat, és véletlenül mind Denuvo védelemmel rendelkeznek...

-

Loha

veterán

DigitalFoundry-nak pont volt erről egy átfogó videója (angolul értőknek):

Why Next-Gen Consoles Need Ryzen CPU Technology! -

Loha

veterán

Oh elnézést, nem tudtam, hogy Abu85 kijelentése, miszerint az "AMD-t az önvezető autók piaca nem érdekli", csak és kizárólag a "vehicle-be rendelt vezérlés/hubok/linkek" -re vonatkozik, de az önvezető autókhoz kapcsolódó minden egyéb szegmens (ami nincs az autóba építve), nagyon is érdekli az AMD-t.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Loha

veterán

válasz

Callisto

#28174

üzenetére

Callisto

#28174

üzenetére

Nem csak a jövőbelátásai nem jönnek be, hanem rendszeresen félretájékoztat, az említett konkrét esetben is pl.:

(#28145) Abu85: Mert az AMD-t az önvezető autók piaca nem érdekli.

Kép közvetlenül az AMD friss ropogós Radeon Instinct weboldaláról:

Autonomous Vehicles magyarul önvezető járműveket jelent, és nyilván azokat a dolgokat sorolja fel az AMD, ami nem érdekli őket.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Loha

veterán

válasz

füles_

#28130

üzenetére

füles_

#28130

üzenetére

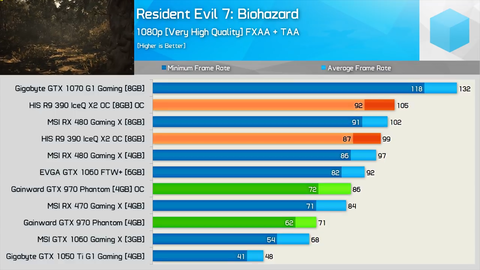

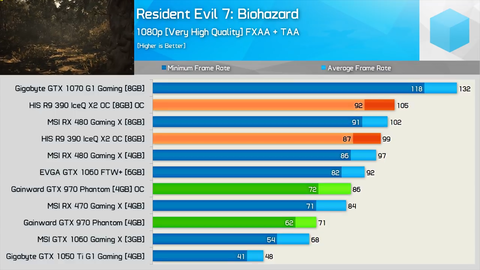

3 nappal korábban még elég volt a 3GB VRAM a GTX 1060 -on:

Kép innen: Radeon R9 390 vs. GeForce GTX 970: Still Worth Buying?

-

Loha

veterán

válasz

Laja333

#28112

üzenetére

Laja333

#28112

üzenetére

Nyilván: GTX 970 < GTX 980 érted?

A PH! szerint ~1,5 éve a R9 390 egy szinten volt a GTX 980 -al, most meg már a GTX 970 -el van csak egy szinten a Techspot szerint.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Ez az NV FineWhisky Technology...![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Loha

veterán

Nem lehet teljesen kiegyensúlyozott hardvert csinálni, mert játékonként változik, hogy mi számít kiegyensúlyozottnak, sőt beállításfüggő is. Pl. a Deus Exnek a Fury X is kiegyensúlyozott, más játéknak meg marhára nem. Egyébként NV-n nem kell kompenzálnod a gyenge setupot, a preempció meg VR...

-

Loha

veterán

Egyáltalán nem mind1 mit mutatnak a szintetikus tesztek, mer a Fury X esetében is nagyon jól látszik, hogy miért ilyen kiegyensúlyozatlan a teljesítménye, és az sem véletlen, hogy a Vega esetében az AMD nagyon ráerősít majd a geometria feldolgozásra is, több mint kétszeres gyorsulást ígérve.

Deus Ex Mankind Divided az Umbra middlewaret használja mint sok más játék a fölösleges geometria kivágására, a végeredmény pedig kevesebb számítandó poligon a GPU számára.

-

Loha

veterán

"Az új Hitman az élmezőnyben van a poligonszám tekintetében, egyedül a Deus Ex Mankind Divided dolgozik több poligonnal a jelenetekre levetítve."

Ha sok poligonnal dolgozna Deus Ex, akkor az az NV kártyáknak kedvezne, de pont az ellenkezője igaz, mert az AMD-nek kedvez, ami nyilvánvalóan azért van, mert kevés poligonnal dolgozik, de sok shaderrel.

Deus Ex tesztben,

Fury X előzi a 980Ti/1070-et,

miközben a Fury X sehol sincs poligonok tekintetében a 980 Ti-hez viszonyítva:

Viszont a Fury X előzi a 980 Ti -t shader teljesítményben:

Sőt nagyon közel van a 1080-hoz is.Tehát nem dolgozhat sok poligonnal a Deus Ex Mankind Divided, mert shader teljesítmény szerint rendeződnek a kártyák.

-

Loha

veterán

"GTX680 vs 7970 friss teszteket hirtelen nem tudok"

Én véletlenül tudok:

The Mighty HD 7970 Returns, GTX 1050 Ti & GTX 680 Battle!

(Gyorslinkek a különböző játékhoz ott vannak a videó leírásában.)SZVSZ a 7970 egyetlen előnye a 3GB VRAM,

és teljesen fölösleges ezen a 680 vs 7970 témán lovagolni,

mert sok év elteltével sincs semmi nagy fordulat a történetben... -

-

Loha

veterán

válasz

keIdor

#24910

üzenetére

keIdor

#24910

üzenetére

A DX szabvány beállítás: 3.

AMD-n Flip Queue Size (egy ideje nem elérhető a beállító panelben, de van rá okosság)

NV-n Maximum pre-rendered frames, magyarul: előre reprodukált képkockák maximális száma, 1-4 -ig lehet állítani.

Az ideális beállítás a PC-s fix 30 fpshez, kontrollerrel, NV-n:

Forza 3 -on nem feltétlenül segít, mert ott a gondot az UWP és a DX12 okozza, ahogy más játékoknál is, de a standard DX11-es játékoknál kontrollerrel kombinálva ez tökélestes konzol élményt ad.

60 fpses vsynchez ajánlott beállítás: 2.

-

Loha

veterán

válasz

Petykemano

#24211

üzenetére

Petykemano

#24211

üzenetére

A Bulldozer egyszálas teljesítményét nem csak a sok mag miatt áldozták be, hanem a magas órajel elérése miatt is, ugyan úgy mint az Intel a P4 esetében, megnyújtották a CPU futószalagok hosszát 12 -ről 20 fölé.

Ez annak tükrében, hogy 2006 körül álltak neki a tervezésnek, és az orruk előtt bukott el a 2004-ben megjelent Hyper-threadinges P4 Prescott és váltotta le a Core 2, elég hülye döntésnek tűnik. -

Loha

veterán

A DX9 a WinXP-vel jött 2001-ben és az első nagyobb játék ami már nem támogatta a BF3 volt 2011-ben, de pl. 2012-ben megejelent Far Cry 3 is DX9-re készült elsősorban, és csak másodlagosan volt benne a DX11-es támogatás.

Tehát kb. 10 évig volt a fő PC-s API a DX9, köszönhetően az Xbox 360-nak és az WinXP-nek is. DX10 említésre sem érdemes a Vista bukása miatt.A DX11 2009-ben jött a Win7 -el, 2012-13 -ban még rengeteg tartalék volt az API-ban, amit csak az új konzolgeneráció megjelenése után (2013) kezdték el kiaknázni, mert addig a konzolok DX9-es tudásszinten voltak, tehát egyáltalán nem volt időszerű 2012-13 környékén kihozni a DX11 utódját.

A DX11 még 2-3 évig simán marad mint fő PC-s API, ami mily meglepetés, pont ugyan úgy kb. 10 éves pályafutást jelent mint a DX9 esetében.

Mire a DX11-et mint fő PC-s API-t leváltja az utódja (ami nem a most ismert DX12 lesz, hanem egy újabb DX verzió, új shader modellel), addigra az AMD teljesen lecseréli a GCN-t. -

Loha

veterán

Nem járt jó úton az AMD, nem volt logikus amit csináltak, tudhatták előre, hogy a DX11 sokáig marad, ahogy előtte a DX9 is, meg a nem is a DX11 probléma, hanem a GCN. Az NV nem vár az MS-ra vagy játékfejlesztőkre, olyan újításokat hoznak, amihez nem kell harmadik fél, mint pl. a DCC, GPU Boost, vagy a Tile Based Rasterization a Maxwellnél.

-

Loha

veterán

Nem volt túltervezve a Fermi, csak egyszerre akartak jó teljesítményt általános számításokban és grafikában is. Csak a teljesítményre koncentráltak és nem figyeltek a hatékonyságra.

Az AMD akkori csak grafikára kihegyezett GPUi ellen ez hosszú távon nem volt versenyképes, ezt akkor ott az NV-nál felismerték és változtattak, ebből lett a Kepler, miközben az AMD meg nekiállt a "Fermi 2" -nek konkurenciát tervezni, ebből lett a GCN, mert nem ismerték fel az AMD-nél, hogy pont a jó úton jártak addig...

-

Loha

veterán

Az Intelnél a Pentium 4 idejében rájöttek, hogy az IPC -t semmiért sem szabad beáldozni, dobták is architektúrát teljesen...

Nvidiánál az első Ferminél már rájöttek, hogy a fogyasztás fogja limitálni a jövőben a teljesítményt, és a Keplernél már arra gyúrtak...

Az AMD meg mit csinált mindeközben?

-

Loha

veterán

válasz

lezso6

#23792

üzenetére

lezso6

#23792

üzenetére

NV-n nagyon pontosan monitorozható a fogyasztás a max. TDP %-ában, csak azt kell tudni hozzá, hogy mennyi a 100%, ami érték megtalálható a kártya BIOS-ában. Arra való egyébként, hogy 100%-nál elkezdi elvenni a boost órajeleket a kártya, hogy ne füstöljön el rajta a VRM.

Intel prociknál ha max TDP közelébe akarsz menni, ahhoz többszálú AVX kódra lesz szükséged.

-

Loha

veterán

válasz

Malibutomi

#22574

üzenetére

Malibutomi

#22574

üzenetére

Kár, pedig érdekelne, hogy melyik játéknál lett volna érdemes az NV driver csapatának odatennie magát...

-

Loha

veterán

válasz

Malibutomi

#22558

üzenetére

Malibutomi

#22558

üzenetére

AMD által szponzorált játék ≠ DX12

Melyik DX12-es AMD-s játékra gondolsz? Ha a Deus Exre, akkor ott sokféle eredmények kijöttek.

Eddig nem igazán volt olyan DX12-es AMD-s játék, amire az NV driver csapatának érdemes lett volna rágyúrnia...

-

Loha

veterán

válasz

Malibutomi

#22549

üzenetére

Malibutomi

#22549

üzenetére

Az nem mantra volt amit írsz, hanem a gyakorlati tapasztalat, és ez most sem változott.

Mantra az az volt, hogy a teljesen kikapcsolható GameWorksszel az NV direkt elrontja a játékokat elsősorban AMD-n, bezzeg a Gaming Evolvedes játékok milyen jól mennek minden VGA-n.![;]](//cdn.rios.hu/dl/s/v1.gif)

Az utóbbi idők AMD-s játékai jobban fekszenek az AMD-nek, DX11-alatt is. -

Loha

veterán

válasz

Malibutomi

#22538

üzenetére

Malibutomi

#22538

üzenetére

Egy kivételével az összes DX12-es játék AMD-s.

-

Loha

veterán

válasz

velizare

#21349

üzenetére

velizare

#21349

üzenetére

A pin2-őn opcionális a 12V mint az ábrán is látható, a sense pinek helyett ground nem opció.

Itt a videóban látható, hogy az AMD korábbi ref. kártyáin szabványosan oldotta meg a dolgot.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- exHWSW - Értünk mindenhez IS

- Android alkalmazások - szoftver kibeszélő topik

- League of Legends

- E-roller topik

- LEGO klub

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- Házi barkács, gányolás, tákolás, megdöbbentő gépek!

- Autós topik

- AMD vs. INTEL vs. NVIDIA

- Pánik a memóriapiacon

- További aktív témák...

- AKCIÓ! LENOVO ThinkPad P15 Gen2 munkaállomás - i7 11800H 32GB DDR4 1TB SSD RTX A2000 4GB W

- BESZÁMÍTÁS! MSI B760 i7 12700K 64GB DDR4 512GB SSD RX 7800XT 16GB Zalman S2 TG GIGABYTE 750W

- Részletfizetés. BankMentes. Kamatmentes. Új noblechairs EPIC műbőr FEKETE - FEKETE. 3 év garancia!

- iking.hu Apple iPhone 14 128GB Midnight használt 100% akku 6 hónap garancia

- ASTRO A50 WIRELESS HEADSET + BASE STATION 4th gen. fejhallgató

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

, hát ez nem sejtet semmi jót a jövőre nézve...

, hát ez nem sejtet semmi jót a jövőre nézve...

a Projects-es Nixxes linket akartam berakni:

a Projects-es Nixxes linket akartam berakni: