-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

joker1220

őstag

válasz

TESCO-Zsömle

#4399

üzenetére

TESCO-Zsömle

#4399

üzenetére

Jelenleg elvisz

De az újabb játékokkal már nem biztos hogy elmenne

Van bringa de sajnos 'alaplap' hibás

-

TESCO-Zsömle

titán

válasz

joker1220

#4398

üzenetére

joker1220

#4398

üzenetére

a leptop elvisz mindent amivel játszom...

Akkor minek? Ha elvisz mindent, és meg is vagy elégedve azzal, amit kapsz, nincs értelme asztalit venni.

Esetleg lecserélheted majd egy másik v harmadik generációs Fusion- Laptopra hybrid CF-el.

Vagy vegyél inkább biciklit és járj azzal.

-

joker1220

őstag

válasz

TESCO-Zsömle

#4397

üzenetére

TESCO-Zsömle

#4397

üzenetére

Én meg azt a configot adtam el amit az adatlapomon látsz, nekem sem

volt semmi gondom vele, csak szükségem lett egy leptop ra ezért

el kellett adni....Viszont itt már az is a kérdés hogy érdemes e nekem újra asztali,

mert a leptop elvisz mindent amivel játszom...i5 2410M 2,3Ghz - 4Gb 1333Mhz Cl9 ram - Geforce GT540M 1Gb

Szerinted van értelme várni és mondjuk egy év múlva venni egy új asztalit?!

-

-

joker1220

őstag

válasz

TESCO-Zsömle

#4395

üzenetére

TESCO-Zsömle

#4395

üzenetére

Kezdek beleőrülni az AMD be, viccen kívül,

nemrég adtam el az asztalimat, épp azért

mert jön az új generáció...Ha az új Radeon okkal is azt csinálják mint

a Bullal hogy húzzák vonják halasztják

hónapokon keresztül akkor beadom a kulcsot

az tuti.Egyáltalán merjek belevágni az am3+ ba.

Minden rev.1 es, teljesen kiforratlan, most

rákölteni egy valag pénzt aztán kiderül

valami hardverhiba:SPhenom II nél is volt három stepping,

mire kiforrott teljesen:SLehet hogy inkább nem veszek semmit

jövő tavaszig, addigra már lesz bőven

teszt meg stb, VGA kkal szerintem

ugyanez a helyzet. -

BotaN

senior tag

válasz

joker1220

#4393

üzenetére

joker1220

#4393

üzenetére

Azért addig még kell várni rendesen, szerintem ha most akarsz venni akkor vegyél. Ha meg kijön az új gen, jönnek a tesztek és tetszeni fog, akkor eladod amit vettél és ráfizetsz egy újra.

Szerintem felesleges fél évet várni, mivel szerintem 2012 Március előtt tuti nem fogsz itthon kapni újat, sőt!

-

joker1220

őstag

Sziasztok!

Érdemes itt a nagy generáció váltás előtt bármilyen VGA-t is venni Radeon vonalon?!

Már csak azért kérdem mert az új sorozat valószínűleg szépen lenyomja majd

a jelenlegi árakat, legalábbis szerintem

-

BotaN

senior tag

válasz

TESCO-Zsömle

#4391

üzenetére

TESCO-Zsömle

#4391

üzenetére

Egyszer lecseng majd úgyis ez a nagy tablet/netbook őrület, majd jön helyette valami más. Azt viszont számomra elég szomorú hogy megéltük azt a kort mikor egy új gpu generáció először mobil eszközökbe jelenik meg, az asztali szegmensnek meg várni kell.

-

TESCO-Zsömle

titán

válasz

Angel1981

#4390

üzenetére

Angel1981

#4390

üzenetére

Asztalinál meg be kell nyomni a TimeShift funkciót, és 'kifutó' platformokat vásárolni, ha jól akarsz járni...

Amúgy is van most egy ilyen "1080p-re minek?" érzésem az új cuccokkal kapcsolatban... Ha elfogy a VGA, dobok mellé egy tesót 40-ért, mert kb annyit fog érni...

Most van egy hd6950-esem unlockolva, tuningolva, szóval technikailag ott van, mint egy alap HD7870-es. Ehhez jön egy csini 250W-os fogyasztás, míg az utóbbi eszik 120W-ott...

Ez a nem mindegy...

Én megértem a mobil platform terjedését. Mindenki rohan és egy rohanó világban béklyó egy ilyen helyhez kötött gép. Játszani ott a konzol, ami alig nagyobb egy ITX-es HTPC-nél, és sokkal kedvezőbbek a fizetési feltételek is.

Arra van igény, amire teremtenek... Az iPad előtt csak egy jelentéktelen kisebbségnek volt igénye tabletekre, most meg boldog-boldogtalan ilyenre csorgatja a nyálát, még akkor is ha semmi szüksége rá...

Tisztelet a kivételnek, Ők vannak kisebbségben... -

Angel1981

veterán

válasz

TESCO-Zsömle

#4389

üzenetére

TESCO-Zsömle

#4389

üzenetére

Illetve az, hogy egyértelműen látszik, hogy már a mobil piac a fő szegmens, az asztali megoldások egyre inkább háttérbe lesznek szorítva, pedig szerintem még egy jó ideig nagyobb lesz rájuk az igény, mint ahogy a médiában, illetve a gyártókon keresztül be van állítva

-

radi8tor

MODERÁTOR

válasz

TESCO-Zsömle

#4380

üzenetére

TESCO-Zsömle

#4380

üzenetére

Ezért gondolkozom én is a váltáson (majd). Nekem 260W mínuszt jelentene.

-

BotaN

senior tag

válasz

TESCO-Zsömle

#4380

üzenetére

TESCO-Zsömle

#4380

üzenetére

Jól hangzik, azért 130W TDP mínusz az már a nem mind1 kategória.

-

BotaN

senior tag

válasz

TESCO-Zsömle

#4376

üzenetére

TESCO-Zsömle

#4376

üzenetére

Az se lesz rossz vétel, persze ha jó lesz az ára, mert a 6970 kiszolgál mindent és ha csökken a csíkszélesség, akkor még hűvösebb is lehet az egész.

-

Def26

félisten

-

Def26

félisten

ipon. Nem tudom volt e már.

-

gyiku

nagyúr

válasz

TESCO-Zsömle

#4366

üzenetére

TESCO-Zsömle

#4366

üzenetére

190w tdp-vel nem piskota. csak lesz vmi kis finom passziv 7770/7850

-

TESCO-Zsömle

titán

válasz

ViiiiktorOC

#4365

üzenetére

ViiiiktorOC

#4365

üzenetére

Érdekes.

AMD is referring to as "CoreNext Architecture", which is expected to boost performance per square millimeter die area beyond even what VLIW4 manages.

Akkor így nem is olyan elképzelhetetlen az a 190W, főleg ha figyelembe vesszük az XDR2 kedvező fogyasztását...

Még nézni is brutál... 1GHz GPU, 8GHz Ram...

-

ViiiiktorOC

senior tag

Lehet hogy mégis XDR2 lesz benne?

TPU! -

tudod, az a gond az "AMD-től azt hallottam" dolgokkal, hogy ők is úgy hazudnak, ahogy éppen kedvük van. ha még emlékszel, a 4770-ről az utolsó pillanatig az ment, hogy 8 ROP lesz benne, mert további 4 alig jelentene extra teljesítményt - erre aztán 16-tal érkezett. nem kételkedem az AMD-s mérnökök szakértelmében, de épp elég nagyvállalatot láttam akcióban már ahhoz, hogy tudjam, mennyire képesek háttérbe szorulni a mérnöki szempontok.

a gyenge dispatch azért furcsa, mert a 6970 nagyon jól teljesít a Heavenben még normál tesszelációs beállítás mellett is, ott pedig kell az ilyen irányú kapacitás. viszont azt kiválóan sikerült kimérnem, hogy a szerencsétlen chip az esetek nagy részében a ROP-ok miatt megy falnak - és btw. 1 setup művelethez nem feltétlen 1 pixelművelet tartozik. szerintem még alá is becsültem azzal, hogy a duplaannyi ROP 25%-os sebességnövekedést hozna - csak azért voltam vele óvatos, mert azt nem tudom, hogy a memória-sávszélesség hol kezdene durván elfogyni.

persze, abból a chipből csak úgy lenne 6990, ahogy a GF100-ból GTX590 - csak kérdés, hogy lenne-e rá bármi szükség.a fusion összefoglaló nagyon érdekes - köszi!

-

TESCO-Zsömle

titán

válasz

Angel1981

#4362

üzenetére

Angel1981

#4362

üzenetére

Nem hiszem.

Eleve ott kezdődik a dolog, hogy a Trinity már Bull magokat kap a GPU mellé.

Gondolom ugyanúgy lesz a skálázás, mint most. Ahol az APU leteszi a fonalat CPU-teljesítményben, ott, vagy alatta kicsivel veszi fel a CPU. Nyilvánvaló, hogy a 40%-os átlapolás ellenére se lehet egy 125W TDP-jű APU olyan erős CPU-ban, mint egy ugyanennyi TDP-jű CPU.

-

Angel1981

veterán

"A Trinity utáni lépcső a durva fúzió. A harmadik lépcsőben közös címteret és teljesen koherens memóriát kap a CPU és a GPU, továbbá a GPU kezelheti az x86 virtuális memóriát CPU pointereken keresztül. Ezt hívja az AMD architekturális integrálásnak."

Ennél a generációnál várható már, hogy a felső kategóriás processzorok ("Next Generation Bulldozer") is megkapják a GPU magokat?

-

Abu85

HÁZIGAZDA

Nem feltétlenül lett volna 25%-kal gyorsabb. Az AMD-től már hallottam, hogy a Cayman a dispatch részen gyenge, ezt a motort egy az egyben a Bartstól kapta meg, csak az már nem elég jó. A 64 ROP-ból jó ha 10%-ot nyernek. Többre nincs lehetőség. Ráadásul a rendszer is asszimetrikus lenne, mert a setup motor nem képes 32 pixelnél többre. Az extrákkal pedig szimplán kivitelezhetetlen lett volna a HD 6990. Vissza kellett volna venni az órajelet, és akkor a GTX 590 elverte volna, bár ez nem biztos, de sanszos lenne. Most viszont a HD 6990 a leggyorsabb rendszer. Tudják azok a mérnökök, hogy mit csinálnak, hiszen mind az asztali, mind pedig a mobil piacon egy Radeon a leggyorsabb.

Ez a fúzió következő nagy állomása. Az AMD három lépcsőre osztja az egészet. Az elsőt már ismerjük a Llanoval. Egy CPU és egy GPU egy lapkában, egy nagyon alacsony késleltetésű, és gyors busszal összekötve (Onion busz). Ez valószínűleg azért alakult így, mert az aktuális programokat CPU+VGA feldolgozásra írják, és nem lenne célszerű ennél többet csinálni. A Sandy Bridge erre jó példa, mert az Intel ennél továbbment azzal, hogy az IGP ír az L3-ba, de az inkább cache-szemetelés, mint jól kezelt fícsőr, amire az AMD gyártja is az összehasonlító videókat. [link] - Ez az egyik, de mindegyikben ugyanazt a koncepciós hibát használják fel, vagyis azt, hogy a Sandy Bridge IGP-je következmény nélkül piszkíthat 1,5 (HD Graphics 2000) vagy 3 (HD Graphics 3000) MB-ot az L3-ba, ezzel a procikat cache-missbe taszítja, és mehetnek a rendszermemóriához az adatért. Az egész azért súlyos, mert az adatok L3-ba való újratöltése után semmi sem garantálja, hogy a következő órajelben már nem barmol oda az IGP. Az egész egy konkrétan futtatott programnál kezelhető, mert az Intel a grafikus driverben szépen profilozza be a játékokat, és kapcsolgatja ki az IGP L3 írási funkcióját, ahol ez gond, de több program mellett ez nem kezelhető ilyen simán. Elég egy olyan program, ahol az IGP írhat az L3-ba, és már érezhetően megbomlik az egész rendszer hatékony működése. Az AMD a videóban a "biztonság kedvéért" (

![;]](//cdn.rios.hu/dl/s/v1.gif) ) két 3D-s programot is bevetett, hogy az IGP 6 MB-os területet barmoljon szét az L3-ban, ez konkrétan ugye az aktuális proci teljes kapacitása, így nem csoda, hogy a rendszer ennyire meghalt. Ha most csinálnák meg ugyanezt, akkor már kisebb lenne a hatás, mert az Intel már tiltja az L3 írás arra a Final Fantasy benchmarkra, így a videó elején mutatott másodperces akadások is megszűntek. Persze a sebesség kisebb, de a futás úgymond egyenletes. Ilyet még az NV rendezvényén láttam a Dead Rising alatt, amikor Igor játszott rajta, és az klotyóajtó 3 másodperc múlva nyílt ki, addig teljesen lemerevedett a kép. Azóta (áprilisi driver) ebben a játékban is tiltva van az L3 írás, így nincsenek akadások, csak folyamatosan 20 alatt az fps. Jó amúgy ez az írós koncepció, mert kétségtelen, hogy erre szükség van a hatékony CPU+GPU feldolgozáshoz, de jelenleg nulla program van erre felkészítve, és ez így lutri, mert vagy jól működik, vagy nem. Na de elkalandoztunk a tárgytól.

) két 3D-s programot is bevetett, hogy az IGP 6 MB-os területet barmoljon szét az L3-ban, ez konkrétan ugye az aktuális proci teljes kapacitása, így nem csoda, hogy a rendszer ennyire meghalt. Ha most csinálnák meg ugyanezt, akkor már kisebb lenne a hatás, mert az Intel már tiltja az L3 írás arra a Final Fantasy benchmarkra, így a videó elején mutatott másodperces akadások is megszűntek. Persze a sebesség kisebb, de a futás úgymond egyenletes. Ilyet még az NV rendezvényén láttam a Dead Rising alatt, amikor Igor játszott rajta, és az klotyóajtó 3 másodperc múlva nyílt ki, addig teljesen lemerevedett a kép. Azóta (áprilisi driver) ebben a játékban is tiltva van az L3 írás, így nincsenek akadások, csak folyamatosan 20 alatt az fps. Jó amúgy ez az írós koncepció, mert kétségtelen, hogy erre szükség van a hatékony CPU+GPU feldolgozáshoz, de jelenleg nulla program van erre felkészítve, és ez így lutri, mert vagy jól működik, vagy nem. Na de elkalandoztunk a tárgytól.

A következő fúziós lépcső a Trinity. Ez a lapka már majdnem kész, volt is belőle demó, így sokat lehet róla tudni. A működésben nagyon hasonlít a Llanora, vagyis az AMD továbbra is az Onion buszos összeköttetést tartja jónak, a programokra és a fentiekre való tekintettel. Annyi lesz a különbség, hogy a GPU része a rendszernek képes lesz több, teljesen független utasításfolyam párhuzamos futtatására. Ezzel például több OpenCL-es program is futhat egy időben. Szintén megjelenik a GPU C++ támogatása. Bár nem programozástechnikai dolog, de megváltozik az energiamenedzsment. A Llano esetén eléggé kimért a dolog, vagyis kvázi fix fogyasztása van a procimagoknak és a GPU résznek. A Trinitynél ez átlapolható, vagyis a proci durván turbózhat, ha arra van szükség, és akkor a GPU-rész alacsony órajelű módba kapcsol. Fordítva is előfordulhat persze, ha nagy GPU-erőre van szükség, ilyenkor a proci rész gazdálkodik. Úgy tudom a GTC-s rendezvényről, hogy alapértelmezetten 30%-os fogyasztásátlapolás lehetséges, de az egész módosítható lesz a Catalystból +/-10%-os irányban, vagy akár manuálisan vezérelhető, ezt mondjuk csak az expert felhasználóknak javasolja az AMD. A manuális rész persze picit gázos, mert nyilván ez a százalékos játék nem következményektől mentes. A lapka teljes fogyasztása fix, ha mondjuk +40%-ot power budgetet adsz a GPU-nak, akkor azt elveszi a procirésztől. Nyilván a manuális kontroll állandó hatás, vagyis jól kell ismerni az alkalmazást. Persze a legtöbb felhasználó úgyis az automatikus kontrollon hagyja, akkor pedig a hardver dönt a menedzsmentről. Szvsz az a legjobb.

A Trinity utáni lépcső a durva fúzió. Eddig csak nyalogattuk a heterogén feldolgozást, amire valóban van lehetőség a Fusion lapkákban, de az egész korlátozott. A harmadik lépcsőben közös címteret és teljesen koherens memóriát kap a CPU és a GPU, továbbá a GPU kezelheti az x86 virtuális memóriát CPU pointereken keresztül. Ezt hívja az AMD architekturális integrálásnak. A chip kódneve nem ismert, de nyilván ez a következő állomás a Trinity után. Valószínűleg ez a lépcső két lapkát is eredményez, mivel a 16 nm messze van, így addig belefér egy upgrade, jelentsen az bármit is. A heterogén éra utolsó lépcsője, vagy mondjuk úgy kiteljesedése pedig az AMD szemében rendszerszintű integráció. Erről még nagyon kevés adat van, és ez még nekem sem teljesen világos, de amolyan Cell-szerűvé vállnak majd a chipek, az előny, hogy logikai szinten eltűnik a különbség a CPU és a GPU között. Az AMD-nél ennek az előjele a Bulldozer modulos felépítése, nyilván ez az architektúra az elkövetkező 5-7 évet meghatározza az AMD-nél, hiszen mindent alárendeltek az alapok fejlesztésénél a Fusion terveknek.A Kaigai blog előrejelzéseiből az Intel is ugyanezt az utat járja be, némi eltéréssel. Nekik ugye az első APU-juk az Ivy Bridge, ami folytatja a Sandy L3 írást, remélhetőleg jobb felügyelet mellett. A következő chip a Haswell, ami szintén erősít a CPU és a GPU kapcsolatán, de inkább a CPU fejlesztését helyezi előtérbe, ellentétben az AMD filozófiájával. Ugye itt az AVX2, mint újdonság, ami előnyt jelenthet. Nyilván a tick-tock miatt lesz egy szokásos upgrade, illetve az úgynevezett, vagy AMD-nél látható architekturális integrálás lépcsője nem igazán valósul meg. Majd végül, nagyjából hasonló időben (pontos időpont nincs, de mindkét cégnél úgy 2015-2016-ot jelent ez) az Intel is eljut rendszerszintű integrációhoz, ami a náluk annyit jelent, hogy a Larrabee-szerű magok beköltöznek a prociba a főmagok mellé. Ez is amolyan Cell-szerű minta. Itt is eltűnik a logikai különbség a CPU és a GPU között. Már ha a Larrabee magokat valaha is GPU-nak tekintettük.

Az NVIDIA esetében nincs ilyen előrejelzés, de az irányt nem nehéz kitalálni. Náluk a Tegra 4 lesz az első APU. Az I/O koherencia a CPU és GPU között biztosítható, ha felhasználják az ARM MMU-400 buszát (ez ugye a miért ne eset, mert hát csak egy licenc kérdése az egész

- persze biztosat nem lehet tudni). Ezzel 2012-ben ez lenne a legmodernebb chip az APU integrációt tekintve. A következő lépcső náluk a project denver, és nagyjából ugyanazt az utat járják, amit az AMD időbeli lépcsője, vagyis közös címtét és teljesen koherens memória a CPU és a GPU között, illetve a GPU kezelheti az virtuális memóriát. Itt ugye az x86 hiányában az ARM-ra kell építeni. Ennél tovább nem teljesen ismertek az NV lépései. Annyit tudunk, hogy a fejlesztéseknél a GPU dominál, vagyis az Intellel és az AMD-vel ellentétben minden egyes lapkában a CPU kapja a háttérszerepet. Az Intelnél ugye a CPU-é a főszerep, míg az AMD egyensúlyozni próbál, hogy mi lehet a valós alkalmazások szempontjából az ideális elosztás.

- persze biztosat nem lehet tudni). Ezzel 2012-ben ez lenne a legmodernebb chip az APU integrációt tekintve. A következő lépcső náluk a project denver, és nagyjából ugyanazt az utat járják, amit az AMD időbeli lépcsője, vagyis közös címtét és teljesen koherens memória a CPU és a GPU között, illetve a GPU kezelheti az virtuális memóriát. Itt ugye az x86 hiányában az ARM-ra kell építeni. Ennél tovább nem teljesen ismertek az NV lépései. Annyit tudunk, hogy a fejlesztéseknél a GPU dominál, vagyis az Intellel és az AMD-vel ellentétben minden egyes lapkában a CPU kapja a háttérszerepet. Az Intelnél ugye a CPU-é a főszerep, míg az AMD egyensúlyozni próbál, hogy mi lehet a valós alkalmazások szempontjából az ideális elosztás. -

Z10N

veterán

Carmack-nek mindig is nagy otletei voltak. De a legfobb amit mindig is tiszteltem benne az a hardver teljes kiakanazasa (jelenleg: xbox360, dx9, rage gepigenye). Tekintve azt, hogy az AMD is hozzajarul ennek optimalizalasahoz ezekkel a textura/memoria eleresi rutinokkal egyre jobban bizok a Fusion APU-ba a dGPU-kkal szemben. Masik tema: ezekszerint nem is lesz HD7400, illetve nekem nagyon gyanus a HD7600 es HD7500 kozeli teljesitmenye. Avagy ebbol is latszik, hogy tomoriteni akarjak az also szegmenst.

-

oh yes. és vajon mennyiért lehetett volna eladni egy 25%-kal gyorsabb kajmánt? mondjuk 600 USD-ért?

a powertune-nal meg az a szerencséjük, hogy ezeket a kártyákat főleg rekorddöntögetésre használják a tulajdonosaik, mert ez az órajelrángatós megoldás egyes játékokban valami borzalom.a texture streaminghez egy jó prediktív algoritmus kell, és akkor mindjárt throughput terhelés lesz belőle. legalábbis az esetek 90%-ában, de ezt jelen pillanatban elfogadja a piac. ha ez hirtelen változna, az mondjuk ciki

a többivel egyetértek, csak az a gond, hogy nem látom a nagy képnek azt a részét, ahol diszkrét eszközt illesztes a rendszerbe - hogyan adsz neki megfelelő natív access-t a rendszermemóriához? -

Abu85

HÁZIGAZDA

Mert a ROP nincs ingyen a tranzisztorszámban, és a fogyasztásban sem. Egy dolgot kell nagyon észrevenni. A 300 dollár fölötti termékek eladása a teljes VGA-piacon 2% alatt van. Ide nem kell két terméknél több. Ha több van az nem jó, mert a 2% az nem sok. Kell egy 400 dollár alá, és egy 600 dolláros. Ez az ideális felállás. A költséghatékonyság sokkal fontosabb a piac jelenlegi viszonyát tekintve. Nem mellesleg a Cayman esetében kettőt kellett benyomni 300 watt alá. Ehhez használni kellett a PowerTune-t, de -20%-on ez sikerült. 64 blendinggel ez nem ment volna.

A texture streaminget ne felejtsd el. Az nem olyan terhelő, mint a megatexture, de rengeteg motorban ott van. Szintén kell a proci hozzá, és eléggé problémás dGPU-val. Persze nélküle még problémásabb lenne, de ezen is lehetne csavarni. A PRT ide is jó, persze itt megint a Fusion nyeri a legtöbbet a rendszermemória közvetlen elérése miatt. Ugyanakkor a dGPU-kon is segít, ha teljesen hardveres lenne a texture streaming.

Ezeknek egyébként a legnagyobb hátráltató tényezője, hogy az AMD támogathatja az x86 virtuális memóriát, míg az NVIDIA a licenc hiányában nem. Megoldják persze a támogatást I/O virtualizációval, csak ez már annyit jelent, hogy a nem egy, hanem két algoritmus kell. Aztán az NV-hez olyan platform is kell, ami IOMMU, vagy VT-d kompatibilis.

Én úgy gondolom, hogy ha valamit is akarunk még a PC-vel, akkor ki kell gyilkolni az API korlátjait. Össze kellene fogni a gyártóknak, és létrehozni egy közös architektúrát, ami a kritikus helyeken megegyezően működik, azaz natívan programozható. Ha ez nem történik meg, akkor szegmentált lesz a PC-s játékpiac. Esetleg ez akkor kerülhető el, ha az összes konzolba egy gyártótól kerülne GPU, de akkor sem lennénk kisegítve, mert akkor meg verseny nem lenne.

Én az összefogásra és a közös alapokra szavazok, legalább a kritikus részeket tekintve. -

hát sorry, de ez nem volt valami meggyőző

ha a +32 ROP-ot csak így lazán bele lehetne hajítani a chipbe, akkor miért nem tették bele a Caymanbe? szegény GTX580 csak pislogott volna, hol van előtte a konkurencia, és még úgy is kisebb lett volna az AMD megoldása.

ha a +32 ROP-ot csak így lazán bele lehetne hajítani a chipbe, akkor miért nem tették bele a Caymanbe? szegény GTX580 csak pislogott volna, hol van előtte a konkurencia, és még úgy is kisebb lett volna az AMD megoldása.

szóval persze, spórolunk a 256-bites busszal, de ha tényleg 64 ROP lesz az új architektúrában, akkor annak a negyede tuti felesleges lesz, és az is költség.a példa a megatextúrázásról pedig jó is, meg nem is. azt kitűnően bebizonyítottad vele, hogy a nem fix pipeline-os motorokhoz (népszerűbb nevükön szoftver rendererekhez) problémás ez a diszkrét GPU-s megoldás, mert egy rakás mesterséges korlátot támaszt - de jelen pillanatban nem sok olyan effekt van, ami annyira meghágja a raszterizációs pipeline-t, mint a megatexture. ehhez pedig kissé luxus HW-t fejleszteni, különösen, ha tekintetbe vesszük, hogy az id-nek mekkora sikere volt az utóbbi években a kommerciális motorok piacán.

persze ne érts félre, már jó ideje kívánom a raszterizációs cső halálát, csak éppen abban nem hiszek, hogy ezt így lépésről lépésre lehet csinálni. valakinek kellene lépni egy nagyot, aztán már mehetne is a lavina...

-

TESCO-Zsömle

titán

válasz

Angel1981

#4352

üzenetére

Angel1981

#4352

üzenetére

Akkor talán leszögezhetted volna az elején a szempontjaidat.

Azt, hogy ezek a cGPU-k mennyire jó hatásfokkal végzik a grafikus megjelenítést, csak a tesztekből tudjuk meg. Egyenlőre annyit tudunk, hogy az nVidia cGPU-inak rossz a hatásfoka, de az nVidia a HPC szegmensre koncentrál, míg az AMD-nek az otthoni szórakoztatás az elsődleges célja.

Azt hiszem a HD69xx-ek bebizonyították, hogy a max TDP képlékeny dolog, ha működésbe lép a PowerPlay. Lásd, miként tartja kordában a 400W-os 6990-est. Ha megfelelően tagoltak a cGPU egységei, akkor egy részük lekapcsolva maradhat, míg pusztán grafiks igénybevétel van, ahogy a grafikához szükséges fix funkciós egységeket is le lehet kapcsolni általános számítások alkalmával.

Arra próbálok rámutatni, hogy az AMD az egész rendszert el akarja vinni a Bull-féle működés felé.

Csodák természetesen nincsenek, de egy csíkszélességváltás után 190W-os TDP-vel bíró GPU hozhatja a korábban 250W-os elődjének teljesítményét.

És ha a PowerPlay játszik, ez a 190W lehet úgy 190W, hogy a GPU negyede/harmada le van kapcsolva. Ez pedig megfelelhet egy 250W-os GPU-nak, ami nem képes lekapcsolni részegységeit külön-külön.Másrészt -szintén PowerPlay- a 190W lehet kirakatszám az OEM-eknek. Egy SW-es kapcsolóval feloldható, és akkor ehet a kártya 250W-ot is... (id 6990)

-

Angel1981

veterán

válasz

TESCO-Zsömle

#4351

üzenetére

TESCO-Zsömle

#4351

üzenetére

Lehet, most már tisztázni kéne, hogy ki milyen szemszögből nézi.

Én kizárólag játékos szemszögből nézem, Te meg ahogy elnézem nem (ami persze nem baj), és lehet, ebből adódik a nézeteltérésünk.Válaszaim:

Igen, de ezek a cGPU-k a puszta grafikus megjelenítésben nem olyan hatékonyak, mint a "sima" GPU-k. (Legalább is jelenleg, és még egy ideig biztos így lesz.)

Lehet, de mi most a max. TDP-ről beszélünk, nem a nyugalmiról, és nem az átlagosról.

Márpedig ha a max. ennyi az sok mindent elárul a várható teljesítményről, ugyanis a puszta architektúraváltással nem lehet csodát tenni ( a korábban említett Pentium-Core egy ritka kivétel).Játékok szempontjából mi értelme "hogy olyan dolgokra is képes, amire eddig nem" ha egyszer nem használja ki, legalább is jelenleg nem?

Lehet, hogy most megkönnyítette volna, de ha ez lenne a cél, eleve nem lett volna tervbe véve a 28 nm. A TSMC amúgy is mindig half node-okban volt jobb, jövőbeli terveik közt szerepel a 20nm és a 14nm, másról nem nagyon van szó.

Arról nem is beszélve, hogy a jövőre nézve pont hogy úgy néz ki, hogy a full node fog eltűnni. Az Intel és az AMD is a 22 nm után 14-et tervez, utána meg 10-et.Az utolsó 2 bekezdésedben tárgyaltakat meg tudom, nagyjából és egyetértek velük.

-

TESCO-Zsömle

titán

válasz

Angel1981

#4349

üzenetére

Angel1981

#4349

üzenetére

Csak hogy az nVidia a nyers teljesítményt helyezte elsődleges szempontnak és nagy, monolitikus chipekkel operál még mindig.

Az AMD energiagazdálkodásban is sokkal jobban áll. Biztos vagyok benne, hogy az új cGPU-khoz is nagyon hatékony PowerPlay társul majd, ami (akár csak a Bull esetében) képes lesz kikapcsolni az éppen nem üzemelő egységeket.

Nem ellenzem a fejlődést. Miért? Szerinted a fejlődés kimerül abban, hogy adott feladatot gyorsabban tud megcsinálni? Mert a cGPU lényege pont az lesz, hogy olyan dolgokra is képes, amire eddig nem. Mi ez, ha nem fejlődés? Még akkor is, ha a teljesítménynövekedés kisebb lenne.

Igen, és pont azért csak 15%, mert törölték a csíkszélesség-csökkentést. A Full-node-ra átállásnak meg lett volna az az előnye, hogy gyártástechnológia szempontjából szinkronba kerül a GPU és a CPU, ami megkönnyíti a Fúziót.

Nem, tényleg nem. De eddig az se volt megszokott, hogy te állítod be a proci TDP-jét, szervereknél mégis ez a helyzet...

A dolgok változnak...

Egyrészt az nV a HPC piac miatt már nem képes igazán versenyképes GeForce-okat állítani a teljes Radeon palettával szembe. Teljesítményben persze ott vannak, de milyen áron? +50-100W...

AMD-nél a Fusion a prioritás. Minden oda dolgozik. A Bull, és a cGPU is.A Llano most Bobcat+Evergreen. A következő generációban megkapja a Bull magot, az azutániban a Bull bizonyos egységeit felváltják a cGPU CU-jai. A magok részeivé válnak a GPU számolóegységei. Nem csak mellette lesznek. Többek között ezért is olyan moduláris a Bulldozer felépítése, amilyen.

-

S-Attila

senior tag

válasz

Angel1981

#4349

üzenetére

Angel1981

#4349

üzenetére

A 3. és 5. ponthoz egy kósza gondolat:

Ugye afelé haladunk, hogy ne legyen olyan CPU, amiben nincsen grafikus gyorsító. És akkor mi a helyzet, hogy ha az AMD-nél úgy gondolkoznak, hogy a GPU fogyasztását csökkentik, és az így kevésbé növekvő teljesítményt a CPU-ban - pardon, APU-ban

- lévő erőforrásokkal fogják majd kiegészíteni?

- lévő erőforrásokkal fogják majd kiegészíteni? -

Angel1981

veterán

válasz

TESCO-Zsömle

#4348

üzenetére

TESCO-Zsömle

#4348

üzenetére

1. Lehet, de míg az csak GPU, addig a most érkezők cGPU-k, általános számításokra is kihegyezve, olyan dolgokra, amik nem szükségesek a mai grafikus megjelenítésekre.

2. Nem tudom? Nézd meg az elmúlt évek kártyagenerációit! Az NVidia a cGPU felépítés miatt csak kb. +40%-nyi tranzisztorral tudott +15-20%-nyi teljesítménytöbblet hozni az AMD megoldásaihoz képest. (4870-GTX280, 5870-GTX480)

3. Nem kell sokkal erősebbnek lennie? Ellenzed a fejlődést? Akkor szerinted baj volt, hogy a HD38XX-nál jó másfélszer erősebb volt a HD48XX, annál meg a HD58XX?

4. a HD6970 valóban kb. 15%-kal erősebb a HD5870-nél, viszont kb. 25%-kal több tranzisztort tartalmaz, és 25%-kal többet is fogyaszt. Hatékonyság tekintetében igazából visszalépés történt, de ezen nincs mit csodálkozni, hiszen a HD69XX egy kis lépéssel közelebb került a cGPU-hoz - mi ez, ha nem "bizonyíték"?

5. Igen, akkor valóban tartható, csakhogy eddig nagyon nem ez volt a megszokott.

Mármint, ha kisebb lett a csíkszélesség, 50-70%-ot nőtt a teljesítmény, kb. változatlan TDP mellett. Nem az volt a helyzet, hogy 20% növekedés, kisebb TDP mellett.

Ez merőben új irány csak ezért vagyok meglepve. -

TESCO-Zsömle

titán

válasz

Angel1981

#4347

üzenetére

Angel1981

#4347

üzenetére

Az R600 (mostani) architektúra is már 4 éves, szóval benne van a korban.

Amúgy nem tudhatod hogy reagál a cGPU architektúra a PowerPlay-re, illetve miként skálázódik az igénybevételhez mérten.

Gyakorlatilag nem tudod bizonyítékkal alátámasztani amit állítasz.

Nem kell sokkal erősebbnek lennie. A HD6970-es sem sokkal erősebb a HD5870-esnél, csupán 10-15% a különbség...

Az 5870-es anno 20-35%-ot pakolt oda a 4890-esnek és 25-50%-ot a 4870-esnek...

10-15%-os teljesítménynövekedés mellett tartható a TDP csökkenés.

-

Angel1981

veterán

válasz

TESCO-Zsömle

#4346

üzenetére

TESCO-Zsömle

#4346

üzenetére

A Netburst architektúra igazából már 2003-4 környékén bukott volt, csak az Intel erőltette, mert bízott benne, hogy megoldja a sokasodó problémákat.

2006-ra már katasztrofálisan elavult volt, míg Core 2 hipermodern architektúrával debütált.

Az általad említett példa egészen kivételes, a mérnökök tervezési hibájával természetesen nem lehet mit kezdeni, azt "nem nehéz" lepipálni teljesítményben egy fejlett architektúrával alacsonyabb TDP mellett.Itt egy jól működő GPU architektúra mellé fog bejönni egy cGPU architektúra, semmi más nem fog történni.

Aki esetleg arra számít, hogy kisebb fogyasztás mellett sokkal erősebb lesz, annak előre megmondom, hogy bizony csalódni fog, ebben biztos vagyok -

TESCO-Zsömle

titán

-

S-Attila

senior tag

válasz

Angel1981

#4344

üzenetére

Angel1981

#4344

üzenetére

Ha az említett számok igazak lennének, akkor az magasabb frekvenciát leszámítva nem lenne közöttük teljesítménykülönbség. No de én ezzel a részével nem is vitatkoztam, pusztán annyit mondtam, hogy a leírt technikai paramétereknek a 28 nanométerrel való kombinálása esetén szerintem a fogyasztás teljesen reális lenne.

Egyébként meg már le lett írva, hogy szinte 100 %, hogy ezek a számok itt teljesen valótlanok.

-

Angel1981

veterán

válasz

S-Attila

#4342

üzenetére

S-Attila

#4342

üzenetére

Természetesen lehet, de akkor kérdem én, hol lesz itt a teljesítménynövekedés?

Merthogy a kettő együtt nem megy - csíkszélesség csökkentésnél vagy a TDP csökken jelentősen, vagy a teljesítmény nő.

Ha valóban ilyen TDP-jük lesz, akkor pl. az általad felhozott két kártya között nem lesz jelentős teljesítménykülönbség, az újabb jelentősen kevesebbet fog fogyasztani, de annyi, oszt kész!

(Pedig a számozásuk alapján egy kategória a kettő, csak 2 generáció különbséggel.) -

TESCO-Zsömle

titán

válasz

Angel1981

#4341

üzenetére

Angel1981

#4341

üzenetére

Vedd hozzá, hogy a két 79x0-asnál most nem beszélhetsz klasszikus értelemben vett duplázásról, mert új architektúráról van szó! Mellesleg az AMD nem arra utazik, hogy minél jobban kihasználja a 300W-os keretet, hanem a hatásfokra. Teljesítmény/W, Teljesítmény/Dollár.

Plusz gondolni kell a 7990-esre is...

A 6970-es TDP-ja ~250W volt, tehát a 6990-esen majdnem 500W-ott kellett beszorítani a PowerPlay-nek 300 alá.

A 7990-es ezek alapján max 380W-ot fogyaszthat, ami sokkal barátibb ilyen téren.

S-Attila: Ő a 7900-asokon lepődött meg, csak azt felejtette el, hogy azok teljesen új architektúrával jönnek, így nem vethető össze a fogyasztás, hisz a teljesítményük ismeretlen...

-

S-Attila

senior tag

válasz

Angel1981

#4341

üzenetére

Angel1981

#4341

üzenetére

Nem, te eredetileg azon lepődtél meg, hogy mennyire alacsonyak a TDP értékek.

Na most, ha megnézed azt, amire ezt reagáltad, pl.:

HD 7870 Thames XT VLIW4

950MHz, 24SIMDs, 1536ALUs, 96TMUs, 32ROPs, 256bit GDDR5 5.8Gbps 186GB/s 2GB, 120W HPL

mindez 28 nanométeren, simán lehet mondjuk a

HD5870 850 MHz, 20 SIMD, 1600 ALU, 80 TMU, 32 ROP, 4,8 Gbps, 153,6 GB/s, 2 GB, 188 W

mindez 40 nanométeren. Avagy nem?

-

Angel1981

veterán

válasz

S-Attila

#4340

üzenetére

S-Attila

#4340

üzenetére

Jaj! Istenem!.....

Teljesítménykategóriákról beszélünk, nem egy adott fix teljesítményről!

Mivel csíkszélességet csökkentenek, kb. duplázzák a tranzisztorokat, így a teljesítményt is, természetes, hogy egy adott tranzisztorszámú GPU teljesítménykategória tekintetében egyre lejjebb keresendő.

Ami az adott generációban a csúcs, a következőben már csak a felső lesz, ami a felső, az már csak a közép, stb. -

-

Angel1981

veterán

válasz

TESCO-Zsömle

#4337

üzenetére

TESCO-Zsömle

#4337

üzenetére

Megfeledkezel arról, hogy a 4870 egy felső kategóriás kártya volt, míg az 5770 egy felső középkategóriás - nem véletlen az eltérés a százas helyértéknél.

Az 4870 megfelelője az 5850 (az 5870 a 4890-é), és szinte pont azonos a TDP.; 150W, mint ahogy a másik páros esetén a 190W.

Egyébként az 5770-nek a hivatalos TPD-je 110W. -

TESCO-Zsömle

titán

válasz

Angel1981

#4335

üzenetére

Angel1981

#4335

üzenetére

Akkor indulj ki abból, hogy kb ugyanilyen viszonyban volt a HD4870 és a HD5770.

A 4870-es simán megkajált 150W-ot, az 5770-esnek elég volt 90W. Ez 40%-os csökkenést jelent az órajel növekedés ellenére.

A HD6970-es fogyasztása 185W. Ennek 60%-a 111W lenne. A táblázatban 120W van megadva.sz: És akkor arról nem is beszéltünk, hogy a továbbfejlesztett PowerPlay-jel egy 500W fogyasztású kártyát is 300W alá lehet szorítani. Gyak olyan fogyasztási limitet írnak be a kártyának, amilyet nem szégyellnek, csak a teljesítmény sínyli meg...

-

Abu85

HÁZIGAZDA

válasz

Robi BALBOA

#4327

üzenetére

Robi BALBOA

#4327

üzenetére

Ugyanaz, mint egy GPU-nál. Amit írtam azt úgy kell érteni, hogy a GPU típusú, vagyis throughput optimized processzornál lényegtelen az, hogy az XDR2-nek nagyobb a késleltetése, mind a GDDR5-nek.

Az XDR2 előnye, hogy a GDDR5-höz képest kevesebbet fogyaszt, mert a bázisórajel alacsony, de magasabb késleltetése, ami persze egy GPU-nál nem számít. A nagy hátrány, hogy drágább, mind a chip maga, mint pedig a tokozás több csatija miatt az implementálás.(#4331) gbors: A 256+ bitet nagyon érdemes kerülni. Nem a mérnöki teljesítmény a probléma, mert 512 bitet is összehoznak, vagy többet is ha kell, de a VGA-piac bevétele drasztikusan csökken (idén a JPR 33%-os mínuszt vár, ami az elmúlt évekhez képest óriási). Az új fejlesztéseknél alapvető elvárás, hogy a mindenhol ahol lehet spórolni lehessen. Ez már nem a nyereség növeléséről szól, hanem a piac fenntartásáról. Egyébként 256 bit mellett is lehet 64 blendinget csinálni. Így is két blokk van egy csatornán, semeddig sem tart négyet rakni rá.

A fő probléma persze nem itt van. Nézd meg Carmack megatextúrázását. Kurva nagy ötlet, de közben tiszta szopás az egész, mert a dedikált GPU-k nem kezelik az x86 virtuális memóriát. Egyszerűen el kell vándorolni az adatért a rendszermemóriához, és a proci segítségét kell kérni, hogy az meglegyen, majd az információkkal vissza kell térni. Szimplán a PCI Express erre nem alkalmas. Nem az információk mennyiségével van a baj, mert azt simán átviszi egy 4-8 GB/s-os link, de teljes a késleltetés (szoftveres és hardveres oldalról együtt), ami ezzel a procedurális jár, kivégzi a teljesítményt. Carmack szerint a direkt eléréshez képest több 10000-szer lassabb a texture update folyamata, egy pixel frissítésénél. Ez így low, szart sem ér az egész. Nem véletlenül tartja úgy, hogy a Sandy Bridge kamu-IGP-jét is ki lehetne hozni gyorsabbnak. Direkt programozással simán 10000-szer gyorsabb frissítést csinálhat, mert kizárja a szoftveres korlátokat, és a rendszermemória is közvetlenül elérhető, ami kizárja a PCI Express fizikailag kivédhetetlen késleltetését.

Erre a problémára egyébként az AMD kitalálta a PRT-t, ami az új architektúrában benne is lesz, de a PCI Express késleltetését ez sem zárja ki, csupán közvetlenül eléri az x86 virtuális memóriát. Ezzel a proci kizárható a texture updateből, ami biztos gyorsulást hoz, de a konzolos direkt programozással elérhető szinttől még mindig messze van. Aminek ez a PRT nagyon, de tényleg nagyon fog segíteni, azok a GCN-es IGP-vel rendelkező Fusion APU-k. És akkor egyre inkább arra megyünk, hogy a IGP teljesítménye túró az erős dGPU-hoz képest, de mégis ott van a rendszermemória mellett, és ez a megatextúrázásnál durva előny egy PRT-vel megspékelve. A texture update késleltetése töredék időt igényel. A direkt programozástól ez is gyengébb, de az időigény már nem 100-szoros, 1000-szeres, vagy 10000-szeres. -

Angel1981

veterán

válasz

TESCO-Zsömle

#4332

üzenetére

TESCO-Zsömle

#4332

üzenetére

Akkor is, mivel ez 1 lépcsőfok!

GPU-k nál inkább half node-ok vannak, a HD4000 55 nm-en készült, a HD5000-6000 40 nm-en. Ezért adja magát, hogy ez 28-on készüljön, a következő csíkszélesség pedig a 20 legyen.

Nem csoda, hogy törölték a 32nm-t, nem is értem, miért terveztek vele, amikor az full node, amin sokkal inkább CPU-kat gyártanak. (Tudom, volt már rá példa, hogy alkalmazták, pl. a G80 90nm-en jött ki, de nem jellemző.)

A 32 és a 28 között meg aztán nincs nagy különbség... -

radi8tor

MODERÁTOR

válasz

TESCO-Zsömle

#4332

üzenetére

TESCO-Zsömle

#4332

üzenetére

Ez szuper hír. Többet lehet gamelni UPS-ről

-

TESCO-Zsömle

titán

válasz

Angel1981

#4328

üzenetére

Angel1981

#4328

üzenetére

Akkor is, ha figyelembe veszed, hogy nem egy, hanem két lépcsőfokot lépnek lefele? (40nm ->

32nm-> 28nm)Figyelembe véve, hogy a hasonló órajelen járó 6970-es eszik 208W-ot, abszolót csúcson pedig 285-öt powerplay nélkül, szerintem a 120W reális ekkora csíkszélcsökkenés után.

Főleg, hogy a csipen szinte semmi változtatást nem hajtanak végre.

-

ebben mekkora elszólás van:

"but this is unconfirmed information that we may very well be fake"

Abu: műszakilag nem értek annyira a chipgyártáshoz, hogy a 256-bit / 384-bit kérdést mérnöki fronton challengelni tudjam, de ha én lennék ezeknek a srácoknak a főnöke, akkor nagyon gyanús lenne, hogy valami nem korrekt a 256-bites döntések körül. a Cayman kapcsán anno azt írtam, hogy nem tudom elképzelni, hogy a backend 256-bit / 32 ROP legyen, mert teljesen megfojtaná a chipet - ehhez képest 256 / 32 lett, és mit ad Isten, teljesen megfojtotta a chipet. most megint bele akarnak szaladni ugyanabba a pofonba, esetleg a másik irányból? zseniális lenne...

-

Z10N

veterán

-

Angel1981

veterán

válasz

csatahajós

#4306

üzenetére

csatahajós

#4306

üzenetére

Számomra meglepően alacsonyak a TDP-k!

-

Abu85

HÁZIGAZDA

Az AMD-nek évek óta állandó licencszerződése van a rambusszal minden technológiájukra. Ez a része a dolognak nem ütközik problémába. A rambus csak azokkal a vállalatokkal bánik kesztyűs kézzel, amelyek ki akarnak bújni a licenc fizetése alól, akik fizetnek, azokkal "mosolyszerződés" van.

(#4322) gbors: 384 bites buszt az AMD nem akar szerintem semmilyen szinten nem akar. Inkább legyen nagyobb a chipméret, mert az összességében olcsóbb, mint a tokozási és a NYÁK költségek drágulása a +128 bitből. Mondjuk én az XDR2-t eleve nem tartom logikusnak, de elképzelhető persze. Egy GPU-nál a hátrányai nem jönnek ki.

-

korcsi

veterán

válasz

csatahajós

#4323

üzenetére

csatahajós

#4323

üzenetére

A rambus-ba nem a gyártás a drága hanem a licenc díj. Az Amd-nek a rambus-szal kellene megállapodni, de az nem lenne olcsó.

-

csatahajós

senior tag

Itt van még egy kis adalék a RAM spekulációhoz

Szóval mi van ha házon belül gyártják az XDR2-t? Így lehet nem is kell az a 384-es busz.

Amúgy a kódnevek tényleg picit össze vannak kutyulva az eredetiben, ettől még szerintem a spec. lehet jó - persze csak okoskodunk, de már tényleg ideje volt valami info morzsának.

-

én nagyon logikátlannak látom ezt a felépítést a high-end chipnél. tök jó, hogy rájöttek, hogy a caymanban a 32 ROP nagyon kevés, de ha a 33%-kal magasabb ALU/TEX kapacitás mellé duplaannyi ROP-ot tesznek, az pont a ló túlsó oldala. ide kellene egy 384-bites memóriabusz 48 ROP-pal, akkor backend kapacitás is lenne elég, meg tudna is miből táplálkozni anélkül, hogy az égbe kellene húzni a memória-órajelet. meglássuk

arról pedig sziget vagy nem sziget ellenére sincs kétségem, hogy fake - de legalább van valami, amin spekulálni lehet

(thanks csatahajós!)

(thanks csatahajós!) -

Abu85

HÁZIGAZDA

Mert a skalár egységet közös gyorsítótárat használnak 4 CU-nként. Le lehet tiltani kettő CU-t a négyből, mert asszimetrikus is lehet a rendszer, de ez nem a legjobb az integer ALU teljesítményére.

Az XDR2 pedig az árát fogja szépen megnövelni a wide-IO kialakítás miatt. Inkább 7 GHz effektív GDDR5-re tippelek. Más eléggé necces, mert az XDR2 bármennyire gyors, nem kevés pénzbe kerül. Az igaz, hogy fogyasztásban az XDR2 előnyösebb.

---

A másik dolog a fake alertre, hogy a Thames az nem sziget

. Az egy mobil GPU (Londonból kiindulva). Az asztalon New Zealand (2x az egyik GPU), Tahiti, Cape Verde, Pitcairn és Lombok lesz.

. Az egy mobil GPU (Londonból kiindulva). Az asztalon New Zealand (2x az egyik GPU), Tahiti, Cape Verde, Pitcairn és Lombok lesz. -

huskydog17

addikt

Abu, te mennyire tartod reálisnak a 4306-os hozzászólásban szereplő adatokat?

Ezt csak azért kérdem, mert pár szót említettél az XDR2 memóriák létjogosultságáról. Mennyivel drágább ezeknek a lapkáknak az alkalmazása, mint az eddig alkalmazott GDDR5-nek?

Gondolom mivel a GCN architektúrát úgyis a high-end (magyar földi halandó számára megfizethetetlen és elérhetetlen) árkategóriába szánja az AMD, akkor ott már talán nem akarnak a memórialapkákon spórolni. Na persze lehet, hogy rosszul látom a dolgot. Mi a véleményed? Szerinted mennyi ideig elégítheti ki a GDDR5 az újabbnál újabb VGA-kat, mennyi tartalékot látsz még bennük? -

BotaN

senior tag

Ahh kedves uram!

Ha 100 alatt lesz a 7950 megjelenéskor akkor ott fogok virrasztani a boltba amíg meg nem hozza a beszállító...

Ha 100 alatt lesz a 7950 megjelenéskor akkor ott fogok virrasztani a boltba amíg meg nem hozza a beszállító... -

Robi BALBOA

őstag

válasz

csatahajós

#4306

üzenetére

csatahajós

#4306

üzenetére

7870 alias 6970 csak 120W-os fogyival, hát ez nagyon korrekt és még a legerősebb(1gpu-s) kari is csak 190W

Nagyon remélem, hogy legalább a fogyasztási adatok igazak lesznek.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Mandarinn

senior tag

válasz

stranger28

#4315

üzenetére

stranger28

#4315

üzenetére

Igaz a jövőben ez változhat. Jelenleg úgy gondolom felesleges.

-

Mandarinn

senior tag

válasz

stranger28

#4313

üzenetére

stranger28

#4313

üzenetére

Ja hát nekem elég 1GB. Nem kell a vakítás

0FPS a különbség kb

-

-

Mandarinn

senior tag

válasz

stranger28

#4311

üzenetére

stranger28

#4311

üzenetére

Reméljük azért kicsit kevesebb

52 a 6950 jelenleg. Csak jobban alatta lesz. -

Mandarinn

senior tag

válasz

csatahajós

#4306

üzenetére

csatahajós

#4306

üzenetére

Szerintetek hova várható a 7850 ára?

Remélem a 6950 alá azért....

40.000Ft? -

Abu85

HÁZIGAZDA

válasz

csatahajós

#4306

üzenetére

csatahajós

#4306

üzenetére

HD 7950 ... brutal bullshit. A 30 nem osztható 4-gyel.

XDR2 felesleges. Drága és van még tartalék a GDDR5-ben. -

radi8tor

MODERÁTOR

válasz

csatahajós

#4306

üzenetére

csatahajós

#4306

üzenetére

És ezek akkor jók lesznek?

-

csatahajós

senior tag

A 7-es széria várható speckói:

HD 7990 New Zealand GCN

HD 7970 Tahiti XT GCN 1000MHz 32CUs 2048ALUs 128TMUs 64ROPs 256bit XDR2 8.0Gbps 256GB / s 2GB 190W HP

HD 7950 Tahiti Pro GCN 900MHz 30CUs 1920ALUs 120TMUs 64ROPs 256bit XDR2 7.2Gbps 230GB/s 2GB 150W HP

HD 7870 Thames XT VLIW4 950MHz 24SIMDs 1536ALUs 96TMUs 32ROPs 256bit GDDR5 5.8Gbps 186GB/s 2GB 120W HPL

HD 7850 Thames Pro VLIW4 850MHz 22SIMDs 1408ALUs 88TMUs 32ROPs 256bit GDDR5 5.2Gbps 166GB/s 2GB 90W HPL

HD 7670 Lombok XT VLIW4 900MHz 12SIMDs 768ALUs 48TMUs 16ROPs 128bit GDDR5 5.0Gbps 80GB/s 1GB 60W HPL

HD 7570 Lombok Pro VLIW4 750MHz 12SIMDs 768ALUs 48TMUs 16ROPs 128bit GDDR5 4.0Gbps 64GB/s 1GB 50W HPL

-

korcsi

veterán

válasz

S-Attila

#4304

üzenetére

S-Attila

#4304

üzenetére

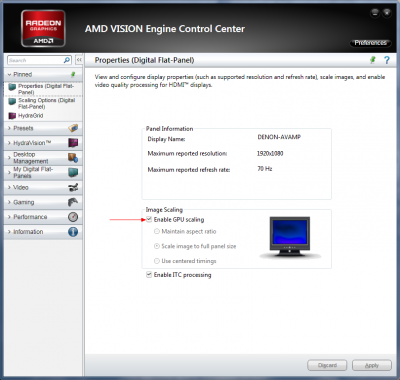

A "GPU scaling" arra való, hogy ha nem natív felbontásba hajtod a megjelenítődet akkor a GPU felskálázza és a monitornak nem kell, így talán picit jobb lesz a minőség.

A másik opció meg HDTV-hez van hogy ha variál a képmérettel a TV, akkor tudd kompenzálni.

De ezt nem itt kellene!!!

-

Zoo123

senior tag

válasz

sonicman89

#4299

üzenetére

sonicman89

#4299

üzenetére

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Példátlan a 2 nm-es TSMC node iránti kereslet

- Programozás topic

- Formula-1 humoros

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Milyen billentyűzetet vegyek?

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- Assassin’s Creed Shadows teszt

- Mégsem lesz divat az atomerőműre kötött adatközpont?

- Milyen autót vegyek?

- Milyen belső merevlemezt vegyek?

- További aktív témák...

- 3DB gyönyörű EVGA GTX260-275-285 Eladó !!

- Garanciális GIGABYTE GeForce RTX 4060 AERO OC 8G Videokártya

- 27% Számla! Sapphire RX 7900 XTX Vapor-X 24GB GDDR6 Nitro+ Videokártya! BeszámítOK

- Csere-Beszámítás! MSI Ventus 3X RTX 4060Ti 8GB GDDR6X Videokártya

- MSI GeForce RTX 5080 16G GAMING TRIO OC majdnem új 2028.04.22-ig magyar garis

- AKCIÓ! VALVE INDEX virtuális valóság szemüveg garanciával hibátlan működéssel

- Dell Optiplex MT/SFF/Mini 3040, 3050, 3060, 3070, 5070, 7060/ Hp ProDesk /SZÁMLA- GARANCIA

- AKCIÓ! Lenovo Thinkpad T14 Gen 3 üzleti notebook - i5 1245U 16GB RAM 512GB SSD Intel Iris XeW11

- Xiaomi Redmi Note 10 Pro 128GB Kártyafüggetlen, 1Év Garanciával

- Bomba ár! Dell Latitude 5310 - i5-10GEN I 16GB I 256SSD I HDMI I 13,3" FHD I Cam I W11 I Garancia!

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

ha a +32 ROP-ot csak így lazán bele lehetne hajítani a chipbe, akkor miért nem tették bele a Caymanbe? szegény GTX580 csak pislogott volna, hol van előtte a konkurencia, és még úgy is kisebb lett volna az AMD megoldása.

ha a +32 ROP-ot csak így lazán bele lehetne hajítani a chipbe, akkor miért nem tették bele a Caymanbe? szegény GTX580 csak pislogott volna, hol van előtte a konkurencia, és még úgy is kisebb lett volna az AMD megoldása.

Másik, hogy ki tudja, mit hoz a jövő, nem akarom 6 ezer miatt ezt csinálni:

Másik, hogy ki tudja, mit hoz a jövő, nem akarom 6 ezer miatt ezt csinálni:  .

.