-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

cwn

tag

válasz

MPowerPH

#2796

üzenetére

MPowerPH

#2796

üzenetére

ugyanazon a csikon, ugyanazzal a gyartastechnologiaval, nem lehet ilyen cegek kozott 10-20%-os kulonbsegnel nagyobb, mindket oldalon profi mernokok dolgoznak akik ugyanazon az egyetemeken tanultak ugyanazokat a szakmai cikkeket olvassak

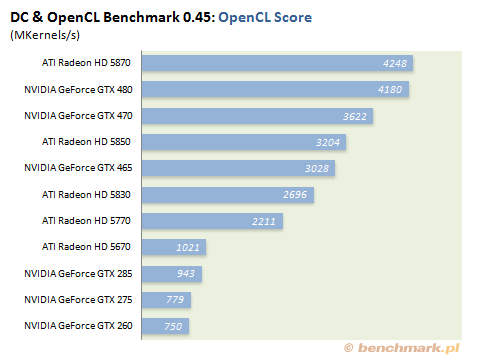

ettol eltero akkor lehet a helyzet mikor mas utat valasztanak , lasd gtx480 4-szer gyorsabb gpgpu alatt mint az ati parja -

MPowerPH

félisten

válasz

Oliverda

#2795

üzenetére

Oliverda

#2795

üzenetére

Ahogy Keldor mondaná, "1GPU vs. 2GPU az NV-sek utolsó mentsvára."

Még mindig nem kaptam rá indokot, hogy miért vettem volna meg a GTX480-at, mikor ugyan annyiért tudok 5970-et, ami jóval gyorsabb, nem akkora kazán, és az ég világon semmi problémám nincs vele. Józan ésszel nem bírom megérteni, hogy miért kellett volna nekem anno máshogy döntenem. Csak a fanatizmus miatt csináltam volna ekkora böszmeséget...

Mod: Ha minden igaz, megvan rá az esély, hogy a 6970 odacsap a GTX-nek. Akkor jönnek a mikro akadásokkal, nem kell izgulni, mindig kitalálnak valamit.

-

Oliverda

félisten

Feljebb leírtam, hogy mi a gond. Rossz gyártó használja ki a multi GPU nyújtotta előnyöket. Majd ha véletlenül a 6970 átveszi a leggyorsabb egy GPU-s kártya szerepét akkor jönnek majd a sz@r a driver, csúnya a hűtő színe, túl sok a 2GB VRAM és újabb hasonló izzadságszagú kifogások.

-

Tényleg nem lehet 100%-ig azonos 2db GPU egy 1 GPU-s, de dupla olyan erős GPU-val.

A lényeges(ebb) kérdés az, hogy mennyire éri meg dupla oylan erős GPU-t csinálni két kisebb, és gyengéb helyett.

Az nV-nek azért éri meg, mert ugyanazt el tudja adni prémiumhaszonnal GPGPU címen.

Ha az AMD-nek lenne erre lehetősége, akkor ők is ezen a sokkal jobban profitáló úton járnának, de mivel eddig magasról letojták a profi vonalat, már nagyon nehéz és költséges ide betörni, így amíg vannak nagyobb promlémáik is (intel, ARM, tabletek, okostelefonok, pénzügyi helyzet), addig olyan piacra koncentrálnak, ahol van esélyük, de itt is minimál befektetéssel igyekeznek max hasznot elérni (sweet spot). Ennek része a két kis GPU az egy nagy helyett.

Szerintem. -

cszn

őstag

Nem értem, hogy hol a gond igazából. A két gyártó lefedte a piacot egymás réseit tömködve, így mindenki megtalálhatja a magának megfelelőt mindkét oldalon. Mindegyik oldalnak megvannak az előnyei és hátrányai, de a leggyorsabb kártya az 5970, ezt elvitatni nem lehet. Most őszintén és objektíven gondolj bele. A csúcskártyánál nem mindegy hány GPU van benne? A csúcskártya egy erődemonstráció és ebben az 5970 a legjobb.

-

TTomax

félisten

válasz

Oliverda

#2789

üzenetére

Oliverda

#2789

üzenetére

Látom elfogytak a szakmai érvek,most jön a szemüvegem...mindig előkerül amikor bajban vagy,várom mikor veszed elő a pisztolyos smile-dat,mert az szokott a következő lenni,gondolom van aki felül rá és elszáll a végfok,de ez nálam nem fog összejönni,bár már megpróbáltad párszor...

-

Oliverda

félisten

Ugyan miért nem lehet a kettő között párhuzamot vonni? Hmm?

Szerintem amúgy egyszerűen csak szúrja a szemüveg mögött rejlő szemeidet, hogy még az nV több ok miatt képtelen egy ideje dual GPU-s kártyát készíteni, addig a Radeon-ok már három (illetve lassan már négy) generáció óta sikerrel használják ki ezt a lehetőséget. Ergo ha az nV-nek most lenne dual GPU-s kártyája és az lenne az elérhető leggyorsabb VGA, akkor baromi de iszonyat qrvajó lenne a dual GPU-s VGA mint olyan.

-

Oliverda

félisten

Nem gondoltam volna, hogy ilyen hatalmas problémákról van szó.

"az én véleményem az,hogy amíg nem azonos képkockán dolgozik a két gpu addig nem lehet egyenértékű egy egy magos kártyával!"

Kár hogy nincs olyan játék ami fixen egy képkockát rajzol ki másodpercenként.

Ilyen elgondolással a gyorsabb végrehajtás ellenére a CPU-k több magja sem egyenértékű egyetlen egy lassabb maggal szemben. Kissé sántít ez az egész valahol én úgy érzem...

-

TTomax

félisten

válasz

Oliverda

#2785

üzenetére

Oliverda

#2785

üzenetére

Minden maghoz kell memória... ez van... vegyük pl a HD5970-et... átlag user bemegy vásárolni... mit lát a dobozon?2G VRAM... ohh ezt megveszem mert a gagyi GTX580-on csak másfél van... amikor hazaér elkezd tesztelni,aztán feljön a fórumra.. idézek egy tipikus kérdést " a GTA4 miért írja,hogy csak 1 G v. memóriám van amikor kettő?"

Igazából a probléma nem is itt van,hanem AZ AFR-ben... az én véleményem az,hogy amíg nem azonos képkockán dolgozik a két gpu addig nem lehet egyenértékű egy egy magos kártyával! -

-

TTomax

félisten

Igen,és e közben a "csúcsmodell" egy rakat gyermekbetegséggel küzd ,ezt is tegyük hozzá... felőlem rakhatnak akár 50GPU-t is a nyákra,de addig amíg nincs közös memóriaelérése addig nem lehet egyenértékű egy single gpu-s megoldással,lehet ezt csűrni csavarni de bizony ez az igazság.Ameddig AFR-t használnak addig meg is maradnak ezek a gondok,gyanítom még majd csúcsosodnak is,ha majd elérünk oda hogy több gpu tud dolgozni azonos képkockán akkor azt mondom ejha,ez már valami!

(#2778) Oliverda

Valóban volt yorkom,és valóban nem volt nativ 4magos,de arra nem emlékszem,hogy magonként bele kellett volna tolnom 1G ramot,vagy hogy akár olyan lapot kellett volna néznem amin 4 memóriavezérlö is van,hogy ne fulladozzon valamelyik mag,gondolom érted mit akarok írni..

(#2783) BMW001

Az rendben van,hogy neked bejött a multiGPU.Gondolom sehol nem tapasztaltál semmi gondot...sőt a fogyasztás is rendben volt,csak ezt nem mindenki tapasztalja így,gondolom ezzel nem mondok újat..Nekem is volt jó néhány több kártyás rendszerem,és találkoztam elég sok problémával,habár most is ismét sli-n töröm a fejem,nem mondanám azt hogy én nyugodtan ajánlom mindenkinek potn a fentebb említett problémák miatt.

-

MPowerPH

félisten

"A leggyorsabb egymagosnak igenis van létjogosultsága ..."

Jah, főleg ha minden téren lassabb, mint a két GPU-s megoldás, többet fogyaszt, kevesebb profitot termel a selejt arány miatt, és ugyan annyiba kerül. Én nem látom csak a létjogosultságot?

Ha tök hülye vagy, pártatlan, és bemész a boltba, hogy a leggyorsabb VGA-t akarod megvenni. Akkor tök mind1, hány GPU van benne, a gyorsabbat adják oda. Mert a mindennapok során észre sem lehet venni, hogy 2 GPU-d van, vagy 1. Én a 4890X2, 5970, és 4890 CF esetén is csak annyit vettem észre a 2db GPU-ból, hogy piszok gyors, és sokkal olcsóbban kijöttem, mintha a drágább, és lassabb NV -s 1 GPU-s megoldást választottam volna. -

válasz

Atom_Anti

#2773

üzenetére

Atom_Anti

#2773

üzenetére

ez melyik marketingkönyvnek hányadik oldala?

nagyon jól hangzik ez a szöveg, de próbálj meg egy olyan pályán spontán lenni, ahol pl. a gyártástesztelési folyamatok hónapokat vesznek igénybe.

4-5 hónap alatt olyanra van lehetőség, amit az AMD csinált a HD5830-ca,l vagy most az nVidia a GTX460 SE-vel. az első már "sikertermék", a másik pedig heteken belül azzá fog válni... -

zuchy

őstag

A GPU-ban is sok végrehajtóegység (Stream processor, Cuda Core) van, ez alapján lehetne akár több magosnak is nevezni. De MCM tokozásban lehetne létrehozni, még anno a Crypress találgatósban sem tűnt rossz ötletnek a két 800SP-s kis lapka MCM tokozása, tehát lényegében kettévágni a mostani HD5870 GPU-ját, így két kisebb chipet kapunk, amit könnyebb és olcsóbb lenne együtt véve is gyártani, mint a nagyobbat. Csak kellene valamilyen port a két chip kommunikációjához, amit meg plusz tranzisztorba kerül.

Mondjuk a Crypressben is már ketté van véve két 800SP-s blokkra, de egy lapkában. Akár nevezhetünk két magosnak is, de azokon belül is további "magok" vannak stream processzorok formájában. Én annyira nem ismerem a CPU-k felépítését, így csak a GPU-tól tudok érdemben nyilatkozni.

Én annyira nem ismerem a CPU-k felépítését, így csak a GPU-tól tudok érdemben nyilatkozni.

Ha meg két Crypress lapkát akarnánk egyre integrálni, akkor nagyon nagy lenne a GPU, szinte legyárthatatlanul. Az a baj, hogy általában egy GPU nagyobb szokott lenni, mint egy CPU, ezért lehet az utóbbiakat integrálni őket egy lapkára. -

Oliverda

félisten

Felesleges mert a GPU-t egymagában nem veszi meg a végfelhasználó mint a CPU-t. Egy nagy lapkát pedig jóval nehezebb legyártani mint két kicsit. Egymáshoz nagyon közel, egy BGA tokozáson belül ülő két nagy fogyasztású GPU-t meg sokkal nehezebb lenne hűteni. Minél távolabb vannak egymástól annál jobb.

A két GPU-s VGA pont olyan alap elgondoláson nyugszik mint a Core 2 Quad csak a VGA-nál jóval nagyobb a nyák és a memória valamint a PWM is ezen kapott helyet.

-

Oliverda

félisten

-

Abu85

HÁZIGAZDA

A GPU sosem lesz így megvalósítva. A dupla GPU azért lett így kialakítva, mert így a csúcsmodell fejlesztése olcsó, és nem mellesleg kegyetlenül gyors lesz a termék. Jelen pillalatban csak ilyennel lehet a leggyorsabb VGA címét hozni. Aztán persze lehet jönni a leggyorsabb GPU, a legkisebb fogyasztás, a legjobb teljesítmény egységnyi fogyasztás mellett, a legnagyobb órajel, a legkisebb idle fogyasztás mondókákkal. Nyilván van ezeknek is értéke, de az abszolút leggyorsabbhoz egyik sem ér fel.

-

TTomax

félisten

Ebben nincs igazad,még csak véletlen sem jó a hasonlatod... az én szememben sosem lesz egyenértékű egy több gpu-s rendszer egy egy gpu-sal.. a processzormagokat több mag esetén egybetokozzák.. majd ha a gpu is így lesz megvalósulta akkor lehet hasonlitgatni!

A leggyorsabb egymagosnak igenis van létjogosultsága ... -

TomiLi

addikt

Cayman hivatalos megjelenése mikor lesz végül is? December 7., vagy 13.?

-

Atom_Anti

senior tag

Spontanítás a lényeg, az adott szitut hogyan és milyen gyorsan tudjuk lereagálni. Nem lehet mindent előretervezni, váratlan és hirtelen döntéseket kell hozni.

Olyan ez mint egy bokszmeccs; megy a küzdelem, majd mikor megrogy az ellenfél akkor minden erővel neki kell menni. Ha nem teszed kibírja a szünetig és kezdődhet előröl a harc.A 3dfx pedig a tipukus példa; a fejlesztők henyéltek; pezsgő, nők és hittek a további jó sikerben. Ez idő alatt Nvidia pedig dolgozott mint a güzü, nem csak jobb hardvert hozott ki, hanem még marketingük is megerősítették, plusz a legfontosabb tesztprogramokat megvették; 3DMark2000, Quake3. Ezek után a GF2 annyival jobbnak látszódott hogy nem is kérdés mért történt ami történt

.

. -

-

Atom_Anti

senior tag

Csak hogy a GTX460 elég nagyban más mint a GTX480, nem egyszerű csonkítás történt, úgymond újjáépítették a Fermit. A többi kicsinek pedig a GF104 GPU lett alapja.

Abu85,

lövöldözheted magad , mert nem is egy teljesen új architektúra kifejlesztéséről beszéltem. Májusra kihozhattak volna egy ráncfelvarrott Cypresst kicsit több Sharderrel, kicsit magasabb órajelen és máris meglett volna a GTX480, ráadásul még mindig barátibb fogyasztással.

, mert nem is egy teljesen új architektúra kifejlesztéséről beszéltem. Májusra kihozhattak volna egy ráncfelvarrott Cypresst kicsit több Sharderrel, kicsit magasabb órajelen és máris meglett volna a GTX480, ráadásul még mindig barátibb fogyasztással. -

Abu85

HÁZIGAZDA

A vészforgatókönyv annyiban állt, hogy 32 nm-ről 40 nm-re váltottak. Az AMD múlt év nyarán már láthatta, hogy mennyire acélos a TSMC 32 nm-je, így el lehetett dönteni, hogy mit választanak.

A 4-5 hónap nagyon karcsú. Egy komplett új architektúrára, gyártással 4-5 évet érdemes mondani. A Cayman újításait látva valószínűleg 3-4 év alatt rakták össze a teljes projekt szintjén. -

TomiLi

addikt

Ha jól emlékszem, akkor tavaly decemberben jelent meg az első hír a mostani cayman fejlesztésének kezdetéről. Szerintem akkoriban még 28nm-rel számoltak, de ahogy Abu szokta mondani, volt/van egy vészforgató könyv...

Tehát egy éve már javában készül a mostani vga... a 4-5 hónap szerintem is karcsú....

főleg, hogy ez nem csak egy ráncfelvarrt vga lesz...

Azt meg nem hiszem, hogy csak marketing fogás lenne a csúszás a megjelenést illetően...Nem látok benne logikát. Tehát még most lehet a hajrá a Cayman körül. -

zuchy

őstag

válasz

Atom_Anti

#2757

üzenetére

Atom_Anti

#2757

üzenetére

A GTX460 a Fermi architektúrából jött elő, amit már évek óta fejlesztettek.

Tudták, hogy kell majd egy kisebb chip is, eleve úgy csinálják ezeket az architektúrákat, hogy könnyen lehessen nyirbálni.

Eleve a GTX480-nál magasabb eladási árral számoltak, így a GTX470-re se kellett volna EOL-t tenni, mert lett volna értelmes haszon. A GTX465 meg a selejtek eladására készült, jobb ha mínusszal el tudják adni, mint hogy a kukába vágják nulla haszonnal. Tudták, hogy kell egy kisebb GPU, ami a középmezőnyben versenyezhet, és még haszon is lehet rajta. -

Atom_Anti

senior tag

-

Abu85

HÁZIGAZDA

válasz

Atom_Anti

#2748

üzenetére

Atom_Anti

#2748

üzenetére

A fontos cím a leggyorsabb VGA. A leggyorsabb GPU, az olyan, mint ha arra verné egy processzorgyártó, hogy nekem van a leggyorsabb egymagosom.

Ha elég lenne stratégiailag a leggyorsabb GPU cím, akkor nem jelent volna meg a GTX 295, ami eléggé fájt anyagilag.

Ha elég lenne stratégiailag a leggyorsabb GPU cím, akkor nem jelent volna meg a GTX 295, ami eléggé fájt anyagilag.(#2751) Atom_Anti: A Bartsra nehéz válaszolni. Majdnem a GF106 mérete egyezik meg vele (bár a memóriabusz és a tokozás kétségtelenül olcsóbb a GeForce GTS 450-en). Az meg nem cél, hogy egy Cayman méretű lapkát bedobjanak ellene, hiszen sokkal költségesebb megoldás. Ez ideiglenesen jó lehet, mert versenyezni kell, de hosszútávon gondolni kell a partnerekre.

-

Atom_Anti

senior tag

5870 után kb 8 hónappal jelent meg a GTX480. Igen gondolom ennyi idő alatt az AMD is megújíthatta volna GPU-ját koktél szörcsölgetés helyett

. Újabb 8 hónap eltelt és nem az AMD, hanem az Nvidia jött elő egy megújított csúcs GPU-val. A Bartsra pedig előbb fog jönni válasz, mint jött a GTX460-ra.

. Újabb 8 hónap eltelt és nem az AMD, hanem az Nvidia jött elő egy megújított csúcs GPU-val. A Bartsra pedig előbb fog jönni válasz, mint jött a GTX460-ra. -

zuchy

őstag

Pont ezt akartam írni. Szerintem rendben van, hogy évente jön egy újabb széria. Na meg a mostanit is ki kell futtatni, hogy azért valami haszon is legyen mán.

Csak a pontosítás kedvéért a GTX 580 ráncfelvarrás 8 hónap volt GTX 480-hoz képest.

A Cayman meg lesz 15 hónap kb. 5870-hez képest.Na igen, és a Cayman az már új architektúra lesz. Persze azt sem a HD5870 megjelenése után kezdték el fejleszteni.

-

cszn

őstag

válasz

Atom_Anti

#2748

üzenetére

Atom_Anti

#2748

üzenetére

Miből gondolod, hogy az AMD fejlesztői csak koktélokat szürcsöltek idáig? Gondolod pár hónap alatt össze lehet dobni egy sokkal jobb GPU-t?

A 460-ra is elég gyorsan jött válasz.

A 460-ra is elég gyorsan jött válasz.

Nem mellesleg még nem tudjuk, hogy milyen lesz pontosan a Cayman, annyi biztos, hogy sokban eltér a mostaniaktól. Mindjárt itt van és az 580 is csak most jelent meg.

Csak a pontosítás kedvéért a GTX 580 ráncfelvarrás 8 hónap volt GTX 480-hoz képest.

A Cayman meg lesz 15 hónap kb. 5870-hez képest. -

Atom_Anti

senior tag

-

Abu85

HÁZIGAZDA

válasz

Atom_Anti

#2746

üzenetére

Atom_Anti

#2746

üzenetére

Szerinted a leggyorsabb GPU presztízsértéke nagyobb, mint e leggyorsabb VGA-é? Ha így lenne nem lett volna GTX 295, ami mint tudjuk veszteséges projekt volt, és le is állt a forgalmazása három hónapig a start után.

A vásárlókat nem érdekli, de a gyártópartnereket igen. Ez a stratégia kevésbé vonzó része. A BFG tönkre is ment benne, míg az XFX inkább átállt. Jövőre még "jobb" a helyzet, mert bizonytalan mindenki az integráció miatt. Az meg nyilván közvetve a vásárlónak sem kedvező, hogy a partnerek kihullanak. -

Atom_Anti

senior tag

válasz

MPowerPH

#2745

üzenetére

MPowerPH

#2745

üzenetére

Tisztába vagyok ez csak az NV mentsvára, (de nagyon is működik) ugyanis sokan nincsenek tisztában a technikai részletekkel és nekik elég hallani a leggyorsabb GPU szöveget. Vagyis, Nvidia megtudja tartani a presztízsét.

Abu85:

A vásárlóknak a GPU mérete is teljesen mindegy, ha Nvidia ugyanazon vagy olcsóbb áron tudja kínálni kártyáit mint az AMD. Hiába nagyobb méretre a GTX460 GPU, de még is olcsóbb mint a Barts. A GTX560 ráadásul még gyorsabb is lesz .

. -

MPowerPH

félisten

válasz

Atom_Anti

#2739

üzenetére

Atom_Anti

#2739

üzenetére

Nem volt itt bevárás. Ez az egy GPU-s duma meg csak az NV egyik mentsvára, ami már nagyon régen csak őket nyugtatja. Az AMD más utat választott, és ezen az úton simán megoldható 2 GPU egy nyákon. És a fogyi még így is jobb, sebességben is jobban állnak, és a driverek is elég jók lettek, nagyon magas a CF hatásfoka.

Az NV meg ha kihozza a GTX560-at, az AMD csökkenti a 6800-as széria árait, és máris sínen vannak. Ugyanis a bevezető ár kicsit megemelkedett azóta, ami annyit tesz, hogy bőven hoz a kártya eladása profitot. És nem elfelejteni, hogy lesz HD6950 is, aminek az árazása szintén egész jó pozícióba eshet. -

Oliverda

félisten

...akkor ennyit a 6990-es slide-ról.

-

Abu85

HÁZIGAZDA

válasz

Oliverda

#2741

üzenetére

Oliverda

#2741

üzenetére

A Sapphire az egy külön cég a Zotactól. Mindkettő anyavállalata a PC partner, de ettől ők külön büdzsével dolgoznak. Nem mellesleg a Sapphire brand nagyobb értékkel bír (ez teljesen normális, hiszen régebbi a brand történelme, többen hallottak már róluk), és bevételben is többet termelnek. A Zotac multimédiás irányba mozdul.

-

Oliverda

félisten

"A Sapphire például Inteles alaplapokat is akar, amire lesz is engedély a kiemelt státusz elvesztése nélkül. "

Gondolom Zotac néven nem? Az nV-s lapokat is ezen a néven hozták forgalomba. Sőt, Intel-es Zotac már van is. Miért lenne jó ha Sapphire néven hoznák őket forgalomba?

-

Abu85

HÁZIGAZDA

válasz

Atom_Anti

#2739

üzenetére

Atom_Anti

#2739

üzenetére

Nem igazán várta be. A Barts ellen hiába megy az NV egy Cayman méretű lapkával. A technikai előny ott van, csak elkérik a pénzt a sebességért. Ez 2011-ben különösen számottevő lesz, mert egyelőre senki sem tudja megjósolni az integráció hatását a belépőszintű VGA-kra nézve, de biztos, ami biztos, mindenki aki forgalmaz Radeont forgalmazhat Fusiont is. Ezt a gyártók ki is használják. Ennél akár tovább is lehet menni. A Sapphire például Inteles alaplapokat is akar, amire lesz is engedély a kiemelt státusz elvesztése nélkül. Hasonló a helyzet az XFX-nél, ők is fojtathatják az Inteles alaplapok gyártását. Nyilván az AMD-nek nem gáz, ha VGA helyett APU-t vesz a nép, de ez a partnereknek szívás, mert az APU-ból nincs pénzük. Valószínű lesznek új koncepciók is a külső VGA-k személyében.

-

Atom_Anti

senior tag

válasz

MPowerPH

#2738

üzenetére

MPowerPH

#2738

üzenetére

Ugyan a GTX480 nem let egy sikertermék, viszont már fél éve hangoztathatja hogy övéké a leggyorsabb GPU. GTX580-nak köszönhetően ez így is maradhat további fél évet. Akkor ott a GTX460 ami nem kevés hónapig volt best-buy, a mostanság megjelent Barts pedig hamarosan kap egy GTX560 ellenfelet. Nekem az egész úgy fest mintha AMD bevárta volna az Nvidiát

.

. -

LK

addikt

válasz

Gaboman

#2729

üzenetére

Gaboman

#2729

üzenetére

Szia! Én is láttam az AMD útitervét,és abban látszik,hogy 5770-ből fejlesztenek valami olcsó kártyát,és 2011 Q1-ben lesz kiadva. Nem értem,hogy akik ezt cáfolják mire alapozzák,hogy nem igaz??? AMD igazgatótanácsában dolgozó cimbijük van? (Én is kérdeztem valakitől és uezt a választ kaptam.) Miért ne vágyhatnék egy 256 bites kissé órajelnövelt 5770-re? Ha 35 ezer körül lesz az f@sza lenne.

-

tzsolesz

nagyúr

Mikor leszünk már ott?

-

Gaboman

nagyúr

válasz

csatahajós

#2728

üzenetére

csatahajós

#2728

üzenetére

Nem hogy nem elég, senki nem mondott ilyet, 1600x1200ban használom egyébként.

Bőven jó, nem azért cserélem majd le, csak szeretem a CF rendszereket és következőre egy 6770CF gondoltam majd, persze ez attól függ mit fog hozni az 5770hez képest. -

csatahajós

senior tag

válasz

Gaboman

#2724

üzenetére

Gaboman

#2724

üzenetére

Ne érts félre kérlek, de mire nem elég a 19"-es CRT kb 1280*1024-es felbontása mellett az 5770 CF, ami miatt annyira a 6770 kell?

Hogy on topic is legyek, jövő év márciusánál előbb nem lesz várható a 6770, nagyon valószínű hogy az lesz a 28nm-es technológia tesztjére készített GPU.

-

A jövőben lehetséges, hogy a CFX-nél stabilan több mint 100+% teljesítményt jelentsen a második és harmadik GPU?

Olyan szép lenne: csak egy bővítőkártya a CPU-GPU páros mellé, és rögtön belövi magát CFX-be és repül.

Azért lenne jó a 100+% mert akkor a második GPU-t már megéri venni, a harmadikat meg pláne.

Kicsit olyan lenne mint a kici kínai bazár, vegyél többet olcób és nacob teljesítmény.

Tudom, de álmodozni szabad.Ha csak 100-% skálázódik akkor csak simán baromi jó lesz.

-

DemonDani

addikt

válasz

Gaboman

#2722

üzenetére

Gaboman

#2722

üzenetére

Ez nem így lett ahogy a cikk írja, mindössze ennyi.

Jött a 6850 és 6870, a 6850 hasonlít a cikkben látott "tárgyra".

Teljesítménysorrend árakkal: (ez neked talán többet ér...)

30ezer: 5750 és GTS450, a GTS450 gyorsabb, de többet is fogyaszt, és tuningolhatóbb is az 5750 (mindenképpen 1gbosat érdemes figyelni minden kártyából)

35ezer: 5770 itt nincs vetélytárs elég jó kártya, az ati nem cserél le, gts450 gyengébb.

40ezer: gtx460 768mb rammal eléggé legjobb vétel szagú tárgy, ugyan kicsit többet fogyaszt, de kényelmesen tuningolható akár nagyobb vadak ellen is, fullhd felbontásra talán 50ezer alatti 1gb-os az ajánlhatóbb de nagy gáz 768mb-tal sem lesz, az 1gb-os valamivel erősebb és stabilabb képjavítók alkalmazásakor (2560, 1920 4AA 8AA, 1680 8AA).

55ezer környékén pihen a 6850, aki az 5850től kicsit ugyan elmarad, de sokszor jobban teljesít mint a GTX460 és jóval kevesebbet fogyaszt.

65ezer: GTX470 és 6870, ezek ugyan azt a szintet hozzák, viszont a fogyasztás ha számít nagyságrendekkel rosszabb a GTX470-nel itt elsőnek említeném hogy márkásabb tápokból is mindenképpen 400W felettit kötnék a végére (főleg a gépedet látva).Ezek azok amik téged érdekelhetnek a tiédtől indulva... Az áraknál kevesebbre számíts mint amit írtam, de ne sokkal. Szándékosan írtam kicsit többet... sorry ha valamit elírtam volna, jelezze ha gond van, ne tévesszek meg senkit

-

Gaboman

nagyúr

Én a 6770ről szeretnék érdeklődni, mikor startolnak a új jövevények?

Néztem róla adatokat és tényleg 256bit lesz? -

DemonDani

addikt

Kiapadni látszanak közben a szembe szomszéd készletei

Érdekes hogy pont addig volt raktáron GTX580 amíg az AMD-nek meg kellett volna jelennie (ez ugye elmarad most)

Hogy kiszámolta az Nv biztos annyival jobb lesz a HD6970, hogy ők is tudják, hogy ha megjelennek róla a tesztek onnantól eladhatatlan az 580![;]](//cdn.rios.hu/dl/s/v1.gif) Ördögi

Ördögi -

Abu85

HÁZIGAZDA

Nem mivel nem tudod kikapcsolni.

Nem hasonlítsuk ezt a szolgáltatást a GF110 TDP limiterjéhez. Teljesen másról van szó. Az AMD TDP limitert már a HD 5000-nél is alkalmazott, ráadásul teljesen hardveres védelmet. Az NV egy félig hardveres védelmet használ, amit természetesen ki lehet ütni, amíg nem érkezik egy új driver.

Nem hasonlítsuk ezt a szolgáltatást a GF110 TDP limiterjéhez. Teljesen másról van szó. Az AMD TDP limitert már a HD 5000-nél is alkalmazott, ráadásul teljesen hardveres védelmet. Az NV egy félig hardveres védelmet használ, amit természetesen ki lehet ütni, amíg nem érkezik egy új driver. -

SzlobiG

félisten

"Ezen felül lesz TDP menedzselő része a Caymannek, ahogy a GF110-nek is van. A nagy különbség az lesz, hogy ez vezérelhető lesz az OverDrive szoftverből, nem lesz megkötve a kezünk"

Érthető a megoldás ezzel bent tudnak maradni a 300W-ba, de aki kicsit is ért hozzá úgy is kikapcsolja aztán had szóljon.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

vzsryl

nagyúr

-

Abu85

HÁZIGAZDA

válasz

DemonDani

#2709

üzenetére

DemonDani

#2709

üzenetére

Eléggé. A modellek meglehetősen méretesek, de csak a modell szelete kell. Persze ettől a tesszellálás még nem lesz gyors. Továbbra is rengeteg felesleges munkát végez a rasztermotor. Ha jól tudom, akkor a Cayman is 2x2 grides feldolgozást használ. Egy kis háromszögnél a négyből három pixelt feleslegesen tesztelsz.

A HAWX 2 nem probléma, mert a driverben lecserélik a tesszellálási algoritmust egy hatékonyabbra. Túlzottan luxus, hogy a raszterizálás hatékonysága 50% alatt legyen. 90% az a minimum, ami elfogadott, akkor kevés erőforrás megy veszendőbe. Ezzel a játék jelentősen gyorsabban is futhat, hiszen a raszteres kalkulációk felét nem kell eldobni.

-

DemonDani

addikt

az off-chip feltételezem vramra utal, mennyire vram igényes dolog ez? egy komplexebb játéknál egészen annak hangzik, de feltételezem hogy megoldották valahogy, vagy ez is eggyel több indok a 2gb vram mellett?

bár komolyabb game talan a hawx2 van ahol nagyon "elvan" a tesszelalas

-

DemonDani

addikt

A Tesszelátornál az Off-chip buffer a 2 tesszelátor egység miatt szükséges ugyan?

-

Abu85

HÁZIGAZDA

A HD 5970 2x1 GB volt.

Igazából senki sem csal, de eléggé gáz, ha egy cég annyira szelektíven gondolkodik, mint az NV. Mindketten csinálják az FP16 demotiont, de ez csak akkor baj, ha az AMD alkalmazza. Valójában az Nv-nek az a baja, hogy az AMD jobban oldotta meg, és többet gyorsulnak a Radeonok. Ezt a problémát úgy lehetne rendezni, ha a GeForce driverben is kikapcsolható lenne az optimalizáció, és megkérné az NV a weboldalakat, hogy kikapcsolt optimalizációval teszteljenek. (mi szó nélkül megtennénk) Erre az AMD is azt mondta, hogy neki megfelel. Az nem felel meg az AMD-nek, hogy a Catalystben kikapcsolod az optimalizáció, míg az NV-ben ottmarad. -

nem egészen - azt írtam, hogy szerintem a full GF104-et sem fogná vissza. a teljesítmény fullHD felett inkább a raszterizálás miatt eshet sokat - míg a GF100-nál 32 pixel / clock jut a 48 ROP-ra, itt már csak 16 pix jut a 32 ROP-ra.

ja, az 1GB már sokszor kevés az Eyefinity-hez.

DemonDani: igen, az nekem is feltűnt az architektúra ábrákon, hogy 4 TEX / SIMD, és semmi kavarc. ha ez tényleg így lesz, és lesz benne 120 TEX...

-

Abu85

HÁZIGAZDA

Ezt írtam én is. A GTX 460 elmegy, enyhén limitálja az biztos, mert sokat esik a teljesítmény Full HD felett.

A teljes értékű GF104-re mondtam, hogy limitálná. De nyilván ezért nincs ilyen termék.(#2698) TTomax: Azért lesz rajta 2 GB, mert 1 GB kevés, viszont ezzel a felépítéssel 2 GB a következő lépcső.

(#2696) Hakuoro: Ebben az a szép, hogy szapulják az AMD-t az utóbbi két driverben kikapcsolható FP16 demotion miatt, amikor az optimalizáció, vagy nevezzük úgy, ahogy az NV hívja CSALÁS a GeForce driverekben ki sem kapcsolható.

Egy publikusan nem elérhető fájlt szokott az NV küldeni, amit le kell futtatni a deaktiváláshoz.

Egy publikusan nem elérhető fájlt szokott az NV küldeni, amit le kell futtatni a deaktiváláshoz.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Anime filmek és sorozatok

- Kódolás Qwen3-mal saját gépen, Cline AI-alapú autonóm kódolási ágenssel

- LEGO klub

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- AMD Ryzen 9 / 7 / 5 / 3 5***(X) "Zen 3" (AM4)

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- BIOS frissítés

- nonsen5e: DPD tapasztalatok

- Elektromos autók - motorok

- E-roller topik

- További aktív témák...

- ASUS ROG Strix GeForce RTX 3090 24GB

- GIGABYTE GeForce RTX 2080 TURBO OC 8GB GDDR6 videokártya (használt)

- Csere-Beszámítás! MSI Gaming X RTX 4060Ti 16GB GDRR6 Videokártya!

- PowerColor AMD RX5700XT 8GB / Újszerű állapotban / 6 hónap jótállással / számlával

- ÁRGARANCIA! Beszámítás, 27% áfa, 5db Sapphire Nitro+ RX 9070XT 16GB készletről BOMBA ÁRON!

- Apple iPhone 15 Pro 128GB, Kártyafüggetlen, 1 Év Garanciával

- Azonnali készpénzes AMD Radeon RX 6000 sorozat videokártya felvásárlás személyesen/csomagküldéssel

- BESZÁMÍTÁS! MSI B450M R5 5600X 32GB DDR4 512GB SSD RTX 3060 12GB Rampage SHIVA Zalman 600W

- Magyarország piacvezető szoftver webáruháza

- Intel X540-T2 dual-port 10GbE RJ45 hálózati vezérlő (10Gbit, 2 port, áfás számla, garancia)

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Pont olyan mint egy CPU csak fizikailag nagyobb, beletolod az alaplapba és megy. Jó... ehhez még driver is kell a procihoz általában nem.

Pont olyan mint egy CPU csak fizikailag nagyobb, beletolod az alaplapba és megy. Jó... ehhez még driver is kell a procihoz általában nem.

.

.![;]](http://cdn.rios.hu/dl/s/v1.gif)

Nem lehet ilyen gyorsan lépni.

Nem lehet ilyen gyorsan lépni.

. Újabb 8 hónap eltelt és nem az AMD, hanem az Nvidia jött elő egy megújított csúcs GPU-val. A Bartsra pedig előbb fog jönni válasz, mint jött a GTX460-ra.

. Újabb 8 hónap eltelt és nem az AMD, hanem az Nvidia jött elő egy megújított csúcs GPU-val. A Bartsra pedig előbb fog jönni válasz, mint jött a GTX460-ra. .

.

.

.

Talán az áraknak is jót fog tenni.

Talán az áraknak is jót fog tenni.

.

.