-

Fototrend

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

X2N

őstag

Azt is vedd figyelembe hogy ezek között a render engine-k között is vannak különbségek. Mindegyik máshogy kezeli kicsit a SSS, a hajat, árnyékokat fényeket. Van ami kifejezetten karakter renderelés az erőssége, más render engine épületek renderelésében brillírozik, vannak teljesen általános engine-k, van ami kifejezetten a pontosságra megy rá és tud pl. caustic-ot és fény hullámhosszokat szimulálni amivel optikáka is le lehet tesztelni. itt egy Blender cycles és UE Path tracing/Lumen összehasonlító videó, látszik hogy nem ugyanaz, nem is fogod tudni megcsinálni ugyanolyanra, még ha lenne 3 hozzáértő ember aki kifejezetten az adott engine-re van specializálódva. A videóban látszik hogy nagyon konzisztens a cycles az UE5 Path tracerhez képest, és a Lumen is jól néz ki helyenként jobban mint a PT...

-

X2N

őstag

Én inkább játszanák a nem felskálázott nem denoiseres zajosabb de élesebb RT-s képpel csak ne kellene a rengeteg post process dolgot futtatni még ez után is ami sok ideig tart és amúgy is csak növeli a render időt. Filmek is zajosak, ha magas iso-n filmezik, senkit nem zavart eddig se. Quake/Portal RTX-ben ki lehet próbálni milyen denoiser nélkül...

-

X2N

őstag

A szintén Maxwell 980Ti-nek csak 649 USD az MRSP-je, RT-ben ugyanazt a sebességet "tudja" mint a Titan X csak kevesebb vram-al. 1080Ti meg "csak" 700USD volt anno, szóval ha kettőt veszel belőle még mindig olcsóbb mint ma egy 4090-es(9-10-es szériát össze is lehetett kötni, és akkor összeadódott a 6-11GB vram, (2015-ben lassan 10 éve!!!

![;]](//cdn.rios.hu/dl/s/v1.gif) ) 200%-os gyorsulást jelent raytracingbe a 2db kártya, ellentétbe a 3 vagy 4db kártyával ahol már sajnos nem gyorsul 3-4X-esére... így nem igazán éri meg, ezt már inkább mozgókép renderelésre rakták össze anno, amire később az nvidia ki is hozta a saját Nvidia GRID gépét 8 GPU-val, de láttam már gépet 11-12 vízhűtött gpu-val ugyanekkora méretben építve...

) 200%-os gyorsulást jelent raytracingbe a 2db kártya, ellentétbe a 3 vagy 4db kártyával ahol már sajnos nem gyorsul 3-4X-esére... így nem igazán éri meg, ezt már inkább mozgókép renderelésre rakták össze anno, amire később az nvidia ki is hozta a saját Nvidia GRID gépét 8 GPU-val, de láttam már gépet 11-12 vízhűtött gpu-val ugyanekkora méretben építve...

Ennyit a fejlődésről. -

-

X2N

őstag

Szerintem nézz utána hogy az nvidia path tracing megoldása(ami nem is az övék) amit az Omniverse-ben is használnak jelenleg melyik render engine-n alapul és az hogy is került hozzájuk, melyik szoftvercéget kellett hozzá felvásárolniuk...ez sem saját fejlesztés. Persze ebbe lettek utólag belefejlesztve dolgok, de én láttam miket fejlesztettek bele az utóbbi 8-10 év alatt(mert ezt használtam, sőt használom a mai napig, a 8-10év alatt kb 2x volt jelentősebb update, 1X egy 40%-os gyorsulás...), hát nem sokat fektettek bele, pedig lehetett volna, már le van maradva az omniverse-ben használt render engine a piacon lévőekhez képest...out of core geometry/textures-t a mai napig napig nem kezeli, pedig igény lenne rá...az Otoy Octane pl sokkal több mindent tud...az tudja ezt is...

Az hogy mi ad jó vizuális eredményt nem TE fogod eldönteni továbbra sem. Ez a TE személyes véleményed.

cucka-Akkori kor csúcskártyáját hasonlítottam össze a jelenlegivel. Árban kb. ugyanannyiba kerül, régen ennyire volt olcsó 4db Titan X, ma meg ennyire drága 1db 4090...

-

PuMbA

titán

"Soha az életben nem fogjuk ezt gyorsan megoldani, amíg feketedoboz az API-nak ez a része."

Persze, ezen dolgoznak majd az iparágban. Mindenesetre az SW Outlaws-t tényleg azért nem hoznám eme két játék mellé, mert ahogy láttam a víz tükröződések például nagyon zajosak benne. Nem tudom, hogy hanyad felbontáson vagy hány sugárral számolódnak.

X2N: Értelek, de engem nem érdekel, hogy kié, ezért nem is említettem meg eddig egy hozzászólásomban se. A lényeg, hogy ki hozza el a játékokba

Mit ér az agyamban

Mit ér az agyamban "Az hogy mi ad jó vizuális eredményt nem TE fogod eldönteni továbbra sem. Ez a TE személyes véleményed."

Persze, hogy nem. De azt látjuk, hogy jelenleg a legjobb kinézetű eredményt játékokban RT esetén a Path Tracing adja Ray Reconstruction-nel. A jövőben ez lehet másképp lesz, valszeg az UE5 megoldása.

-

PuMbA

titán

Igen, én is az Avatar és a SW Outlaws megoldása mellett vagyok és ahogy írtam, van mit optimalizálni a Path Tracing-en. Csak azt akartam mondani, hogy kiválóan néz ki a Cyberpunk 2077 és az Alan Wake 2 Path tracing-gel. Nehezen tudnánk felsorolni jobban kinéző játékokat.

-

Abu85

HÁZIGAZDA

De nem tudják megcsinálni, amíg az API-k által használt egyedi BVH adatstruktúra-formátum zárt. Ez nem fejlesztői gond, hanem maga az API van rosszul felépítve. Pontosabban a legnagyobb gond az, hogy az RT-hez szükséges formátumot nem nyitották meg, mert ha megnyitnák, akkor kinyílna a feketedoboz. És ezen már régóta vita van, mert igazából nagy dolgokat ez a formátum nem rejt. Pusztán a hardveres implementációhoz oda kell adnia gyártóknak, hiszen erre kell tervezniük a hardvereiket. Tehát a zártság ebben a formában csak azt tudja szolgálni, hogy az adott effekteket ne lehessen gyorsan megcsinálni, hogy minél drágább hardvereket kelljen venni. Nem vételen, hogy az Ubisoft az Avatarban egy saját formátummal mennyivel gyorsabban megoldotta az RT. Az nem túl jó cím a gyártóknak, mert nem kell a legdrágább hardver hozzá, mert megkerülte az Ubisoft a feketedobozt.

Sajnos az Until Dawn egy elég problémás eset, mert ott folyamatos gondok vannak a képgenerálóval. Például az, hogy esetenként random kikapcsol, és senki sem tudja, hogy miért. Az egész implementáció rossz. De nem működött ott az RT, ami megint ugyanaz a gond volt, hogy nem tudni mikor működik és mikor nem. Még a HDR is problémás továbbra is.

Tökéletestől messze van, mert sokkal több erőforrást levesz, mint elméletben kellene. De ugye megint az a gond, hogy a fejlesztők nem tudják előre, hogy gyors lesz-e a kód vagy lassú, és ha lassú, akkor hogyan lehetne gyors.

-

PuMbA

titán

"Sajnos nem, nagyon rossz az eredmény, és iszonyatosan sok a panasz az API-ra."

Nem panaszkodni kell, hanem megcsinálni

Ez hasonlít arra, hogy mennyi a panasz a tök egyértelmű és open szósz FSR 3.1-re, ahol még két patch után se bírták megcsinálni, hogy működjön az FSR frame generation az Until Dawn esetén, miközben a DLSS frame generation pöccre megy a játék kiadása óta.

Ez hasonlít arra, hogy mennyi a panasz a tök egyértelmű és open szósz FSR 3.1-re, ahol még két patch után se bírták megcsinálni, hogy működjön az FSR frame generation az Until Dawn esetén, miközben a DLSS frame generation pöccre megy a játék kiadása óta.Ha az AMD FSR 3 rossz implementálása esetén a játékfejlesztőkre lehet húzni a lepedőt, ahogy le szoktuk írni ebbe a topikba, akkor szerintem itt se kivételezzünk. Alan Wake 2-ben és Cyberpunk 2077 esetén tökéletesen működik a Path tracing.

-

Abu85

HÁZIGAZDA

Sajnos nem, nagyon rossz az eredmény, és iszonyatosan sok a panasz az API-ra. Ha jó eredményt adna, akkor launchra el tudnák készíteni a működő RT-t, de például nemrég a Star Wars Outlaws esetében a PT úgy lett implementálva, hogy hol működött, hol nem. És nem azért, mert így akarta az Ubisoft, hanem azért, mert nem látható a fejlesztő számára, hogy x helyen miért működik, y helyen pedig miért nem. És még ma is van olyan területe a játéknak, ahol valamiért nem működik a PT, annak ellenére sem, hogy aktiválod. Nem tudják, hogy miért, mert black box az egész. Azt tudják, hogy a saját pipeline-juk mikor jó és rossz, az követhető, de a PT külön pipeline-on megy, arra nincs ráhatásuk, és ha ezt összerakod, akkor elég szar dolog, hogy be tudsz építeni valamit, de nem tudod garantálni, hogy mindenhol aktív legyen, sőt, nem tudod, hogy ahol nem kapcsol be ott miért nem. Ez maga a rossz eredmény.

A Megalights az egy alternatív megközelítése annak. És pont azért tervezi magának az Epic, mert ők sem tudják garantálni azt, hogy az NV implementációja működjön, mert nem látnak a driver mögé, nem látják, hogy mi van a feketedobozban. Csak ugye erre nem mindenkinek van erőforrása, mert meg kell kerülni hozzá az API-nak azt a részét, ami a feketedobozt adja. Plusz, ha ezt megkerülöd, akkor az RT hardverek egy részét sem használhatod, mert nem ismered azt a formátumot, amit ezek a hardverek elfogadnak, tehát szoftveres módra kell váltani hozzá, vagyis az ALU-kat kell terhelni a hardverbe épített RT részegységek egy része helyett. Nem mind helyett persze, mert ütközésvizsgálatot gyorsíthatod, de a hardver egy részét elveszíted, és ha ezt elkezdik megkerülgetni, akkor felmerül az a kérdés, hogy mi a fenének vannak beépítve, ha végül nem használják a fejlesztők.

-

PuMbA

titán

-

Abu85

HÁZIGAZDA

Az ezen semmit sem segít. A probléma az API, nem maga a hardver. Pontosabban az a gond, hogy az egész RT egy nagy black box még ma is.

Már az elején kapta ezért az ívet a Microsoft. Az egész sugárkövetés egy nagy feketedobozként valósul meg bennük. Vannak bizonyos funkciók, amelyeket a shaderekben meg lehet hívni, de ezek nagy része limitált lehetőségeket ad, és maguk az API specifikációk is rendkívül titkolózók az alkalmazott BVH adatstruktúra-formátumával kapcsolatban. Utóbbit nyilván nem is kell ismerni, mert a jelenlegi modell a Vulkan és a DirectX Raytracing esetében is annyiból áll, hogy a limitált lehetőségek szerint megírt kód alapján a driver majd csinál valami, fejlesztői oldalról láthatatlan "fekete mágiát", és ha jó az eredmény, akkor örülni kell. És itt ez pont annyira jó, amennyire rossz, mert felmerülhet a kérdés, hogy mi van akkor, ha nem túl jól muzsikál a megírt kód? Ez a bonyolultabb eset, ugyanis ilyenkor a végére kell járni annak, hogy hol a gond. Netán az alkalmazott gyorsítóstruktúra egyes limitációi erősödtek fel? Lehet, de mivel ez nem ellenőrizhető, így biztosra nem jelenthető ki. Elképzelhető, hogy a munka ütemezése kapcsán került homokszem a gépezetbe? Nem kizárható, de nem tudni, hogy mi az optimális egyensúly az erőforrás-kihasználásban, amire törekedni kellene a sugárkövetés használatakor. És ezeket a kérdéseket lehetne még folytatni, viszont egyértelmű válasz egyikre sincs, mert minden teljesítményt meghatározó döntés a futtatási környezeten vagy a meghajtón belül történik, gondosan elrejtve a fejlesztői szemek előle. És nem azért, mert ez így jó, hanem azért, mert ezt az implementációt követeli meg a Vulkan és a DirectX Raytracing API. Szóval a szabványos sugárkövetéssel kihozható valamilyen módon egy adott sebesség, akár úgy is, hogy a sugarakkal való kalkuláció virtuális távolságát korlátozzák, de érdemi előrelépést biztosító optimalizálásokra nincs lehetőség, mert a szabványos implementációk ezeket egyszerűen nem teszik lehetővé. És amíg ez nem változik meg, addig hozhatnak alá akármilyen hardvert, nem látják a fejlesztők, hogy miért lassú, amit írtak. Ha meg gyors, akkor örülnek, mert sajnos azt sem tudják, hogy miért gyors.

Tulajdonképpen a mostani módszer abból a szempontból brute force, hogy gyakorlatilag csak csinál valamit rejtve mélyen a driver mögött, és fingod sincs róla fejlesztőként, hogy amit éppen akarsz, azt gyorsan fogja megtenni vagy lassan. Nincs előre tervezhetősége a nagymértékű programozhatóság hiányában. Ez egy API probléma, bármilyen hardvert hozol rá, ha az API nem változik meg, a nagymértékű erőforrás-pazarlás megmarad.

-

PuMbA

titán

"Az egész RT ahogy ma van játékokban, csak trükközés nem is valódi RT, minden késik, zajos, nem számolja távolra a sugarakat, nincs elég iteráció stb. egy kalap sz.r az egész, ha tudod mit kell nézni.."

Erre van az NVIDIA Ray Reconstruction-je, hogy ne késsen és ne legye zajos

AMD VGA-val sajnos nem tudod bekapcsolni és megnézni, de a YouTube-on jól látszik Cyberpunk 2077 alatt, hogy nagyon megdobja a tükröződések részletességét, eltünteti a zajosságot, kisebb késleltetés mellett. Kár, hogy AMD kártyákra még nincs ilyen.

AMD VGA-val sajnos nem tudod bekapcsolni és megnézni, de a YouTube-on jól látszik Cyberpunk 2077 alatt, hogy nagyon megdobja a tükröződések részletességét, eltünteti a zajosságot, kisebb késleltetés mellett. Kár, hogy AMD kártyákra még nincs ilyen."Ilyen brute force megoldásokat erőltethetik tovább de nem fog menni 50 év múlva se."

Előbb azt írtad, hogy nem valódi RT, hanem trükközés, most meg brute force? Akkor melyik? Brute force módszer nem lesz szerintem, az felesleges, hiszen a raszter grafika is tele van trükkökkel.

-

X2N

őstag

válasz

Komplikato

#66279

üzenetére

Komplikato

#66279

üzenetére

"Most meg ki játszana élsimítás meg anizótropikus szűrés nélkül?"

Élsimítás nélkül játszom évek óta a 24" 4K monitoromon... Régen volt létjogosultsága az élsimításnak alacsony felbontásnál, de ma már abszolút nincs, a retina kijelzők idejében teljesen felesleges technika. Vehetne mindenki 4-5K-s 24" vagy 32 8K monitort és el is lehet hagyni ezt a technológiát, minimális SMAA kell ha nincs retina közeli felbontás de ennyi, a temporális képromboló eljárásokat el kell hagyni. Átlagosan szerintem a legtöbb ember látása sem olyan jó már hogy ilyen PPI monitort kihasználjon....van szemedbe épített MSAA...

-

válasz

Komplikato

#66279

üzenetére

Komplikato

#66279

üzenetére

Pontosan így gondolom én is

-

X2N

őstag

Ha megnézed a 4db 8 éves Titan X-hez képest egy mostani 4090 "gyorsaságát" csak annyi a jelentős különbség hogy jóval kevesebbet fogyaszt, nem mondanám jelentősen gyorsabbnak a 4090-est.. a preview-et elnézve. Mivel az SLI-t, Nvlinket is veszik már ki ezekből a kártyákból évek óta így csökken a használhatóságuk ezeknek a kártyáknak is az értéke ilyen komolyabb dolgokra...mert az igények is nőnek, nem csak a kártyák teljesítménye. 8! éve volt 12GB a kártyákon... Már 2016-ben vehettem volna ~180et-ért használtan hasonló 12GB-os kártyát aprón...

-

X2N

őstag

Látom már nem is tudod értelmezni amit írtam, késő van. ŐT húztam le, nem az nvidiát mert azt hiszi erről az egészről az nvidia tehet, pedig nem. Nincsen semmi bajom az RT-vel, imádom az RT-t, annyira hogy csak lassan 10+ éve 3d renderelek hobbiból. Csak zokon vettem, mert szerinte a játék fejlesztők(CD Project Red, Epic). nem csináltak l.faszt se persze... Csak az nvidia.

![;]](//cdn.rios.hu/dl/s/v1.gif) Valószínű hogy azért nincs a konzolba nvidia hardver mert annyira jófej cég volt mindig is az nvidia, hogy nem akar se a Sony se a Microsoft zárt technológiás hardvert tenni a saját fejlesztésű konzoljukba...emiatt bukták az ARM deal-t is.

Valószínű hogy azért nincs a konzolba nvidia hardver mert annyira jófej cég volt mindig is az nvidia, hogy nem akar se a Sony se a Microsoft zárt technológiás hardvert tenni a saját fejlesztésű konzoljukba...emiatt bukták az ARM deal-t is.

Nem tudna többet nyújtani az nvidia féle konzol, azt a konzolosok nem fizetnék meg.![;]](//cdn.rios.hu/dl/s/v1.gif)

Tudod a konzolnál fontos szempont az hogy egy APU-ba beleférjen minden, ezt az nvidia nem tudja megcsinálni, mert nem gyártanak processzort, ha nincs licensz...meg nem ártana ha az egész gép nem fogyasztana többet 350W-nál. Ami nem jellemző egy komolyabb nvidia kártyára manapság, milyen raytracinget akarsz kihozni ennyi teljesítményből?A fejlesztőknek kell eldönteniük hogy akkor raszterizációt használnak vagy RT-t, attól függően hogy miből profitál jobban a játékuk. Ezt nem az nvidia fogja eldönteni. Sok érv van a raszter mellett továbbra is.

2 évente lesz alig 2X-es gyorsabb RT teljesítmény-ben egy új nvidia kártya? Az k.va kevés RT-re...

Itt van mit tudott 4db Titan X 8 éve RT-ben...12000 Cuda maggal.

Lehet hogy nektek újdonság az RT, nekem nem, az hogy gyorsabb lett a hardver nem számít RT-nél, leírom miért is mert sokak még a mai napig nem értik miért is kevés amikor raszterbe már tapsikoltak +50% teljesítménynek....

Anno 4 magos Ivy Bridge géppel kezdtem el 3D-renderelni,

8-24 óráig! tartott egy kb. 1080p kép renderelése...és csak találgatni tudtam hogy mi lesz a végeredmény annyira nem lehetett látni semmit a preview renderből...

első komolyabb videokártyámat a GTX670-est is emiatt vettem többek között, ezzel már láttam körülbelül hogy milyen lesz a végeredmény még ha zajosan is, ezzel már csak pár órát kellett renderelni rendszerint, hacsak nem fogyott el a 2GB vram, mit lehet tenni, optimalizálni kell meg elküldeni a gyártókat melegebb éghajlatra, váltottam később 980Ti-re, ez a raszterbe 2X gyorsabb volt mint a 670, hát RT-be ezt nem igazán vettem észre, pedig cuda magban is közel 2x annyi volt rajta... így is kb fél óra/óra minimum amíg kevésbe zajos a kép, 6GB elég volt hosszabb ideig, akkoriban már kint voltak a 10-es kártyák is, csak lestük youtubon hogy a profik 4 kártyás rendszereket raknak össze 11GB-os 1080Ti-kel... és közel realtime lehetett mozgatni a 3D nézetet...még ha zajosan is de ki lehetett venni a jelenetet...aztán kijöttek az RTX-es kártyák, én egy 2060Super-t vettem, ez már kb felezte a render időt a 980Ti-hez képest(célhardver, valamit csak fel kellett mutatni nvidiának is már), jóval kevesebbet is fogyasztott, csak közbe jöttek olyan updatek is mint az OptiX, amik meg a régi kártyákon nem ment ezért sem air az összehasonlítás.. ami elég rendesen csökkentette a renderelési időt, jobban mint egy "újabb" generációs kártya. Aztán jött a bányászláz...és évekig nem volt fejlesztés, se több vram, akkoriban nekem már kevés volt a 6-8GB...kellett volna a 12GB. Ilyen kártya nem volt csak nagyon drágán, úgyhogy vettem új gépet, 6 magos 2600-as Ryzen-t, meg később le is váltottam egy sima 6 gigás 2060-ra... ha kifutott a vramból akkor ment procin a render, ott 32GB-al elfért sok minden. 2 éve vettem a mostani gépet(adatlapban), abból a célból hogy akkor már procival fogok renderelni azért is, még úgy is hogy a 7900XTX tényleg baromi gyors 3D renderre(~több mint 10x gyorsabb mint a 16 magos Ryzen), de a 24GB-ból is ki lehet futni, ha nem ma kezdte az ember...és mivel több 3D programot használok így rengetek komolyabb minőségű modellt rengeteg poligonnal, (20+millió fölött!) és 4K textúrával betudok dobni egy jelenetbe ahol ha akarom a 32GB úgy fogy el hogy öröm nézni...

Na most ha azt mondod nekem hogy a 4090 2X gyorsabb RT-ben kb le se fogom tojni mert teljesen mindegy, amikor eleve egy kapásból zajos képet renderel mindkettő. Az idő meg hogy nekem most 30 percet renderelek vga-n vagy 1 órát már kb mindegy, a procin továbbra is 8 óra, csak ott nincs memória limit... Ha ugyanannyi vram van az nvidián, akkor is a radaont veszem meg mert nem éri meg a 2x-es árat az nvidia.... -

Komplikato

veterán

"A RT egy kikapcsolható funkció"

És amíg ÍGY lesz, addig pont annyira túlértékelt semmi lesz, mint amilyennek az RT ellen prüszkölők mondják. Mert nem volt elég a vas hozzá még, és mert kikapcsolhatónak kell lennie, amíg ennyi RT mentes vas van még. Ez van. Most. De nem lesz mindig így.

Anno mikor a TNT1-nél a Creative behozta az élsimítást (!) sem sokan gondoltak rá, hogy egyszer alap lesz minden videókártyán. Jó pár éve már az volt a menő, ami nem fosta magát össze az élsimítástól. Most meg ki játszana élsimítás meg anizótropikus szűrés nélkül?Másrészt meg AMD kártyák igen is le vannak maradva RT teljesítményben, ha nem lennének, akkor nem várná mindenki, hogy igazak e a pletykák a következő generációról, ami állítólag már NEM lesz lemaradva. Emlékeim szerint még szegény hányatott ARC is jobb volt benne.

-

Értem én hogy ez a küldetésed,hogy lehúzd az Nvidiát és gyűlöld az RT miatt,de akkor sem azt írta hogy az Nvidia csinálta a path tracinget. Azt írta hogy amit azzal csináltak az eléggé csúcs manapság.

Ha rákeresel a CP2077 és az Alan wake 2 [link] ilyen játékok. Nem véletlenül a legjobbak jelenleg ebben, mindegyik zöld szponzorált játék.

A RT egy kikapcsolható funkció. Ennek is kell egy evoluciós fejlődés szoftveres ( amibe beletartozik a grafikus motork mellett az oprendszer, DX , API ) és hardveres.

AZ Ada sokkal többet tudna nyújtani RT ben, ha konzolban lenne, ahol kizárólag rá fejlesztenének DX megkötések nélkül, de jelenleg a szotfvereknek és hardvereknek hybrid működést és vissza fele kompatibilitást kell nyújtaniuk ami lassítja az előrelépést. Minden népszerű játékos hardver ami 2024- és 25 ben kijön, képes az RT olyan szintű kezelésére ami 8 éve elképzelhetetlen volt. nemsokára a játékmotorok csak erre fognak építkezni. -

X2N

őstag

válasz

Komplikato

#66271

üzenetére

Komplikato

#66271

üzenetére

A több fényforrás éppenséggel nem probléma RT-nél inkább előny...mert ha nincs fény ott több a zaj is az meg rosszabb képminőséget is eredményez, ezért látod az RT-s játékokban olyan rossz minőségűnek az árnyékokat.

-

X2N

őstag

Le se írta hogy mit is csinált az nvidia a Path Tracingel csak megy az áradozás a nagy semmiről. Mint mindig. Mutattak valami megint az Epic-nél is erre mindenki szakértő lett Megalights-ból is. Közben meg évek múlva lesz ebből játék ami ezt majd ki is használja mint a többi feature-t amit tud az engine mert jelenleg is bugos még.

Ahogy a várva várt nvidia féle Racer RTX-ből se lett semmi a mai napig...

-

X2N

őstag

Mi köze van az AMD-nek a gyenge RT-hez? A játékfejlesztő sara hogy nem úgy csinálta meg a játékot. Meg se jelent még az RDNA4 de te már tudod hogy nem kell visszafogni az RT komplexitást? Mégis milyen komplexitást? 70-es évek óta volt már erről szó, akkor is kevés volt rá a hardver, ma is az. Ilyen brute force megoldásokat erőltethetik tovább de nem fog menni 50 év múlva se.

Az egész RT ahogy ma van játékokban, csak trükközés nem is valódi RT, minden késik, zajos, nem számolja távolra a sugarakat, nincs elég iteráció stb. egy kalap sz.r az egész, ha tudod mit kell nézni...developer móddal a játékokban rendszerint ki lehet kapcsolni TAA-t, sharpeninget, Denoisert...

A fizetős cyberpunk RT shader mod-vel amit a youtubon mutogatnak is csak azért néz ki legjobban mert agyon van nyomorítva a DOF-al a kép és nem látsz tovább élesen 5 méternél tovább így ha közelre nézed az autókat pl nem rossz a látvány mert kb eddig van benne raytracing...leg látványosabb játék ami RT-s az továbbra is a Minecraft RT, másik kiemelkedő játék mellette a Control, ahol elég jók a tükröződések...de ott is kedvez a setting a raytracingnek...belső zárt tér, iroda, üvegablakok...a RT GI és az RT árnyákok már távolról se voltak olyan jók...Nem az nvidia csinálta meg a path tracinget. James Kajiya volt 1986-ban majd ezt is továbbfejlesztette(Monte Carlo method) 1997-ben Eric Veach és Leonidas J. Guibas.

Ennyire "új" a technológia. Felesleges itt az nvidiát sztárolni bármiért is.

Monte Carlo method féle RT/PT-t te a büdös életbe nem fogsz játékba látni. Ami a jelengeg Blenderben alapértelmezett Cycles render engine sem tud olyan pontosan szimulálni mert nem is az a cél, és már erre is kevés a jelenlegi csúcs hardver is. -

Komplikato

veterán

Na jó, de az NVidia RTXDI-val UE5-ben két tucat fényforrással egy RTX4090 is megmakkan, a Megalights techdemójában meg elvileg 1000 fényforrás volt.

Én nem akarok ezer fényforrást a játékokba, mert minek, csak nagyon kevés helyen lehet indokolt, de RT játékokban is jó esetben volt egy-két fényforrás, ehhez mért árnyékokkal vagy azzal se.

Ezért nézhetett ki sokkal jobban a PatchTracing a Cyberpunk 2077-ben, a szép részletes árnyékokkal, de milyen áron?

Nyilván erős kompromisszumokkal, de valami távolról hasonlót össze lehet hozni MegaLights-szal, csak félmilliós VGA nélkül. Azért ez is egy előrelépés. Mert az RT elleni jogos kritika volt, hogy HA kihasználnák a játékok, akkor egy RTX3060-at vagy RX6600-at kenhetne a hajára a kedves játékos. És ez igaz is volt.

Szóval jelenleg ebben látom a normális RT játékok eljövetelét. Tévedés jogát fenntartom. -

PuMbA

titán

A videóban az is ott van, hogy főleg az AMD által szponzorált címekbe került gyenge RT, hogy normálisan fusson az AMD kártyákon. Ennek meg az lett az eredménye alig látszik a különbség a raszterhez képest

Na de végre az RDNA4-gyel ennek vége lesz, hogy vissza kell fogni az RT komplexitását.

Na de végre az RDNA4-gyel ennek vége lesz, hogy vissza kell fogni az RT komplexitását.Komplikato: Igen, de a Megalights-ban is vannak még lólábak. DigitalFoundry jól látta, hogy az RT effektek valamennyit késnek a tükröződő objektumhoz képest, á lá Cyberpunk 2077 tükröződések Ray Reconstruction nélkül, illetve még az RT-ben lévő objektumok távolsága se valami hű de nagy. Amit az NVIDIA megcsinált a Path Tracing-gel az a mai napig a csúcs és nem véletlen megy 4090-en úgy, ahogy. Biztos van még rajta mit optimalizálni, de a Megalights bemutatót látva érthető, hogy miért.

-

Komplikato

veterán

Ezért örülök az UE5.5-ben bemutatott MegaLights megoldásnak, mert a csak itt-ott megjelenő RT a játékokban lehetetlenné tette, hogy érdemben kihasználják a játékok az RT lehetőségeit, mert mennie kellett kenyérpirítón is mennie kellett. A MegaLights meg eleve csak RT vason fog menni. Viszont jó időre elássa a realtime PathTracing-et szerintem. Csak hát ugye minimum vagy 2 év, mire ezzel jönnek majd a játékok.

-

válasz

hahakocka

#66265

üzenetére

hahakocka

#66265

üzenetére

Nem mindíg. Van ahol igen, ezeket főleg az Nvidia PC címek, de van ahol értelmetlen.De ezt eddig is tudtuk.

Ahogy a végén összefoglalja, ez a játékipar jövője és fontos dolog,de szükség lenne arra hogy megfelelően használják a játékészítők.

Sajnos jelenleg még arra sem képesek sok esetben, hogy RT nélkül adjanak ki vállalható sebességű játékokat.

Érdekes és visszás dolog, hogy a DLSS és FSR arra készteti a fejlesztőket, hogy ne optimalizáljanak sebességet ,ahelyett hogy arra használnák, hogy az RT-t és a különböző eszközöket minél jobb minőségben építsék be a játékokba.Egyre jobb hardverekkel rendelkezünk és egyre roszabb minőségű portok jönnek ki PC-re.

Tisztelet a kivételnek, szerencsére vannak kivételek és jól hazsnált RT címekben. Mint pl CP2077, Alan Wake, Metro, stb.. -

PuMbA

titán

válasz

hahakocka

#66265

üzenetére

hahakocka

#66265

üzenetére

Én is néztem nem rég

A Path tracing-gel és a tisztán RT-vel (Metro Exodus EE) rendelkező játékokban van a legnagyobb látványbeli különbség, a többi játékban inkább csak tessék-lássék kategória egy-két effekttel. Főleg az NVIDIA szponzorált játékokban van eddig nagyobb látványbeli különbség. Az Unreal Engine 5 meg a Snowdrop 2 indítja meg jobban majd az utat, mert muszáj az alapoktól kezdve RT-re felépíteni a játékokat, hogy legyen értelme.

A Path tracing-gel és a tisztán RT-vel (Metro Exodus EE) rendelkező játékokban van a legnagyobb látványbeli különbség, a többi játékban inkább csak tessék-lássék kategória egy-két effekttel. Főleg az NVIDIA szponzorált játékokban van eddig nagyobb látványbeli különbség. Az Unreal Engine 5 meg a Snowdrop 2 indítja meg jobban majd az utat, mert muszáj az alapoktól kezdve RT-re felépíteni a játékokat, hogy legyen értelme. -

hahakocka

őstag

Is Ray Tracing Good?

HWU elemzésHát igen ezért is tartottam az RT től megéri az a 25-30% sebesség esés legalább ? Nem mindig legalábbis e gamekben

-

Abu85

HÁZIGAZDA

Igazából megoldható. Az AFMF2 egy szoftver, ami a játéktól csak végleges képkockát vár el. Tehát a képkockákat számolhatja a GeForce, az AFMF2-t pedig egy Radeon hozzá. Na most persze ez az elmélet, és elméletben működik is, de persze garanciát egyik gyártó sem fog vállalni kevert konfigra. Emellett ugye több játék esetében van olyan, hogy ha kevered a gyártót egy gépben, akkor nem feltétlenül engedi meg azt, hogy te válaszd meg azt az adaptert, ami fut a program, az esetek többségében hardcoded szinten Radeonra kényszerülsz.

-

Yutani

nagyúr

válasz

mozesapo

#66259

üzenetére

mozesapo

#66259

üzenetére

Próbáld meg elfogadni, hogy a DLSS egyelőre superior a többi felskálázóhoz képest. Ez van, az AMD-nek és a többieknek dolgozniuk kell még a saját megoldásukon. Egyébként meg a Geforce kártyák nem az ördögtől valók, vegyél egyet és nézd meg magad. A fórumon szórakozó emberkék keltik benned ezt az érzetet, de ezek csak egy gyártó megvásárolható termékei, lehet élvezni a használatukat mindenféle fanboyság nélkül. AMD dettó.

-

mozesapo

tag

válasz

Busterftw

#66257

üzenetére

Busterftw

#66257

üzenetére

Ti hasonlítgattok egy 700 usd-s terméket egy 1500 usd-s pc-hez. Azért az nvidia már évek óta tréningezi a dlss-t. De szerintetek = jelet kell tenni a 2 hardver felskálázása közé. Sajnos ti trollkodjátok szét a topikot a dlss mindenek felett kijelentéseitekkel, aminek semmi köze a jövő amd gpuihoz. Igen mindkettő felskálázó van a körte felskálázó és az alma felskálázó. Mindenki azt veszi amelyiket akarja. Viszont nálatok ami nem a dlss az SZ*R! És ez az elvakultság már sok.

-

Busterftw

nagyúr

válasz

mozesapo

#66256

üzenetére

mozesapo

#66256

üzenetére

Mindketto felskalazo, mirol beszelsz?

Ha jon egy uj szereplo a piacra, az userekert es a technologiai elsosegert a mar piacon levo megoldasokkal kell versenyeznie.Tehat szerinted ha kijon egy uj automarka, elso modellel egy 25 ezer euros compact a piacra, akkor ne a 8-as Golfhoz hasonlitsuk, hanem az 1-eshez?

Csatlakozom a Raymondhoz, zt remelem nem gondolod komolyan es csak valami trollkodas. -

Busterftw

nagyúr

válasz

S_x96x_S

#66253

üzenetére

S_x96x_S

#66253

üzenetére

Igen egy focimeccsen. Meg a kovetkezon.

Aztan lehet beszelni a kovetkezo szezonrol.

Ettol meg az idei szezon szar es nem lesz jobb csak azert, mert te leadtad a fogadasod a WishfulThinking Ltd. bookie-nal."a diszruptív technológiák"

Az mar megjelent, 2019 februarjaban."Ezzel Abu-val vitatkozz."

PuMbA ezert a korabbi hsz miatt mondta azt, amit a kiindulo hsz-eben.

Ha ez neked nem volt tiszta, az a te sarad, kovesd jobban a topikot, persze ugy nehez, ha nem allsz meg es ertekeled a jelent, mert te mar varod a kovetkezo "2-3 ev latszatat", aztan a kovetkezo "2-3 ev latszatat".Szerintem meg ugorjunk, majd visszaterunk ra 2-3 ev mulva.

-

S_x96x_S

addikt

> Már lassan nem dolgokat beszélünk meg

> hanem feltételes állításokon megy a vita, amikben a bekövetkezési valószínűsége 10%.nehéz megállapítani a konkrét valószínűségeket a való életben,

de azért 10% esély a végzetes golyóra - egy orosz rulett esetén

már olyan nagy esély - ami miatt én már aggódnék.És egy céges stratégiánál - fel kell készülni mindenre,

és forgatókönyvek kellenek arra az esetre is, hogyha az a 10%-nak becsült esemény bekövetkezne.A probléma, hogy sokan ( a döntéshozók közül is )

nem tudják értelmezni a valószínűségeket. ( lásd aug.20-i tűzijáték és az OMSZ esete. )de a konkrét kérdés: mire érted és mi alapján állítod a "10%." -ot ?

-

S_x96x_S

addikt

válasz

Busterftw

#66249

üzenetére

Busterftw

#66249

üzenetére

> Igen is meg kell allni es kimondani,

> hogy mit ert el a beharangozott technologia, a merfoldkovek fontosak.Mint egy focimeccsen??

A sípszó előtt és alatt döntést hozni

és ott hagyni a stadiont, hogy lefutott a mecs, és nincs mit nézni?![;]](//cdn.rios.hu/dl/s/v1.gif)

[ A PS5 PRO 2024. november 7-től érhető el és most október van!! ]

Clayton Christensen elmélete szerint a diszruptív technológiák kezdetben alacsonyabb teljesítményt nyújtanak a meglévő technológiákhoz képest, de idővel fejlődnek és végül felülmúlják azokat. Persze a győzelem sose garantált,

De az nVidia se ihat előre a medve bőrére, látva a DF videót.Az nVidia számára az lenne a legveszélyesebb,

hogyha a PSSR és az RDNA4 optimalizációk átjárhatóak(kompatibilisek) lennének

és a PSSR optimalizációt az RDNA4 kártyák is fel tudnák használni.

Bár a PSSR a Sony technológiája - kehetséges, hogy keresztlicensz megállapodással az AMD is használhatja.> Erdekes, a kiindulo hsz-e pont arra vonatkozott,

> hogy meg sem jelent a PSSR,

> de itt mar messzemeno kovetkezteteseket vontak le, lasd Abu85:Ezzel Abu-val vitatkozz. Én csak a saját állításaimért tartozom felelősséggel.

És felesleges ezzel mindenkit letámadni.

Vagyok olyan kreativ, hogy nekem saját véleményem legyen mindenről - is.

De amúgy a DF videó kihangsúlyozta,

hogy egy 1 játék alapján ne vonjunk le messzemenő következtetést.

és ez alapján az is biztos, hogy önmagában a DF videó még nem cáfolja Abu-t.Szerintem többet akartok belelátni a DF videóba - mint ami.

-

PuMbA

titán

válasz

Busterftw

#66249

üzenetére

Busterftw

#66249

üzenetére

Köszönöm a kifejtést

Én nem szeretném, hogy ez a topik is lefele kezdjen el mozdulni, mint az internet nagy része. Például a híroldalakon a hírek jó része már nem is hír, sőt olyan "hírek" vannak már, hogy ez meg az történhet a jövőben. Kész őrület. Már lassan nem dolgokat beszélünk meg, hanem feltételes állításokon megy a vita, amikben a bekövetkezési valószínűsége 10%.

Én nem szeretném, hogy ez a topik is lefele kezdjen el mozdulni, mint az internet nagy része. Például a híroldalakon a hírek jó része már nem is hír, sőt olyan "hírek" vannak már, hogy ez meg az történhet a jövőben. Kész őrület. Már lassan nem dolgokat beszélünk meg, hanem feltételes állításokon megy a vita, amikben a bekövetkezési valószínűsége 10%. -

Busterftw

nagyúr

válasz

S_x96x_S

#66247

üzenetére

S_x96x_S

#66247

üzenetére

"Őt nem igazán érdekli a jövő és hogy mi lesz 1 - 2 - 3 év múlva"

Dehogynem erdekli, de 1-2-3 ev mulva, ja az mar a PSSR 2.0 vagy 3.0.

Majd megnezzuk hogy alakult. Most "kijott" a PSSR, megneztuk hogy alakult, nem ugy ahogy be lett harangozva.Ha ot nem erdekelni a jovo es mire lenne kepes a technologia, akkor leragadt volna a DLSS 1.0-nel. De nem, ahogy jottek az uj verziok, azokat ujraertekelte a jelenben.

Viszont nem ugy ervelt a DLSS-tol, hogy nincs rola semmilyen objektiv velemenye es csak tolja a "na majd nezzuk meg a 2.0-at, majd nezzuk meg ket ev mulva a 3.0-at, bezzeg a 4.0 megint ket ev mulva."Igen is meg kell allni es kimondani, hogy mit ert el a beharangozott technologia, a merfoldkovek fontosak.

"ebből még a PSSR-re nem érdemes messzemenő következtetést levonni"

Erdekes, a kiindulo hsz-e pont arra vonatkozott, hogy meg sem jelent a PSSR, de itt mar messzemeno kovetkezteteseket vontak le, lasd Abu85:

"Csak mondom, hogy a PSSR egyelőre minden felskálázót leigáz." -

PuMbA

titán

válasz

Raymond

#66246

üzenetére

Raymond

#66246

üzenetére

Az, trollkodás. A most megjelent elektromos autókat is az 1908-as Ford T modellhez hasonlítjuk....ja, nem

S_x96x_S: "PuMbA -t viszont csak az "élj a mában" és a jelen érdekli, és egyáltalán nem kiváncsi, hogy mire képes a technológia és a hw, amit a PS5 PRO-ba tettek."

Én kíváncsi vagyok, de semmit nem tudunk még

Az olyan spekuláció pedig, aminek semmi alapja nincs ide nem tartozik szerintem, mert ez nem az asztrológia vagy kártyából jóslás topik. Ez az AMD GPU-k jövője topik ésszerűen.

Az olyan spekuláció pedig, aminek semmi alapja nincs ide nem tartozik szerintem, mert ez nem az asztrológia vagy kártyából jóslás topik. Ez az AMD GPU-k jövője topik ésszerűen. -

S_x96x_S

addikt

válasz

Busterftw

#66244

üzenetére

Busterftw

#66244

üzenetére

> PuMbA csak ennyit csinalt, az elotte uberalles beharangozott PSSR-t

> az uj tesztek fenyeben a helyere tette.PuMbA - a "AMD GPU-k jelen" alapján nézi a dolgot

és ezt többször egyértelműsítette is.

Őt nem igazán érdekli a jövő és hogy mi lesz 1 - 2 - 3 év múlva.És emiatt nem is veszi figyelembe a hivatkozott DF videóban elhangzottakat,

hogy ebből még a PSSR-re nem érdemes messzemenő következtetést levonni.> A "nem jott ossze" eredmenyeket nem lehet csak annyival elintézni,

mert ?

- nézd már meg azt a videót alaposan - az elejétől a végéig - többször is.

- és nem tudom, hogy mennyire ismered az új konzolok - launch time - játékainak a színvonalát. A nagy részük előző gen-es port.A korrekt ítélethez adj egy kis időt.

PuMbA -t viszont csak az "élj a mában" és a jelen érdekli, és egyáltalán nem kiváncsi, hogy mire képes a technológia és a hw, amit a PS5 PRO-ba tettek.

de ez az ő nézőpontja.

-

mozesapo

tag

válasz

Busterftw

#66244

üzenetére

Busterftw

#66244

üzenetére

Mivel a pssr teljesen új, a korrekt összehasonlítás az FSR1.0-val, DLSS 1.0-val lenne, majd nézzük meg x év múlva. Körtét almával eset. Teljesen igaza van S_x96x_S-nek. Nézzük meg milyen volt az fsr1.0, dlss 1.0 és milyen most. Minden újdonságnak idő kell, hogy kiforrja magát. A mellékelt videó alapján a pssr is teljesen rendben van, főleg, hogy a csatlakoztatott eszköz egy tv készülék a konzolt használók többségénél, amit pár méterről néz. Ez az egész csak kukacoskodás, amit néha leműveltek itt a fórumon.

-

Busterftw

nagyúr

válasz

S_x96x_S

#66243

üzenetére

S_x96x_S

#66243

üzenetére

Viszont mivel (szerinted) gyorsan valtozik a technologia, gyorsabban is kielemezheto valaminek az eredmenye, vagy sikerult, vagy nem.

PuMbA csak ennyit csinalt, az elotte uberalles beharangozott PSSR-t az uj tesztek fenyeben a helyere tette.A "nem jott ossze" eredmenyeket nem lehet csak annyival elintezni, hogy reseteled gondolatod egy uj dologgal, megszorod a temat csillamporral es rozsaszin vattacukorral, majd beallitod az ebresztot megint, jovore. ("1-2-3 ev mulva lesz latszata")

-

S_x96x_S

addikt

válasz

paprobert

#66242

üzenetére

paprobert

#66242

üzenetére

> Azért abban egyetérthetünk, hogy

> egy spekulatív következtetéshez érdemes nem figyelmen kívül hagyni a jelent.pontosítanám:

Az is probléma, amikor valaki túlságosan a jelenre hagyatkozik,

ami amolyan stratégiai vakságot okozhat.------

Gyors technológia változáskor,

nem tudod milyen fejlesztések zajlanak a háttérben

mert a "publikus jelen" <> " a valós jelen"- el

a leak-ek fele téves vagy direkt megtévesztés,

és nehéz eldönteni, hogy a saját és a rivális technológia mire lesz képes

és melyik technológia lesz zsákutca.Az AMD például a GPU chipletes technológiánál nem várt nehézségekbe ütközött

és bár az MI300X az RDNA3 - tapasztalatain is alapul,

de nem képes a játékok támogatására

ami várhatóan a jövőben az UDNA -val történik meg.A technológia menedezsmenten próbáltak jó pár téves asszociációt kiverni a fejünkből.

pl. nem mindig a jobb technológia nyer, mert sok más dolog is közrejátszik.

- A VHS például rosszabb minőségű volt mint a Betamax.

de mai példákat is fel lehet hozni:

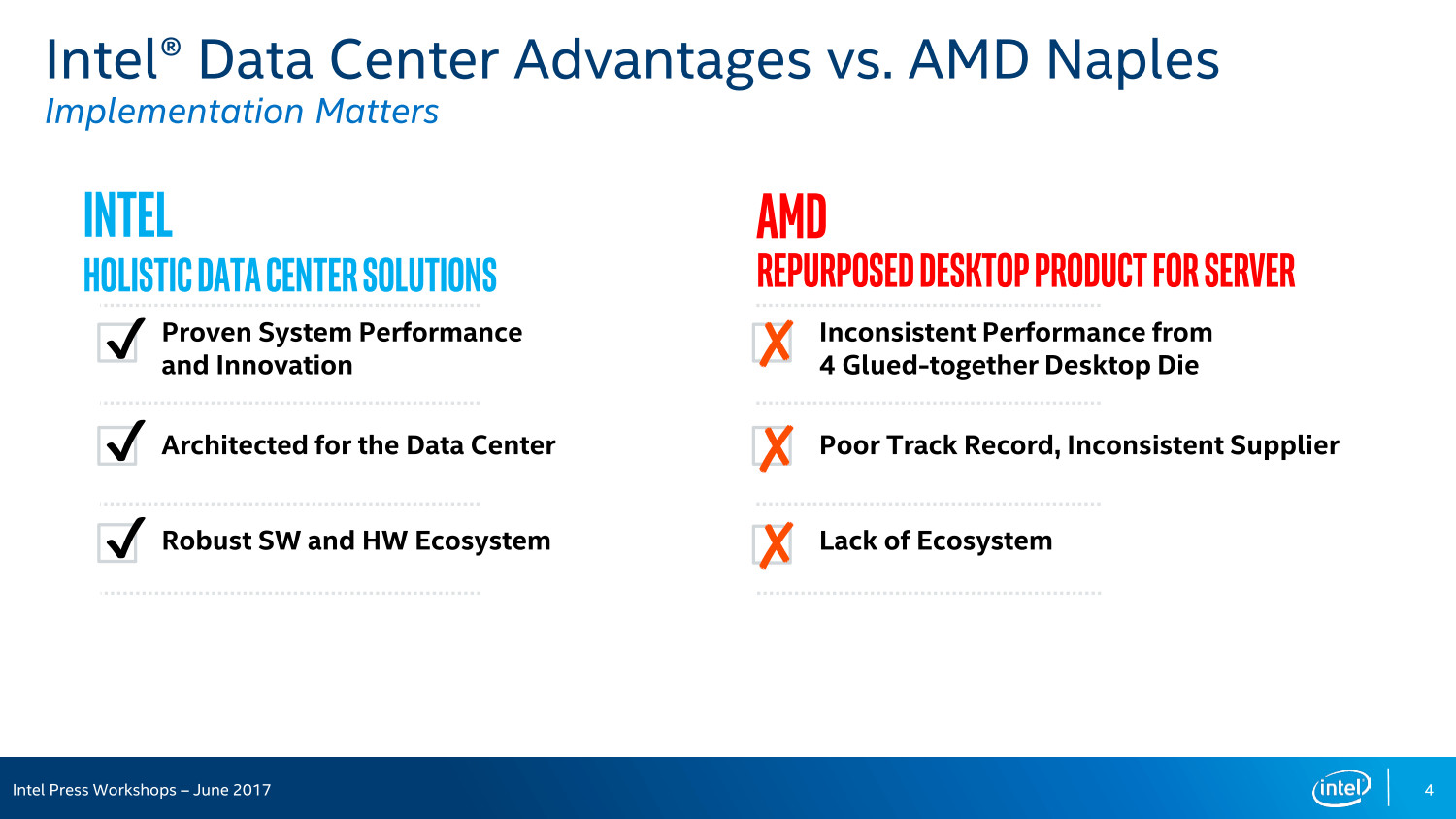

- "AMD FreeSync technology" vs. nVidia G-SyncÉs ha visszamész az időben 2017 -re - akkor a tények pont az AMD ellen szólnak,

amire az Intel rá is mutatott ( "Glued-together" )

És az Intel az akkori jelen és az akkori múlt alapján

egyáltalán nem érezte fenyegetésnek az új AMD stratégiát,

és túl későn kezdett el reagálni.

és ezt amolyan stratégia rövidlátás, hogyha valaki túlságosan a jelenre fókuszál.És az Intel teljesen figyelmen kívül hagyta az alapitó ( A. Grove ) üzenetét.

"Csak a paranoidok maradnak fenn"

„Andy Grove mesterien használja fel saját és az Intel tapasztalatait, hogy meghatározza és elemezze a stratégiai inflexiós pont szerepét egy fejlődő vállalkozásnál.

Aki szívén viseli üzletének sikerét, annak el kell olvasnia ezt a bölcs könyvet, melyet Amerika egyik leginnovatívabb vállalkozója írt.”

Michael S. Ovitz a Wall Disney Company elnökeDe sokan még azt se tudják, hogy mi a stratégiai inflexiós pont - lényege.

"Az úgynevezett inflexiós pont egy olyan változás az üzleti környezetben, amely drámai változást okoz tevékenységünk teljes egészében, vagy annak számos elemében, megkérdőjelezve bizonyos szilárdnak hitt feltételezéseket."

--------

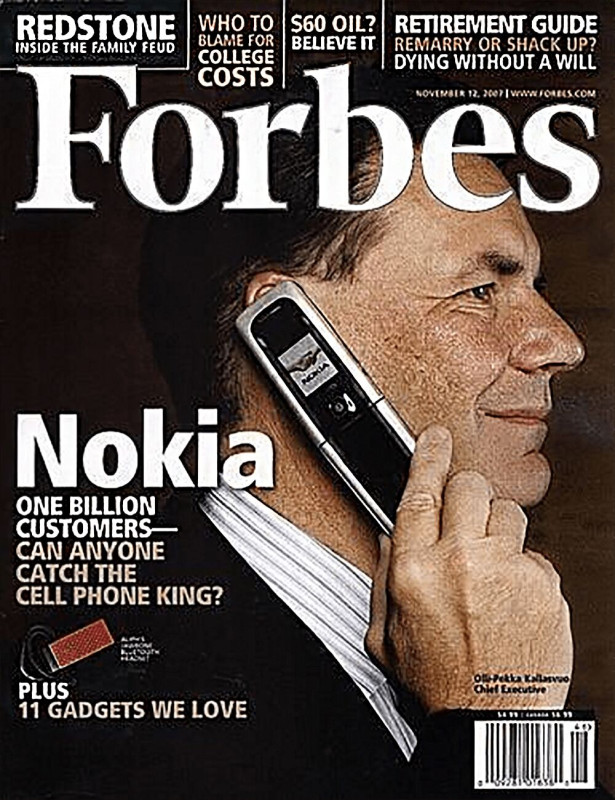

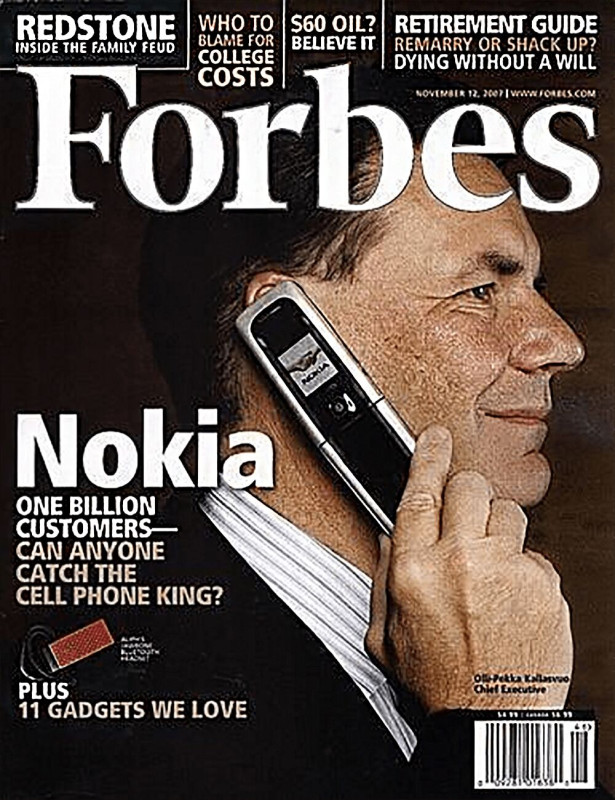

És a Nokia menedzsment is stratégia rövidlátásban szenvedett.

------

Az nVidia amit felismert - hogy a jövőben CPU technológia nélkül nem tud annyira növekedni, mivel az X86-64 területen mindig ki lesznek szolgáltatva.

Próbálta megszerezni az ARM-et, ami nem sikerült,

de a cpu-gpu integrációt elkezdte a grace -el, és dolgozik a desktop arm-os saját megoldásán is. Az első verzió ott is gyenge lesz, és kell 3-4 iteráció, amíg felnő majd a kiforrott Intel-AMD-X86-64 -es platformhoz.Az AI forradalmat az Intel és az AMD félig átaludta - mert senki se képzelte, hogy ilyen gyorsan - ekkora áttörés lesz.

És a gyors technológiai áttörés még az nVidiát is meglepte.Nagyon gyors technológia változások zajlanak most,

és a jelen - nagyon gyorsan elavul.Ha valakit zavarja, hogyha néha a CXL-ről vagy a PCIe 7.0 -ról is posztolok,

akkor az kénytelen lesz ezt megszokni.

-

paprobert

őstag

válasz

S_x96x_S

#66241

üzenetére

S_x96x_S

#66241

üzenetére

Azért abban egyetérthetünk, hogy egy spekulatív következtetéshez érdemes nem figyelmen kívül hagyni a jelent.

Azért abban egyetérthetünk, hogy egy spekulatív következtetéshez érdemes nem figyelmen kívül hagyni a jelent.

Nekem az a benyomásom támad az írásaiddal kapcsolatban sokszor, mintha a legfinomabb szűrés nélkül csak bedobnád a megjelenő gondolataidat, ami kicsit RNG/chatbot érzetet kelt...

Így persze nem hagysz ki semmit sem, de felhígul a mondandód, és keresni kell benne a megfoghatót. Talán erre utalhatott Pumba.Ettől eltekintve szerintem adsz hozzá a diskurzushoz, szóval ne vedd ezt támadásnak. Peace.

off vége

-

S_x96x_S

addikt

válasz

paprobert

#66238

üzenetére

paprobert

#66238

üzenetére

> ami a topikba illik. Az AMD GPU-k jövőjéről van szó.

azért nem egyértelmű

![;]](//cdn.rios.hu/dl/s/v1.gif)

mert PuMbA úgy értelmezi, hogy az "AMD GPU-k jelene" a téma.

( ~ "Beszéljünk a jelenről, amit tudunk." ) -

Abu85

HÁZIGAZDA

Azért AI-val megoldott képkockagenerálás csak egy van, ami az AFMF 2. A többi nem is használ AI-t. Optical flow hardvert vagy ennek a compute megvalósítását használják. De az AFMF 2 sem a képkockageneráláshoz használ AI-t, hanem ahhoz, hogy mikor legyen kikapcsolva.

Jelen pillanatban AI képkockagenerálás nem is létezik gyakorlatban működő szinten, valós időben. Se a DLSS, se az FSR nem az. Még az AFMF sem, ha csak a képkockagenerálóját nézzük, de igen az igaz, hogy az AFMF 2-nek egy kicsike része AI, de pont nem a képkockageneráló.

-

S_x96x_S

addikt

> Ugyanennyire nem értelmes a folytonos jövővárás és jövőbe tekintés,

> Most látjuk a tényeket és ez van.

> Nem kell tovább ragozni, mert senki se jövőbelátó.nem tudom, hogy mennyire van műszaki háttered,

de újabban már létezik olyan tantárgy a műszaki képzéseken,

hogy "technológiamenedzsment" / "stratégiai technológiamenedzsment"

És tekintsd úgy, hogy a jövőről mint "technológiai stratégiákról" beszélünk.Az hogy mennyire értelmes a "technológiai stratégiákról" értekezni,

arra nagyon jó (negatív) példa a NOKIA és újabban az Intel és a Boeing.

és talán a pozitiv példák közé tartozik - Steve Jobs - a víziójával.Engem speciel érdekel az ilyen stratégiai szemlélet,

mert fontos dolog és ide tartozik.> Beszéljünk a jelenről.

ez a találgatós ( amolyan stratégiai topik )

A jelenről nincs mit találgatni.

ráadásul minden leak - a jövőről szól. -

mozesapo

tag

válasz

S_x96x_S

#66234

üzenetére

S_x96x_S

#66234

üzenetére

Az a lényeg ami itt lejött nekem az elmúlt hónapokban. Az nvidia király és a dlss, minden más sz*r. Erről ennyit, felesleges bármit írni.

Az admint meg kérném, hogy legyen erélyesebb és a topik címének megfelelő kommentek legyenek a későbbiekben. Egy kicsit fárasztó már az nvidia, dlss dömping. -

PuMbA

titán

válasz

S_x96x_S

#66234

üzenetére

S_x96x_S

#66234

üzenetére

"A PSSR esetében

sem az extrém felhajtás ( ~ a medve bőrére inni),

sem a túl korai ítélkezés (a PSSR temetése)

nem túl értelmes,"Ugyanennyire értelmetlen a folytonos jövővárás és jövőbe tekintés, ami a hozzászólásaid nagy részében van a tények helyett, mert ilyen erővel minden, ami most rossz az 30 év múlva jó lehet. A valóság pedig az, hogy a rossz dolgok nagy része ugyanolyan rossz marad a jövőben is vagy eltűnik és még egyes jó dolgok is eltűnhetnek a semmibe. Most látjuk a tényeket és ez van. Nem kell tovább ragozni. Beszéljünk a jelenről, amit tudunk. A jövőről elég csak pár szót megejteni, abból is azt, aminek legalább a valószínűsége nagyon nagy.

-

PuMbA

titán

Abu nem igazán szokott NVIDIA mellett érvelni és ez most az

S_x96x_S: "hogy a "FSR3 jól együtt tud működni a PSSR" -rel"

Ennek a valószínűsége nulla. A beszúrt cikkedben is le van írva, hogy a Sony-nál dolgoznak a további AI megoldásokon, tehát a képkocka generálás is. Az FSR ki lesz dobva a kukába, nem véletlenül kezdtek neki a PSSR-nek. Ez pedig egy érdekes helyzetet fog teremteni, mert az FSR alól kezd kicsúszni a talaj, hiszen elvesztették a Playstaton-t. Nintendo Switch 2-ben DLSS lesz. Marad a PC platform meg a Steam Deck?

-

S_x96x_S

addikt

válasz

paprobert

#66233

üzenetére

paprobert

#66233

üzenetére

> Az előre megígért csoda maradt csak el,

A PSSR esetében

sem az extrém felhajtás ( ~ a medve bőrére inni),

sem a túl korai ítélkezés (a PSSR temetése)

nem túl értelmes,Szokásosan minden csúszik,

de a hardver már rendelkezésre áll,

és körülbelül egy évre van még szükség, hogy kiderüljön,

hogyan teljesít az új játékokban.Kérdés, hogy a Ratchet and Clank -ot mennyire okosították fel a fejlesztők,

vagy csak azt használták ki,

hogy a "FSR3 jól együtt tud működni a PSSR" -rel------------------

draft -gépi-fordítással:

"""

A Digital Foundry podcast során a tech szakértő arról beszélt, hogy a PlayStation 5 Pro-ban miért nem található AI-alapú képkocka-generálási technológia. Valószínű, hogy ennek időzítési okai vannak, mivel a Sony már akkor megkezdte a rendszer processzorának fejlesztését, amikor az NVIDIA DLSS 3 Frame Generation technológia még nem is létezett. Továbbá, önmagában a gépi tanulásra alkalmas hardver megléte nem feltétlenül hoz eredményt, hiszen például az NVIDIA képkocka-generálási technológiája több összetevőből áll, amelyek közül a gépi tanulás csupán az egyik. Valószínű, hogy a teljesítmény nem volt akkora prioritás, mint a képminőség, így inkább a felbontás növelésére fókuszáltak a minőség javítása érdekében. Végül, ha mégis szükség lenne képkocka-generálási technológiára, az AMD FSR 3 jól együttműködhet a PSSR-rel.

Egy dolog azonban biztosnak tűnik. A PlayStation 5 Pro gépi tanulásra alkalmas hardvere csupán az első lépés, és várhatóan elindítja a Sony AI-kutatását. Mindezek ellenére ez egy kiváló kiindulási pont, amely az idő múlásával csak javulni fog, ahogy azt a PlayStation 4 Pro checkerboard renderelési technológiájánál is láthattuk. A jövőbeni játékokat már kifejezetten a PlayStation Spectral Super Resolution AI-alapú felbontásnövelő rendszer köré építik majd, amelyek sokkal nagyobb előnyét élvezhetik, mint a jelenlegi játékok.

""" -

paprobert

őstag

válasz

S_x96x_S

#66231

üzenetére

S_x96x_S

#66231

üzenetére

Ne aggódj, nem lett leírva a PSSR, de ez volt az első teszt, és nem az előzetes állítások alapján várt-sugallt eredmény jött ki.

Tisztán látszódik hogy előrelépés az FSR-hoz képest, és akár meg fejlődhet is, akárcsak a másik két AI felskálázó tette azt az első 1-2 évben.

Az előre megígért csoda maradt csak el, van helyette egy jónak tűnő, good enough megoldás.

-

S_x96x_S

addikt

válasz

paprobert

#66230

üzenetére

paprobert

#66230

üzenetére

> aminek épp a szöges ellentétét bizonyította a DF a mostani videóban.

A DF videóban - éppen eléggé kihangsúlyozták:

- Ez egy Ratchet and Clank fej-fej melletti összehasonlítási próbálkozás - és hogy ebből még ne vonjunk le semmilyen megalapozott következtetést a többis PSSR-es játékra, mivel a felskálázási megvalósítások minősége játékról játékra változhat.

- valamint hogy a PSSR egy játék alapján sokkal jobbnak tűnik mint az FSR3

És amit még kihangsúlyoztak, hogy az összehasonlítás eléggé problémás:

- a PS5 Pro-t a PC-vel, közelítő minőségi beállítások alapján lehetetlen teljesen egyező eredményt elérni.

- a Rift Apart dinamikus felbontás-skálázást használ, és a PC-s megvalósítás nagyon-nagyon különböző, így minden a tesztképek pixelezését egyenként kellett megoldani.

- ezen túlmenően, bár megpróbálták kikapcsolni a mozgási elmosódást a PS5 Pro-n a tisztább kép érdekében, ez csak az effekt intenzitását csökkenti, így ezt is hozzá kellett igazítani a PC-s képkockákhoz.

- valamint az Nvidia DLSS-sel való összehasonlításnak talán kevesebb gyakorlati haszna van, mivel az FSR 3.1-től eltérően soha nem fogunk látni Sony konzolon ilyen felskálázási technológiát. -

paprobert

őstag

válasz

S_x96x_S

#66223

üzenetére

S_x96x_S

#66223

üzenetére

Füles információ volt a "pár százalék az AI a DLSS-ben", és a "PSSR mindent alázni fog mert full AI" is, elhintve itt a fórumon a 2-3 GPU-s topikban.

Ez a két információ felfest egy végeredményt (azaz hogy a PSSR (és emiatt talán az FSR4.0 is) sokkal jobb), aminek épp a szöges ellentétét bizonyította a DF a mostani videóban.

Valahol kilóg a lóláb, mert a végeredménynek nem ennek kellett volna lennie a két állítást igaznak elfogadva.Szerintem eléggé egyértelmű Pumba álláspontja, nem szorul semmi sem magyarázatra a margón.

-

PuMbA

titán

válasz

mozesapo

#66227

üzenetére

mozesapo

#66227

üzenetére

PSSR is egy készből dolgozik, hiszen a PSSR diákon látható egy "Uses pretrained graph parameters. No per title training needed" sor

Az AI cuccok modell nélkül használhatatlanok tudomásom szerint. A Tesla önvezetése is így működik, hogy van mögötte egy gigantikus szuperszámítógép, hiába van a kocsiban 245 TOPS számolási teljesítmény. Ugye Itt a PS5 Pro-ban 300 TOPS van.

Az AI cuccok modell nélkül használhatatlanok tudomásom szerint. A Tesla önvezetése is így működik, hogy van mögötte egy gigantikus szuperszámítógép, hiába van a kocsiban 245 TOPS számolási teljesítmény. Ugye Itt a PS5 Pro-ban 300 TOPS van. -

PuMbA

titán

válasz

mozesapo

#66225

üzenetére

mozesapo

#66225

üzenetére

Nem értem, hogy hogy jön ide a szuperszámítógép meg a pénzügyi háttér. Ez a százalékos arány arról szól, hogy a gépeinken mennyi AI-t számol a felskálázó, tehát az egész felskálázási művelethez szükséges utasítások hány százaléka fut AI egységeken és hány általános egységeken. Ennyi

-

PuMbA

titán

válasz

S_x96x_S

#66223

üzenetére

S_x96x_S

#66223

üzenetére

Ha sima mosolyt rakok a mondat végére

, akkor az nálam komoly megállapítás. Abban a hozzászólásban is a DLSS-t hoztam ki nyertesnek, hiszen a minősége kiváló a PSSR-rel szemben, de azt sokkal kevesebb AI használatával éri el.

, akkor az nálam komoly megállapítás. Abban a hozzászólásban is a DLSS-t hoztam ki nyertesnek, hiszen a minősége kiváló a PSSR-rel szemben, de azt sokkal kevesebb AI használatával éri el.Kérdés, hogy a PSSR hova fog fejlődni 1 év múlva, de akkorra már lesz DLSS 4 is.

-

S_x96x_S

addikt

> "Én mindig a tényekkel értek egyet, tehát ami gépi tanulással megy, az AI. "

sokszor nem derül ki, hogy melyik irásod

- tény

- és melyik speckuláció

- és melyik szatíra.> "Hát igen. A PSSR a 100%-os AI használatával

> a jelenlegi állapotában nem veri a csak 5%-ban AI-t használó DLSS-t "ha még 3x leirod, akkor a fórum fele elhiszi

hogy ez a véleményed és nem tartod sokra a DLLS-t![;]](//cdn.rios.hu/dl/s/v1.gif)

-

S_x96x_S

addikt

> A probléma, hogy továbbra se tudható,

> hogy az FSR4-hez CPU-ba épített NPU fog-e kelleni,Szerintem van rá esély, hogy az AMD NPU-támogatást IS integrál az FSR4 technológiába, különösen a hordozható eszközöknél.

például Jack Huynh az IFA 2024-es interjúban a hordozható gaming-re fókuszált, és kiemelte az akkumulátor élettartam fontosságát, ami az NPU-k használatát indokolhatja, hiszen ezek kifejezetten hatékonyak AI-feladatok végrehajtásában, és csökkenthetik az energiafogyasztást.

"Jack Huynh: On the handheld side, my number one priority is battery life. If you look at the ASUS ROG Ally or the Lenovo Legion Go, it’s just that the battery life is not there. I need multiple hours. I need to play a Wukong for three hours, not 60 minutes. This is where frame generation and interpolation [come in], so this is the FSR4 that we're adding."

https://www.tomshardware.com/pc-components/gpus/amd-plans-for-fsr4-to-be-fully-ai-based-designed-to-improve-quality-and-maximize-power-efficiency> de ha igen, akkor az FSR4 ott halt meg a DLSS-sel szemben.

mobil Gaming-nél az NPU előnyös.

Ha az nVidia hasonlóan hatékony fogyasztást el tud érni

a mobil GPU DLSS-el mint amilyen az NPU,

akkor van esélye az NPU ellen. -

PuMbA

titán

válasz

huskydog17

#66215

üzenetére

huskydog17

#66215

üzenetére

Kegyetlen!

Múltkor viccelődtem, hogy még 2027-ben is RDNA2 kártyák jönnek majd ki....

Múltkor viccelődtem, hogy még 2027-ben is RDNA2 kártyák jönnek majd ki....S_x96x_S: Én mindig a tényekkel értek egyet, tehát ami gépi tanulással megy, az AI. Ami nem, az nem AI.

-

S_x96x_S

addikt

köszi;

akkor most már értem hogy te miért Abu-val értesz egyet és nem az nVidiával.

- mert hw fókusszal nézitek - és hogy az adott GPU a raszter mellett hány százalékban használja az AI-t. ( Mindenesetre majd Abu pontosítja.)

- de ilyen alapon nézzük akkor PSSR - se 100%. és az FSR4 se 100%

- és Abu valószínüleg alábecsüli - vagy teljesen mást ért AI-alatt.

---

Ellenben az nVidia - általánosságban beszélt a DLSS - AI-ról - mint módszertan,

amit a szuperkomputereken tréningeznek és optimalizálnak - egy-egy játékra.

---Azt már tudom, hogy Abu mit ért AI alatt,

- de TE mit értesz alatta? és jól érted-e hogy Abu mit ért alatta. -

PuMbA

titán

válasz

S_x96x_S

#66216

üzenetére

S_x96x_S

#66216

üzenetére

"Vagyis ha jól értelek - te konkrétan nem értesz egyet az nVidiával."

Ez nem tudom, hogy honnan vetted. Mindig elismerően nyilatkoztam a DLSS-ről, hiszen a legjobb felskálázó jelenleg. A probléma, hogy továbbra se tudható, hogy az FSR4-hez CPU-ba épített NPU fog-e kelleni, de ha igen, akkor az FSR4 ott halt meg a DLSS-sel szemben.

"kérek pontos linket és kontextust."

Te olvasod is a topikot vagy csak a PCI-E Gen 5 pörög a fejedben?

![;]](//cdn.rios.hu/dl/s/v1.gif) Ha rákeresel ebben a topikban, hogy DLSS AI, akkor könnyen megtalálod, mert csomószor volt róla szó.10 másodpercembe tellett megkeresnem ezt: [link]

Ha rákeresel ebben a topikban, hogy DLSS AI, akkor könnyen megtalálod, mert csomószor volt róla szó.10 másodpercembe tellett megkeresnem ezt: [link] -

Raymond

titán

válasz

huskydog17

#66215

üzenetére

huskydog17

#66215

üzenetére

Pozitivan nezve a dolgot annyit lehetne mondani hogy legalabb nem Polaris [link]

-

S_x96x_S

addikt

Vagyis ha jól értelek - te konkrétan nem értesz egyet az nVidiával.

Amúgy én az AI-t módszertannak és algoritmusnak tartom.

( vagy még inkább módszertanok és algoritmusok gyüjtő fogalma)

emiatt egy CPU-val ( + "általános számoló egységgel" )

is lehet AI-s dolgokat csinálni ,

a dedikált hardware csak gyorsít rajta, de nem az teszi AI -vá a megoldást.> Abu írta, hogy kb. 5%-ban használ AI-t

kérek pontos linket és kontextust.

-------------

Persze léteznek már teljesen (100%) neurális hálón alapuló játékok,

( a sakkon és a go-n kivül is ) de ezek még nem gyakoriak1 héttel ezelőtti hír:

"Counter-Strike's Dust II runs purely within a neural network on an RTX 3090 — performance is disappointing at only 10 FPS"és a kutatás mögötte

"CSGO DIAMOND 💎 Diffusion World Model Demonstrations"

https://diamond-wm.github.io/

-

huskydog17

addikt

Minek RDNA3 és RDNA4? Éljen az RDNA2!

ZEPHYR introduces Radeon RX 6800/6900 with white PCB, four years after AMD release

Mondjuk tény, hogy nagyon baráti áron adják ott ezeket az új fehér csodákat:

"The RX 6900 XT model is priced at 2,999 RMB (around $410 USD), while the RX 6800 XT and RX 6800 are priced at 2,799 RMB ($383 USD) and 2,499 RMB ($342 USD) respectively."

#66212 PuMbA: Szerintem aki eddig is két lábbal állt a talajon, annak ez nem meglepő.

Tehát akkor a Sony egy dedikált AI hardverrel meg tudja közelíteni azt a minőséget, amit az NVIDIA - állítólag - nem AI alapú megoldása hoz általános feldolgozókkal több éve. Ez a konzolosoknak jó hír, hogy végre ők is kapnak DLSS szintű képminőséget.

Na persze ez még csak egy játék, de nagy valószínűséggel a többi játékban is hasonló lesz az eredmény.

Ilyenkor elgondolkozik az ember, hogy ha a Sony-nak és AMD-nek külön dedikált hardveregység kell ahhoz, hogy elérjék/megközelítsék a DLSS minőségét, akkor vajon az NVIDIA szintén dedikált AI hardverrel milyen minőséget képviselne? Hm... -

PuMbA

titán

válasz

S_x96x_S

#66213

üzenetére

S_x96x_S

#66213

üzenetére

Abu írta, hogy kb. 5%-ban használ AI-t már többször ebben a topikban is, illetve PH-n még hír is volt róla, hiszen csak a képkockák összefésülése fut Tensor magokon

A többi általános számoló egységeken megy, hogy az SM-en (Streaming Multiprocessor) belüli 64 vagy 128kB regiszter kapacitás elég legyen, ugyanis egyszerre nagy mennyiségű számítás nem mehet párhuzamosan Tensor magokon és általános számolóegységeket együtt, mert elfogy a hely.

A többi általános számoló egységeken megy, hogy az SM-en (Streaming Multiprocessor) belüli 64 vagy 128kB regiszter kapacitás elég legyen, ugyanis egyszerre nagy mennyiségű számítás nem mehet párhuzamosan Tensor magokon és általános számolóegységeket együtt, mert elfogy a hely. -

S_x96x_S

addikt

> a csak 5%-ban AI-t használó DLSS-t

AI -alatt mindenki mást ért ( hasonlóan mint a "smart" alatt )

emiatt bővebben is ki tudnád fejteni, hogy te itt - miért csak 5%-ra értékeled az AI használatát?-------

szerintem: a DLSS ( = Deep Learning Super Sampling) a mesterséges intelligencián (AI) alapul, mivel a mélytanulás (DL = Deep Learning ) az AI egyik részterülete,

amely mély neurális hálózatokat használ a mintafelismeréshez és az előrejelzésekhez.

És ezért a DLSS-t teljes mértékben AI technológiának tartom.https://developer.nvidia.com/rtx/dlss

"NVIDIA DLSS (Deep Learning Super Sampling) is a neural graphics technology that multiplies performance using AI to create entirely new frames, display higher resolution through image reconstruction, and improve the image quality of intensive ray-traced content—all while delivering best-in-class image quality and responsiveness."

- The AI network analyzes sequential frames and motion data to create additional high-quality, responsive frames.

- DLSS takes advantage of AI models that are continuously improved through ongoing training on NVIDIA supercomputers, providing better image quality and performance across more games and applications.

----- -

PuMbA

titán

Upscaling Face-Off: PS5 Pro PSSR vs PC DLSS/FSR 3.1 in Ratchet and Clank Rift Apart

Hát igen. A PSSR a 100%-os AI használatával a jelenlegi állapotában nem veri a csak 5%-ban AI-t használó DLSS-t

-

S_x96x_S

addikt

"AMD ROCm Looks Like It Will Finally Be Supporting OpenCL 3.0 Soon"

https://www.phoronix.com/news/AMD-ROCm-OpenCL-3.0-Soon -

S_x96x_S

addikt

> a konzolbiznisz semmilyen előnyt se sw, se hw oldalon sajnos.

Ahogy én látom - a Sony és a Microsoft mint fő partnerek jelentős szerepet játszottak a GPU-fejlesztések finanszírozásában. Ezek a fél-egyedi (semi-custom) tervezések stabil bevételi forrást és hosszú távú együttműködést biztosítottak az AMD számára.

De a konzoloknál a tranzisztorszám és a gyártási költségek kritikus tényezők.

És ez arra ösztönözte az AMD-t, hogy optimalizálja chipjeit és innovatív megoldásokat találjon a költséghatékonyság érdekében.

És ennek a konzol orientált nézőpontnak volt az egyik következménye

az RDNA-CDNA szétválasztása.

És emiatt van elég kevés tartalék az RDNA-ban az új funkciókra.Az Nvidia kevésbé volt kötve a tranzisztorszám és a gyártási költségek korlátaihoz, ezért:

A gaming GPU-ikban benne hagyták az AI-hoz szükséges részeket, amelyek számítási tartalékként szolgáltak.

És ezeket a tartalékokat felhasználták olyan innovatív megoldásokra, mint például a DLSSAz egységes UDNA (Unified DNA) bevezetésével az AMD összevonja a számítási és grafikai képességeket egyetlen architektúrában.

És az AI-funkciók integrálása a gaming GPU-kba nemcsak a teljesítményt növeli, hanem hozzájárul a gaming fejlesztések finanszírozásához is.

( és az AI-ban sok pénz van, lásd MI300 bevételek 2024-re)

Ezzel az AMD jobban követi az Nvidia stratégiáját,

és kihasználja az AI nyújtotta lehetőségeket a játékfejlesztésben. -

sb

veterán

válasz

S_x96x_S

#66195

üzenetére

S_x96x_S

#66195

üzenetére

Akkor helyesbítek: ambíció - szavakban - van.

Ambíció = lesz.Eddig amit láttunk: az alapján nem nagyon történt semmi. Egyébként amennyire (nem) látom, gaming oldalon sem hozott a konzolbiznisz semmilyen előnyt se sw, se hw oldalon sajnos.

ROCm-nél 7900 felett van valami támogatás consumer oldalon. Ill. windowsos alapokon van talán alatta is úgy emlékszem.

Amúgy az AI sw oldali résszel biztosan kezdenek valamit, ezt aláírom. Van is némi mérhető eredménye. Ez kell és ha már van/jön fentről, akkor a Halo és pár dgpu farvizén ide is logikus hozni. -

S_x96x_S

addikt

"AMD confirms Ryzen AI MAX 300 naming for Strix Halo"

https://videocardz.com/newz/amd-confirms-ryzen-ai-max-300-naming-for-strix-halo

-

S_x96x_S

addikt

válasz

Yutani

#66204

üzenetére

Yutani

#66204

üzenetére

Én hiszek a "Root cause analysis" megközelítésben.

Amit lehet alkalmazni az AMD - consumer GPU estére is:

1. Azonosítsd és írd le világosan az AMD alacsony GPU piaci részesedésének problémáját.

2. Állíts fel egy idővonalat a normális helyzettől az AMD alacsony piaci részesedésének kialakulásáig.

3. Különböztesd meg a gyökérokot és az egyéb okozati tényezőket, amelyek befolyásolják az AMD GPU piaci részesedését (például események korrelációja révén).

4. Állíts fel egy okozati gráfot a gyökérok és az AMD alacsony GPU piaci részesedésének problémája között.És ha csak az első két lépés-t végzed el, akkor garantált a téves következtetés.

--> Kell egy okozati gráf a gyökérokokról.És ha az AMD tevékenyen - 5000x erőbedobással nem a gyökérokokon dolgozik, akkor grantált az újabb kudarc.

Hasonlóan mint a túl okos részeg történetében, aki elvesztette lakáskulcsát, és az utcai lámpa körül keresi, mert ott van világos.

És nem tudod, hogy az AMD mit csinál a sötétben, főleg akkor, hogyha te csak az utcai lámpára koncentrálsz.Úgyhogy szerintem nincs még értelme itélkezni.

----

Az, hogy nem látsz előrelépést, sőt inkább visszalépésnek tünik pár dolog, szintén nem lehet a "gyökérokok" nélkül értelmezni, hasonlóan mint egy autó elakadást - ami kénytelen visszatolatni - hogy egy másik úton előrébb jusson.

---> "Navi4x már most lelombozó"

--> gondold erősen, hogy az RDNA4 jó lesz.

-

Busterftw

nagyúr

válasz

Yutani

#66204

üzenetére

Yutani

#66204

üzenetére

Illetve epp az RDNA4 sulhet el rosszul ezzel, mert az "oke raszter es de sokkal jobb RT" egy hatalmas fricska lehet egy csomo core AMD fannak/usernek, mivel eleg sokan epp amellett szolaltak fel, hogy engem nem erdekel az RT, ha az RT-t nem nezed, raszterben igen is kompetitiv az AMD.

-

Yutani

nagyúr

válasz

S_x96x_S

#66202

üzenetére

S_x96x_S

#66202

üzenetére

Busterftw fórumtársnak igaza van, mindig csak a "majd". Persze a Navi2x esetén történt valami, elindult pozitív irányba a VGA portfólió, de a Navi3x nem lett egy sikertörténet. A Navi4x már most lelombozó (bár nem bánnám, ha meglepnének egy jól látható RT sebesség előrelépéssel), a jövő meg még messze van, és valahogy nem látom realitását a 40% market share-nek.

-

Busterftw

nagyúr

válasz

Yutani

#66199

üzenetére

Yutani

#66199

üzenetére

De amugy ezeket mar evek ota atragtuk, teljesen egyertelmu az ordogi kor amiben az AMD van evek ota. Mar vagy 20x leirtam biztosan az elmult 5-6 evben.

1. Az AMD-nek sokkal gyorsabb megoldast kell hozni olcsobban, vagy legalabb egal teljesitmenyt joval olcsobban.

2. Az AMD-nek mobil/dvga piacon sokkal-sokkal tobbet kell gyartatnia, a 3-6-8 honapos termek keseseket 0-ra kell csokkenteni, mert az OEM-ek csak kirohogik oket.- Szevasz Lenovo/MSI/Asus/Dell/HP, itt az uj Hydra/Leviathan/Keszeg/Harcsa Point APU,

tok zsir, kell?

- Persze, iskolanyitasra kell par tizmillio darab.

- Jah hat talan jovo marciusra meglesz, mert csuszik, de azert bejelentjuk, meg olyan 100ezret tudunk talan szallitani.

-Oke, talan a ROG/Alienware 2500 dollarert majd limitaltan belerakjuk.Persze lehet mosdatni oket napestig, S_x96x_S gondolom emlekszik a "dolgoznak a kapacitas bovitesen meg a tobb rendelesen", ennek evek mulva lesz latszata, csak aztan azok az evek mar elteltek, aztan ugyanugy minden termek csak csordogal a piacra.

szerk: csak most lattam, lol, latod mondom en, ez a mantra csak minden evben toljuk a 2-3 evet es kesz az ultimate erv

"Az UDNA és a realistább célok - 2 fontos stratégia irányváltó lépés

aminek csak 2-3 év után látszik az eredménye"

Velemenyem szerint, ha a teljes kepet nezzuk, pontosan ezert esett egy egeszsegesebb 35%-os piaci reszesedesrol 10% korulire, mert az userek lassan rajottek hogy ez a folyamatos "majd 2-3 ev mulva" mosdatas teljesen abszurd, az allando varakozas, na majd a kovetkezo generacio, na majd az ev vegi csodadriver.

Meg marad 12%, aki kitart. -

S_x96x_S

addikt

válasz

Yutani

#66199

üzenetére

Yutani

#66199

üzenetére

valószínüleg teljesen mást értünk az "ambíció" fogalma alatt.

legalábbis én erre a megjegyzésedre refrektáltam: ( --> "AMD oldalról semmiféle gpu irányú ambíciót nem láttam és nem is látok:" )a 2db Jack-es cikk nekem arról árulkodik,

hogy legalább az eddigi stratégiai hibákat felismerték és próbálják korrigálni

- az UDNA -val

- és a realistább célokkal ( ~ addig nyújtozkodnak, ameddig a jelenlegi technológia ér - és emiatt most nem csinálnak high-end rdna4-et, csak a presztízs miatt.). De ez azt is jelenti, hogy az nVidiát nem a legerősebb pontján akarják támadni, hanem a gyengébb pontján - a túlárazott low/middle szegmensben. Nem árt tudni, hogy mindkét cégvezér ( nvidia, amd ) ismeri a Szun-Ce, A háború művészete - írást - mivel a gyökereik Taijvaniak, de amúgy a könyv már a mai modern stratégiai képzések része is.

( akit érdekel: https://mek.oszk.hu/01300/01345/01345.htm )

főleg:

- Ismerd meg önmagad és ismerd meg az ellenséget, és száz csatában sem kerülsz veszélybe.!

- Kerüld az erőt, támadd a gyengeséget.Az AMD-nek minél hamarabb eredményeket kell felmutatnia és ezt csak a low-middle szegmensben - az RDNA4 -el tudja elérni.

------------

Az UDNA és a realistább célok - 2 fontos stratégia irányváltó lépés

aminek csak 2-3 év után látszik az eredménye

és nem fél éven belül. És ez még önmagában nem garancia a sikerre.Amúgy az UDNA-s irányváltás szoftveresen már elkezdődött,

mivel a Radeon kátyákat kezdik megnyitni az AI-s ROCm-es csomagok előtt.

"AMD's ROCm documentation now includes a dedicated ROCm on Radeon section"

"AMD continues to attract AI developers to Radeon." October 9, 2024

https://www.tomshardware.com/pc-components/gpus/amds-rocm-documentation-now-includes-a-dedicated-rocm-on-radeon-section

"Normally, AMD only supported AI/ML frameworks on Instinct accelerators based on the CDNA architecture for AI and HPC applications, but recently it changed its mind and enabled AI acceleration on its RDNA 3-based GPUs. To make it easier for developers to use Radeon graphics processors for AI development, starting from ROCm 6.1.3 and Radeon Software for Linux 24.10.3 software, ROCm documentation now features a dedicated ROCm on Radeon section to simplify installation and reveal compatibility details."

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Óvodások homokozója

- A fociról könnyedén, egy baráti társaságban

- Kerékpárosok, bringások ide!

- Steam, GOG, Epic Store, Humble Store, Xbox PC Game Pass, Origin Access, uPlay+, Apple Arcade felhasználók barátságos izgulós topikja

- Jövőre az Apple megérkezhet 2019-be

- Bukta a GeForce RTX 5090D-t Kína?

- Gran Turismo

- Clair Obscur: Expedition 33 teszt

- Milyen SSD-t vegyek?

- AMD Ryzen 9 / 7 / 5 7***(X) "Zen 4" (AM5)

- További aktív témák...

- Tablet felvásárlás!! Samsung Galaxy Tab A8, Samsung Galaxy Tab A9, Samsung Galaxy Tab S6 Lite

- Samsung Galaxy A9 2018 128GB, Kártyafüggetlen, 1 Év Garanciával

- MacBook felváráslás!! MacBook, MacBook Air, MacBook Pro

- AKCIÓ! Gigabyte H610M i5 12400F 16GB DDR4 512GB SSD RX 6700XT 12GB Zalman S2 TG Seasonic 650W

- Magyarország piacvezető szoftver webáruháza

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) ) 200%-os gyorsulást jelent raytracingbe a 2db kártya, ellentétbe a 3 vagy 4db kártyával ahol már sajnos nem gyorsul 3-4X-esére... így nem igazán éri meg, ezt már inkább mozgókép renderelésre rakták össze anno, amire később az nvidia ki is hozta a saját Nvidia GRID gépét 8 GPU-val, de láttam már gépet 11-12 vízhűtött gpu-val ugyanekkora méretben építve...

) 200%-os gyorsulást jelent raytracingbe a 2db kártya, ellentétbe a 3 vagy 4db kártyával ahol már sajnos nem gyorsul 3-4X-esére... így nem igazán éri meg, ezt már inkább mozgókép renderelésre rakták össze anno, amire később az nvidia ki is hozta a saját Nvidia GRID gépét 8 GPU-val, de láttam már gépet 11-12 vízhűtött gpu-val ugyanekkora méretben építve...

Mit ér az agyamban

Mit ér az agyamban